Omówienie konfiguracji AI i LLM w Microsoft Cloud for Sovereignty (wersja zapoznawcza)

Ważne

Jest to funkcja w wersji zapoznawczej. Informacje te dotyczą funkcji w wersji wstępnej, która może zostać znacznie zmodyfikowana przed jej udostępnieniem. Firma Microsoft nie udziela żadnych gwarancji, jawnych lub domniemanych, w odniesieniu do informacji podanych w tym miejscu.

Organizacje publiczne mogą korzystać z najnowszych technologii AI w chmurze publicznej, zarządzających danymi zgodnie z lokalną zasadami i wymaganiami prawnymi Microsoft Cloud for Sovereignty.

Microsoft Cloud for Sovereignty oferuje dynamikę i elastyczność, zaawansowane funkcje dostosowywania oraz dostęp do najnowszych nowatorów, takich jak Platforma Azure OpenAI, w celu przyspieszenia transformacji cyfrowej i dostarczania istotnych usług publicznych. Umożliwia klientom tworzenie zaufanych obciążeń przekształcania cyfrowego w Microsoft Cloud podczas pomagania spełniania wielu z ich specyficznych zabezpieczeń zgodności i wymogów zasad.

Usługa Azure OpenAI zapewnia dostęp do OpenAI potężnych modeli językowych, w tym serii modeli GTP4-o, GPT-4, GPT-3.5-Turbo i Embeddings. Te podstawowe modele językowe są wstępnie wyszkolone na dużych ilościach danych do wykonywania zadań, takich jak generowanie zawartości, podsumowanie, wyszukiwanie po wyszukaniu języka naturalnego do przetłumaczenia kodu. Klienci mogą używać usługi Azure OpenAI Service w celu uzyskiwania dostępu do wstępnie wyszukanych modeli w celu szybkiego i minimalnego nakładu pracy przy budowaniu aplikacji korzystających z AI, a jednocześnie używając Microsoft Cloud for Sovereignty do wymuszania zgodności, zabezpieczeń i wymagań dotyczących zasad w przypadku formantów skalowania przedsiębiorstwa oraz architektury chmury.

Świadczenia

Do przekazywania danych możesz użyć usług Azure OpenAI:

Większa produktywność pracowników dzięki skróceniu czasu potrzebnego na znajdowanie najważniejszych informacji w bazie wiedzy.

Zwiększanie zadowolenia użytkowników przez uproszczenie złożonych przepisów i wymagań programowych.

Przykładowe przypadki użycia

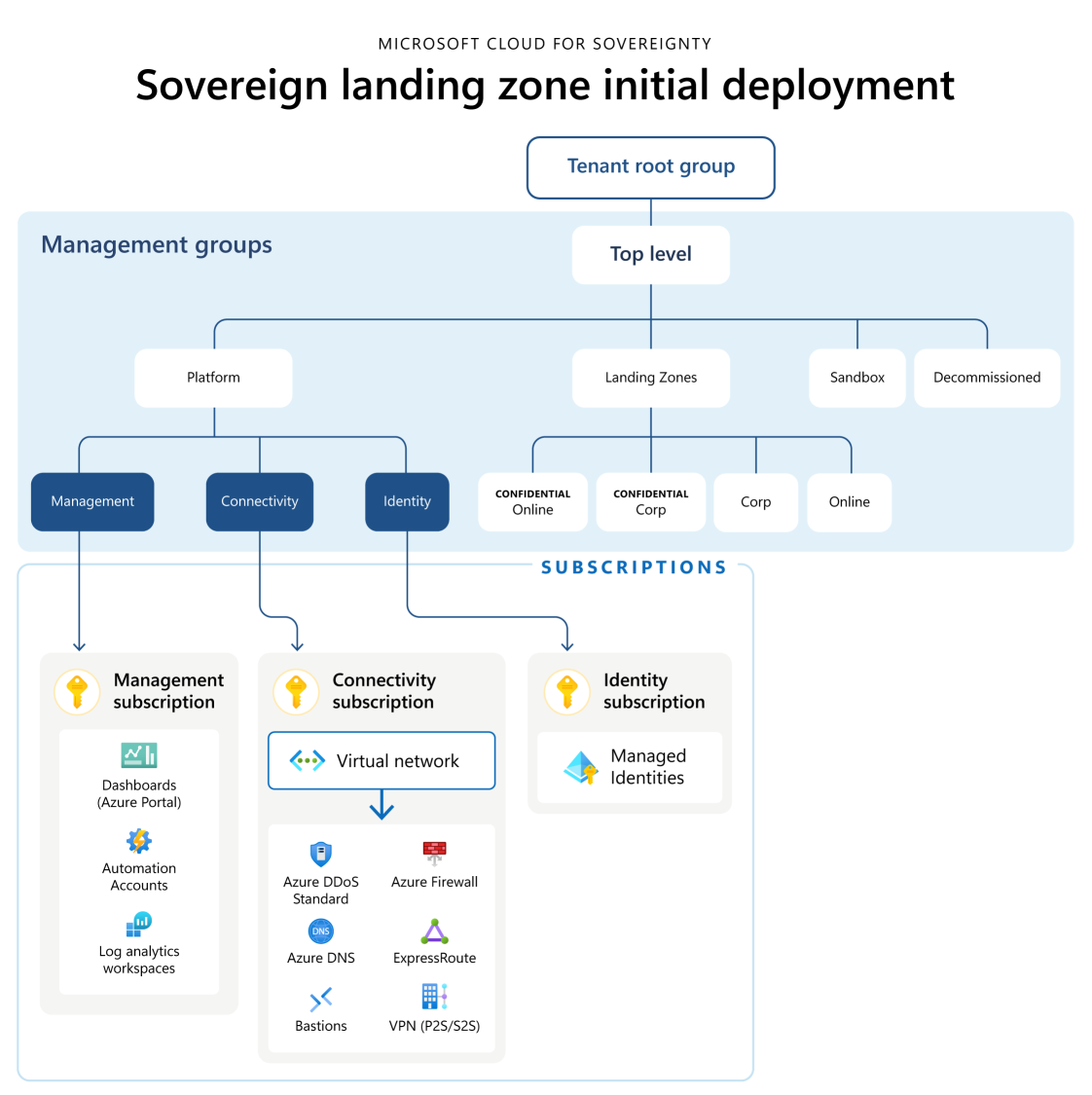

Sprawy używania zabezpieczeń są najlepiej zaimplementowane w oparciu o Suwerenną strefę docelową (SLZ). SLZ składa się z hierarchii grupy zarządzania wraz z wspólnymi zasobami platformy w celu ułatwienia tożsamości usług sieciowych, rejestrowania i zarządzania, jak pokazano: Na poniższym diagramie przedstawiono architekturę początkowego wdrożenia strefy docelowej Suweren.

Główna grupa zarządzania rozwiązania SLZ jest często określana jako strefa docelowa lub strefa docelowa na skali przedsiębiorstwa. Poszczególne subskrypcje, które trafiają do jednej z grup zarządzania podrzędnego pod obiektem nadrzędnym, są często określane mianem stref docelowych aplikacji lub stref docelowych obciążenia. Obciążenia aplikacji można wdrożyć w środowisku SLZ w jednej z czterech domyślnych stref docelowych:

Korporacja (korporacja) — obciążenia niezwiązane z Internetem, niepoufne

Online - dostęp do Internetu, niepoufne obciążenia

Poufna korporacja — poufne obciążenia niezwiązane z Internetem (zezwalają tylko na korzystanie z poufnych zasobów obliczeniowych)

Poufne online — dostęp do Internetu, poufne obciążenia (umożliwia korzystanie tylko z poufnych zasobów obliczeniowych)

Główna różnica między grupami zarządzania Corp i Online polega na tym, jak obsługują publiczne punkty końcowe. Środowisko Online zezwala na korzystanie z publicznych punktów końcowych, podczas gdy środowisko Corp nie. Dowiedz się więcej o architekturze z SLZ.

W środowisku SLZ należy wdrażać rozwiązania oparte na sztucznej inteligencji jako dedykowane obciążenia we własnych subskrypcjach w hierarchii grup zarządzania Corp lub Online .

Zalecamy używanie środowiska Corp jako bezpiecznego wzorca standardowego do implementowania dużych modeli językowych (LLM) za pośrednictwem aplikacji opartych na Retrieval Augmented Generation (RAG), takich jak agenci do użytku wewnętrznego organizacji. Połączenia ExpressRoro i VPN są wymagane w przypadku wdrożeń Corp w celu uzyskania dostępu do interfejsów API frontu lub interfejsów użytkownika, które łączą się z usługami Azure AI i zapewniają funkcje LLM z powrotem do użytkowników końcowych lub do interfejsów użytkownika.

Aby zaoferować aplikacjom opartym na LLM lub lub RAG, należy użyć stref docelowych obciążenia w hierarchii grup zarządzania online. Należy jednak uzyskać dostęp do wszystkich usług wymaganych do implementacji za pośrednictwem punktów końcowych prywatnych w sieci wirtualnej. Interfejs API lub aplikację sieci Web front end należy dostarczać użytkownikom punkt końcowy lub przez odbiorców końcowych.

W takim przypadku należy chronić publiczne serwera punkt końcowy za pomocą zapory aplikacji sieci Web. Należy także zastosować i skonfigurować odpowiednie usługi DDoS i inne usługi zabezpieczeń. Ta konfiguracja, w zależności od preferencji, może odbywać się centralnie w sieci wirtualnej centrum lub być rozcentralizowana w sieci wirtualnej obciążenia.

Jeśli musisz zintegrować dane z poufnych stref docelowych z obciążeniami sztucznej inteligencji, musisz uruchomić procesy przekształcania, które przetwarzają i przechowują dane w usługach, takich jak Azure usługi sztucznej inteligencji, takie jak Azure AI Search lub Azure OpenAI, w poufnej strefie docelowej. Ponadto te procesy powinny aktywnie filtrować dane i zarządzać nimi, aby zapobiec wysyłaniu poufnych danych, które muszą być szyfrowane w sposób szyfrowany z usługami niekonsekwencjami i obciążeniami. To filtrowanie należy zaimplementować w niestandardowej logice biznesowej dla niestandardowych reguł biznesowych dla niestandardowych liter.

Jeśli musisz pozyskiwać, przekształcać i używać danych przez obciążenia sztucznej inteligencji, zalecamy wdrożenie strefy docelowej danych wyrównanej z domenami danych. Strefa docelowa danych składa się z kilku warstwy, które umożliwiają dynamikę integracji danych i produktów z danymi, które zawiera.

Strefa docelowa danych jest częścią scenariusza analizy w skali chmury Cloud Adoption Framework, który jest kompleksowym, opiniotwórczym podejściem zaprojektowanym w celu przyspieszenia i usprawnienia wdrażania zaawansowanych rozwiązań analitycznych w chmurze. Zapewnia ustrukturyzowaną metodologię, obejmującą najlepsze praktyki i ustandaryzowane usługi, aby ułatwić pozyskiwanie, przekształcanie i używanie danych w różnych domenach. Korzystając z tego scenariusza, organizacje mogą osiągnąć większą elastyczność i skalowalność operacji na danych, zapewniając bezpieczne udostępnianie danych i nadzór nad nimi. Struktura ta nie tylko optymalizuje wydajność obciążeń analitycznych, ale także usprawnia bezproblemową integrację produktów danych i zarządzanie nimi, co ostatecznie prowadzi do bardziej wnikliwych i świadomych procesów decyzyjnych.

Można wdrożyć nową strefę docelową danych ze standardowym zestawem usług, co pozwala rozpocząć przetwarzanie i analizowanie danych w strefie docelowej danych. Strefę docelową danych możesz połączyć ze strefą docelową danych LLM i wszystkimi innymi strefami docelowymi danych przy użyciu funkcji peeringu dla sieci wirtualnej. Ten mechanizm pozwala bezpieczne udostępniać dane za pośrednictwem wewnętrznej sieci Azure, jednocześnie osiągnąć obniżenie wydajności i wyższą wydajność w porównaniu z przepływem przez centrum.

W przypadku niektórych implementacji może być wymagane użycie poufnych lub poufnych danych, które wymagają szyfrowania podczas korzystania z poufnego przetwarzania. W tym scenariuszu możesz uruchomić rozwiązań danych opartych na maszynach wirtualnych w obszarach docelowych grupę zarządzania poufną. Niektóre usługi danych PaaS mogą nie być w stanie uruchomić na poufnych maszynach wirtualnych.

Następne kroki

- Dowiedz się, jak używać LLMs i Azure OpenAI w generowaniu plików wyszukiwania (RAG) (wersja zapoznawcza).