Kierowanie strumieni danych na podstawie zawartości w strumieniach zdarzeń usługi Fabric

W tym artykule przedstawiono sposób kierowania zdarzeń na podstawie zawartości w strumieniach zdarzeń usługi Microsoft Fabric.

Teraz możesz użyć edytora bez kodu na głównej kanwie strumieni zdarzeń sieci szkieletowej, aby utworzyć złożoną logikę przetwarzania strumieniowego bez konieczności pisania kodu. Ta funkcja umożliwia łatwiejsze dostosowywanie, przekształcanie i zarządzanie strumieniami danych. Po ustawieniu operacji przetwarzania strumienia można bezproblemowo wysyłać strumienie danych do różnych miejsc docelowych zgodnie z określonym schematem i danymi strumienia.

Obsługiwane operacje

Oto lista operacji obsługiwanych w przypadku przetwarzania danych w czasie rzeczywistym:

Agregacja: obsługują funkcje SUM, AVG, MIN i MAX, które wykonują obliczenia w kolumnie wartości, zwracając pojedynczy wynik.

Rozwiń: rozwiń wartość tablicy i utwórz nowy wiersz dla każdej wartości w tablicy.

Filtr: wybierz lub przefiltruj określone wiersze ze strumienia danych na podstawie warunku.

Grupuj według: Agreguj wszystkie dane zdarzeń w określonym przedziale czasu z opcją grupowania co najmniej jednej kolumny.

Zarządzanie polami: dodawanie, usuwanie lub zmienianie typu danych pola lub kolumny strumieni danych.

Unia: połącz co najmniej dwa strumienie danych z polami udostępnionymi o tej samej nazwie i typie danych w jednym strumieniu danych. Pola, które nie są zgodne, są porzucane.

Sprzężenia: połącz dane z dwóch strumieni na podstawie zgodnego warunku między nimi.

Obsługiwane miejsca docelowe

Obsługiwane miejsca docelowe to:

Lakehouse: To miejsce docelowe zapewnia możliwość przekształcania zdarzeń w czasie rzeczywistym przed ich załadowaniem do systemu Lakehouse. Zdarzenia w czasie rzeczywistym są konwertowane na format usługi Delta Lake, a następnie przechowują je w wyznaczonych tabelach lakehouse. To miejsce docelowe pomaga w scenariuszach magazynowania danych.

Eventhouse: To miejsce docelowe umożliwia przesyłanie danych zdarzeń w czasie rzeczywistym do usługi Eventhouse, gdzie można użyć zaawansowanego języka zapytań Kusto (KQL) do wykonywania zapytań i analizowania danych. Dzięki danym w Eventhouse możesz uzyskać głębszy wgląd w dane dotyczące zdarzeń i tworzyć bogate raporty oraz pulpity nawigacyjne.

Aktywacja sieci szkieletowej: to miejsce docelowe umożliwia bezpośrednie połączenie danych zdarzeń w czasie rzeczywistym z aktywatorem sieci szkieletowej. Aktywacja to typ inteligentnego agenta, który zawiera wszystkie informacje niezbędne do nawiązania połączenia z danymi, monitorowania warunków i działania. Gdy dane osiągną określone progi lub pasują do innych wzorców, aktywator automatycznie podejmuje odpowiednie działania, takie jak zgłaszanie alertów użytkownikom lub uruchamianie przepływów pracy usługi Power Automate.

Niestandardowy punkt końcowy (była aplikacja niestandardowa): dzięki temu miejscu docelowemu można łatwo kierować zdarzenia w czasie rzeczywistym do aplikacji niestandardowej. To miejsce docelowe umożliwia łączenie własnych aplikacji z strumieniem zdarzeń i korzystanie z danych zdarzenia w czasie rzeczywistym. Jest to przydatne, gdy chcesz wychodzących danych w czasie rzeczywistym do systemu zewnętrznego poza usługą Microsoft Fabric.

Strumień: to miejsce docelowe reprezentuje domyślny nieprzetworzony strumień zdarzeń przekształcony przez serię operacji, nazywany również strumieniem pochodnym. Po utworzeniu możesz wyświetlić strumień z centrum czasu rzeczywistego.

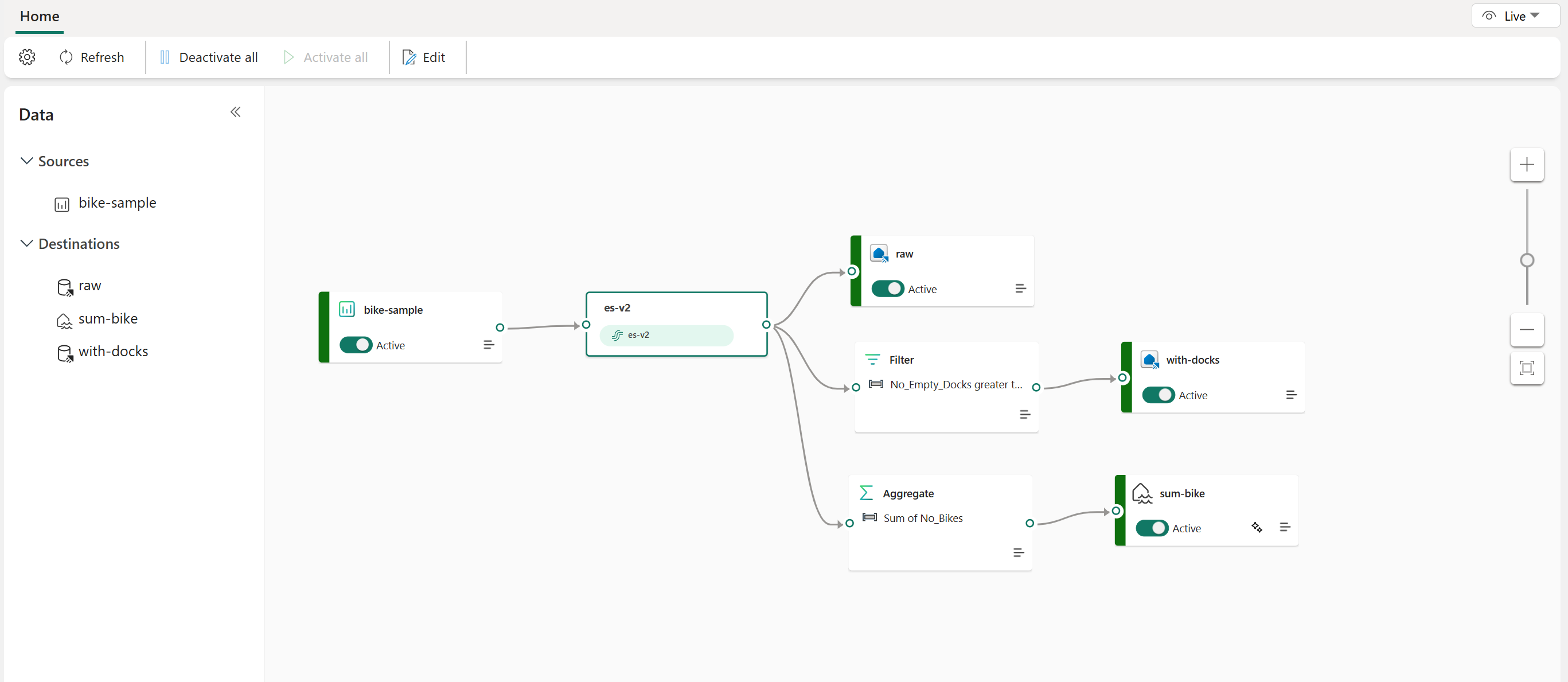

W poniższym przykładzie pokazano, jak trzy odrębne miejsca docelowe strumienia zdarzeń usługi Fabric mogą obsługiwać oddzielne funkcje dla pojedynczego źródła strumienia danych. Jedna usługa Eventhouse jest przeznaczona do przechowywania danych pierwotnych, a druga usługa Eventhouse służy do przechowywania przefiltrowanych strumieni danych, a usługa Lakehouse służy do przechowywania zagregowanych wartości.

Aby przekształcić i skierować strumień danych na podstawie zawartości, wykonaj kroki opisane w temacie Edytowanie i publikowanie strumienia zdarzeń oraz rozpoczęcie projektowania logiki przetwarzania strumienia dla strumienia danych.