Pozyskiwanie danych do usługi OneLake i analizowanie za pomocą usługi Azure Databricks

W tym przewodniku wykonasz następujące elementy:

Utwórz potok w obszarze roboczym i pozyskuj dane do usługi OneLake w formacie delta.

Odczytywanie i modyfikowanie tabeli delty w usłudze OneLake za pomocą usługi Azure Databricks.

Wymagania wstępne

Przed rozpoczęciem musisz mieć następujące elementy:

Obszar roboczy z elementem lakehouse.

Obszar roboczy usługi Azure Databricks w warstwie Premium. Tylko obszary robocze usługi Azure Databricks w warstwie Premium obsługują przekazywanie poświadczeń firmy Microsoft. Podczas tworzenia klastra włącz przekazywanie poświadczeń usługi Azure Data Lake Storage w obszarze Opcje zaawansowane.

Przykładowy zestaw danych.

Pozyskiwanie danych i modyfikowanie tabeli delty

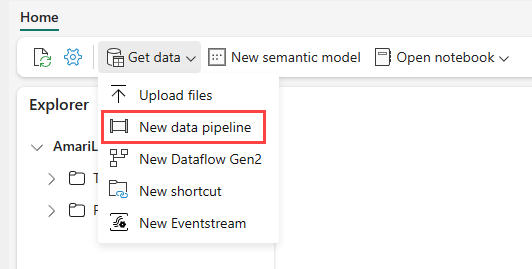

Przejdź do usługi Lakehouse w usługa Power BI i wybierz pozycję Pobierz dane, a następnie wybierz pozycję Nowy potok danych.

W wierszu polecenia Nowy potok wprowadź nazwę nowego potoku, a następnie wybierz pozycję Utwórz.

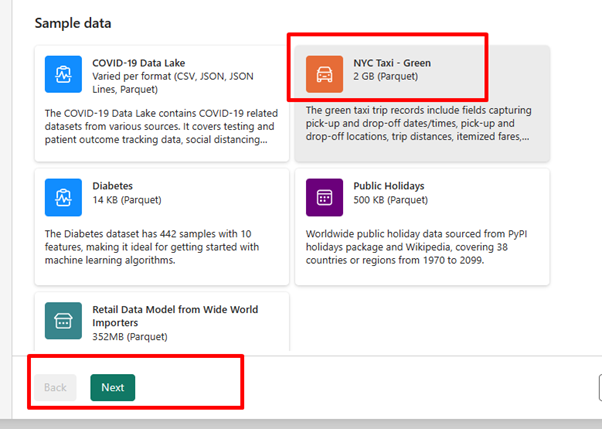

W tym ćwiczeniu wybierz przykładowe dane NYC Taxi — Green jako źródło danych, a następnie wybierz pozycję Dalej.

Na ekranie podglądu wybierz pozycję Dalej.

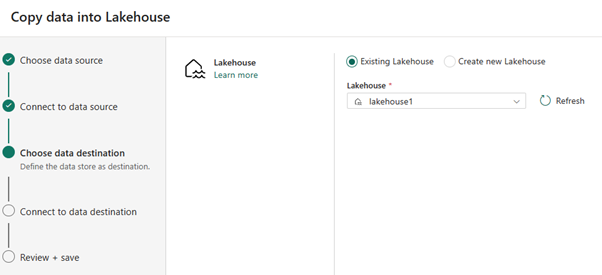

W przypadku miejsca docelowego danych wybierz nazwę magazynu lakehouse, którego chcesz użyć do przechowywania danych tabeli delty OneLake. Możesz wybrać istniejący lakehouse lub utworzyć nowy.

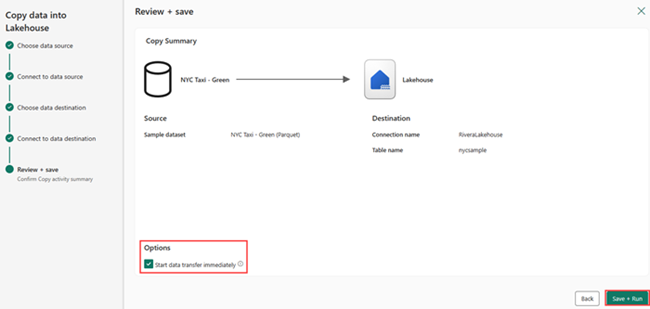

Wybierz miejsce przechowywania danych wyjściowych. Wybierz pozycję Tabele jako folder główny i wprowadź ciąg "nycsample" jako nazwę tabeli.

Na ekranie Przeglądanie i zapisywanie wybierz pozycję Rozpocznij transfer danych natychmiast , a następnie wybierz pozycję Zapisz i uruchom.

Po zakończeniu zadania przejdź do usługi Lakehouse i wyświetl tabelę delty wymienioną w folderze /Tables.

Kliknij prawym przyciskiem myszy nazwę utworzonej tabeli, wybierz pozycję Właściwości i skopiuj ścieżkę systemu plików obiektów blob platformy Azure (ABFS).

Otwórz notes usługi Azure Databricks. Przeczytaj tabelę delta w usłudze OneLake.

olsPath = "abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample" df=spark.read.format('delta').option("inferSchema","true").load(olsPath) df.show(5)Zaktualizuj dane tabeli delty, zmieniając wartość pola.

%sql update delta.`abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample` set vendorID = 99999 where vendorID = 1;