Scenariusz cenowy użycia usługi Dataflow Gen2 do załadowania 2 GB danych Parquet do tabeli Lakehouse

W tym scenariuszu usługa Dataflow Gen2 została użyta do załadowania 2 GB danych Parquet przechowywanych w usłudze Azure Data Lake Storage (ADLS) Gen2 do tabeli lakehouse w usłudze Microsoft Fabric. Użyliśmy przykładowych danych NYC Taxi-green dla danych Parquet.

Ceny używane w poniższym przykładzie są hipotetyczne i nie zamierzają oznaczać dokładnych rzeczywistych cen. Wystarczy pokazać, jak oszacować, zaplanować i zarządzać kosztami projektów usługi Data Factory w usłudze Microsoft Fabric. Ponadto, ponieważ pojemności sieci szkieletowej są wyceniane unikatowo w różnych regionach, używamy cennika z płatnością zgodnie z rzeczywistym użyciem dla pojemności sieci szkieletowej w regionie Zachodnie stany USA 2 (typowy region świadczenia usługi Azure), przy wartości 0,18 USD za jednostkę CU za godzinę. Zapoznaj się tutaj z usługą Microsoft Fabric — cennik , aby zapoznać się z innymi opcjami cen pojemności sieci szkieletowej.

Konfigurowanie

Aby wykonać ten scenariusz, należy utworzyć przepływ danych, wykonując następujące czynności:

- Inicjowanie przepływu danych: pobieranie danych 2 GB plików Parquet z konta magazynu usługi ADLS Gen2.

- Konfigurowanie dodatku Power Query:

- Przejdź do dodatku Power Query.

- Upewnij się, że opcja przemieszczania zapytania jest włączona.

- Przejdź do łączenia plików Parquet.

- Przekształcanie danych:

- Podwyższanie poziomu nagłówków w celu uzyskania przejrzystości.

- Usuń niepotrzebne kolumny.

- Dostosuj typy danych kolumn zgodnie z potrzebami.

- Zdefiniuj miejsce docelowe danych wyjściowych:

- Skonfiguruj usługę Lakehouse jako miejsce docelowe danych wyjściowych.

- W tym przykładzie utworzono i wykorzystano usługę Lakehouse w usłudze Fabric.

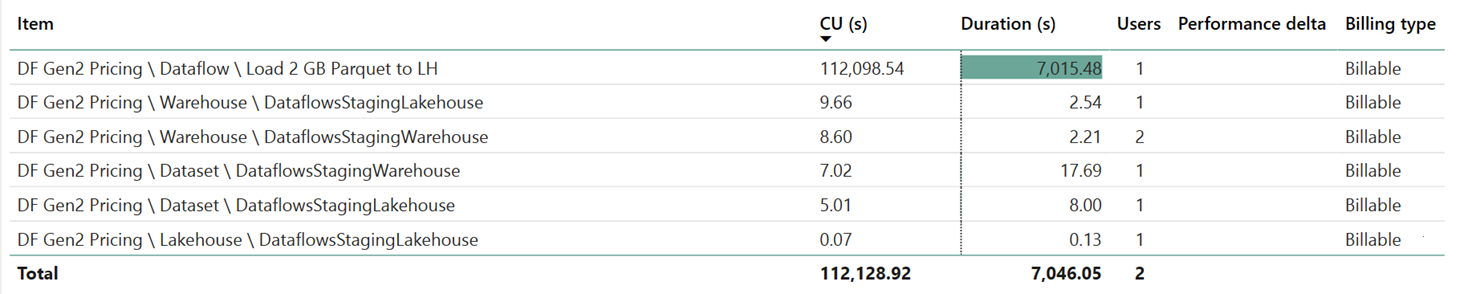

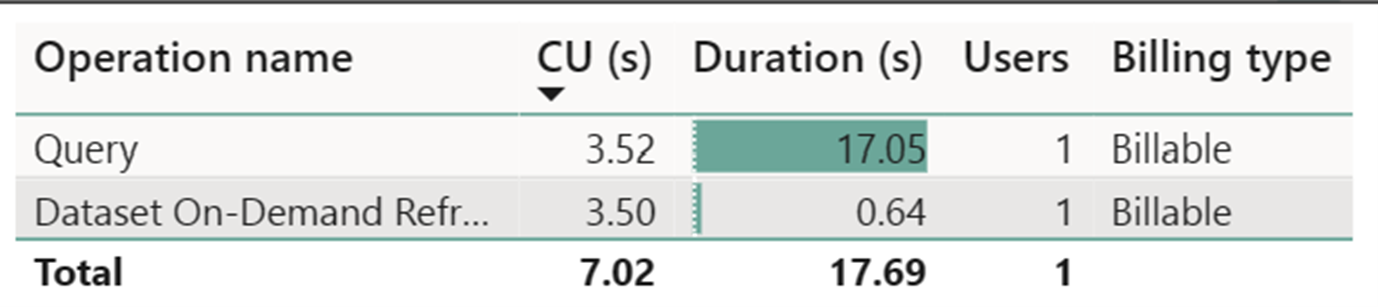

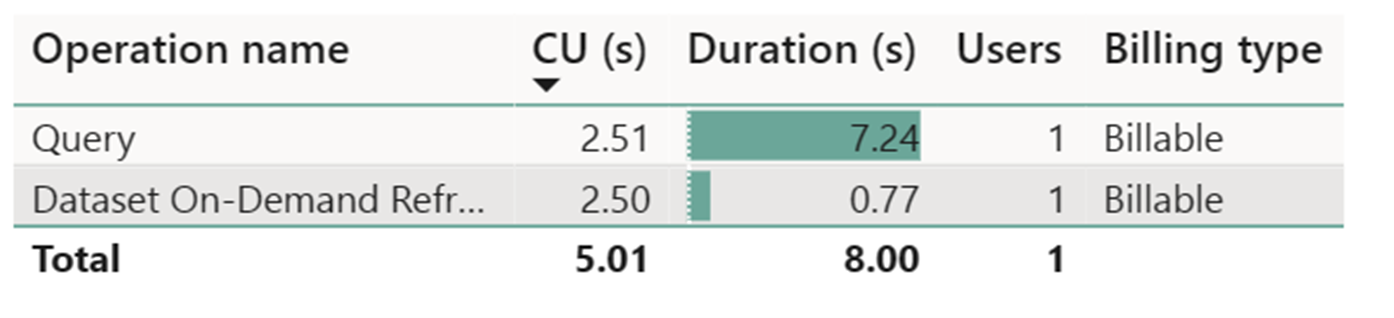

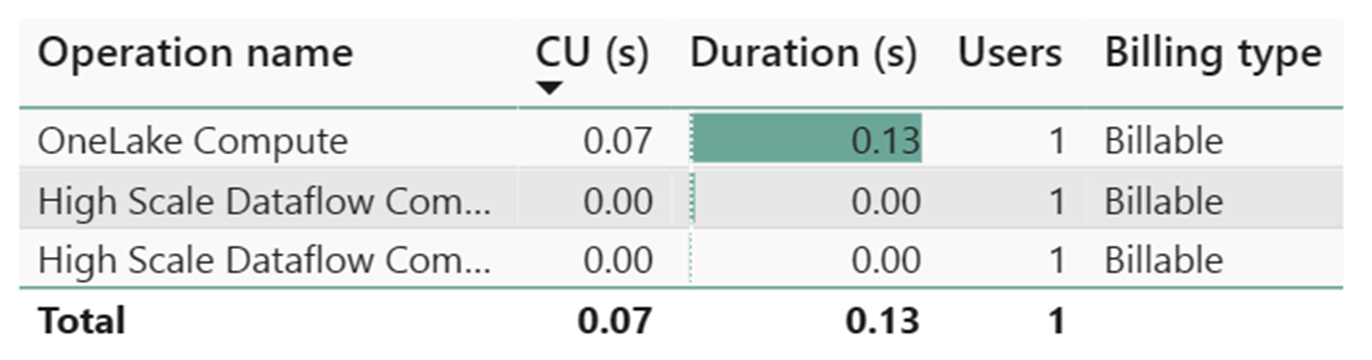

Szacowanie kosztów przy użyciu aplikacji metryk sieci szkieletowej

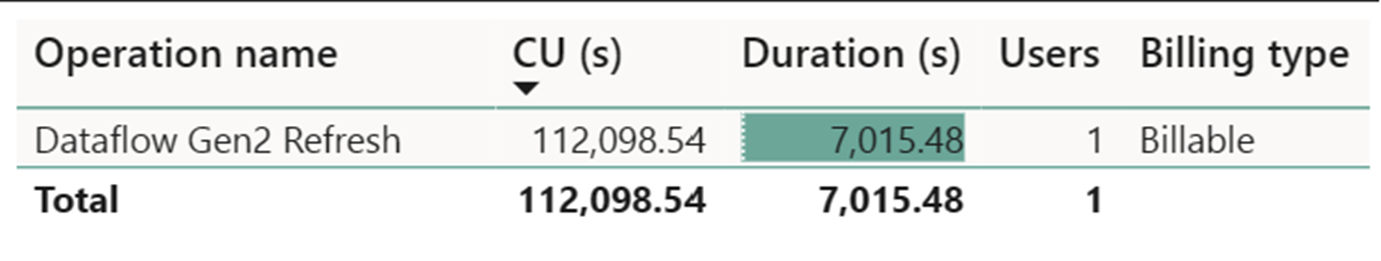

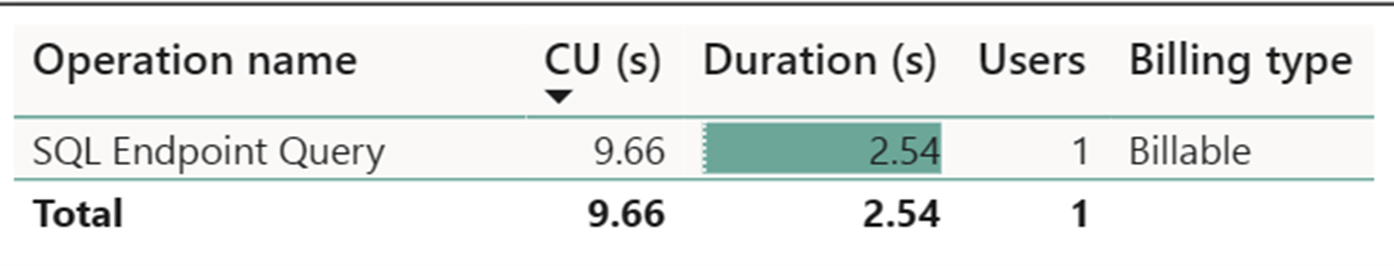

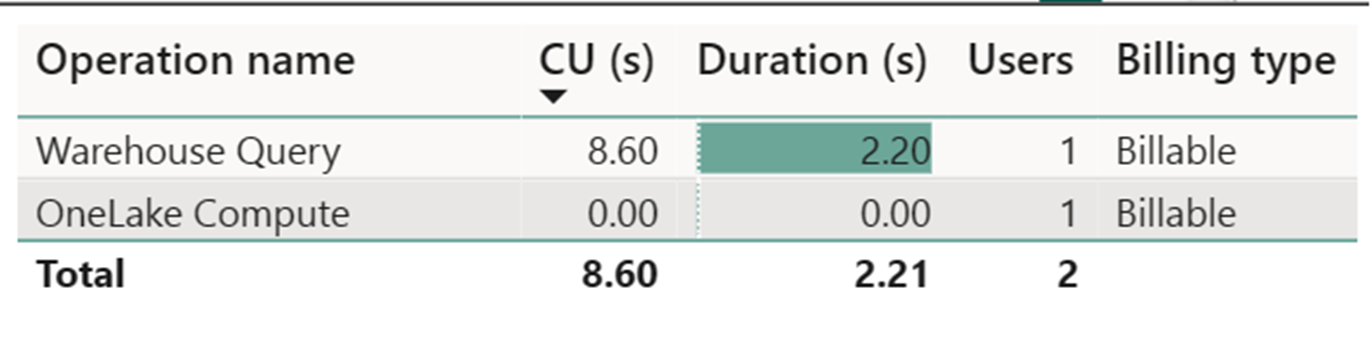

Miernik obliczeniowy przepływu danych o dużej skali odnotował niewielką aktywność. Standardowy miernik obliczeniowy dla operacji odświeżania przepływu danych Gen2 zużywa 112 098,540 jednostek obliczeniowych (CU). Należy wziąć pod uwagę, że inne operacje, w tym zapytanie magazynu, zapytanie punktu końcowego SQL i odświeżanie zestawu danych na żądanie, stanowią szczegółowe aspekty implementacji przepływu danych Gen2, które są obecnie przejrzyste i niezbędne dla odpowiednich operacji. Jednak te operacje zostaną ukryte w przyszłych aktualizacjach i powinny zostać zignorowane podczas szacowania kosztów przepływu danych Gen2.

Uwaga

Chociaż raportowany jako metryka, rzeczywisty czas trwania przebiegu nie jest istotny podczas obliczania obowiązujących godzin aktualizacji AKTUALIZACJi przy użyciu aplikacji metryk sieci szkieletowej, ponieważ metryka sekund aktualizacji cu również raportuje już czas trwania.

| Metric | Usługa Compute w warstwie Standardowa | Obliczenia o dużej skali |

|---|---|---|

| Łączna liczba sekund aktualizacji cu | 112 098,54 CU s | 0 CU s |

| Rozliczane godziny obowiązywania aktualizacji CU | 112 098,54 / (60*60) = 31,14 godziny aktualizacji CU | 0 / (60*60) = 0 godz. |

Całkowity koszt uruchomienia na 0,18 USD/godzinę CU = (31,14 CU-hours) * ($0.18/CU hour) ~= $5.60