Odpowiedzialne używanie sztucznej inteligencji w obciążeniach platformy Azure

Celem odpowiedzialnego projektowania obciążeń z użyciem AI jest zapewnienie, że zastosowanie algorytmów sztucznej inteligencji jest sprawiedliwe, przejrzystei inkluzywne. Zasady zabezpieczeń platformy Microsoft Azure Well-Architected Framework są powiązane i koncentrują się na poufności i integralności . Środki bezpieczeństwa muszą być spełnione, aby zachować prywatność użytkownika, chronić dane i chronić integralność projektu. Projekt nie powinien być niewłaściwie używany do niezamierzonych celów.

W przypadku obciążeń sztucznej inteligencji modele często używają nieprzezroczystej logiki do podejmowania decyzji. Użytkownicy powinni ufać funkcjonalności systemu i mieć pewność, że modele podejmują te decyzje w odpowiedzialny sposób. Należy zapobiec niedopuszczalnym zachowaniom, takim jak manipulowanie, toksyczność zawartości, naruszenie adresów IP i sfałszowane reakcje.

Rozważ przypadek użycia, w którym firma zajmująca się rozrywką medialną chce udostępnić zalecenia przy użyciu modeli sztucznej inteligencji. Jeśli firma nie implementuje odpowiedzialnej sztucznej inteligencji i odpowiednich protokołów zabezpieczeń, zły aktor może przejąć kontrolę nad modelami. Model może zalecić zawartość, która powoduje szkodę. W przypadku organizacji takie zachowanie może spowodować uszkodzenie marki, niebezpieczne środowiska i problemy prawne. W związku z tym utrzymanie odpowiedniej czujności w całym cyklu życia systemu jest niezbędne i nie do negocjacji.

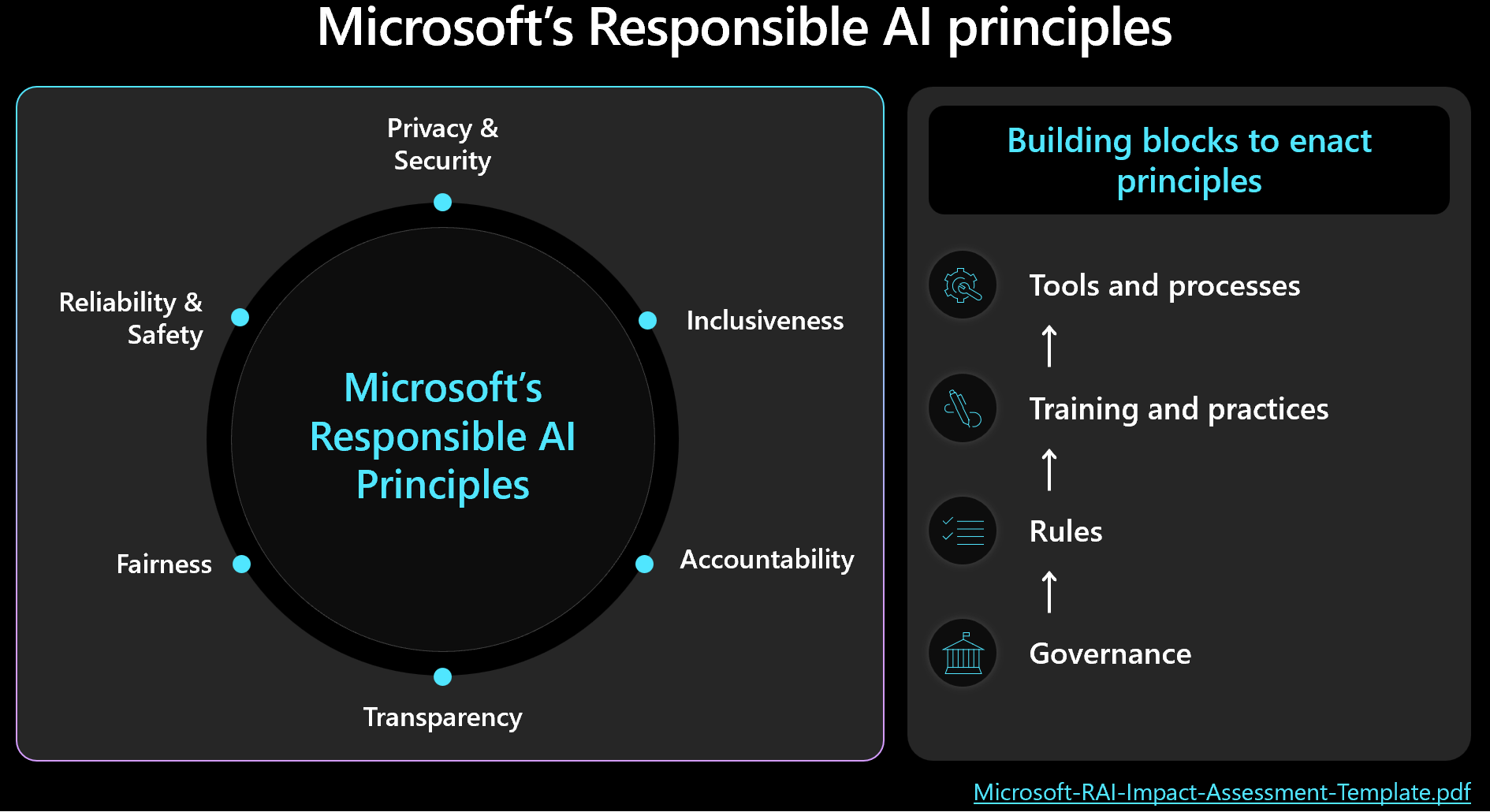

Należy określić priorytety zarządzania zabezpieczeniami i obciążeniami oraz zachować na uwadze wyniki ludzkie podczas podejmowania decyzji projektowych. Zapoznaj się z platformą firmy Microsoft dla odpowiedzialnej sztucznej inteligencji i upewnij się, że mierzysz i wdrażasz zasady struktury w projekcie. Na poniższej ilustracji przedstawiono podstawowe pojęcia dotyczące platformy.

Ważne

Dokładność przewidywań i metryk odpowiedzialnej sztucznej inteligencji jest zwykle połączona ze sobą. Poprawiając dokładność modelu, można zwiększyć jego uczciwość i dopasowanie do rzeczywistości. Odpowiedzialna sztuczna inteligencja często jest zgodna z dokładnością, ale sama dokładność nie obejmuje wszystkich kwestii bezpieczeństwa. Ważne jest, aby walidować te zasady w odpowiedzialny sposób.

Ten artykuł zawiera zalecenia dotyczące odpowiedzialnego podejmowania decyzji, weryfikowania danych wejściowych użytkownika i pomaga zapewnić bezpieczne środowisko użytkownika. Zawiera również wskazówki dotyczące zabezpieczeń danych, które ułatwiają ochronę danych użytkowników.

Zalecenia

Poniższa tabela zawiera podsumowanie zaleceń w tym artykule.

| Zalecenie | opis |

|---|---|

| Opracowywanie zasad, które wymuszają praktyki moralne na każdym etapie cyklu życia. | Uwzględnij elementy listy kontrolnej, które jawnie spełniają wymagania dotyczące bezpieczeństwa i są dostosowane do kontekstu obciążenia. Przykłady obejmują przejrzystość danych użytkownika, konfigurację zgody i procedury dotyczące sposobu obsługi prawa do zapomnienia (RTBF). ▪ Opracowywanie zasad dotyczących odpowiedzialnej sztucznej inteligencji ▪ Egzekwowanie ładu w politykach dotyczących odpowiedzialnej sztucznej inteligencji |

| Ochrona danych użytkowników za pomocą celu zmaksymalizowania prywatności. | Zbierz tylko to, co jest niezbędne i z odpowiednią zgodą użytkownika. Zastosuj mechanizmy kontroli technicznej, aby chronić profile użytkowników, ich dane i dostęp do tych danych. ▪ Odpowiednio obsługuj dane użytkowników ▪ Inspekcja danych przychodzących i wychodzących |

| zachować jasne i zrozumiałe decyzje dotyczące sztucznej inteligencji. | Jasno wyjaśnij, jak działają algorytmy rekomendacji. Zapewnij użytkownikom wgląd w użycie danych i algorytmiczne podejmowanie decyzji, aby pomóc im zrozumieć i zaufać procesowi. ▪ Zabezpieczanie środowiska użytkownika |

Opracowywanie zasad dotyczących odpowiedzialnej sztucznej inteligencji

Udokumentuj podejście do odpowiedzialnego użycia sztucznej inteligencji. Jawnie określa zasady stosowane na każdym etapie cyklu życia, aby zespół ds. obciążeń zrozumiał swoje obowiązki. Standardy firmy Microsoft dotyczące odpowiedzialnej sztucznej inteligencji zawierają wytyczne, ale należy zdefiniować, co te wytyczne oznaczają specjalnie dla danego kontekstu.

Na przykład zasady powinny zawierać elementy listy kontrolnej dla mechanizmów obsługujących przejrzystość danych użytkownika i konfigurację zgody. W idealnym przypadku te mechanizmy powinny zezwalać użytkownikom na rezygnację z dołączania danych. Potoki danych, analiza, trenowanie modelu i inne etapy muszą uwzględniać ten wybór. Innym przykładem jest procedura obsługi rtBF. Skontaktuj się z działem etyki organizacji i zespołem prawnym, aby podejmować świadome decyzje.

Tworzenie przejrzystych zasad dotyczących używania danych i algorytmicznego podejmowania decyzji, aby ułatwić użytkownikom zrozumienie i zaufanie do tego procesu. Udokumentowanie tych decyzji w celu utrzymania jasnej historii potencjalnego przyszłego postępowania sądowego.

Implementacja odpowiedzialnej sztucznej inteligencji obejmuje trzy kluczowe role: zespół badawczy, zespół ds. zasad i zespół inżynierów. Współpraca między tymi zespołami powinna być zoperacjonalizowana. Jeśli Twoja organizacja ma istniejący zespół, użyj ich pracy. W przeciwnym razie samodzielnie ustanów te praktyki.

Każdy zespół powinien mieć własne obowiązki. Na przykład:

Zespół badawczy przeprowadza identyfikację ryzyka poprzez konsultację z wytycznymi organizacyjnymi, standardami branżowymi, przepisami, regulacjami i znanymi taktykami zespołu red-team.

Zespół ds. zasad opracowuje zasady specyficzne dla obciążenia. Zawierają one wytyczne z organizacji nadrzędnej i przepisów rządowych.

Zespół inżynierów implementuje zasady w swoich procesach i elementach dostarczanych. Zespół weryfikuje i sprawdza zgodność.

Każdy zespół sformalizuje swoje wytyczne, ale zespół ds. obciążeń musi być odpowiedzialny za własne udokumentowane praktyki. Zespół powinien wyraźnie udokumentować wszelkie dodatkowe kroki lub zamierzone odchylenia, aby upewnić się, że nie ma wątpliwości co do tego, co jest dozwolone. Zespół powinien być również przejrzysty w zakresie wszelkich potencjalnych niedociągnięć lub nieoczekiwanych wyników w rozwiązaniu.

Wymuszanie ładu w zasadach dotyczących odpowiedzialnej sztucznej inteligencji

Zaprojektuj obciążenie tak, aby było zgodne z ładem organizacyjnym i regulacyjnym. Jeśli na przykład przejrzystość jest wymaganiem organizacyjnym, określ, jak ma to zastosowanie do obciążenia. Zidentyfikuj obszary w projekcie, cyklu życia, kodzie lub innych składnikach, w których należy wprowadzić funkcje przezroczystości, aby spełnić ten standard.

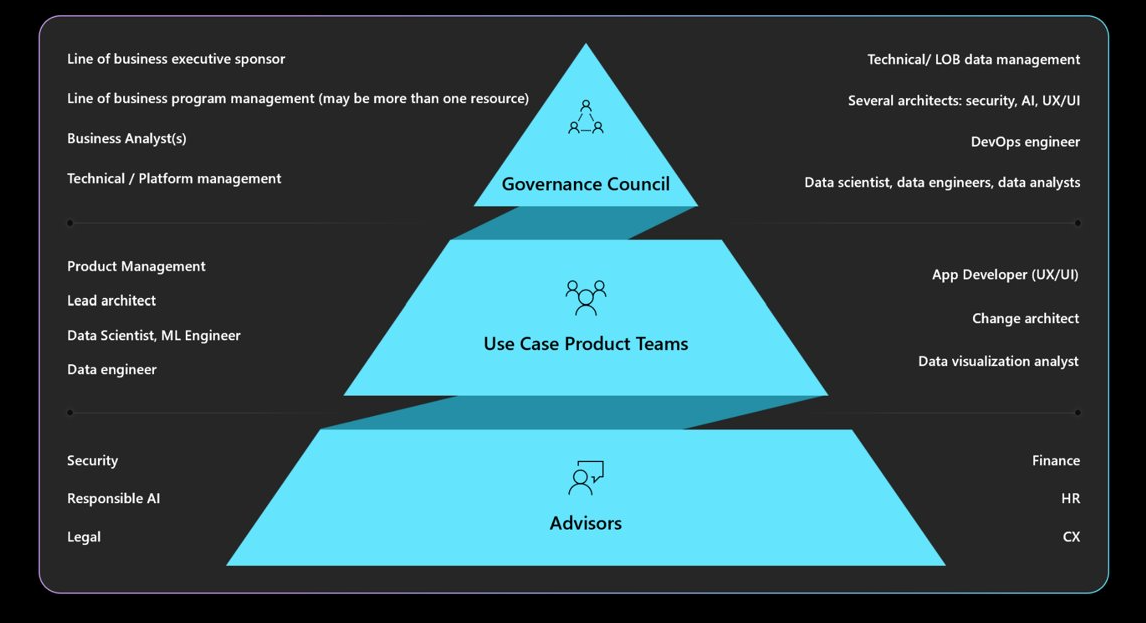

Zapoznaj się z wymaganymi mandatami dotyczącymi ładu, odpowiedzialności, przeglądu i raportowania. Upewnij się, że rada zarządzająca zatwierdza i podpisuje projekty zadań, aby uniknąć przeprojektowania i złagodzić problemy dotyczące bezpieczeństwa lub prywatności. Może być konieczne przejście przez wiele warstw zatwierdzenia. Na poniższym diagramie przedstawiono typową strukturę ładu w organizacji.

Aby uzyskać więcej informacji na temat zasad organizacyjnych i osób zatwierdzających, zobacz Definiowanie strategii odpowiedzialnej sztucznej inteligencji.

Zabezpieczanie środowiska użytkownika

Środowiska użytkownika powinny być oparte na wytycznych branżowych. Skorzystaj z biblioteki Microsoft Human-AI Experiences Design Library, która zawiera zasady i zawiera wytyczne dotyczące implementacji. Zawiera również przykłady z produktów firmy Microsoft i innych źródeł branżowych.

W całym cyklu życia interakcji użytkownika istnieją obowiązki związane z zadaniami. Zaczynają od intencji użytkownika do korzystania z systemu i są one kontynuowane przez całą sesję i podczas wszelkich zakłóceń, które powodują błędy systemowe. Rozważ następujące rozwiązania:

Budować przejrzystość. Uświadom użytkownikom, jak system generuje odpowiedzi na swoje zapytanie.

Dołącz linki do źródeł danych, które model konsultuje pod kątem przewidywań. Ta praktyka zwiększa pewność użytkownika, wyświetlając im źródła informacji. Projekt danych powinien zawierać te źródła w metadanych. Na przykład gdy orkiestrator w aplikacji rozszerzonej o funkcje pobierania wykonuje wyszukiwanie, pobiera 20 fragmentów dokumentu i wysyła 10 najwyżej ocenianych fragmentów do modelu jako kontekstu. 10 pierwszych fragmentów należy do trzech różnych dokumentów. Interfejs użytkownika może następnie odwoływać się do tych trzech dokumentów źródłowych podczas wyświetlania odpowiedzi modelu. Ta przejrzystość zwiększa zaufanie użytkowników.

Przejrzystość staje się ważniejsza w przypadku korzystania z agentów, które pełnią rolę pośredników między interfejsami frontonu i systemami zaplecza. Na przykład w systemie obsługi biletów kod orkiestracji interpretuje intencję użytkownika i wykonuje wywołania interfejsu programowania aplikacji (API) do agentów w celu pobrania niezbędnych informacji. Uwidacznianie tych interakcji ułatwia użytkownikowi zapoznanie się z akcjami systemu.

W przypadku zautomatyzowanych przepływów pracy obejmujących wielu agentów utwórz pliki dziennika, które rejestrują każdy krok. Pliki dziennika mogą pomóc w identyfikowaniu i poprawianiu błędów. Zapewniają również użytkownikom wyjaśnienie decyzji, które operacjonalizuje przejrzystość.

Uwaga

Podczas implementowania zaleceń dotyczących przejrzystości należy unikać przeciążania użytkownika zbyt dużą ilością informacji. Weź pod uwagę stopniowe podejście przy użyciu metod interfejsu użytkownika, które mają minimalny wpływ na zakłócenia.

Na przykład wyświetl podpowiedź, która pokazuje wartość pewności modelu. Możesz dołączyć linki, takie jak linki do dokumentów źródłowych, które użytkownicy mogą wybrać, aby uzyskać więcej szczegółów. Ta metoda zainicjowana przez użytkownika utrzymuje niezakłócony interfejs użytkownika i umożliwia użytkownikom wyszukiwanie dodatkowych informacji tylko wtedy, gdy sami na to się zdecydują.

Zbieraj opinie. Implementowanie mechanizmów przesyłania opinii.

Unikaj przytłaczających użytkowników z rozbudowanymi kwestionariuszami po każdej odpowiedzi. Zamiast tego używaj szybkich i prostych mechanizmów przesyłania opinii, takich jak kciuki w górę lub kciuk w dół, lub systemu klasyfikacji dla określonych aspektów odpowiedzi w skali od 1 do 5. Metody te pomagają ulepszyć system w czasie i umożliwiają uzyskanie szczegółowych informacji zwrotnych bez natrętnego działania. Należy pamiętać o potencjalnych problemach z sprawiedliwością w opiniach, ponieważ mogą istnieć dodatkowe przyczyny odpowiedzi użytkowników.

Implementowanie mechanizmu przesyłania opinii wpływa na architekturę ze względu na potrzebę przechowywania danych. Traktuj opinie, takie jak dane użytkowników, i zastosuj poziomy kontroli prywatności zgodnie z potrzebami.

Oprócz opinii zwrotnej zbieraj opinie na temat skuteczności środowiska użytkownika. Zbieraj metryki zaangażowania przez stos monitorowania systemu.

Operacjonalizacja środków bezpieczeństwa zawartości

Integrowanie bezpieczeństwa zawartości z każdym etapem cyklu życia sztucznej inteligencji przy użyciu niestandardowego kodu rozwiązania, odpowiednich narzędzi i skutecznych praktyk zabezpieczeń. Rozważ następujące strategie:

Anonimizuj dane. W miarę jak dane przechodzą od pozyskiwania do trenowania lub oceny, zaimplementuj kontrole na każdym etapie, aby zminimalizować ryzyko wycieku informacji osobistych i uniknąć ujawnienia danych użytkownika w surowej formie.

Moderowanie zawartości. Użyj interfejsu API bezpieczeństwa zawartości, który ocenia żądania i odpowiedzi w czasie rzeczywistym. Upewnij się, że te interfejsy API są osiągalne.

Identyfikowanie i eliminowanie zagrożeń. Zastosuj dobrze znane rozwiązania zabezpieczeń do scenariuszy sztucznej inteligencji. Na przykład należy przeprowadzić modelowanie zagrożeń, a następnie udokumentować zagrożenia i sposoby ich łagodzenia. Typowe rozwiązania w zakresie zabezpieczeń, takie jak ćwiczenia czerwonego zespołu, mają zastosowanie do obciążeń sztucznej inteligencji. Czerwone zespoły mogą sprawdzić, czy modele mogą być manipulowane w celu generowania szkodliwej zawartości. Te działania powinny być zintegrowane z operacjami sztucznej inteligencji.

Aby uzyskać informacje, zobacz Planowanie testów red team dla dużych modeli językowych i ich zastosowań.

Użyj odpowiednich metryk. Używaj metryk, które skutecznie mierzą zachowanie modelu. Metryki różnią się w zależności od typu modelu AI. W niektórych przypadkach pomiar modeli generowania może nie być stosowany do modeli regresji. Na przykład model przewiduje oczekiwaną długość życia, a wyniki wpływają na stawki ubezpieczeniowe. Problemy z sprawiedliwością w tym modelu mogą spowodować szkody związane z sprawiedliwością. Ten problem wynika z odchyleń w testach metryk podstawowych, ponieważ metryki sprawiedliwości i dokładności są zwykle połączone. Zwiększ dokładność, aby zmniejszyć szkody związane z sprawiedliwością.

Dodaj odpowiednią instrumentację. Wyniki modelu sztucznej inteligencji muszą być wyjaśnialne. Należy uzasadnić i śledzić sposób wnioskowania, w tym dane treningowe, funkcje obliczeniowe i dane uziemienia. W dyskryminacyjnej sztucznej inteligencji możesz uzasadnić decyzje krok po kroku. Jednak w przypadku modeli generujących wyniki mogą być złożone. Udokumentowanie procesu podejmowania decyzji w celu rozwiązania potencjalnych skutków prawnych i zapewnienia przejrzystości.

Należy zaimplementować ten aspekt objaśnienia w całym cyklu życia sztucznej inteligencji. Czyszczenie, pochodzenie danych, kryteria wyboru i przetwarzanie to kluczowe etapy, w których należy śledzić decyzje.

Narzędzia

Integrowanie narzędzi do zapewniania bezpieczeństwa zawartości i śledzenia danych, takich jak Microsoft Purview. Interfejsy API bezpieczeństwa zawartości usługi Azure AI można wywoływać z poziomu testowania w celu ułatwienia testowania zawartości.

Usługa Azure AI Foundry udostępnia metryki, które oceniają zachowanie modelu. Aby uzyskać więcej informacji, zobacz Metryki oceny i monitorowania dla generowania sztucznej inteligencji.

Aby przeanalizować modele szkoleniowe, zapoznaj się z metrykami dostarczanymi przez Azure Machine Learning .

Inspekcja danych przychodzących i wychodzących

Ataki polegających na wstrzyknięciu monitów, takich jak jailbreaking, są typowym problemem dla obciążeń sztucznej inteligencji. W takim przypadku niektórzy użytkownicy mogą próbować użyć modelu w niezamierzonych celach. Aby zapewnić bezpieczeństwo, sprawdzają dane, aby zapobiec atakom i odfiltrować nieodpowiednią zawartość. Zastosuj tę analizę zarówno do danych wejściowych użytkownika, jak i odpowiedzi systemu, aby zapewnić dokładne moderowanie zawartości w przepływach przychodzących i przepływach wychodzących.

W niektórych przypadkach należy wykonać wiele wywołań modelu, takich jak usługa Azure OpenAI Service, aby obsłużyć pojedyncze żądanie klienta. W tych przypadkach przeprowadzanie kontroli bezpieczeństwa treści dla każdego wywołania może być kosztowne i niepotrzebne. Rozważ scentralizowanie pracy w architekturze przy jednoczesnym zachowaniu zabezpieczeń jako odpowiedzialności po stronie serwera. Załóżmy, że architektura ma bramę przed punktem końcowym wnioskowania modelu, aby odciążyć określone możliwości zaplecza. Bramę można zaprojektować tak, aby obsługiwała kontrole bezpieczeństwa zawartości dla żądań i odpowiedzi, których zaplecze może nie obsługiwać natywnie. Chociaż brama jest typowym rozwiązaniem, warstwa orkiestracji może efektywnie obsługiwać te zadania w prostszych architekturach. W obu przypadkach można selektywnie zastosować te kontrole w razie potrzeby, co optymalizuje wydajność i koszty.

Inspekcje powinny być wielomodalne i obejmować różne formaty. Jeśli używasz danych wejściowych wielomodalnych, takich jak obrazy, ważne jest, aby analizować je pod kątem ukrytych komunikatów, które mogą być szkodliwe lub brutalne. Te komunikaty mogą nie być natychmiast widoczne, dlatego wymagają starannej kontroli. W tym celu użyj narzędzi takich jak interfejsy API bezpieczeństwa zawartości.

Aby ułatwić egzekwowanie zasad ochrony prywatności i bezpieczeństwa danych, sprawdź dane użytkowników i dane referencyjne pod kątem zgodności z przepisami dotyczącymi prywatności. Upewnij się, że dane są czyszczone lub filtrowane, gdy przepływa przez system. Na przykład dane z poprzednich rozmów z pomocą techniczną klienta mogą służyć jako dane podstawowe. Te dane powinny zostać oczyszczone przed ponownym użyciem.

Odpowiednie obsługa danych użytkownika

Odpowiedzialne rozwiązania obejmują staranne zarządzanie danymi użytkowników. Takie zarządzanie obejmuje wiedzę o tym, kiedy należy używać danych i kiedy unikać polegania na danych użytkownika.

Przećwicz wnioskowanie bez udostępniania danych użytkownika. Aby bezpiecznie udostępniać dane użytkowników innym organizacjom w celu uzyskania szczegółowych informacji, użyj modelu rozliczeń. W tym scenariuszu organizacje dostarczają dane zaufanemu partnerowi, który szkoli model przy użyciu zagregowanych danych. Następnie wszystkie instytucje mogą korzystać z tego modelu i udostępniać szczegółowe informacje bez uwidaczniania poszczególnych zestawów danych. Celem jest użycie możliwości wnioskowania modelu bez udostępniania szczegółowych danych szkoleniowych.

Promowanie różnorodności i niekluzywności. Gdy dane dotyczące użytkowników są niezbędne, użyj zróżnicowanego zakresu danych, w tym niedostatecznie reprezentowanych gatunków i twórców, aby zmniejszyć ryzyko niesprawiedliwości. Zaimplementuj funkcje, które zachęcają użytkowników do eksplorowania nowej i zróżnicowanej zawartości. Monitoruj użycie na bieżąco i dostosowuj zalecenia, aby uniknąć nadmiernego przedstawiania pojedynczego typu zawartości.

Szanuj RTBF. Unikaj używania danych użytkownika, jeśli to możliwe. Pomóż zapewnić zgodność z protokołem RTBF, stosując niezbędne środki, aby upewnić się, że dane użytkownika są usuwane pilnie.

Aby zapewnić zgodność, mogą istnieć żądania usunięcia danych użytkownika z systemu. W przypadku mniejszych modeli można usunąć dane użytkownika przez ponowne trenowanie modelu przy użyciu danych wykluczających dane osobowe. W przypadku większych modeli, które mogą składać się z kilku mniejszych, niezależnie wytrenowanych modeli, proces jest bardziej złożony, a koszt i nakład pracy jest znaczący. Poszukaj wskazówek prawnych i etycznych dotyczących obsługi tych sytuacji i pamiętaj, aby uwzględnić wskazówki w zasadach dotyczących odpowiedzialnej sztucznej inteligencji.

Zachowywanie danych w sposób odpowiedzialny. Gdy usunięcie danych nie jest możliwe, uzyskaj jawną zgodę użytkownika na zbieranie danych i podaj jasne zasady ochrony prywatności. Zbieranie i przechowywanie danych tylko wtedy, gdy jest to absolutnie konieczne. Miej procedury, które umożliwiają agresywne usuwanie danych, gdy nie są już potrzebne. Na przykład wyczyść historię czatów tak szybko, jak to jest praktyczne, i anonimizuj poufne dane przed przechowywaniem. Użyj zaawansowanych metod szyfrowania dla danych w stanie spoczynku.

Wspieraj objaśnialność. Decyzje dotyczące śledzenia w systemie w celu obsługi wymagań dotyczących możliwości wyjaśnienia. Opracuj jasne wyjaśnienia sposobu działania algorytmów rekomendacji. Udostępnianie użytkownikom szczegółowych informacji o tym, dlaczego jest im zalecana konkretna zawartość. Celem jest zapewnienie, że obciążenia sztucznej inteligencji i ich wyniki są przejrzyste i uzasadnione, szczegółowo opisując sposób podejmowania decyzji, danych, których używają, i sposobu trenowania modeli.

Szyfrowanie danych użytkownika. Dane wejściowe muszą być szyfrowane na każdym etapie potoku przetwarzania danych od momentu wprowadzenia danych przez użytkownika. Te etapy obejmują dane w trakcie przechodzenia z jednego punktu do drugiego, dane, które są przechowywane, oraz dane, które są wnioskowane, w razie potrzeby. Zrównoważ bezpieczeństwo i funkcjonalność oraz dąż do utrzymania prywatności danych przez cały ich cykl życia.

Zapewnianie niezawodnych mechanizmów kontroli dostępu. Kilka typów tożsamości może potencjalnie uzyskiwać dostęp do danych użytkownika. Zaimplementuj kontrolę dostępu opartą na rolach zarówno dla płaszczyzny sterowania, jak i płaszczyzny danych, aby obejmowała komunikację między użytkownikami i systemami.

Zachowaj odpowiednią segmentację użytkowników, aby chronić prywatność. Na przykład rozwiązanie Microsoft 365 Copilot może wyszukiwać i udostępniać odpowiedzi na podstawie określonych dokumentów i wiadomości e-mail użytkownika, zapewniając jednocześnie, że dostęp do tej zawartości jest uzyskiwany tylko dla tego użytkownika.

Zmniejsz obszar powierzchni. Podstawową strategią filaru zabezpieczeń Well-Architected Framework jest zminimalizowanie obszaru podatnego na ataki i wzmocnienie zasobów. Należy zastosować tę strategię do standardowych praktyk zabezpieczeń punktów końcowych, ściśle kontrolując punkty końcowe interfejsu API, ujawniając tylko niezbędne dane i unikając nadmiarowych informacji w odpowiedziach. Zrównoważ wybór projektu między elastycznością a kontrolą.

Upewnij się, że nie ma żadnych anonimowych punktów końcowych. Ogólnie rzecz biorąc, unikaj zapewniania użytkownikom większej kontroli niż jest to konieczne. W większości scenariuszy użytkownicy nie muszą dostosowywać hiperparametrów z wyjątkiem środowisk eksperymentalnych. W przypadku typowych przypadków użycia, takich jak interakcja z agentem wirtualnym, użytkownicy powinni kontrolować tylko podstawowe aspekty, aby zapewnić bezpieczeństwo przez ograniczenie niepotrzebnej kontroli.

Aby uzyskać więcej informacji, zobacz Projektowanie aplikacji dla obciążeń sztucznej inteligencji na platformie Azure.