Omówienie maszyny wirtualnej serii HX

Dotyczy: ✔️ Maszyny wirtualne z systemem Linux Maszyny ✔️ wirtualne z systemem Windows ✔️ — elastyczne zestawy ✔️ skalowania

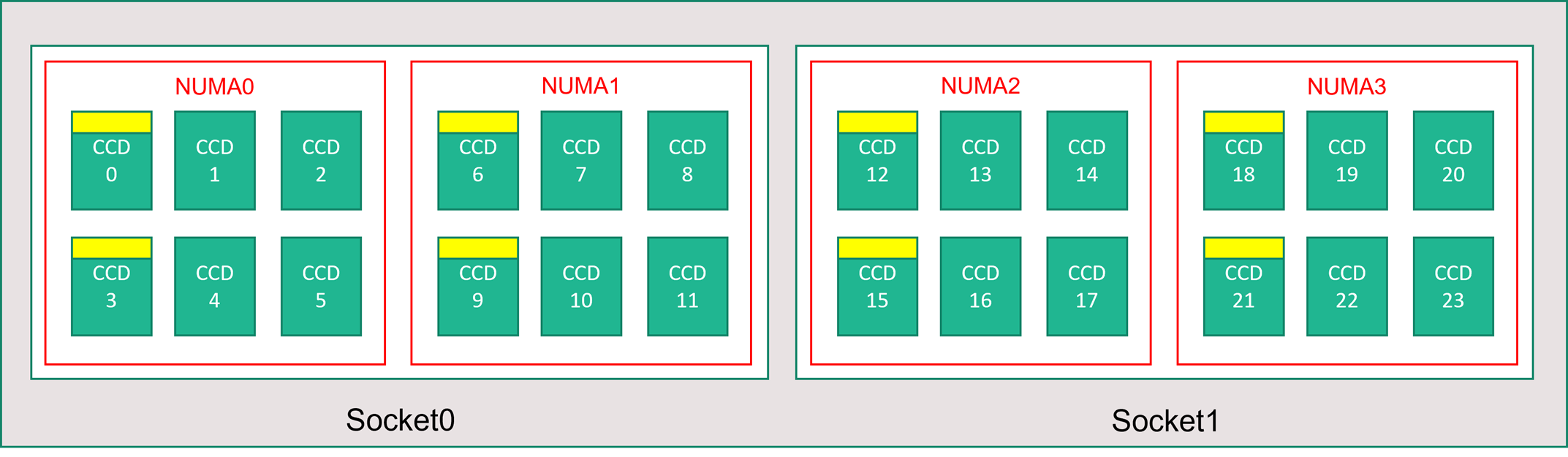

Serwer serii HX zawiera 2 * 96-rdzeniowe procesory EPYC 9V33X dla łącznie 192 fizycznych rdzeni "Zen4" z pamięcią podręczną AMD 3D-V. Jednoczesne wielowątkowość (SMT) jest wyłączona w HX. Te 192 rdzenie są podzielone na 24 sekcje (12 na gniazdo), każda sekcja zawierająca 8 rdzeni procesora z jednolity dostęp do pamięci podręcznej L3 96 MB. Serwery HX platformy Azure uruchamiają również następujące ustawienia systemu BIOS firmy AMD:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

W związku z tym serwer uruchamia się z 4 domenami NUMA (2 na gniazdo) o rozmiarze 48 rdzeni. Każda architektura NUMA ma bezpośredni dostęp do 6 kanałów fizycznego DRAM.

Aby zapewnić miejsce na działanie funkcji hypervisor platformy Azure bez zakłócania działania maszyny wirtualnej, rezerwujemy 16 rdzeni fizycznych na serwer.

Topologia maszyny wirtualnej

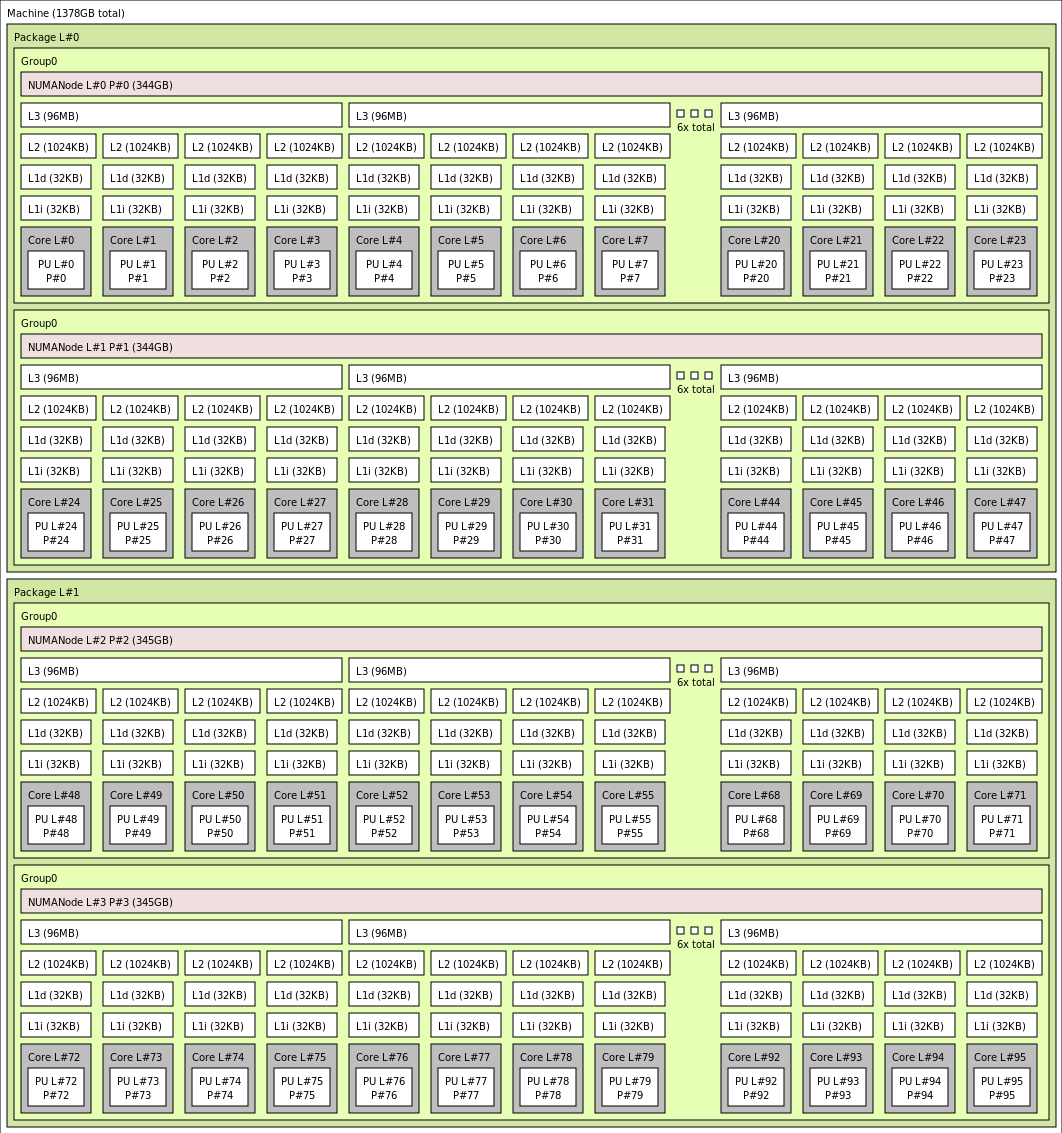

Na poniższym diagramie przedstawiono topologię serwera. Rezerwujemy te 16 rdzeni hosta funkcji hypervisor (żółty) symetrycznie w obu gniazdach procesora CPU, biorąc pierwsze 2 rdzenie z określonych rdzeni złożonych dies (CCD) w każdej domenie NUMA, z pozostałymi rdzeniami maszyny wirtualnej serii HX (zielony).

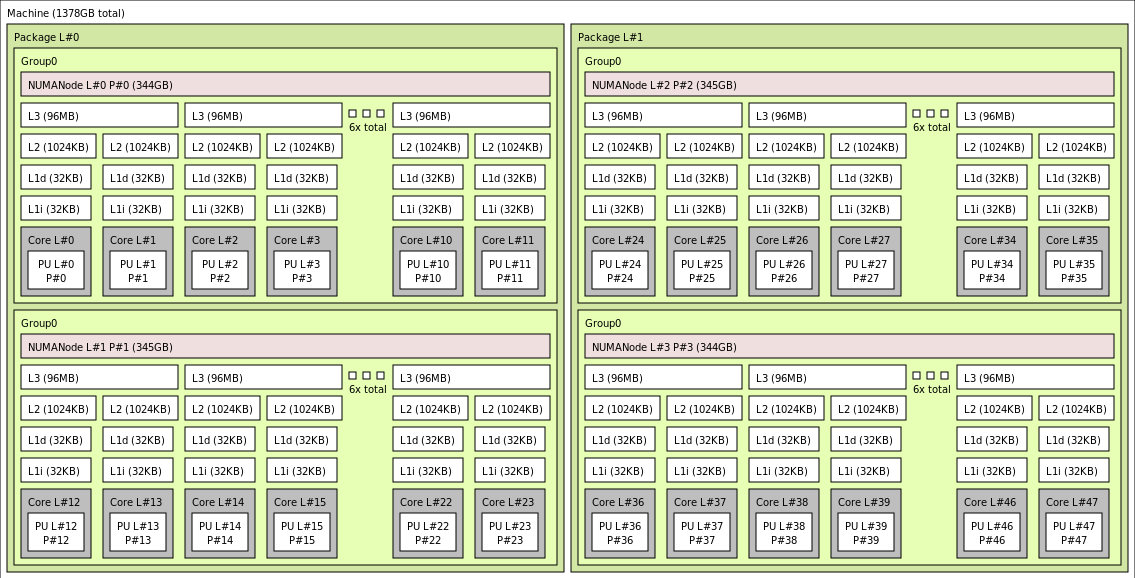

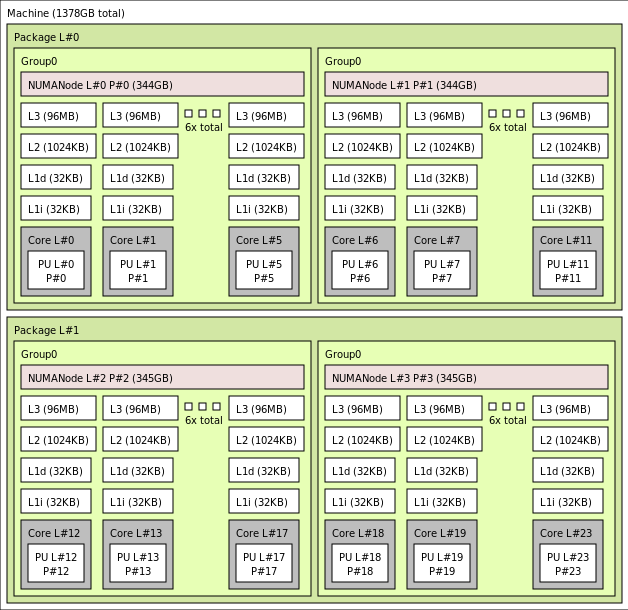

Granica CCD różni się od granicy NUMA. W HX grupa sześciu (6) kolejnych CCDs jest skonfigurowana jako domena NUMA, zarówno na poziomie serwera hosta, jak i na maszynie wirtualnej gościa. W związku z tym wszystkie rozmiary maszyn wirtualnych HX uwidaczniają 4 jednolite domeny NUMA, które będą wyświetlane w systemie operacyjnym i aplikacji, jak pokazano poniżej, każdy z różnymi liczbą rdzeni w zależności od określonego rozmiaru maszyny wirtualnej HX.

Każdy rozmiar maszyny wirtualnej HX jest podobny w układzie fizycznym, funkcjach i wydajności innego procesora CPU niż seria AMD EPYC 9004 w następujący sposób:

| Rozmiar maszyny wirtualnej serii HX | Domeny NUMA | Rdzenie na domenę NUMA | Podobieństwo z procesorem AMD EPYC |

|---|---|---|---|

| Standard_HX176rs | 100 | 44 | Podwójne gniazdo EPYC 9V33X |

| Standard_HX176-144rs | 100 | 36 | Podwójne gniazdo EPYC 9V33X |

| Standard_HX176-96rs | 100 | 24 | Podwójne gniazdo EPYC 9V33X |

| Standard_HX176-48rs | 4 | 12 | Podwójne gniazdo EPYC 9V33X |

| Standard_HX176-24rs | 100 | 6 | Podwójne gniazdo EPYC 9V33X |

Uwaga

Ograniczone rozmiary maszyn wirtualnych rdzeni zmniejszają tylko liczbę rdzeni fizycznych uwidocznionych dla maszyny wirtualnej. Wszystkie globalne zasoby udostępnione (pamięć RAM, przepustowość pamięci, pamięć podręczna L3, łączność GMI i xGMI, InfiniBand, sieć Ethernet platformy Azure, lokalny dysk SSD) pozostają stałe. Dzięki temu klient może wybrać rozmiar maszyny wirtualnej najlepiej dostosowany do danego zestawu wymagań dotyczących obciążeń lub licencjonowania oprogramowania.

Wirtualne mapowanie architektury NUMA każdego rozmiaru maszyny wirtualnej HX jest mapowane na podstawową fizyczną topologię NUMA. Nie ma potencjalnej mylącej abstrakcji topologii sprzętu.

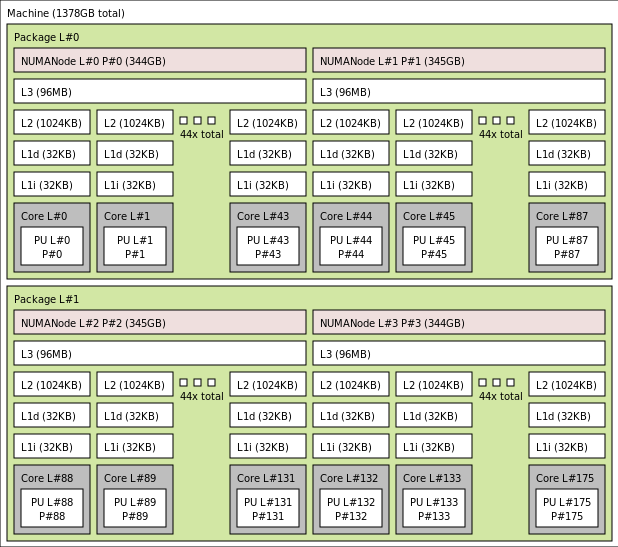

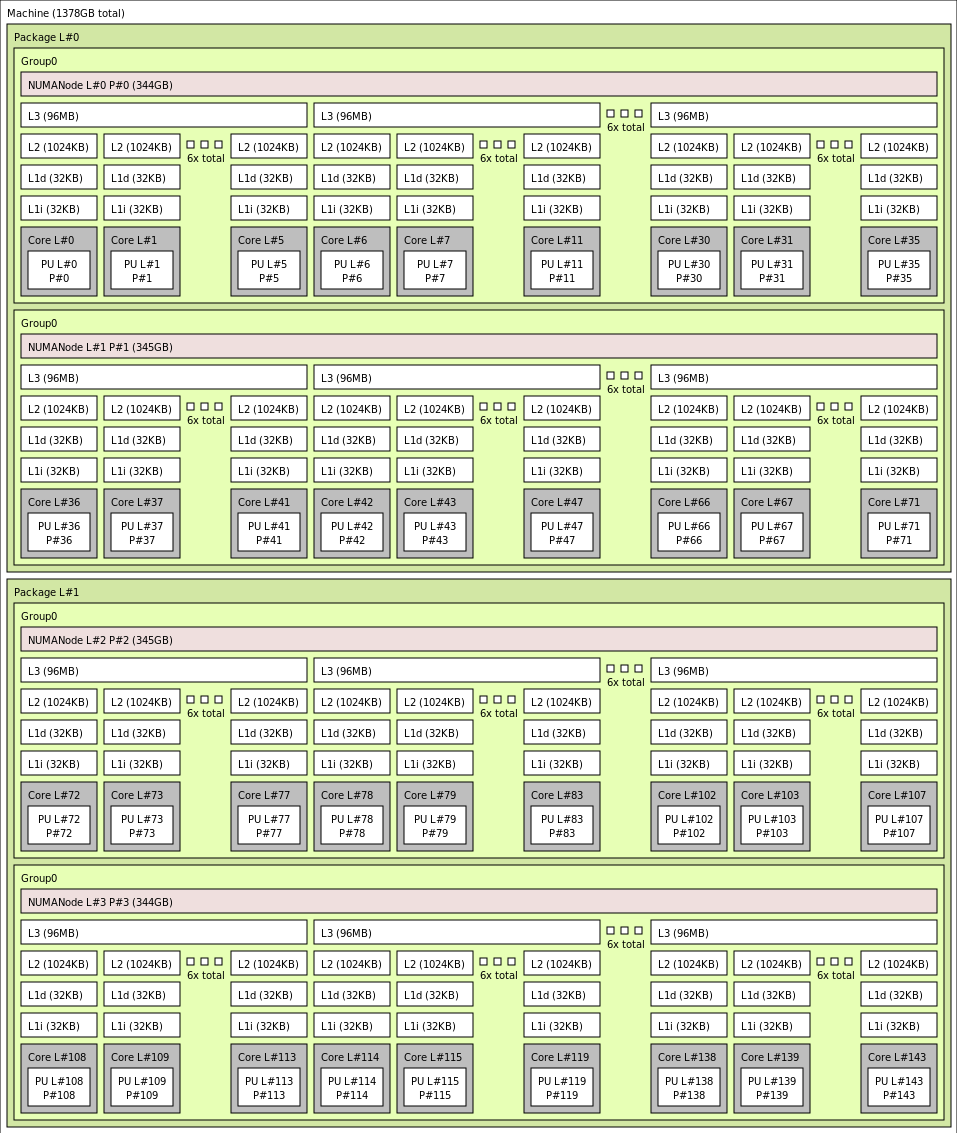

Dokładna topologia dla różnych rozmiarów maszyn wirtualnych HX jest wyświetlana w następujący sposób przy użyciu danych wyjściowych lstopo:

lstopo-no-graphics --no-io --no-legend --of txt

Kliknij, aby wyświetlić dane wyjściowe lstopo dla Standard_HX176rs

Kliknij, aby wyświetlić dane wyjściowe lstopo dla Standard_HX176-144rs

Kliknij, aby wyświetlić dane wyjściowe lstopo dla Standard_HX176-96rs

Kliknij, aby wyświetlić dane wyjściowe lstopo dla Standard_HX176-48rs

Kliknij, aby wyświetlić dane wyjściowe lstopo dla Standard_HX176-24rs

Sieć InfiniBand

Maszyny wirtualne HX oferują również karty sieciowe NVIDIA Mellanox NDR InfiniBand (ConnectX-7) działające z maksymalnie 400 Gigabits/s. Karta sieciowa jest przekazywana do maszyny wirtualnej za pośrednictwem SRIOV, umożliwiając ruch sieciowy w celu obejścia funkcji hypervisor. W rezultacie klienci ładują standardowe sterowniki Mellanox OFED na maszynach wirtualnych HX, ponieważ byłyby to środowisko bez systemu operacyjnego.

Maszyny wirtualne HX obsługują routing adaptacyjny, dynamiczny transport połączony (DCT, oprócz standardowych transportów RC i UD) oraz odciążanie sprzętowe kolektywów MPI do procesora dołączanego adaptera ConnectX-7. Te funkcje zwiększają wydajność aplikacji, skalowalność i spójność, a ich użycie jest zalecane.

Magazyn tymczasowy

Maszyny wirtualne HX zawierają 3 fizyczne lokalne urządzenia SSD. Jedno urządzenie jest wstępnie sformatowane, aby służyło jako plik strony i było wyświetlane na maszynie wirtualnej jako ogólne urządzenie SSD.

Dwa inne, większe dyski SSD są udostępniane jako niesformatowane urządzenia NVMe bloku za pośrednictwem NVMeDirect. Ponieważ blokowe urządzenie NVMe pomija funkcję hypervisor, ma wyższą przepustowość, większą liczbę operacji we/wy na sekundę i mniejsze opóźnienia na operację we/wy na sekundę.

W przypadku parowania w tablicy rozłożonej dysk SSD NVMe zapewnia do 12 GB/s odczytów i 7 GB/s operacji zapisu oraz maksymalnie 186 000 operacji we/wy na sekundę (odczyty) i 201 000 operacji we/wy na sekundę (zapisów) na potrzeby głębokości kolejek.

Specyfikacje sprzętowe

| Specyfikacje sprzętowe | Maszyny wirtualne serii HX |

|---|---|

| Rdzenie | 176, 144, 96, 48 lub 24 (wyłączono protokół SMT) |

| Procesor CPU | AMD EPYC 9V33X |

| Częstotliwość procesora CPU (inne niż AVX) | Podstawa 2,4 GHz, szczytowa moc 3,7 GHz |

| Pamięć | 1,4 TB (pamięć RAM na rdzeń zależy od rozmiaru maszyny wirtualnej) |

| Dysk lokalny | 2 * 1,8 TB NVMe (blok), 480 GB SSD (plik stronicowy) |

| InfiniBand | 400 Gb/s Mellanox ConnectX-7 NDR InfiniBand |

| Sieć | Sieć Ethernet 80 Gb/s (40 Gb/s do użycia) Azure Second Gen SmartNIC |

Specyfikacje oprogramowania

| Specyfikacje oprogramowania | Maszyny wirtualne serii HX |

|---|---|

| Maksymalny rozmiar zadania MPI | 52 800 rdzeni (300 maszyn wirtualnych w jednym zestawie skalowania maszyn wirtualnych z singlePlacementGroup=true) |

| Obsługa interfejsu MPI | HPC-X (2.13 lub nowszy), Intel MPI (2021.7.0 lub nowszy), OpenMPI (4.1.3 lub nowszy), MVAPICH2 (2.3.7 lub nowszy), MPICH (4.1 lub nowszy) |

| Dodatkowe struktury | UCX, libfabric, PGAS lub inne środowiska uruchomieniowe oparte na rozwiązaniu InfiniBand |

| Obsługa usługi Azure Storage | Dyski w warstwie Standardowa i Premium (maksymalnie 32 dyski), Azure NetApp Files, Azure Files, Azure HPC Cache, Azure Managed Lustre File System |

| Obsługiwany i zweryfikowany system operacyjny | AlmaLinux 8.6, 8.7, Ubuntu 20.04+ |

| Zalecany system operacyjny pod kątem wydajności | AlmaLinux HPC 8.7, Ubuntu-HPC 20.04+ |

| Obsługa programu Orchestrator | Azure CycleCloud, Azure Batch, AKS; opcje konfiguracji klastra |

Uwaga

- Te maszyny wirtualne obsługują tylko generację 2.

- Oficjalne wsparcie na poziomie jądra firmy AMD rozpoczyna się od RHEL 8.6 i AlmaLinux 8.6, który jest pochodną RHEL.

- System Windows Server 2012 R2 nie jest obsługiwany na maszynach HX i innych maszynach wirtualnych z więcej niż 64 rdzeniami (wirtualnymi lub fizycznymi). Aby uzyskać więcej informacji, zobacz Obsługiwane systemy operacyjne gościa systemu Windows dla funkcji Hyper-V w systemie Windows Server. System Windows Server 2022 jest wymagany w przypadku rozmiarów rdzeni 144 i 176, system Windows Server 2016 działa również dla 24, 48 i 96 rdzeni, system Windows Server działa tylko dla 24 i 48 rdzeni.

Ważne

Zalecana nazwa URN obrazu: almalinux:almalinux-hpc:8_7-hpc-gen2:8.7.2023060101, Aby wdrożyć ten obraz za pośrednictwem interfejsu wiersza polecenia platformy Azure, upewnij się, że uwzględniono następujące parametry : --plan 8_7-hpc-gen2 --product almalinux-hpc --publisher almalinux. W przypadku testów skalowania użyj zalecanej nazwy URN wraz z nowym tarballem HPC-X.

Uwaga

- Obsługa NDR jest dodawana w wersji UCX 1.13 lub nowszej. Starsze wersje UCX będą zgłaszać powyższy błąd środowiska uruchomieniowego. Błąd UCX: Nieprawidłowa aktywna szybkość

[1677010492.951559] [updsb-vm-0:2754 :0] ib_iface.c:1549 UCX ERROR Invalid active_speed on mlx5_ib0:1: 128. - Ibstat pokazuje niską prędkość (SDR): starsze wersje Mellanox OFED (MOFED) nie obsługują NDR i może zgłaszać wolniejsze prędkości IB. Użyj wersji MOFED MOFED 5.6-1.0.3.3 lub nowszej.

Następne kroki

- Przeczytaj o najnowszych ogłoszeniach, przykładach obciążeń HPC i wynikach wydajności na blogach społeczności technicznej usługi Azure Compute.

- Aby uzyskać widok architektury wyższego poziomu na potrzeby uruchamiania obciążeń HPC, zobacz Obliczenia o wysokiej wydajności (HPC) na platformie Azure.