Pobieranie rozszerzonej generacji przy użyciu przepływu monitu usługi Azure Machine Learning (wersja zapoznawcza)

Ważne

Ta funkcja jest obecnie w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone.

Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

Pobieranie rozszerzonej generacji (RAG) to wzorzec, który współpracuje ze wstępnie wytrenowanym dużymi modelami językowymi (LLM) i własnymi danymi w celu wygenerowania odpowiedzi. W usłudze Azure Machine Learning można teraz zaimplementować narzędzie RAG w natychmiastowym przepływie. Obsługa RAG jest obecnie dostępna w publicznej wersji zapoznawczej.

W tym artykule wymieniono niektóre korzyści z programu RAG, przedstawiono omówienie techniczne i opisano obsługę rag w usłudze Azure Machine Learning.

Uwaga

Czy dopiero zaczynasz korzystać z koncepcji LLM i RAG? Ten klip wideo z prezentacji firmy Microsoft oferuje proste wyjaśnienie.

Dlaczego warto używać programu RAG?

Tradycyjnie model podstawowy jest trenowany przy użyciu danych punkt-w czasie w celu zapewnienia skuteczności wykonywania określonych zadań i dostosowywania się do żądanej domeny. Jednak czasami trzeba pracować z nowszymi lub bardziej aktualnymi danymi. Dwa podejścia mogą uzupełniać model podstawowy: dostrajanie lub dalsze szkolenie modelu podstawowego przy użyciu nowych danych lub RAG, które używają monitu inżynieryjnego do uzupełnienia lub kierowania modelem w czasie rzeczywistym.

Dostrajanie jest odpowiednie do ciągłej adaptacji domeny, co umożliwia znaczne ulepszenia jakości modelu, ale często wiąże się z wyższymi kosztami. Z drugiej strony funkcja RAG oferuje alternatywne podejście, umożliwiając korzystanie z tego samego modelu co aparat rozumowania w przypadku nowych danych dostarczonych w wierszu polecenia. Ta technika umożliwia uczenie w kontekście bez konieczności kosztownego dostrajania, co umożliwia firmom wydajniejsze korzystanie z funkcji LLM.

Rozwiązanie RAG umożliwia firmom osiągnięcie dostosowanych rozwiązań przy zachowaniu istotności danych i optymalizacji kosztów. Przyjmując rag, firmy mogą używać możliwości rozumowania llMs, wykorzystując swoje istniejące modele do przetwarzania i generowania odpowiedzi na podstawie nowych danych. Program RAG ułatwia okresowe aktualizacje danych bez konieczności precyzyjnego dostrajania, usprawniając integrację oprogramowania LLMs z firmami.

- Podaj dane uzupełniające jako dyrektywę lub monit do usługi LLM

- Dodaje składnik sprawdzania faktów w istniejących modelach

- Trenowanie modelu na aktualnych danych bez ponoszenia dodatkowego czasu i kosztów związanych z dostrajaniem

- Trenowanie na danych specyficznych dla firmy

Omówienie techniczne korzystania z programu RAG w przypadku dużych modeli językowych (LLMs)

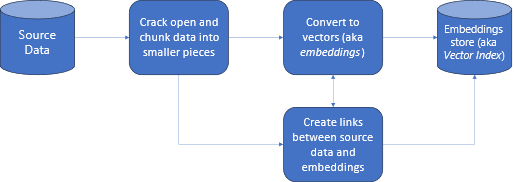

W przypadku pobierania informacji rag jest podejściem, które umożliwia wykorzystanie możliwości llMs z własnymi danymi. Włączenie funkcji LLM w celu uzyskania dostępu do danych niestandardowych obejmuje następujące kroki. Najpierw duże dane powinny być podzielone na zarządzane elementy. Po drugie fragmenty muszą zostać przekonwertowane na format z możliwością wyszukiwania. Po trzecie, przekonwertowane dane powinny być przechowywane w lokalizacji, która umożliwia wydajny dostęp. Ponadto ważne jest przechowywanie odpowiednich metadanych w przypadku cytatów lub odwołań, gdy usługa LLM udostępnia odpowiedzi.

Przyjrzyjmy się bardziej szczegółowo diagramowi.

Dane źródłowe: to miejsce, w którym istnieją twoje dane. Może to być plik/folder na maszynie, plik w magazynie w chmurze, zasób danych usługi Azure Machine Learning, repozytorium Git lub baza danych SQL.

Fragmentowanie danych: dane w źródle muszą zostać przekonwertowane na zwykły tekst. Na przykład dokumenty programu Word lub pliki PDF muszą być otwierane i konwertowane na tekst. Tekst jest następnie podzielony na mniejsze fragmenty.

Konwertowanie tekstu na wektory: nazywane osadzaniem. Wektory to liczbowe reprezentacje pojęć konwertowanych na sekwencje liczbowe, co ułatwia komputerom zrozumienie relacji między tymi pojęciami.

Linki między danymi źródłowymi i osadzaniem: te informacje są przechowywane jako metadane we utworzonych fragmentach, które są następnie używane do wspierania funkcji LLM do generowania cytatów podczas generowania odpowiedzi.

RAG z usługą Azure Machine Learning (wersja zapoznawcza)

Funkcja RAG w usłudze Azure Machine Learning jest włączona przez integrację z usługą Azure OpenAI Service na potrzeby dużych modeli językowych i wektoryzacji, z obsługą faiss i usługi Azure AI Search (dawniej Cognitive Search) jako magazynów wektorów oraz obsługę narzędzi i struktur typu open source, takich jak LangChain na potrzeby fragmentowania danych.

Aby zaimplementować usługę RAG, należy spełnić kilka kluczowych wymagań. Najpierw dane powinny być sformatowane w sposób umożliwiający efektywne wyszukiwanie przed wysłaniem ich do usługi LLM, co ostatecznie zmniejsza użycie tokenu. Aby zapewnić skuteczność programu RAG, ważne jest również regularne aktualizowanie danych w regularnych okresach. Ponadto możliwość oceny danych wyjściowych z usługi LLM przy użyciu danych umożliwia mierzenie skuteczności technik. Usługa Azure Machine Learning nie tylko pozwala łatwo rozpocząć pracę na tych aspektach, ale także umożliwia ulepszanie i produkcję rag. Oferty usługi Azure Machine Learning:

- Przykłady uruchamiania scenariuszy Q&A opartych na technologii RAG.

- Środowisko interfejsu użytkownika oparte na kreatorze w celu tworzenia danych i zarządzania nimi oraz dołączania ich do przepływów monitów.

- Możliwość mierzenia i ulepszania przepływów pracy RAG, w tym generowania danych testowych, automatycznego tworzenia monitów i wizualizowania metryk oceny monitów.

- Zaawansowane scenariusze z większą kontrolą przy użyciu nowych wbudowanych składników RAG do tworzenia niestandardowych potoków w notesach.

- Środowisko kodu, które umożliwia wykorzystanie danych utworzonych za pomocą ofert typu open source, takich jak LangChain.

- Bezproblemowa integracja przepływów pracy RAG z przepływami pracy metodyki MLOps przy użyciu potoków i zadań.

Podsumowanie

Usługa Azure Machine Learning umożliwia dołączenie rozwiązania RAG do sztucznej inteligencji przy użyciu usługi Azure Machine Learning Studio lub użycia kodu z potokami usługi Azure Machine Learning. Oferuje on kilka dodatków o wartości, takich jak możliwość mierzenia i ulepszania przepływów pracy RAG, generowania danych testowych, automatycznego tworzenia monitów i wizualizowania metryk oceny monitów. Umożliwia integrację przepływów pracy RAG z przepływami pracy metodyki MLOps przy użyciu potoków. Możesz również używać swoich danych z ofertami typu open source, takimi jak LangChain.

Następne kroki

Używanie magazynów wektorów z usługą Azure Machine Learning (wersja zapoznawcza)

Jak utworzyć indeks wektorów w przepływie monitów usługi Azure Machine Learning (wersja zapoznawcza)