Nawiązywanie połączenia z usługami azure AI z przepływów pracy w usłudze Azure Logic Apps

Dotyczy: Azure Logic Apps (Zużycie + Standardowa)

Aby zintegrować usługi, systemy i dane przedsiębiorstwa z technologiami sztucznej inteligencji, przepływy pracy aplikacji logiki mogą łączyć się z zasobami azure OpenAI i Azure AI Search używanymi w tych scenariuszach integracji.

Ten przewodnik zawiera omówienie i przykłady pokazujące, jak używać operacji łącznika Azure OpenAI i Azure AI Search w przepływie pracy.

Dlaczego warto używać usługi Azure Logic Apps z usługami sztucznej inteligencji?

Zazwyczaj tworzenie rozwiązań sztucznej inteligencji obejmuje kilka kluczowych kroków i wymaga kilku bloków konstrukcyjnych. Przede wszystkim musisz mieć dynamiczny potok pozyskiwania i interfejs czatu, który może komunikować się z dużymi modelami językowymi (LLMs) i bazami danych wektorów.

Napiwek

Aby dowiedzieć się więcej, możesz zadać następujące pytania dotyczące platformy Azure Copilot:

- Co to jest dynamiczny potok pozyskiwania danych w sztucznej inteligencji?

- Co to jest wektorowa baza danych w sztucznej inteligencji?

Aby znaleźć narzędzie Azure Copilot, na pasku narzędzi witryny Azure Portal wybierz pozycję Copilot.

Można tworzyć różne składniki, nie tylko do wykonywania pozyskiwania danych, ale także w celu zapewnienia niezawodnego zaplecza dla interfejsu czatu. To zaplecze ułatwia wprowadzanie monitów i generowanie zależnych odpowiedzi podczas interakcji. Jednak utworzenie kodu do zarządzania wszystkimi tymi elementami i kontrolowania ich może stanowić wyzwanie, co jest możliwe w przypadku większości rozwiązań.

Usługa Azure Logic Apps oferuje niskie podejście do kodu i upraszcza zarządzanie zapleczem, udostępniając wstępnie utworzone łączniki, których używasz jako bloków konstrukcyjnych w celu usprawnienia procesu zaplecza. Takie podejście pozwala skupić się na określaniu źródła danych i upewnieniu się, że wyniki wyszukiwania zawierają bieżące i istotne informacje. Dzięki tym łącznikom sztucznej inteligencji przepływ pracy działa jako aparat aranżacji, który przesyła dane między usługami sztucznej inteligencji a innymi składnikami, które chcesz zintegrować.

Aby uzyskać więcej informacji, zobacz następujące zasoby:

Wymagania wstępne

Konto i subskrypcja platformy Azure. Jeśli nie masz subskrypcji platformy Azure, zarejestruj się w celu założenia bezpłatnego konta platformy Azure.

Zasoby usługi Azure AI Search i Azure OpenAI w celu uzyskiwania dostępu do przepływu pracy i ich używania, w tym informacje o połączeniu:

Przepływ pracy aplikacji logiki, w którym chcesz uzyskać dostęp do zasobów usługi Azure OpenAI i usługi Azure AI Search.

Łączniki dla tych usług obecnie udostępniają tylko akcje, a nie wyzwalacze. Przed dodaniem akcji łącznika usługi Azure AI upewnij się, że przepływ pracy rozpoczyna się od odpowiedniego wyzwalacza dla danego scenariusza.

Dokumentacja techniczna łącznika

W przepływach pracy Zużycie łączniki zarządzane przez usługę Azure OpenAI i Azure AI Search lub "udostępnione" są obecnie dostępne w wersji zapoznawczej i podlegają dodatkowym warunkom użytkowania dla wersji zapoznawczej platformy Microsoft Azure.

Azure OpenAI

Usługa Azure OpenAI Service zapewnia dostęp do modeli językowych openAI, w tym GPT-4, GPT-4 Turbo z usługą Vision, GPT-3.5-Turbo i serią modeli Osadzanie. Za pomocą łącznika Azure OpenAI przepływ pracy może łączyć się z usługą Azure OpenAI Service i pobierać osadzanie openAI dla danych lub generować uzupełnienia czatów.

Napiwek

Aby dowiedzieć się więcej, możesz zadać następujące pytania dotyczące platformy Azure Copilot:

- Co to jest osadzanie w sztucznej inteligencji?

- Co to jest ukończenie czatu w sztucznej inteligencji?

Aby znaleźć narzędzie Azure Copilot, na pasku narzędzi witryny Azure Portal wybierz pozycję Copilot.

Łącznik azure OpenAI ma różne wersje na podstawie typu aplikacji logiki i modelu hostingu:

| Aplikacja logiki | Środowisko | Wersja łącznika |

|---|---|---|

| Zużycie | Wielodostępna usługa Azure Logic Apps | Zarządzany łącznik hostowany na platformie Azure, który jest wyświetlany w galerii łączników w obszarze Udostępnione środowisko uruchomieniowe>. Aby uzyskać więcej informacji, zobacz Dokumentacja łącznika zarządzanego usługi Azure OpenAI. |

| Standardowa | Usługa Azure Logic Apps z jedną dzierżawą, środowisko App Service Environment w wersji 3 (tylko plany systemu Windows) lub wdrożenie hybrydowe, które jest twoją własną infrastrukturą. | Wbudowany łącznik, który jest wyświetlany w galerii łączników w obszarze Środowisko uruchomieniowe>w aplikacji i jest oparty na dostawcy usług. Wbudowany łącznik ma między innymi następujące możliwości: - Obsługa wielu typów uwierzytelniania — Bezpośredni dostęp do zasobów w sieciach wirtualnych i punktach końcowych platformy Azure dla usługi Azure OpenAI za zaporami. Aby uzyskać więcej informacji, zobacz Dokumentacja wbudowanego łącznika usługi Azure OpenAI. |

Wyszukiwanie AI platformy Azure

Azure AI Search to platforma do pobierania informacji opartych na sztucznej inteligencji, która ułatwia deweloperom tworzenie zaawansowanych środowisk wyszukiwania i generowanie aplikacji sztucznej inteligencji dzięki połączeniu dużych modeli językowych z danymi przedsiębiorstwa. Za pomocą łącznika usługi Azure AI Search przepływ pracy może łączyć się z usługą Azure AI Search w celu indeksowania dokumentów i przeszukiwania wektorów danych.

Łącznik usługi Azure AI Search ma różne wersje na podstawie typu aplikacji logiki i modelu hostingu:

| Aplikacja logiki | Środowisko | Wersja łącznika |

|---|---|---|

| Zużycie | Wielodostępna usługa Azure Logic Apps | Zarządzany łącznik hostowany na platformie Azure, który jest wyświetlany w galerii łączników w obszarze Udostępnione środowisko uruchomieniowe>. Aby uzyskać więcej informacji, zobacz Dokumentacja łącznika zarządzanego usługi Azure AI Search. |

| Standardowa | Usługa Azure Logic Apps z jedną dzierżawą, środowisko App Service Environment w wersji 3 (tylko plany systemu Windows) lub wdrożenie hybrydowe, które jest twoją własną infrastrukturą. | Wbudowany łącznik, który jest wyświetlany w galerii łączników w obszarze Środowisko uruchomieniowe>w aplikacji i jest oparty na dostawcy usług. Wbudowany łącznik ma między innymi następujące możliwości: - Obsługa wielu typów uwierzytelniania — Bezpośredni dostęp do zasobów w sieciach wirtualnych i punktach końcowych platformy Azure dla usługi Azure OpenAI za zaporami. Aby uzyskać więcej informacji, zobacz Dokumentacja wbudowanego łącznika usługi Azure AI Search. |

Uwierzytelnianie

Łączniki zarządzane przez sztuczną inteligencję wymagają klucza interfejsu API do uwierzytelniania. Jednak wbudowane łączniki sztucznej inteligencji obsługują wiele typów uwierzytelniania dla punktu końcowego usługi sztucznej inteligencji. Te opcje zapewniają niezawodne uwierzytelnianie spełniające większość potrzeb klientów. Oba wbudowane łączniki mogą również łączyć się bezpośrednio z zasobami usługi Azure OpenAI i Azure AI Search w sieciach wirtualnych lub za zaporami.

W poniższej tabeli opisano wbudowane opcje uwierzytelniania łącznika, które wymagają podania adresu URL punktu końcowego usługi sztucznej inteligencji:

| Typ uwierzytelniania | opis |

|---|---|

| Uwierzytelnianie oparte na adresach URL i kluczach | Podaj klucz interfejsu API lub administrator wygenerowany przez usługę sztucznej inteligencji. |

| Active Directory OAuth (Microsoft Entra ID) | Podaj informacje, takie jak dzierżawa Entra, identyfikator klienta i hasło do uwierzytelniania jako użytkownik Entra. |

| Tożsamość zarządzana | Po skonfigurowaniu uwierzytelniania tożsamości zarządzanej w zasobie usługi sztucznej inteligencji i zasobie aplikacji logiki można użyć tej tożsamości do uwierzytelniania dostępu dla łącznika. |

Ważne

Aby uzyskać optymalne zabezpieczenia, użyj identyfikatora Entra firmy Microsoft z tożsamościami zarządzanymi do uwierzytelniania, jeśli to możliwe. Ta metoda zapewnia doskonałe zabezpieczenia bez konieczności podawania poświadczeń. Platforma Azure zarządza tą tożsamością i pomaga zapewnić bezpieczeństwo informacji uwierzytelniania, aby nie trzeba było samodzielnie zarządzać tymi poufnymi informacjami. Aby skonfigurować tożsamość zarządzaną dla usługi Azure Logic Apps, zobacz Uwierzytelnianie dostępu i połączeń z zasobami platformy Azure przy użyciu tożsamości zarządzanych w usłudze Azure Logic Apps.

Jeśli musisz użyć innego typu uwierzytelniania, użyj następnej dostępnej opcji zabezpieczeń najwyższego poziomu. Załóżmy na przykład, że musisz utworzyć połączenie przy użyciu parametry połączenia. Parametry połączenia zawiera informacje o autoryzacji wymagane przez aplikację w celu uzyskania dostępu do określonego zasobu, usługi lub systemu. Klucz dostępu w parametry połączenia jest podobny do hasła głównego.

W środowiskach produkcyjnych zawsze chronić poufne informacje i wpisy tajne, takie jak poświadczenia, certyfikaty, odciski palca, klucze dostępu i parametry połączenia. Upewnij się, że te informacje są bezpiecznie przechowywane przy użyciu identyfikatora Entra firmy Microsoft i usługi Azure Key Vault. Unikaj kodowania tych informacji, udostępniania innym użytkownikom lub zapisywania w postaci zwykłego tekstu w dowolnym miejscu, do którego inni mogą uzyskiwać dostęp. Obracanie wpisów tajnych tak szybko, jak to możliwe, jeśli uważasz, że te informacje mogą zostać naruszone. Aby uzyskać więcej informacji, zobacz About Azure Key Vault (Informacje o usłudze Azure Key Vault).

Aby uzyskać więcej informacji, zobacz następujące zasoby:

- Uwierzytelnianie żądań w usługach Azure AI

- Co to jest Microsoft Entra ID

- Co to są tożsamości zarządzane dla zasobów platformy Azure

- Uwierzytelnianie dostępu i połączeń z zasobami platformy Azure przy użyciu tożsamości zarządzanych w usłudze Azure Logic Apps

Dodawanie akcji azure OpenAI lub Azure AI Search do przepływu pracy

Obecnie łączniki dla usług Azure OpenAI i Azure AI Search udostępniają tylko akcje, a nie wyzwalacze. Możesz uruchomić przepływ pracy przy użyciu dowolnego wyzwalacza, który odpowiada Twojemu scenariuszowi lub potrzebom. W zależności od tego, czy masz przepływ pracy Zużycie, czy Standardowy, możesz wykonać następujące ogólne kroki, aby dodać akcje dla usług Azure OpenAI, Azure AI Search i innych operacji.

Scenariusze

W następujących scenariuszach opisano tylko dwa z wielu sposobów używania operacji łącznika sztucznej inteligencji w przepływach pracy:

Tworzenie baza wiedzy dla danych przedsiębiorstwa

Usługa Azure Logic Apps udostępnia ponad 1400 łączników zarządzanych przez firmę Microsoft i natywnie uruchomionych wbudowanych łączników dla przepływu pracy w celu bezpiecznego łączenia się z niemal dowolnym źródłem danych, takim jak SharePoint, Oracle DB, Salesforce, OneDrive, Dropbox, SAP, IBM itd. Każdy łącznik udostępnia operacje, które obejmują wyzwalacze, akcje lub oba te elementy, których można używać w przepływie pracy.

Można na przykład wybrać spośród wielu typów wyzwalaczy, aby zautomatyzowany przepływ pracy był uruchamiany zgodnie z harmonogramem lub na podstawie określonych zdarzeń, takich jak przekazywanie nowych dokumentów do witryny programu SharePoint. W przypadku tak wielu operacji, które można wybrać, można utworzyć baza wiedzy i łatwo utworzyć potok pozyskiwania dokumentów przy użyciu osadzania wektorów dla tych dokumentów w usłudze Azure AI Search.

Aby uzyskać więcej informacji, zobacz następujące zasoby:

Generowanie uzupełniania

Przepływ pracy usługi Azure Logic Apps może akceptować dane wejściowe, a usługa Azure OpenAI może wykonywać operacje uzupełniania. Te możliwości oznaczają, że przepływ pracy może pozyskiwać pytania w czasie rzeczywistym, generować odpowiedzi dotyczące danych lub wysyłać automatyczne odpowiedzi przy użyciu usługi Azure OpenAI. Możesz natychmiast wysłać odpowiedzi z powrotem do klienta lub do przepływu pracy zatwierdzania w celu weryfikacji.

Aby uzyskać więcej informacji, zobacz następujące zasoby:

Przykładowy scenariusz z przykładowym kodem: pozyskiwanie danych i tworzenie interakcji z czatem

W tym przykładowym standardowym przepływie pracy pokazano, jak używać wbudowanych łączników usług Azure OpenAI i Azure AI Search, aby podzielić logikę zaplecza na pozyskiwanie danych i prowadzenie prostych konwersacji na czacie w dwóch kluczowych przepływach pracy. Aby uzyskać szybszą wydajność, utwórz bezstanowe przepływy pracy, które domyślnie nie zapisują i nie przechowują historii dla każdego przebiegu.

Przykładowy kod

Tworzenie czatu przy użyciu pozyskanych danych

Inne wymagania wstępne

Przepływ pracy standardowej aplikacji logiki

Zobacz przykładowe wymagania dotyczące kodu.

Następujące wartości parametrów środowiska krzyżowego są również używane przez operacje przepływu pracy w tym przykładzie:

Nazwa parametru opis aisearch_admin_key Klucz administracyjny usługi Azure AI Search aisearch_endpoint Adres URL punktu końcowego dla przykładu usługi Azure AI Search aisearch_index_name Indeks do użycia dla przykładu usługi Azure AI Search openapi_api_key Klucz interfejsu API dla usługi Azure OpenAI openai_deployment_id Identyfikator wdrożenia dla przykładu usługi Azure OpenAI openai_endpoint Adres URL punktu końcowego dla przykładu usługi Azure OpenAI tokenize_function_url Adres URL niestandardowej funkcji platformy Azure, która wsaduje i tokenizuje dane, co jest wymagane, aby usługa Azure OpenAI prawidłowo utworzyła osadzanie w tym przykładzie.

Aby uzyskać więcej informacji na temat tej funkcji, zobacz przykładowy kod "Tworzenie czatu przy użyciu pozyskanych danych".

Wideo: Dowiedz się, jak tworzyć aplikacje sztucznej inteligencji przy użyciu aplikacji logiki

Dowiedz się, jak tworzyć aplikacje sztucznej inteligencji przy użyciu aplikacji logiki

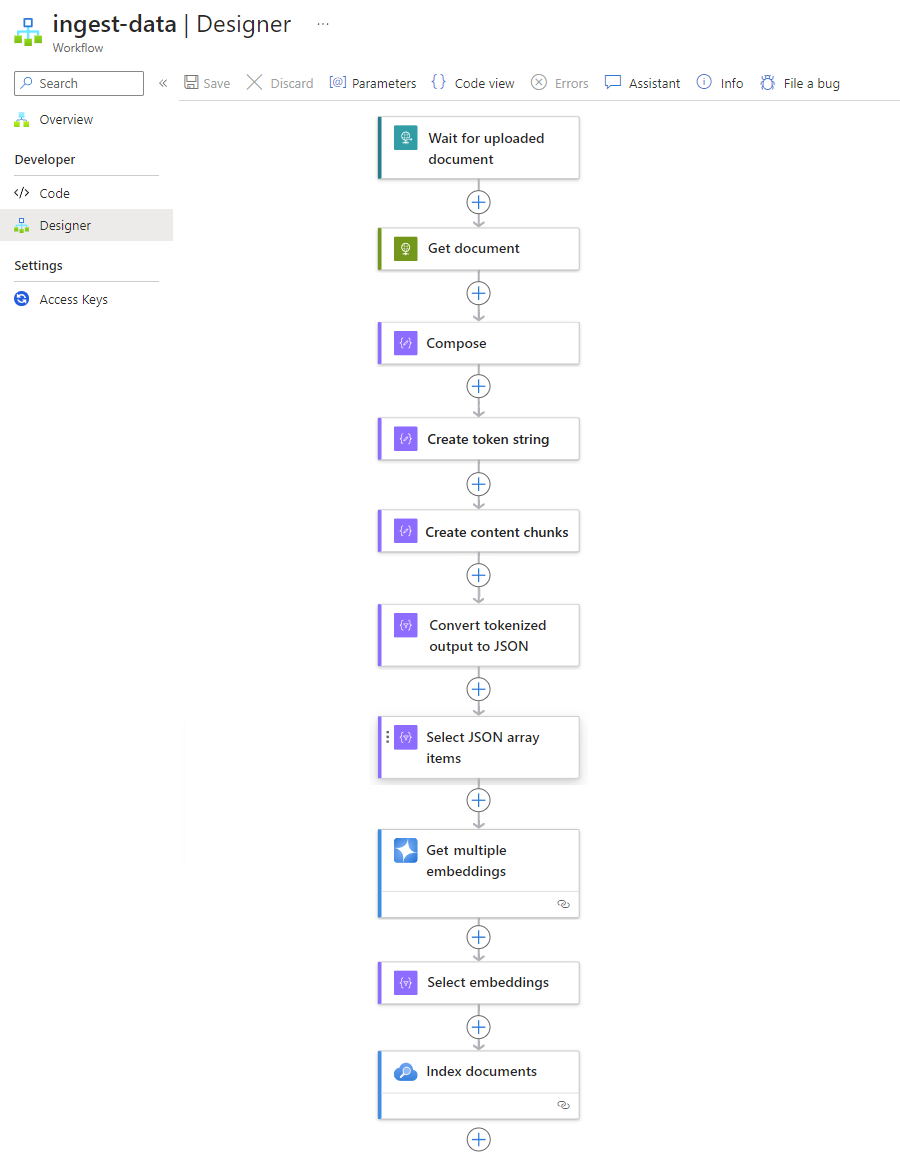

Pozyskiwanie przepływu pracy danych

Aby zaoszczędzić dużo czasu i nakładu pracy podczas tworzenia potoku pozyskiwania, zaimplementuj następujący wzorzec z dowolnym źródłem danych. Ten wzorzec hermetyzuje wszystkie zalety i korzyści oferowane obecnie przez przepływy pracy w warstwie Standardowa w usłudze Azure Logic Apps z jedną dzierżawą.

Każdy krok w tym wzorcu zapewnia, że sztuczna inteligencja bezproblemowo wyodrębnia wszystkie kluczowe informacje z plików danych. Jeśli jest uruchamiany jako bezstanowy przepływ pracy, ten wzorzec zapewnia również szybszą wydajność. Takie podejście upraszcza nie tylko aspekt kodowania, ale także gwarantuje, że przepływy pracy mają skuteczne procesy uwierzytelniania, monitorowania i wdrażania.

| Krok | Zadanie | Operacja bazowa | opis |

|---|---|---|---|

| 1 | Sprawdź, czy nie ma nowych danych. | Po odebraniu żądania HTTP | Wyzwalacz, który sonduje lub czeka na nadejście nowych danych na podstawie zaplanowanego cyklu lub odpowiednio w odpowiedzi na określone zdarzenia. Takie zdarzenie może być nowym plikiem przekazanym do określonego systemu magazynu, takiego jak SharePoint, OneDrive lub Azure Blob Storage. W tym przykładzie operacja wyzwalacza żądania czeka na żądanie HTTP lub HTTPS wysłane z innego punktu końcowego. Żądanie zawiera adres URL nowego przekazanego dokumentu. |

| 2 | Pobierz dane. | HTTP | Akcja HTTP , która pobiera przekazany dokument przy użyciu adresu URL pliku z danych wyjściowych wyzwalacza. |

| 3 | Utwórz szczegóły dokumentu. | Redaguj | Akcja Operacje na danych, która łączy różne elementy. Ten przykład łączy informacje o klucz-wartość dokumentu. |

| 100 | Utwórz ciąg tokenu. | Analizowanie dokumentu | Akcja Operacje na danych, która tworzy ciąg tokenu przy użyciu danych wyjściowych akcji Redaguj. |

| 5 | Tworzenie fragmentów zawartości. | Tekst fragmentu | Akcja Operacje na danych dzieląca ciąg tokenu na fragmenty na podstawie liczby znaków lub tokenów na fragment zawartości. |

| 6 | Konwertowanie tokenizowanych danych na format JSON. | Przeanalizuj dane JSON | Akcja Operacje na danych, która konwertuje fragmenty ciągu tokenu na tablicę JSON. |

| 7 | Wybierz pozycję Elementy tablicy JSON. | Wybieranie | Akcja Operacje na danych, która wybiera wiele elementów z tablicy JSON. |

| 8 | Wygeneruj osadzanie. | Pobieranie wielu osadzania | Akcja usługi Azure OpenAI , która tworzy osadzanie dla każdego elementu tablicy JSON. |

| 9 | Wybierz pozycję Osadzanie i inne informacje. | Wybieranie | Akcja Operacje na danych, która wybiera osadzanie i inne informacje o dokumencie. |

| 10 | Indeksowanie danych. | Indeksowanie dokumentów | Akcja usługi Azure AI Search , która indeksuje dane na podstawie każdego wybranego osadzania. |

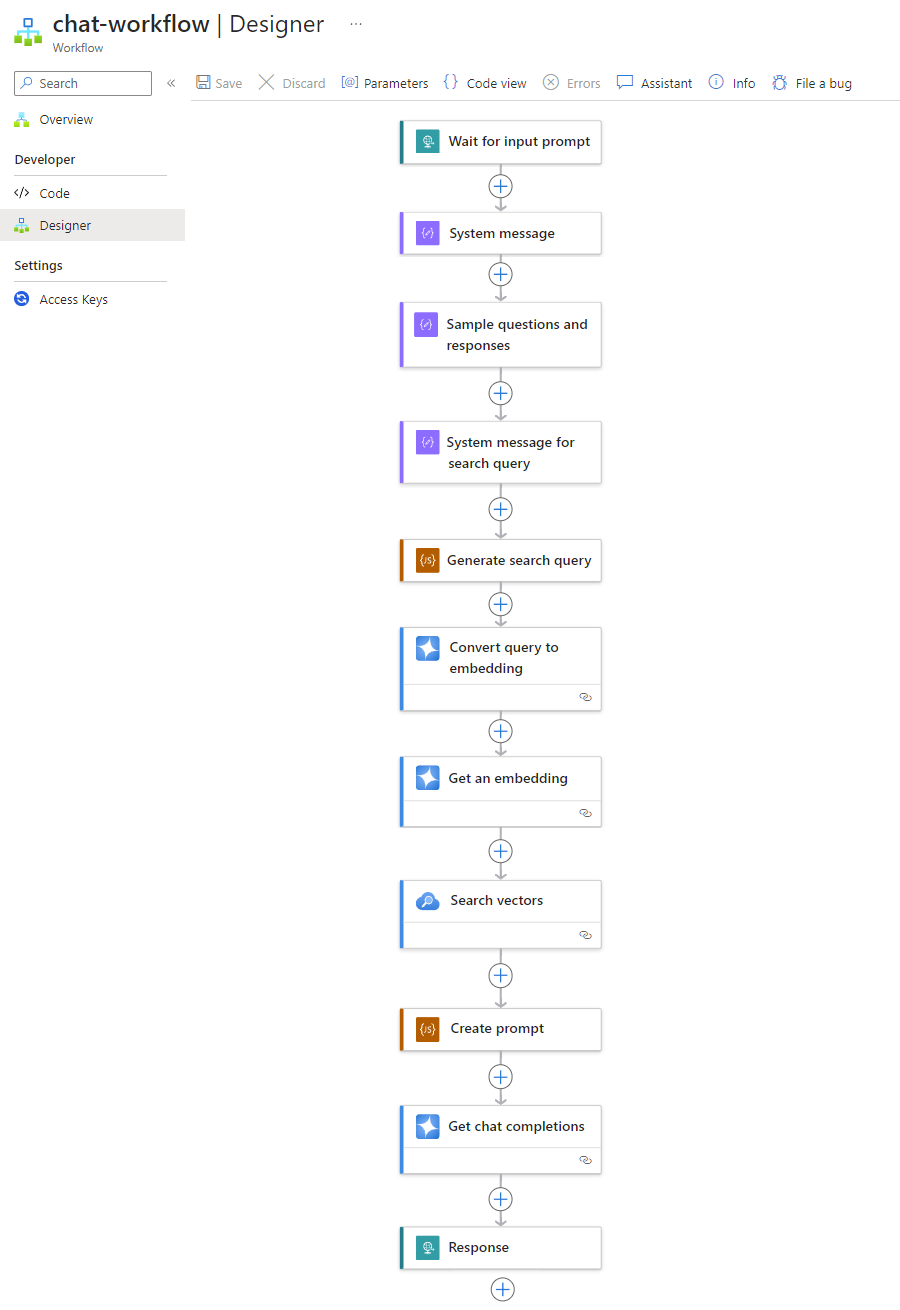

Przepływ pracy czatu

Ponieważ wektorowe bazy danych nadal pozyskiwać dane, upewnij się, że dane można łatwo przeszukiwać, aby gdy użytkownik zadaje pytanie, przepływ pracy aplikacji logiki zaplecza w warstwie Standardowa może przetworzyć monit i wygenerować niezawodną odpowiedź.

Poniższy wzorzec to tylko jeden przykład pokazujący, jak może wyglądać przepływ pracy czatu:

| Krok | Zadanie | Operacja bazowa | opis |

|---|---|---|---|

| 1 | Zaczekaj na monit wejściowy. | Po odebraniu żądania HTTP | Wyzwalacz, który sonduje lub czeka na nadejście nowych danych na podstawie zaplanowanego cyklu lub odpowiednio w odpowiedzi na określone zdarzenia. W tym przykładzie wyzwalacz Żądania czeka i przechwytuje pytanie klienta. |

| 2 | Komunikat systemu wejściowego dla modelu. | Redaguj | Akcja Operacje na danych, która udostępnia dane wejściowe w celu wytrenowania modelu. |

| 3 | Przykładowe pytania i odpowiedzi dotyczące danych wejściowych. | Redaguj | Akcja Operacje na danych, która udostępnia przykładowe pytania klienta i skojarzone role w celu wytrenowania modelu. |

| 100 | Komunikat systemu wejściowego dla zapytania wyszukiwania. | Redaguj | Akcja Operacje na danych, która udostępnia dane wejściowe zapytania wyszukiwania w celu wytrenowania modelu. |

| 5 | Generowanie zapytania wyszukiwania. | Wykonywanie kodu JavaScript | Akcja kodu wbudowanego, która używa języka JavaScript do utworzenia zapytania wyszukiwania dla magazynu wektorów na podstawie danych wyjściowych z poprzednich akcji redagowania. |

| 6 | Konwertuj zapytanie na osadzanie. | Uzyskiwanie ukończenia czatu | Akcja usługi Azure OpenAI , która łączy się z interfejsem API uzupełniania czatu, która gwarantuje niezawodne odpowiedzi podczas konwersacji na czacie. W tym przykładzie akcja akceptuje zapytania wyszukiwania i role jako dane wejściowe do modelu i zwraca wektorowe osadzanie jako dane wyjściowe. |

| 7 | Pobierz osadzanie. | Pobieranie osadzania | Akcja usługi Azure OpenAI , która pobiera osadzanie pojedynczego wektora. |

| 8 | Przeszukaj bazę danych wektorów. | Wektory wyszukiwania | Akcja usługi Azure AI Search , która wykonuje wyszukiwania w magazynie wektorów. |

| 9 | Utwórz monit. | Wykonywanie kodu JavaScript | Akcja kodu wbudowanego, która używa języka JavaScript do kompilowania monitów. |

| 10 | Wykonaj uzupełnianie czatu. | Uzyskiwanie ukończenia czatu | Akcja usługi Azure OpenAI , która łączy się z interfejsem API uzupełniania czatu, która gwarantuje niezawodne odpowiedzi podczas konwersacji na czacie. W tym przykładzie akcja akceptuje monity i role jako dane wejściowe modelu i zwraca wygenerowane przez model odpowiedzi jako dane wyjściowe. |

| 11 | Zwróć odpowiedź. | Response | Akcja Żądanie zwracająca wyniki do elementu wywołującego podczas korzystania z wyzwalacza Żądanie. |