Co to jest Apache Flink® w Azure HDInsight na AKS? (Wersja zapoznawcza)

Ważny

Usługa Azure HDInsight w usłudze AKS została wycofana 31 stycznia 2025 r. Dowiedz się więcej z tego ogłoszenia .

Aby uniknąć nagłego kończenia obciążeń, należy przeprowadzić migrację obciążeń do usługi Microsoft Fabric lub równoważnego produktu platformy Azure.

Ważny

Ta funkcja jest obecnie dostępna w wersji zapoznawczej. Dodatkowe warunki użytkowania dla wersji zapoznawczych Microsoft Azure zawierają więcej warunków prawnych, które dotyczą funkcji Azure w wersji beta, w wersji zapoznawczej lub w inny sposób nieudostępnione publicznie. Aby uzyskać informacje na temat tej konkretnej wersji zapoznawczej, zobacz informacje o wersji zapoznawczej Azure HDInsight na AKS. W przypadku pytań lub sugestii dotyczących funkcji, prosimy o złożenie wniosku na AskHDInsight ze szczegółami, a także śledzenie nas w celu uzyskania więcej aktualizacji na temat społeczności Azure HDInsight.

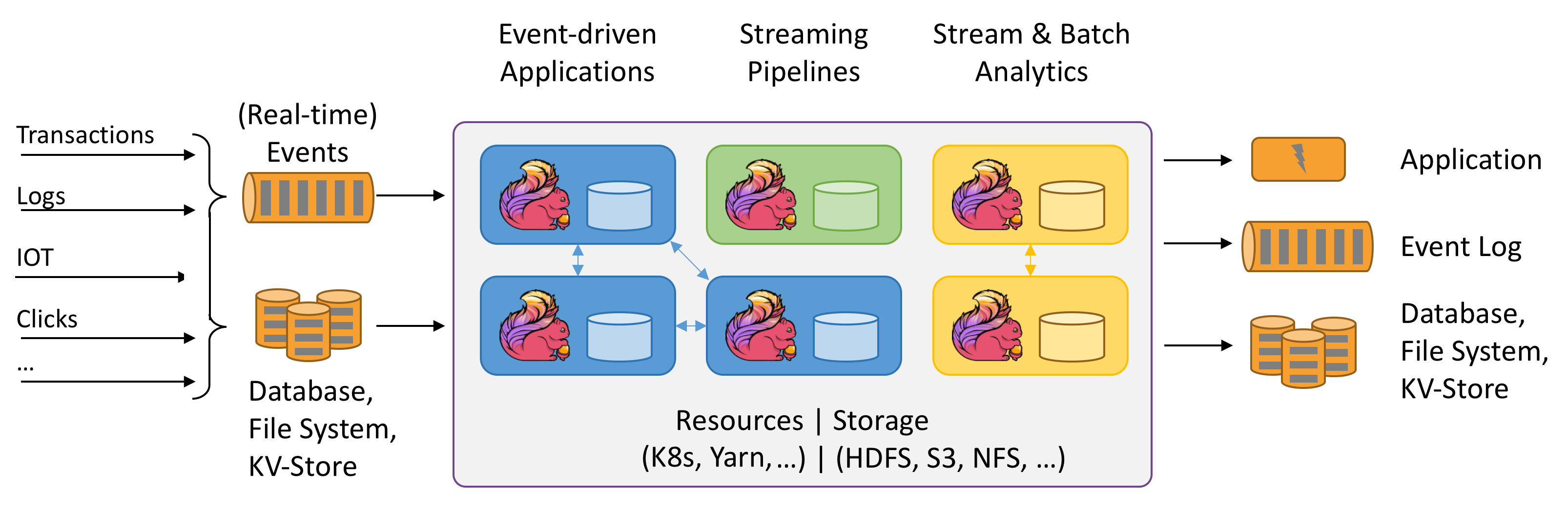

Apache Flink to framework i silnik przetwarzania rozproszonego do obliczeń stanowych przy użyciu strumieni danych nieograniczonych i ograniczonych. Flink został zaprojektowany do działania we wszystkich typowych środowiskach klastrów, wykonywania obliczeń oraz stanowych aplikacji przesyłania strumieniowego z prędkością pamięciową i w dowolnej skali. Aplikacje są równoległe do prawdopodobnie tysięcy zadań, które są dystrybuowane i wykonywane współbieżnie w klastrze. W związku z tym aplikacja może używać nieograniczonej liczby procesorów wirtualnych, pamięci głównej, dysku i operacji we/wy sieci. Ponadto Flink z łatwością zarządza dużym stanem aplikacji. Algorytm asynchronicznego i przyrostowego tworzenia punktów kontrolnych zapewnia minimalny wpływ na opóźnienia przetwarzania przy jednoczesnym zagwarantowaniu dokładnie jednej spójności stanu.

Apache Flink to wysoce skalowalny aparat analityczny do przetwarzania strumieniowego.

Oto niektóre z najważniejszych funkcji oferowanych przez funkcję Flink:

- Operacje na strumieniach ograniczonych i niezwiązanych

- Wydajność pamięci

- Możliwość przesyłania strumieniowego i obliczeń wsadowych

- Małe opóźnienia, operacje o wysokiej przepływności

- Dokładnie jednokrotne przetwarzanie

- Wysoka dostępność

- Stan i odporność na uszkodzenia

- W pełni zgodne z ekosystemem usługi Hadoop

- Ujednolicone interfejsy API SQL zarówno dla strumieniowego, jak i wsadowego przetwarzania

Dlaczego apache Flink?

Apache Flink to doskonały wybór do tworzenia i uruchamiania wielu różnych typów aplikacji ze względu na rozbudowany zestaw funkcji. Funkcje Flink obejmują obsługę przetwarzania strumieniowego i wsadowego, zaawansowane zarządzanie stanem, semantykę przetwarzania czasu zdarzeń oraz gwarancje spójności typu 'dokładnie raz' dla stanu. Flink nie ma jednego punktu awarii. Flink został sprawdzony do skalowania do tysięcy rdzeni i terabajtów stanu aplikacji, zapewnia wysoką przepływność i małe opóźnienia oraz obsługuje niektóre z najbardziej wymagających aplikacji przetwarzania strumieni na świecie.

- Wykrywanie oszustw: Flink może służyć do wykrywania oszukańczych transakcji lub działań w czasie rzeczywistym przez zastosowanie złożonych reguł i modeli uczenia maszynowego na strumieniowych danych.

- wykrywania anomalii: Flink może służyć do identyfikowania wartości odstających lub nietypowych wzorców w danych przesyłanych strumieniowo, takich jak odczyty czujników, ruch sieciowy lub zachowanie użytkownika.

- Alerty oparte na regułach: Flink można użyć do wyzwalania alertów lub powiadomień na podstawie wstępnie zdefiniowanych warunków lub progów danych przesyłanych strumieniowo, takich jak temperatura, ciśnienie lub ceny akcji.

- monitorowanie procesów biznesowych: Flink może służyć do śledzenia i analizowania stanu i wydajności procesów biznesowych lub przepływów pracy w czasie rzeczywistym, takich jak realizacja zamówienia, dostawa lub obsługa klienta.

- aplikacji internetowej (sieci społecznościowej): Flink może być używany do zasilania aplikacji internetowych, które wymagają przetwarzania danych tworzonych przez użytkowników w czasie rzeczywistym, takich jak wiadomości, polubienia, komentarze lub rekomendacje.

Przeczytaj więcej na temat typowych przypadków użycia narzędzia Apache Flink opisanych w

Klastry Apache Flink na AKS w HDInsight są w pełni zarządzaną usługą. Zalety tworzenia klastra Flink w HDInsight na AKS są wymienione tutaj.

| Funkcja | Opis |

|---|---|

| Łatwość tworzenia | Nowy klaster Flink można utworzyć w usłudze HDInsight w ciągu kilku minut przy użyciu witryny Azure Portal, programu Azure PowerShell lub zestawu SDK. Zobacz Rozpocznij pracę z klastrem Apache Flink w usłudze HDInsight na platformie AKS. |

| Łatwość użycia | Klastry Flink w HDInsight na AKS obejmują zarządzanie konfiguracją za pośrednictwem portalu oraz skalowanie. Oprócz korzystania z interfejsu API zarządzania zadaniami, możesz również używać interfejsu REST API lub Azure Portal do zarządzania zadaniami. |

| Interfejsy programistyczne REST | Klastry Flink w usłudze HDInsight na AKS obejmują interfejs API zarządzania zadaniami, metodę przesyłania zadań Flink opartą na interfejsie API REST, umożliwiającą zdalne przesyłanie i monitorowanie zadań w portalu Azure. |

| Typ wdrożenia | Flink może wykonywać aplikacje w trybie sesji lub w trybie aplikacji. Obecnie usługa HDInsight w usłudze AKS obsługuje tylko klastry sesji. W klastrze sesyjnym można uruchomić wiele zadań Flink. Tryb aplikacji znajduje się w harmonogramie działania usługi HDInsight w klastrach usługi AKS |

| Obsługa magazynu metadanych | Klastry Flink w usługach HDInsight na platformie AKS mogą obsługiwać katalogi z Metastore Hive w różnych otwartych formatach plików z wykorzystaniem zdalnych punktów kontrolnym w usłudze Azure Data Lake Storage Gen2. |

| Obsługa usługi Azure Storage | Klastry Flink w usłudze HDInsight mogą używać usługi Azure Data Lake Storage Gen2 jako miejsce docelowe dla plików. Aby uzyskać więcej informacji na temat usługi Data Lake Storage Gen2, zobacz Azure Data Lake Storage Gen2. |

| Integracja z usługami platformy Azure | Klaster Flink w usłudze HDInsight w usłudze AKS jest dostarczany z integracją z platformą Kafka wraz z Azure Event Hubs i Azure HDInsight. Aplikacje przesyłania strumieniowego można tworzyć przy użyciu usługi Event Hubs lub USŁUGI HDInsight. |

| Adaptowalność | Usługa HDInsight w usłudze AKS umożliwia skalowanie węzłów klastra Flink na podstawie harmonogramu za pomocą funkcji autoskalowania. Zobacz Automatyczne skalowanie Azure HDInsight na klastrach AKS. |

| Zaplecze stanu | Usługa HDInsight w usłudze AKS używa RocksDB jako domyślnego elementu StateBackend. RocksDB to wbudowany trwały system magazynowania par klucz-wartość do szybkiego przechowywania. |

| Punktów kontrolnych | Tworzenie punktów kontrolnych jest domyślnie włączone w usłudze HDInsight w klastrach usługi AKS. Ustawienia domyślne w HDInsight na AKS utrzymują pięć ostatnich punktów kontrolnych w trwałej pamięci. W przypadku niepowodzenia zadania zadanie można uruchomić ponownie z najnowszego punktu kontrolnego. |

| Przyrostowe punkty kontrolne | Baza danych RocksDB obsługuje przyrostowe punkty kontrolne. Zachęcamy do korzystania z przyrostowych punktów kontrolnych dla dużego stanu. Należy włączyć tę funkcję ręcznie. Ustawienie wartości domyślnej w flink-conf.yaml: state.backend.incremental: true włącza przyrostowe punkty kontrolne, chyba że aplikacja zastąpi to ustawienie w kodzie. To stwierdzenie jest domyślnie prawdziwe. Alternatywnie tę wartość można skonfigurować bezpośrednio w kodzie (zastępuje domyślną konfigurację) EmbeddedRocksDBStateBackend` backend = new `EmbeddedRocksDBStateBackend(true); . Domyślnie zachowujemy pięć ostatnich punktów kontrolnych w skonfigurowanym dir punktów kontrolnych. Tę wartość można zmienić, zmieniając konfigurację w sekcji zarządzania konfiguracją state.checkpoints.num-retained: 5 |

Klastry Apache Flink w HDInsight na AKS obejmują następujące składniki; są one domyślnie dostępne w klastrach.

Zapoznaj się z harmonogramem działania na temat tego, co będzie wkrótce!

Zarządzanie zadaniami Apache Flink

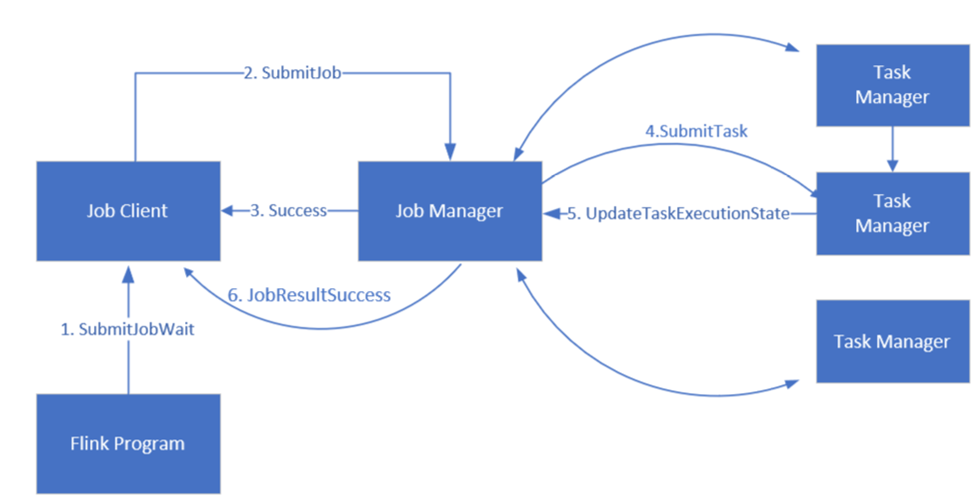

Flink planuje zadania przy użyciu trzech rozproszonych składników: Menedżera prac, Menedżera zadań i Klienta zadań, które są skonfigurowane według wzoru Leader-Follower.

Flink Job: Zadanie lub program Flink składa się z wielu zadań. Zadania są podstawową jednostką wykonywania w Flink. Każde zadanie Flink ma wiele wystąpień w zależności od poziomu równoległości, a każde wystąpienie jest wykonywane na menedżerze zadań.

Menedżer pracy: Menedżer pracy działa jako harmonogram i przydziela zadania menedżerom zadań.

Menedżer zadań: Menedżerowie zadań mają co najmniej jedno gniazdo do równoległego wykonywania zadań.

klient zadań: klient zadań komunikuje się z menedżerem zadań w celu przesyłania zadań Flink

Flink Web UI: Flink oferuje internetowy interfejs użytkownika do inspekcji, monitorowania i debugowania uruchomionych aplikacji.

Odniesienie

- witryny internetowej Apache Flink

- Nazwy projektów typu Apache, Apache Kafka, Kafka, Apache Flink, Flink i związane z nimi projekty open source są znakami towarowymiApache Software Foundation (ASF).