Sztuczna inteligencja i uczenie maszynowe w usłudze Databricks

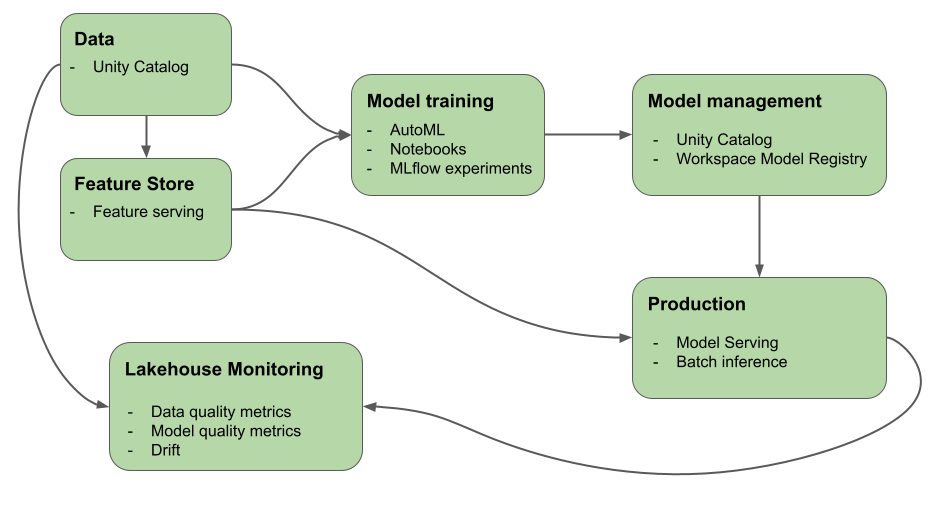

W tym artykule opisano narzędzia, które oferuje mozaika AI (dawniej Databricks Machine Learning), które ułatwiają tworzenie systemów sztucznej inteligencji i uczenia maszynowego. Na diagramie przedstawiono, w jaki sposób różne produkty na platformie Databricks pomagają zaimplementować kompleksowe przepływy pracy w celu tworzenia i wdrażania systemów sztucznej inteligencji i uczenia maszynowego

Generowanie sztucznej inteligencji w usłudze Databricks

Mozaika sztucznej inteligencji łączy cykl życia sztucznej inteligencji z zbierania i przygotowywania danych, do opracowywania modeli i llMOps, do obsługi i monitorowania. Poniższe funkcje są specjalnie zoptymalizowane pod kątem ułatwiania tworzenia aplikacji generacyjnych sztucznej inteligencji:

- Unity Catalog do zapewnienia ładu, odnajdywania, przechowywania wersji i kontroli dostępu do danych, cech, modeli i funkcji.

- MLflow na potrzeby śledzenia programowania modeli.

- mozaikowa brama sztucznej inteligencji do zarządzania i monitorowania dostępu do obsługiwanych modeli generowania sztucznej inteligencji i skojarzonych z nimi modeli obsługujących punkty końcowe.

-

Mozaika model sztucznej inteligencji służąca do wdrażania llMs. Możesz skonfigurować model obsługujący punkt końcowy specjalnie na potrzeby uzyskiwania dostępu do modeli generacyjnych sztucznej inteligencji:

- Najnowocześniejsze otwarte maszyny LLM przy użyciu interfejsów API modelu foundation.

- Modele innych firm hostowane poza usługą Databricks. Zobacz Modele zewnętrzne w narzędziu Mosaic AI Model Serving.

- Mosaic AI Vector Search udostępnia przeszukiwalną bazę danych wektorów, która przechowuje wektory osadzeń i może być skonfigurowana do automatycznej synchronizacji z bazą wiedzy.

- Lakehouse Monitoring na potrzeby monitorowania i śledzenia jakości przewidywania modelu oraz dryfu przy użyciu automatycznego rejestrowania ładunków z tabelami wnioskowania.

- AI Playground do testowania generowania modeli sztucznej inteligencji z obszaru roboczego usługi Databricks. Możesz monitować, porównywać i dostosowywać ustawienia, takie jak monit systemowy i parametry wnioskowania.

- Foundation Model Fine-tuning (obecnie część Mosaic AI Model Training) do dostosowywania modelu podstawowego przy użyciu własnych danych w celu optymalizacji wydajności dla określonej aplikacji.

- Mozaika AI Agent Framework do kompilowania i wdrażania agentów jakości produkcyjnej, takich jak pobieranie aplikacji generacji rozszerzonej (RAG).

- Mozaika AI Agent Evaluation do oceny jakości, kosztów i opóźnień aplikacji generacyjnych sztucznej inteligencji, w tym aplikacji RAG i łańcuchów.

Co to jest generowanie sztucznej inteligencji?

Generowanie sztucznej inteligencji to typ sztucznej inteligencji skoncentrowany na możliwości komputerów do używania modeli do tworzenia zawartości, takiej jak obrazy, tekst, kod i syntetyczne dane.

Generowanie aplikacji sztucznej inteligencji opiera się na modelach generacyjnych sztucznej inteligencji: dużych modelach językowych (LLM) i modelach podstawowych.

- LlMs to modele uczenia głębokiego, które używają ogromnych zestawów danych i trenują je w celu wykonywania zadań przetwarzania języka. Tworzą nowe kombinacje tekstu, które naśladują język naturalny na podstawie ich danych treningowych.

- Generowanie modeli sztucznej inteligencji lub modeli podstawowych to duże modele uczenia maszynowego wstępnie wytrenowane z zamiarem dostosowania ich do bardziej szczegółowych zadań interpretacji języka i generowania. Te modele służą do rozróżniania wzorców w danych wejściowych.

Po tym, jak te modele zakończą swoje procesy uczenia się, razem generują statystycznie prawdopodobne dane wyjściowe po otrzymaniu polecenia i mogą być stosowane do wykonywania różnych zadań, w tym:

- Generowanie obrazów na podstawie istniejących lub użycie stylu jednego obrazu w celu zmodyfikowania lub utworzenia nowego obrazu.

- Zadania mowy, takie jak transkrypcja, tłumaczenie, generowanie pytań/odpowiedzi oraz interpretacja intencji lub znaczenia tekstu.

Ważne

Chociaż wiele modeli LLM lub innych modeli generacyjnych sztucznej inteligencji ma zabezpieczenia, nadal mogą generować szkodliwe lub niedokładne informacje.

Generowanie sztucznej inteligencji ma następujące wzorce projektowe:

- Monitowanie inżynieryjne: tworzenie wyspecjalizowanych monitów o wskazówki dotyczące zachowania usługi LLM

- Pobieranie rozszerzonej generacji (RAG): łączenie modułu LLM z zewnętrznym pobieraniem wiedzy

- Dostrajanie: dostosowanie wstępnie wytrenowanego modułu LLM do określonych zestawów danych domen

- Wstępne szkolenie: trenowanie modułu LLM od podstaw

Uczenie maszynowe w usłudze Databricks

Dzięki sztucznej inteligencji Mozaika jedna platforma obsługuje każdy krok opracowywania i wdrażania uczenia maszynowego, od danych pierwotnych po tabele wnioskowania, które zapisują każde żądanie i odpowiedź dla obsługiwanego modelu. Analitycy danych, inżynierowie danych, inżynierowie uczenia maszynowego i metodyka DevOps mogą wykonywać swoje zadania przy użyciu tego samego zestawu narzędzi i pojedynczego źródła prawdy dla danych.

Mozaika sztucznej inteligencji łączy warstwę danych i platformę uczenia maszynowego. Wszystkie zasoby danych i artefakty, takie jak modele i funkcje, są wykrywalne i zarządzane w jednym wykazie. Korzystanie z jednej platformy dla danych i modeli umożliwia śledzenie pochodzenia danych pierwotnych do modelu produkcyjnego. Wbudowane monitorowanie danych i modeli zapisuje metryki jakości w tabelach, które są również przechowywane na platformie, co ułatwia zidentyfikowanie głównej przyczyny problemów z wydajnością modelu. Aby uzyskać więcej informacji o tym, jak usługa Databricks obsługuje pełny cykl życia uczenia maszynowego i metodyki MLOps, zobacz Przepływy pracy metodyki MLOps w usłudze Azure Databricks i stosach MLOps: proces tworzenia modelu jako kod.

Oto niektóre kluczowe składniki platformy analizy danych:

| Zadania | Składnik |

|---|---|

| Zarządzanie danymi, funkcjami, modelami i funkcjami oraz zarządzanie nimi. Odnajdywanie, przechowywanie wersji i pochodzenie danych. | Unity Catalog |

| Śledzenie zmian w danych, jakości danych i jakości przewidywania modelu | Lakehouse Monitoring, tabele wnioskowania dla modeli niestandardowych |

| Opracowywanie funkcji i zarządzanie nimi | Inżynieria cech i obsługa. |

| Szkolenie modeli | AutoML, notesy usługi Databricks |

| Śledzenie opracowywania modeli | Śledzenie MLflow |

| Obsługa modeli niestandardowych | Obsługa modelu mozaiki sztucznej inteligencji. |

| Tworzenie zautomatyzowanych przepływów pracy i potoków ETL gotowych do produkcji | Zadania usługi Databricks |

| Integracja z usługą Git | Foldery Git usługi Databricks |

Uczenie głębokie w usłudze Databricks

Konfigurowanie infrastruktury dla aplikacji uczenia głębokiego może być trudne. Środowisko Databricks Runtime for Machine Learning zajmuje się tym za Ciebie, z klastrami, które mają wbudowane wersje najpopularniejszych bibliotek uczenia głębokiego, takich jak TensorFlow, PyTorch i Keras.

Klastry uczenia maszynowego środowiska Databricks Runtime obejmują również wstępnie skonfigurowaną obsługę procesora GPU ze sterownikami i bibliotekami pomocniczymi. Obsługuje również biblioteki, takie jak Ray , aby zrównać przetwarzanie obliczeniowe na potrzeby skalowania przepływów pracy uczenia maszynowego i aplikacji uczenia maszynowego.

Klastry uczenia maszynowego środowiska Databricks Runtime obejmują również wstępnie skonfigurowaną obsługę procesora GPU ze sterownikami i bibliotekami pomocniczymi. Obsługa modeli mozaiki sztucznej inteligencji umożliwia tworzenie skalowalnych punktów końcowych procesora GPU dla modeli uczenia głębokiego bez dodatkowej konfiguracji.

W przypadku aplikacji uczenia maszynowego usługa Databricks zaleca używanie klastra z uruchomionym środowiskiem Databricks Runtime na potrzeby uczenia maszynowego. Zobacz Tworzenie klastra przy użyciu usługi Databricks Runtime ML.

Aby rozpocząć uczenie głębokie w usłudze Databricks, zobacz:

- Najlepsze rozwiązania dotyczące uczenia głębokiego w usłudze Azure Databricks

- Uczenie głębokie w usłudze Databricks

- Rozwiązania referencyjne dotyczące uczenia głębokiego

Następne kroki

Aby rozpocząć pracę, zobacz:

Aby uzyskać zalecany przepływ pracy metodyki MLOps w usłudze Databricks Mosaic AI, zobacz:

Aby dowiedzieć się więcej o kluczowych funkcjach sztucznej inteligencji usługi Databricks Mosaic, zobacz: