Architektura usługi Data lakehouse: dobrze zaprojektowana struktura usługi Databricks

Ten zestaw artykułów dotyczących architektury typu data lakehouse zawiera zasady i najlepsze rozwiązania dotyczące implementacji i działania usługi Lakehouse przy użyciu usługi Azure Databricks.

Dobrze zaprojektowana struktura usługi Databricks dla lakehouse

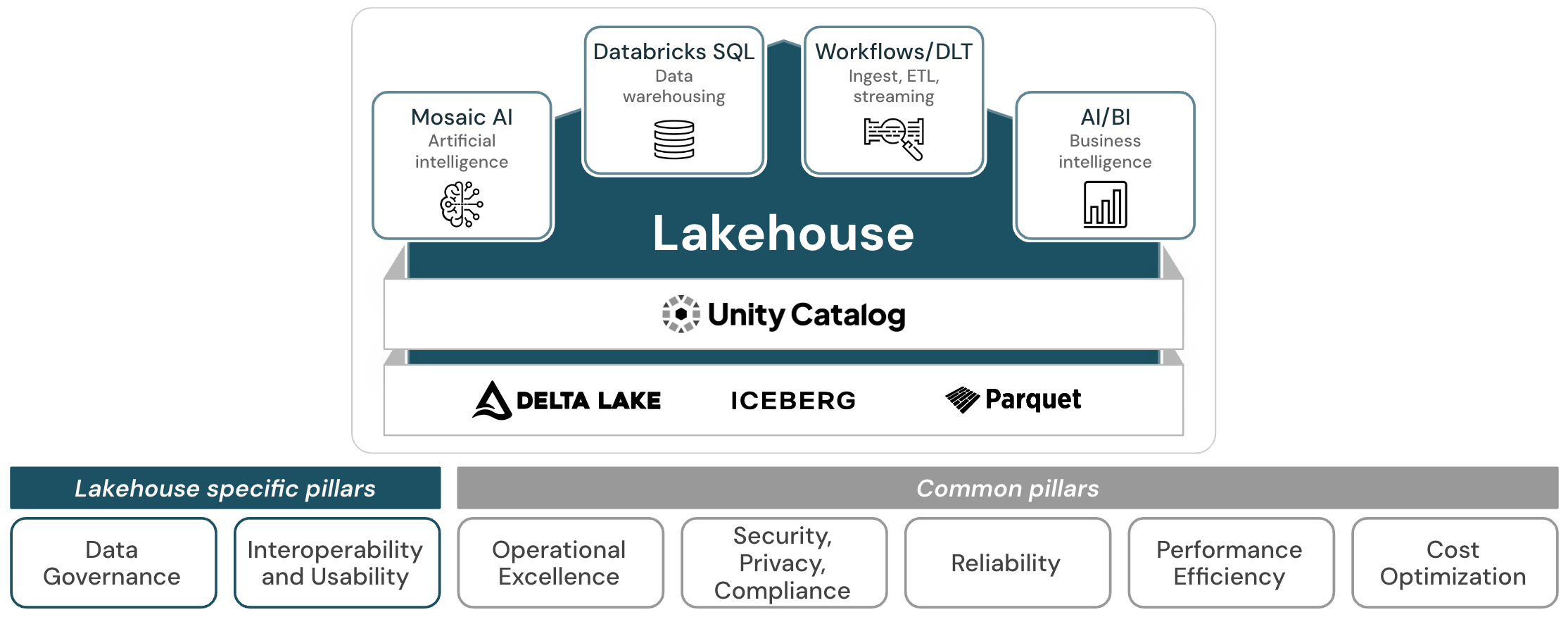

Dobrze zaprojektowany lakehouse składa się z 7 filarów, które opisują różne obszary zainteresowania implementacją magazynu typu data lakehouse w chmurze:

Zarządzanie danymi i sztuczną inteligencją

Nadzór nad zapewnieniem, że dane i sztuczna inteligencja przynoszą wartość i wspierają strategię biznesową.

Współdziałanie i użyteczność

Zdolność lakehouse do interakcji z użytkownikami i innymi systemami.

Bezpieczeństwo operacyjne

Wszystkie procesy operacyjne, które utrzymują działanie lakehouse w środowisku produkcyjnym.

Zabezpieczenia, prywatność i zgodność

Chroń aplikację usługi Azure Databricks, obciążenia klientów i dane klientów przed zagrożeniami.

Niezawodność

Zdolność systemu do odzyskiwania sprawności po awarii i kontynuowania działania.

Wydajność

Możliwość systemu do dostosowywania do zmian w obciążeniu.

Optymalizacja kosztów

Zarządzanie kosztami w celu zmaksymalizowania dostarczanej wartości.

Dobrze zaprojektowany Lakehouse rozszerza Microsoft Azure Well-Architected Framework na platformę analizy danych Databricks Data Intelligence i udostępnia filary "doskonałość operacyjna", "Bezpieczeństwo" (jako "Bezpieczeństwo, prywatność i zgodność"), "niezawodność", "wydajność" i "optymalizacja kosztów".

W przypadku tych pięciu filarów zasady i najlepsze rozwiązania dotyczące struktury chmury nadal mają zastosowanie do usługi Lakehouse. Dobrze zaprojektowany lakehouse rozszerza te zasady i najlepsze praktyki specyficzne dla lakehouse i istotne dla budowy skutecznego i wydajnego lakehouse.

Filary specyficzne dla domu nad jeziorem

Kolumny "Data and AI Governance" i "Interoperacyjność i użyteczność" dotyczą kwestii specyficznych dla lakehouse.

Zarządzanie danymi i sztuczną inteligencją hermetyzuje zasady i praktyki zaimplementowane w celu bezpiecznego zarządzania danymi i zasobami sztucznej inteligencji w organizacji. Jednym z podstawowych aspektów usługi Lakehouse jest scentralizowane zarządzanie danymi i sztuczną inteligencją: usługa Lakehouse łączy magazynowanie danych i przypadki użycia sztucznej inteligencji na jednej platformie. Upraszcza to nowoczesny stos danych, eliminując silosy danych, które tradycyjnie oddzielają i komplikują inżynierię danych, analizę, analizę, analizę danych, naukę o danych i uczenie maszynowe. Aby uprościć te zadania zarządzania, Lakehouse oferuje ujednolicone rozwiązanie zarządzania danymi, analizami i sztuczną inteligencją. Minimalizując kopie danych i przechodząc do pojedynczej warstwy przetwarzania danych, w której wszystkie dane i mechanizmy kontroli ładu sztucznej inteligencji mogą być uruchamiane razem, zwiększasz szanse na zachowanie zgodności i wykrywanie naruszenia zabezpieczeń danych.

Kolejną ważną cechą jeziora jest zapewnienie doskonałego środowiska użytkownika dla wszystkich osób, które z nią współpracują, i możliwość interakcji z szerokim ekosystemem systemów zewnętrznych. Platforma Azure ma już wiele narzędzi do obsługi danych, które wykonują większość zadań, których może potrzebować przedsiębiorstwo oparte na danych. Jednak te narzędzia muszą być prawidłowo zebrane, aby zapewnić wszystkie funkcje, z każdą usługą oferującą inne środowisko użytkownika. Takie podejście może prowadzić do wysokich kosztów implementacji i zwykle nie zapewnia takiego samego środowiska użytkownika jak natywna platforma lakehouse: użytkownicy są ograniczeni niespójnościami między narzędziami a brakiem możliwości współpracy, a często muszą przejść przez złożone procesy w celu uzyskania dostępu do systemu, a tym samym do danych.

Zintegrowana usługa Lakehouse po drugiej stronie zapewnia spójne środowisko użytkownika we wszystkich obciążeniach i w związku z tym zwiększa użyteczność. Zmniejsza to koszty trenowania i dołączania oraz poprawia współpracę między funkcjami. Ponadto nowe funkcje są automatycznie dodawane w miarę upływu czasu — w celu dalszego ulepszania środowiska użytkownika — bez konieczności inwestowania w wewnętrzne zasoby i budżety.

Podejście wielochmurowe może być celową strategią firmy lub wynikiem fuzji i przejęć lub niezależnych jednostek biznesowych wybierających różnych dostawców chmury. W takim przypadku użycie usługi Multi-Cloud Lakehouse powoduje ujednolicone środowisko użytkownika we wszystkich chmurach. Zmniejsza to rozprzestrzenianie się systemów w całym przedsiębiorstwie, co z kolei zmniejsza wymagania dotyczące umiejętności i szkolenia pracowników zaangażowanych w zadania oparte na danych.

Na koniec w świecie sieciowym z procesami biznesowymi między firmami systemy muszą współpracować tak bezproblemowo, jak to możliwe. Stopień współdziałania jest tutaj kluczowym kryterium, a najnowsze dane, jako podstawowy zasób każdej firmy, muszą bezpiecznie przepływać między systemami wewnętrznymi i zewnętrznymi partnerami.