Dokumentacja konfiguracji obliczeniowej

Uwaga

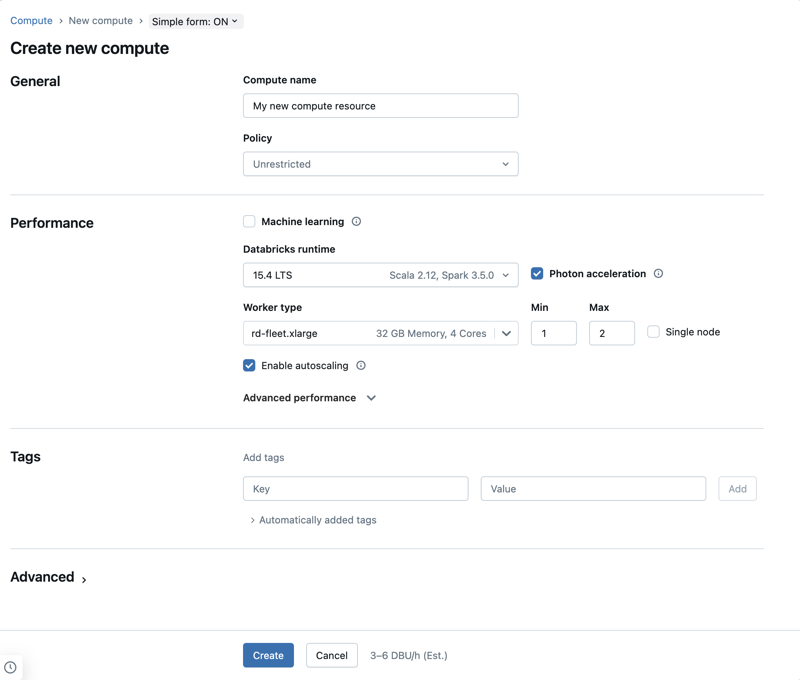

Organizacja tego artykułu zakłada, że używasz prostego interfejsu użytkownika do obliczeń. Aby zapoznać się z omówieniem prostych aktualizacji formularzy, zobacz Używanie prostego formularza do zarządzania obliczeniami.

W tym artykule opisano ustawienia konfiguracji dostępne podczas tworzenia nowego zasobu obliczeniowego ogólnego przeznaczenia lub zadania. Większość użytkowników tworzy zasoby obliczeniowe przy użyciu przypisanych zasad, co ogranicza konfigurowalne ustawienia. Jeśli w interfejsie użytkownika nie widzisz określonego ustawienia, to dlatego, że wybrane zasady nie umożliwiają skonfigurowania tego ustawienia.

Konfiguracje i narzędzia do zarządzania opisane w tym artykule dotyczą zarówno obliczeń ogólnego przeznaczenia, jak i obliczeń zadaniowych. Aby uzyskać więcej informacji na temat konfigurowania obliczeń zadań, zobacz Konfigurowanie zasobów obliczeniowych dla zadań.

Tworzenie nowego zasobu obliczeniowego ogólnego przeznaczenia

Aby utworzyć nowy zasób obliczeniowy ogólnego przeznaczenia:

- Na pasku bocznym obszaru roboczego kliknij Compute.

- Kliknij przycisk Utwórz obliczenia.

- Skonfiguruj zasób obliczeniowy.

- Kliknij pozycję Utwórz.

Nowy zasób obliczeniowy zostanie automatycznie uruchomiony i będzie gotowy do użycia wkrótce.

zasady obliczeniowe

Zasady to zestaw reguł używanych do ograniczania opcji konfiguracji dostępnych dla użytkowników podczas tworzenia zasobów obliczeniowych. Jeśli użytkownik nie ma nieograniczonego uprawnienia do tworzenia klastra, może tworzyć tylko zasoby obliczeniowe przy użyciu przyznanych zasad.

Aby utworzyć zasoby obliczeniowe zgodnie z zasadami, wybierz zasady z menu rozwijanego Zasady .

Domyślnie wszyscy użytkownicy mają dostęp do polityki Personal Compute, co pozwala im na tworzenie zasobów obliczeniowych przy użyciu pojedynczej maszyny. Jeśli potrzebujesz dostępu do zasobów obliczeniowych osobistych lub innych zasad, skontaktuj się z administratorem obszaru roboczego.

Ustawienia wydajności

Następujące ustawienia są wyświetlane w sekcji wydajności prostego interfejsu użytkownika formularza obliczeniowego:

- Wersje środowiska Uruchomieniowego usługi Databricks

- Użyj przyspieszenia fotonów

- typ węzła roboczego

- Jednowęzłowe obliczenia

- Włączanie skalowania automatycznego

- Zaawansowane ustawienia wydajności

Wersje Uruchomieniowe usługi Databricks

Środowisko Databricks Runtime to zestaw podstawowych składników uruchamianych na obliczeniach. Wybierz środowisko uruchomieniowe z menu rozwijanego Wersja środowiska uruchomieniowego usługi Databricks. Aby uzyskać szczegółowe informacje na temat określonych wersji środowiska Databricks Runtime, zobacz Databricks Runtime release notes versions and compatibility (Wersje i zgodność środowiska Databricks Runtime). Wszystkie wersje obejmują platformę Apache Spark. Usługa Databricks zaleca następujące kwestie:

- W przypadku obliczeń wszystkich celów użyj najnowszej wersji, aby upewnić się, że masz najnowsze optymalizacje i najbardziej aktualną zgodność między kodem i wstępnie załadowanych pakietów.

- W przypadku obliczeń zadań z obciążeniami operacyjnymi w toku, rozważ użycie wersji Long Term Support (LTS) środowiska Databricks Runtime. Użycie wersji LTS zapewni, że nie wystąpią problemy ze zgodnością i że będziesz mógł dokładnie przetestować swoje obciążenie przed uaktualnieniem.

- W przypadku zastosowań nauki o danych i uczenia maszynowego, należy wziąć pod uwagę środowisko Databricks Runtime ML.

Użyj przyspieszania Photon

Funkcja Photon jest domyślnie włączona na obliczeniach z uruchomionym środowiskiem Databricks Runtime 9.1 LTS i nowszym.

Aby włączyć lub wyłączyć przyspieszanie Photon, zaznacz pole wyboru Użyj przyspieszania Photon. Aby dowiedzieć się więcej na temat aplikacji Photon, zobacz Co to jest Photon?.

typ węzła roboczego

Zasób obliczeniowy składa się z jednego węzła sterownika i zera lub większej liczby węzłów roboczych. Można wybrać oddzielne typy wystąpień dostawcy usług w chmurze dla węzłów sterowników i procesów roboczych, chociaż domyślnie węzeł sterownika używa tego samego typu wystąpienia co węzeł roboczy. Ustawienie węzła sterownika znajduje się poniżej sekcji Zaawansowana wydajność.

Różne rodziny typów wystąpień pasują do różnych przypadków użycia, takich jak obciążenia intensywnie korzystające z pamięci lub intensywnie korzystające z obliczeń. Możesz również wybrać pulę do użycia jako węzeł roboczy lub węzeł sterowniczy.

Ważne

Nie używaj puli z wystąpieniami typu spot jako typ sterownika. Wybierz typ sterownika na żądanie, aby uniemożliwić odzyskanie sterownika. Zobacz Łączenie z pulami.

W przypadku obliczeń wielowęzłowych węzły robocze uruchamiają funkcje wykonawcze platformy Spark i inne usługi wymagane do prawidłowego działania zasobu obliczeniowego. Podczas dystrybucji obciążenia za pomocą platformy Spark całe rozproszone przetwarzanie odbywa się w węzłach roboczych. Usługa Azure Databricks uruchamia jedną funkcję wykonawczą na węzeł roboczy. W związku z tym terminy wykonawcze i proces roboczy są używane zamiennie w kontekście architektury usługi Databricks.

Napiwek

Aby uruchomić zadanie platformy Spark, potrzebujesz co najmniej jednego węzła roboczego. Jeśli zasób obliczeniowy ma zero procesów roboczych, możesz uruchamiać polecenia spoza platformy Spark w węźle sterownika, ale polecenia platformy Spark kończą się niepowodzeniem.

Adresy IP węzłów roboczych

Usługa Azure Databricks uruchamia węzły robocze z dwoma prywatnymi adresami IP. Podstawowy prywatny adres IP węzła hostuje ruch wewnętrzny usługi Azure Databricks. Pomocniczy prywatny adres IP jest używany przez kontener Spark do komunikacji wewnątrz klastra. Ten model umożliwia usłudze Azure Databricks zapewnienie izolacji między wieloma zasobami obliczeniowymi w tym samym obszarze roboczym.

Typy wystąpień procesora GPU

W przypadku zadań wymagających obliczeń wymagających wysokiej wydajności, takich jak te związane z uczeniem głębokim, usługa Azure Databricks obsługuje zasoby obliczeniowe przyspieszane za pomocą procesorów graficznych (GPU). Aby uzyskać więcej informacji, zobacz Obliczenia z obsługą procesora GPU.

Maszyny wirtualne poufnego przetwarzania na platformie Azure

Typy maszyn wirtualnych przetwarzania poufnego platformy Azure uniemożliwiają nieautoryzowany dostęp do danych podczas ich użycia, w tym także dostęp operatora chmury. Ten typ maszyny wirtualnej jest korzystny dla wysoce regulowanych branż i regionów, a także firm z poufnymi danymi w chmurze. Aby uzyskać więcej informacji na temat poufnego przetwarzania na platformie Azure, zobacz Poufne przetwarzanie na platformie Azure.

Aby uruchamiać obciążenia przy użyciu maszyn wirtualnych poufnego przetwarzania w Azure, wybierz typy maszyn wirtualnych serii DC lub EC z rozwijanej listy w węźle sterownika i węźle procesu roboczego. Zobacz opcje poufnych maszyn wirtualnych Azure.

obliczenia jednowęzłowe

Pole wyboru pojedynczy węzeł umożliwia utworzenie zasobu obliczeniowego z jednym węzłem.

Obliczenia z jednym węzłem są przeznaczone dla zadań korzystających z małych ilości danych lub obciążeń nieprostrybucyjnych, takich jak biblioteki uczenia maszynowego z jednym węzłem. Obliczenia z wieloma węzłami powinny być używane w przypadku większych zadań z obciążeniami rozproszonymi.

Właściwości pojedynczego węzła

Zasób obliczeniowy z jednym węzłem ma następujące właściwości:

- Uruchamia platformę Spark lokalnie.

- Sterownik działa zarówno jako główny, jak i pracownik, bez węzłów roboczych.

- Tworzy jeden wątek wykonawczy na każdy rdzeń logiczny w zasobie obliczeniowym, z wyjątkiem 1 rdzenia dla sterownika.

- Zapisuje wszystkie

stderr,stdoutilog4jwyjścia logów w dzienniku sterownika. - Nie można przekonwertować na zasób obliczeniowy z wieloma węzłami.

Wybieranie pojedynczego lub wielowęzłowego

Podczas podejmowania decyzji o obliczeniach z jednym lub wieloma węzłami należy wziąć pod uwagę przypadek użycia:

Przetwarzanie danych na dużą skalę spowoduje wyczerpanie zasobów w zasobie obliczeniowym pojedynczego węzła. W przypadku tych obciążeń usługa Databricks zaleca korzystanie z obliczeń wielowęźleowych.

Komputer z jednym węzłem nie jest przeznaczony do wspólnego użytkowania. Aby uniknąć konfliktów zasobów, usługa Databricks zaleca używanie zasobu obliczeniowego z wieloma węzłami, gdy zasoby obliczeniowe muszą być współużytkowane.

Nie można skalować zasobu obliczeniowego z wieloma węzłami do zera pracowników. Zamiast tego użyj systemu obliczeniowego z jednym węzłem.

Obliczenia z jednym węzłem nie są zgodne z izolacją procesów.

Planowanie procesora GPU nie jest włączone w obliczeniach z jednym węzłem.

W przypadku obliczeń na pojedynczym węźle Spark nie może odczytać plików Parquet z kolumną UDT. Pojawia się następujący komunikat o błędzie:

The Spark driver has stopped unexpectedly and is restarting. Your notebook will be automatically reattached.Aby obejść ten problem, wyłącz natywny czytnik Parquet:

spark.conf.set("spark.databricks.io.parquet.nativeReader.enabled", False)

Włączanie skalowania automatycznego

Po włączeniu opcji Włącz skalowanie automatyczne można podać minimalną i maksymalną liczbę pracowników dla zasobu obliczeniowego. Następnie Databricks decyduje się na odpowiednią liczbę pracowników wymaganych do uruchomienia zadania.

Aby ustawić minimalną i maksymalną liczbę pracowników, pomiędzy którymi zasób obliczeniowy będzie się automatycznie skalować, użyj pól Min i Maks obok listy rozwijanej Typ pracownika .

Jeśli nie włączysz skalowania automatycznego, musisz wprowadzić stałą liczbę pracowników w polu Pracownicy obok listy rozwijanej Typ pracownika.

Uwaga

Gdy zasób obliczeniowy działa, na stronie szczegółów zasobu obliczeniowego wyświetlana jest liczba przydzielonych pracowników. Liczbę przydzielonych pracowników można porównać z konfiguracją pracowników i wprowadzić korekty zgodnie z potrzebami.

Zalety skalowania automatycznego

Dzięki automatycznemu skalowaniu usługa Azure Databricks dynamicznie przydziela zasoby robocze w zależności od charakterystyki zadania. Niektóre części przepływu danych mogą być bardziej wymagające pod względem obliczeniowym niż inne, a usługa Databricks automatycznie dodaje dodatkowych pracowników podczas tych etapów wykonywania zadań (i usuwa ich, gdy nie są już potrzebni).

Skalowanie automatyczne ułatwia osiągnięcie wysokiego wykorzystania, ponieważ nie trzeba aprowizować zasobów obliczeniowych w celu dopasowania ich do obciążenia. Dotyczy to szczególnie obciążeń, których wymagania zmieniają się w czasie (na przykład eksplorowanie zestawu danych w ciągu dnia), ale może również mieć zastosowanie do jednorazowego krótszego obciążenia, którego wymagania dotyczące aprowizacji są nieznane. Skalowanie automatyczne oferuje zatem dwie zalety:

- Obciążenia mogą działać szybciej w porównaniu z nieodpowiednio przydzielonym zasobem obliczeniowym o stałym rozmiarze.

- Skalowanie automatyczne może zmniejszyć całościowe koszty w porównaniu z zasobem obliczeniowym o statycznie określonej wielkości.

W zależności od stałego rozmiaru zasobu obliczeniowego i obciążenia skalowanie automatyczne daje jedną lub obie te korzyści w tym samym czasie. Rozmiar obliczeniowy może spaść poniżej minimalnej liczby jednostek roboczych wybranych, gdy dostawca usług w chmurze kończy wystąpienia. W takim przypadku usługa Azure Databricks stale ponawia próbę ponownego aprowizowania wystąpień w celu zachowania minimalnej liczby procesów roboczych.

Uwaga

Skalowanie automatyczne nie jest dostępne w przypadku zadań spark-submit.

Uwaga

Automatyczne skalowanie zasobów obliczeniowych ma ograniczenia dotyczące zmniejszania rozmiaru klastra dla obciążeń przetwarzania strumieniowego ze zdefiniowaną strukturą. Firma Databricks zaleca używanie DLT z rozszerzonym skalowaniem automatycznym dla obciążeń strumieniowych. Zobacz Optymalizowanie wykorzystania klastra potoków DLT za pomocą rozszerzonego skalowania automatycznego.

How autoscaling behaves (Jak działa skalowanie automatyczne)

Obszary robocze na planie Premium używają zoptymalizowanego skalowania automatycznego. Obszary robocze w standardowym planie cenowym korzystają ze standardowego skalowania automatycznego.

Zoptymalizowane skalowanie automatyczne ma następujące cechy:

- Zwiększa się od minimum do maksimum w 2 krokach.

- Można skalować w dół, nawet jeśli zasób obliczeniowy nie jest bezczynny, sprawdzając stan pliku shuffle.

- Skaluje w dół na podstawie procenta aktualnych węzłów.

- W przypadku wykonywania zadań obliczeniowych następuje automatyczne zmniejszanie zasobów, jeśli zasoby obliczeniowe są niedostatecznie wykorzystane przez ostatnie 40 sekund.

- W przypadku zasobów obliczeniowych ogólnego przeznaczenia skaluje się w dół, jeśli zasób obliczeniowy jest niedostatecznie wykorzystany w ciągu ostatnich 150 sekund.

-

spark.databricks.aggressiveWindowDownSWłaściwość konfiguracji platformy Spark określa w sekundach, jak często obliczenia podejmują decyzje dotyczące skalowania w dół. Zwiększenie wartości powoduje, że obliczenia będą skalowane w dół wolniej. Maksymalna wartość to 600.

Skalowanie automatyczne w warstwie Standardowa jest używane w obszarach roboczych planu standardowego. Skalowanie automatyczne w warstwie Standardowa ma następujące cechy:

- Rozpoczyna się od dodania 8 węzłów. Następnie skaluje w górę wykładniczo, wykonując tyle kroków, ile jest wymaganych do osiągnięcia maksymalnej wartości.

- Skaluje w dół, gdy 90% węzłów nie jest zajęte przez 10 minut, a obliczenia były bezczynne przez co najmniej 30 sekund.

- Skaluje w dół wykładniczo, począwszy od 1 węzła.

Skalowanie automatyczne za pomocą pul

Jeśli dołączasz zasób obliczeniowy do puli, rozważ następujące kwestie:

- Upewnij się, że żądany rozmiar obliczeniowy jest mniejszy lub równy minimalnej liczbie bezczynnych wystąpień w puli. Jeśli jest większy, czas uruchamiania obliczeń będzie odpowiednikiem obliczeń, które nie korzystają z puli.

- Upewnij się, że maksymalny rozmiar obliczeniowy jest mniejszy lub równy maksymalnej pojemności puli. Jeśli jest on większy, tworzenie zasobów obliczeniowych zakończy się niepowodzeniem.

Przykład skalowania automatycznego

Jeśli ponownie skonfigurujesz statyczny zasób obliczeniowy do automatycznego skalowania, usługa Azure Databricks natychmiast zmienia rozmiar zasobu obliczeniowego w granicach minimalnych i maksymalnych, a następnie uruchamia skalowanie automatyczne. Na przykład w poniższej tabeli przedstawiono, co dzieje się z zasobem obliczeniowym o określonym rozmiarze początkowym, jeśli ponownie skonfigurujesz zasób obliczeniowy do automatycznego skalowania między 5 i 10 węzłami.

| Rozmiar początkowy | Rozmiar po rekonfiguracji |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

Zaawansowane ustawienia wydajności

Poniższe ustawienia są wyświetlane w sekcji Zaawansowana wydajność w prostym interfejsie obliczeniowym formularza.

wystąpienia typu spot

Możesz określić, czy używać wystąpień typu spot, zaznaczając pole wyboru Użyj wystąpienia typu spot w sekcji Zaawansowana wydajność. Zobacz cenę typu spot platformy AWS .

wystąpienia typu spot

Aby zaoszczędzić koszty, możesz wybrać użycie wystąpień typu spot (maszyn wirtualnych typu spot platformy Azure), zaznaczając pole wyboru wystąpień typu spot.

Pierwsze wystąpienie zawsze będzie na żądanie (węzeł sterujący jest zawsze na żądanie), a kolejne wystąpienia będą wystąpieniami typu spot.

Jeśli instancje są eksmitowane z powodu niedostępności, usługa Azure Databricks podejmie próbę uzyskania nowych instancji typu spot w celu zastąpienia eksmitowanych instancji. Jeśli nie można uzyskać wystąpień typu spot, wystąpienia na żądanie są stosowane w celu zastąpienia usuniętych wystąpień. Ten powrót po awarii na żądanie jest obsługiwany tylko w przypadku wystąpień typu spot, które zostały w pełni pozyskane i są uruchomione. Wystąpienia typu spot, które kończą się niepowodzeniem podczas instalacji, nie są automatycznie zastępowane.

Ponadto po dodaniu nowych węzłów do istniejących zasobów obliczeniowych usługa Azure Databricks próbuje uzyskać wystąpienia typu spot dla tych węzłów.

Automatyczne zakończenie

Automatyczne kończenie obliczeń można ustawić w sekcji Zaawansowana wydajność. Podczas tworzenia zasobów obliczeniowych określ okres braku aktywności w minutach, po którym ma zostać zakończony zasób obliczeniowy.

Jeśli różnica między bieżącym czasem a ostatnim uruchomieniem polecenia w zasobie obliczeniowym jest większa niż określony okres braku aktywności, usługa Azure Databricks automatycznie kończy to obliczenie. resource Aby uzyskać więcej informacji na temat kończenia obliczeń, zobacz Kończenie obliczeń.

Typ sterownika

Typ sterownika można wybrać w sekcji Zaawansowana wydajność. Węzeł sterownika przechowuje informacje o stanie wszystkich notesów dołączonych do zasobu obliczeniowego. Węzeł sterownika obsługuje również SparkContext, interpretuje wszystkie polecenia uruchamiane z notesu lub biblioteki na zasobie obliczeniowym i uruchamia węzeł główny Apache Spark, który koordynuje się z wykonawcami Spark.

Wartość domyślna typu węzła sterownika jest taka sama jak typ węzła roboczego. Możesz wybrać większy typ węzła sterownika z większą ilością pamięci, jeśli planujesz collect() wiele danych z procesów roboczych platformy Spark i analizować je w notesie.

Napiwek

Ponieważ węzeł sterownika przechowuje wszystkie informacje o stanie dołączonych notesów, pamiętaj, aby odłączyć nieużywane notesy z węzła sterownika.

Tagi

Tagi umożliwiają łatwe monitorowanie kosztów zasobów obliczeniowych używanych przez różne grupy w organizacji. Określ tagi jako pary klucz-wartość podczas tworzenia obliczeń, a usługa Azure Databricks stosuje te tagi do zasobów w chmurze, takich jak maszyny wirtualne i woluminy dysków, a także raporty użycia jednostek DBU.

W przypadku obliczeń uruchamianych z pul tagi niestandardowe są stosowane tylko do raportów użycia jednostek DBU i nie są propagowane do zasobów w chmurze.

Aby uzyskać szczegółowe informacje o tym, jak tagi puli i zasobów obliczeniowych współpracują ze sobą, zobacz Użycie atrybutów przy użyciu tagów

Aby dodać tagi do zasobu obliczeniowego:

- W sekcji Tagi dodaj parę klucz-wartość dla każdego tagu niestandardowego.

- Kliknij przycisk Dodaj.

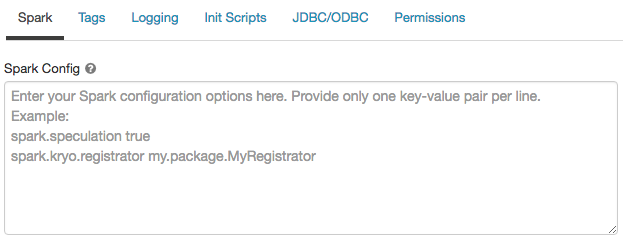

Ustawienia zaawansowane

W sekcji Zaawansowane prostego interfejsu użytkownika formularza obliczeniowego wyświetlane są następujące ustawienia:

- Tryby dostępu

- Włączanie automatycznego skalowania magazynu lokalnego

- Szyfrowanie dysków lokalnych

- Konfiguracja platformy Spark

- dostęp SSH do zasobów obliczeniowych

- zmienne środowiskowe

- Dostarczanie dzienników obliczeniowych

Tryby dostępu

Tryb dostępu to funkcja zabezpieczeń, która określa, kto może używać zasobu obliczeniowego i danych, do których mogą uzyskiwać dostęp przy użyciu zasobu obliczeniowego. Każdy zasób obliczeniowy w usłudze Azure Databricks ma tryb dostępu. Ustawienia trybu dostępu znajdują się w sekcji zaawansowanej interfejsu użytkownika prostego formularza obliczeniowego.

Wybór trybu dostępu jest domyślnie Auto, co oznacza, że tryb dostępu jest automatycznie wybierany na podstawie wybranego Databricks Runtime. Środowiska uruchomieniowe uczenia maszynowego i środowiska Databricks Runtime o wersji niższej niż 14.3 domyślnie używają Dedykowane, w przeciwnym razie używana jest Standard.

Usługa Databricks zaleca używanie standardowego trybu dostępu dla wszystkich obciążeń. Używaj trybu dedykowanego dostępu tylko wtedy, gdy wymagana funkcja nie jest obsługiwana przez standardowy tryb dostępu.

| Tryb dostępu | Widoczne dla użytkownika | Obsługa interfejsu użytkownika | Obsługiwane języki | Uwagi |

|---|---|---|---|---|

| Dedykowany (dawniej pojedynczy użytkownik) | Zawsze | Tak | Python, SQL, Scala, R | Może być przypisany i używany przez pojedynczego użytkownika lub grupę. |

| Standardowa (wcześniej udostępniona) | Zawsze | Tak | Python, SQL, Scala (w przypadku obliczeń z katalogiem Unity włączonym przy użyciu środowiska Databricks Runtime 13.3 LTS lub nowszych) | Może być używany przez wielu użytkowników z izolacją danych wśród użytkowników. |

Aby uzyskać szczegółowe informacje na temat obsługi funkcji dla każdego z tych trybów dostępu, zobacz Ograniczenia trybu dostępu obliczeniowego dla Unity Catalog.

Uwaga

W środowisku Databricks Runtime 13.3 LTS i nowszym skrypty inicjowania i biblioteki są obsługiwane przez wszystkie tryby dostępu. Wymagania i poziomy obsługi różnią się. Zobacz Gdzie można zainstalować skrypty inicjowania? biblioteki przypisane do zasobów obliczeniowychi.

Włączanie automatycznego skalowania magazynu lokalnego

Często trudno jest oszacować ilość miejsca na dysku potrzebnego do wykonania określonego zadania. Aby zaoszczędzić na konieczności oszacowania, ile gigabajtów dysku zarządzanego ma zostać dołączonych do zasobów obliczeniowych w czasie tworzenia, usługa Azure Databricks automatycznie włącza automatyczne skalowanie magazynu lokalnego na wszystkich obliczeniach usługi Azure Databricks.

Dzięki automatycznemu skalowaniu magazynu lokalnego usługa Azure Databricks monitoruje ilość wolnego miejsca na dysku dostępnego dla procesów roboczych platformy Spark w środowisku obliczeniowym. Jeśli pracownik zaczyna mieć mało dostępnego miejsca na dysku, usługa Databricks automatycznie dołącza nowy zarządzany dysk do pracownika, zanim zabraknie mu przestrzeni dyskowej. Dyski mogą być dołączone do momentu osiągnięcia limitu 5 TB całkowitego miejsca na dysku na maszynę wirtualną (łącznie z początkową przestrzenią lokalną maszyny wirtualnej).

Dyski zarządzane dołączone do maszyny wirtualnej są odłączane tylko wtedy, gdy maszyna wirtualna zostanie zwrócona na platformę Azure. Oznacza to, że dyski zarządzane nigdy nie są odłączane od maszyny wirtualnej, o ile są one częścią działającego środowiska obliczeniowego. Aby skalować w dół użycie dysku zarządzanego, usługa Azure Databricks zaleca użycie tej funkcji w obliczeniach skonfigurowanych z automatycznym skalowaniem obliczeniowym lub automatycznym kończeniem.

Szyfrowanie dysku lokalnego

Ważne

Ta funkcja jest dostępna w publicznej wersji zapoznawczej.

Niektóre typy wystąpień używane do uruchamiania obliczeń mogą mieć lokalnie dołączone dyski. Usługa Azure Databricks może przechowywać dane tymczasowe lub dane shuffle na tych dyskach dołączonych lokalnie. Aby upewnić się, że wszystkie dane w spoczynku są szyfrowane dla wszystkich typów magazynu, w tym dane shuffle przechowywane tymczasowo na dyskach lokalnych zasobu obliczeniowego, można włączyć szyfrowanie dysku lokalnego.

Ważne

Obciążenia mogą działać wolniej ze względu na wpływ na wydajność odczytywania i zapisywania zaszyfrowanych danych do i z woluminów lokalnych.

Po włączeniu szyfrowania dysku lokalnego usługa Azure Databricks generuje lokalnie klucz szyfrowania unikatowy dla każdego węzła obliczeniowego i służy do szyfrowania wszystkich danych przechowywanych na dyskach lokalnych. Zakres klucza jest lokalny dla każdego węzła obliczeniowego i jest niszczony wraz z samym węzłem obliczeniowym. W okresie jego istnienia klucz znajduje się w pamięci na potrzeby szyfrowania i odszyfrowywania i jest przechowywany zaszyfrowany na dysku.

Aby włączyć szyfrowanie dysków lokalnych, należy użyć interfejsu API klastrów. Podczas tworzenia lub edytowania zasobów obliczeniowych ustaw enable_local_disk_encryption na true.

Konfiguracja platformy Spark

Aby dostosować zadania platformy Spark, możesz podać niestandardowe właściwości konfiguracji platformy Spark.

Na stronie konfiguracji obliczeń kliknij przełącznik Zaawansowane.

Kliknij kartę Spark .

W konfiguracji Spark wprowadź właściwości konfiguracji, wpisując jedną parę klucz-wartość na wiersz.

Podczas konfigurowania obliczeń za pomocą Clusters API, ustaw właściwości Spark w polu spark_conf w interfejsie API tworzenia klastra lub API aktualizacji klastra.

Aby wymusić konfiguracje platformy Spark na obliczeniach, administratorzy obszaru roboczego mogą używać zasad obliczeniowych.

Pobierz właściwość konfiguracji Spark ze źródła tajnego

Databricks zaleca przechowywanie poufnych informacji, takich jak hasła, w sekrecie zamiast zwykłego tekstu. Aby odwołać się do wpisu tajnego w konfiguracji platformy Spark, użyj następującej składni:

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

Na przykład, aby ustawić właściwość konfiguracji Spark o nazwie password na wartość tajemnicy przechowywanej w pliku secrets/acme_app/password:

spark.password {{secrets/acme-app/password}}

Aby uzyskać więcej informacji, zobacz Zarządzanie tajemnicami.

Dostęp SSH do obliczeń

Ze względów bezpieczeństwa w usłudze Azure Databricks port SSH jest domyślnie zamykany. Jeśli chcesz włączyć dostęp SSH do klastrów Spark, zobacz Protokół SSH do węzła sterownika.

Uwaga

Protokół SSH można włączyć tylko wtedy, gdy obszar roboczy zostanie wdrożony we własnej sieci wirtualnej platformy Azure.

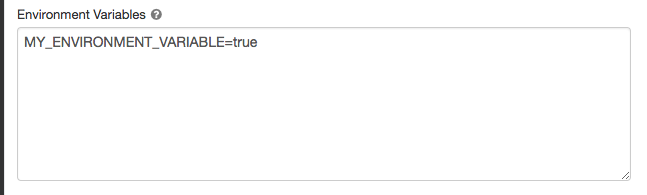

Zmienne środowiskowe

Skonfiguruj niestandardowe zmienne środowiskowe, do których można uzyskać dostęp za pomocą skryptów inicjowania uruchomionych w zasobie obliczeniowym. Usługa Databricks udostępnia również wstępnie zdefiniowane zmienne środowiskowe, których można używać w skryptach inicjowania. Nie można zastąpić tych wstępnie zdefiniowanych zmiennych środowiskowych.

Na stronie konfiguracji obliczeń kliknij przełącznik Zaawansowane.

Kliknij kartę Spark .

Ustaw zmienne środowiskowe w polu Zmienne środowiskowe.

Zmienne środowiskowe można również ustawić przy użyciu pola spark_env_vars w interfejsie API tworzenia klastra lub interfejsie API aktualizowania klastra.

Dostarczanie logów obliczeń

Podczas tworzenia obliczeń można określić lokalizację dostarczania dzienników dla węzła sterownika Spark, węzłów procesów roboczych i zdarzeń. Dzienniki są dostarczane co pięć minut i archiwizowane co godzinę w wybranym miejscu docelowym. Po zakończeniu działania zasobu obliczeniowego usługa Azure Databricks gwarantuje dostarczenie wszystkich dzienników wygenerowanych do momentu zakończenia zasobu obliczeniowego.

Miejsce docelowe dzienników zależy od zasobu cluster_idobliczeniowego . Jeśli określone miejsce docelowe to dbfs:/cluster-log-delivery, dzienniki obliczeniowe dla 0630-191345-leap375 są dostarczane do dbfs:/cluster-log-delivery/0630-191345-leap375.

Aby skonfigurować lokalizację dostarczania dziennika:

- Na stronie obliczeniowej kliknij przełącznik Zaawansowane.

- Kliknij kartę Rejestrowanie .

- Wybierz typ miejsca docelowego.

- Wprowadź ścieżkę dziennika obliczeniowego.

Uwaga

Ta funkcja jest również dostępna w interfejsie API REST. Zobacz API klastrów.