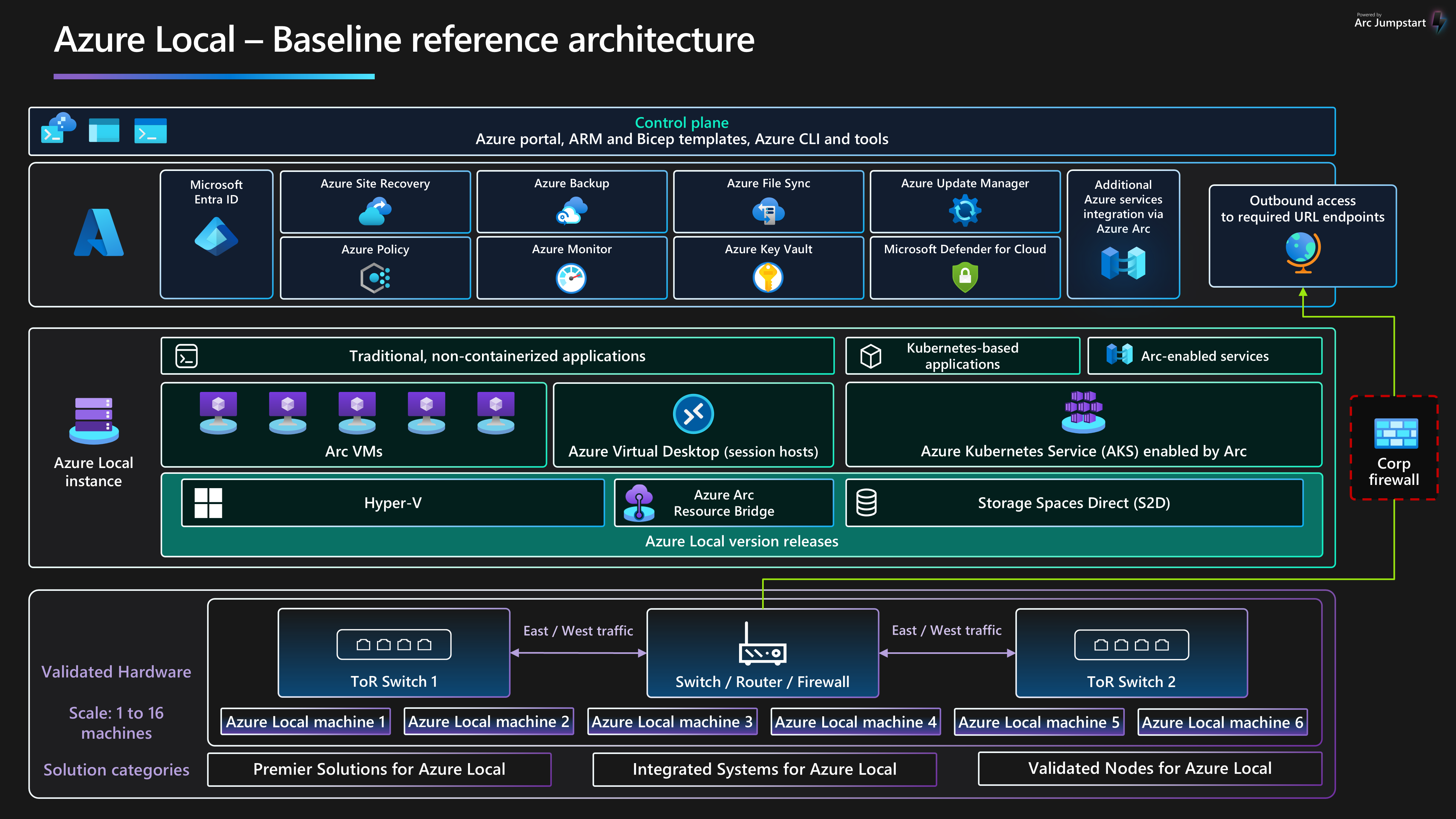

Ta architektura referencyjna odniesienia zapewnia niezależne od obciążenia wskazówki i zalecenia dotyczące konfigurowania lokalnych, lokalnych, 23H2, wersji 2311 i nowszej infrastruktury, aby zapewnić niezawodną platformę, która może wdrażać obciążenia zwirtualizowane i konteneryzowane oraz zarządzać nimi. Ta architektura opisuje składniki zasobów i opcje projektowania klastra dla węzłów fizycznych, które zapewniają lokalne funkcje obliczeniowe, magazynowe i sieciowe. W tym artykule opisano również sposób używania usług platformy Azure w celu uproszczenia i usprawnienia codziennego zarządzania lokalną platformą Azure.

Aby uzyskać więcej informacji na temat wzorców architektury obciążeń zoptymalizowanych pod kątem uruchamiania w usłudze Azure Local, zobacz zawartość znajdującą się w menu nawigacji obciążenia lokalne platformy Azure.

Ta architektura stanowi punkt wyjścia do wdrażania wystąpienia lokalnego platformy Azure przy użyciu projektu sieci przełączonej do magazynu. Aplikacje obciążeń wdrożone w wystąpieniu lokalnym platformy Azure powinny być dobrze zaprojektowane. Dobrze zaprojektowane aplikacje obciążeń muszą być wdrażane przy użyciu wielu wystąpień lub wysokiej dostępności dowolnych krytycznych usług obciążeń i mieć odpowiednie mechanizmy kontroli ciągłości działania i odzyskiwania po awarii (BCDR). Te kontrolki BCDR obejmują regularne kopie zapasowe i możliwości trybu failover odzyskiwania po awarii. Aby skoncentrować się na platformie infrastruktury HCI, te aspekty projektowania obciążenia są celowo wykluczone z tego artykułu.

Aby uzyskać więcej informacji na temat wytycznych i zaleceń dotyczących pięciu filarów platformy Azure Well-Architected Framework, zobacz przewodnik Azure Local Well-Architected Framework.

Układ artykułu

| Architektura | Decyzje projektowe | podejście Well-Architected Framework |

|---|---|---|

| ▪ architektury ▪ Potencjalne przypadki użycia ▪ szczegóły scenariusza ▪ zasoby platformy ▪ zasoby pomocnicze platformy ▪ Wdrażanie tego scenariusza |

▪ Wybór projektu klastra ▪ fizycznych dysków ▪ Projekt sieci ▪ monitorowanie ▪ Update Management |

▪ niezawodność ▪ Security ▪ optymalizacja kosztów ▪ doskonałość operacyjna ▪ wydajność |

Napiwek

szablon lokalny platformy Azure pokazuje, jak używać szablonu usługi Azure Resource Management (szablonu arm) i pliku parametrów w celu wdrożenia przełączonego wdrożenia wieloserwerowego platformy Azure lokalnie. Alternatywnie przykład Bicep pokazuje, jak za pomocą szablonu Bicep wdrożyć wystąpienie lokalne platformy Azure i jego zasoby wymagań wstępnych.

Architektura

Aby uzyskać więcej informacji, zobacz Powiązane zasoby.

Potencjalne przypadki użycia

Typowe przypadki użycia usługi Azure Local obejmują możliwość uruchamiania obciążeń wysokiej dostępności (HA) w lokalizacjach lokalnych lub brzegowych, co zapewnia rozwiązanie spełniające wymagania dotyczące obciążenia. Można:

Zapewnij rozwiązanie chmury hybrydowej, które zostało wdrożone lokalnie, aby spełnić wymagania dotyczące niezależności danych, regulacji i zgodności lub opóźnień.

Wdrażanie obciążeń brzegowych opartych na wysokiej dostępności lub kontenerach wdrożonych w jednej lokalizacji lub w wielu lokalizacjach oraz zarządzanie nimi. Ta strategia umożliwia działanie aplikacji i usług o krytycznym znaczeniu dla działania w sposób odporny, ekonomiczny i skalowalny.

Obniż całkowity koszt posiadania (TCO), korzystając z rozwiązań certyfikowanych przez firmę Microsoft, wdrożenie oparte na chmurze, scentralizowane zarządzanie oraz monitorowanie i zgłaszanie alertów.

Zapewnienie scentralizowanej możliwości aprowizacji przy użyciu platformy Azure i usługi Azure Arc w celu spójnego i bezpiecznego wdrażania obciążeń w wielu lokalizacjach. Narzędzia takie jak witryna Azure Portal, interfejs wiersza polecenia platformy Azure lub szablony infrastruktury jako kodu (IaC) używają platformy Kubernetes do konteneryzacji lub tradycyjnej wirtualizacji obciążeń w celu zapewnienia automatyzacji i powtarzalności.

Przestrzegaj rygorystycznych wymagań dotyczących zabezpieczeń, zgodności i inspekcji. Usługa Azure Local jest wdrażana przy użyciu skonfigurowanego domyślnie stanu zabezpieczeń ze wzmocnionymi zabezpieczeniami lub domyślnie. Usługa Azure Local obejmuje certyfikowany sprzęt, bezpieczny rozruch, moduł TPM ( Trusted Platform Module), zabezpieczenia oparte na wirtualizacji (VBS), funkcję Credential Guard i wymuszane zasady kontroli aplikacji usługi Windows Defender. Integruje się również z nowoczesnymi usługami zabezpieczeń i zarządzania zagrożeniami opartymi na chmurze, takimi jak Microsoft Defender for Cloud i Microsoft Sentinel.

Szczegóły scenariusza

Poniższe sekcje zawierają więcej informacji na temat scenariuszy i potencjalnych przypadków użycia dla tej architektury referencyjnej. W tych sekcjach znajduje się lista korzyści biznesowych i przykładowe typy zasobów obciążeń, które można wdrożyć na platformie Azure Local.

Używanie usługi Azure Arc z lokalną platformą Azure

Usługa Azure Local bezpośrednio integruje się z platformą Azure przy użyciu usługi Azure Arc, aby zmniejszyć koszt posiadania i obciążenie operacyjne. Usługa Azure Local jest wdrażana i zarządzana za pośrednictwem platformy Azure, która zapewnia wbudowaną integrację usługi Azure Arc z wdrożeniem składnika mostka zasobów usługi Azure Arc. Ten składnik jest instalowany podczas procesu wdrażania klastra HCI. Węzły klastra lokalnego platformy Azure są rejestrowane w usłudze Azure Arc dla serwerów jako warunek wstępny do zainicjowania wdrożenia klastra opartego na chmurze. Podczas wdrażania obowiązkowe rozszerzenia są instalowane na każdym węźle klastra, takim jak Menedżer cyklu życia, Zarządzanie urządzeniami przeglądarki Microsoft Edge oraz telemetria i diagnostyka. Za pomocą usług Azure Monitor i Log Analytics można monitorować klaster HCI po wdrożeniu, włączając usługę Insights for Azure Local. aktualizacje funkcji dla lokalnego platformy Azure są okresowo wydawane w celu ulepszenia środowiska klienta. Aktualizacje są kontrolowane i zarządzane za pośrednictwem usługi Azure Update Manager.

Zasoby obciążenia, takie jak maszyn wirtualnych usługi Azure Arc, z włączoną usługą Azure Kubernetes Service (AKS)i hostami sesji usługi Azure Virtual Desktop, które korzystają z witryny Azure Portal, wybierając lokalizację niestandardową wystąpienia lokalnego platformy Azure jako miejsce docelowe wdrożenia obciążenia. Te składniki zapewniają scentralizowaną administrację, zarządzanie i pomoc techniczną. Jeśli masz aktywny pakiet Software Assurance na istniejących licencjach rdzeni systemu Windows Server Datacenter, możesz dodatkowo obniżyć koszty, stosując korzyść użycia hybrydowego platformy Azure do maszyn wirtualnych platformy Azure, maszyn wirtualnych z systemem Windows Server i klastrów usługi AKS. Ta optymalizacja pomaga efektywnie zarządzać kosztami dla tych usług.

Integracja z platformą Azure i usługą Azure Arc rozszerza możliwości zwirtualizowanych i konteneryzowanych obciążeń platformy Azure w celu uwzględnienia następujących funkcji:

maszyny wirtualne usługi Azure Arc dla tradycyjnych aplikacji lub usług uruchamianych na maszynach wirtualnych w środowisku lokalnym platformy Azure.

usługi AKS w usłudze Azure Local dla konteneryzowanych aplikacji lub usług, które korzystają z używania platformy Kubernetes jako platformy aranżacji.

usługi Azure Virtual Desktop w celu wdrożenia hostów sesji dla obciążeń usługi Azure Virtual Desktop w środowisku lokalnym platformy Azure (lokalnie). Aby zainicjować tworzenie i konfigurację puli hostów, możesz użyć płaszczyzny sterowania i zarządzania na platformie Azure.

usług danych z obsługą usługi Azure Arc na potrzeby konteneryzowanego wystąpienia zarządzanego Azure SQL lub serwera usługi Azure Database for PostgreSQL, który korzysta z usługi AKS z obsługą usługi Azure Arc hostowanej w środowisku lokalnym platformy Azure.

Rozszerzenie usługi Azure Event Grid z obsługą usługi Azure Arc

dla platformy Kubernetes w celu wdrożenia składnikówbrokera usługi Event Grid i operatora usługi Event Grid. To wdrożenie umożliwia korzystanie z funkcji, takich jak tematy usługi Event Grid i subskrypcje na potrzeby przetwarzania zdarzeń. uczenia maszynowego z włączoną usługą Azure Arc z klastrem usługi AKS wdrożonym na platformie Azure Lokalnie jako obiektem docelowym obliczeń w celu uruchomienia usługi Azure Machine Learning. Za pomocą tego podejścia można trenować lub wdrażać modele uczenia maszynowego na brzegu sieci.

Obciążenia połączone z usługą Azure Arc zapewniają rozszerzoną spójność i automatyzację platformy Azure dla wdrożeń lokalnych platformy Azure, takich jak automatyzacja konfiguracji systemu operacyjnego gościa przy użyciu rozszerzeń maszyn wirtualnych usługi Azure Arc lub oceny zgodności z przepisami branżowymi lub standardami firmowymi za pośrednictwem usługi Azure Policy. Usługę Azure Policy można aktywować za pomocą witryny Azure Portal lub automatyzacji IaC.

Korzystanie z domyślnej konfiguracji zabezpieczeń platformy Azure

Domyślna konfiguracja zabezpieczeń platformy Azure zapewnia szczegółową strategię ochrony w celu uproszczenia kosztów zabezpieczeń i zgodności. Wdrażanie usług IT i zarządzanie nimi w scenariuszach sprzedaży detalicznej, produkcji i biura zdalnego stanowi unikatowe wyzwania związane z zabezpieczeniami i zgodnością. Zabezpieczanie obciążeń przed zagrożeniami wewnętrznymi i zewnętrznymi ma kluczowe znaczenie w środowiskach, w których ograniczono obsługę IT lub brak lub dedykowane centra danych. Usługa Azure Local ma domyślne wzmocnienie zabezpieczeń i głęboką integrację z usługami platformy Azure, aby pomóc Ci sprostać tym wyzwaniom.

Sprzęt z certyfikatem lokalnym platformy Azure zapewnia wbudowaną obsługę bezpiecznego rozruchu, ujednoliconego interfejsu UEFI (Unified Extensible Firmware Interface) i modułu TPM. Te technologie są używane w połączeniu z VBS, aby chronić obciążenia wrażliwe na zabezpieczenia. Szyfrowanie dysków funkcją BitLocker umożliwia szyfrowanie woluminów dysku rozruchowego i woluminów bezpośrednich miejsc do magazynowania. Szyfrowanie bloku komunikatów serwera (SMB) zapewnia automatyczne szyfrowanie ruchu między serwerami w klastrze (w sieci magazynu) i podpisywanie ruchu SMB między węzłami klastra i innymi systemami. Szyfrowanie SMB pomaga również zapobiegać atakom przekazywania i ułatwia zgodność ze standardami prawnymi.

Lokalne maszyny wirtualne platformy Azure można dołączyć w usłudze Defender for Cloud, aby aktywować analizę behawioralną opartą na chmurze, wykrywanie zagrożeń i korygowanie, alerty i raportowanie. Zarządzanie lokalnymi maszynami wirtualnymi platformy Azure w usłudze Azure Arc, dzięki czemu można użyć Azure Policy do oceny zgodności z przepisami branżowymi i standardami firmowymi.

Składniki

Ta architektura składa się ze sprzętu serwera fizycznego, którego można użyć do wdrażania wystąpień lokalnych platformy Azure w lokalizacjach lokalnych lub brzegowych. Aby zwiększyć możliwości platformy, usługa Azure Local integruje się z usługą Azure Arc i innymi usługami platformy Azure, które zapewniają zasoby pomocnicze. Platforma Azure Local zapewnia odporną platformę do wdrażania aplikacji użytkowników lub systemów biznesowych oraz zarządzania nimi oraz zarządzania nimi. Zasoby i usługi platformy opisano w poniższych sekcjach.

Zasoby platformy

Architektura wymaga następujących obowiązkowych zasobów i składników:

lokalne platformy Azure to rozwiązanie infrastruktury hiperkonwergentnej (HCI), które jest wdrażane lokalnie lub w lokalizacjach brzegowych przy użyciu sprzętu serwera fizycznego i infrastruktury sieciowej. Platforma Azure Local udostępnia platformę do wdrażania zwirtualizowanych obciążeń, takich jak maszyny wirtualne, klastry Kubernetes i inne usługi, które są włączone przez usługę Azure Arc. Wystąpienia lokalne platformy Azure mogą być skalowane z wdrożenia z jednego węzła do maksymalnie szesnastu węzłów przy użyciu zweryfikowanych, zintegrowanych lub premium kategorii sprzętu udostępnianych przez partnerów producenta oryginalnego sprzętu (OEM).

azure Arc to oparta na chmurze usługa, która rozszerza model zarządzania oparty na usłudze Azure Resource Manager na lokalizacje lokalne platformy Azure i inne lokalizacje spoza platformy Azure. Usługa Azure Arc używa platformy Azure jako płaszczyzny sterowania i zarządzania, aby umożliwić zarządzanie różnymi zasobami, takimi jak maszyny wirtualne, klastry Kubernetes oraz konteneryzowane dane i usługi uczenia maszynowego.

usługi Azure Key Vault to usługa w chmurze, której można używać do bezpiecznego przechowywania wpisów tajnych i uzyskiwania do nich dostępu. Wpis tajny to wszystko, do czego chcesz ściśle ograniczyć dostęp, takie jak klucze interfejsu API, hasła, certyfikaty, klucze kryptograficzne, poświadczenia administratora lokalnego i klucze odzyskiwania funkcji BitLocker.

monitor w chmurze to funkcja usługi Azure Storage, która działa jako kworum klastra trybu failover. Węzły klastra lokalnego platformy Azure używają tego kworum do głosowania, co zapewnia wysoką dostępność klastra. Konfiguracja konta magazynu i monitora jest tworzona podczas procesu wdrażania w chmurze lokalnej platformy Azure.

Update Manager to ujednolicona usługa przeznaczona do zarządzania aktualizacjami platformy Azure i zarządzania nimi. Za pomocą programu Update Manager można zarządzać obciążeniami wdrożonym na platformie Azure Lokalnie, w tym zgodnością aktualizacji systemu operacyjnego gościa dla maszyn wirtualnych z systemem Windows i Linux. To ujednolicone podejście usprawnia zarządzanie poprawkami na platformie Azure, środowiskach lokalnych i innych platformach w chmurze za pośrednictwem jednego pulpitu nawigacyjnego.

Zasoby pomocnicze dla platformy

Architektura obejmuje następujące opcjonalne usługi pomocnicze, aby zwiększyć możliwości platformy:

Monitor to oparta na chmurze usługa służąca do zbierania, analizowania i działania na dziennikach diagnostycznych i telemetrii z obciążeń w chmurze i lokalnych. Za pomocą funkcji Monitor można zmaksymalizować dostępność i wydajność aplikacji i usług za pomocą kompleksowego rozwiązania do monitorowania. Wdróż szczegółowe informacje dla usługi Azure Local, aby uprościć tworzenie reguły zbierania danych monitora (DCR) i szybko włączyć monitorowanie wystąpień lokalnych platformy Azure.

azure policy to usługa, która ocenia zasoby platformy Azure i zasoby lokalne. Usługa Azure Policy ocenia zasoby za pośrednictwem integracji z usługą Azure Arc przy użyciu właściwości tych zasobów do reguł biznesowych, nazywanych definicjami zasad , w celu określenia zgodności lub możliwości, których można użyć do zastosowania konfiguracji gościa maszyny wirtualnej przy użyciu ustawień zasad.

Defender for Cloud to kompleksowy system zarządzania zabezpieczeniami infrastruktury. Zwiększa ona poziom zabezpieczeń centrów danych i zapewnia zaawansowaną ochronę przed zagrożeniami dla obciążeń hybrydowych, niezależnie od tego, czy znajdują się na platformie Azure, czy w innych miejscach oraz w środowiskach lokalnych.

azure Backup to oparta na chmurze usługa, która zapewnia proste, bezpieczne i ekonomiczne rozwiązanie do tworzenia kopii zapasowych danych i odzyskiwania ich z chmury firmy Microsoft. Usługa Azure Backup Server służy do tworzenia kopii zapasowych maszyn wirtualnych wdrożonych w usłudze Azure Local i przechowywania ich w usłudze Backup.

usługi Site Recovery to usługa odzyskiwania po awarii, która zapewnia możliwości BCDR, umożliwiając przełączanie aplikacji biznesowych i obciążeń w tryb failover w przypadku awarii lub awarii. Usługa Site Recovery zarządza replikacją i trybem failover obciążeń uruchamianych na serwerach fizycznych i maszynach wirtualnych między lokacją główną (lokalną) a lokalizacją pomocniczą (Azure).

Opcje projektowania klastra

Ważne jest, aby zrozumieć wymagania dotyczące wydajności i odporności obciążeń podczas projektowania wystąpienia lokalnego platformy Azure. Wymagania te obejmują czas celu czasu odzyskiwania (RTO) i czas celu punktu odzyskiwania (RPO), obliczenia (CPU), pamięć i wymagania dotyczące magazynu dla wszystkich obciążeń wdrożonych w wystąpieniu lokalnym platformy Azure. Kilka cech obciążenia wpływa na proces podejmowania decyzji i obejmują:

Funkcje architektury centralnej jednostki przetwarzania (CPU), w tym funkcje technologii zabezpieczeń sprzętu, liczba procesorów CPU, częstotliwość GHz (szybkość) i liczba rdzeni na gniazdo procesora CPU.

Wymagania jednostki przetwarzania grafiki (GPU) obciążenia, takie jak sztuczna inteligencja lub uczenie maszynowe, wnioskowanie lub renderowanie grafiki.

Pamięć na węzeł lub ilość pamięci fizycznej wymaganej do uruchomienia obciążenia.

Liczba węzłów fizycznych w klastrze, które mają od 1 do 16 węzłów w skali. Maksymalna liczba węzłów wynosi trzy podczas korzystania z architektury sieci bez przełącznika magazynu .

Aby zachować odporność obliczeniową, należy zarezerwować co najmniej N+1 węzły pojemności w klastrze. Ta strategia umożliwia opróżnianie węzłów na potrzeby aktualizacji lub odzyskiwania po nagłych awariach, takich jak awarie zasilania lub awarie sprzętu.

W przypadku obciążeń o znaczeniu krytycznym dla działania firmy lub o znaczeniu krytycznym należy rozważyć zarezerwowanie węzłów N+2 w celu zwiększenia odporności. Jeśli na przykład dwa węzły w klastrze są w trybie offline, obciążenie może pozostać w trybie online. Takie podejście zapewnia odporność w scenariuszach, w których węzeł, w którym uruchomione obciążenie przechodzi w tryb offline podczas planowanej procedury aktualizacji i powoduje, że dwa węzły są w trybie offline jednocześnie.

Wymagania dotyczące odporności, pojemności i wydajności magazynu:

odporność: zalecamy wdrożenie co najmniej trzech węzłów w celu włączenia dublowania trzystopniowego, który zapewnia trzy kopie danych dla woluminów infrastruktury i użytkowników. Dublowanie trójstopniowe zwiększa wydajność i maksymalną niezawodność magazynu.

pojemność: uwzględniana jest łączna wymagana ilość miejsca do użycia po odporności na uszkodzenia lub kopie . Ta liczba wynosi około 33% nieprzetworzonego miejsca do magazynowania dysków warstwy pojemności podczas korzystania z dublowania trzystopniowego.

wydajność: operacje wejścia/wyjścia na sekundę (IOPS) platformy, która określa możliwości przepływności magazynu dla obciążenia po pomnożone przez rozmiar bloku aplikacji.

Aby zaprojektować i zaplanować wdrożenie lokalne platformy Azure, zalecamy użycie narzędzia do określania rozmiaru lokalnego platformy Azure

Narzędzie określania rozmiaru Preferencje sekcji zawiera pytania dotyczące typu systemu (Premier, Integrated System lub Validated Node) i opcji rodziny procesorów CPU. Pomaga również wybrać wymagania dotyczące odporności klastra. Upewnij się, że:

Zarezerwuj co najmniej n+1 węzły pojemności lub jeden węzeł w klastrze.

Zarezerwuj pojemność węzłów N+2 w klastrze, aby zapewnić dodatkową odporność. Ta opcja umożliwia systemowi wytrzymanie awarii węzła podczas aktualizacji lub innego nieoczekiwanego zdarzenia, które ma wpływ na dwa węzły jednocześnie. Gwarantuje również, że w klastrze jest wystarczająca pojemność, aby obciążenie było uruchamiane w pozostałych węzłach online.

Ten scenariusz wymaga użycia dublowania trzystopniowego dla woluminów użytkowników, co jest ustawieniem domyślnym dla klastrów z co najmniej trzema węzłami fizycznymi.

Dane wyjściowe narzędzia do określania rozmiaru lokalnego platformy Azure to lista zalecanych jednostek SKU rozwiązania sprzętowego, które mogą zapewnić wymaganą pojemność obciążenia i wymagania dotyczące odporności platformy na podstawie wartości wejściowych w projekcie sizer. Aby uzyskać więcej informacji na temat dostępnych rozwiązań partnerów sprzętowych OEM, zobacz katalog rozwiązań lokalnych platformy Azure. Aby ułatwić odpowiednie określanie rozmiaru jednostek SKU rozwiązania w celu spełnienia wymagań, skontaktuj się z preferowanym dostawcą rozwiązań sprzętowych lub partnerem ds. integracji systemu (SI).

Dyski fizyczne

bezpośrednie miejsca do magazynowania obsługuje wiele typów dysków fizycznych, które różnią się wydajnością i pojemnością. Podczas projektowania wystąpienia lokalnego platformy Azure skontaktuj się z wybranym partnerem producenta OEM sprzętu, aby określić najbardziej odpowiednie typy dysków fizycznych, aby spełnić wymagania dotyczące pojemności i wydajności obciążenia. Przykłady obejmują obracające się dyski twarde (HDD) lub dyski PÓŁPRZEWODNIK (SSD) i dyski NVMe. Te dyski są często nazywane dyskami flash lub pamięci trwałej (PMem)magazynu , który jest znany jako pamięć klasy magazynu (SCM).

Niezawodność platformy zależy od wydajności krytycznych zależności platformy, takich jak typy dysków fizycznych. Upewnij się, że wybrano odpowiednie typy dysków zgodnie z wymaganiami. W przypadku obciążeń, które mają wymagania dotyczące wysokiej wydajności lub małych opóźnień, należy używać rozwiązań do magazynowania wszystkich dysków flash, takich jak NVMe lub SSD. Obciążenia te obejmują, ale nie są ograniczone do wysoce transakcyjnych technologii baz danych, produkcyjnych klastrów usługi AKS ani obciążeń o krytycznym znaczeniu dla działania firmy lub o krytycznym znaczeniu dla działania firmy, które mają wymagania dotyczące magazynu o małych opóźnieniach lub wysokiej przepływności. Użyj wdrożeń all-flash, aby zmaksymalizować wydajność magazynu. All-NVMe dysk lub wszystkie konfiguracje dysków SSD, zwłaszcza w małej skali, zwiększyć wydajność magazynu i zmaksymalizować wydajność, ponieważ żadne dyski nie są używane jako warstwa pamięci podręcznej Aby uzyskać więcej informacji, zobacz

W przypadku obciążeń ogólnego przeznaczenia konfiguracji magazynu hybrydowego, takich jak dyski NVMe lub dyski SSD na potrzeby pamięci podręcznej i hdd dla pojemności, mogą zapewnić więcej miejsca do magazynowania. Kompromis polega na tym, że obracanie dysków ma niższą wydajność, jeśli obciążenie przekracza zestaw roboczy pamięci podręcznej, a dyski HDD mają krótszy średni czas między wartością awarii w porównaniu z dyskami NVMe i SSD.

Wydajność magazynu klastra ma wpływ na typ dysku fizycznego, który różni się w zależności od właściwości wydajności każdego typu dysku i wybranego mechanizmu buforowania. Typ dysku fizycznego jest integralną częścią każdego projektu i konfiguracji bezpośrednich miejsc do magazynowania. W zależności od wymagań dotyczących obciążenia lokalnego platformy Azure i ograniczeń budżetowych można wybrać zmaksymalizować wydajność, zmaksymalizować pojemnośćlub zaimplementować konfigurację typu dysku mieszanego, która równoważy wydajność i pojemność.

Funkcja Bezpośrednie miejsca do magazynowania zapewnia wbudowane wbudowane, trwałe, w czasie rzeczywistym, odczyt, zapis, pamięć podręczna po stronie serwera, które maksymalizuje wydajność magazynu. Pamięć podręczna powinna mieć rozmiar i skonfigurować do obsługi zestawu roboczego aplikacji i obciążeń. Bezpośrednie dyski wirtualne funkcji Miejsca do magazynowania lub woluminy są używane w połączeniu z pamięcią podręczną woluminu udostępnionego klastra (CSV), aby poprawić wydajność Hyper-V, szczególnie w przypadku niebuforowanego dostępu wejściowego do obciążeń wirtualnych dysków twardych (VHD) lub plików wirtualnego dysku twardego v2 (VHDX).

Napiwek

W przypadku obciążeń o wysokiej wydajności lub opóźnieniach zalecamy użycie wszystkich dysków flash (wszystkie dyski NVMe lub wszystkie dyski SSD) i rozmiar klastra o rozmiarze co najmniej trzech węzłów fizycznych. Wdrożenie tego projektu przy użyciu domyślnej konfiguracji magazynu ustawień używa dublowania trzystopniowego dla woluminów infrastruktury i użytkowników. Ta strategia wdrażania zapewnia najwyższą wydajność i odporność. W przypadku korzystania z konfiguracji all-NVMe lub all-SSD można korzystać z pełnej pojemności miejsca do magazynowania dla każdego dysku flash. W przeciwieństwie do konfiguracji hybrydowych lub mieszanych dysków NVMe i SSD nie ma pojemności zarezerwowanej do buforowania. Zapewnia to optymalne wykorzystanie zasobów magazynu. Aby uzyskać więcej informacji na temat równoważenia wydajności i pojemności w celu spełnienia wymagań dotyczących obciążenia, zobacz Woluminy planu — gdy wydajność ma największe znaczenie.

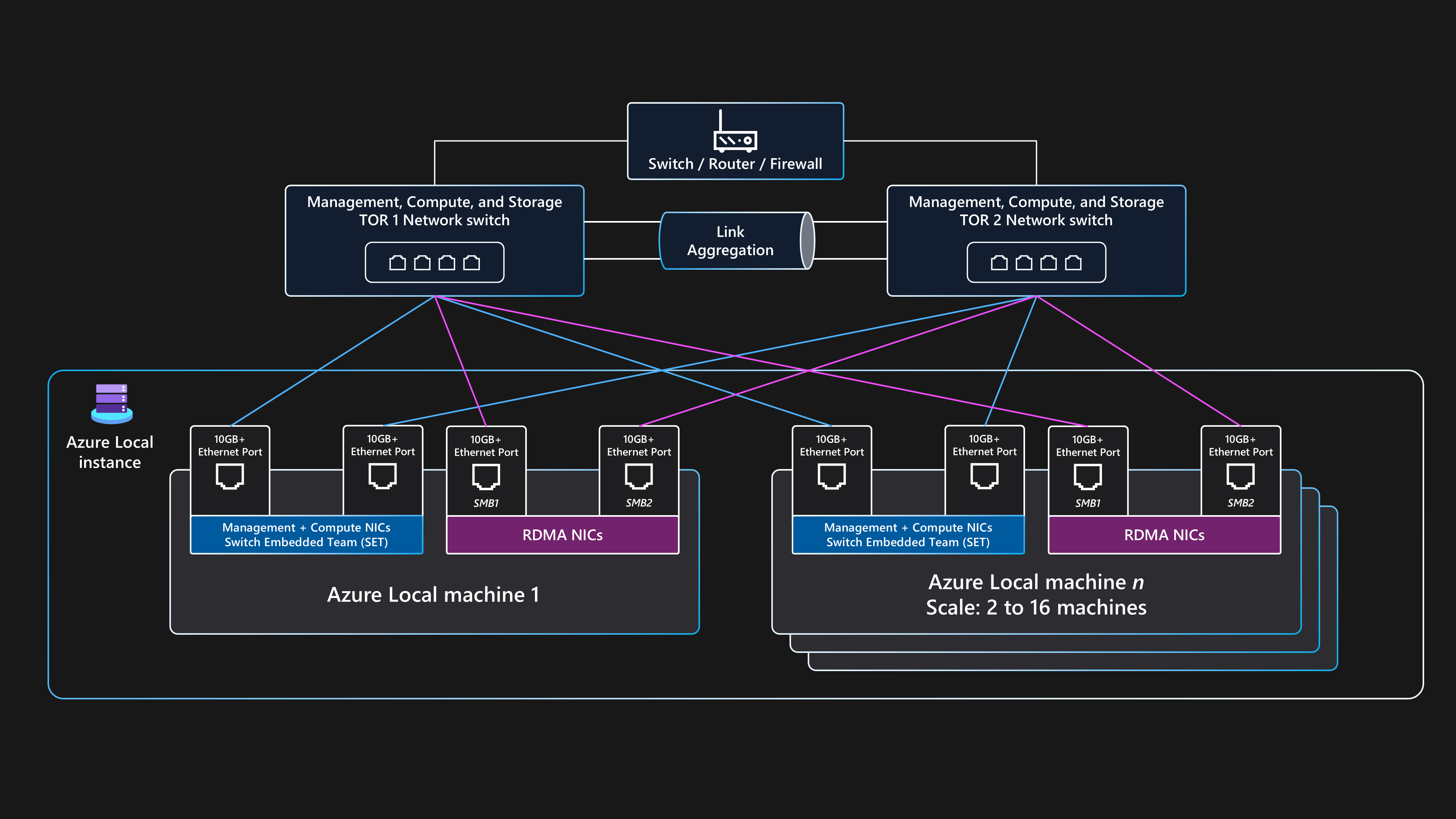

Projekt sieci

Projekt sieci to ogólny układ składników w infrastrukturze fizycznej sieci i konfiguracjach logicznych. Można użyć tych samych portów fizycznej karty sieciowej (NIC) dla wszystkich kombinacji intencji zarządzania, obliczeń i sieci magazynu. Użycie tych samych portów karty sieciowej dla wszystkich celów związanych z intencją jest nazywane w pełni zbieżną konfiguracją sieci.

Mimo że obsługiwana jest w pełni konwergentna konfiguracja sieci, optymalną konfiguracją wydajności i niezawodności jest użycie dedykowanych portów karty sieciowej. W związku z tym ta architektura bazowa zawiera przykładowe wskazówki dotyczące wdrażania wystąpienia lokalnego platformy Azure z wieloma węzłami platformy Azure przy użyciu architektury sieci przełączonej magazynu z dwoma portami karty sieciowej, które są zbieżne z intencjami zarządzania i obliczeń oraz dwoma dedykowanymi portami karty sieciowej dla intencji magazynu. Aby uzyskać więcej informacji, zobacz zagadnienia dotyczące sieci dotyczące wdrożeń w chmurze usługi Azure Local.

Ta architektura wymaga co najmniej dwóch węzłów fizycznych i maksymalnie 16 węzłów w skali. Każdy węzeł wymaga czterech portów karty sieciowej podłączonych do dwóch przełączników Top-of-Rack (ToR). Dwa przełączniki toR powinny być połączone za pośrednictwem łączy agregacji łączy z wieloma obudowami (MLAG). Dwa porty karty sieciowej używane do ruchu intencji magazynu muszą obsługiwać zdalny bezpośredni dostęp do pamięci (RDMA). Te porty wymagają minimalnej szybkości łącza wynoszącej 10 Gb/s, ale zalecamy szybkość 25 Gb/s lub wyższą. Dwa porty karty sieciowej używane do zarządzania i intencji obliczeniowych są zbieżne przy użyciu technologii tworzenia zespołu osadzonego przełącznika (SET). Technologia SET zapewnia nadmiarowość linków i możliwości równoważenia obciążenia. Te porty wymagają minimalnej szybkości łącza wynoszącej 1 Gb/s, ale zalecamy szybkość 10 Gb/s lub wyższą.

Topologia sieci fizycznej

Poniższa topologia sieci fizycznej przedstawia rzeczywiste połączenia fizyczne między węzłami i składnikami sieci.

Podczas projektowania magazynu wielowęźle przełączonego wdrożenia lokalnego platformy Azure, które korzysta z tej architektury bazowej, potrzebne są następujące składniki:

Przełączniki Podwójne toR:

Podwójne przełączniki sieciowe toR są wymagane do odporności sieci i możliwości obsługi lub stosowania aktualizacji oprogramowania układowego do przełączników bez ponoszenia przestojów. Ta strategia uniemożliwia pojedynczy punkt awarii (SPoF).

Dwa przełączniki ToR są używane do magazynowania lub ruchu na wschód-zachód. Przełączniki te używają dwóch dedykowanych portów Ethernet, które mają określone wirtualne sieci lokalne magazynu (VLAN) i klasy ruchu sterowania przepływem priorytetu (PFC), które są zdefiniowane w celu zapewnienia bezstratnej komunikacji RDMA.

Te przełączniki łączą się z węzłami za pośrednictwem Ethernet.

Co najmniej dwa węzły fizyczne i maksymalnie 16 węzłów:

Każdy węzeł to serwer fizyczny z systemem operacyjnym Azure Stack HCI.

Każdy węzeł wymaga łącznie czterech portów karty sieciowej: dwa porty obsługujące funkcję RDMA dla magazynu i dwa porty karty sieciowej na potrzeby zarządzania i ruchu obliczeniowego.

Magazyn używa dwóch dedykowanych portów kart sieciowych obsługujących funkcję RDMA, które łączą się z jedną ścieżką do każdego z dwóch przełączników tor. Takie podejście zapewnia nadmiarowość ścieżki łącza i dedykowaną priorytetową przepustowość dla ruchu magazynu SMB Direct.

Zarządzanie i obliczenia korzystają z dwóch portów karty sieciowej, które zapewniają jedną ścieżkę do każdego z dwóch przełączników ToR w celu zapewnienia nadmiarowości ścieżki łącza.

Łączność zewnętrzna:

Podwójne przełączniki ToR łączą się z siecią zewnętrzną, taką jak wewnętrzna firmowa sieć LAN, aby zapewnić dostęp do wymaganych adresów URL ruchu wychodzącego przy użyciu urządzenia sieci brzegowej. To urządzenie może być zaporą lub routerem. Te przełączniki kierują ruch wychodzący i wychodzący z wystąpienia lokalnego platformy Azure lub ruchu północno-południowego.

Zewnętrzna łączność ruchu północno-południowego obsługuje intencję zarządzania klastrem i intencje obliczeniowe. Jest to osiągane przy użyciu dwóch portów przełącznika i dwóch portów karty sieciowej na węzeł, które są zbieżne za pośrednictwem osadzonego tworzenia zespołu przełącznika (SET) i przełącznika wirtualnego w Hyper-V w celu zapewnienia odporności. Te składniki działają w celu zapewnienia łączności zewnętrznej dla maszyn wirtualnych usługi Azure Arc i innych zasobów obciążeń wdrożonych w sieciach logicznych utworzonych w usłudze Resource Manager przy użyciu witryny Azure Portal, interfejsu wiersza polecenia lub szablonów IaC.

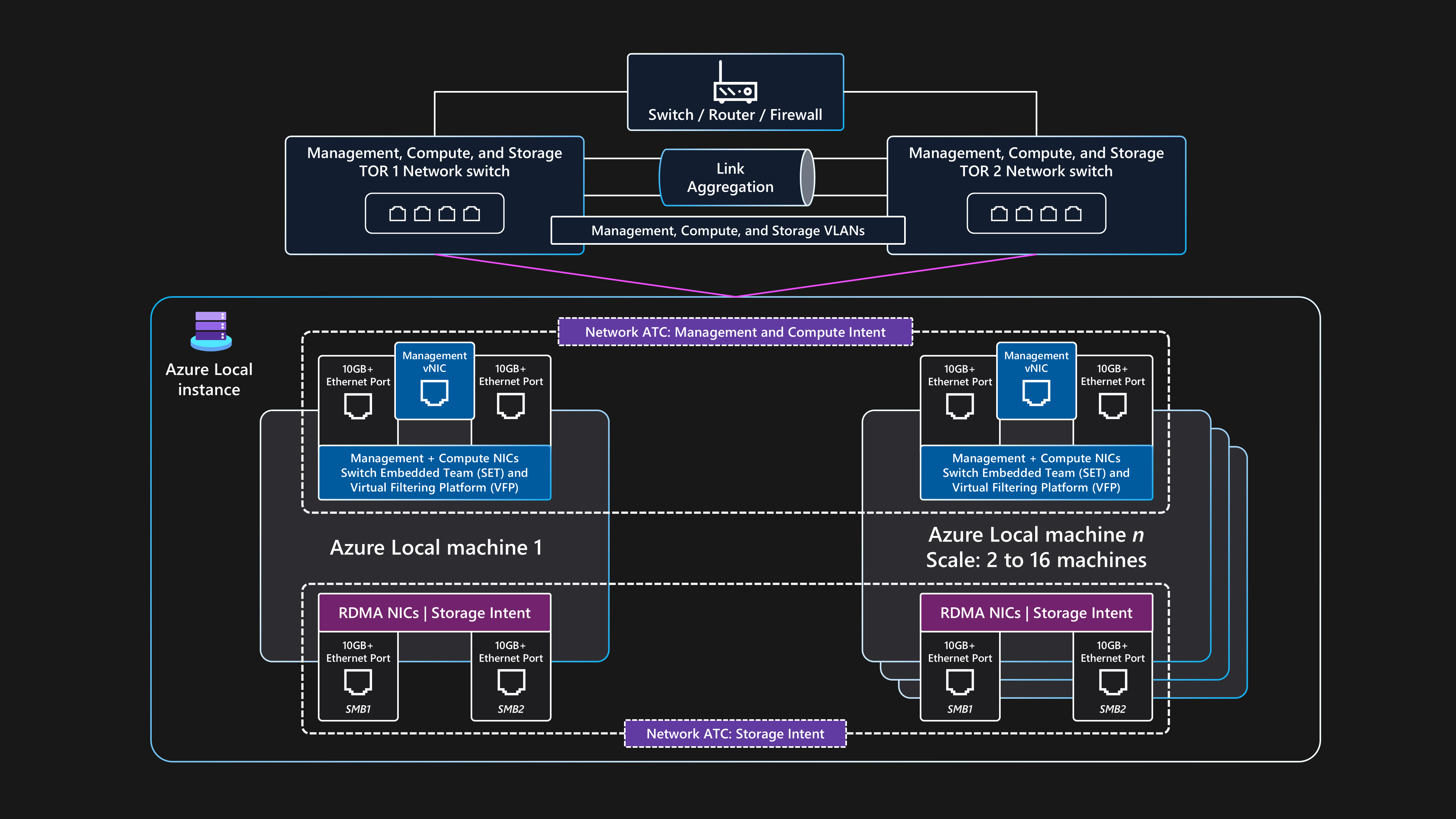

Topologia sieci logicznej

Topologia sieci logicznej przedstawia przegląd sposobu przepływu danych sieciowych między urządzeniami, niezależnie od ich połączeń fizycznych.

Podsumowanie konfiguracji logicznej dla tej architektury punktu odniesienia przełączonego magazynu wielowęźnikowego dla usługi Azure Local jest następujące:

Przełączniki Podwójne toR:

- Przed wdrożeniem klastra należy skonfigurować dwa przełączniki sieciowe tor z wymaganymi identyfikatorami sieci VLAN, maksymalnymi ustawieniami jednostki transmisji i konfiguracją mostkowania centrum danych dlazarządzania

, obliczeniowych iportów magazynu . Aby uzyskać więcej informacji, zobacz Wymagania dotyczące sieci fizycznej dla usługi Azure Locallub poproś dostawcę sprzętu przełącznika lub partnera SI o pomoc.

- Przed wdrożeniem klastra należy skonfigurować dwa przełączniki sieciowe tor z wymaganymi identyfikatorami sieci VLAN, maksymalnymi ustawieniami jednostki transmisji i konfiguracją mostkowania centrum danych dlazarządzania

Usługa Azure Local używa podejścia Network ATC do zastosowania automatyzacji sieci i konfiguracji sieci opartej na intencji.

Usługa Network ATC została zaprojektowana w celu zapewnienia optymalnej konfiguracji sieci i przepływu ruchu przy użyciu ruchu sieciowego intencji. Usługa Network ATC definiuje, które fizyczne porty karty sieciowej są używane dla różnych intencji ruchu sieciowego (lub typów), takich jak dla klastra zarządzania, obciążenia obliczeniowychi intencji magazynu klastra.

Zasady oparte na intencjach upraszczają wymagania dotyczące konfiguracji sieci, automatyzując konfigurację sieci węzła na podstawie danych wejściowych parametrów określonych w ramach procesu wdrażania w chmurze lokalnej platformy Azure.

Komunikacja zewnętrzna:

Gdy węzły lub obciążenie muszą komunikować się zewnętrznie przez uzyskanie dostępu do firmowej sieci LAN, Internetu lub innej usługi, są one kierowane przy użyciu przełączników podwójnych tor. Ten proces został opisany w poprzedniej sekcji topologii sieci fizycznej.

Gdy dwa przełączniki tor działają jako urządzenia warstwy 3, obsługują routing i zapewniają łączność poza klastrem z urządzeniem granicznym brzegowym, takim jak zapora lub router.

Intencja sieci zarządzania używa konwergentnego interfejsu wirtualnego zespołu SET, który umożliwia zasobom płaszczyzny sterowania i adresowi IP zarządzania klastrem komunikację zewnętrzną.

W przypadku intencji sieci obliczeniowej można utworzyć co najmniej jedną sieć logiczną na platformie Azure z określonymi identyfikatorami sieci VLAN dla danego środowiska. Zasoby obciążenia, takie jak maszyny wirtualne, używają tych identyfikatorów, aby udzielić dostępu do sieci fizycznej. Sieci logiczne używają dwóch fizycznych portów karty sieciowej, które są zbieżne przy użyciu zespołu SET dla intencji obliczeniowych i zarządzania.

Ruch magazynu:

Węzły fizyczne komunikują się ze sobą przy użyciu dwóch dedykowanych portów karty sieciowej podłączonych do przełączników toR w celu zapewnienia wysokiej przepustowości i odporności na ruch magazynu.

Porty magazynu SMB1 i SMB2 łączą się z dwiema oddzielnymi sieciami bez routingu (lub warstwy 2). Każda sieć ma skonfigurowany określony identyfikator sieci VLAN, który musi być zgodny z konfiguracją portów przełącznika na domyślnych identyfikatorów sieci VLAN magazynu magazynu: 711 i 712.

Nie ma bramy domyślnej skonfigurowane na dwóch portach karty sieciowej intencji magazynu w systemie operacyjnym Azure Stack HCI.

Każdy węzeł może uzyskiwać dostęp do funkcji bezpośrednich miejsc do magazynowania klastra, takich jak zdalne dyski fizyczne, które są używane w puli magazynów, dyskach wirtualnych i woluminach. Dostęp do tych funkcji jest ułatwiony za pośrednictwem protokołu SMB-Direct RDMA za pośrednictwem dwóch dedykowanych portów karty sieciowej magazynu dostępnych w każdym węźle. Funkcja SMB Multichannel jest używana do odporności.

Ta konfiguracja zapewnia wystarczającą szybkość transferu danych dla operacji związanych z magazynem, takich jak utrzymywanie spójnych kopii danych dla woluminów dublowanych.

Wymagania dotyczące przełącznika sieciowego

Przełączniki Ethernet muszą spełniać różne specyfikacje wymagane przez platformę Azure Local i ustawione przez Institute of Electrical and Electronics Engineers Standards Association (IEEE SA). Na przykład w przypadku wdrożeń przełączonych w magazynie wielowęźle sieć magazynowa jest używana do RDMA za pośrednictwem usługi RoCE v2 lub iWARP. Ten proces wymaga standardu IEEE 802.1Qbb PFC, aby zapewnić bezstratną komunikację dla klasy ruchu magazynu . Przełączniki toR muszą zapewnić obsługę ieee 802.1Q dla sieci VLAN i IEEE 802.1AB dla protokołu odnajdywania warstwy łącza.

Jeśli planujesz używać istniejących przełączników sieciowych dla wdrożenia lokalnego platformy Azure, zapoznaj się z listą obowiązkowych standardów IEEE i specyfikacji, które muszą zapewnić przełączniki sieciowe i konfiguracja. Podczas zakupu nowych przełączników sieciowych zapoznaj się z listą modeli przełączników certyfikowanych przez dostawcę sprzętu, które obsługują wymagania sieci lokalnej platformy Azure.

Wymagania dotyczące adresów IP

W przypadku wdrożenia przełączonego magazynu wielowęzłowego liczba potrzebnych adresów IP zwiększa się wraz z dodaniu każdego węzła fizycznego do maksymalnie 16 węzłów w ramach jednego klastra. Na przykład w celu wdrożenia konfiguracji magazynu przełączonego z dwoma węzłami usługi Azure Local infrastruktura klastra wymaga przydzielenia co najmniej 11 x adresów IP. W przypadku korzystania z mikrosegmentacji lub sieci zdefiniowanej programowo wymagane jest więcej adresów IP. Aby uzyskać więcej informacji, zobacz Przejrzyj wymagania dotyczące adresów IP wzorca referencyjnego magazynu z dwoma węzłami dla usługi Azure Local.

Podczas projektowania i planowania wymagań dotyczących adresów IP dla usługi Azure Local pamiętaj, aby uwzględnić dodatkowe adresy IP lub zakresy sieci wymagane dla obciążenia poza wymaganiami dotyczącymi lokalnego wystąpienia i składników infrastruktury platformy Azure. Jeśli planujesz wdrożyć usługę AKS na platformie Azure Lokalnie, zobacz AKS włączone przez wymagania dotyczące sieci usługi Azure Arc.

Monitoring

Aby ulepszyć monitorowanie i alerty, włącz Monitor Insights on Azure Local. Szczegółowe informacje mogą być skalowane w celu monitorowania wielu klastrów lokalnych i zarządzania nimi przy użyciu spójnego środowiska platformy Azure. Szczegółowe informacje używają liczników wydajności klastra i kanałów dziennika zdarzeń do monitorowania kluczowych funkcji lokalnych platformy Azure. Dzienniki są zbierane przez kontroler domeny skonfigurowany za pośrednictwem usługi Monitor i Log Analytics.

Szczegółowe informacje o usłudze Azure Local są tworzone przy użyciu usługi Monitor i Log Analytics, co gwarantuje, że zawsze up-to— skalowalne rozwiązanie, które jest wysoce dostosowywane. Szczegółowe informacje zapewniają dostęp do domyślnych skoroszytów z podstawowymi metrykami oraz wyspecjalizowanymi skoroszytami utworzonymi na potrzeby monitorowania kluczowych funkcji usługi Azure Local. Te składniki udostępniają rozwiązanie do monitorowania niemal w czasie rzeczywistym i umożliwiają tworzenie grafów, dostosowywanie wizualizacji za pomocą agregacji i filtrowania oraz konfigurację niestandardowych reguł alertów dotyczących kondycji zasobów.

Zarządzanie aktualizacjami

Wystąpienia lokalne platformy Azure i wdrożone zasoby obciążenia, takie jak maszyny wirtualne usługi Azure Arc, muszą być regularnie aktualizowane i poprawiane. Regularnie stosując aktualizacje, upewnisz się, że organizacja utrzymuje wysoki poziom zabezpieczeń i zwiększa ogólną niezawodność i obsługę majątku. Zalecamy używanie automatycznych i okresowych ręcznych ocen na potrzeby wczesnego odnajdywania i stosowania poprawek zabezpieczeń i aktualizacji systemu operacyjnego.

Aktualizacje infrastruktury

Usługa Azure Local jest stale aktualizowana w celu poprawy jakości obsługi klienta i dodawania nowych funkcji i funkcji. Ten proces jest zarządzany za pośrednictwem pociągów wydań, które dostarczają nowe kompilacje bazowe kwartalnie. Kompilacje bazowe są stosowane do wystąpień lokalnych platformy Azure, aby zapewnić ich aktualność. Oprócz regularnych aktualizacji kompilacji planu bazowego usługa Azure Local jest aktualizowana przy użyciu comiesięcznych aktualizacji zabezpieczeń i niezawodności systemu operacyjnego.

Update Manager to usługa platformy Azure, której można użyć do stosowania, wyświetlania i zarządzania aktualizacjami dla usługi Azure Local. Ta usługa udostępnia mechanizm wyświetlania wszystkich wystąpień lokalnych platformy Azure w całej infrastrukturze i lokalizacjach brzegowych przy użyciu witryny Azure Portal w celu zapewnienia scentralizowanego środowiska zarządzania. Aby uzyskać więcej informacji, zobacz następujące zasoby:

Przeglądanie faz aktualizacji lokalnej platformy Azure

aktualizowanie lokalnego platformy Azure za pomocą usługi Azure Update Manager

Ważne jest, aby regularnie sprawdzać dostępność nowych sterowników i aktualizacji oprogramowania układowego, takich jak co trzy do sześciu miesięcy. Jeśli używasz wersji kategorii rozwiązania Premier dla sprzętu lokalnego platformy Azure, aktualizacje pakietów rozszerzenia konstruktora rozwiązań są zintegrowane z programem Update Manager w celu zapewnienia uproszczonego środowiska aktualizacji. Jeśli używasz zweryfikowanych węzłów lub zintegrowanej kategorii systemu, może być wymagane pobranie i uruchomienie pakietu aktualizacji specyficznego dla producenta OEM zawierającego oprogramowanie układowe i aktualizacje sterowników sprzętu. Aby określić, jak aktualizacje są dostarczane dla sprzętu, skontaktuj się ze sprzętowym partnerem OEM lub SI.

Stosowanie poprawek systemu operacyjnego gościa obciążenia

Maszyny wirtualne usługi Azure Arc wdrożone na platformie Azure lokalnie można zarejestrować przy użyciu azure Update Manager (AUM) w celu zapewnienia ujednoliconego środowiska zarządzania poprawkami przy użyciu tego samego mechanizmu używanego do aktualizowania węzłów fizycznych klastra lokalnego platformy Azure. Za pomocą usługi AUM można utworzyć konfiguracje konserwacji gościa . Te konfiguracje kontrolują ustawienia, takie jak ustawienie Ponowne uruchamianie ponowne uruchomienie w razie potrzeby, harmonogram (daty, godziny i opcje powtarzania) oraz dynamiczna (subskrypcja) lub statyczna lista maszyn wirtualnych usługi Azure Arc dla zakresu. Te ustawienia kontrolują konfigurację systemu operacyjnego, gdy poprawki zabezpieczeń systemu operacyjnego są instalowane wewnątrz systemu operacyjnego gościa maszyny wirtualnej obciążenia.

Zagadnienia dotyczące

Te zagadnienia obejmują implementację filarów platformy Azure Well-Architected Framework, która jest zestawem wytycznych, które mogą służyć do poprawy jakości obciążenia. Aby uzyskać więcej informacji, zobacz Microsoft Azure Well-Architected Framework.

Niezawodność

Niezawodność zapewnia, że aplikacja może spełnić zobowiązania podjęte przez klientów. Aby uzyskać więcej informacji, zobacz

Identyfikowanie potencjalnych punktów awarii

Każda architektura jest podatna na błędy. Możesz przewidzieć awarie i przygotować się za pomocą środków zaradczych z analizą trybu awarii. W poniższej tabeli opisano cztery przykłady potencjalnych punktów awarii w tej architekturze:

| Składnik | Ryzyko | Prawdopodobieństwo | Efekt/środki zaradcze/uwaga | Awarii |

|---|---|---|---|---|

| Awaria wystąpienia lokalnego platformy Azure | Awaria zasilania, sieci, sprzętu lub oprogramowania | Średni | Aby zapobiec długotrwałej awarii aplikacji spowodowanej awarią wystąpienia lokalnego platformy Azure dla firm lub przypadków użycia o krytycznym znaczeniu, obciążenie powinno być zaprojektowane przy użyciu zasad wysokiej dostępności i odzyskiwania po awarii. Na przykład można użyć standardowych technologii replikacji danych obciążeń do obsługi wielu kopii trwałych danych stanu wdrożonych przy użyciu wielu maszyn wirtualnych usługi Azure Arc lub wystąpień usługi AKS wdrożonych w oddzielnych wystąpieniach lokalnych platformy Azure i w oddzielnych lokalizacjach fizycznych. | Potencjalna awaria |

| Awaria lokalnego pojedynczego węzła fizycznego platformy Azure | Awaria zasilania, sprzętu lub oprogramowania | Średni | Aby zapobiec długotrwałej awarii aplikacji spowodowanej awarią pojedynczej maszyny lokalnej platformy Azure, wystąpienie lokalne platformy Azure powinno mieć wiele węzłów fizycznych. Wymagania dotyczące pojemności obciążenia w fazie projektowania klastra określają liczbę węzłów. Zalecamy posiadanie co najmniej trzech węzłów. Zalecamy również użycie dublowania trójstopniowego, czyli domyślnego trybu odporności magazynu dla klastrów z co najmniej trzema węzłami. Aby zapobiec funkcji SPoF i zwiększyć odporność obciążenia, wdróż wiele wystąpień obciążenia przy użyciu co najmniej dwóch maszyn wirtualnych usługi Azure Arc lub zasobników kontenerów działających w wielu węzłach roboczych usługi AKS. Jeśli jeden węzeł ulegnie awarii, maszyny wirtualne usługi Azure Arc i obciążenia/usługi aplikacji zostaną uruchomione ponownie w pozostałych węzłach fizycznych online w klastrze. | Potencjalna awaria |

| Maszyna wirtualna usługi Azure Arc lub węzeł roboczy usługi AKS (obciążenie) | Konfiguracji | Średni | Użytkownicy aplikacji nie mogą się zalogować lub uzyskać dostępu do aplikacji. Błędy konfiguracji powinny zostać przechwycone podczas wdrażania. Jeśli te błędy wystąpią podczas aktualizacji konfiguracji, zespół DevOps musi wycofać zmiany. W razie potrzeby możesz ponownie wdrożyć maszynę wirtualną. Ponowne wdrożenie trwa krócej niż 10 minut, ale może trwać dłużej zgodnie z typem wdrożenia. | Potencjalna awaria |

| Łączność z platformą Azure | Awaria sieci | Średni | Klaster musi regularnie uzyskiwać dostęp do płaszczyzny sterowania platformy Azure na potrzeby funkcji rozliczeń, zarządzania i monitorowania. Jeśli klaster utraci łączność z platformą Azure, działa w stanie obniżonej wydajności. Na przykład nie można wdrożyć nowych maszyn wirtualnych usługi Azure Arc ani klastrów usługi AKS, jeśli klaster utraci łączność z platformą Azure. Istniejące obciążenia uruchomione w klastrze HCI nadal działają, ale należy przywrócić połączenie w ciągu 48 do 72 godzin, aby zapewnić nieprzerwaną operację. | Żaden |

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące przeprowadzania analizy trybu awarii.

Cele dotyczące niezawodności

W tej sekcji opisano przykładowy scenariusz. Fikcyjny klient o nazwie Contoso Manufacturing używa tej architektury referencyjnej do wdrożenia lokalnej platformy Azure. Firma chce spełnić swoje wymagania i wdrożyć obciążenia i zarządzać nimi lokalnie. Firma Contoso Manufacturing ma wewnętrzny cel poziomu usług (SLO) na poziomie 99,8%, że uczestnicy projektu biznesowego i aplikacji zgadzają się na ich usługi.

Cel SLO 99.8% czasu pracy lub dostępności powoduje następujące okresy dozwolonego przestoju lub niedostępności dla aplikacji wdrożonych przy użyciu maszyn wirtualnych usługi Azure Arc uruchamianych na platformie Azure Lokalnie:

Co tydzień: 20 minut i 10 sekund

Co miesiąc: 1 godzina, 26 minut i 56 sekund

Co kwartał: 4 godziny, 20 minut i 49 sekund

Co rok: 17 godzin, 23 minuty i 16 sekund

Aby pomóc spełnić cele slo, firma Contoso Manufacturing implementuje zasadę najniższych uprawnień (PoLP), aby ograniczyć liczbę administratorów wystąpień lokalnych platformy Azure do małej grupy zaufanych i kwalifikowanych osób. Takie podejście pomaga zapobiec przestojom z powodu nieumyślnych lub przypadkowych akcji wykonywanych na zasobach produkcyjnych. Ponadto dzienniki zdarzeń zabezpieczeń lokalnych kontrolerów domeny usług Active Directory Domain Services (AD DS) są monitorowane w celu wykrywania i zgłaszania zmian członkostwa w grupach kont użytkowników, znanych jako dodawania i usuwania akcji, dla administratorów lokalnego wystąpienia platformy Azure grupy przy użyciu rozwiązania do zarządzania zdarzeniami informacji o zabezpieczeniach (SIEM). Monitorowanie zwiększa niezawodność i zwiększa bezpieczeństwo rozwiązania.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące zarządzania tożsamościami i dostępem.

Ścisłe procedury kontroli zmian są spełnione w systemach produkcyjnych firmy Contoso Manufacturing. Ten proces wymaga przetestowania i zweryfikowania wszystkich zmian w reprezentatywnym środowisku testowym przed wdrożeniem w środowisku produkcyjnym. Wszystkie zmiany przesłane do cotygodniowego procesu doradczego zespołu doradczego ds. zmian muszą zawierać szczegółowy plan implementacji (lub link do kodu źródłowego), ocenę poziomu ryzyka, kompleksowy plan wycofywania, testowanie po wydaniu i weryfikację oraz jasne kryteria powodzenia zmiany do przeglądu lub zatwierdzenia.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące bezpiecznych praktyk wdrażania.

miesięczne poprawki zabezpieczeń i kwartalne aktualizacje punktu odniesienia są stosowane do produkcyjnego wystąpienia lokalnego platformy Azure dopiero po ich zweryfikowaniu przez środowisko przedprodukcyjne. Update Manager i funkcja aktualizacji obsługującej klaster automatyzują proces korzystania z migracji na żywo maszyny wirtualnej w celu zminimalizowania przestojów obciążeń krytycznych dla działania firmy podczas miesięcznych operacji obsługi. Standardowe procedury operacyjne firmy Contoso wymagają zastosowania aktualizacji kompilacji zabezpieczeń, niezawodności lub planu bazowego do wszystkich systemów produkcyjnych w ciągu czterech tygodni od daty wydania. Bez tych zasad systemy produkcyjne nie mogą być na bieżąco z comiesięcznymi aktualizacjami systemu operacyjnego i aktualizacjami zabezpieczeń. Nieaktualne systemy negatywnie wpływają na niezawodność i bezpieczeństwo platformy.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące ustanawiania punktu odniesienia zabezpieczeń.

firma Contoso Manufacturing implementuje codziennie, co tydzień i co miesiąc kopie zapasowe zachować ostatnie 6 x dni codziennych kopii zapasowych (od poniedziałków do sobot), ostatnie 3 x tygodniowe (każda niedziela) i 3 x miesięczne kopie zapasowe, z każdym niedzielnym tygodniu 4 są przechowywane, aby stać się miesiąc 1, miesiąc 2 i miesiąc 3 kopie zapasowe przy użyciu harmonogram oparty na kalendarzu kroczącym, który jest udokumentowany i możliwy do inspekcji. Takie podejście spełnia wymagania firmy Contoso Manufacturing w celu zapewnienia odpowiedniej równowagi między liczbą dostępnych punktów odzyskiwania danych a obniżeniem kosztów usługi magazynu kopii zapasowych poza siedzibą firmy lub w chmurze.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące projektowania strategii odzyskiwania po awarii.

procesy tworzenia kopii zapasowych i odzyskiwania danych są testowane dla każdego systemu biznesowego co sześć miesięcy. Ta strategia zapewnia, że procesy BCDR są prawidłowe i że firma jest chroniona w przypadku awarii centrum danych lub zdarzenia cybernetycznego.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące projektowania strategii testowania niezawodności.

Procedury i procesy operacyjne opisane wcześniej w artykule oraz zalecenia przedstawione w przewodniku dotyczącym usługi Well-Architected Framework dla usługi Azure Localumożliwiają firmie Contoso Manufacturing spełnienie wymagań docelowych poziomu 99,8% slo oraz efektywne skalowanie wdrożeń lokalnych i obciążeń platformy Azure oraz zarządzanie nimi w wielu zakładach produkcyjnych rozproszonych na całym świecie.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące definiowania celów niezawodności.

Nadmiarowości

Rozważ obciążenie wdrożone w jednym wystąpieniu lokalnym platformy Azure jako lokalnie nadmiarowe wdrożenie. Klaster zapewnia wysoką dostępność na poziomie platformy, ale należy wdrożyć klaster w jednym stojaku. W przypadku przypadków użycia o znaczeniu krytycznym dla działania firmy lub krytycznym zalecamy wdrożenie wielu wystąpień obciążenia lub usługi w co najmniej dwóch osobnych wystąpieniach lokalnych platformy Azure, najlepiej w oddzielnych lokalizacjach fizycznych.

Użyj standardowych wzorców wysokiej dostępności dla obciążeń zapewniających replikację aktywną/pasywną, replikację synchroniczną lub replikację asynchroniczną, taką jak zawsze włączona programu SQL Server. Można również użyć zewnętrznej technologii równoważenia obciążenia sieciowego (NLB), która kieruje żądania użytkowników do wielu wystąpień obciążeń uruchamianych w wystąpieniach lokalnych platformy Azure wdrożonych w oddzielnych lokalizacjach fizycznych. Rozważ użycie zewnętrznego urządzenia równoważenia obciążenia sieciowego partnera. Możesz też ocenić opcje równoważenia obciążenia , które obsługują routing ruchu dla usług hybrydowych i lokalnych, takich jak wystąpienie usługi Azure Application Gateway, które używa usługi Azure ExpressRoute lub tunelu sieci VPN do łączenia się z usługą lokalną.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące projektowania pod kątem nadmiarowości.

Bezpieczeństwo

Zabezpieczenia zapewniają ochronę przed celowymi atakami i nadużyciami cennych danych i systemów. Aby uzyskać więcej informacji, zobacz Lista kontrolna przeglądu projektu dotyczącazabezpieczeń.

Zagadnienia dotyczące zabezpieczeń obejmują:

Bezpieczny fundament dla lokalnej platformy Azure: Azure Local to bezpieczny domyślnie produkt, który używa zweryfikowanych składników sprzętowych z modułem TPM, UEFI i bezpiecznym rozruchem w celu utworzenia bezpiecznej podstawy dla lokalnej platformy Azure i zabezpieczeń obciążeń. Po wdrożeniu przy użyciu domyślnych ustawień zabezpieczeń usługa Azure Local ma włączoną kontrolę aplikacji usługi Windows Defender, funkcję Credential Guard i funkcję BitLocker. Aby uprościć delegowanie uprawnień przy użyciu funkcji PoLP, użyj role wbudowanej kontroli dostępu opartej na rolach (RBAC) platformy Azure, takie jak administrator lokalny platformy Azure dla administratorów platformy i współautor lokalnej maszyny wirtualnej platformy Azure lub czytelnik lokalnych maszyn wirtualnych platformy Azure dla operatorów obciążeń.

domyślne ustawienia zabezpieczeń: domyślne zabezpieczenia lokalne platformy Azure stosuje domyślne ustawienia zabezpieczeń dla wystąpienia lokalnego platformy Azure podczas wdrażania i umożliwia kontrolowanie dryfu, aby zachować węzły w znanym dobrym stanie. Ustawienia domyślne zabezpieczeń umożliwiają zarządzanie zabezpieczeniami klastra, kontrolą dryfu i zabezpieczonymi ustawieniami serwera podstawowego w klastrze.

Dzienniki zdarzeń zabezpieczeń: przekazywanie lokalnego dziennika systemowego platformy Azure integruje się z rozwiązaniami do monitorowania zabezpieczeń, pobierając odpowiednie dzienniki zdarzeń zabezpieczeń w celu agregowania i przechowywania zdarzeń do przechowywania na własnej platformie SIEM.

Ochrona przed zagrożeniami i lukami w zabezpieczeniach: Defender for Cloud chroni wystąpienie lokalne platformy Azure przed różnymi zagrożeniami i lukami w zabezpieczeniach. Ta usługa pomaga zwiększyć poziom zabezpieczeń środowiska lokalnego platformy Azure i chronić przed istniejącymi i zmieniającymi się zagrożeniami.

wykrywanie zagrożeń i korygowanie :Microsoft Advanced Threat Analytics wykrywa i koryguje zagrożenia, takie jak te przeznaczone dla usług AD DS, które zapewniają usługi uwierzytelniania węzłom lokalnego wystąpienia platformy Azure i ich obciążeniam maszyn wirtualnych z systemem Windows Server.izolacja sieci: izolowanie sieci w razie potrzeby. Można na przykład aprowizować wiele sieci logicznych korzystających z oddzielnych sieci VLAN i zakresów adresów sieciowych. W przypadku korzystania z tego podejścia upewnij się, że sieć zarządzania może dotrzeć do każdej sieci logicznej i sieci VLAN, aby węzły wystąpienia lokalnego platformy Azure mogły komunikować się z sieciami sieci VLAN za pośrednictwem przełączników lub bram usługi ToR. Ta konfiguracja jest wymagana do zarządzania obciążeniem, na przykład umożliwienia agentom zarządzania infrastrukturą komunikowania się z systemem operacyjnym gościa obciążenia.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące tworzenia strategii segmentacji.

Optymalizacja kosztów

Optymalizacja kosztów dotyczy sposobów zmniejszenia niepotrzebnych wydatków i poprawy wydajności operacyjnej. Aby uzyskać więcej informacji, zobacz Lista kontrolna przeglądu projektu dlaoptymalizacji kosztów.

Zagadnienia dotyczące optymalizacji kosztów obejmują:

modelu rozliczeń w stylu chmury na potrzeby licencjonowania: cennik lokalny platformy Azure jest zgodny z modelem rozliczeń miesięcznej subskrypcji z ryczałtowaną stawką na rdzeń procesora fizycznego w wystąpieniu lokalnym platformy Azure. W przypadku korzystania z innych usług platformy Azure obowiązują dodatkowe opłaty za użycie. Jeśli masz lokalne licencje podstawowe dla wersji Windows Server Datacenter z aktywnym pakietem Software Assurance, możesz wymienić te licencje, aby aktywować lokalne wystąpienie platformy Azure i opłaty za subskrypcję maszyn wirtualnych z systemem Windows Server.

automatyczne stosowanie poprawek gościa maszyn wirtualnych usługi Azure Arc: ta funkcja pomaga zmniejszyć obciążenie związane z ręcznym stosowaniem poprawek i powiązanymi kosztami konserwacji. Nie tylko ta akcja pomaga zwiększyć bezpieczeństwo systemu, ale także optymalizuje alokację zasobów i przyczynia się do ogólnej wydajności kosztów.

konsolidacji monitorowania kosztów: aby skonsolidować koszty monitorowania, użyj Insights for Azure Local and patch using Update Manager for Azure Local. Usługa Insights używa funkcji Monitor, aby zapewnić zaawansowane metryki i możliwości alertów. Składnik menedżera cyklu życia platformy Azure Localintegrates z programem Update Manager, aby uprościć zadanie aktualizowania klastrów przez konsolidowanie przepływów pracy aktualizacji dla różnych składników w jednym środowisku. Użyj narzędzia Monitor i Update Manager, aby zoptymalizować alokację zasobów i przyczynić się do ogólnej wydajności kosztów.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące optymalizowania czasu personelu.

Początkowa pojemność obciążenia i wzrost: podczas planowania wdrożenia lokalnego platformy Azure należy wziąć pod uwagę początkową pojemność obciążenia, wymagania dotyczące odporności i przyszłe zagadnienia dotyczące wzrostu. Rozważ użycie architektury bez przełącznika magazynu z dwoma lub trzema węzłami, które może obniżyć koszty, takie jak usunięcie konieczności pozyskania przełączników sieciowych klasy magazynu. Pozyskiwanie dodatkowych przełączników sieciowych klasy magazynu może być kosztownym składnikiem nowych wdrożeń wystąpienia lokalnego platformy Azure. Zamiast tego można użyć istniejących przełączników do zarządzania i sieci obliczeniowych, co upraszcza infrastrukturę. Jeśli pojemność i odporność obciążenia nie będą skalowane poza konfigurację z trzema węzłami, rozważ użycie istniejących przełączników dla sieci zarządzania i obliczeniowych oraz użycie architektury bez przełączania magazynu z trzema węzłami w celu wdrożenia usługi Azure Local.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące optymalizowania kosztów składników.

Napiwek

Możesz zaoszczędzić na kosztach dzięki korzyści użycia hybrydowego platformy Azure, jeśli masz licencje systemu Windows Server Datacenter z aktywnym pakietem Software Assurance. Aby uzyskać więcej informacji, zobacz Korzyść użycia hybrydowego platformy Azure dla usługi Azure Local.

Doskonałość operacyjna

Doskonałość operacyjna obejmuje procesy operacyjne, które wdrażają aplikację i działają w środowisku produkcyjnym. Aby uzyskać więcej informacji, zobacz Lista kontrolna przeglądu projektu dotycząca doskonałości operacyjnej.

Zagadnienia dotyczące doskonałości operacyjnej obejmują:

uproszczone środowisko aprowizacji i zarządzania zintegrowane z usługą Azure: Wdrożenie oparte na chmurze na platformie Azure udostępnia interfejs oparty na kreatorze, który pokazuje, jak utworzyć wystąpienie lokalne platformy Azure. Podobnie platforma Azure upraszcza proces zarządzania wystąpieniami lokalnymi platformy Azure i maszyn wirtualnych usługi Azure Arc. Wdrożenie wystąpienia lokalnego platformy Azure można zautomatyzować za pomocą szablonu usługi ARM. Ten szablon zapewnia spójność i automatyzację wdrażania platformy Azure lokalnie na dużą skalę, w szczególności w scenariuszach brzegowych, takich jak sklepy detaliczne lub lokacje produkcyjne, które wymagają lokalnego wystąpienia platformy Azure do uruchamiania obciążeń krytycznych dla działania firmy.

możliwości automatyzacji dla maszyn wirtualnych: usługa Azure Local oferuje szeroką gamę możliwości automatyzacji do zarządzania obciążeniami, takimi jak maszyny wirtualne usługi Azure Arc, z zautomatyzowane wdrażanie maszyn wirtualnych usługi Azure Arc przy użyciu interfejsu wiersza polecenia platformy Azure, usługi ARM lub szablonu Bicepz aktualizacjami systemu operacyjnego maszyny wirtualnej przy użyciu rozszerzenia usługi Azure Arc na potrzeby aktualizacji i azure Update Manager aktualizacji każdego wystąpienia lokalnego platformy Azure. Usługa Azure Local zapewnia również obsługę zarządzania maszynami wirtualnymi usługi Azure Arc przy użyciu interfejsu wiersza polecenia platformy Azure i maszyn wirtualnych spoza usługi Azure Arc przy użyciu programu Windows PowerShell. Polecenia interfejsu wiersza polecenia platformy Azure można uruchamiać lokalnie z jednego z maszyn lokalnych platformy Azure lub zdalnie z komputera zarządzania. Integracja z usługą Azure Automation i usługą Azure Arc ułatwia szeroką gamę dodatkowych scenariuszy automatyzacji dla obciążeń maszyn wirtualnych za pośrednictwem rozszerzeń usługi Azure Arc.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące korzystania z usługi IaC.

możliwości automatyzacji dla kontenerów w usłudze AKS: Usługa Azure Local oferuje szeroką gamę możliwości automatyzacji do zarządzania obciążeniami, takimi jak kontenery, w usłudze AKS. Możesz zautomatyzować wdrażanie klastrów usługi AKS przy użyciu interfejsu wiersza polecenia platformy Azure. Zaktualizuj klastry obciążeń usługi AKS przy użyciu rozszerzenia usługi Azure Arc dla aktualizacji platformy Kubernetes. Za pomocą interfejsu wiersza polecenia platformy Azure można również zarządzać usługą AKS z obsługą usługi Azure Arc. Polecenia interfejsu wiersza polecenia platformy Azure można uruchamiać lokalnie z jednego z maszyn lokalnych platformy Azure lub zdalnie z komputera zarządzania. Integracja z usługą Azure Arc w celu uzyskania szerokiej gamy dodatkowych scenariuszy automatyzacji dla konteneryzowanych obciążeń za pośrednictwem rozszerzeń usługi Azure Arc.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące włączania automatyzacji.

Wydajność

Wydajność to zdolność obciążenia do zaspokojenia wymagań, które są na nim nakładane przez użytkowników w wydajny sposób. Aby uzyskać więcej informacji, zobacz Lista kontrolna przeglądu projektu pod kątem wydajności.

Zagadnienia dotyczące wydajności obejmują:

wydajność magazynu obciążenia: rozważ użycie narzędzia DiskSpd w celu przetestowania możliwości magazynu obciążenia wystąpienia lokalnego platformy Azure. Narzędzie VMFleet umożliwia generowanie obciążenia i mierzenie wydajności podsystemu magazynowania. Oceń, czy do mierzenia wydajności podsystemu magazynowania należy użyć VMFleet.

Zalecamy ustanowienie punktu odniesienia dla wydajności wystąpień lokalnych platformy Azure przed wdrożeniem obciążeń produkcyjnych. Narzędzie DiskSpd używa różnych parametrów wiersza polecenia, które umożliwiają administratorom testowanie wydajności magazynu klastra. Główną funkcją DiskSpd jest wydawanie operacji odczytu i zapisu oraz metryk wydajności danych wyjściowych, takich jak opóźnienie, przepływność i operacje we/wy.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące testowania wydajnościowego.

Odporność magazynu obciążenia: należy wziąć pod uwagę zalety odporności magazynu , wydajności użycia (lub pojemności) i wydajności. Planowanie woluminów lokalnych platformy Azure obejmuje identyfikowanie optymalnej równowagi między odpornością, wydajnością użycia i wydajnością. Trudno jest zoptymalizować tę równowagę, ponieważ maksymalizacja jednej z tych cech zwykle ma negatywny wpływ na jedną lub więcej innych cech. Zwiększenie odporności zmniejsza pojemność do wykorzystania. W związku z tym wydajność może się różnić w zależności od wybranego typu odporności. Gdy odporność i wydajność są priorytetem, a gdy używasz co najmniej trzech węzłów, domyślna konfiguracja magazynu stosuje dublowanie trzystopniowe zarówno dla woluminów infrastruktury, jak i użytkowników.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące planowania pojemności.

optymalizacja wydajności sieci: rozważ optymalizację wydajności sieci. W ramach projektu należy uwzględnić przewidywane alokacji przepustowości ruchu sieciowego podczas określania optymalnej konfiguracji sprzętu sieciowego.

Aby zoptymalizować wydajność obliczeń w usłudze Azure Local, możesz użyć przyspieszania procesora GPU. Przyspieszanie procesora GPU jest korzystne w przypadku obciążeń sztucznej inteligencji o wysokiej wydajności lub uczenia maszynowego obejmujących szczegółowe informacje o danych lub wnioskowanie. Te obciążenia wymagają wdrożenia w lokalizacjach brzegowych ze względu na zagadnienia, takie jak wagę danych lub wymagania dotyczące zabezpieczeń. W przypadku wdrożenia hybrydowego lub wdrożenia lokalnego należy wziąć pod uwagę wymagania dotyczące wydajności obciążenia, w tym procesory GPU. Takie podejście pomaga wybrać odpowiednie usługi podczas projektowania i pozyskiwania lokalnych wystąpień platformy Azure.

Aby uzyskać więcej informacji, zobacz Zalecenia dotyczące wybierania odpowiednich usług.

Wdróż ten scenariusz

W poniższej sekcji przedstawiono przykładową listę zadań wysokiego poziomu lub typowego przepływu pracy używanego do wdrażania lokalnego platformy Azure, w tym zadań wstępnych i zagadnień. Ta lista przepływów pracy jest przeznaczona tylko jako przykładowy przewodnik. Nie jest to wyczerpująca lista wszystkich wymaganych akcji, które mogą się różnić w zależności od wymagań organizacyjnych, geograficznych lub specyficznych dla projektu.

Scenariusz: istnieje wymóg wdrożenia rozwiązania chmury hybrydowej lub przypadek użycia w lokalizacji lokalnej lub brzegowej w celu zapewnienia lokalnych zasobów obliczeniowych na potrzeby przetwarzania danych i chęci korzystania z spójnych na platformie Azure środowisk zarządzania i rozliczeń. Więcej szczegółów opisano w sekcji potencjalnych przypadków użycia tego artykułu. W pozostałych krokach przyjęto założenie, że usługa Azure Local jest wybranym rozwiązaniem platformy infrastruktury dla projektu.

zbierz wymagania dotyczące obciążeń i przypadków użycia od odpowiednich osób biorących udział w projekcie. Ta strategia umożliwia projektowi potwierdzenie, że funkcje i możliwości platformy Azure Local spełniają wymagania dotyczące skalowania, wydajności i funkcjonalności obciążeń. Ten proces przeglądu powinien obejmować zrozumienie skali obciążenia lub rozmiaru oraz wymaganych funkcji, takich jak maszyny wirtualne usługi Azure Arc, usługa AKS, usługa Azure Virtual Desktop lub usługi Danych z obsługą usługi Azure Arc lub usługa Azure Arc z obsługą uczenia maszynowego. Wartości celu czasu odzyskiwania obciążenia i celu punktu odzyskiwania (niezawodność) oraz inne wymagania niefunkcjonalne (wydajność/skalowalność obciążenia) powinny być udokumentowane w ramach tego kroku zbierania wymagań.

Przejrzyj dane wyjściowe lokalnego narzędzia do rozmiarów platformy Azure dla zalecanego rozwiązania partnerskiego sprzętu. Te dane wyjściowe zawierają szczegółowe informacje dotyczące zalecanego sprzętu serwera fizycznego i modelu, liczby węzłów fizycznych oraz specyfikacji procesora CPU, pamięci i magazynu poszczególnych węzłów fizycznych wymaganych do wdrożenia i uruchamiania obciążeń.

Użyj narzędzia do określania rozmiaru lokalnego platformy Azure utworzyć nowy projekt, który modeluje typ obciążenia i skaluj. Ten projekt obejmuje rozmiar i liczbę maszyn wirtualnych oraz ich wymagania dotyczące magazynu. Te szczegóły są wprowadzane razem z wyborami dla typu systemu, preferowanej rodziny procesorów i wymagań dotyczących odporności na wysoką dostępność i odporność magazynu, jak wyjaśniono w poprzedniej sekcji Wyboru projektu klastra.

Przejrzyj dane wyjściowe narzędzia Azure Local Sizer dla zalecanego rozwiązania partnera sprzętowego. To rozwiązanie zawiera szczegółowe informacje na temat zalecanego sprzętu serwera fizycznego (make and model), liczby węzłów fizycznych oraz specyfikacji procesora CPU, pamięci i konfiguracji magazynu każdego węzła fizycznego wymaganego do wdrożenia i uruchomienia obciążeń.

skontaktuj się ze sprzętowym partnerem OEM lub SI, aby dodatkowo kwalifikować się do przydatności zalecanej wersji sprzętowej w porównaniu z wymaganiami dotyczącymi obciążenia. Jeśli jest dostępna, użyj narzędzi ustalania rozmiaru specyficznych dla producenta OEM, aby określić wymagania dotyczące określania rozmiaru sprzętu specyficzne dla producenta OEM dla zamierzonych obciążeń. Ten krok obejmuje zazwyczaj dyskusje ze sprzętowym partnerem OEM lub SI na potrzeby komercyjnych aspektów rozwiązania. Te aspekty obejmują oferty, dostępność sprzętu, czasy realizacji oraz wszelkie profesjonalne lub wartościowe usługi, które partner zapewnia, aby przyspieszyć twój projekt lub wyniki biznesowe.

wdróż dwa przełączniki toR na potrzeby integracji sieci. W przypadku rozwiązań o wysokiej dostępności klastry HCI wymagają wdrożenia dwóch przełączników ToR. Każdy węzeł fizyczny wymaga czterech kart sieciowych, z których dwie muszą być obsługujące funkcję RDMA, która udostępnia dwa łącza z każdego węzła do dwóch przełączników ToR. Dwie karty sieciowe, jedna połączona z każdym przełącznikiem, są zbieżne dla wychodzącej łączności północno-południowej dla sieci obliczeniowych i sieci zarządzania. Pozostałe dwie karty sieciowe obsługujące funkcję RDMA są przeznaczone dla ruchu magazynowego na wschód-zachód. Jeśli planujesz używać istniejących przełączników sieciowych, upewnij się, że tworzenie i model przełączników znajdują się na zatwierdzonej liście przełączników sieciowych obsługiwanych przez usługę Azure Local.

Współpracuj ze sprzętowym partnerem OEM lub SI w celu zorganizowania dostarczania sprzętu. Partner SI lub pracownicy są następnie zobowiązani do zintegrowania sprzętu z lokalnym centrum danych lub lokalizacji brzegowej, takich jak stojaki i układanie sprzętu, sieci fizycznej i okablowania jednostki zasilania dla węzłów fizycznych.

Wykonaj wdrożenie lokalnego wystąpienia platformy Azure. W zależności od wybranej wersji rozwiązania (rozwiązanie Premier, zintegrowany system lub zweryfikowane węzły) partner sprzętu, partner SI lub pracownicy mogą wdrożyć lokalne oprogramowanie platformy Azure. Ten krok rozpoczyna się od dołączenia węzłów fizycznych systemu operacyjnego Azure Stack HCI do serwerów z obsługą usługi Azure Arc, a następnie uruchomienia procesu wdrażania w chmurze lokalnej platformy Azure. Klienci i partnerzy mogą zgłosić wniosek o pomoc techniczną bezpośrednio z firmą Microsoft w witrynie Azure Portal, wybierając ikonę Pomocy technicznej i rozwiązywania problemów lub kontaktując się ze swoim partnerem sprzętowym OEM lub SI, w zależności od charakteru żądania i kategorii rozwiązania sprzętowego.

Napiwek

System operacyjny Azure Stack HCI w wersji 23H2 pokazuje, jak wdrożyć przełączone wdrożenie wieloserwerowe usługi Azure Local przy użyciu szablonu usługi ARM i pliku parametrów. Alternatywnie przykład Bicep pokazuje, jak za pomocą szablonu Bicep wdrożyć wystąpienie lokalne platformy Azure, w tym jego zasoby wymagań wstępnych.

Wdrażanie obciążeń o wysokiej dostępności na platformie Azure lokalnie przy użyciu witryny Azure Portal, interfejsu wiersza polecenia lub szablonów usługi ARM i usługi Azure Arc na potrzeby automatyzacji. Użyj niestandardowej lokalizacji zasobu nowego klastra HCI jako regionu docelowego podczas wdrażania zasobów obciążeń, takich jak maszyny wirtualne usługi Azure Arc, hosty sesji usługi AKS, usługi Azure Virtual Desktop lub inne usługi obsługujące usługę Azure Arc, które można włączyć za pomocą rozszerzeń usługi AKS i konteneryzacji na platformie Azure Lokalnie.

Zainstaluj comiesięczne aktualizacje, aby zwiększyć bezpieczeństwo i niezawodność platformy. Aby zapewnić aktualność wystąpień lokalnych platformy Azure, ważne jest zainstalowanie aktualizacji oprogramowania i aktualizacji sprzętu producenta OEM oraz aktualizacji oprogramowania układowego firmy Microsoft. Te aktualizacje zwiększają bezpieczeństwo i niezawodność platformy. update Manager stosuje aktualizacje i udostępnia scentralizowane i skalowalne rozwiązanie do instalowania aktualizacji w jednym klastrze lub wielu klastrach. Zajrzyj do partnera producenta OEM sprzętu, aby określić proces instalowania sterowników sprzętu i aktualizacji oprogramowania układowego, ponieważ ten proces może się różnić w zależności od wybranego typu kategorii rozwiązań sprzętowych (rozwiązanie Premier, zintegrowany system lub zweryfikowane węzły). Aby uzyskać więcej informacji, zobacz Aktualizacje infrastruktury.

Powiązane zasoby

- projektowanie architektury hybrydowej

- opcje hybrydowe platformy Azure

- Automation w środowisku hybrydowym

- Azure Automation State Configuration

- Optymalizowanie administrowania wystąpieniami programu SQL Server w środowiskach lokalnych i wielochmurowych przy użyciu usługi Azure Arc

Następne kroki

Dokumentacja produktu:

- systemu operacyjnego Azure Stack HCI w wersji 23H2

- AKS w lokalnej platformy Azure

- Azure Virtual Desktop for Azure Local

- Co to jest lokalne monitorowanie platformy Azure?

- Ochrona obciążeń maszyn wirtualnych za pomocą usługi Site Recovery w lokalnej platformy Azure

- Monitor — omówienie

- Omówienie śledzenia zmian i spisu

- Update Manager — omówienie

- Co to są usługi danych z obsługą usługi Azure Arc?

- Co to są serwery z obsługą usługi Azure Arc?

- Co to jest usługa backup?

Dokumentacja produktu, aby uzyskać szczegółowe informacje na temat określonych usług platformy Azure:

- lokalnej platformy Azure

- azure arc

-

Key Vault - usługi Azure Blob Storage

- Monitor

- azure policy

- usługi Azure Container Registry

- Defender for Cloud

- Site Recovery

- kopii zapasowej

Moduły microsoft Learn:

- Konfigurowanie monitora

- Projektowanie rozwiązania do odzyskiwania lokacji w usłudze Azure

- Wprowadzenie do serwerów z obsługą usługi Azure Arc

- Wprowadzenie do usług danych z obsługą usługi Azure Arc

- Wprowadzenie do usługi AKS

- Skalowanie wdrożenia modelu za pomocą uczenia maszynowego w dowolnym miejscu — blog społeczności technicznej

- realizowanie uczenia maszynowego w dowolnym miejscu za pomocą usługi AKS i usługi Azure Arc — blog społeczności technicznej

- uczenie maszynowe w hybrydowej usłudze AKS i rozwiązaniu Stack HCI przy użyciu uczenia maszynowego z obsługą usługi Azure Arc — blog społeczności technicznej

- wprowadzenie do docelowego środowiska obliczeniowego Kubernetes w usłudze Machine Learning

- Aktualizowanie maszyn wirtualnych

- Ochrona ustawień maszyny wirtualnej przy użyciu konfiguracji stanu usługi Automation

- Ochrona maszyn wirtualnych przy użyciu kopii zapasowych