Modele obsługiwane przez usługę Azure AI Agent Service

Agenci są obsługiwani przez zróżnicowany zestaw modeli z różnymi możliwościami i punktami cenowymi. Dostępność modelu różni się w zależności od regionu i chmury. Niektóre narzędzia i możliwości wymagają najnowszych modeli. Poniższe modele są dostępne w dostępnych zestawach SDK. Poniższa tabela dotyczy płatności zgodnie z rzeczywistym użyciem. Aby uzyskać informacje na temat dostępności jednostki przepływności aprowizowanej (PTU), zobacz aprowizowanie przepływności w dokumentacji usługi Azure OpenAI. Możesz użyć globalnych modeli standardowych, jeśli są one obsługiwane w regionach wymienionych tutaj.

Modele usługi Azure OpenAI

Usługa agenta AI platformy Azure obsługuje te same modele co interfejs API uzupełniania czatów w usłudze Azure OpenAI w następujących regionach.

| Region | gpt-4o, 2024-05-13 | gpt-4o, 2024-08-06 | gpt-4o-mini, 2024-07-18 | gpt-4, 0613 | gpt-4, 1106-Preview | gpt-4, 0125-Preview | gpt-4, turbo-2024-04-09 | gpt-4-32k, 0613 | gpt-35-turbo, 0613 | gpt-35-turbo, 1106 | gpt-35-turbo, 0125 | gpt-35-turbo-16k, 0613 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| eastus | ✅ | ✅ | ✅ | - | - | ✅ | ✅ | - | ✅ | - | ✅ | ✅ |

| francecentral | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | - | ✅ |

| japaneast | - | - | - | - | - | - | - | - | ✅ | - | ✅ | ✅ |

| uksouth | - | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ |

| westus | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | ✅ | ✅ | - |

Więcej modeli

Usługa Azure AI Agent Service obsługuje również następujące modele z katalogu modeli usługi Azure AI Foundry.

- Llama 3.1-70B-poinstruowanie

- Mistral-large-2407

- Cohere polecenie R+

Aby użyć tych modeli, możesz użyć portalu Azure AI Foundry do wdrożenia, a następnie odwołać się do niego w agencie.

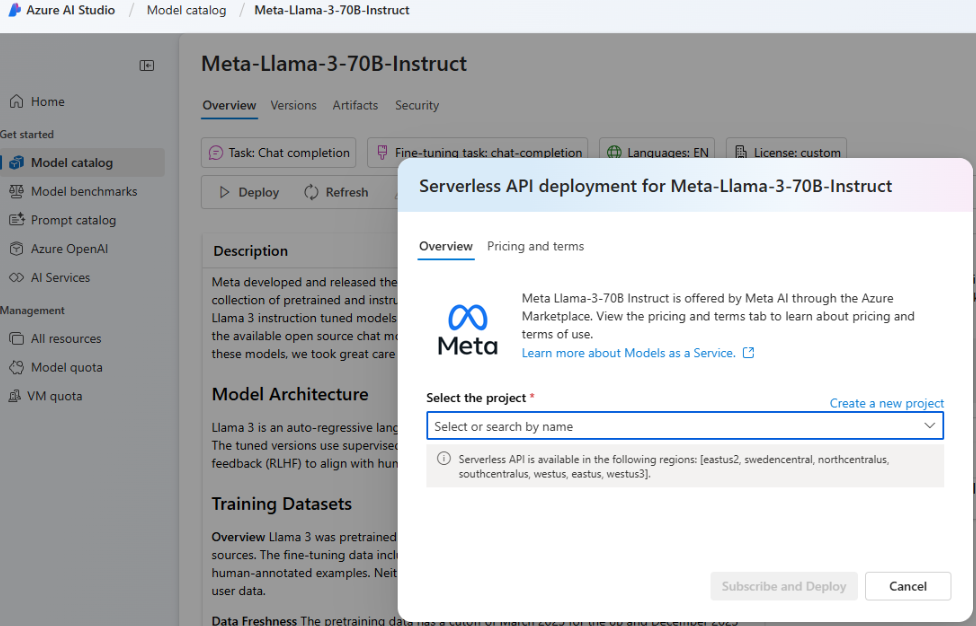

Przejdź do portalu usługi Azure AI Foundry i wybierz pozycję Katalog modeli w menu nawigacji po lewej stronie, a następnie przewiń w dół do pozycji Meta-Llama-3-70B-Poinstruuj. Możesz również znaleźć i użyć jednego z wymienionych wcześniej modeli.

Wybierz Wdróż.

Na wyświetlonym ekranie Opcje wdrażania wybierz pozycję Bezserwerowy interfejs API z bezpieczeństwem zawartości usługi Azure AI.

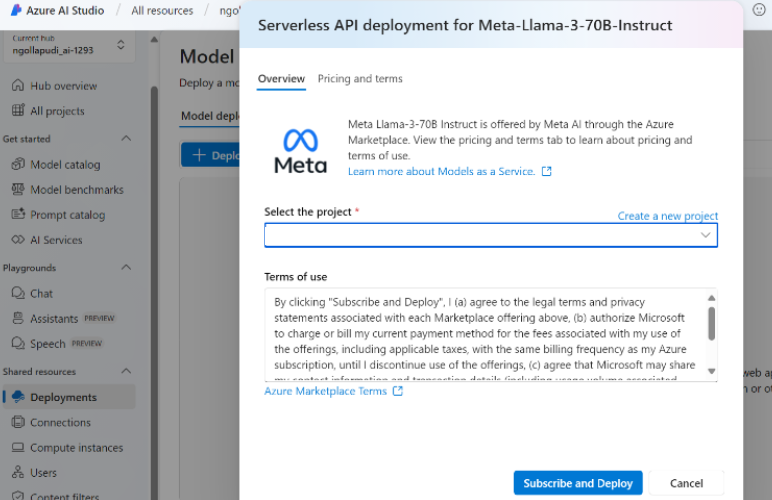

Wybierz projekt, a następnie wybierz pozycję Subskrybuj i wdróż.

Dodaj połączenie bezserwerowe do centrum/projektu. Wybrana nazwa wdrożenia to nazwa, do której odwołujesz się w kodzie.

Podczas wywoływania interfejsu API tworzenia agenta

modelsustaw parametr na nazwę wdrożenia. Na przykład: