Geïntegreerde software- en hardwarefuncties en -technologieën (SH)

Deze functies hebben zowel software- als hardwareonderdelen. De software is nauw gekoppeld aan hardwaremogelijkheden die nodig zijn om de functie te laten werken. Voorbeelden hiervan zijn VMMQ, VMQ, IPv4 Checksum Offload aan de verzendzijde en RSS. Zie Host-netwerkvereisten voor lokale Azure-voor meer informatie.

Tip

SH- en HO-functies zijn beschikbaar als de geïnstalleerde NIC dit ondersteunt. In de onderstaande functiebeschrijvingen wordt beschreven hoe u kunt zien of uw NIC de functie ondersteunt.

Geconvergeerde NIC

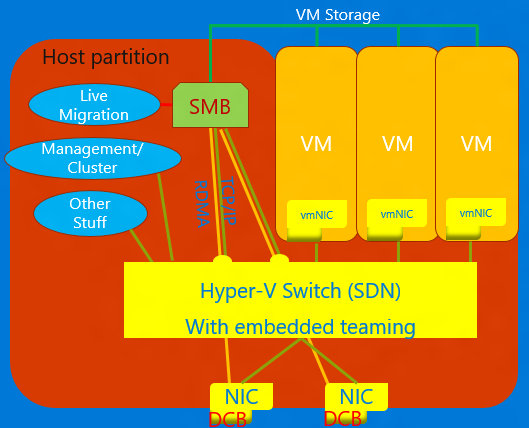

Geconvergeerde NIC is een technologie waarmee virtuele NIC's in de Hyper-V host RDMA-services beschikbaar kunnen maken voor het hosten van processen. Voor Windows Server 2016 zijn geen afzonderlijke NIC's meer vereist voor RDMA. Met de functie Geconvergeerde NIC's kunnen de virtuele NIC's in de hostpartitie (vNIC's) RDMA beschikbaar maken voor de hostpartitie en de bandbreedte van de NIC's delen tussen het RDMA-verkeer en de VM en ander TCP/UDP-verkeer op een eerlijke en beheerbare manier.

U kunt de geconvergeerde NIC-bewerking beheren via VMM of Windows PowerShell. De PowerShell-cmdlets zijn dezelfde cmdlets die worden gebruikt voor RDMA (zie hieronder).

De geconvergeerde NIC-functie gebruiken:

Zorg ervoor dat u de host instelt voor DCB.

Zorg ervoor dat RDMA op de NIC is ingeschakeld, of in het geval van een SET-team, de NIC's zijn gebonden aan de Hyper-V switch.

Zorg ervoor dat u RDMA inschakelt op de vNIC's die zijn aangewezen voor RDMA in de host.

Voor meer informatie over RDMA en SET, zie Remote Direct Memory Access (RDMA) en Switch Embedded Teaming (SET).

Data Center Bridging (DCB)

DCB is een suite met IEEE-standaarden (Institute of Electrical and Electronics Engineers) die geconvergeerde fabrics in datacenters mogelijk maken. DCB biedt bandbreedtebeheer op basis van hardwarewachtrijen in een host met medewerking van de aangrenzende switch. Al het verkeer voor opslag, gegevensnetwerken, cluster Inter-Process Communication (IPC) en beheer delen dezelfde Ethernet-netwerkinfrastructuur. In Windows Server 2016 kan DCB afzonderlijk worden toegepast op elke NIC en NIC's die zijn gebonden aan de Hyper-V-switch.

Voor DCB maakt Windows Server gebruik van PFC (Priority-based Flow Control), gestandaardiseerde in IEEE 802.1Qbb. PFC maakt een (bijna) lossless netwerkinfrastructuur door overloop binnen verkeersklassen te voorkomen. Windows Server maakt ook gebruik van Enhanced Transmission Selection (ETS), gestandaardiseerde in IEEE 802.1Qaz. Met ETS kan de bandbreedte worden verdeeld in gereserveerde delen voor maximaal acht klassen verkeer. Elke verkeersklasse heeft een eigen verzendwachtrij en kan via het gebruik van PFC de overdracht binnen een klasse starten en stoppen.

Hyper-V netwerkvirtualisatie

| Versie | Beschrijving |

|---|---|

| v1 (HNVv1) | Geïntroduceerd in Windows Server 2012 maakt Hyper-V Network Virtualization (HNV) virtualisatie van klantnetwerken mogelijk boven op een gedeelde, fysieke netwerkinfrastructuur. Met minimale wijzigingen die nodig zijn voor de fysieke netwerkinfrastructuur, biedt HNV serviceproviders de flexibiliteit om tenantworkloads overal in de drie clouds te implementeren en migreren: de cloud van de serviceprovider, de privécloud of de openbare Cloud van Microsoft Azure. |

| v2 NVGRE (HNVv2 NVGRE) | In Windows Server 2016 en System Center Virtual Machine Manager biedt Microsoft een end-to-end netwerkvirtualisatieoplossing met RAS Gateway, Software Load Balancing, Netwerkcontroller en meer. Zie Hyper-V Network Virtualization Overview in Windows Server 2016voor meer informatie. |

| v2 VxLAN (HNVv2 VxLAN) | In Windows Server 2016 is het onderdeel van de SDN-extensie, die u beheert via de Network Controller. |

IPsec Taak Offload (IPsecTO)

IPsec-taakoffload is een NIC-functie waarmee het besturingssysteem de processor op de NIC kan gebruiken voor de IPsec-versleutelingsprocessen.

Belangrijk

IPsec-taken offload is een verouderde technologie die niet door de meeste netwerkadapters wordt ondersteund, en als deze wel bestaat, is deze standaard uitgeschakeld.

Private Virtual Local Area Network (PVLAN).

PVLAN's staan alleen communicatie toe tussen virtuele machines op dezelfde virtualisatieserver. Een particulier virtueel netwerk is niet gebonden aan een fysieke netwerkadapter. Een particulier virtueel netwerk is geïsoleerd van alle externe netwerkverkeer op de virtualisatieserver, evenals netwerkverkeer tussen het beheerbesturingssysteem en het externe netwerk. Dit type netwerk is handig wanneer u een geïsoleerde netwerkomgeving moet maken, zoals een geïsoleerd testdomein. De Hyper-V- en SDN-stacks ondersteunen alleen de PVLAN Isolated-poortmodus.

Zie System Center: Virtual Machine Manager Engineering Blogvoor meer informatie over PVLAN-isolatie.

Remote Direct Memory Access (RDMA) (toegang op afstand tot direct geheugen)

RDMA is een netwerktechnologie die communicatie met hoge doorvoer en lage latentie biedt waarmee het CPU-gebruik wordt geminimaliseerd. RDMA biedt ondersteuning voor zero-copy-netwerken door de netwerkadapter in staat te stellen gegevens rechtstreeks naar of vanuit het toepassingsgeheugen over te dragen. RDMA-geschikt betekent dat de NIC (fysiek of virtueel) RDMA beschikbaar kan maken voor een RDMA-client. RDMA ingeschakeld, daarentegen, betekent dat een RDMA-compatibele NIC de RDMA-interface beschikbaar maakt voor de stack.

Voor meer informatie over Remote Direct Memory Access (RDMA), zie Remote Direct Memory Access (RDMA) en Switch Embedded Teaming (SET).

Ontvangerszijde Schaling (Receive Side Scaling, RSS)

RSS is een NIC-functie die verschillende sets streams scheidt en deze levert aan verschillende processors voor verwerking. RSS parallel verwerkt de netwerkprocessen, waardoor een host kan opschalen naar zeer hoge datasnelheden.

Voor meer details, zie Receive Side Scaling (RSS).

Single Root Input-Output Virtualization (SR-IOV)

SR-IOV maakt het mogelijk dat VM-verkeer rechtstreeks van de NIC naar de VM gaat zonder door de Hyper-V host te gaan. SR-IOV is een ongelooflijke prestatieverbetering voor een VM, maar de host mist de mogelijkheid om dat kanaal te beheren. Gebruik alleen SR-IOV wanneer de workload goed werkt, vertrouwd is en over het algemeen de enige VIRTUELE machine in de host is.

Verkeer dat gebruikmaakt van SR-IOV omzeilt de Hyper-V-switch, wat betekent dat beleid, bijvoorbeeld ACL's of bandbreedtebeheer, niet wordt toegepast. SR-IOV verkeer kan ook niet worden doorgegeven via een netwerkvirtualisatiemogelijkheid, dus NV-GRE of VxLAN-inkapseling kan niet worden toegepast. Gebruik alleen SR-IOV voor goed vertrouwde workloads in specifieke situaties. Daarnaast kunt u het hostbeleid, bandbreedtebeheer en virtualisatietechnologieën niet gebruiken.

In de toekomst zouden twee technologieën SR-IOV toestaan: Algemene stroomtabellen (GFT) en QoS-offload van hardware (bandbreedtebeheer in de NIC) – zodra de NIC's in ons ecosysteem deze ondersteunen. De combinatie van deze twee technologieën zou SR-IOV nuttig maken voor alle VM's, zou toestaan dat beleidsregels, virtualisatie en bandbreedtebeheerregels worden toegepast en kunnen leiden tot grote sprongen voorwaarts in de algemene toepassing van SR-IOV.

Zie voor meer informatie Overzicht van Single Root I/O-virtualisatie (SR-IOV).

TCP-schoorsteen offload

TCP Chimney Offload, ook wel bekend als TCP Engine Offload (TOE), is een technologie waarmee de host alle TCP-verwerking naar de NIC kan offloaden. Omdat de Windows Server TCP-stack bijna altijd efficiënter is dan de TOE-engine, wordt het gebruik van TCP Chimney Offload niet aanbevolen.

Belangrijk

TCP Chimney Offload is een afgeschafte technologie. We raden u aan TCP Chimney Offload niet te gebruiken, omdat Microsoft dit in de toekomst mogelijk niet meer ondersteunt.

Virtual Local Area Network (VLAN)

VLAN is een uitbreiding op de Ethernet-frameheader om partitionering van een LAN in meerdere VLAN's mogelijk te maken, elk met een eigen adresruimte. In Windows Server 2016 worden VLAN's ingesteld op poorten van de Hyper-V-switch of door de teaminterfaces in te stellen via NIC-teaming.

Virtuele-machinewachtrij (VMQ)

VMQs is een NIC-functie waarmee een wachtrij voor elke VIRTUELE machine wordt toegewezen. Wanneer u Hyper-V inschakelt, moet u ook VMQ inschakelen. In Windows Server 2016 gebruiken VMQs NIC Switch vPorts met één wachtrij die is toegewezen aan de vPort om dezelfde functionaliteit te bieden.

Virtuele machine met meerdere wachtrijen (VMMQ)

VMMQ is een NIC-functie waarmee verkeer voor een VIRTUELE machine kan worden verspreid over meerdere wachtrijen, die elk worden verwerkt door een andere fysieke processor. Het verkeer wordt vervolgens doorgegeven aan meerdere IP's in de virtuele machine, net als in vRSS, waardoor aanzienlijke netwerkbandbreedte aan de VIRTUELE machine kan worden geleverd.