Spark gebruiken in notebooks

U kunt veel verschillende soorten toepassingen uitvoeren in Spark, waaronder code in Python- of Scala-scripts, Java-code die is gecompileerd als een Java Archive (JAR) en andere. Spark wordt vaak gebruikt in twee soorten workloads:

- Batch- of streamverwerkingstaken voor het opnemen, opschonen en transformeren van gegevens, die vaak worden uitgevoerd als onderdeel van een geautomatiseerde pijplijn.

- Interactieve analysesessies voor het verkennen, analyseren en visualiseren van gegevens.

Spark-code uitvoeren in notebooks

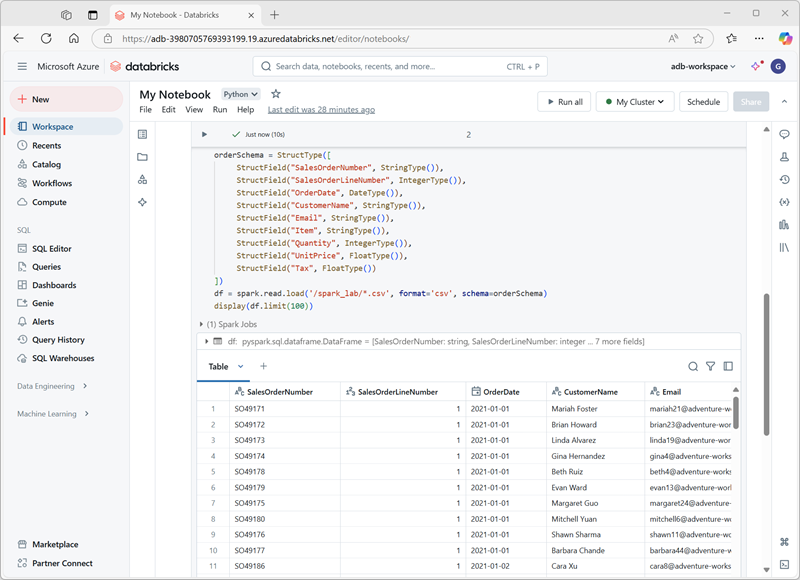

Azure Databricks bevat een geïntegreerde notebookinterface voor het werken met Spark. Notebooks bieden een intuïtieve manier om code te combineren met Markdown-notities, die vaak worden gebruikt door gegevenswetenschappers en gegevensanalisten. Het uiterlijk van de geïntegreerde notebookervaring in Azure Databricks is vergelijkbaar met die van Jupyter-notebooks: een populair opensource-notebookplatform.

Notebooks bestaan uit een of meer cellen, elk met code of markdown. Codecellen in notebooks hebben enkele functies die u kunnen helpen productiever te zijn, waaronder:

- Syntaxismarkering en foutondersteuning.

- Automatisch aanvullen van code.

- Interactieve gegevensvisualisaties.

- De mogelijkheid om resultaten te exporteren.

Tip

Zie het artikel Notebooks in de documentatie van Azure Databricks voor meer informatie over het werken met notebooks in Azure Databricks.