Inzicht in Azure Databricks-notebooks en -pijplijnen

In Azure Databricks kunt u notebooks gebruiken om code uit te voeren die is geschreven in Python, Scala, SQL en andere talen om gegevens op te nemen en te verwerken. Notebooks bieden een interactieve interface waarin u afzonderlijke codecellen kunt uitvoeren en Markdown kunt gebruiken om notities en aantekeningen op te nemen.

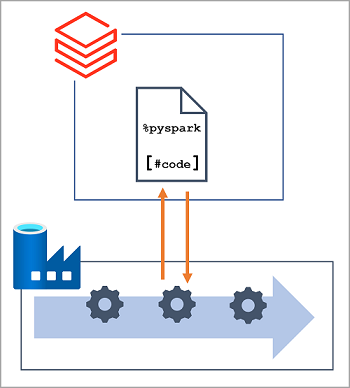

In veel data engineering-oplossingen kan code die interactief is geschreven en getest later worden opgenomen in een geautomatiseerde gegevensverwerkingsworkload. In Azure worden dergelijke workloads vaak geïmplementeerd als pijplijnen in Azure Data Factory, waarin een of meer activiteiten worden gebruikt om een reeks taken te organiseren die op aanvraag kunnen worden uitgevoerd, met geplande intervallen of als reactie op een gebeurtenis (zoals nieuwe gegevens die in een map in een data lake worden geladen). Azure Data Factory ondersteunt een Notebook-activiteit die kan worden gebruikt om de uitvoering van een notebook zonder toezicht in een Azure Databricks-werkruimte te automatiseren.

Notitie

Dezelfde Notebook-activiteit is beschikbaar in pijplijnen die zijn gebouwd in Azure Synapse Analytics.