Experimenten uitvoeren met MLflow

Met MLflow-experimenten kunnen gegevenswetenschappers trainingsuitvoeringen bijhouden in een verzameling die een experiment wordt genoemd. Experimentuitvoeringen zijn handig voor het vergelijken van wijzigingen in de loop van de tijd of het vergelijken van de relatieve prestaties van modellen met verschillende hyperparameterwaarden.

Een experiment uitvoeren

Het maken van een experiment in Azure Databricks gebeurt automatisch wanneer u een uitvoering start. Hier volgt een voorbeeld van het starten van een uitvoering in MLflow, het vastleggen van twee parameters en het vastleggen van één metrische waarde:

with mlflow.start_run():

mlflow.log_param("input1", input1)

mlflow.log_param("input2", input2)

# Perform operations here like model training.

mlflow.log_metric("rmse", rmse)

In dit geval is de naam van het experiment de naam van het notebook. U kunt een variabele met de naam MLFLOW_EXPERIMENT_NAME exporteren om de naam van uw experiment te wijzigen.

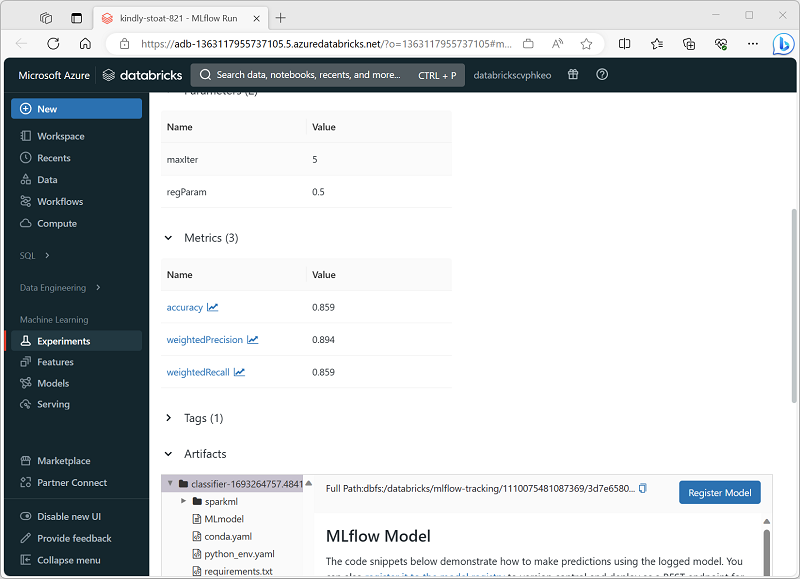

Een experimentuitvoering controleren

In de Azure Databricks-portal kunt u op de pagina Experimenten details van elke experimentuitvoering bekijken, inclusief vastgelegde waarden voor parameters, metrische gegevens en andere artefacten.