Informatie over LLM's

Een LLM (Large Language Model) is een type AI dat tekst in natuurlijke taal kan verwerken en produceren. Het leert van een enorme hoeveelheid gegevens die is verzameld uit bronnen zoals boeken, artikelen, webpagina's en afbeeldingen om patronen en taalregels te ontdekken.

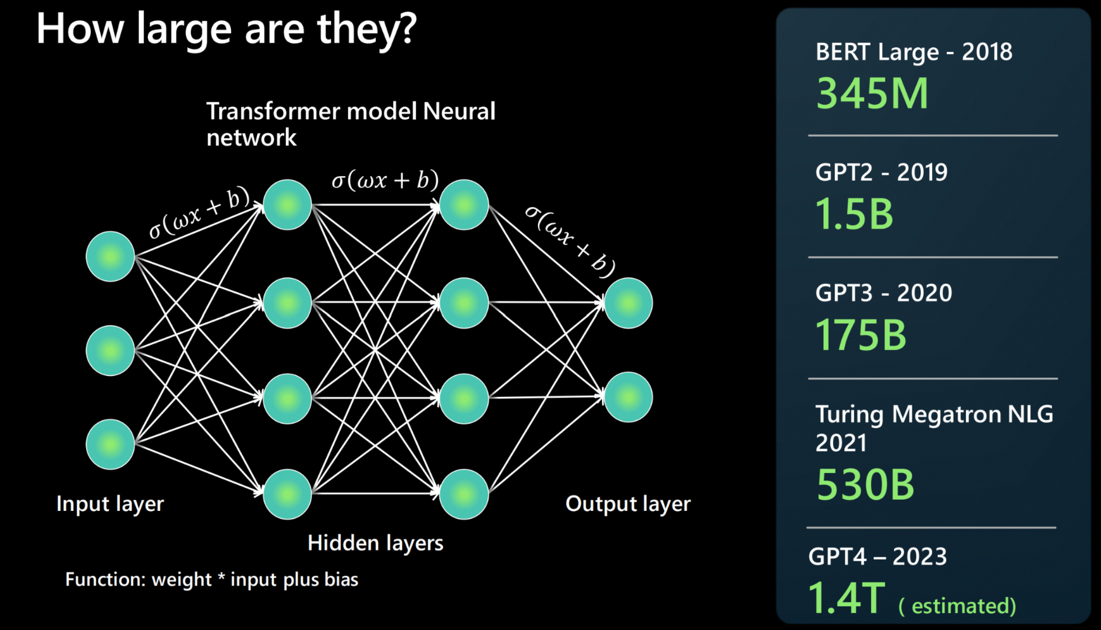

Hoe groot zijn ze?

Een LLM wordt gebouwd met behulp van een neurale netwerkarchitectuur. Het kost een invoer, heeft verschillende verborgen lagen die verschillende aspecten van taal opsplitsen en produceert op de uitvoerlaag.

Mensen melden vaak hoe het nieuwste fundamentele model groter is dan het laatste, maar wat betekent dit? Kortom, hoe meer parameters een model heeft, hoe meer gegevens het kan verwerken, leren en genereren.

Voor elke verbinding tussen twee neuronen van de neurale netwerkarchitectuur is er een functie: gewicht * invoer + vooroordelen. Dit netwerk produceert numerieke waarden die bepalen hoe de taal van het model wordt verwerkt.

LLM's zijn inderdaad groot en groeien snel. Sommige modellen kunnen miljoenen parameters in 2018 berekenen. Maar vandaag kan GPT-4 biljoenen parameters berekenen.

Waar passen basismodellen in LLM's?

Een basismodel verwijst naar een specifiek exemplaar of een specifieke versie van een LLM. Bijvoorbeeld GPT-3, GPT-4 of Codex.

Basismodellen worden getraind en afgestemd op een grote verzameling tekst of code als het een Codex-modelinstantie is.

Een basismodel gebruikt trainingsgegevens in alle verschillende indelingen en maakt gebruik van een transformatiearchitectuur om een algemeen model te bouwen. Aanpassingen en specialisaties kunnen worden gemaakt om bepaalde taken te bereiken via prompts of fine-tuning.

Hoe verschilt een LLM van traditionelere verwerking van natuurlijke taal (NLP)?

Er zijn enkele dingen die traditionele NLP's scheiden van LLM's.

| Traditionele NLP | Grote taalmodellen |

|---|---|

| Er is één model per mogelijkheid nodig. | Eén model wordt gebruikt voor veel gebruiksvoorbeelden voor natuurlijke taal. |

| Biedt een set gelabelde gegevens om het ML-model te trainen. | Gebruikt veel terabytes aan niet-gelabelde gegevens in het basismodel. |

| Hierin wordt in natuurlijke taal beschreven wat u wilt dat het model doet. | Sterk geoptimaliseerd voor specifieke gebruiksvoorbeelden. |

Wat doet een LLM niet?

Net zo belangrijk als het is om te begrijpen wat een LLM kan doen, is het even belangrijk om te begrijpen wat het niet kan doen, zodat u het juiste hulpprogramma voor de taak kiest.

Taal begrijpen: een LLM is een voorspellende engine die patronen samenbrengt op basis van bestaande tekst om meer tekst te produceren. Het begrijpt geen taal of wiskunde.

Feiten begrijpen: een LLM heeft geen afzonderlijke modi voor het ophalen van informatie en creatief schrijven. Het voorspelt gewoon het eerstvolgende meest waarschijnlijke token.

Inzicht in manieren, emotie of ethiek: een LLM kan geen antropomorfisme vertonen of ethiek begrijpen. De uitvoer van een basismodel is een combinatie van trainingsgegevens en prompts.