Werken met Microsoft Fabric Lakehouses

Nu u inzicht hebt in de belangrijkste mogelijkheden van een Microsoft Fabric Lakehouse, gaan we eens kijken hoe u ermee kunt werken.

Een lakehouse maken en verkennen

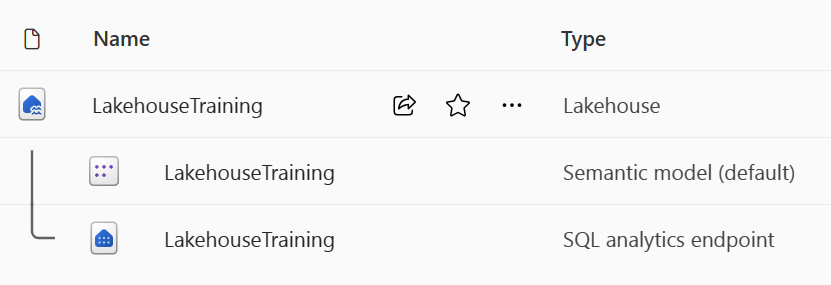

Wanneer u een nieuw lakehouse maakt, hebt u drie verschillende gegevensitems automatisch gemaakt in uw werkruimte.

- Het lakehouse bevat snelkoppelingen, mappen, bestanden en tabellen.

- Het Semantische model (standaard) biedt een eenvoudige gegevensbron voor Power BI-rapportontwikkelaars.

- Het EINDPUNT van SQL Analytics biedt alleen-lezentoegang tot het uitvoeren van query's op gegevens met SQL.

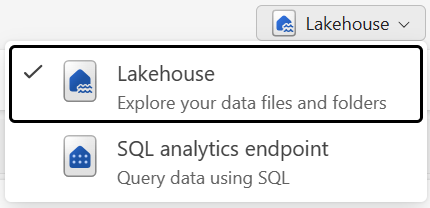

U kunt in twee modi met de gegevens in het lakehouse werken:

- Met lakehouse kunt u tabellen, bestanden en mappen toevoegen en ermee werken in lakehouse.

- Met sql Analytics-eindpunt kunt u SQL gebruiken om query's uit te voeren op de tabellen in lakehouse en het relationele semantische model te beheren.

Gegevens opnemen in een lakehouse

Het opnemen van gegevens in uw Lakehouse is de eerste stap in uw ETL-proces. Gebruik een van de volgende methoden om gegevens in uw Lakehouse te brengen.

- Uploaden: lokale bestanden uploaden.

- Gegevensstromen Gen2: Gegevens importeren en transformeren met Behulp van Power Query.

- Notebooks: Apache Spark gebruiken om gegevens op te nemen, te transformeren en te laden.

- Data Factory-pijplijnen: gebruik de activiteit Gegevens kopiëren.

Deze gegevens kunnen vervolgens rechtstreeks in bestanden of tabellen worden geladen. Houd rekening met uw patroon voor het laden van gegevens bij het opnemen van gegevens om te bepalen of u alle onbewerkte gegevens als bestanden moet laden voordat u faseringstabellen verwerkt of gebruikt.

Spark-taakdefinities kunnen ook worden gebruikt om batch-/streamingtaken naar Spark-clusters te verzenden. Door de binaire bestanden te uploaden vanuit de compilatie-uitvoer van verschillende talen (bijvoorbeeld .jar van Java), kunt u verschillende transformatielogica toepassen op de gegevens die worden gehost op een lakehouse. Naast het binaire bestand kunt u het gedrag van de taak verder aanpassen door meer bibliotheken en opdrachtregelargumenten te uploaden.

Notitie

Zie de documentatie voor het maken van een Apache Spark-taakdefinitie voor meer informatie.

Toegang tot gegevens met behulp van snelkoppelingen

Een andere manier om gegevens in Fabric te openen en te gebruiken, is door snelkoppelingen te gebruiken. Met snelkoppelingen kunt u gegevens integreren in uw Lakehouse terwijl deze in externe opslag worden opgeslagen.

Snelkoppelingen zijn handig wanneer u gegevens wilt ophalen die zich in een ander opslagaccount of zelfs een andere cloudprovider bevinden. Binnen uw lakehouse kunt u snelkoppelingen maken die verwijzen naar verschillende opslagaccounts en andere Fabric-items, zoals datawarehouses, KQL-databases en andere lakehouses.

Machtigingen en referenties voor brongegevens worden allemaal beheerd door OneLake. Wanneer u gegevens opent via een snelkoppeling naar een andere OneLake-locatie, wordt de identiteit van de aanroepende gebruiker gebruikt om toegang tot de gegevens in het doelpad van de snelkoppeling te autoriseren. De gebruiker moet machtigingen hebben op de doellocatie om de gegevens te kunnen lezen.

Snelkoppelingen kunnen worden gemaakt in zowel lakehouses als KQL-databases en worden weergegeven als een map in het meer. Hierdoor kunnen Spark, SQL, realtime intelligentie en Analysis Services gebruikmaken van snelkoppelingen bij het uitvoeren van query's op gegevens.

Notitie

Zie de documentatie voor OneLake-snelkoppelingen in de Microsoft Fabric-documentatie voor meer informatie over het gebruik van snelkoppelingen.