OneLake integreren met Azure Synapse Analytics

Azure Synapse is een service voor oneindige analyses die datawarehousing op ondernemingsniveau en analyse van big data samenbrengt. Deze zelfstudie laat zien hoe u verbinding maakt met OneLake met behulp van Azure Synapse Analytics.

Gegevens schrijven vanuit Synapse met behulp van Apache Spark

Volg deze stappen om Apache Spark te gebruiken om voorbeeldgegevens naar OneLake te schrijven vanuit Azure Synapse Analytics.

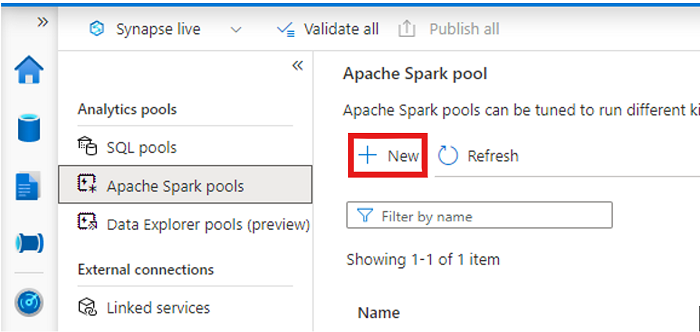

Open uw Synapse-werkruimte en maak een Apache Spark-pool met uw voorkeursparameters.

Maak een nieuw Apache Spark-notebook.

Open het notebook, stel de taal in op PySpark (Python) en verbind deze met uw zojuist gemaakte Spark-pool.

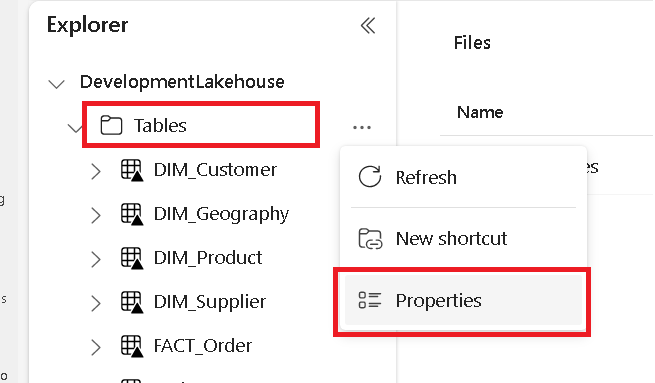

Ga op een afzonderlijk tabblad naar uw Microsoft Fabric Lakehouse en zoek de map Tabellen op het hoogste niveau.

Klik met de rechtermuisknop op de map Tabellen en selecteer Eigenschappen.

Kopieer het ABFS-pad vanuit het deelvenster Eigenschappen.

Geef in de eerste nieuwe codecel in het Azure Synapse-notebook het lakehouse-pad op. In dit lakehouse worden uw gegevens later geschreven. Voer de cel uit.

# Replace the path below with the ABFS path to your lakehouse Tables folder. oneLakePath = 'abfss://WorkspaceName@onelake.dfs.fabric.microsoft.com/LakehouseName.lakehouse/Tables'Laad in een nieuwe codecel gegevens uit een open Azure-gegevensset in een dataframe. Deze gegevensset is de gegevensset die u in uw lakehouse laadt. Voer de cel uit.

yellowTaxiDf = spark.read.parquet('wasbs://nyctlc@azureopendatastorage.blob.core.windows.net/yellow/puYear=2018/puMonth=2/*.parquet') display(yellowTaxiDf.limit(10))In een nieuwe codecel kunt u uw gegevens filteren, transformeren of voorbereiden. Voor dit scenario kunt u uw gegevensset verkleinen voor sneller laden, samenvoegen met andere gegevenssets of filteren op specifieke resultaten. Voer de cel uit.

filteredTaxiDf = yellowTaxiDf.where(yellowTaxiDf.tripDistance>2).where(yellowTaxiDf.passengerCount==1) display(filteredTaxiDf.limit(10))Schrijf in een nieuwe codecel met behulp van uw OneLake-pad uw gefilterde gegevensframe naar een nieuwe Delta-Parquet-tabel in uw Fabric Lakehouse. Voer de cel uit.

filteredTaxiDf.write.format("delta").mode("overwrite").save(oneLakePath + '/Taxi/')Test ten slotte in een nieuwe codecel of uw gegevens zijn geschreven door het zojuist geladen bestand van OneLake te lezen. Voer de cel uit.

lakehouseRead = spark.read.format('delta').load(oneLakePath + '/Taxi/') display(lakehouseRead.limit(10))

Gefeliciteerd. U kunt nu gegevens lezen en schrijven in OneLake met behulp van Apache Spark in Azure Synapse Analytics.

Gegevens lezen uit Synapse met behulp van SQL

Volg deze stappen om serverloze SQL te gebruiken om gegevens uit OneLake te lezen vanuit Azure Synapse Analytics.

Open een Fabric Lakehouse en identificeer een tabel die u wilt opvragen vanuit Synapse.

Klik met de rechtermuisknop op de tabel en selecteer Eigenschappen.

Kopieer het ABFS-pad voor de tabel.

Open uw Synapse-werkruimte in Synapse Studio.

Maak een nieuw SQL-script.

Voer in de SQL-queryeditor de volgende query in, waarbij u het pad vervangt

ABFS_PATH_HEREdat u eerder hebt gekopieerd.SELECT TOP 10 * FROM OPENROWSET( BULK 'ABFS_PATH_HERE', FORMAT = 'delta') as rows;Voer de query uit om de tien bovenste rijen van de tabel weer te geven.

Gefeliciteerd. U kunt nu gegevens uit OneLake lezen met behulp van SQL serverloos in Azure Synapse Analytics.