Prijsscenario met Dataflow Gen2 voor het laden van 2 GB aan Parquet-gegevens naar een Lakehouse-tabel

In dit scenario is Dataflow Gen2 gebruikt voor het laden van 2 GB aan Parquet-gegevens die zijn opgeslagen in Azure Data Lake Storage (ADLS) Gen2 naar een Lakehouse-tabel in Microsoft Fabric. We hebben de NYC Taxi-groene voorbeeldgegevens gebruikt voor de Parquet-gegevens.

De prijzen die in het volgende voorbeeld worden gebruikt, zijn hypothetisch en zijn niet van plan exacte werkelijke prijzen te impliceren. Dit zijn alleen om te laten zien hoe u kosten voor Data Factory-projecten in Microsoft Fabric kunt schatten, plannen en beheren. Omdat infrastructuurcapaciteiten uniek zijn geprijsd in verschillende regio's, gebruiken we de prijzen voor betalen per gebruik voor een infrastructuurcapaciteit op US - west 2 (een typische Azure-regio), met $ 0,18 per CU per uur. Raadpleeg hier Microsoft Fabric : prijzen om andere prijsopties voor fabric-capaciteit te verkennen.

Configuratie

Voor dit scenario moet u een gegevensstroom maken met de volgende stappen:

- Gegevensstroom initialiseren: gegevens van Parquet-bestanden van 2 GB ophalen uit het ADLS Gen2-opslagaccount.

- Power Query configureren:

- Navigeer naar Power Query.

- Zorg ervoor dat de optie voor het faseren van de query is ingeschakeld.

- Ga verder met het combineren van de Parquet-bestanden.

- Gegevenstransformatie:

- Promoot kopteksten voor duidelijkheid.

- Verwijder overbodige kolommen.

- Pas zo nodig kolomgegevenstypen aan.

- Doel van uitvoergegevens definiëren:

- Configureer Lakehouse als het doel van de gegevensuitvoer.

- In dit voorbeeld is een Lakehouse binnen Fabric gemaakt en gebruikt.

Kostenraming met behulp van de Metrische infrastructuur-app

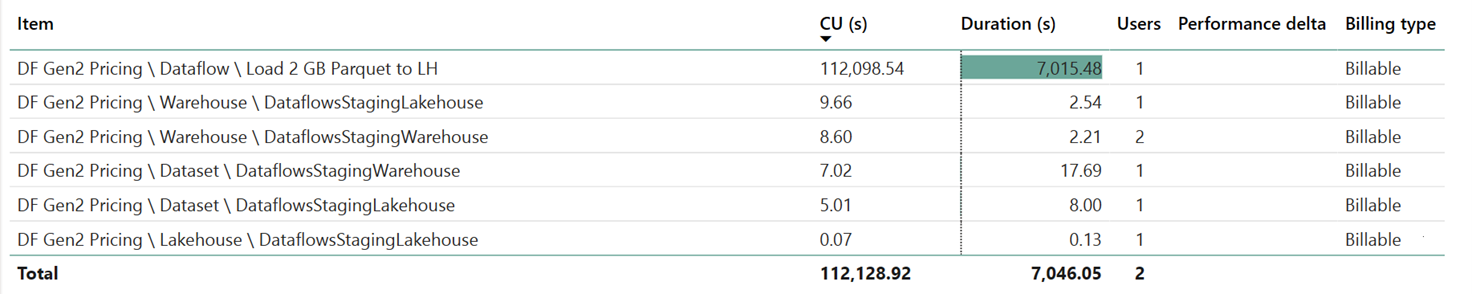

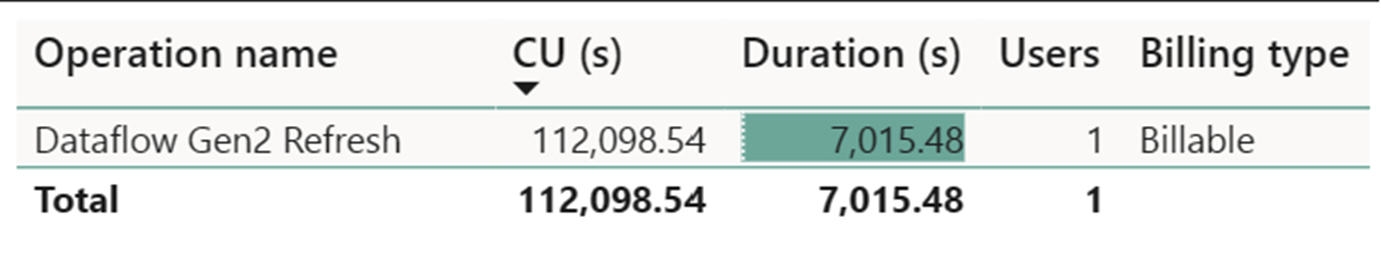

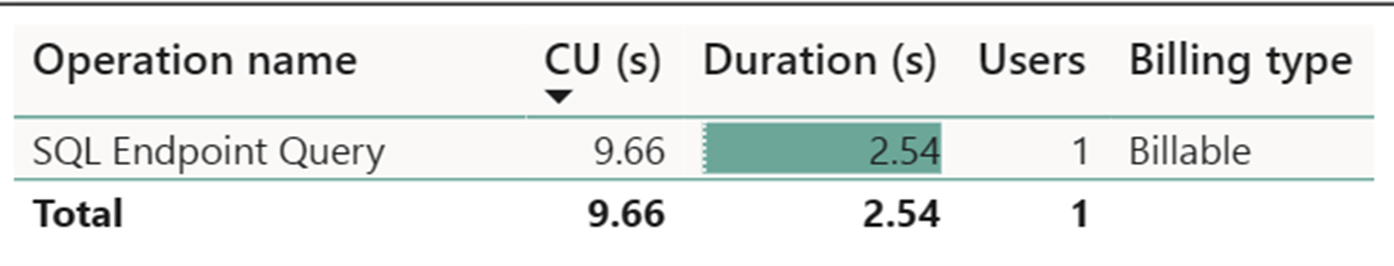

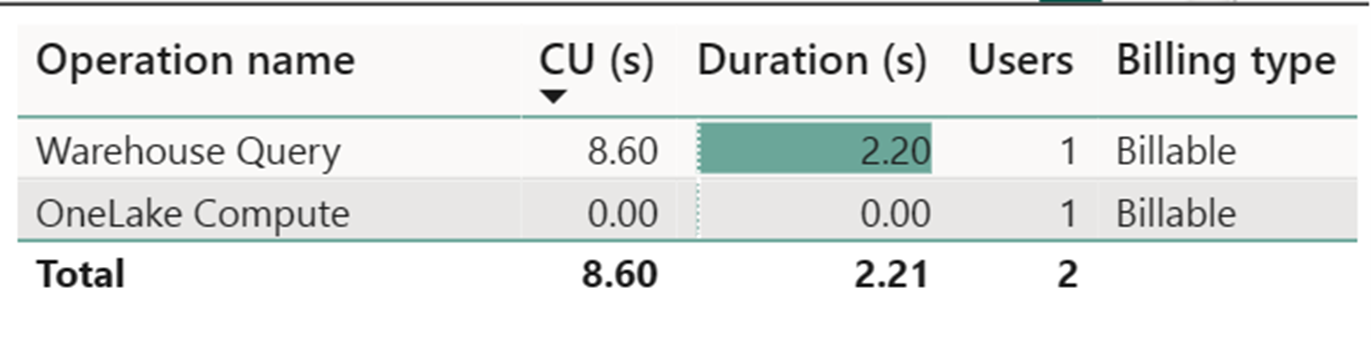

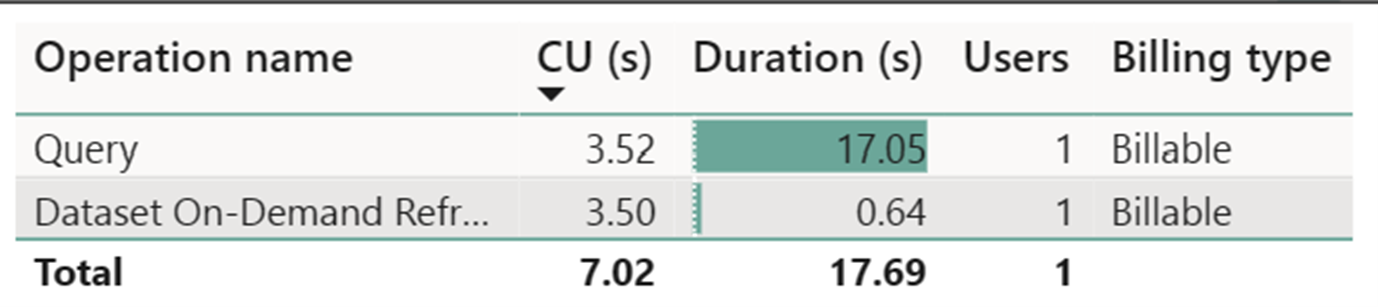

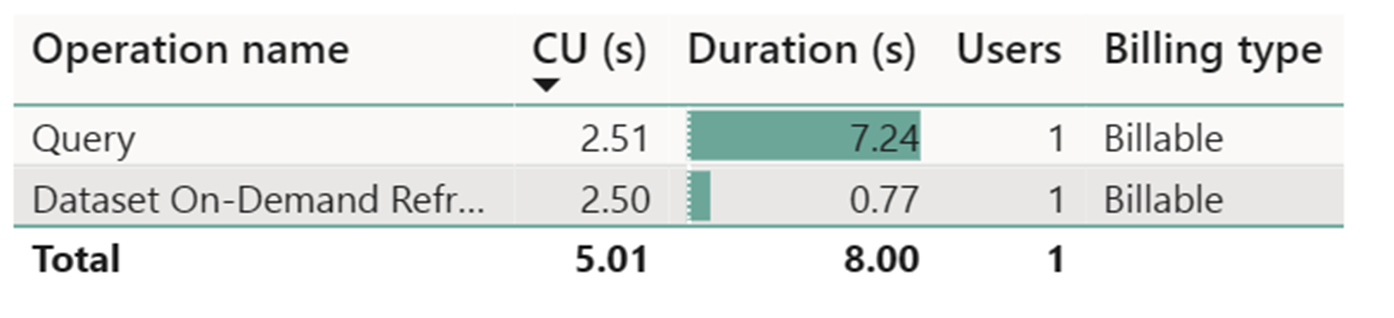

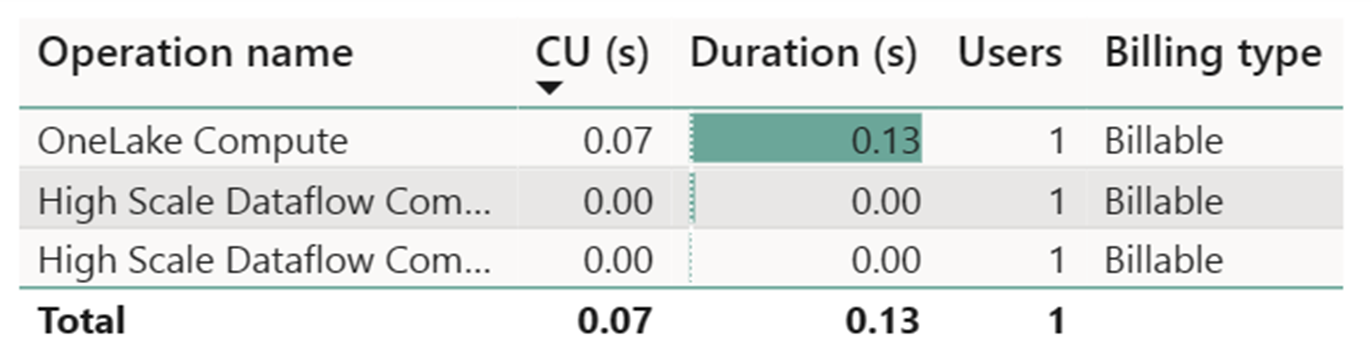

De rekenmeter voor hoge schaalgegevensstromen heeft een verwaarloosbare activiteit geregistreerd. De standaard compute-meter voor vernieuwingsbewerkingen van Dataflow Gen2 verbruikt 112.098.540 Rekeneenheden (CU's). Het is belangrijk om te overwegen dat andere bewerkingen, waaronder Warehouse Query, SQL Endpoint Query en Gegevensset On-Demand Vernieuwen, gedetailleerde aspecten vormen van de Dataflow Gen2-implementatie die momenteel transparant en noodzakelijk zijn voor hun respectieve bewerkingen. Deze bewerkingen worden echter verborgen in toekomstige updates en moeten worden genegeerd bij het schatten van de kosten voor Dataflow Gen2.

Notitie

Hoewel deze wordt gerapporteerd als metrische waarde, is de werkelijke duur van de uitvoering niet relevant bij het berekenen van de effectieve CU-uren met de Fabric Metrics-app, omdat de CU-metrische gegevens ook al rekening houdt met de duur ervan.

| Metric | Rekenlaag Standard | Rekenkracht op hoge schaal |

|---|---|---|

| Totaal aantal CU seconden | 112.098,54 CU seconden | 0 CU seconden |

| Effectieve CU-uren gefactureerd | 112.098,54 / (60*60) = 31,14 CU-uren | 0 / (60*60) = 0 CU-uren |

Totale uitvoeringskosten voor $ 0,18/CU uur = (31,14 CU-uren) * ($ 0,18/CU uur) ~= $ 5,60