Gegevensstroom Gen2-gegevensbestemmingen en beheerde instellingen

Nadat u uw gegevens hebt opgeschoond en voorbereid met Dataflow Gen2, wilt u uw gegevens in een bestemming landen. U kunt dit doen met behulp van de mogelijkheden voor gegevensbestemmingen in Dataflow Gen2. Met deze mogelijkheid kunt u kiezen uit verschillende bestemmingen, zoals Azure SQL, Fabric Lakehouse en nog veel meer. Gegevensstroom Gen2 schrijft vervolgens uw gegevens naar het doel en van daaruit kunt u uw gegevens gebruiken voor verdere analyse en rapportage.

De volgende lijst bevat de ondersteunde gegevensbestemmingen.

- Azure SQL-databases

- Azure Data Explorer (Kusto)

- Fabric Lakehouse

- Infrastructuurwarehouse

- Fabric KQL-database

- Fabric SQL-database

Toegangspunten

Elke gegevensquery in uw Dataflow Gen2 kan een gegevensbestemming hebben. Functies en lijsten worden niet ondersteund; u kunt deze alleen toepassen op query's in tabelvorm. U kunt de gegevensbestemming voor elke query afzonderlijk opgeven en u kunt meerdere verschillende bestemmingen in de gegevensstroom gebruiken.

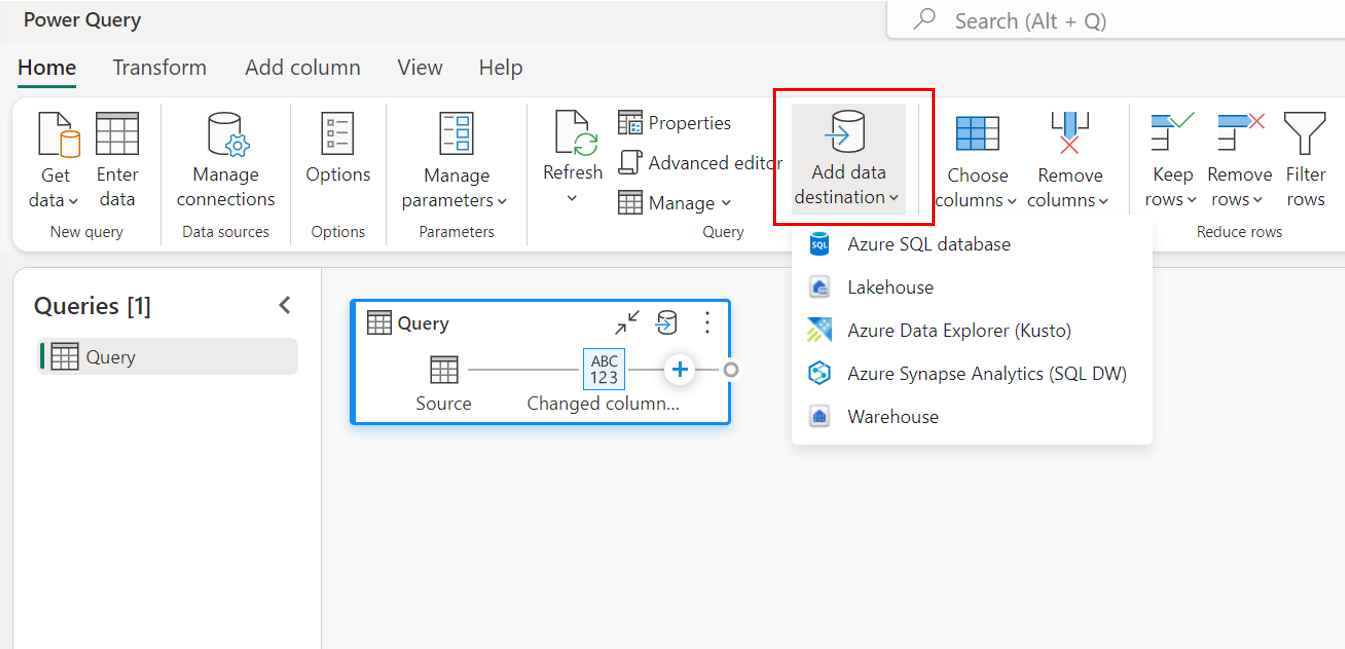

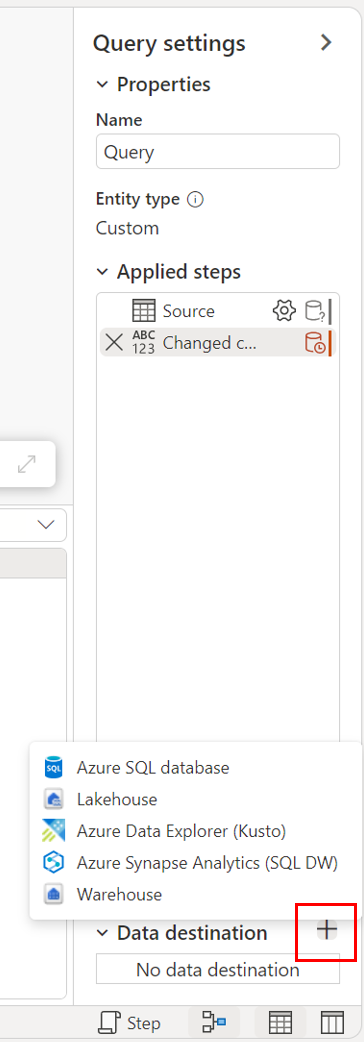

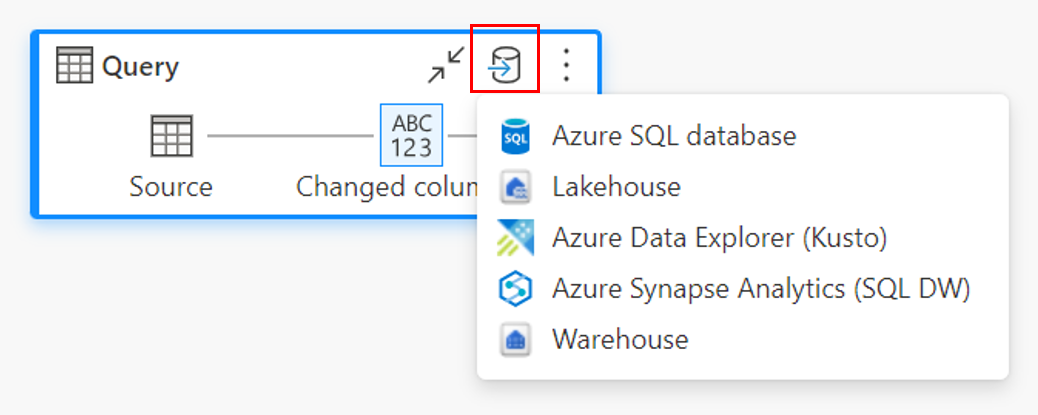

Er zijn drie hoofdinvoerpunten om de gegevensbestemming op te geven:

Via het bovenste lint.

Via query-instellingen.

Via de diagramweergave.

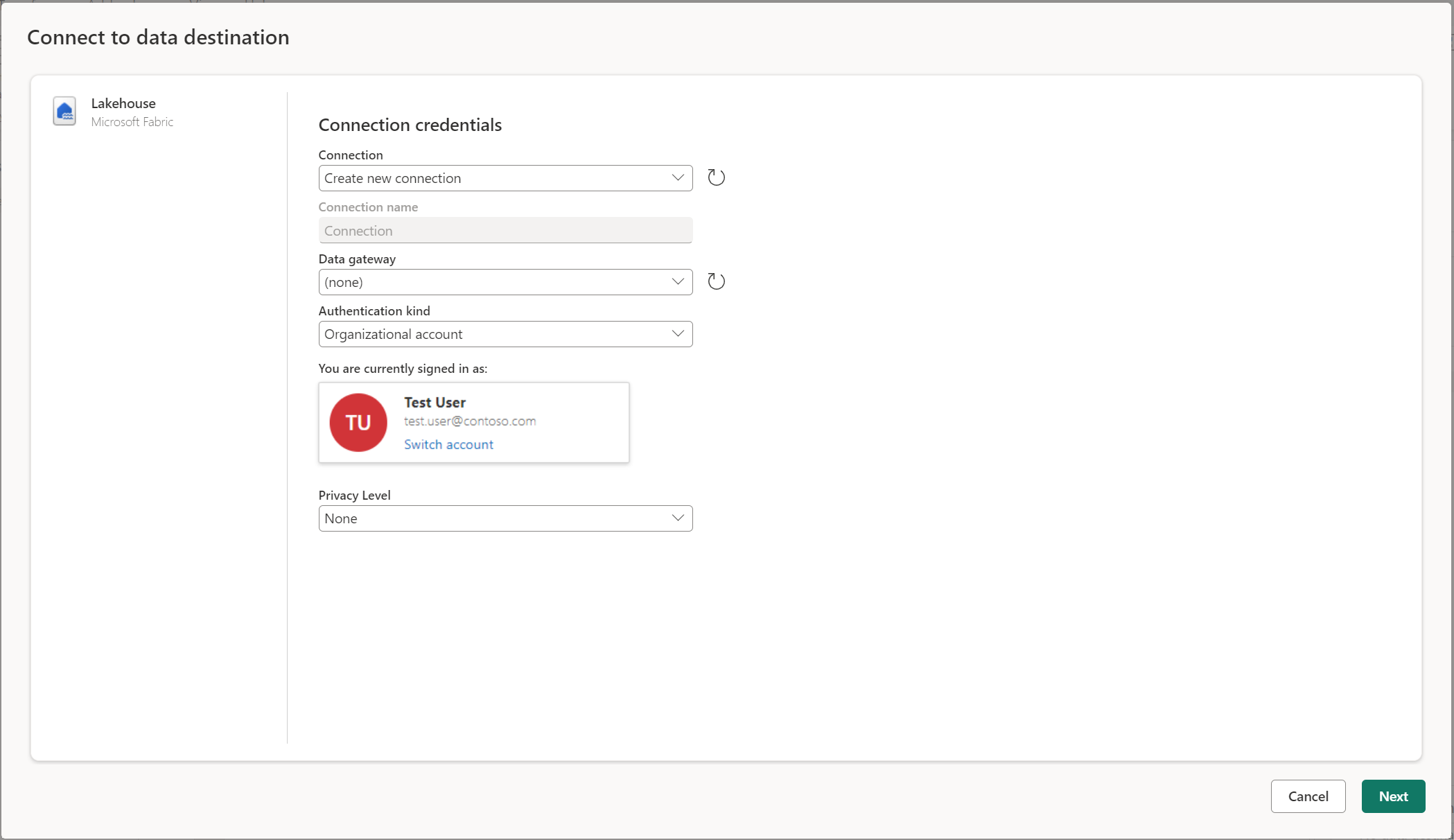

Verbinding maken met het gegevensdoel

Verbinding maken met de gegevensbestemming is vergelijkbaar met het maken van verbinding met een gegevensbron. Verbindingen kunnen worden gebruikt voor zowel het lezen als schrijven van uw gegevens, aangezien u over de juiste machtigingen voor de gegevensbron beschikt. U moet een nieuwe verbinding maken of een bestaande verbinding kiezen en vervolgens Volgende selecteren.

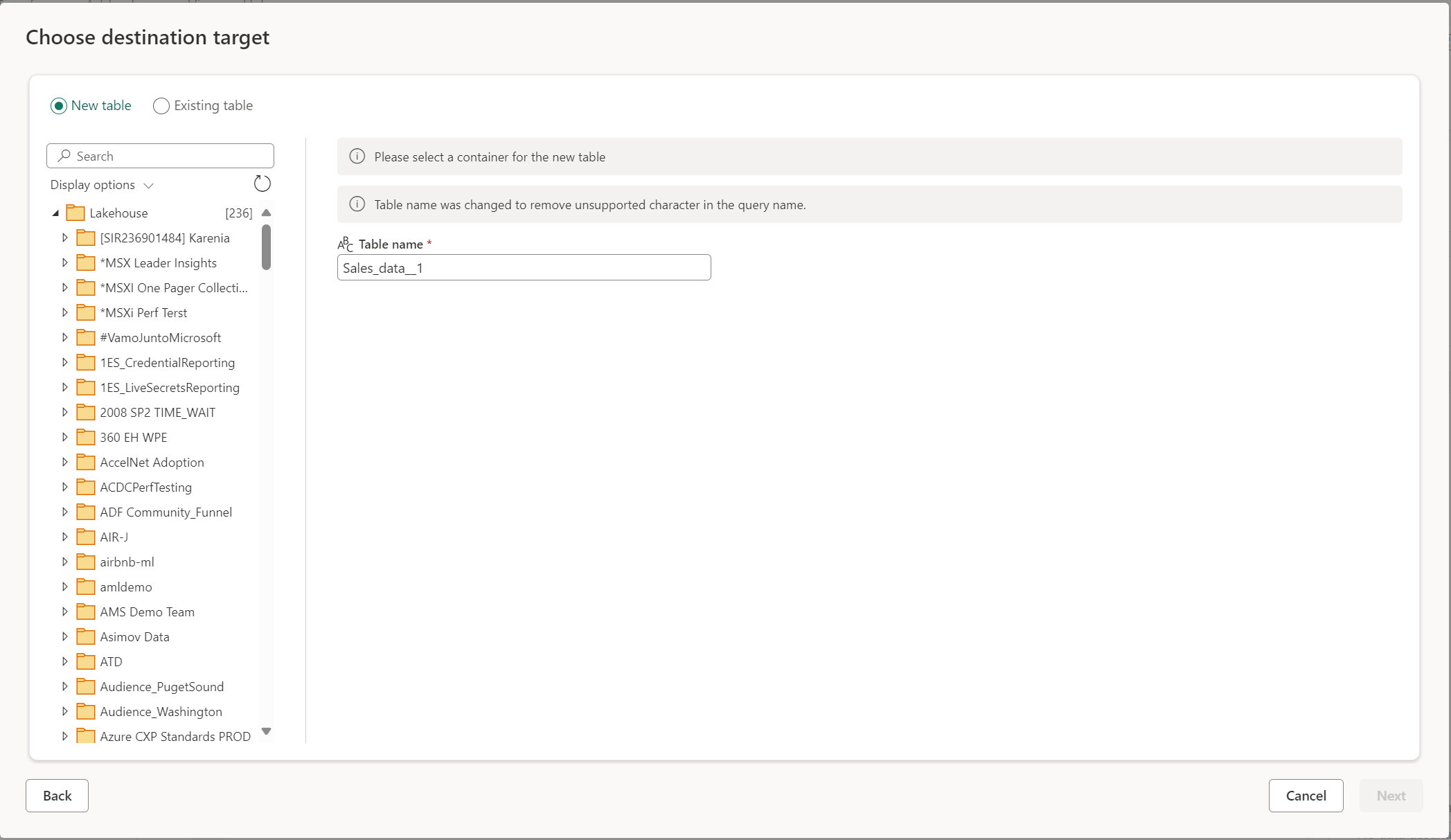

Een nieuwe tabel maken of een bestaande tabel kiezen

Wanneer u in uw gegevensbestemming laadt, kunt u een nieuwe tabel maken of een bestaande tabel kiezen.

Een nieuwe tabel maken

Wanneer u ervoor kiest om een nieuwe tabel te maken, wordt tijdens het vernieuwen van Dataflow Gen2 een nieuwe tabel gemaakt in uw gegevensbestemming. Als de tabel in de toekomst wordt verwijderd door handmatig naar het doel te gaan, maakt de gegevensstroom de tabel opnieuw tijdens de volgende gegevensstroomvernieuwing.

De tabelnaam heeft standaard dezelfde naam als uw querynaam. Als u ongeldige tekens in de tabelnaam hebt die niet door de bestemming worden ondersteund, wordt de tabelnaam automatisch aangepast. Veel bestemmingen ondersteunen bijvoorbeeld geen spaties of speciale tekens.

Vervolgens moet u de doelcontainer selecteren. Als u een van de Fabric-gegevensbestemmingen hebt gekozen, kunt u de navigator gebruiken om het Fabric-artefact te selecteren waarnaar u uw gegevens wilt laden. Voor Azure-bestemmingen kunt u de database opgeven tijdens het maken van de verbinding of de database selecteren in de navigatorervaring.

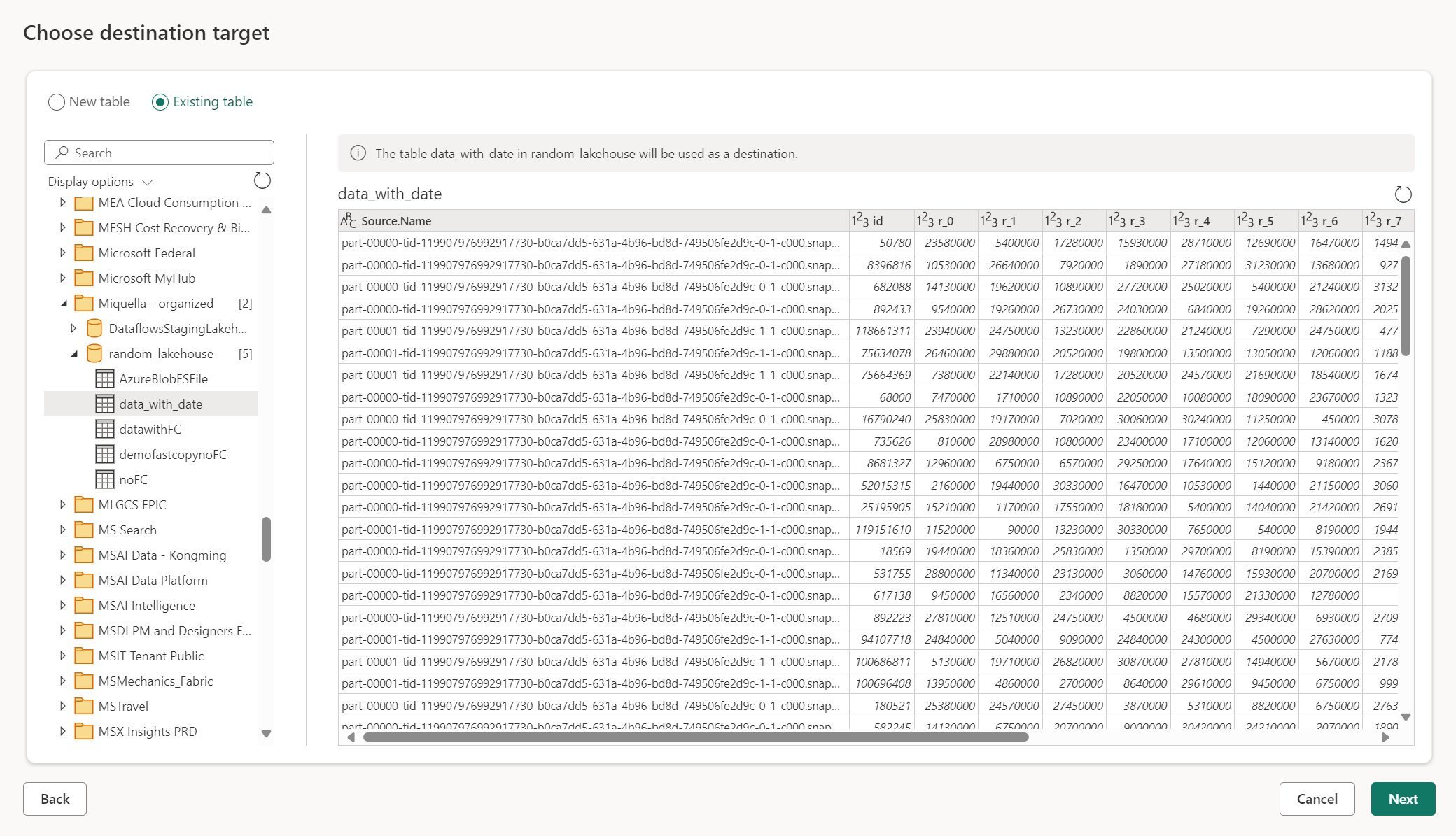

Een bestaande tabel gebruiken

Als u een bestaande tabel wilt kiezen, gebruikt u de wisselknop boven aan de navigator. Wanneer u een bestaande tabel kiest, moet u zowel het Fabric-artefact/de database als de tabel kiezen met behulp van de navigator.

Wanneer u een bestaande tabel gebruikt, kan de tabel in geen enkel scenario opnieuw worden gemaakt. Als u de tabel handmatig verwijdert uit het gegevensdoel, wordt de tabel niet opnieuw gemaakt in Dataflow Gen2 bij de volgende vernieuwing.

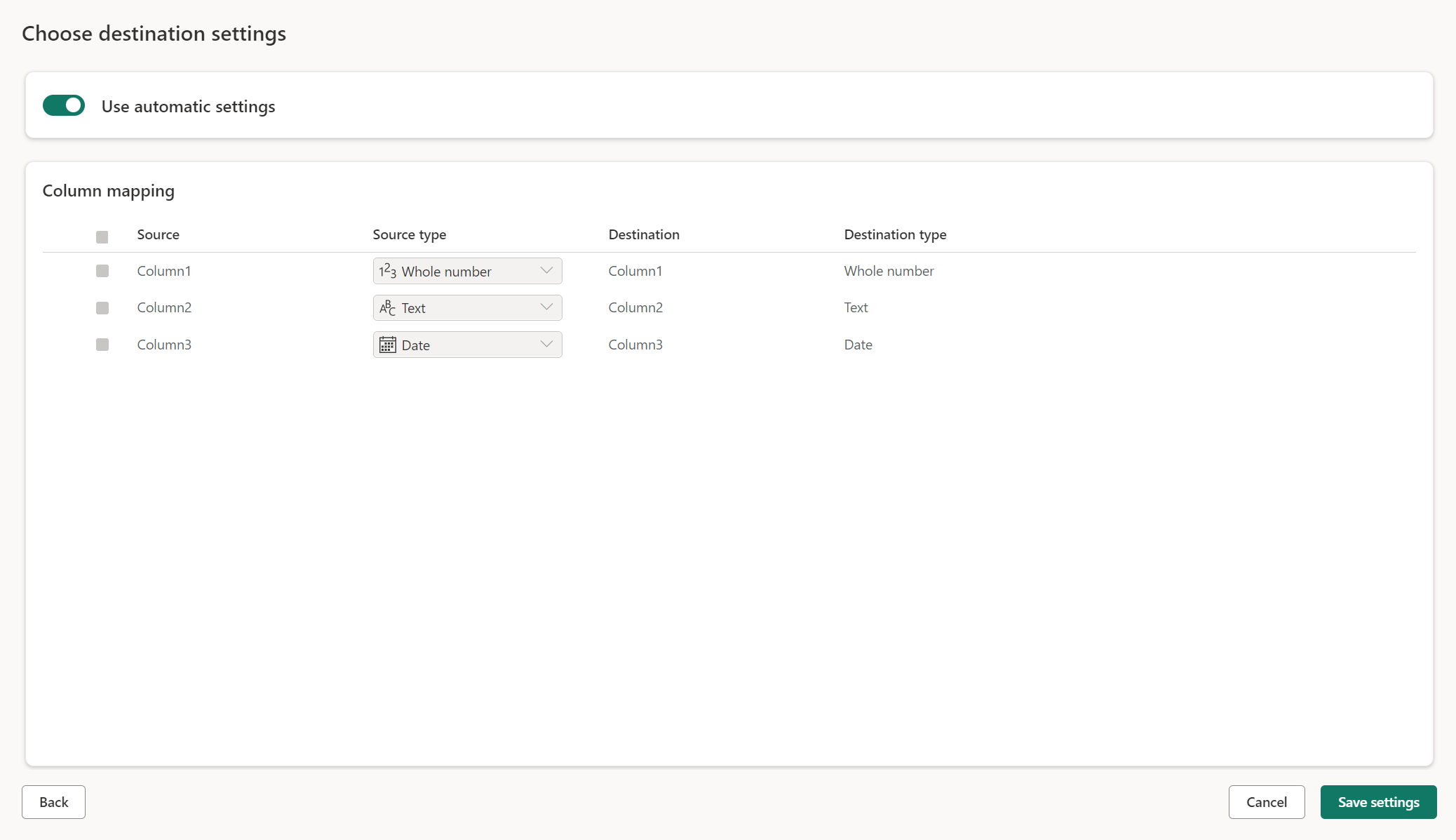

Beheerde instellingen voor nieuwe tabellen

Wanneer u in een nieuwe tabel laadt, zijn de automatische instellingen standaard ingeschakeld. Als u de automatische instellingen gebruikt, beheert Dataflow Gen2 de toewijzing voor u. De automatische instellingen bieden het volgende gedrag:

Updatemethode vervangen: gegevens worden vervangen bij elke gegevensstroomvernieuwing. Alle gegevens in de bestemming worden verwijderd. De gegevens in de bestemming worden vervangen door de uitvoergegevens van de gegevensstroom.

Beheerde toewijzing: Toewijzing wordt voor u beheerd. Wanneer u wijzigingen wilt aanbrengen in uw gegevens/query om een andere kolom toe te voegen of een gegevenstype te wijzigen, wordt de toewijzing automatisch aangepast voor deze wijziging wanneer u de gegevensstroom opnieuw publiceert. U hoeft niet elke keer dat u wijzigingen aanbrengt in uw gegevensstroom in te gaan, zodat u eenvoudig schemawijzigingen kunt doorvoeren wanneer u de gegevensstroom opnieuw publiceert.

Tabel verwijderen en opnieuw maken: als u deze schemawijzigingen wilt toestaan, wordt de tabel verwijderd en opnieuw gemaakt bij elke gegevensstroomvernieuwing. Het vernieuwen van de gegevensstroom kan ertoe leiden dat relaties of metingen die eerder aan de tabel zijn toegevoegd, worden verwijderd.

Notitie

Op dit moment worden automatische instellingen alleen ondersteund voor Lakehouse en Azure SQL-database als gegevensbestemming.

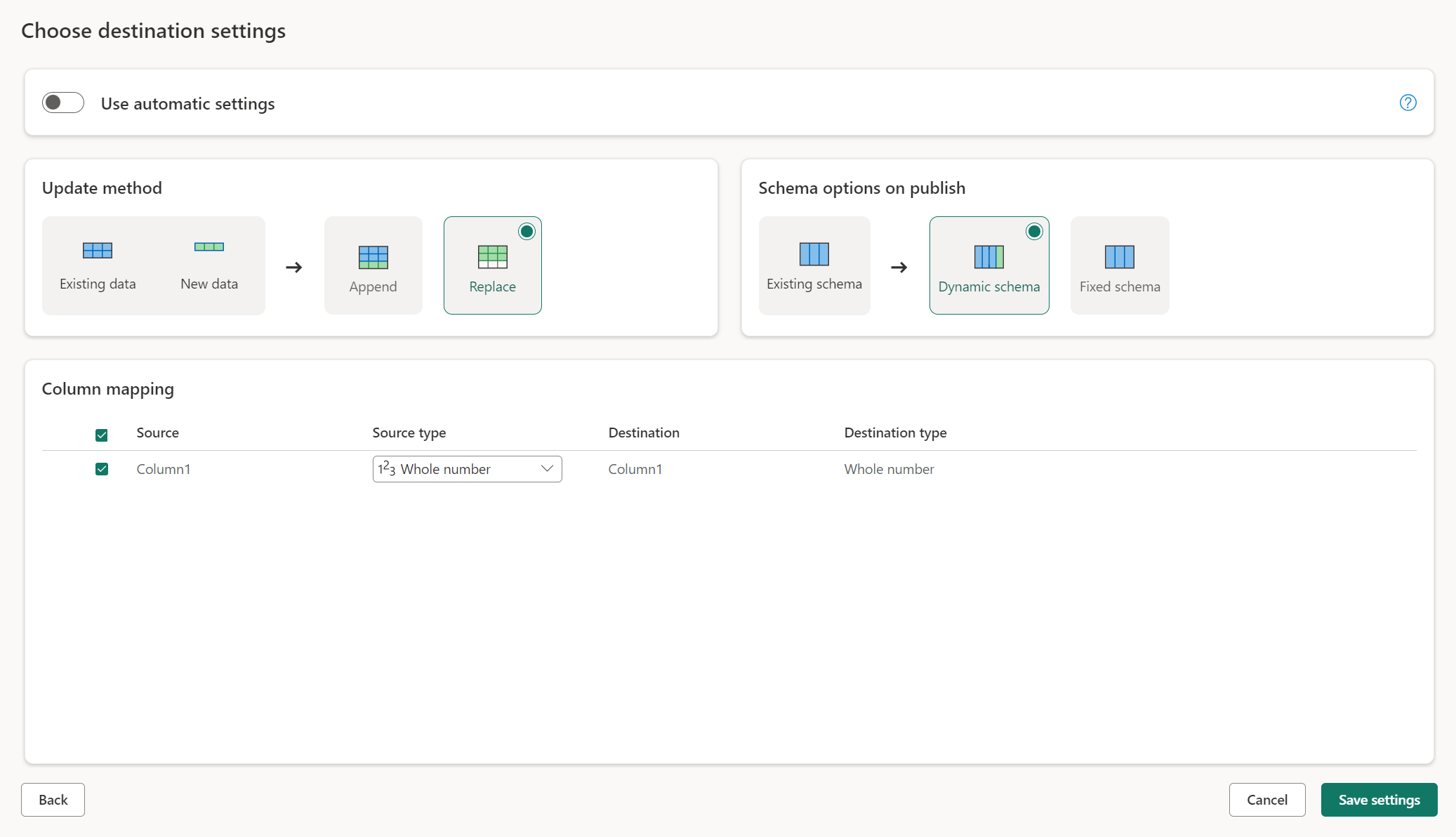

Handmatige instellingen

Als u automatische instellingen wilt gebruiken, krijgt u volledige controle over het laden van uw gegevens in de gegevensbestemming. U kunt eventuele wijzigingen aanbrengen in de kolomtoewijzing door het brontype te wijzigen of een kolom uit te sluiten die u niet nodig hebt in uw gegevensbestemming.

Methoden bijwerken

De meeste bestemmingen ondersteunen zowel toevoegen als vervangen als updatemethoden. Fabric KQL-databases en Azure Data Explorer bieden echter geen ondersteuning voor vervanging als updatemethode.

Vervangen: Bij elke gegevensstroomvernieuwing worden uw gegevens verwijderd van het doel en vervangen door de uitvoergegevens van de gegevensstroom.

Toevoegen: Bij elke gegevensstroomvernieuwing worden de uitvoergegevens van de gegevensstroom toegevoegd aan de bestaande gegevens in de gegevensbestemmingstabel.

Schemaopties voor publiceren

Schemaopties voor publiceren zijn alleen van toepassing wanneer de updatemethode wordt vervangen. Wanneer u gegevens toevoegt, zijn wijzigingen in het schema niet mogelijk.

Dynamisch schema: bij het kiezen van een dynamisch schema kunt u schemawijzigingen in de gegevensbestemming toestaan wanneer u de gegevensstroom opnieuw publiceert. Omdat u geen beheerde toewijzing gebruikt, moet u de kolomtoewijzing in de doelstroom van de gegevensstroom bijwerken wanneer u wijzigingen aanbrengt in uw query. Wanneer de gegevensstroom wordt vernieuwd, wordt de tabel verwijderd en opnieuw gemaakt. Het vernieuwen van de gegevensstroom kan ertoe leiden dat relaties of metingen die eerder aan de tabel zijn toegevoegd, worden verwijderd.

Vast schema: wanneer u een vast schema kiest, zijn schemawijzigingen niet mogelijk. Wanneer de gegevensstroom wordt vernieuwd, worden alleen de rijen in de tabel verwijderd en vervangen door de uitvoergegevens van de gegevensstroom. Alle relaties of metingen in de tabel blijven intact. Als u wijzigingen aanbrengt in uw query in de gegevensstroom, mislukt de publicatie van de gegevensstroom als wordt gedetecteerd dat het queryschema niet overeenkomt met het doelschema van de gegevens. Gebruik deze instelling wanneer u niet van plan bent om het schema te wijzigen en relaties of metingen toe te voegen aan uw doeltabel.

Notitie

Bij het laden van gegevens in het magazijn wordt alleen een vast schema ondersteund.

Ondersteunde gegevensbrontypen per bestemming

| Ondersteunde gegevenstypen per opslaglocatie | DataflowStagingLakehouse | Uitvoer van Azure DB (SQL) | Uitvoer van Azure Data Explorer | Fabric Lakehouse -uitvoer (LH) | Wh-uitvoer (Fabric Warehouse) | SQL Database-uitvoer (SQL) fabric |

|---|---|---|---|---|---|---|

| Actie | Nee | Nee | Nee | Nee | Nee | Nr. |

| Alle | Nee | Nee | Nee | Nee | Nee | Nr. |

| Binary | Nee | Nee | Nee | Nee | Nee | Nr. |

| Valuta | Ja | Ja | Ja | Ja | No | Ja |

| DateTimeZone | Ja | Ja | Ja | No | No | Ja |

| Duration | Nee | No | Ja | No | Nee | Nr. |

| Functie | Nee | Nee | Nee | Nee | Nee | Nee |

| Geen | Nee | Nee | Nee | Nee | Nee | Nr. |

| Null | Nee | Nee | Nee | Nee | Nee | Nr. |

| Tijd | Ja | Ja | No | Nee | No | Ja |

| Type | Nee | Nee | Nee | Nee | Nee | Nr. |

| Gestructureerd (lijst, record, tabel) | Nee | Nee | Nee | Nee | Nee | Nr. |

Geavanceerde onderwerpen

Fasering gebruiken voordat u naar een bestemming laadt

Om de prestaties van queryverwerking te verbeteren, kan fasering worden gebruikt in Dataflows Gen2 om Fabric-rekenkracht te gebruiken om uw query's uit te voeren.

Wanneer fasering is ingeschakeld voor uw query's (het standaardgedrag), worden uw gegevens in de faseringslocatie geladen. Dit is een intern Lakehouse dat alleen toegankelijk is voor gegevensstromen zelf.

Het gebruik van faseringslocaties kan in sommige gevallen de prestaties verbeteren, waarbij het vouwen van de query naar het SQL-analyse-eindpunt sneller is dan in de geheugenverwerking.

Wanneer u gegevens laadt in de Lakehouse- of andere niet-magazijnbestemmingen, schakelen we standaard de faseringsfunctie uit om de prestaties te verbeteren. Wanneer u gegevens in de gegevensbestemming laadt, worden de gegevens rechtstreeks naar de gegevensbestemming geschreven zonder fasering te gebruiken. Als u fasering voor uw query wilt gebruiken, kunt u deze opnieuw inschakelen.

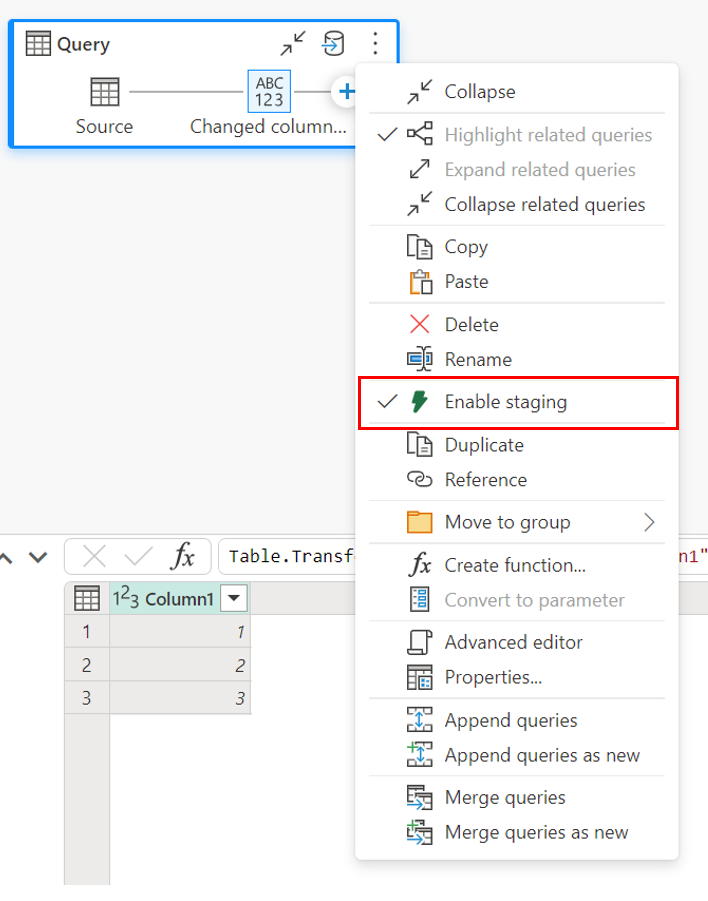

Als u fasering wilt inschakelen, klikt u met de rechtermuisknop op de query en schakelt u fasering in door de knop Fasering inschakelen te selecteren. De query wordt vervolgens blauw.

Gegevens laden in het magazijn

Wanneer u gegevens in het magazijn laadt, is fasering vereist voordat de schrijfbewerking naar de gegevensbestemming wordt uitgevoerd. Deze vereiste verbetert de prestaties. Momenteel wordt alleen laden in dezelfde werkruimte als de gegevensstroom ondersteund. Zorg ervoor dat fasering is ingeschakeld voor alle query's die in het magazijn worden geladen.

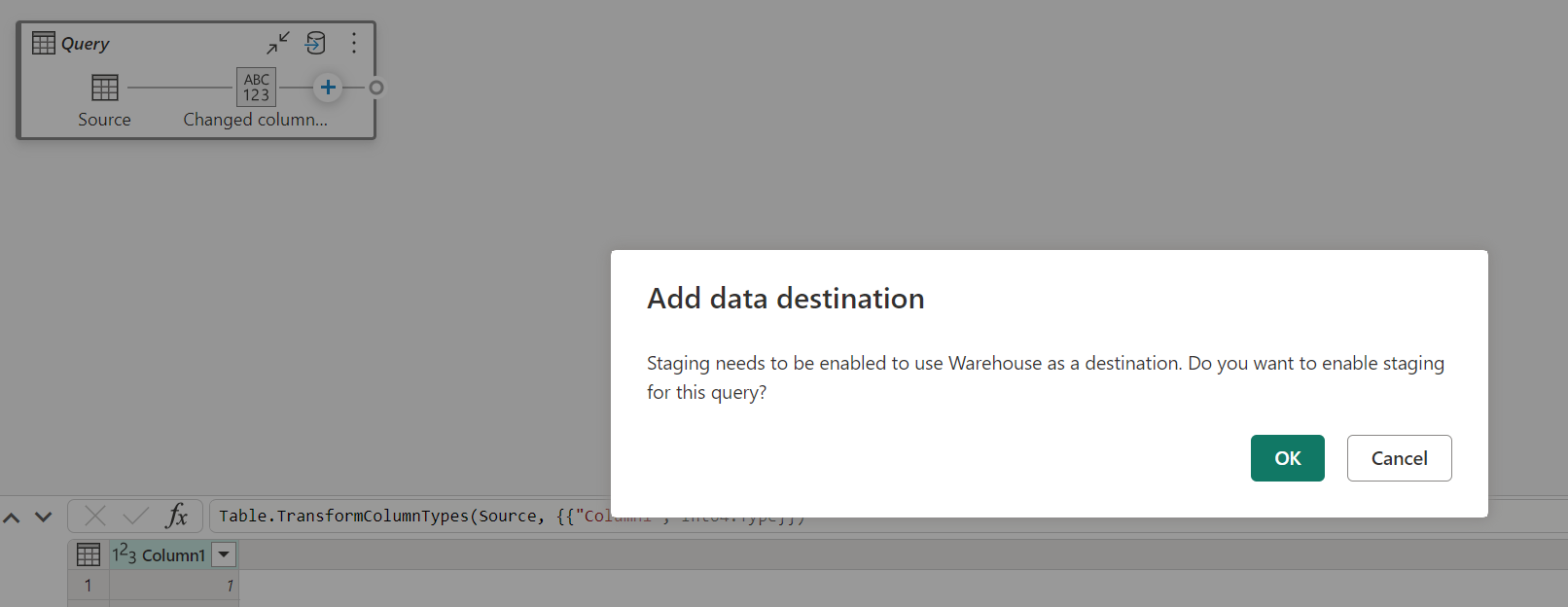

Wanneer fasering is uitgeschakeld en u Warehouse als uitvoerbestemming kiest, krijgt u een waarschuwing om fasering eerst in te schakelen voordat u de gegevensbestemming kunt configureren.

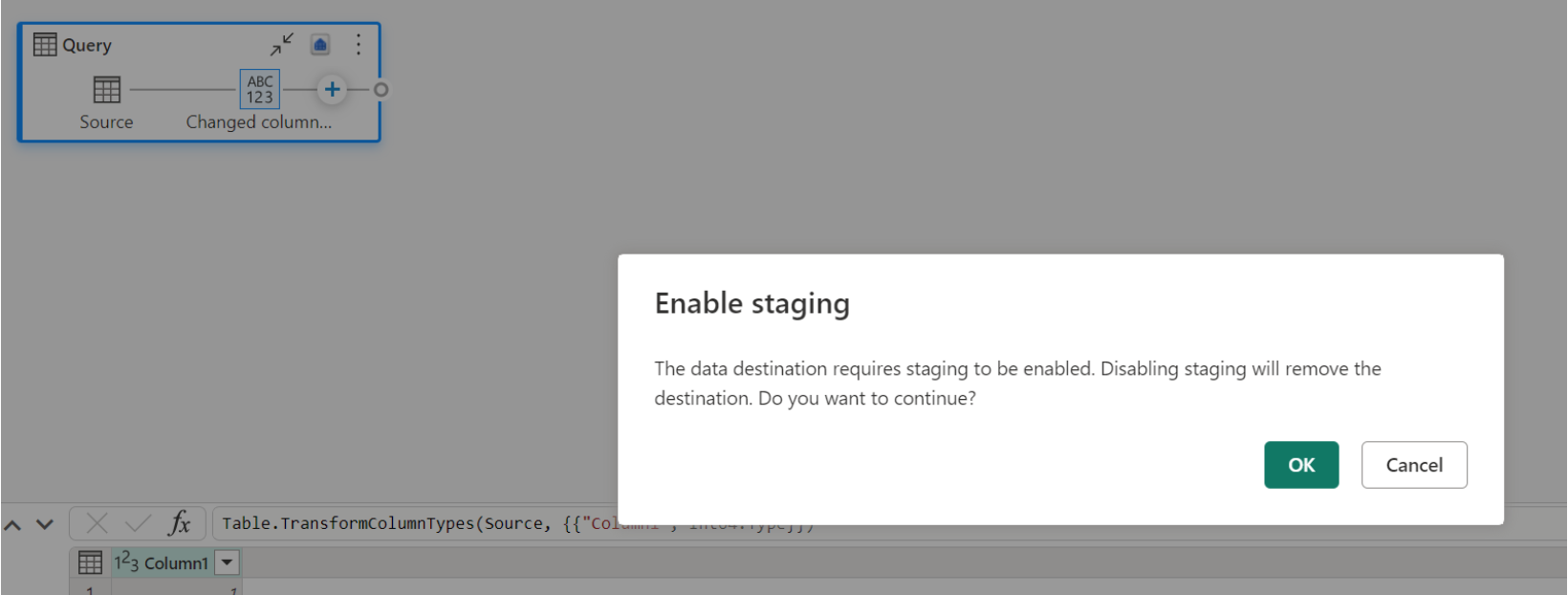

Als u al een magazijn als bestemming hebt en staging probeert uit te schakelen, wordt er een waarschuwing weergegeven. U kunt het magazijn verwijderen als de bestemming of de faseringsactie sluiten.

Uw Lakehouse-gegevensbestemming leegmaken

Wanneer u Lakehouse gebruikt als bestemming voor Dataflow Gen2 in Microsoft Fabric, is het van cruciaal belang om regelmatig onderhoud uit te voeren om optimale prestaties en efficiënt opslagbeheer te garanderen. Een essentiële onderhoudstaak is het leegmaken van uw gegevensbestemming. Dit proces helpt bij het verwijderen van oude bestanden waarnaar niet meer wordt verwezen door het Delta-tabellogboek, waardoor de opslagkosten worden geoptimaliseerd en de integriteit van uw gegevens behouden blijft.

Waarom vacuüm is belangrijk

- Opslagoptimalisatie: In de loop van de tijd verzamelen Delta-tabellen oude bestanden die niet meer nodig zijn. Vacuüm helpt bij het opschonen van deze bestanden, het vrijmaken van opslagruimte en het verlagen van de kosten.

- Prestatieverbetering: het verwijderen van onnodige bestanden kan de queryprestaties verbeteren door het aantal bestanden te verminderen dat moet worden gescand tijdens leesbewerkingen.

- Gegevensintegriteit: Ervoor zorgen dat alleen relevante bestanden worden bewaard, helpt de integriteit van uw gegevens te behouden, waardoor potentiële problemen met niet-doorgevoerde bestanden die kunnen leiden tot fouten in lezers of beschadigde tabellen, worden voorkomen.

Uw gegevensbestemming leegmaken

Voer de volgende stappen uit om uw Delta-tabellen in Lakehouse te vacuümeren:

- Navigeer naar uw Lakehouse: Ga vanuit uw Microsoft Fabric-account naar het gewenste Lakehouse.

- Onderhoud van toegangstabellen: Klik in Lakehouse Explorer met de rechtermuisknop op de tabel die u wilt onderhouden of gebruik het beletselteken voor toegang tot het contextmenu.

- Selecteer onderhoudsopties: Kies de menuopdracht Onderhoud en selecteer de optie Vacuüm .

- Voer de opdracht vacuüm uit: stel de retentiedrempel in (standaard is zeven dagen) en voer de vacuümopdracht uit door Nu uitvoeren te selecteren.

Aanbevolen procedures

- Bewaarperiode: Stel een bewaarperiode van ten minste zeven dagen in om ervoor te zorgen dat oude momentopnamen en niet-doorgevoerde bestanden niet voortijdig worden verwijderd, waardoor gelijktijdige tabellezers en schrijvers kunnen worden onderbroken.

- Regelmatig onderhoud: plan regelmatig vacuüm in als onderdeel van uw dataonderhoudsroutine om uw Delta-tabellen geoptimaliseerd en gereed te houden voor analyse.

Door vacuüm in uw strategie voor gegevensonderhoud op te nemen, kunt u ervoor zorgen dat uw Lakehouse-bestemming efficiënt, rendabel en betrouwbaar blijft voor uw gegevensstroombewerkingen.

Raadpleeg de onderhoudsdocumentatie voor deltatabellen voor meer gedetailleerde informatie over tabelonderhoud in Lakehouse.

Null-waarde toegestaan

In sommige gevallen wanneer u een kolom met null-waarden hebt, wordt deze door Power Query gedetecteerd als niet-nullbaar en wanneer u naar het gegevensdoel schrijft, is het kolomtype niet nullbaar. Tijdens het vernieuwen treedt de volgende fout op:

E104100 Couldn't refresh entity because of an issue with the mashup document MashupException.Error: DataFormat.Error: Error in replacing table's content with new data in a version: #{0}., InnerException: We can't insert null data into a non-nullable column., Underlying error: We can't insert null data into a non-nullable column. Details: Reason = DataFormat.Error;Message = We can't insert null data into a non-nullable column.; Message.Format = we can't insert null data into a non-nullable column.

Als u null-kolommen wilt afdwingen, kunt u de volgende stappen uitvoeren:

Verwijder de tabel uit de gegevensbestemming.

Verwijder de gegevensbestemming uit de gegevensstroom.

Ga naar de gegevensstroom en werk de gegevenstypen bij met behulp van de volgende Power Query-code:

Table.TransformColumnTypes( #"PREVIOUS STEP", { {"COLLUMNNAME1", type nullable text}, {"COLLUMNNAME2", type nullable Int64.Type} } )Voeg de gegevensbestemming toe.

Conversie en upscaling van gegevenstypen

In sommige gevallen verschilt het gegevenstype binnen de gegevensstroom van wat wordt ondersteund in de onderstaande gegevensbestemming enkele standaardconversies die we hebben ingesteld om ervoor te zorgen dat u uw gegevens nog steeds in de gegevensbestemming kunt ophalen:

| Bestemming | Gegevenstype gegevensstroom | Doelgegevenstype |

|---|---|---|

| Infrastructuurwarehouse | Int8.Type | Int16.Type |