Bewaking van apache Spark-toepassingsgegevens

Met Microsoft Fabric kunt u Apache Spark gebruiken om notebooks, taken en andere soorten toepassingen in uw werkruimte uit te voeren. In dit artikel wordt uitgelegd hoe u uw Apache Spark-toepassing bewaakt, zodat u de recente uitvoeringsstatus, problemen en voortgang van uw taken in de gaten kunt houden.

Apache Spark-toepassingen weergeven

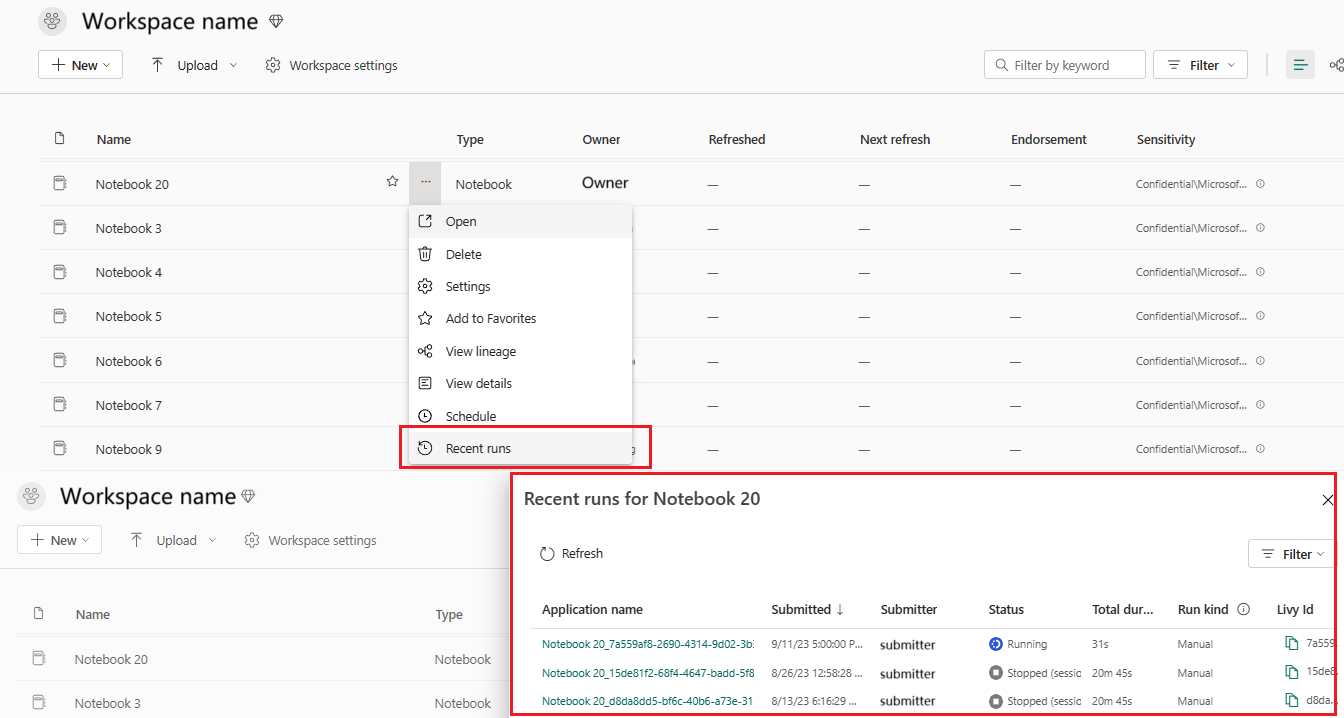

U kunt alle Apache Spark-toepassingen bekijken vanuit de Spark-taakdefinitie of het contextmenu voor notitieblokitems toont de recente uitvoeringsoptie ->Recente uitvoeringen.

U kunt de naam selecteren van de toepassing die u wilt weergeven in de lijst met toepassingen. Op de pagina met toepassingsgegevens kunt u de toepassingsgegevens bekijken.

Status van Apache Spark-toepassing bewaken

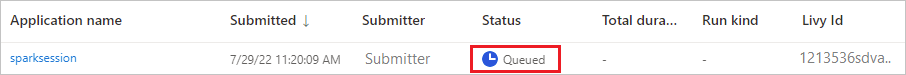

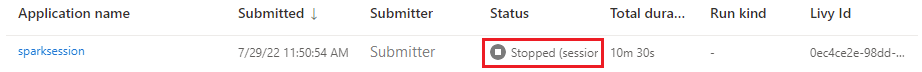

Open de pagina Recente uitvoeringen van het notebook of de Spark-taakdefinitie. U kunt de status van de Apache-toepassing bekijken.

- Geslaagd

- In wachtrij geplaatst

- Gestopt

- Geannuleerd

- Mislukt

Projecten

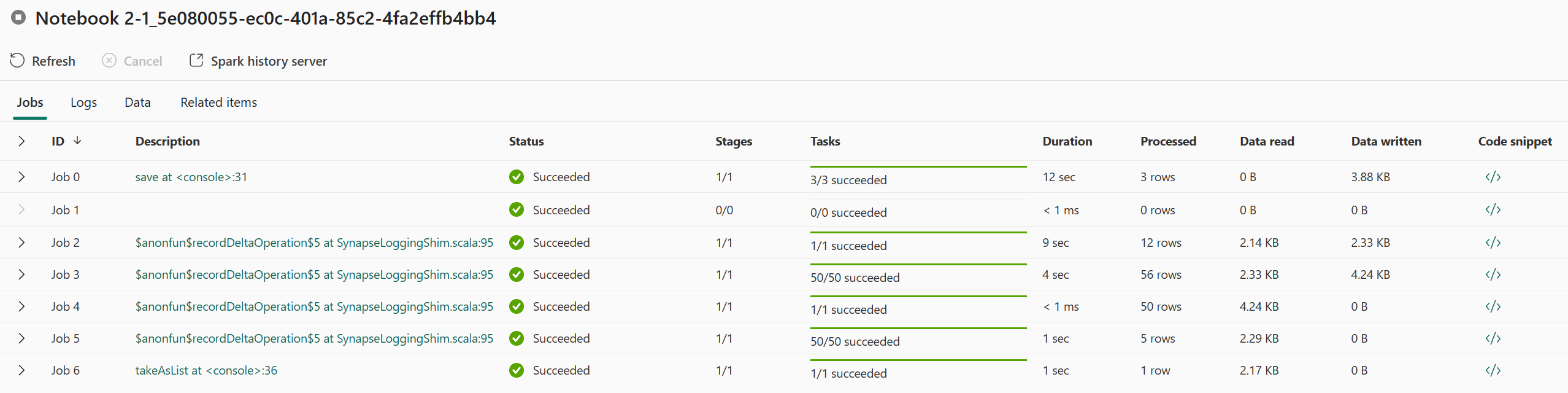

Open een Apache Spark-toepassingstaak in het contextmenu van de Spark-taakdefinitie of het contextmenu voor notitieblokitems met de optie Recent uitvoeren -Recente uitvoeringen -> selecteer een taak op de pagina recente uitvoeringen.>

Op de pagina details van de Apache Spark-toepassingsbewaking wordt de lijst met taken uitgevoerd op het tabblad Taken weergegeven. Hier kunt u de details van elke taak bekijken, waaronder taak-id, beschrijving, status, fasen, taken, duur, verwerkt, gegevens lezen, geschreven gegevens en codefragment.

- Als u op taak-id klikt, kunt u de taak uitvouwen/samenvouwen.

- Klik op de taakbeschrijving. U kunt naar de taak- of fasepagina gaan in de Spark-gebruikersinterface.

- Klik op het codefragment van de taak. U kunt de code met betrekking tot deze taak controleren en kopiëren.

Hulpmiddelen

De uitvoerdersgebruiksgrafiek onder het tabblad Resources visualiseert de toewijzing en het gebruik van Spark-uitvoerders voor de huidige Spark-toepassing in bijna realtime tijdens de uitvoering van Spark. U kunt het volgende raadplegen: Resourcegebruik van Apache Spark-toepassingen bewaken.

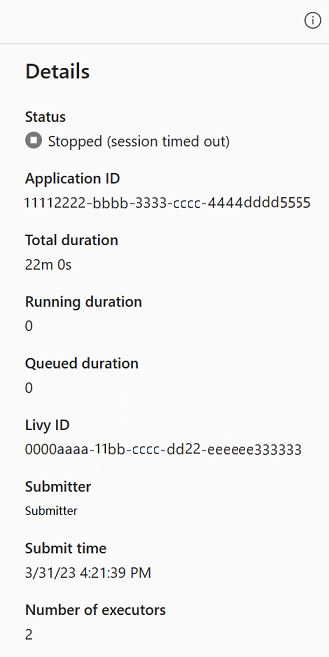

Samenvattingsvenster

Klik op de pagina bewaking van Apache Spark-toepassingen op de knop Eigenschappen om het samenvattingsvenster te openen/samen te vouwen. U kunt de details voor deze toepassing bekijken in Details.

- Status voor deze Spark-toepassing.

- De id van deze Spark-toepassing.

- Totale duur.

- Uitvoeringsduur voor deze Spark-toepassing.

- Duur in de wachtrij voor deze Spark-toepassing.

- Livy-id

- Submitter voor deze Spark-toepassing.

- Verzend tijd voor deze Spark-toepassing.

- Aantal uitvoerders.

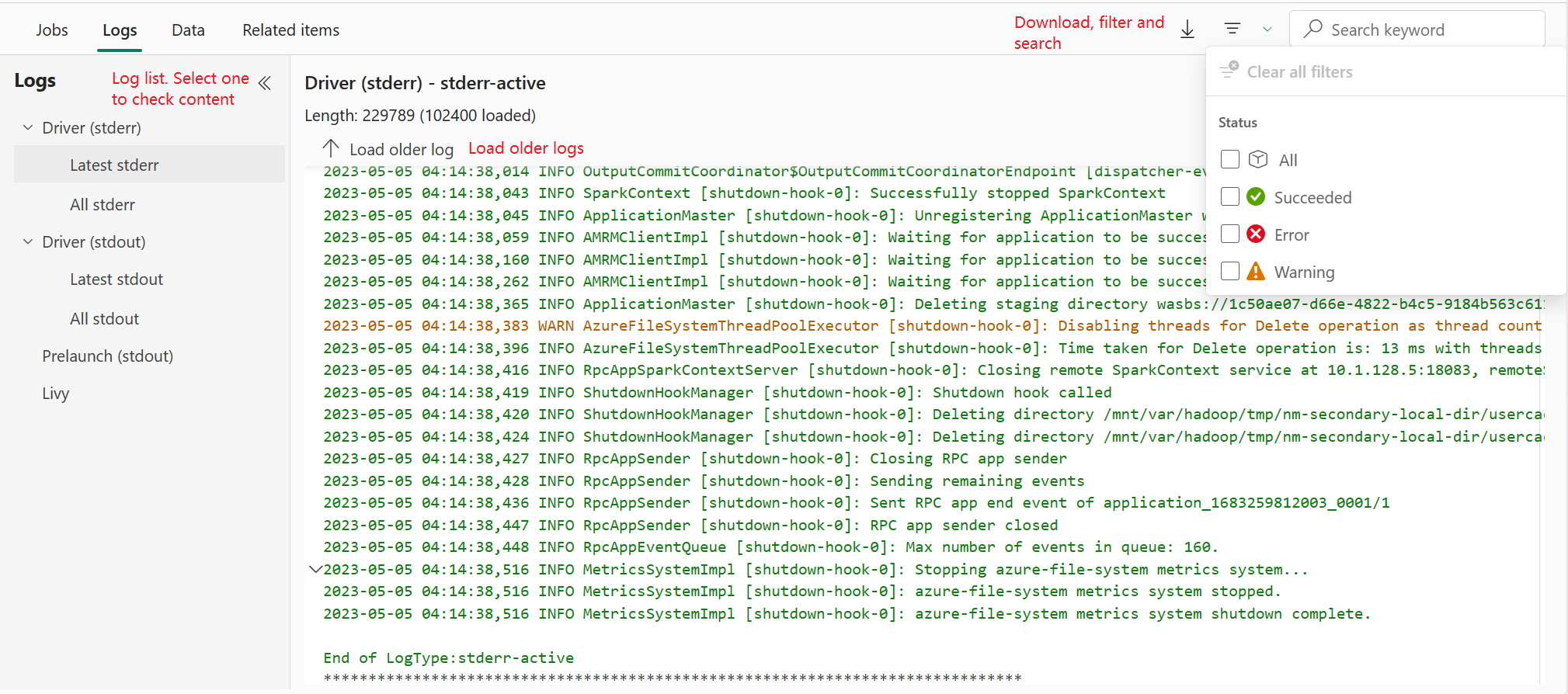

Logboeken

Voor het tabblad Logboeken kunt u het volledige logboek van Livy, Prelaunch, Stuurprogrammalogboek weergeven met verschillende opties die zijn geselecteerd in het linkerdeelvenster. En u kunt de vereiste logboekgegevens rechtstreeks ophalen door trefwoorden te zoeken en de logboeken weer te geven door de logboekstatus te filteren. Klik op Logboek downloaden om de logboekgegevens naar de lokale te downloaden.

Soms zijn er geen logboeken beschikbaar, zoals de status van de taak in de wachtrij en het maken van het cluster is mislukt.

Livelogboeken zijn alleen beschikbaar wanneer het verzenden van apps mislukt en stuurprogrammalogboeken worden ook opgegeven.

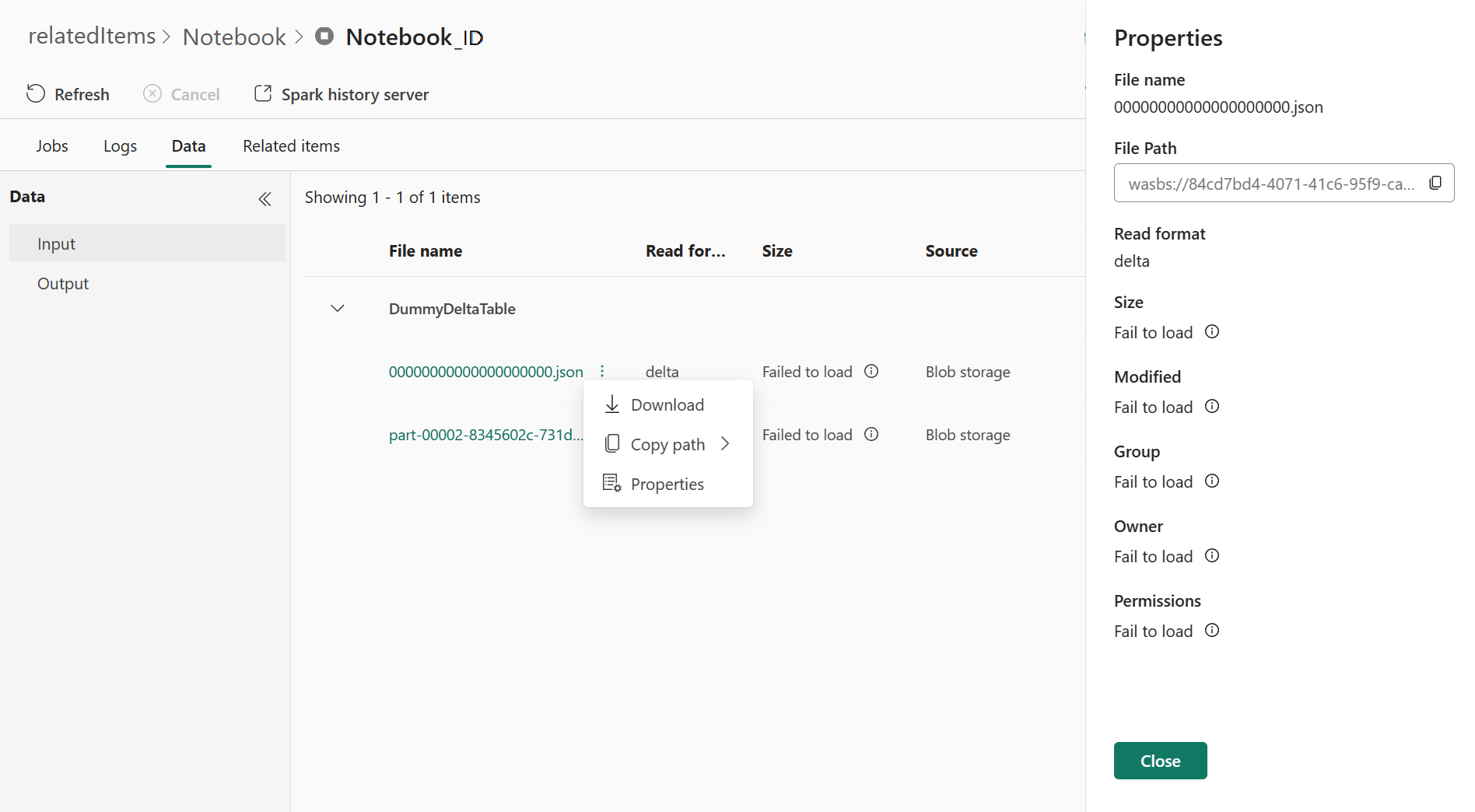

Gegevens

Voor het tabblad Gegevens kunt u de gegevenslijst op het klembord kopiëren, de gegevenslijst en één gegevens downloaden en de eigenschappen voor elke gegevens controleren.

- Het linkerdeelvenster kan worden uitgevouwen of samengevouwen.

- De naam, leesindeling, grootte, bron en pad van de invoer- en uitvoerbestanden worden weergegeven in deze lijst.

- De bestanden in invoer en uitvoer kunnen worden gedownload, pad kopiëren en eigenschappen weergeven.

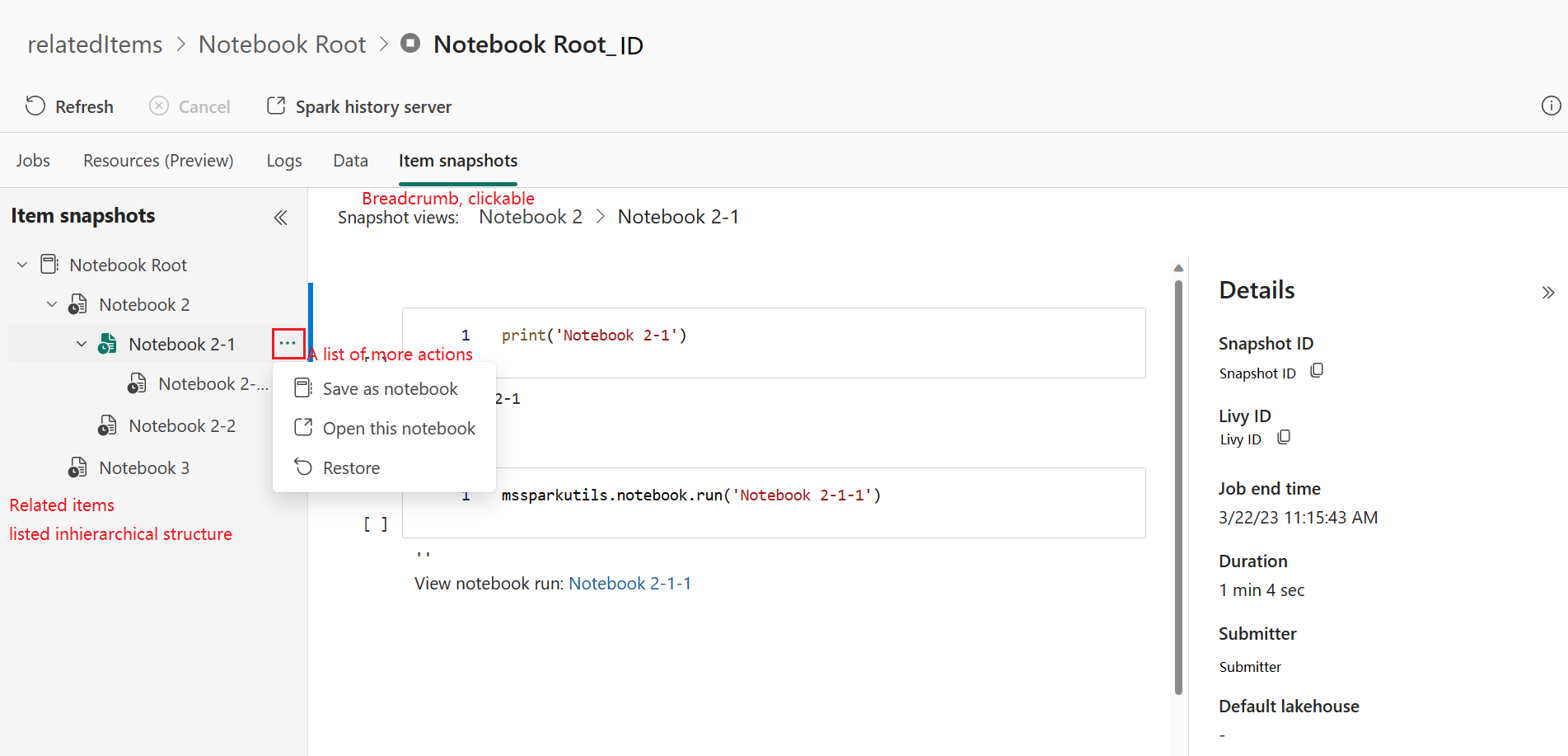

Momentopnamen van items

Op het tabblad Itemmomentopnamen kunt u items bekijken die zijn gekoppeld aan de Apache Spark-toepassing, waaronder notebooks, Spark-taakdefinitie en/of pijplijnen. Op de pagina met momentopnamen van items wordt de momentopname van de code en parameterwaarden weergegeven op het moment van uitvoering voor Notebooks. Ook ziet u de momentopname van alle instellingen en parameters op het moment van indiening voor Spark-taakdefinities. Als de Apache Spark-toepassing is gekoppeld aan een pijplijn, geeft de gerelateerde itempagina ook de bijbehorende pijplijn en de Spark-activiteit weer.

In het scherm Itemmomentopnamen kunt u het volgende doen:

- Blader en navigeer door de gerelateerde items in de hiërarchische structuur.

- Klik op het beletselteken 'Een lijst met meer acties' voor elk item om verschillende acties uit te voeren.

- Klik op het momentopname-item om de inhoud ervan weer te geven.

- Bekijk de Breadcrumb om het pad van het geselecteerde item naar de hoofdmap te zien.

Notitie

De functie Momentopnamen van notebooks biedt momenteel geen ondersteuning voor notebooks die actief zijn of in een Spark-sessie met hoge gelijktijdigheid.

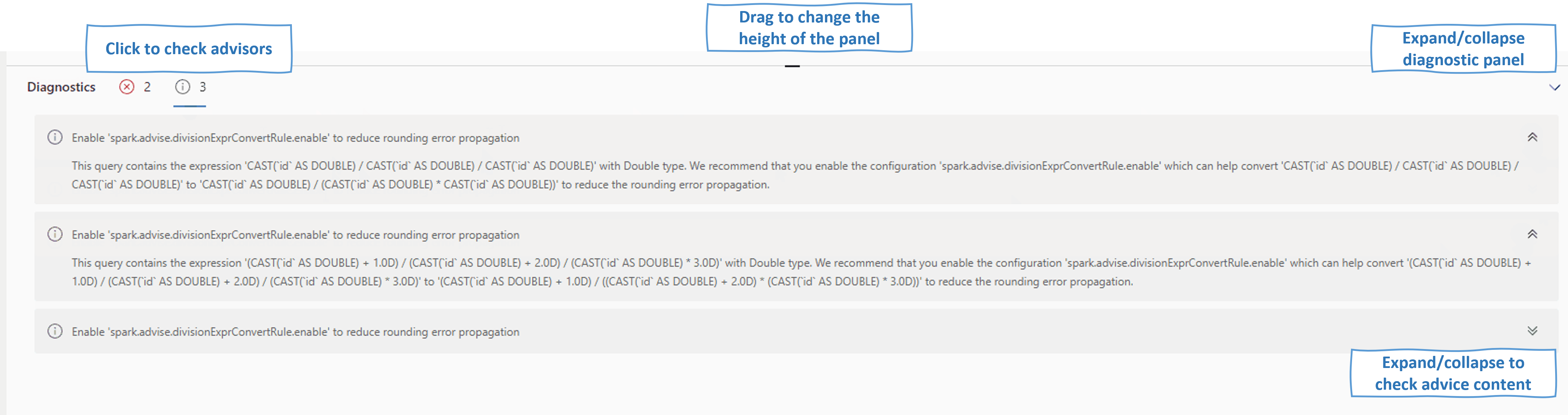

Diagnostiek

Het diagnostische deelvenster biedt gebruikers realtime aanbevelingen en foutanalyse, die worden gegenereerd door Spark Advisor via een analyse van de code van de gebruiker. Met ingebouwde patronen helpt de Apache Spark Advisor gebruikers veelvoorkomende fouten te voorkomen en fouten te analyseren om hun hoofdoorzaak te identificeren.

Gerelateerde inhoud

De volgende stap nadat u de details van een Apache Spark-toepassing hebt bekeken, is door de voortgang van de Spark-taak onder de notebookcel weer te geven. U kunt het volgende raadplegen: