Gegevens van Event Hubs vastleggen in Parquet-indeling

In dit artikel wordt uitgelegd hoe u de code-editor zonder code gebruikt om automatisch streaminggegevens vast te leggen in Event Hubs in een Azure Data Lake Storage Gen2-account in de Parquet-indeling.

Vereisten

Een Azure Event Hubs-naamruimte met een Event Hub en een Azure Data Lake Storage Gen2-account met een container voor het opslaan van de vastgelegde gegevens. Deze resources moeten openbaar toegankelijk zijn en kunnen zich niet achter een firewall bevinden of zijn beveiligd in een virtueel Azure-netwerk.

Als u geen Event Hub hebt, maakt u er een door de instructies uit de quickstart te volgen: Een Event Hub maken.

Als u geen Data Lake Storage Gen2-account hebt, maakt u er een door de instructies te volgen van Een opslagaccount maken

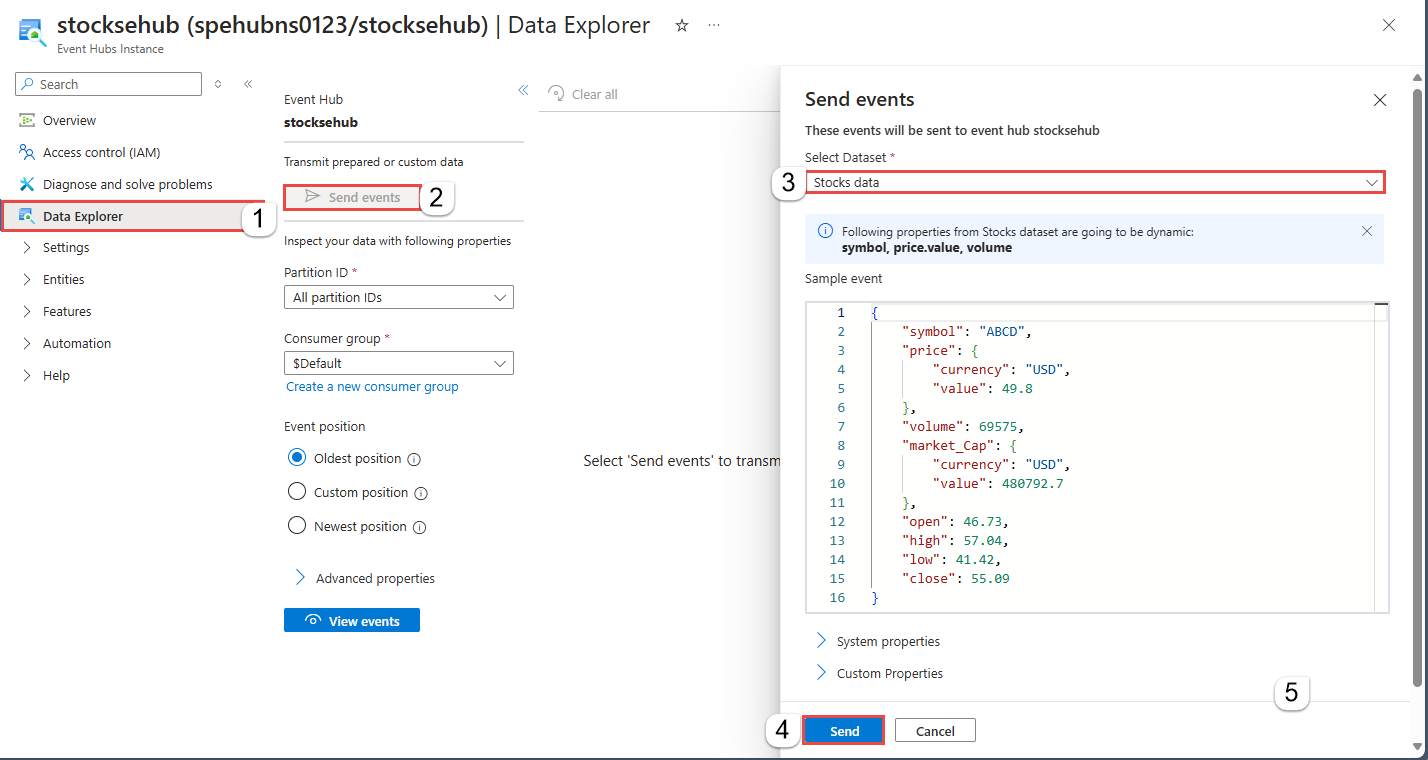

De gegevens in uw Event Hubs moeten worden geserialiseerd in JSON-, CSV- of Avro-indeling. Voor testdoeleinden selecteert u Gegevens genereren (preview) in het linkermenu, selecteert u Aandelengegevens voor de gegevensset en selecteert u Vervolgens Verzenden.

Een taak configureren om gegevens vast te leggen

Gebruik de volgende stappen om een Stream Analytics-taak te configureren voor het vastleggen van gegevens in Azure Data Lake Storage Gen2.

Navigeer in Azure Portal naar uw Event Hub.

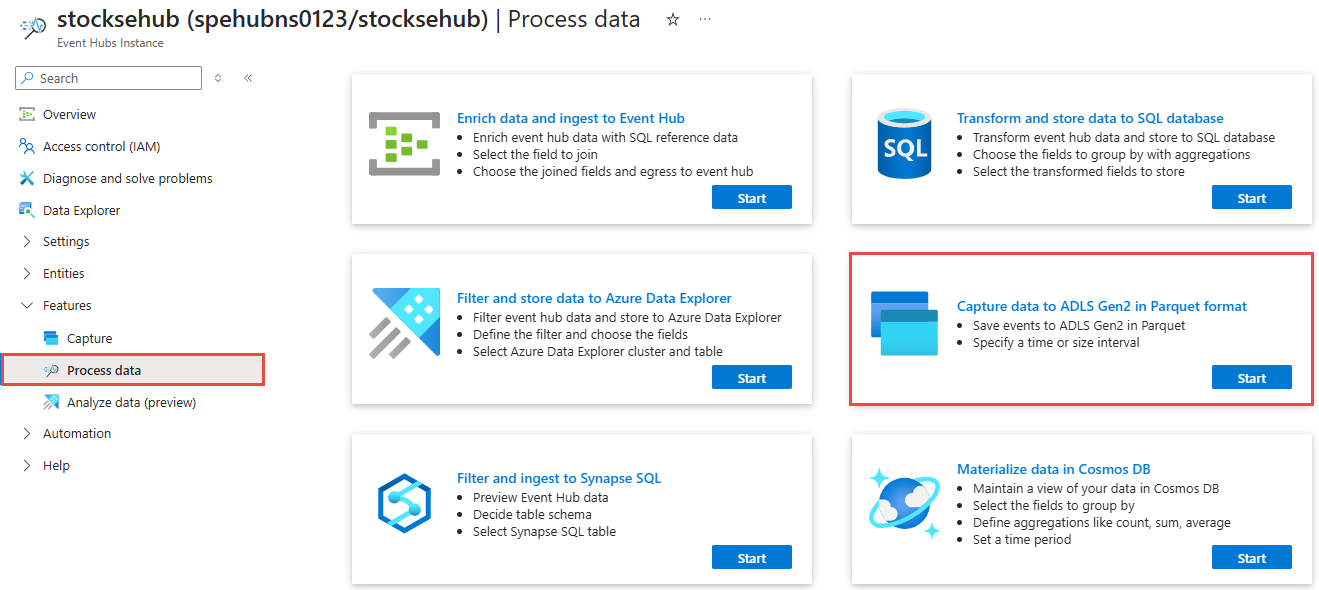

Selecteer in het linkermenu Procesgegevens onder Functies. Selecteer vervolgens Start op de Capture-gegevens naar ADLS Gen2 in de Parquet-indelingskaart .

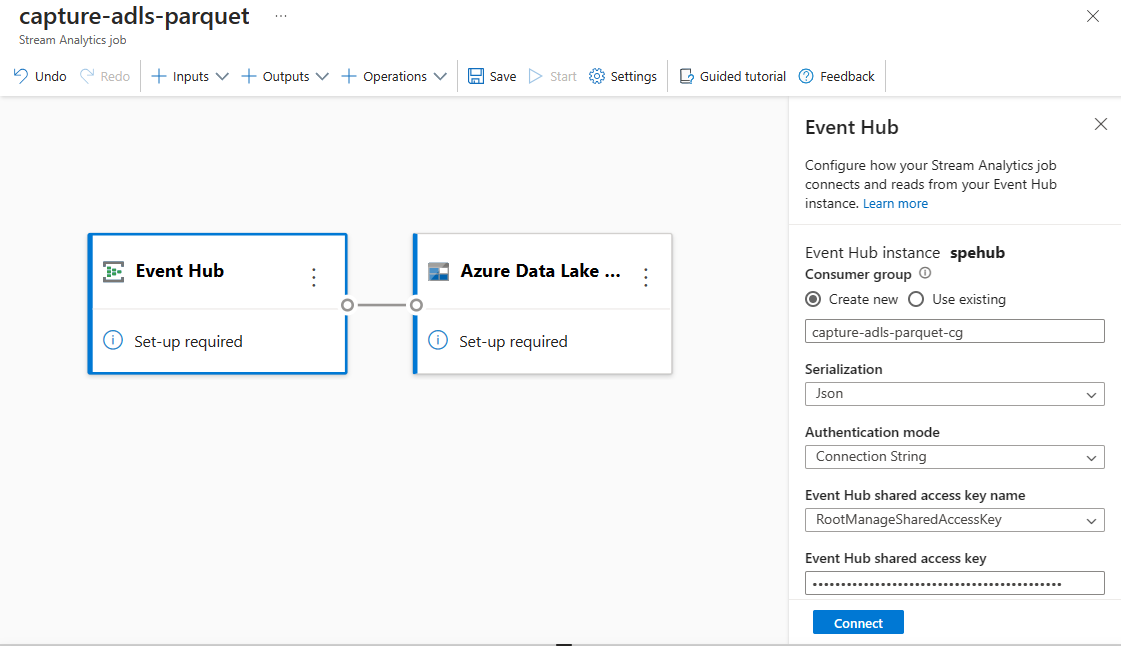

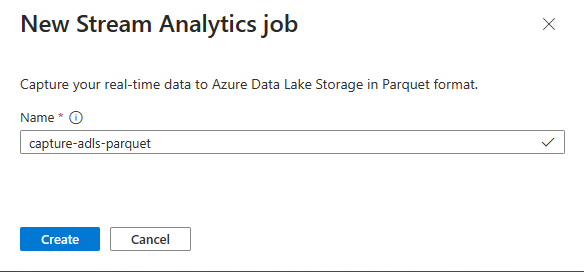

Voer een naam in voor uw Stream Analytics-taak en selecteer Vervolgens Maken.

Geef het serialisatietype van uw gegevens op in de Event Hubs en de verificatiemethode die door de taak wordt gebruikt om verbinding te maken met Event Hubs. Selecteer vervolgens Connect.

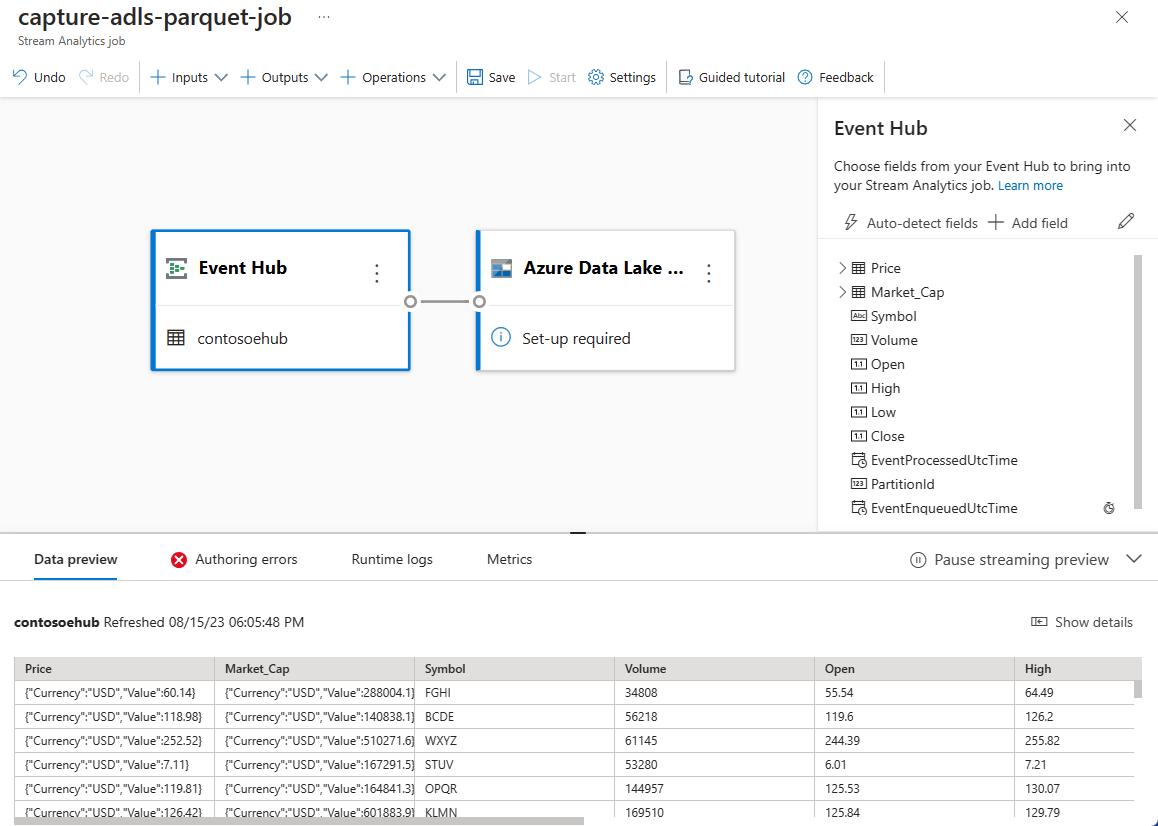

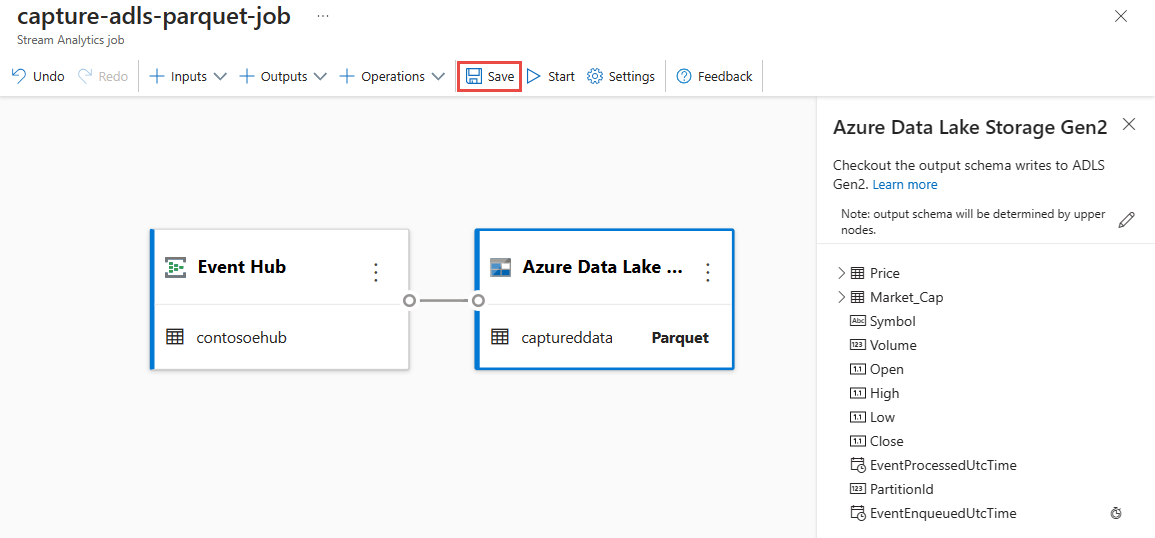

Wanneer de verbinding tot stand is gebracht, ziet u:

Velden die aanwezig zijn in de invoergegevens. U kunt veld toevoegen kiezen of u kunt het drie puntsymbool naast een veld selecteren om desgewenst de naam te verwijderen, te wijzigen of de naam ervan te wijzigen.

Een livevoorbeeld van binnenkomende gegevens in de tabel Gegevensvoorbeeld onder de diagramweergave. Het wordt periodiek vernieuwd. U kunt streamingvoorbeeld onderbreken selecteren om een statische weergave van de voorbeeldinvoer weer te geven.

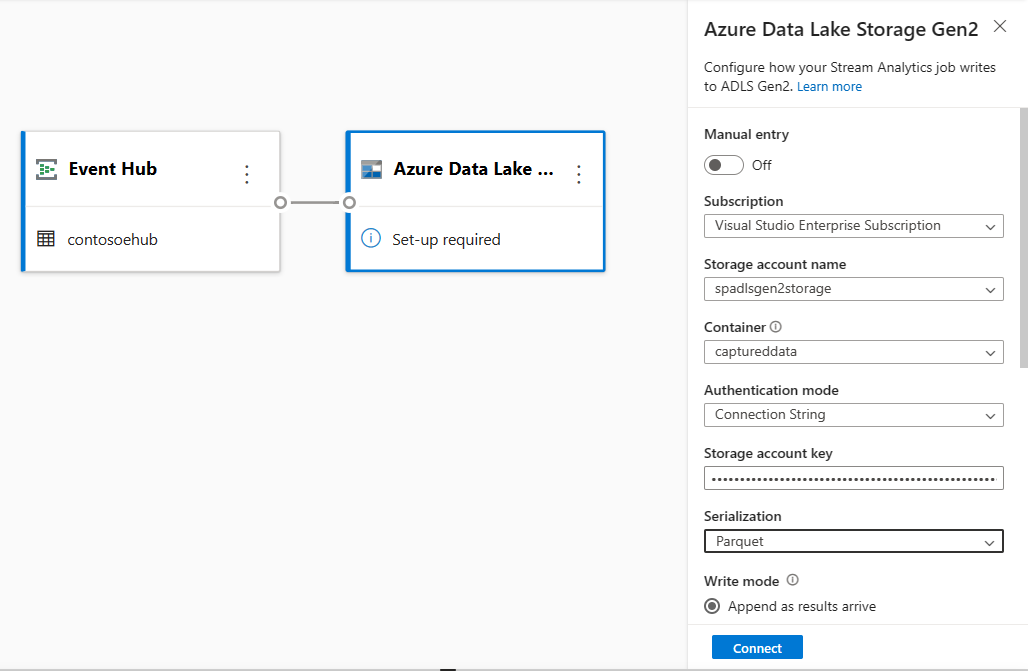

Selecteer de tegel Azure Data Lake Storage Gen2 om de configuratie te bewerken.

Voer op de configuratiepagina van Azure Data Lake Storage Gen2 de volgende stappen uit:

Selecteer het abonnement, de naam van het opslagaccount en de container in de vervolgkeuzelijst.

Zodra het abonnement is geselecteerd, moeten de verificatiemethode en de sleutel van het opslagaccount automatisch worden ingevuld.

Selecteer Parquet voor serialisatie-indeling .

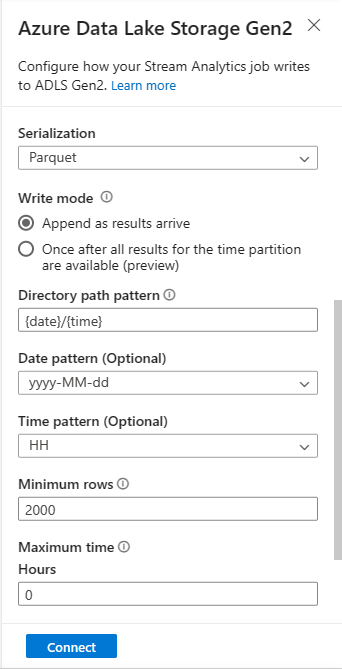

Voor streaming-blobs is het padpatroon van de map naar verwachting een dynamische waarde. Het is vereist dat de datum deel uitmaakt van het bestandspad voor de blob, waarnaar

{date}wordt verwezen. Zie voor meer informatie over aangepaste padpatronen, aangepaste blob-uitvoerpartitionering van Azure Stream Analytics.Selecteer Verbinden

Wanneer de verbinding tot stand is gebracht, ziet u velden die aanwezig zijn in de uitvoergegevens.

Selecteer Opslaan op de opdrachtbalk om uw configuratie op te slaan.

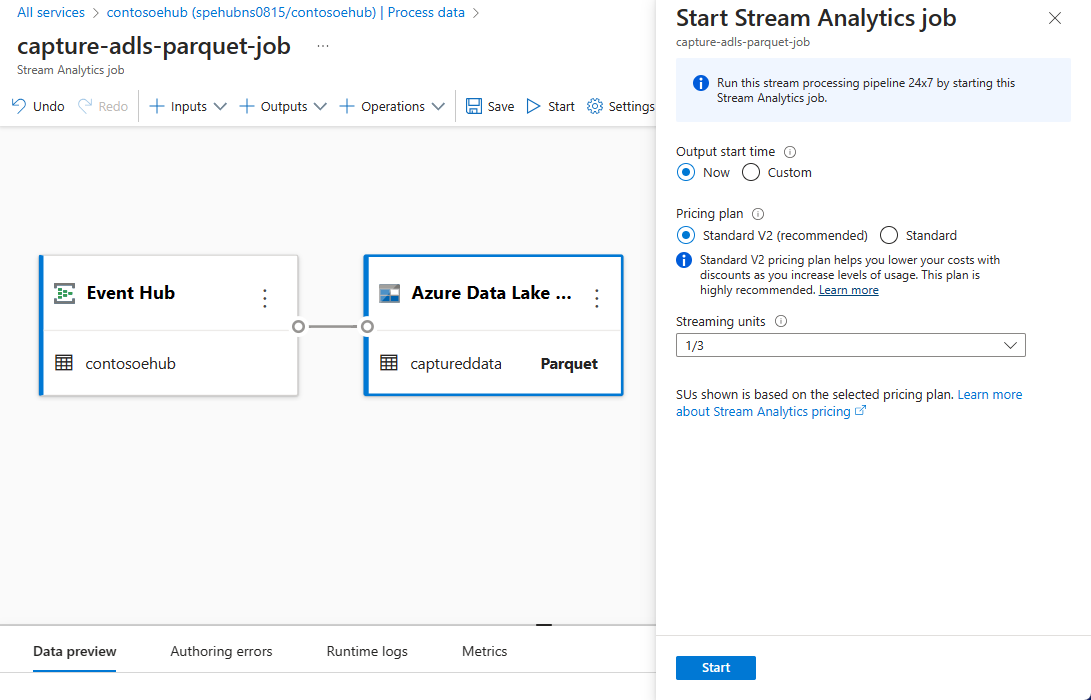

Selecteer Starten op de opdrachtbalk om de streamingstroom te starten om gegevens vast te leggen. Vervolgens in het venster Stream Analytics-taak starten:

Kies de begintijd van de uitvoer.

Selecteer het prijsplan.

Selecteer het aantal streaming-eenheden (SU) waarmee de taak wordt uitgevoerd. SU vertegenwoordigt de rekenresources die zijn toegewezen om een Stream Analytics-taak uit te voeren. Zie Streaming-eenheden in Azure Stream Analytics voor meer informatie.

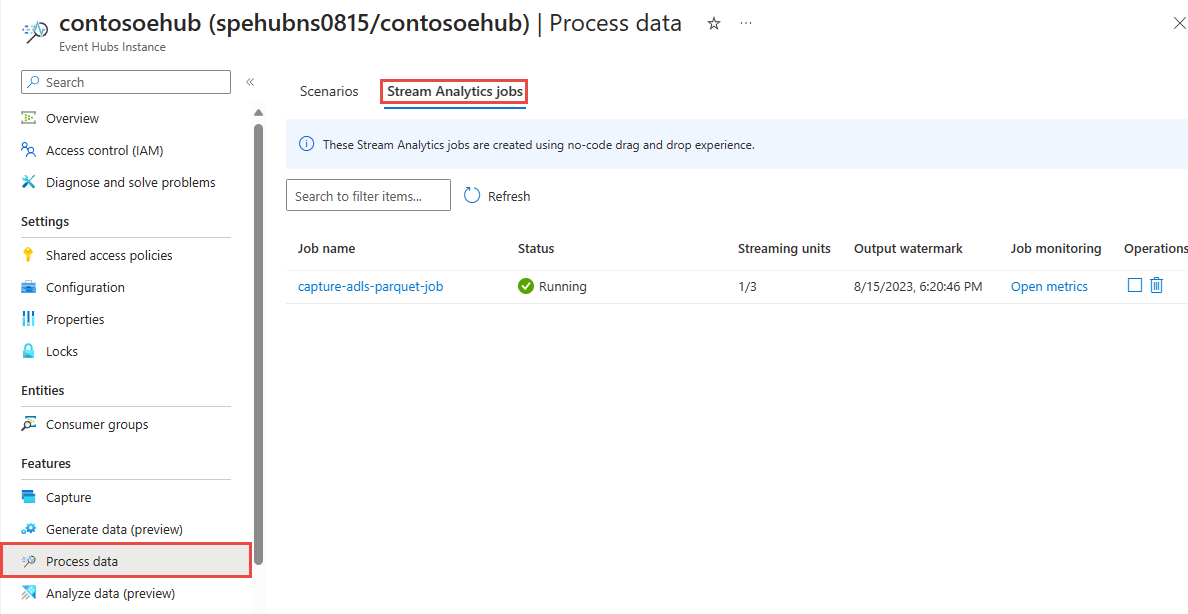

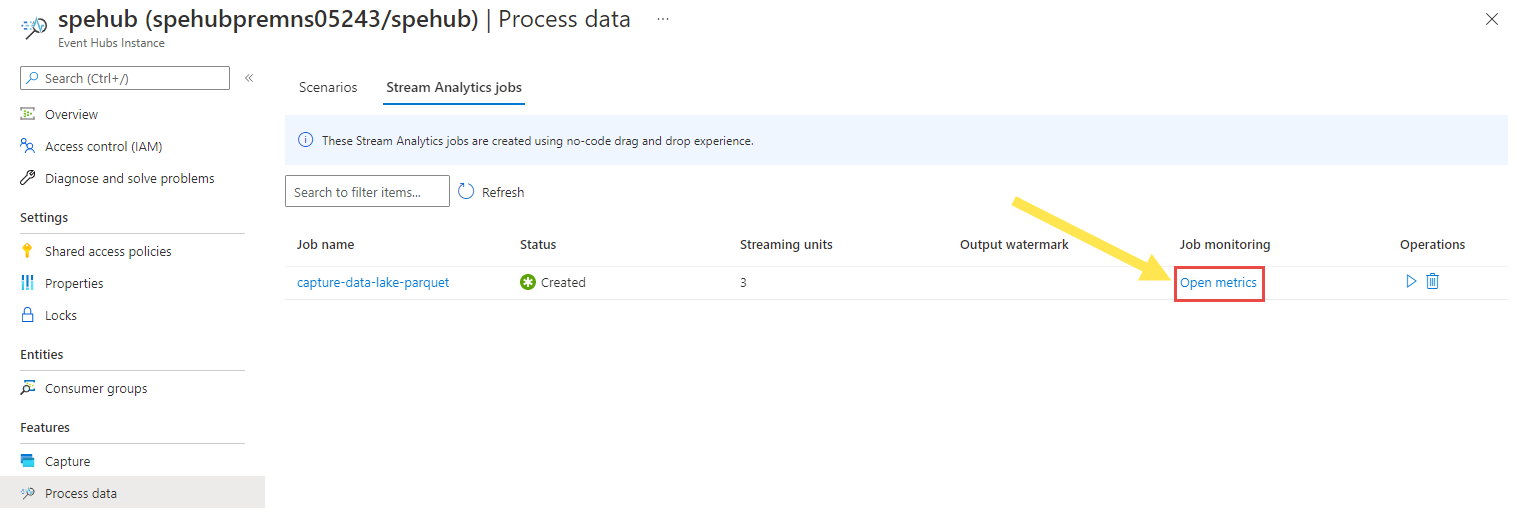

U ziet de Stream Analytics-taak op het tabblad Stream Analytics-taak van de pagina Procesgegevens voor uw Event Hub.

Uitvoer controleren

Selecteer Op de event Hubs-exemplaarpagina voor uw Event Hub gegevens genereren, selecteerT u Aandelengegevens voor de gegevensset en selecteert u Verzenden om enkele voorbeeldgegevens naar de Event Hub te verzenden.

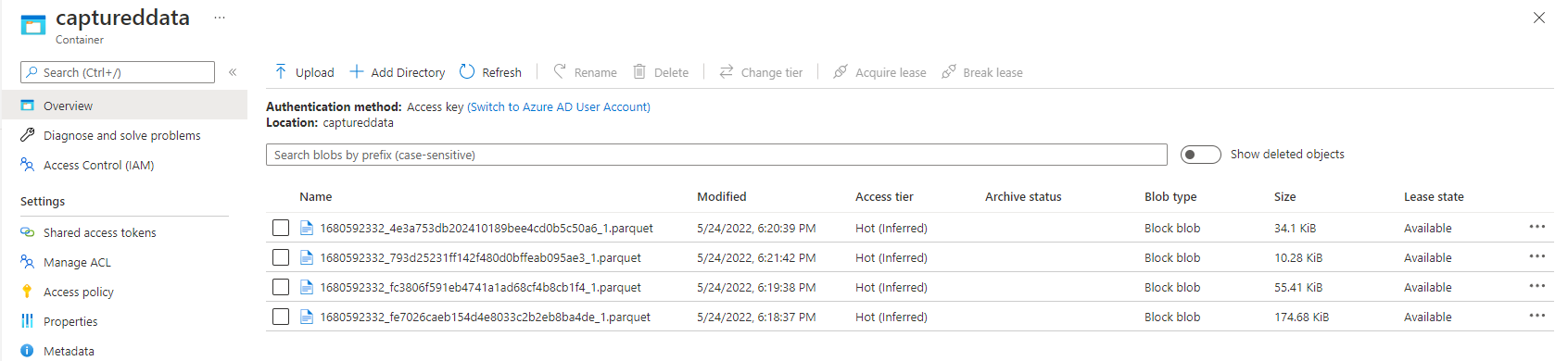

Controleer of de Parquet-bestanden zijn gegenereerd in de Azure Data Lake Storage-container.

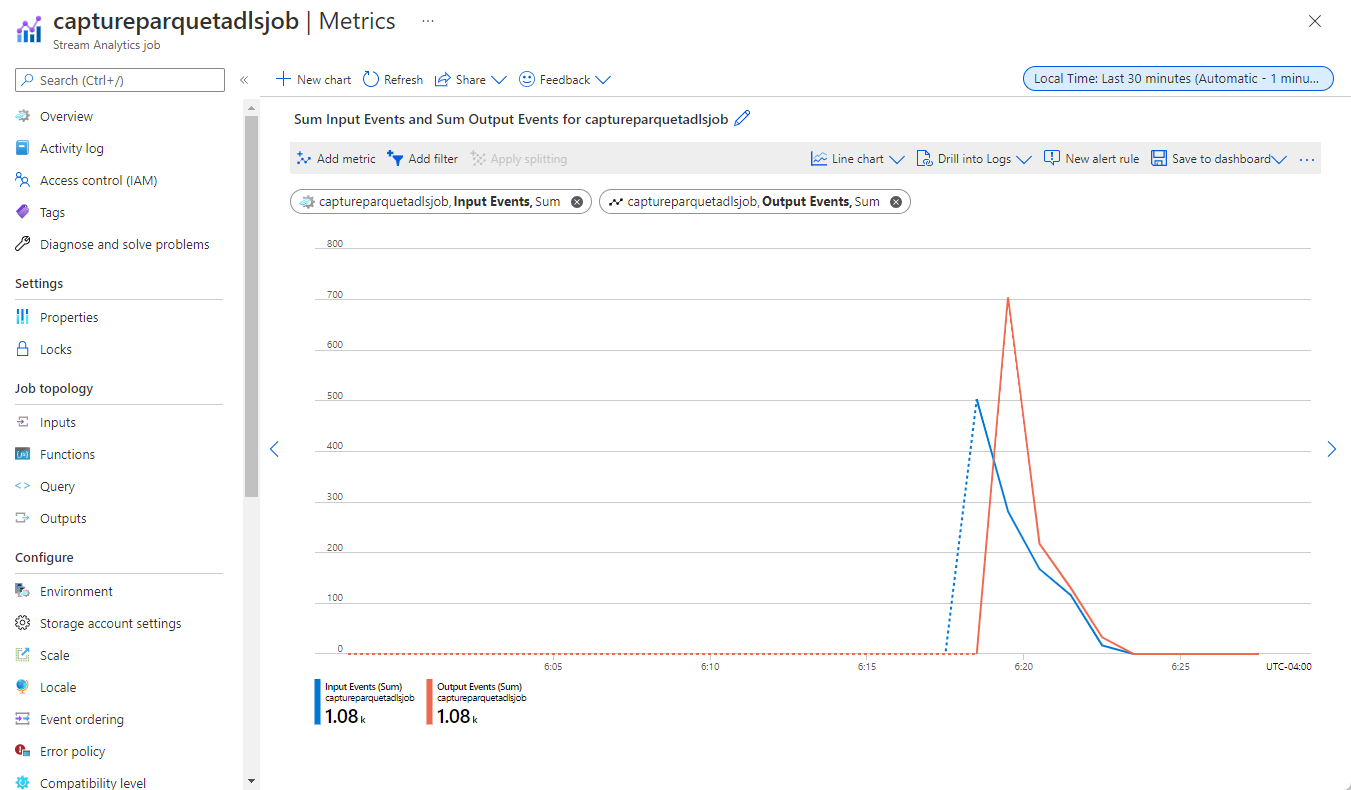

Selecteer Gegevens verwerken in het linkermenu. Ga naar het tabblad Stream Analytics-taken . Selecteer Metrische gegevens openen om deze te controleren.

Hier volgt een voorbeeldschermopname van metrische gegevens met invoer- en uitvoerevenementen.

Overwegingen bij het gebruik van de functie Geo-replicatie van Event Hubs

Azure Event Hubs heeft onlangs de functie Geo-replicatie gelanceerd in de openbare preview. Deze functie verschilt van de functie Geo Disaster Recovery van Azure Event Hubs.

Wanneer het failovertype geforceerd is en replicatieconsistentie Asynchroon is, garandeert de Stream Analytics-taak niet precies één keer uitvoer naar een Azure Event Hubs-uitvoer.

Azure Stream Analytics, als producent met een Event Hub een uitvoer, kan de watermerkvertraging van de taak observeren tijdens de failoverduur en tijdens het beperken door Event Hubs in het geval replicatievertraging tussen primaire en secundaire vertraging de maximaal geconfigureerde vertraging bereikt.

Azure Stream Analytics, als consument met Event Hubs als invoer, kan tijdens de failover de watermerkvertraging van de taak observeren en mogelijk gegevens overslaan of dubbele gegevens vinden nadat de failover is voltooid.

Vanwege deze opmerkingen raden we u aan om de Stream Analytics-taak opnieuw te starten met de juiste begintijd direct nadat de Failover van Event Hubs is voltooid. Omdat de functie Geo-replicatie van Event Hubs in openbare preview is, raden we u ook op dit moment niet aan dit patroon te gebruiken voor productie Stream Analytics-taken. Het huidige Gedrag van Stream Analytics wordt verbeterd voordat de functie Geo-replicatie van Event Hubs algemeen beschikbaar is en kan worden gebruikt in Stream Analytics-productietaken.

Volgende stappen

U weet nu hoe u de Stream Analytics zonder code-editor kunt gebruiken om een taak te maken waarmee Event Hubs-gegevens worden vastgelegd in Azure Data Lake Storage Gen2 in Parquet-indeling. Vervolgens vindt u meer informatie over Azure Stream Analytics en hoe u de taak bewaakt die u hebt gemaakt.