Hoge beschikbaarheid van SAP ASCS/SCS-exemplaar met meerdere SID's met Failoverclustering van Windows Server en gedeelde Azure-schijf

Ramen

Dit artikel is gericht op het verplaatsen van één SAP ASCS/SCS-installatie naar de configuratie van meerdere SAP-systeem-id's (SID's) door extra SAP ASCS/SCS-geclusterde exemplaren te installeren in een bestaand WSFC-cluster (Windows Server Failover Clustering) met een gedeelde Azure-schijf. Wanneer u dit proces voltooit, hebt u een SAP-cluster met meerdere SID's geconfigureerd.

Vereisten en beperkingen

U kunt Azure Premium SSD-schijven gebruiken als gedeelde Azure-schijven voor het SAP ASCS/SCS-exemplaar. De volgende beperkingen gelden momenteel:

- Azure Ultra Disk Storage-schijven en Azure Standard SSD-schijven worden niet ondersteund als gedeelde Azure-schijven voor SAP-workloads.

- Gedeelde Azure-schijven met Premium SSD-schijven worden ondersteund voor SAP-implementatie in beschikbaarheidssets en beschikbaarheidszones.

- Gedeelde Azure-schijven met Premium SSD-schijven worden geleverd met twee opslagopties:

- Lokaal redundante opslag (LRS) voor gedeelde Premium SSD-schijven (

skuNamewaarde vanPremium_LRS) wordt ondersteund met implementatie in beschikbaarheidssets. - Zone-redundante opslag (ZRS) voor gedeelde Premium SSD-schijven (

skuNamewaarde vanPremium_ZRS) wordt ondersteund met implementatie in beschikbaarheidszones.

- Lokaal redundante opslag (LRS) voor gedeelde Premium SSD-schijven (

- De waarde van de gedeelde Azure-schijf maxShares bepaalt hoeveel clusterknooppunten de gedeelde schijf kunnen gebruiken. Voor een SAP ASCS/SCS-exemplaar configureert u doorgaans twee knooppunten in WSFC. Vervolgens stelt u de waarde voor

maxSharesin op2. - Een Azure Proximity-plaatsingsgroep (PPG) is niet vereist voor gedeelde Azure-schijven. Voor SAP-implementatie met PPG's volgt u deze richtlijnen:

- Als u PPG's gebruikt voor een SAP-systeem dat in een regio is geïmplementeerd, moeten alle virtuele machines die een schijf delen deel uitmaken van dezelfde PPG.

- Als u PPG's gebruikt voor een SAP-systeem dat in meerdere zones is geïmplementeerd, zoals beschreven in nabijheidsplaatsingsgroepen met zonegebonden implementaties, kunt u opslag koppelen aan

Premium_ZRSvirtuele machines die een schijf delen.

Raadpleeg de sectie Beperkingen van de documentatie voor gedeelde Azure-schijven voor meer informatie.

Belangrijke overwegingen voor gedeelde Premium SSD-schijven

Houd rekening met deze belangrijke punten over gedeelde Schijven van Azure Premium SSD:

LRS voor gedeelde Premium SSD-schijven:

- SAP-implementatie met LRS voor Premium SSD-gedeelde schijven werkt met één gedeelde Azure-schijf op één opslagcluster. Als er een probleem is met het opslagcluster waarin de gedeelde Azure-schijf is geïmplementeerd, is dit van invloed op uw SAP ASCS/SCS-exemplaar.

ZRS voor gedeelde Premium SSD-schijven:

- Schrijflatentie voor ZRS is hoger dan die van LRS, omdat gegevens in meerdere richtingen worden gekopieerd.

- De afstand tussen beschikbaarheidszones in verschillende regio's varieert en zorgt er dus voor ZRS-schijflatentie in beschikbaarheidszones. Benchmark uw schijven om de latentie van ZRS-schijven in uw regio te identificeren.

- ZRS voor Gedeelde Schijven met Premium SSD repliceert synchroon gegevens over drie beschikbaarheidszones in de regio. Als er een probleem is in een van de opslagclusters, blijft uw SAP ASCS/SCS-exemplaar actief omdat de opslagfailover transparant is voor de toepassingslaag.

- Raadpleeg de sectie Beperkingen van de documentatie over ZRS voor beheerde schijven voor meer informatie.

Belangrijk

De installatie moet aan de volgende voorwaarden voldoen:

- De SID voor elk databasebeheersysteem (DBMS) moet een eigen toegewezen WSFC-cluster hebben.

- SAP-toepassingsservers die tot één SAP SID behoren, moeten hun eigen toegewezen virtuele machines (VM's) hebben.

- Een combinatie van Enqueue Replication Server 1 (ERS1) en Enqueue Replication Server 2 (ERS2) in hetzelfde cluster wordt niet ondersteund.

Ondersteunde besturingssysteemversies

Windows Server 2016, 2019 en hoger worden ondersteund. Gebruik de nieuwste datacenterinstallatiekopieën.

We raden u ten zeerste aan om ten minste Windows Server 2019 Datacenter te gebruiken om deze redenen:

- WSFC in Windows Server 2019 is op de hoogte van Azure.

- Windows Server 2019 Datacenter omvat integratie en bewustzijn van azure-hostonderhoud en verbeterde ervaring door te controleren op geplande Azure-gebeurtenissen.

- U kunt gedistribueerde netwerknamen gebruiken. (Dit is de standaardoptie.) U hoeft geen toegewezen IP-adres te hebben voor de naam van het clusternetwerk. U hoeft ook geen IP-adres te configureren op een interne Load Balancer van Azure.

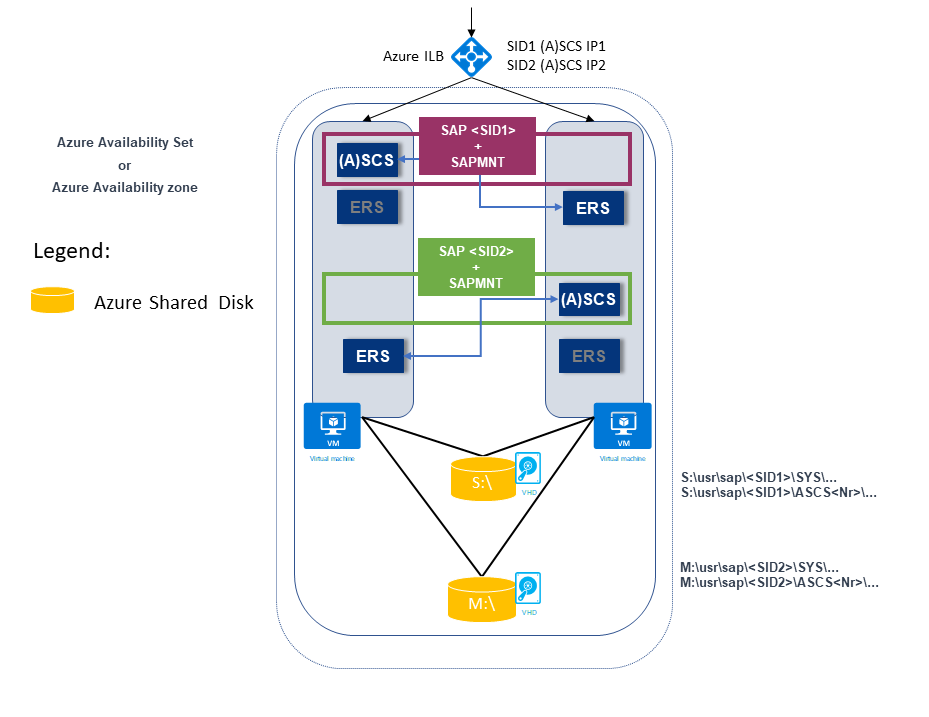

Architectuur

Zowel ERS1 als ERS2 worden ondersteund in een configuratie met meerdere SID's. Een combinatie van ERS1 en ERS2 wordt niet ondersteund in hetzelfde cluster.

In het volgende voorbeeld ziet u twee SAP-SID's. Beide hebben een ERS1-architectuur waarbij:

SAP SID1 wordt geïmplementeerd op een gedeelde schijf met ERS1. Het ERS-exemplaar wordt geïnstalleerd op een lokale host en op een lokaal station.

SAP SID1 heeft een eigen virtueel IP-adres (SID1 (A)SCS IP1, dat is geconfigureerd op de interne Load Balancer van Azure.

SAP SID2 wordt geïmplementeerd op een gedeelde schijf met ERS1. Het ERS-exemplaar wordt geïnstalleerd op een lokale host en op een lokaal station.

SAP SID2 heeft een eigen virtueel IP-adres (SID2 (A)SCS IP2, dat is geconfigureerd op de interne Load Balancer van Azure.

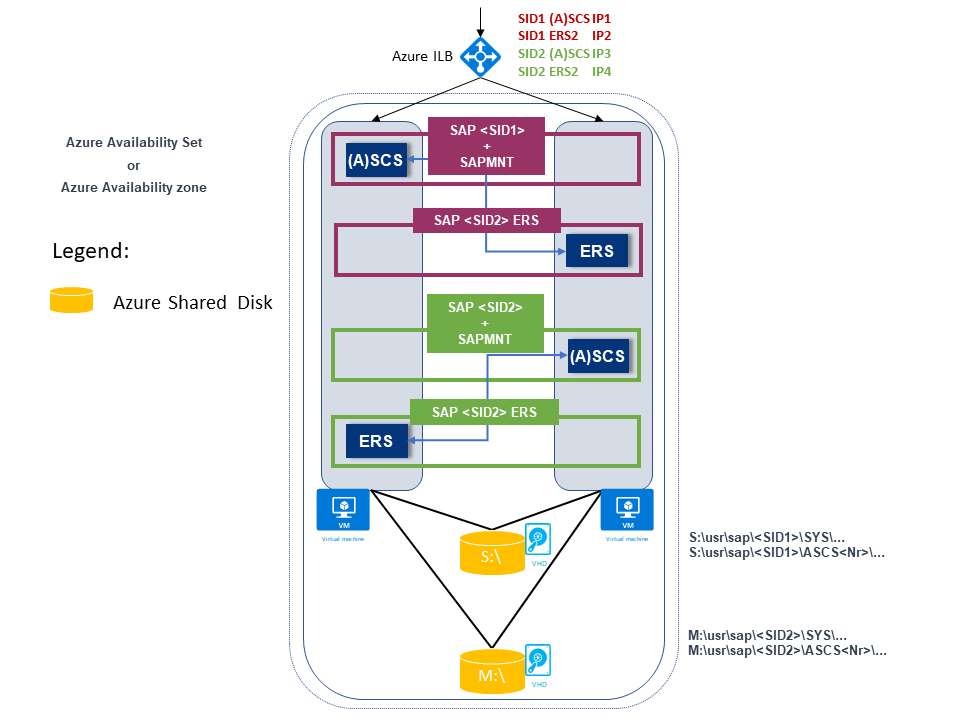

In het volgende voorbeeld ziet u ook twee SAP-SID's. Beide hebben een ERS2-architectuur waarbij:

SAP SID1 wordt geïmplementeerd op een shardschijf met ERS2, die is geclusterd en wordt geïmplementeerd op een lokaal station.

SAP SID1 heeft een eigen virtueel IP-adres (SID1 (A)SCS IP1, dat is geconfigureerd op de interne Load Balancer van Azure.

SAP ERS2 heeft een eigen virtueel IP-adres (SID1 ERS2 IP2), dat is geconfigureerd op de interne Load Balancer van Azure.

SAP SID2 wordt geïmplementeerd op een shardschijf met ERS2, die is geclusterd en wordt geïmplementeerd op een lokaal station.

SAP SID2 heeft een eigen virtueel IP-adres (SID2 (A)SCS IP3, dat is geconfigureerd op de interne Load Balancer van Azure.

SAP ERS2 heeft een eigen virtueel IP-adres (SID2 ERS2 IP4), dat is geconfigureerd op de interne Load Balancer van Azure.

Er zijn in totaal vier virtuele IP-adressen:

- SID1 (A)SCS IP1

- SID2 ERS2 IP2

- SID2 (A)SCS IP3

- SID2 ERS2 IP4

Infrastructuurvoorbereiding

U installeert een nieuw SAP SID PR2-exemplaar, naast het bestaande geclusterde SAP PR1 ASCS/SCS-exemplaar.

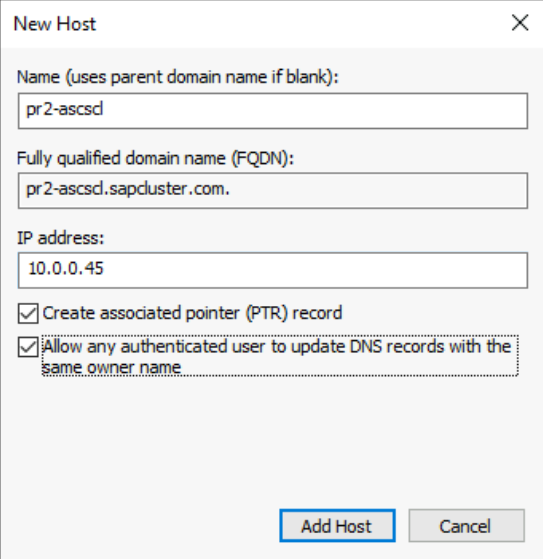

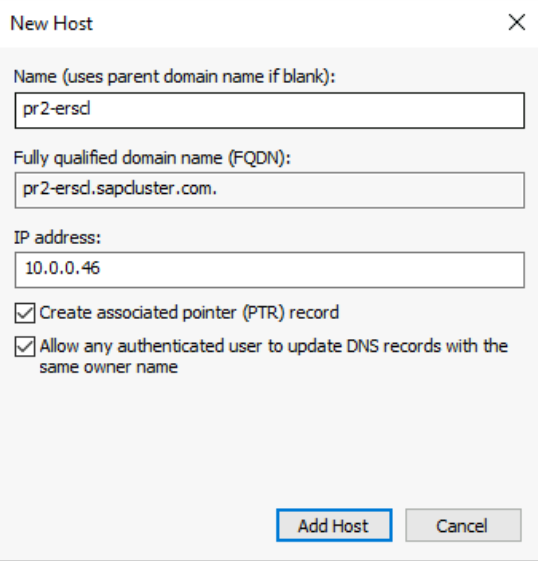

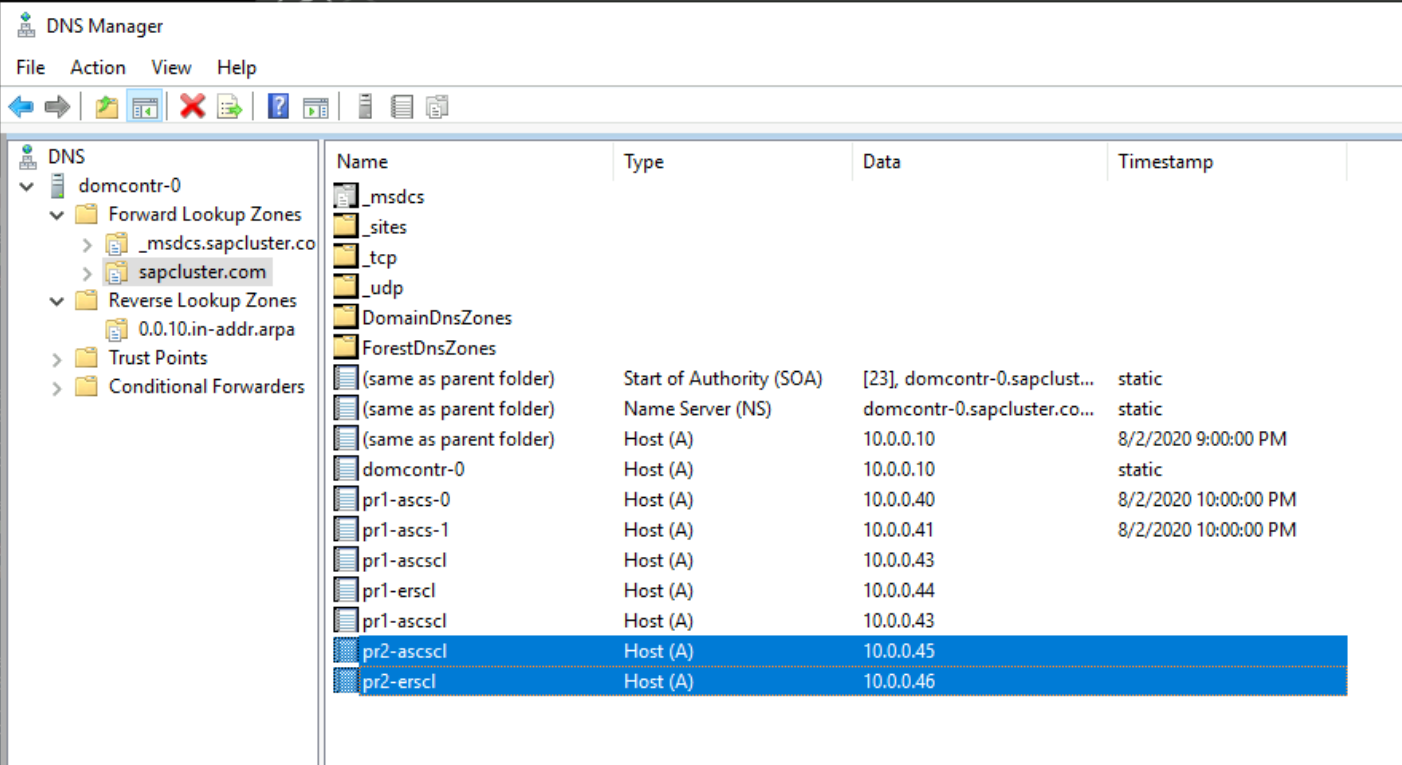

Hostnamen en IP-adressen

Op basis van uw implementatietype moeten de hostnamen en de IP-adressen van het scenario lijken op de volgende voorbeelden.

Hier volgen de details voor een SAP-implementatie in een Azure-beschikbaarheidsset:

| Hostnaamrol | Hostnaam | Statisch IP-adres | Beschikbaarheidsset | Schijfwaarde SkuName |

|---|---|---|---|---|

| Eerste clusterknooppunt ASCS/SCS-cluster | pr1-ascs-10 | 10.0.0.4 | pr1-ascs-avset | Premium_LRS |

| Tweede clusterknooppunt ASCS/SCS-cluster | pr1-ascs-11 | 10.0.0.5 | pr1-ascs-avset | |

| Naam van clusternetwerk | pr1clust | 10.0.0.42 (alleen voor een Windows Server 2016-cluster) | Niet van toepassing | |

| SID1 ASCS-clusternetwerknaam | pr1-ascscl | 10.0.0.43 | Niet van toepassing | |

| SID1 ERS-clusternetwerknaam (alleen voor ERS2) | pr1-erscl | 10.0.0.44 | Niet van toepassing | |

| SID2 ASCS-clusternetwerknaam | pr2-ascscl | 10.0.0.45 | Niet van toepassing | |

| SID2 ERS-clusternetwerknaam (alleen voor ERS2) | pr1-erscl | 10.0.0.46 | Niet van toepassing |

Hier volgen de details voor een SAP-implementatie in Azure-beschikbaarheidszones:

| Hostnaamrol | Hostnaam | Statisch IP-adres | Availability zone | Schijfwaarde SkuName |

|---|---|---|---|---|

| Eerste clusterknooppunt ASCS/SCS-cluster | pr1-ascs-10 | 10.0.0.4 | AZ01 | Premium_ZRS |

| Tweede clusterknooppunt ASCS/SCS-cluster | pr1-ascs-11 | 10.0.0.5 | AZ02 | |

| Naam van clusternetwerk | pr1clust | 10.0.0.42 (alleen voor een Windows Server 2016-cluster) | Niet van toepassing | |

| SID1 ASCS-clusternetwerknaam | pr1-ascscl | 10.0.0.43 | Niet van toepassing | |

| SID2 ERS-clusternetwerknaam (alleen voor ERS2) | pr1-erscl | 10.0.0.44 | Niet van toepassing | |

| SID2 ASCS-clusternetwerknaam | pr2-ascscl | 10.0.0.45 | Niet van toepassing | |

| SID2 ERS-clusternetwerknaam (alleen voor ERS2) | pr1-erscl | 10.0.0.46 | Niet van toepassing |

De stappen in dit artikel blijven hetzelfde voor beide implementatietypen. Maar als uw cluster wordt uitgevoerd in een beschikbaarheidsset, moet u LRS implementeren voor gedeelde Schijven van Azure Premium SSD (Premium_LRS). Als uw cluster wordt uitgevoerd in een beschikbaarheidszone, moet u ZRS implementeren voor gedeelde Schijven van Azure Premium SSD (Premium_ZRS).

Een interne Load Balancer van Azure maken

Voor configuratie met meerdere sid's van SAP SID, PR2, kunt u dezelfde interne load balancer gebruiken die u hebt gemaakt voor SAP SID, PR1-systeem. Voor de ENSA1-architectuur in Windows hebt u slechts één virtueel IP-adres nodig voor SAP ASCS/SCS. Aan de andere kant vereist de ENSA2-architectuur twee virtuele IP-adressen: één voor SAP ASCS en een andere voor ERS2.

Configureer aanvullende front-end-IP- en taakverdelingsregel voor SAP SID, PR2-systeem op de bestaande load balancer met behulp van de volgende richtlijnen. In deze sectie wordt ervan uitgegaan dat de configuratie van de standaard interne load balancer voor SAP SID, PR1 al aanwezig is, zoals beschreven in load balancer maken.

- Open dezelfde standaard interne load balancer die u hebt gemaakt voor SAP SID, PR1-systeem.

- Front-end-IP-configuratie: front-end-IP maken (bijvoorbeeld: 10.0.0.45).

- Back-endpool: back-endpool is hetzelfde als die van het SAP SID PR1-systeem.

- Regels voor inkomend verkeer: taakverdelingsregel maken.

- Front-end-IP-adres: front-end-IP selecteren

- Back-endpool: back-endpool selecteren

- Controleer poorten met hoge beschikbaarheid

- Protocol: TCP

- Statustest: Statustest maken met de onderstaande details

- Protocol: TCP

- Poort: [bijvoorbeeld: 620<Instance-no.> voor SAP SID, PR2 ASCS]

- Interval: 5

- Testdrempel: 2

- Time-out voor inactiviteit (minuten): 30

- Schakel Zwevend IP-adres in

- Van toepassing op alleen ENSA2-architectuur: Maak extra front-end-IP (10.0.0.44), taakverdelingsregel (gebruik 621<Exemplaar-nee.> voor DE STATUStestpoort VOOR ERS2), zoals beschreven in punt 1 en 3.

Notitie

Het eigenschapsnummer van de statustestconfiguratieofOfProbes, ook wel 'Drempelwaarde beschadigd' genoemd in de portal, wordt niet gerespecteerd. Als u dus het aantal geslaagde of mislukte opeenvolgende tests wilt beheren, stelt u de eigenschap probeThreshold in op 2. Het is momenteel niet mogelijk om deze eigenschap in te stellen met behulp van Azure Portal, dus gebruik de Azure CLI of PowerShell-opdracht .

Notitie

Wanneer VM's zonder openbare IP-adressen worden geplaatst in de back-endpool van een interne (geen openbaar IP-adres) Standard Azure Load Balancer, is er geen uitgaande internetverbinding, tenzij u aanvullende configuratie uitvoert om routering naar openbare eindpunten toe te staan. Zie Openbare eindpuntconnectiviteit voor virtuele machines met behulp van Azure Standard Load Balancer in scenario's met hoge beschikbaarheid van SAP voor meer informatie over het bereiken van uitgaande connectiviteit.

Een tweede gedeelde Azure-schijf maken en koppelen

Voer deze opdracht uit op een van de clusterknooppunten. Pas de waarden voor details aan, zoals uw resourcegroep, Azure-regio en SAP SID.

$ResourceGroupName = "MyResourceGroup"

$location = "MyRegion"

$SAPSID = "PR2"

$DiskSizeInGB = 512

$DiskName = "$($SAPSID)ASCSSharedDisk"

$NumberOfWindowsClusterNodes = 2

# For SAP deployment in an availability set, use this storage SkuName value

$SkuName = "Premium_LRS"

# For SAP deployment in an availability zone, use this storage SkuName value

$SkuName = "Premium_ZRS"

$diskConfig = New-AzDiskConfig -Location $location -SkuName $SkuName -CreateOption Empty -DiskSizeGB $DiskSizeInGB -MaxSharesCount $NumberOfWindowsClusterNodes

$dataDisk = New-AzDisk -ResourceGroupName $ResourceGroupName -DiskName $DiskName -Disk $diskConfig

##################################

## Attach the disk to cluster VMs

##################################

# ASCS cluster VM1

$ASCSClusterVM1 = "pr1-ascs-10"

# ASCS cluster VM2

$ASCSClusterVM2 = "pr1-ascs-11"

# Next free LUN

$LUNNumber = 1

# Add the Azure shared disk to Cluster Node 1

$vm = Get-AzVM -ResourceGroupName $ResourceGroupName -Name $ASCSClusterVM1

$vm = Add-AzVMDataDisk -VM $vm -Name $DiskName -CreateOption Attach -ManagedDiskId $dataDisk.Id -Lun $LUNNumber

Update-AzVm -VM $vm -ResourceGroupName $ResourceGroupName -Verbose

# Add the Azure shared disk to Cluster Node 2

$vm = Get-AzVM -ResourceGroupName $ResourceGroupName -Name $ASCSClusterVM2

$vm = Add-AzVMDataDisk -VM $vm -Name $DiskName -CreateOption Attach -ManagedDiskId $dataDisk.Id -Lun $LUNNumber

Update-AzVm -VM $vm -ResourceGroupName $ResourceGroupName -Verbose

De gedeelde schijf formatteren met behulp van PowerShell

Haal het schijfnummer op. Voer deze PowerShell-opdrachten uit op een van de clusterknooppunten:

Get-Disk | Where-Object PartitionStyle -Eq "RAW" | Format-Table -AutoSize # Example output # Number Friendly Name Serial Number HealthStatus OperationalStatus Total Size Partition Style # ------ ------------- ------------- ------------ ----------------- ---------- --------------- # 3 Msft Virtual Disk Healthy Online 512 GB RAWMaak de schijf op. In dit voorbeeld is het schijfnummer 3:

# Format SAP ASCS disk number 3, with drive letter S $SAPSID = "PR2" $DiskNumber = 3 $DriveLetter = "S" $DiskLabel = "$SAPSID" + "SAP" Get-Disk -Number $DiskNumber | Where-Object PartitionStyle -Eq "RAW" | Initialize-Disk -PartitionStyle GPT -PassThru | New-Partition -DriveLetter $DriveLetter -UseMaximumSize | Format-Volume -FileSystem ReFS -NewFileSystemLabel $DiskLabel -Force -Verbose # Example output # DriveLetter FileSystemLabel FileSystem DriveType HealthStatus OperationalStatus SizeRemaining Size # ----------- --------------- ---------- --------- ------------ ----------------- ------------- ---- # S PR2SAP ReFS Fixed Healthy OK 504.98 GB 511.81 GBControleer of de schijf nu zichtbaar is als clusterschijf:

# List all disks Get-ClusterAvailableDisk -All # Example output # Cluster : pr1clust # Id : c469b5ad-d089-4d8f-ae4c-d834cbbde1a2 # Name : Cluster Disk 2 # Number : 3 # Size : 549755813888 # Partitions : {\\?\GLOBALROOT\Device\Harddisk3\Partition2\}Registreer de schijf in het cluster:

# Add the disk to the cluster Get-ClusterAvailableDisk -All | Add-ClusterDisk # Example output # Name State OwnerGroup ResourceType # ---- ----- ---------- ------------ # Cluster Disk 2 Online Available Storage Physical Disk

Een virtuele hostnaam maken voor het geclusterde SAP ASCS/SCS-exemplaar

Maak een DNS-vermelding voor de naam van de virtuele host voor het nieuwe SAP ASCS/SCS-exemplaar in Windows DNS-beheer.

Het IP-adres dat u hebt toegewezen aan de naam van de virtuele host in DNS, moet hetzelfde zijn als het IP-adres dat u hebt toegewezen in Azure Load Balancer.

Als u een geclusterd exemplaar van SAP ERS2 gebruikt, moet u een virtuele hostnaam voor ERS2 reserveren in DNS.

Het IP-adres dat u hebt toegewezen aan de naam van de virtuele host voor ERS2 in DNS, moet hetzelfde zijn als het IP-adres dat u hebt toegewezen in Azure Load Balancer.

Als u het IP-adres wilt definiëren dat is toegewezen aan de naam van de virtuele host, selecteert u DNS Manager-domein>.

SAP-installatie

Het eerste SAP-clusterknooppunt installeren

Volg de installatieprocedure die door SAP is beschreven. Zorg ervoor dat u First Cluster Node selecteert als de optie voor het starten van de installatie. Selecteer Gedeelde clusterschijf als de configuratieoptie. Kies de zojuist gemaakte gedeelde schijf.

Het SAP-profiel van het ASCS/SCS-exemplaar wijzigen

Als u ERS1 uitvoert, voegt u de SAP-profielparameter enque/encni/set_so_keepalivetoe. De profielparameter voorkomt dat verbindingen tussen SAP-werkprocessen en de wachtrijserver worden gesloten wanneer ze te lang inactief zijn. De SAP-parameter is niet vereist voor ERS2.

Voeg deze profielparameter toe aan het SAP ASCS/SCS-exemplaarprofiel als u ERS1 gebruikt:

enque/encni/set_so_keepalive = TRUEVoor zowel ERS1 als ERS2 moet u ervoor zorgen dat de parameters van het

keepalivebesturingssysteem zijn ingesteld zoals beschreven in SAP-opmerking 1410736.Als u de wijzigingen wilt toepassen op de parameter SAP-profiel, start u het SAP ASCS/SCS-exemplaar opnieuw.

Een testpoort configureren op de clusterresource

Gebruik de testfunctionaliteit van de interne load balancer om de volledige clusterconfiguratie te laten werken met Azure Load Balancer. De interne Load Balancer van Azure distribueert meestal de binnenkomende werkbelasting gelijkmatig tussen deelnemende virtuele machines.

Deze aanpak werkt echter niet in sommige clusterconfiguraties omdat er slechts één exemplaar actief is. Het andere exemplaar is passief en kan geen enkele workload accepteren. Een testfunctionaliteit helpt wanneer de interne Load Balancer van Azure detecteert welk exemplaar actief is en alleen gericht is op het actieve exemplaar.

Belangrijk

In deze voorbeeldconfiguratie is de testpoort ingesteld op 620nr. Voor SAP ASCS met exemplaarnummer 02 is dit 62002.

U moet de configuratie aanpassen zodat deze overeenkomt met uw SAP-exemplaarnummers en uw SAP-SID.

Als u een testpoort wilt toevoegen, voert u deze PowerShell-module uit op een van de cluster-VM's:

Als u SAP ASC/SCS gebruikt met exemplaarnummer 02:

Set-AzureLoadBalancerHealthCheckProbePortOnSAPClusterIPResource -SAPSID PR2 -ProbePort 62002Als u ERS2 met exemplaarnummer 12 gebruikt, configureert u een testpoort. U hoeft geen testpoort voor ERS1 te configureren. ERS2 met exemplaarnummer 12 is geclusterd, terwijl ERS1 niet is geclusterd.

Set-AzureLoadBalancerHealthCheckProbePortOnSAPClusterIPResource -SAPSID PR2 -ProbePort 62012 -IsSAPERSClusteredInstance $True

De code voor de functie Set-AzureLoadBalancerHealthCheckProbePortOnSAPClusterIPResource ziet er als volgt uit:

function Set-AzureLoadBalancerHealthCheckProbePortOnSAPClusterIPResource {

<#

.SYNOPSIS

Set-AzureLoadBalancerHealthProbePortOnSAPClusterIPResource will set a new Azure Load Balancer health probe port on the SAP $SAPSID IP cluster resource.

.DESCRIPTION

Set-AzureLoadBalancerHealthProbePortOnSAPClusterIPResource will set a new Azure Load Balancer health probe port on the SAP $SAPSID IP cluster resource.

It will also restart the SAP cluster group (default behavior), to activate the changes.

You need to run it on one of the SAP ASCS/SCS Windows cluster nodes.

The expectation is that the SAP group is installed with the official SWPM installation tool, which will set the default expected naming convention for:

- SAP cluster group: SAP $SAPSID

- SAP cluster IP address resource: SAP $SAPSID IP

.PARAMETER SAPSID

SAP SID - three characters, starting with a letter.

.PARAMETER ProbePort

Azure Load Balancer health check probe port.

.PARAMETER RestartSAPClusterGroup

Optional parameter. Default value is $True, so the SAP cluster group will be restarted to activate the changes.

.PARAMETER IsSAPERSClusteredInstance

Optional parameter. Default value is $False.

If it's set to $True, then handle the clustered new SAP ERS2 instance.

.EXAMPLE

# Set the probe port to 62000 on SAP cluster resource SAP AB1 IP, and restart the SAP cluster group SAP AB1 to activate the changes.

Set-AzureLoadBalancerHealthCheckProbePortOnSAPClusterIPResource -SAPSID AB1 -ProbePort 62000

.EXAMPLE

# Set the probe port to 62000 on SAP cluster resource SAP AB1 IP. SAP cluster group SAP AB1 is not restarted, so the changes are not active.

# To activate the changes, you need to manually restart the SAP AB1 cluster group.

Set-AzureLoadBalancerHealthCheckProbePortOnSAPClusterIPResource -SAPSID AB1 -ProbePort 62000 -RestartSAPClusterGroup $False

.EXAMPLE

# Set the probe port to 62001 on SAP cluster resource SAP AB1 ERS IP. SAP cluster group SAP AB1 ERS is restarted to activate the changes.

Set-AzureLoadBalancerHealthCheckProbePortOnSAPClusterIPResource -SAPSID AB1 -ProbePort 62000 -IsSAPERSClusteredInstance $True

#>

[CmdletBinding()]

param(

[Parameter(Mandatory=$True)]

[ValidateNotNullOrEmpty()]

[ValidateLength(3,3)]

[string]$SAPSID,

[Parameter(Mandatory=$True)]

[ValidateNotNullOrEmpty()]

[int] $ProbePort,

[Parameter(Mandatory=$False)]

[bool] $RestartSAPClusterGroup = $True,

[Parameter(Mandatory=$False)]

[bool] $IsSAPERSClusteredInstance = $False

)

BEGIN{}

PROCESS{

try{

if($IsSAPERSClusteredInstance){

#Handle clustered SAP ERS instance

$SAPClusterRoleName = "SAP $SAPSID ERS"

$SAPIPresourceName = "SAP $SAPSID ERS IP"

}else{

#Handle clustered SAP ASCS/SCS instance

$SAPClusterRoleName = "SAP $SAPSID"

$SAPIPresourceName = "SAP $SAPSID IP"

}

$SAPIPResourceClusterParameters = Get-ClusterResource $SAPIPresourceName | Get-ClusterParameter

$IPAddress = ($SAPIPResourceClusterParameters | Where-Object {$_.Name -eq "Address" }).Value

$NetworkName = ($SAPIPResourceClusterParameters | Where-Object {$_.Name -eq "Network" }).Value

$SubnetMask = ($SAPIPResourceClusterParameters | Where-Object {$_.Name -eq "SubnetMask" }).Value

$OverrideAddressMatch = ($SAPIPResourceClusterParameters | Where-Object {$_.Name -eq "OverrideAddressMatch" }).Value

$EnableDhcp = ($SAPIPResourceClusterParameters | Where-Object {$_.Name -eq "EnableDhcp" }).Value

$OldProbePort = ($SAPIPResourceClusterParameters | Where-Object {$_.Name -eq "ProbePort" }).Value

$var = Get-ClusterResource | Where-Object { $_.name -eq $SAPIPresourceName }

#Write-Host "Current configuration parameters for SAP IP cluster resource '$SAPIPresourceName' are:" -ForegroundColor Cyan

Write-Output "Current configuration parameters for SAP IP cluster resource '$SAPIPresourceName' are:"

Get-ClusterResource -Name $SAPIPresourceName | Get-ClusterParameter

Write-Output " "

Write-Output "Current probe port property of the SAP cluster resource '$SAPIPresourceName' is '$OldProbePort'."

Write-Output " "

Write-Output "Setting the new probe port property of the SAP cluster resource '$SAPIPresourceName' to '$ProbePort' ..."

Write-Output " "

$var | Set-ClusterParameter -Multiple @{"Address"=$IPAddress;"ProbePort"=$ProbePort;"Subnetmask"=$SubnetMask;"Network"=$NetworkName;"OverrideAddressMatch"=$OverrideAddressMatch;"EnableDhcp"=$EnableDhcp}

Write-Output " "

#$ActivateChanges = Read-Host "Do you want to take restart SAP cluster role '$SAPClusterRoleName', to activate the changes (yes/no)?"

if($RestartSAPClusterGroup){

Write-Output ""

Write-Output "Activating changes..."

Write-Output " "

Write-Output "Taking SAP cluster IP resource '$SAPIPresourceName' offline ..."

Stop-ClusterResource -Name $SAPIPresourceName

sleep 5

Write-Output "Starting SAP cluster role '$SAPClusterRoleName' ..."

Start-ClusterGroup -Name $SAPClusterRoleName

Write-Output "New ProbePort parameter is active."

Write-Output " "

Write-Output "New configuration parameters for SAP IP cluster resource '$SAPIPresourceName':"

Write-Output " "

Get-ClusterResource -Name $SAPIPresourceName | Get-ClusterParameter

}else

{

Write-Output "SAP cluster role '$SAPClusterRoleName' is not restarted, therefore changes are not activated."

}

}

catch{

Write-Error $_.Exception.Message

}

}

END {}

}

Doorgaan met de SAP-installatie

Installeer het database-exemplaar door het proces te volgen dat wordt beschreven in de SAP-installatiehandleiding.

Installeer SAP op het tweede clusterknooppunt door de stappen te volgen die worden beschreven in de SAP-installatiehandleiding.

Installeer het SAP Primary Application Server-exemplaar (PAS) op de virtuele machine die is aangewezen om het PAS te hosten.

Volg het proces dat wordt beschreven in de SAP-installatiehandleiding. Er zijn geen afhankelijkheden van Azure.

Installeer extra SAP-toepassingsservers op de virtuele machines die zijn aangewezen voor het hosten van SAP-toepassingsserverexemplaren.

Volg het proces dat wordt beschreven in de SAP-installatiehandleiding. Er zijn geen afhankelijkheden van Azure.

FAILOVER van SAP ASCS/SCS-exemplaren testen

Bij de beschreven failovertests wordt ervan uitgegaan dat SAP ASCS actief is op knooppunt A.

Controleer of het SAP-systeem een failover van knooppunt A naar knooppunt B kan uitvoeren. In dit voorbeeld is de test voor SAP SID PR2.

Zorg ervoor dat elke SAP-SID kan worden verplaatst naar het andere clusterknooppunt. Kies een van deze opties om een failover van de SAP <SID-clustergroep> te starten van clusterknooppunt A naar clusterknooppunt B:

- Failoverclusterbeheer

- PowerShell-opdrachten voor failoverclusters

$SAPSID = "PR2" # SAP <SID> $SAPClusterGroup = "SAP $SAPSID" Move-ClusterGroup -Name $SAPClusterGroupStart het clusterknooppunt A opnieuw op binnen het Windows-gastbesturingssysteem. Met deze stap wordt een automatische failover van de SAP <SID-clustergroep> gestart van knooppunt A naar knooppunt B.

Start clusterknooppunt A opnieuw vanuit Azure Portal. Met deze stap wordt een automatische failover van de SAP <SID-clustergroep> gestart van knooppunt A naar knooppunt B.

Start clusterknooppunt A opnieuw op met behulp van Azure PowerShell. Met deze stap wordt een automatische failover van de SAP <SID-clustergroep> gestart van knooppunt A naar knooppunt B.