Classificatie met AutoML

Gebruik AutoML om automatisch het beste classificatie-algoritme en de hyperparameterconfiguratie te vinden om het label of de categorie van een bepaalde invoer te voorspellen.

classificatieexperiment instellen met de gebruikersinterface

U kunt een classificatieprobleem instellen met behulp van de AutoML-gebruikersinterface met de volgende stappen:

Selecteer Experimenten in de zijbalk.

Selecteer Training starten in de classificatiekaart.

De pagina AutoML-experiment configureren wordt weergegeven. Op deze pagina configureert u het AutoML-proces, waarbij u de gegevensset, het probleemtype, de doelkolom of de labelkolom opgeeft om te voorspellen, metrische gegevens te gebruiken om de uitvoeringen van het experiment te evalueren en te beoordelen en te stoppen.

Selecteer in het veld Compute een cluster met Databricks Runtime ML.

Selecteer Bladeren onder Gegevensset.

Navigeer naar de tabel die u wilt gebruiken en klik op Selecteren. Het tabelschema wordt weergegeven.

- In Databricks Runtime 10.3 ML en hoger kunt u opgeven welke kolommen AutoML moet gebruiken voor training. U kunt de geselecteerde kolom niet verwijderen als het voorspellingsdoel of de tijdkolom om de gegevens te splitsen.

- In Databricks Runtime 10.4 LTS ML en hoger kunt u opgeven hoe null-waarden worden imputed door in de vervolgkeuzelijst Impute te selecteren. Standaard selecteert AutoML een imputatiemethode op basis van het kolomtype en de inhoud.

Notitie

Als u een niet-standaardimplicatiemethode opgeeft, voert AutoML geen semantische typedetectie uit.

Klik in het veld Voorspellingsdoel . Er wordt een vervolgkeuzelijst weergegeven met de kolommen die in het schema worden weergegeven. Selecteer de kolom die u wilt voorspellen in het model.

In het veld Experimentnaam wordt de standaardnaam weergegeven. Als u deze wilt wijzigen, typt u de nieuwe naam in het veld.

U kunt ook het volgende doen:

- Geef aanvullende configuratieopties op.

- Gebruik bestaande functietabellen in Feature Store om de oorspronkelijke invoergegevensset te verbeteren.

Geavanceerde configuraties

Open de sectie Geavanceerde configuratie (optioneel) voor toegang tot deze parameters.

- De metrische evaluatiewaarde is de primaire metriek die wordt gebruikt om de uitvoeringen te beoordelen.

- In Databricks Runtime 10.4 LTS ML en hoger kunt u trainingsframeworks uitsluiten van overweging. AutoML traint standaard modellen met behulp van frameworks die worden vermeld onder AutoML-algoritmen.

- U kunt de stopvoorwaarden bewerken. Standaardcondities voor stoppen zijn:

- Voor het voorspellen van experimenten stopt u na 120 minuten.

- Stop in Databricks Runtime 10.4 LTS ML en hieronder voor classificatie- en regressieexperimenten na 60 minuten of na het voltooien van 200 proefversies, afhankelijk van wat het eerst gebeurt. Voor Databricks Runtime 11.0 ML en hoger wordt het aantal experimenten niet gebruikt als stopvoorwaarde.

- In Databricks Runtime 10.4 LTS ML en hoger, voor classificatie- en regressieexperimenten, omvat AutoML vroege stop; het stopt met het trainen en afstemmen van modellen als de metrische validatiegegevens niet meer worden verbeterd.

- In Databricks Runtime 10.4 LTS ML en hoger kunt u een

time columnoptie selecteren om de gegevens te splitsen voor training, validatie en testen in chronologische volgorde (alleen van toepassing op classificatie en regressie). - Databricks raadt aan het veld Gegevensmap niet in te vullen. Hierdoor wordt het standaardgedrag geactiveerd voor het veilig opslaan van de gegevensset als een MLflow-artefact. Een DBFS-pad kan worden opgegeven, maar in dit geval neemt de gegevensset de toegangsmachtigingen van het AutoML-experiment niet over.

Voer het experiment uit en bewaak de resultaten

Klik op AutoML starten om het AutoML-experiment te starten. Het experiment wordt uitgevoerd en de AutoML-trainingspagina wordt weergegeven. Als u de uitvoeringstabel wilt vernieuwen, klikt u op  .

.

Voortgang van experiment weergeven

Op deze pagina kunt u het volgende doen:

- Stop het experiment op elk gewenst moment.

- Open het notebook voor gegevensverkenning.

- Uitvoeringen bewaken.

- Navigeer naar de uitvoeringspagina voor elke uitvoering.

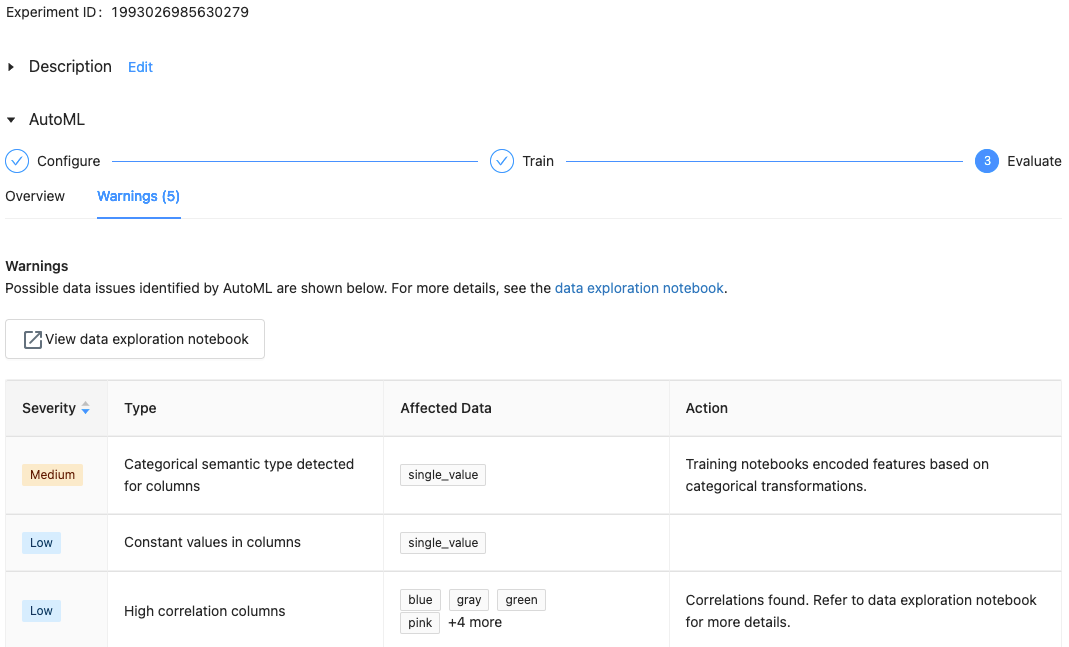

Met Databricks Runtime 10.1 ML en hoger geeft AutoML waarschuwingen weer voor mogelijke problemen met de gegevensset, zoals niet-ondersteunde kolomtypen of kolommen met hoge kardinaliteit.

Notitie

Databricks doet het beste om potentiële fouten of problemen aan te geven. Dit is echter mogelijk niet uitgebreid en legt mogelijk de problemen of fouten die u zoekt niet vast.

Als u waarschuwingen voor de gegevensset wilt zien, klikt u op het tabblad Waarschuwingen op de trainingspagina of op de experimentpagina nadat het experiment is voltooid.

Resultaten weergeven

Wanneer het experiment is voltooid, kunt u het volgende doen:

- Registreer en implementeer een van de modellen met MLflow.

- Selecteer Notitieblok weergeven voor het beste model om het notitieblok te bekijken en te bewerken dat het beste model heeft gemaakt.

- Selecteer Het notitieblok voor gegevensverkenning weergeven om het notitieblok voor gegevensverkenning te openen.

- Zoek, filter en sorteer de uitvoeringen in de uitvoeringstabel.

- Zie de details voor elke uitvoering:

- Het gegenereerde notebook met broncode voor een proefuitvoering vindt u door te klikken op de MLflow-uitvoering. Het notebook wordt opgeslagen in de sectie Artefacten van de uitvoeringspagina. U kunt dit notitieblok downloaden en importeren in de werkruimte als het downloaden van artefacten is ingeschakeld door uw werkruimtebeheerders.

- Als u de uitvoeringsresultaten wilt weergeven, klikt u in de kolom Modellen of de kolom Begintijd . De uitvoeringspagina wordt weergegeven met informatie over de proefversie (zoals parameters, metrische gegevens en tags) en artefacten die door de uitvoering zijn gemaakt, inclusief het model. Deze pagina bevat ook codefragmenten die u kunt gebruiken om voorspellingen te doen met het model.

Als u later wilt terugkeren naar dit AutoML-experiment, zoekt u het in de tabel op de pagina Experimenten. De resultaten van elk AutoML-experiment, inclusief de notebooks voor gegevensverkenning en training, worden opgeslagen in een databricks_automl map in de basismap van de gebruiker die het experiment heeft uitgevoerd.

Een model registreren en implementeren

U kunt uw model registreren en implementeren met de AutoML-gebruikersinterface:

- Selecteer de koppeling in de kolom Modellen voor het model dat u wilt registreren. Wanneer een uitvoering is voltooid, is de bovenste rij het beste model (op basis van de primaire metriek).

- Selecteer

deze optie om het model te registreren in het modelregister.

deze optie om het model te registreren in het modelregister. - Selecteer

Modellen in de zijbalk om naar het modelregister te navigeren.

Modellen in de zijbalk om naar het modelregister te navigeren. - Selecteer de naam van uw model in de modeltabel.

- Op de geregistreerde modelpagina kunt u het model bedienen met Model Serving.

Geen module met de naam pandas.core.indexes.numeriek

Bij het leveren van een model dat is gebouwd met Behulp van AutoML met Model Serving, krijgt u mogelijk de volgende fout: No module named 'pandas.core.indexes.numeric.

Dit komt door een incompatibele pandas versie tussen AutoML en het model voor eindpuntomgeving. U kunt deze fout oplossen door het add-pandas-dependency.py script uit te voeren. Het script bewerkt het requirements.txt en conda.yaml voor het vastgelegde model om de juiste pandas afhankelijkheidsversie op te nemen: pandas==1.5.3

- Wijzig het script om de

run_idMLflow-uitvoering op te nemen waarin uw model is vastgelegd. - Het model opnieuw registreren bij het MLflow-modelregister.

- Probeer de nieuwe versie van het MLflow-model te leveren.