Benchmarks gebruiken in een Genie-ruimte

In dit artikel wordt uitgelegd hoe u benchmarks gebruikt om de nauwkeurigheid van uw Genie-ruimte te evalueren.

Overzicht

Met benchmarks kunt u een set testvragen maken die u kunt uitvoeren om de algehele reactienauwkeurigheid van Genie te beoordelen. Een goed ontworpen reeks benchmarks die betrekking hebben op de meest gestelde vragen van gebruikers, helpt bij het evalueren van de nauwkeurigheid van uw Genie-ruimte terwijl u deze verfijnt.

Benchmarkvragen worden als nieuwe gesprekken uitgevoerd. Ze hebben niet dezelfde context als een threaded Genie-gesprek. Elke vraag wordt verwerkt als een nieuwe query, met behulp van de instructies die in de ruimte zijn gedefinieerd, inclusief eventuele voorbeelden van SQL- en SQL-functies.

Benchmarkvragen toevoegen

Benchmarkvragen moeten verschillende manieren weerspiegelen om de veelgestelde vragen te formuleren die uw gebruikers stellen. U kunt deze gebruiken om het antwoord van Genie te controleren op variaties in de formulering van vragen of verschillende vraagindelingen.

Wanneer u een benchmarkvraag maakt, kunt u desgewenst een SQL-query opnemen waarvan de resultatenset het juiste antwoord is. Tijdens benchmarkuitvoeringen wordt de nauwkeurigheid beoordeeld door de resultatenset van uw SQL-query te vergelijken met de set die door Genie wordt gegenereerd.

Voer de volgende stappen uit om een benchmarkvraag toe te voegen:

Klik op de

linkerzijbalk in een Genie-ruimte.

linkerzijbalk in een Genie-ruimte.Klik op het tabblad Vragen . Klik vervolgens op Benchmark toevoegen.

Voer in het veld Vraag een benchmarkvraag in die u wilt testen.

(Optioneel) Voer de SQL-instructie in waarmee de door u ingevoerde vraag nauwkeurig wordt beantwoord.

Notitie

Deze stap wordt aanbevolen. Alleen vragen die deze SQL-voorbeeldinstructie bevatten, kunnen automatisch worden beoordeeld op nauwkeurigheid. Voor vragen die geen SQL Answer bevatten, moet handmatige beoordeling worden beoordeeld.

(Optioneel) Klik op uitvoeren om uw query uit te voeren en de resultaten weer te geven.

Wanneer u klaar bent met bewerken, klikt u op Benchmark toevoegen.

Als u een vraag wilt bijwerken nadat u deze hebt opgeslagen, klikt u op het

potloodpictogram om het dialoogvenster Vraag bijwerken te openen.

potloodpictogram om het dialoogvenster Vraag bijwerken te openen.

Benchmarks gebruiken om alternatieve formuleringen met vragen te testen

Bij het evalueren van de nauwkeurigheid van uw Genie-ruimte is het belangrijk om tests te structuren om realistische scenario's weer te geven. Gebruikers kunnen op verschillende manieren dezelfde vraag stellen. Databricks raadt aan om meerdere formuleringen van dezelfde vraag toe te voegen en hetzelfde voorbeeld van SQL in uw benchmarktests te gebruiken om de nauwkeurigheid volledig te beoordelen. De meeste Genie-ruimten moeten 2 - 4 formuleringen van dezelfde vraag bevatten.

Benchmarkvragen uitvoeren

Gebruikers met ten minste CAN EDIT-machtigingen in een Genie-ruimte kunnen op elk gewenst moment een benchmarkuitvoering maken, die automatisch wordt geëvalueerd voor alle benchmarkvragen. Om elke benchmarkvraag te evalueren, zullen we eerst de vraag indienen bij Genie en vervolgens de Genie-resultaten vergelijken met de benchmark. Een van de volgende labels wordt toegepast op elke benchmark:

- Goed: Antwoorden worden gemarkeerd met dit label wanneer het door Genie gegenereerde queryresultaat overeenkomt met de resultaten van het opgegeven SQL-antwoord. Wanneer een antwoord is gemarkeerd als Goed, betekent dit dat de rijwaarden exact overeenkomen, ongeacht de sorteervolgorde of kolomnamen.

- Moet worden beoordeeld: antwoorden worden gemarkeerd met dit label wanneer Genie de juistheid niet kan beoordelen of wanneer door Genie gegenereerde queryresultaten niet overeenkomen met de resultaten van het opgegeven SQL-antwoord. Als er onverwachte wijzigingen zijn in de dimensies van een tabel in het gegenereerde antwoord of in het opgegeven SQL-antwoord, kan de vraag worden gemarkeerd voor beoordeling. Benchmarkvragen die geen SQL Answer bevatten, moeten handmatig worden gecontroleerd.

- Slecht: Reacties worden nooit automatisch aangeduid als Slecht. Als door Genie gegenereerde queryresultaten niet overeenkomen met de resultatenset van de opgegeven SQL Answer, wordt de vraag gemarkeerd als Moet worden beoordeeld. Wanneer u deze benchmarks bekijkt, kunt u een resultaat markeren als Slecht als u niet denkt dat de gegenereerde queryresultaten van Genie de vraag beantwoorden.

Alle benchmarkvragen uitvoeren:

- Klik op

Benchmarks in de zijbalk van de Genie-spatie aan de linkerkant van het scherm.

Benchmarks in de zijbalk van de Genie-spatie aan de linkerkant van het scherm. - Klik op Benchmarks uitvoeren om de testuitvoering te starten.

Notitie

Als u deze pagina sluit, wordt de benchmarkuitvoering automatisch onderbroken. U kunt de test hervatten wanneer u de pagina opnieuw opent.

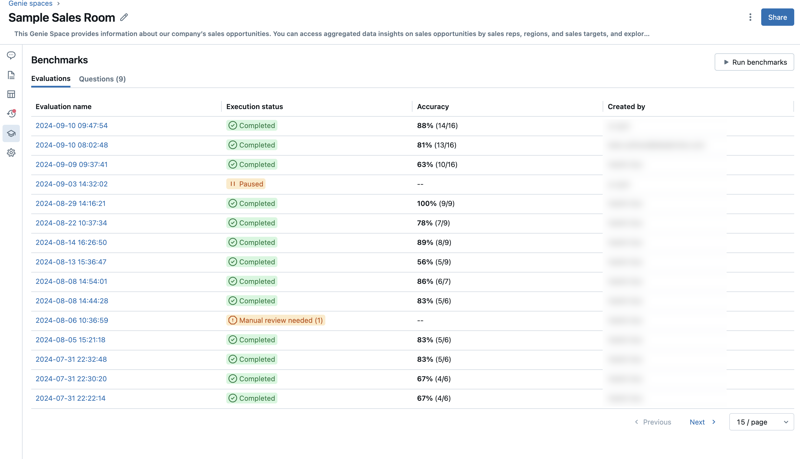

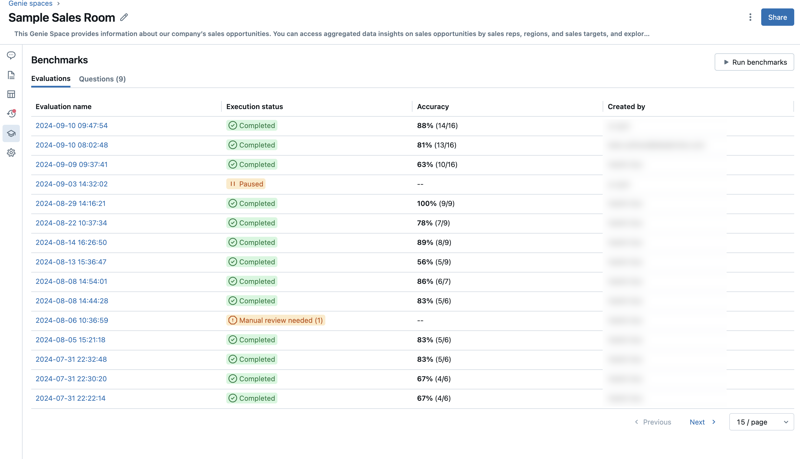

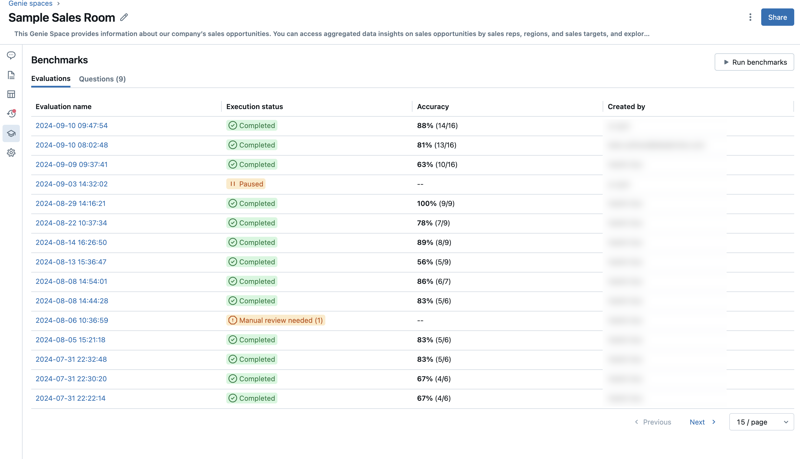

Evaluaties van Access-benchmark

U hebt toegang tot al uw benchmark-evaluaties om de nauwkeurigheid in uw Genie-ruimte in de loop van de tijd bij te houden. Wanneer u op het pictogram ![]() in de linkerzijbalk in een Genie-ruimte, wordt er een tijdstempellijst met evaluatieuitvoeringen weergegeven op het tabblad Evaluaties. Als er geen evaluatieuitvoeringen worden gevonden, raadpleegt u Benchmarkvragen toevoegen of Benchmarkvragen uitvoeren.

in de linkerzijbalk in een Genie-ruimte, wordt er een tijdstempellijst met evaluatieuitvoeringen weergegeven op het tabblad Evaluaties. Als er geen evaluatieuitvoeringen worden gevonden, raadpleegt u Benchmarkvragen toevoegen of Benchmarkvragen uitvoeren.

Op het tabblad Evaluaties ziet u een overzicht van de evaluaties en de prestaties die in de volgende categorieën zijn gerapporteerd:

Evaluatienaam: een tijdstempel die aangeeft wanneer een evaluatieuitvoering heeft plaatsgevonden. Klik op de tijdstempel om details voor die evaluatie weer te geven. Uitvoeringsstatus: Geeft aan of de evaluatie is voltooid, onderbroken of mislukt. Als een evaluatieuitvoering benchmarkvragen bevat die geen vooraf gedefinieerde SQL-antwoorden hebben, wordt deze gemarkeerd voor beoordeling in deze kolom. Nauwkeurigheid: Een numerieke beoordeling van nauwkeurigheid in alle benchmarkvragen. Voor evaluatieuitvoeringen waarvoor handmatige controle is vereist, wordt er pas een nauwkeurigheidsmeting weergegeven nadat deze vragen zijn beoordeeld. Gemaakt door: Geeft de naam aan van de gebruiker die de evaluatie heeft uitgevoerd.

Afzonderlijke evaluaties bekijken

U kunt afzonderlijke evaluaties bekijken om elk antwoord gedetailleerd te bekijken. U kunt de evaluatie bewerken voor elke vraag en alle items bijwerken die handmatig moeten worden gecontroleerd.

Afzonderlijke evaluaties bekijken:

Klik op

Benchmarks in de zijbalk van de Genie-spatie aan de linkerkant van het scherm.

Benchmarks in de zijbalk van de Genie-spatie aan de linkerkant van het scherm.Klik op de tijdstempel voor een evaluatie in de kolom Evaluatienaam om een gedetailleerde weergave van die testuitvoering te openen.

Klik op een vraag aan de linkerkant van het scherm om de bijbehorende details weer te geven. Gebruik het detailscherm van de evaluatie om de volgende stappen uit te voeren.

Controleer en vergelijk het uitvoerantwoord van het model met het antwoord Ground truth.

Notitie

De resultaten van deze antwoorden worden één week weergegeven in de evaluatiedetails. Na een week zijn de resultaten niet meer zichtbaar. De gegenereerde SQL-instructie en de voorbeeld-SQL-instructie blijven behouden.

Klik op het

label om de evaluatie te bewerken.

label om de evaluatie te bewerken.Markeer elk resultaat als Good of Bad om een nauwkeurige score voor deze evaluatie te krijgen.