Referentie voor rekenconfiguratie

Notitie

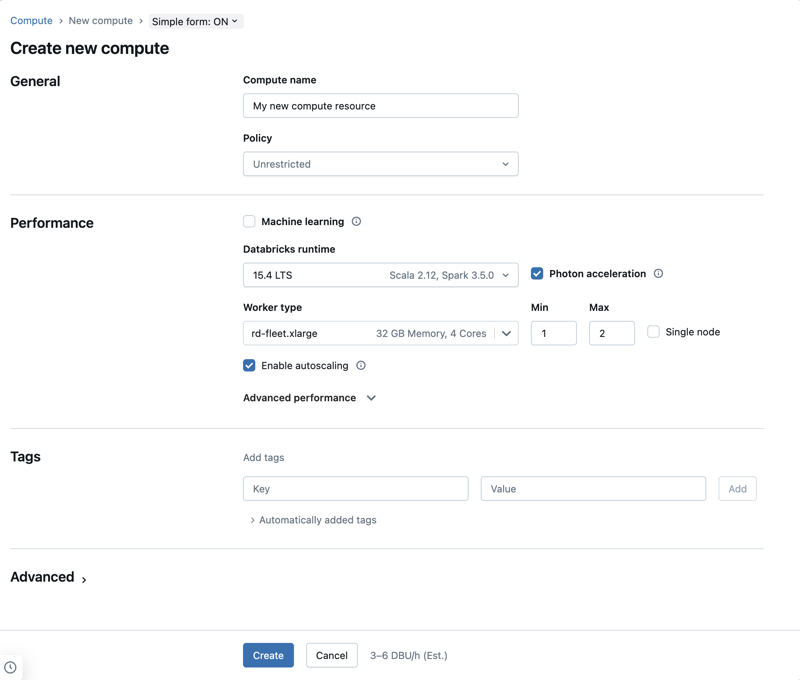

Bij de organisatie van dit artikel wordt ervan uitgegaan dat u de eenvoudige rekeninterface van formulieren gebruikt. Voor een overzicht van de updates van het eenvoudige formulier, zie Het eenvoudige formulier gebruiken voor het beheren van compute.

In dit artikel worden de configuratie-instellingen uitgelegd die beschikbaar zijn bij het maken van een nieuwe algemene of taakspecifieke bron. De meeste gebruikers maken rekenresources met behulp van hun toegewezen beleid, waardoor de configureerbare instellingen worden beperkt. Als u een bepaalde instelling niet ziet in uw gebruikersinterface, is dit omdat u deze instelling niet kunt configureren met het beleid dat u hebt geselecteerd.

De configuraties en beheerhulpprogramma's die in dit artikel worden beschreven, zijn van toepassing op zowel alle doeleinden als taak berekenen. Zie Rekenproces configureren voor taken voor meer overwegingen over het configureren van taak berekenen.

Een nieuwe rekenresource voor alle doeleinden maken

Een nieuwe rekenresource voor alle doeleinden maken:

- Klik in de zijbalk van de werkruimte op Compute.

- Klik op de knop Compute maken.

- Configureer de rekenresource.

- Klik op Create.

Je nieuwe rekenresource wordt automatisch opgestart en is binnenkort klaar voor gebruik.

Compute-beleid

Beleidsregels zijn een set regels die worden gebruikt om de configuratieopties te beperken die beschikbaar zijn voor gebruikers wanneer ze rekenresources maken. Als een gebruiker niet beschikt over het recht voor het maken van een onbeperkt cluster, kunnen ze alleen rekenresources maken met behulp van hun toegewezen beleid.

Als u rekenresources wilt maken op basis van een beleid, selecteert u een beleid in de vervolgkeuzelijst Beleid.

Standaard hebben alle gebruikers toegang tot het personal compute-beleid , zodat ze rekenresources met één computer kunnen maken. Als u toegang nodig hebt tot Personal Compute of aanvullende beleidsregels, neemt u contact op met uw werkruimtebeheerder.

Prestatie-instellingen

De volgende instellingen worden weergegeven in de sectie Performance van de eenvoudige rekeninterface voor formulieren:

- Databricks Runtime-versies

- Fotonversnelling gebruiken

- werkknooppunt type

- rekenproces met één knooppunt

- Automatische schaalaanpassing inschakelen

- Geavanceerde prestatie-instellingen

Databricks Runtime-versies

Databricks Runtime is een set van kernonderdelen die worden uitgevoerd op uw rekenkracht. Selecteer de runtime via de Databricks Runtime-versie vervolgkeuzelijst. Raadpleeg de versies en compatibiliteit van de release-opmerkingen van Databricks Runtime voor meer informatie over specifieke Databricks Runtime-versies. Alle versies bevatten Apache Spark. Databricks raadt het volgende aan:

- Gebruik voor rekendoeleinden de meest recente versie om ervoor te zorgen dat u over de nieuwste optimalisaties beschikt en de meest recente compatibiliteit tussen uw code en vooraf geladen pakketten.

- Voor het berekenen van taken waarop operationele workloads worden uitgevoerd, kunt u overwegen de Databricks Runtime-versie (Long Term Support) te gebruiken. Met behulp van de LTS-versie zorgt u ervoor dat u geen compatibiliteitsproblemen ondervindt en uw workload grondig kunt testen voordat u een upgrade uitvoert.

- Voor data science- en machine learning-gebruiksscenario's kunt u de Databricks Runtime ML-versie overwegen.

Fotonversnelling gebruiken

Photon is standaard ingeschakeld voor berekeningen met Databricks Runtime 9.1 LTS en hoger.

Als u Photon-versnelling wilt in- of uitschakelen, selecteert u het selectievakje Photon-versnelling gebruiken. Zie Wat is Photon?voor meer informatie over Photon.

werkknooppunt type

Een rekenresource bestaat uit één stuurprogrammaknooppunt en nul of meer werkknooppunten. U kunt afzonderlijke typen cloudproviderexemplaren kiezen voor het stuurprogramma- en werkknooppunt, hoewel het stuurprogrammaknooppunt standaard hetzelfde exemplaartype gebruikt als het werkknooppunt. De instelling van het stuurprogrammaknooppunt bevindt zich onder de sectie Geavanceerde prestaties.

Verschillende families van instantietypen passen bij verschillende toepassingen, zoals geheugenintensieve of rekenintensieve workloads. U kunt ook een pool selecteren om te gebruiken als werkernode of drivernode.

Belangrijk

Gebruik geen pool met spot-exemplaren als bestuurderstype. Selecteer een stuurprogrammatype op afroep om te voorkomen dat uw stuurprogramma wordt teruggenomen. Zie Verbinding maken met pools.

In rekenkracht met meerdere knooppunten voeren werkknooppunten de Spark-uitvoerders en andere services uit die nodig zijn voor een goed functionerende rekenresource. Wanneer u uw workload distribueert met Spark, vindt alle gedistribueerde verwerking plaats op werkknooppunten. Azure Databricks voert één uitvoerder per werkknooppunt uit. Daarom worden de termen uitvoerders en werkers wisselend gebruikt binnen de context van de Databricks-architectuur.

Tip

Als u een Spark-taak wilt uitvoeren, hebt u ten minste één werkknooppunt nodig. Als de rekenresource nul werkers heeft, kunt u niet-Spark-opdrachten uitvoeren op het gebruikersknooppunt, maar Spark-opdrachten zullen mislukken.

IP-adressen van werkknooppunten

Azure Databricks start werkknooppunten met elk twee privé-IP-adressen. Het primaire privé-IP-adres van het knooppunt fungeert als host voor intern verkeer van Azure Databricks. Het secundaire privé-IP-adres wordt gebruikt door de Spark-container voor communicatie tussen clusters. Met dit model kan Azure Databricks isolatie bieden tussen meerdere rekenresources in dezelfde werkruimte.

GPU-exemplaartypen

Azure Databricks biedt ondersteuning voor rekenresources die worden versneld met GPU's (Graphics Processing Units). Zie rekenkracht met GPU voor meer informatie.

Azure confidential computing VM's

VM-typen Azure Confidential Computing verhinderen onbevoegde toegang tot gegevens terwijl deze in gebruik zijn, waaronder van de cloudoperator. Dit VM-type is nuttig voor sterk gereglementeerde branches en regio's, evenals bedrijven met gevoelige gegevens in de cloud. Zie Azure Confidential Computing voor meer informatie over confidential computing van Azure.

Als u uw workloads wilt uitvoeren met vm's van Azure Confidential Computing, selecteert u de VM-typen DC- of EC-serie in de vervolgkeuzelijsten voor werkrollen en stuurprogrammaknooppunten. Zie azure Confidential VM-opties.

rekenproces met één knooppunt

Met het selectievakje enkel knooppunt kunt u een rekenresource met één knooppunt maken.

Rekenkracht met één knooppunt is bedoeld voor taken die kleine hoeveelheden gegevens of niet-gedistribueerde workloads gebruiken, zoals machine learning-bibliotheken met één knooppunt. Rekenkracht met meerdere knooppunten moet worden gebruikt voor grotere taken met gedistribueerde workloads.

Eigenschappen van één knooppunt

Een rekenresource met één knooppunt heeft de volgende eigenschappen:

- Voert Spark lokaal uit.

- De driver fungeert zowel als master als worker, zonder werkknooppunten.

- Start één executorthread per logische kern in het computersysteem, min één kern voor de driver.

- Hiermee worden alle

stderr-,stdout- enlog4j-logboekuitvoer opgeslagen in het stuurprogrammalogboek. - Kan niet worden geconverteerd naar een rekenresource met meerdere knooppunten.

Eén of meerdere knooppunten selecteren

Houd rekening met uw use-case bij het kiezen tussen rekenkracht van één of meerdere knooppunten:

Grootschalige gegevensverwerking zal de resources op een enkele knooppunt computercapaciteit uitputten. Voor deze workloads raadt Databricks aan om rekenkracht met meerdere knooppunten te gebruiken.

Rekenkracht met één knooppunt is niet ontworpen om te worden gedeeld. Om resourceconflicten te voorkomen, raadt Databricks aan om een rekenresource met meerdere knooppunten te gebruiken wanneer de berekening moet worden gedeeld.

Een rekenresource met meerdere knooppunten kan niet worden geschaald naar 0 werkrollen. Gebruik een enkele knooppuntcomputer.

Rekenkracht met één knooppunt is niet compatibel met procesisolatie.

GPU-planning is niet ingeschakeld op een enkel knooppunt.

Bij berekeningen met één knooppunt kan Spark Parquet-bestanden met een UDT-kolom niet lezen. Het volgende foutbericht verschijnt:

The Spark driver has stopped unexpectedly and is restarting. Your notebook will be automatically reattached.U kunt dit probleem omzeilen door de systeemeigen Parquet-lezer uit te schakelen:

spark.conf.set("spark.databricks.io.parquet.nativeReader.enabled", False)

Automatisch schalen inschakelen

Wanneer automatisch schalen inschakelen is ingeschakeld, kunt u een minimum en maximum aantal werkrollen opgeven voor de rekenresource. Databricks kiest vervolgens het juiste aantal werkers dat nodig is om uw klus uit te voeren.

Om het minimum- en maximumaantal werknemers tussen welke uw rekenresource automatisch schaalt in te stellen, gebruik de velden Min en Max naast de Worker-type dropdownlijst.

Als u automatisch schalen niet inschakelt, moet u een vast aantal werknemers invoeren in het veld Werknemers naast de vervolgkeuzelijst met Arbeidertype.

Notitie

Wanneer de rekenresource wordt uitgevoerd, wordt op de pagina met rekengegevens het aantal toegewezen werknemers weergegeven. U kunt het aantal toegewezen werknemers vergelijken met de werkrolconfiguratie en zo nodig aanpassingen aanbrengen.

Voordelen van automatisch schalen

Met automatisch schalen worden werknemers in Azure Databricks dynamisch verplaatst om rekening te houden met de kenmerken van uw taak. Bepaalde onderdelen van uw pijplijn kunnen meer rekenkracht vereisen dan andere, en Databricks voegt automatisch extra werkrollen toe tijdens deze fasen van uw taak (en verwijdert ze wanneer ze niet meer nodig zijn).

Automatisch schalen maakt het gemakkelijker om een hoog gebruik te bereiken, omdat u de rekenkracht niet hoeft in te richten om aan een workload te voldoen. Dit geldt met name voor workloads waarvan de vereisten na verloop van tijd veranderen (zoals het verkennen van een gegevensset tijdens de loop van een dag), maar deze kan ook van toepassing zijn op een eenmalige kortere workload waarvan de inrichtingsvereisten onbekend zijn. Automatische schaalaanpassing biedt dus twee voordelen:

- Workloads kunnen sneller worden uitgevoerd in vergelijking met een onderbemeten rekenresource met een constante omvang.

- Automatisch schalen kan de totale kosten verlagen in vergelijking met een rekenresource met een statisch formaat.

Afhankelijk van de constante grootte van de rekenresource en de workload biedt automatisch schalen u een of beide voordelen tegelijk. De computegrootte kan onder het minimale aantal werkers gaan dat is geselecteerd wanneer de cloudprovider instanties beëindigt. In dit geval probeert Azure Databricks voortdurend instanties opnieuw in te richten om het minimale aantal werknemers te behouden.

Notitie

Automatisch schalen is niet beschikbaar voor spark-submit-taken.

Notitie

Automatisch schalen van berekeningen heeft beperkingen bij het verkleinen van de clustergrootte voor gestructureerde streamingworkloads. Databricks raadt aan DLT te gebruiken met verbeterde automatische schaalaanpassing voor streamingworkloads. Zie Het clustergebruik van DLT-pijplijnen optimaliseren met verbeterde automatische schaalaanpassing.

De werking van automatisch schalen

Werkruimtes in het Premium-abonnement gebruiken geoptimaliseerde automatische schaalaanpassing. Werkruimten in het standaard prijspakket maken gebruik van automatische schaalvergroting.

Geoptimaliseerde automatische schaalaanpassing heeft de volgende kenmerken:

- Schaalt omhoog van min tot max in 2 stappen.

- Kan omlaag schalen, zelfs als de rekenresource niet inactief is, door de status van het willekeurige bestand te bekijken.

- Schaalt omlaag op basis van een percentage van de huidige knooppunten.

- Bij het berekenen van de taak schaalt u omlaag als de rekenresource in de afgelopen 40 seconden te weinig wordt gebruikt.

- Bij berekeningen voor alle doeleinden schaalt u omlaag als de rekenresource in de afgelopen 150 seconden te weinig wordt gebruikt.

- De

spark.databricks.aggressiveWindowDownSSpark-configuratie-eigenschap geeft in seconden op hoe vaak de berekening beslissingen neemt over omlaag schalen. Door de waarde te verhogen, wordt de rekenkracht langzamer verminderd. De maximumwaarde is 600.

Standaard automatische schaalvergroting wordt gebruikt in standaard plan-werkruimten. Standaard automatisch schalen heeft de volgende kenmerken:

- Begint met het toevoegen van 8 knooppunten. Schaalt vervolgens exponentieel omhoog en neemt zo veel stappen uit als nodig is om het maximum te bereiken.

- Schaalt omlaag wanneer 90% van de knooppunten gedurende 10 minuten niet bezet is en de berekening gedurende ten minste 30 seconden niet actief is.

- Schaalt exponentieel omlaag, te beginnen met 1 knooppunt.

Automatisch schalen met pools

Als u uw rekenresource aan een pool koppelt, kunt u het volgende overwegen:

- Zorg ervoor dat de aangevraagde rekenkracht kleiner is dan of gelijk is aan het minimale aantal niet-actieve exemplaren in de pool. Als deze groter is, is de opstarttijd van de rekenkracht gelijk aan de rekenkracht die geen pool gebruikt.

- Zorg ervoor dat de maximale rekenkracht kleiner is dan of gelijk is aan de maximale capaciteit van de pool. Als het groter is, zal het aanmaken van de computingbron mislukken.

Voorbeeld van automatisch schalen

Als u een statische rekenresource opnieuw configureert om automatisch te schalen, wijzigt Azure Databricks de grootte van de rekenresource onmiddellijk binnen de minimum- en maximumgrenzen en wordt vervolgens automatisch schalen gestart. In de volgende tabel ziet u bijvoorbeeld wat er gebeurt met een rekenresource met een bepaalde initiële grootte als u de rekenresource opnieuw configureert voor automatische schaalaanpassing tussen 5 en 10 knooppunten.

| Oorspronkelijke grootte | Grootte na herconfiguratie |

|---|---|

| 6 | 6 |

| 12 | 10 |

| 3 | 5 |

geavanceerde prestatie-instellingen

De volgende instelling wordt weergegeven in het gedeelte Geavanceerde prestaties in de eenvoudige rekeninterface van formulieren.

Spot-exemplaren

U kunt opgeven of u spot-exemplaren wilt gebruiken door het selectievakje Spot-exemplaar gebruiken onder Geavanceerde prestatiesin te schakelen. Zie AWS-spotprijzen.

Spot-exemplaren

Als u kosten wilt besparen, kunt u ervoor kiezen om spot-exemplaren te gebruiken , ook wel Azure Spot-VM's genoemd door het selectievakje Spot-exemplaren in te schakelen.

Het eerste exemplaar is altijd on-demand (het stuurprogrammaknooppunt is altijd on-demand) en volgende exemplaren zijn spot-exemplaren.

Als exemplaren worden verwijderd vanwege niet-beschikbaarheid, probeert Azure Databricks nieuwe spot-exemplaren te verkrijgen om de verwijderde exemplaren te vervangen. Als spot-exemplaren niet kunnen worden verkregen, worden on-demand exemplaren geïmplementeerd om de verwijderde exemplaren te vervangen. Deze failback op aanvraag wordt alleen ondersteund voor spot-instances die volledig zijn toegewezen en in gebruik zijn. Spot-instanties die falen tijdens de installatie, worden niet automatisch vervangen.

Als er nieuwe knooppunten worden toegevoegd aan bestaande rekenresources, probeert Azure Databricks spot-exemplaren voor die knooppunten te verkrijgen.

Automatische beëindiging

U kunt automatische beëindiging instellen voor berekening in het gedeelte Geavanceerde prestaties. Geef tijdens het maken van de berekening een inactiviteitsperiode op in minuten waarna u de rekenresource wilt beëindigen.

Als het verschil tussen de huidige tijd en de laatste opdracht die wordt uitgevoerd op de rekenresource meer is dan de opgegeven inactiviteitsperiode, beëindigt Azure Databricks die berekening automatisch. voor meer informatie over het beëindigen van rekenprocessen raadpleegt u Een rekenproces beëindigen.

Stuurprogramma type

U kunt het type stuurprogramma selecteren in de sectie Geavanceerde prestaties. Het stuurprogrammaknooppunt onderhoudt statusgegevens van alle notebooks die zijn gekoppeld aan de rekenresource. Het stuurprogrammaknooppunt onderhoudt ook sparkContext, interpreteert alle opdrachten die u uitvoert vanuit een notebook of een bibliotheek op de rekenresource en voert de Apache Spark-master uit die wordt gecoördineerd met de Spark-uitvoerders.

De standaardwaarde van het type stuurprogrammaknooppunt is hetzelfde als het type werkknooppunt. U kunt een groter type stuurprogrammaknooppunt met meer geheugen kiezen als u van plan bent om veel gegevens van Spark-werkrollen te collect() gebruiken en deze te analyseren in het notebook.

Tip

Omdat het stuurprogrammaknooppunt alle statusgegevens van de gekoppelde notitieblokken onderhoudt, moet u ongebruikte notitieblokken loskoppelen van het stuurprogrammaknooppunt.

Tags

Met tags kunt u eenvoudig de kosten van rekenresources bewaken die door verschillende groepen in uw organisatie worden gebruikt. Geef tags op als sleutel-waardeparen wanneer u rekenkracht maakt en Azure Databricks past deze tags toe op cloudresources, zoals VM's en schijfvolumes, evenals DBU-gebruiksrapporten.

Voor berekeningen die worden gestart vanuit pools, worden de aangepaste tags alleen toegepast op DBU-gebruiksrapporten en worden ze niet doorgegeven aan cloudresources.

Zie Kenmerkgebruik met tags voor gedetailleerde informatie over hoe pool- en rekentagtypen samenwerken

Tags toevoegen aan uw rekenresource:

- Voeg in de sectie Tags een sleutel-waardepaar toe voor elke aangepaste tag.

- Klik op Toevoegen.

Geavanceerde instellingen

De volgende instellingen worden weergegeven in het gedeelte Advanced van de eenvoudige gebruikersinterface voor het berekenen van formulieren:

- Toegangsmodi

- automatische schaalaanpassing van lokale opslag inschakelen

- lokale schijfversleuteling

- Spark-configuratie

- SSH-toegang tot computing-

- omgevingsvariabelen

- compute-logboeklevering

Toegangsmodi

De toegangsmodus is een beveiligingsfunctie die bepaalt wie de rekenresource kan gebruiken en welke gegevens ze kunnen benaderen met behulp van de rekenresource. Elke rekenresource in Azure Databricks heeft een toegangsmodus. Instellingen voor de toegangsmodus vindt u in het gedeelte Advanced van de eenvoudige gebruikersinterface voor het berekenen van formulieren.

De selectie van de toegangsmodus wordt standaard Automatisch, wat betekent dat de toegangsmodus automatisch voor u wordt gekozen op basis van de geselecteerde Databricks Runtime. Machine learning-runtimes en Databricks-runtimes lager dan 14.3 zijn standaard ingesteld op Toegewezen modus, anders wordt Standaard gebruikt.

Databricks raadt u aan om de standaardtoegangsmodus voor alle workloads te gebruiken. Gebruik de toegewezen toegangsmodus alleen als uw vereiste functionaliteit niet wordt ondersteund door de standaardtoegangsmodus.

| Toegangsmodus | Zichtbaar voor gebruiker | UC-ondersteuning | Ondersteunde talen | Opmerkingen |

|---|---|---|---|---|

| Dedicated (voorheen één gebruiker) | Altijd | Ja | Python, SQL, Scala, R | Kan worden toegewezen aan en gebruikt door één gebruiker of groep. |

| Standard (voorheen gedeeld) | Altijd | Ja | Python, SQL, Scala (op Unity Catalog-geactiveerde compute met Databricks Runtime 13.3 LTS en hoger) | Kan worden gebruikt door meerdere gebruikers met gegevensisolatie tussen gebruikers. |

Voor gedetailleerde informatie over de functieondersteuning voor deze toegangsmodi zie beperkingen van de compute access mode voor Unity Catalog.

Notitie

In Databricks Runtime 13.3 LTS en hoger worden init-scripts en -bibliotheken ondersteund door alle toegangsmodi. De vereisten en ondersteuningsniveaus variëren. Zie Waar kunnen init-scripts worden geïnstalleerd? en Compute-scoped bibliotheken.

Lokale opslag automatisch schalen inschakelen

Het kan vaak lastig zijn om te schatten hoeveel schijfruimte een bepaalde taak nodig heeft. Azure Databricks schakelt automatisch de automatische schaalvergroting van lokale opslag in op alle Azure Databricks computing om te voorkomen dat u vooraf hoeft te schatten hoeveel gigabytes aan beheerde schijf moet worden gekoppeld.

Met automatische schaalaanpassing van lokale opslag bewaakt Azure Databricks de hoeveelheid vrije schijfruimte die beschikbaar is voor spark-werkrollen van uw rekenproces. Als een werknemer bijna geen schijfruimte meer heeft, koppelt Databricks automatisch een nieuwe beheerde schijf aan de werknemer voordat de schijfruimte op is. Schijven zijn gekoppeld aan een limiet van 5 TB aan totale schijfruimte per virtuele machine (inclusief de initiële lokale opslag van de virtuele machine).

De beheerde schijven die aan een virtuele machine zijn gekoppeld, worden alleen losgekoppeld wanneer de virtuele machine wordt geretourneerd naar Azure. Beheerde schijven worden dus nooit losgekoppeld van een virtuele machine zolang ze deel uitmaken van een actieve berekening. Als u het gebruik van beheerde schijven omlaag wilt schalen, raadt Azure Databricks aan om deze functie te gebruiken in berekeningen die zijn geconfigureerd met automatische schaalaanpassing of automatische beëindiging.

Lokale schijfversleuteling

Belangrijk

Deze functie is beschikbaar als openbare preview.

Sommige exemplaartypen die u gebruikt om berekeningen uit te voeren, hebben mogelijk lokaal gekoppelde schijven. Azure Databricks kan shuffle-gegevens of tijdelijke gegevens opslaan op deze lokaal gekoppelde schijven. Om ervoor te zorgen dat alle data in rust is versleuteld voor alle opslagtypen, inclusief shuffle-gegevens die tijdelijk zijn opgeslagen op de lokale schijven van uw compute-resource, kunt u versleuteling van lokale schijven inschakelen.

Belangrijk

Uw workloads kunnen langzamer worden uitgevoerd vanwege de prestatie-impact van het lezen en schrijven van versleutelde gegevens naar en van lokale volumes.

Wanneer versleuteling van lokale schijven is ingeschakeld, genereert Azure Databricks lokaal een versleutelingssleutel die uniek is voor elk rekenknooppunt en wordt gebruikt voor het versleutelen van alle gegevens die zijn opgeslagen op lokale schijven. Het bereik van de sleutel is lokaal voor elk rekenknooppunt en wordt samen met het rekenknooppunt zelf vernietigd. Tijdens de levensduur bevindt de sleutel zich in het geheugen voor versleuteling en ontsleuteling en wordt deze versleuteld op de schijf opgeslagen.

Als u lokale schijfversleuteling wilt inschakelen, moet u de Clusters-API gebruiken. Tijdens het maken of bewerken van de berekening stelt u enable_local_disk_encryption in op true.

Spark-configuratie

Als u Spark-taken wilt verfijnen, kunt u aangepaste Spark-configuratie-eigenschappen opgeven.

Klik op de pagina rekenconfiguratie op de wisselknop Geavanceerd.

Klik op het tabblad Spark .

Voer in Spark-configuratie de configuratie-eigenschappen in als één sleutel-waardepaar per regel.

Wanneer u rekenkracht configureert met behulp van de Clusters-API, stelt u Spark-eigenschappen in het veld spark_conf in de API voor het aanmaken van een cluster of de API voor het bijwerken van een cluster.

Voor het afdwingen van Spark-configuraties op rekenproces kunnen werkruimtebeheerders rekenbeleid gebruiken.

Een Spark-configuratie-eigenschap ophalen uit een geheim

Databricks raadt aan gevoelige informatie, zoals wachtwoorden, op te slaan in een geheim in plaats van tekst zonder opmaak. Gebruik de volgende syntaxis om te verwijzen naar een geheim in de Spark-configuratie:

spark.<property-name> {{secrets/<scope-name>/<secret-name>}}

Als u bijvoorbeeld een Spark-configuratie-eigenschap met de naam password wilt instellen op de waarde van het geheim dat is opgeslagen in secrets/acme_app/password:

spark.password {{secrets/acme-app/password}}

Zie Geheimen beheren voor meer informatie.

SSH-toegang tot rekenkracht

Om veiligheidsredenen wordt de SSH-poort in Azure Databricks standaard gesloten. Als u SSH-toegang tot uw Spark-clusters wilt inschakelen, zie SSH naar het stuurprogrammaknooppunt.

Notitie

SSH kan alleen worden ingeschakeld als uw werkruimte is geïmplementeerd in uw eigen virtuele Azure-netwerk.

Omgevingsvariabelen

Configureer aangepaste omgevingsvariabelen die u kunt openen vanuit init-scripts die worden uitgevoerd op de rekenresource. Databricks biedt ook vooraf gedefinieerde omgevingsvariabelen die u kunt gebruiken in init-scripts. U kunt deze vooraf gedefinieerde omgevingsvariabelen niet overschrijven.

Klik op de pagina rekenconfiguratie op de wisselknop Geavanceerd.

Klik op het tabblad Spark .

Stel de omgevingsvariabelen in in het veld Omgevingsvariabelen.

U kunt ook omgevingsvariabelen instellen met behulp van het veld spark_env_vars in de Cluster-API maken of Cluster-API bijwerken.

Levering van rekenlogboek

Wanneer u rekenkracht creëert, kunt u een locatie bepalen om de logboeken af te leveren voor het Spark-stuurprogrammaknooppunt, de werkknooppunten en de gebeurtenissen. Logboeken worden elke vijf minuten bezorgd en elk uur gearchiveerd in uw gekozen bestemming. Wanneer een rekenresource wordt beëindigd, garandeert Azure Databricks dat alle logboeken worden geleverd die zijn gegenereerd totdat de rekenresource is beëindigd.

De bestemming van de logboeken is afhankelijk van de rekenresource cluster_id. Als de opgegeven bestemming is dbfs:/cluster-log-delivery, worden rekenlogboeken 0630-191345-leap375 geleverd aan dbfs:/cluster-log-delivery/0630-191345-leap375.

Ga als volgende te werk om de locatie voor de levering van logboeken te configureren:

- Klik op de rekenpagina op de wisselknop Geavanceerd.

- Klik op het tabblad Logboekregistratie .

- Selecteer een doeltype.

- Voer het pad voor het rekenlogboek in.

Notitie

Deze functie is ook beschikbaar in de REST API. Zie de Clusters-API.