Netwerkeisen voor host voor Azure Local

Van toepassing op: Azure Local 2311.2 en hoger

In dit onderwerp worden overwegingen en vereisten voor hostnetwerken voor Azure Local besproken. Zie De vereisten van het fysieke netwerk voor informatie over datacenterarchitecturen en de fysieke verbindingen tussen machines.

Zie Hostnetwerken vereenvoudigen met Network ATC voor informatie over het vereenvoudigen van hostnetwerken met Network ATC.

Netwerkverkeerstypen

Lokaal Azure-netwerkverkeer kan worden geclassificeerd op basis van het beoogde doel:

- Beheerverkeer: Verkeer naar of van buiten het lokale systeem. Bijvoorbeeld opslagreplicaverkeer of verkeer dat wordt gebruikt door de beheerder voor beheer van het systeem, zoals Extern bureaublad, Windows Admin Center, Active Directory, enzovoort.

- Rekenverkeer: verkeer dat afkomstig is van of bestemd is voor een virtuele machine (VM).

- Opslagverkeer: Verkeer dat gebruik maakt van Server Message Block (SMB), zoals Storage Spaces Direct of SMB-gebaseerde live migratie. Dit verkeer is laag 2-verkeer en kan niet worden gerouteerd.

Belangrijk

Opslagreplica maakt gebruik van niet-RDMA-SMB-verkeer. Dit en de richtingsgebonden aard van het verkeer (Noord-Zuid) maakt het nauw afgestemd op dat van 'beheer'-verkeer dat hierboven wordt vermeld, vergelijkbaar met die van een traditionele bestandsshare.

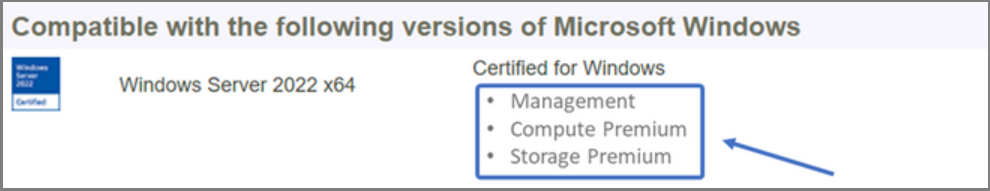

Een netwerkadapter selecteren

Netwerkadapters worden gekwalificeerd door de netwerkverkeerstypen (zie hierboven) die worden ondersteund voor gebruik met. Terwijl u de Windows Server-catalogus bekijkt, geeft de Certificering van Windows Server 2022 nu een of meer van de volgende rollen aan. Voordat u een machine aanschaft voor Azure Local, moet u minimaal één adapter hebben die is gekwalificeerd voor beheer, berekening en opslag, omdat alle drie de verkeerstypen vereist zijn op Azure Local. Vervolgens kunt u Network ATC gebruiken om uw adapters te configureren voor de juiste verkeerstypen.

Zie deze Windows Server-blogpost voor meer informatie over deze NIC-kwalificatie op basis van rollen.

Belangrijk

Het gebruik van een adapter buiten het gekwalificeerde verkeerstype wordt niet ondersteund.

| Niveau | Beheerrol | Berekeningsrol | Opslagrol |

|---|---|---|---|

| Onderscheid op basis van rollen | Beheer | Berekeningsstandaard | Opslagstandaard |

| Maximumprijs | Niet van toepassing | Compute Premium | Opslag Premium |

Notitie

De hoogste kwalificatie voor elke adapter in ons ecosysteem bevat de kwalificaties Management, Compute Premium en Storage Premium .

Stuurprogrammavereisten

Inbox-stuurprogramma's worden niet ondersteund voor gebruik met Azure Local. Voer de volgende cmdlet uit om te bepalen of uw adapter een ingebouwd stuurprogramma gebruikt. Een adapter gebruikt een inbox-stuurprogramma als de eigenschap DriverProviderMicrosoft.

Get-NetAdapter -Name <AdapterName> | Select *Driver*

Overzicht van de mogelijkheden van de belangrijkste netwerkadapter

Belangrijke netwerkadaptermogelijkheden die door Azure Local worden gebruikt, zijn onder andere:

- Dynamische virtuele machine multiwachtrij (dynamische VMMQ of d.VMMQ)

- Remote Direct Memory Access (RDMA, Direct Geheugentoegang op Afstand)

- Gast-RDMA

- Switch Ingebed Teaming (SET)

Dynamische VMMQ

Alle netwerkadapters met de Kwalificatie Compute (Premium) ondersteunen Dynamische VMMQ. Dynamische VMMQ vereist het gebruik van Switch Embedded Teaming.

Toepasselijke verkeerstypen: berekening

Vereiste certificeringen: Compute (Premium)

Dynamische VMMQ is een intelligente technologie aan de ontvangstzijde. Het bouwt voort op zijn voorgangers van Virtual Machine Queue (VMQ), Virtual Receive Side Scaling (vRSS) en VMMQ, om drie primaire verbeteringen te bieden:

- Optimaliseert de efficiëntie van de host door minder CPU-kernen te gebruiken.

- Automatisch afstemmen van de verwerking van netwerkverkeer naar CPU-kernen, waardoor VM's aan de verwachte doorvoer kunnen voldoen en onderhouden.

- Hiermee worden workloads met piekbelastingen in staat gesteld om de verwachte hoeveelheid verkeer te ontvangen.

Zie het blogbericht Synthetische versnellingen voor meer informatie over Dynamische VMMQ.

RDMA

RDMA is een netwerkstack-offload naar de netwerkadapter. Hiermee kan SMB-opslagverkeer het besturingssysteem omzeilen voor verwerking.

RDMA maakt netwerken met hoge doorvoer, lage latentie mogelijk met minimale CPU-resources van de host. Deze HOST-CPU-resources kunnen vervolgens worden gebruikt om extra VM's of containers uit te voeren.

Toepasselijke verkeerstypen: hostopslag

Vereiste certificeringen: Opslag (Standaard)

Alle adapters met Opslag (Standard) of Premium-kwalificatie ondersteunen RDMA aan de hostzijde. Zie de sectie 'Gast-RDMA' verderop in dit artikel voor meer informatie over het gebruik van RDMA met gastworkloads.

Azure Local ondersteunt RDMA met iWARP (Internet Wide Area RDMA Protocol) of RDMA via geconvergeerde Ethernet-protocolimplementaties (RoCE).

Belangrijk

RDMA-adapters werken alleen met andere RDMA-adapters die hetzelfde RDMA-protocol (iWARP of RoCE) implementeren.

Niet alle netwerkadapters van leveranciers ondersteunen RDMA. De volgende tabel bevat de leveranciers (in alfabetische volgorde) die gecertificeerde RDMA-adapters bieden. Er zijn echter hardwareleveranciers die niet zijn opgenomen in deze lijst die ook RDMA ondersteunen. Zie de Windows Server-catalogus om adapters te vinden met de kwalificatie Storage (Standard) of Storage (Premium) waarvoor RDMA-ondersteuning is vereist.

Notitie

InfiniBand (IB) wordt niet ondersteund met Azure Local.

| NIC-leverancier | iWARP | RoCE |

|---|---|---|

| Broadcom | Nee | Ja |

| Intel | Ja | Ja (sommige modellen) |

| Marvell (Qlogic) | Ja | Ja |

| Nvidia | Nee | Ja |

Voor meer informatie over het implementeren van RDMA voor de host raden we u ten zeerste aan Network ATC te gebruiken. Zie de SDN GitHub-opslagplaats voor meer informatie over handmatige implementatie.

iWARP

iWARP maakt gebruik van Transmission Control Protocol (TCP) en kan eventueel worden uitgebreid met PFC (Priority-based Flow Control) en Enhanced Transmission Service (ETS).

Gebruik iWARP als:

- U hebt geen ervaring met het beheren van RDMA-netwerken.

- U beheert uw ToR-switches niet of voelt zich ongemakkelijk bij het beheren ervan.

- U beheert de oplossing niet na de implementatie.

- U hebt al implementaties die gebruikmaken van iWARP.

- U weet niet zeker welke optie u moet kiezen.

RoCE

RoCE maakt gebruik van UDP (User Datagram Protocol) en vereist PFC en ETS om betrouwbaarheid te bieden.

Gebruik RoCE als:

- U hebt al implementaties met RoCE in uw datacenter.

- U bent vertrouwd met het beheren van de DCB-netwerkvereisten.

Gast RDMA

Met gast-RDMA kunnen SMB-workloads voor VM's dezelfde voordelen krijgen als het gebruik van RDMA op hosts.

Toepasselijke verkeerstypen: op gast gebaseerde opslag

Vereiste certificeringen: Compute (Premium)

De belangrijkste voordelen van het gebruik van gast-RDMA zijn:

- CPU-offload naar de NIC voor netwerkverkeerverwerking.

- Extreem lage latentie.

- Hoge doorvoer.

Download voor meer informatie het document uit de SDN GitHub-opslagplaats.

Switch Embedded Teaming (SET)

SET is een softwaregebaseerde teamtechnologie die is opgenomen in het Windows Server-besturingssysteem sinds Windows Server 2016. SET is de enige teamtechnologie die wordt ondersteund door Azure Local. SET werkt goed met reken-, opslag- en beheerverkeer en wordt ondersteund met maximaal acht adapters in hetzelfde team.

Toepasselijke verkeerstypen: berekening, opslag en beheer

Vereiste certificeringen: Compute (Standard) of Compute (Premium)

SET is de enige teamtechnologie die wordt ondersteund door Azure Local. SET werkt goed met reken-, opslag- en beheerverkeer.

Belangrijk

Azure Local biedt geen ondersteuning voor NIC-koppeling met de oudere LBFO (Load Balancing/Failover). Zie het blogbericht Teaming in Azure Local voor meer informatie over LBFO in Azure Local.

SET is belangrijk voor Azure Local, omdat dit de enige teamtechnologie is die het volgende mogelijk maakt:

- Koppeling van RDMA-adapters (indien nodig).

- Gast-RDMA.

- Dynamische VMMQ.

- Andere belangrijke lokale functies van Azure (zie Teaming in Azure Local).

SET vereist het gebruik van symmetrische (identieke) adapters. Symmetrische netwerkadapters zijn adapters met dezelfde:

- merk (leverancier)

- Model (versie)

- snelheid (doorvoer)

- configuratie

In 22H2 detecteert en informeert Network ATC u automatisch als de door u gekozen adapters asymmetrisch zijn. De eenvoudigste manier om handmatig te bepalen of adapters symmetrisch zijn , is als de snelheden en interfacebeschrijvingen exact overeenkomen. Ze kunnen alleen afwijken van de cijfers die in de beschrijving worden vermeld. Gebruik de Get-NetAdapterAdvancedProperty cmdlet om ervoor te zorgen dat de gerapporteerde configuratie dezelfde eigenschapswaarden bevat.

Zie de volgende tabel voor een voorbeeld van de interfacebeschrijvingen die alleen afwijken per numeriek (#):

| Naam | Interfacebeschrijving | Snelheid van koppeling |

|---|---|---|

| NIC1 | Netwerkadapter 1 | 25 Gbps |

| NIC2 | Netwerkadapter 2 | 25 Gbps |

| NIC3 | Netwerkadapter 3 | 25 Gbps |

| NIC4 | Netwerkadapter 4 | 25 Gbps |

Notitie

SET ondersteunt alleen switchonafhankelijke configuratie met behulp van dynamische of Hyper-V-poorttaakverdelingsalgoritmen. Voor de beste prestaties wordt Hyper-V Port aanbevolen voor gebruik op alle NIC's met minimaal 10 Gbps. Netwerk-ATC maakt alle vereiste configuraties voor SET.

Overwegingen voor RDMA-verkeer

Als u DCB implementeert, moet u ervoor zorgen dat de PFC- en ETS-configuratie correct wordt geïmplementeerd op elke netwerkpoort, inclusief netwerkswitches. DCB is vereist voor RoCE en optioneel voor iWARP.

Voor gedetailleerde informatie over het implementeren van RDMA downloadt u het document uit de SDN GitHub-opslagplaats.

Lokale Implementaties van Azure op basis van RoCE vereisen de configuratie van drie PFC-verkeersklassen, waaronder de standaardverkeersklasse, in de infrastructuur en alle hosts.

Systeemverkeersklasse

Deze verkeersklasse zorgt ervoor dat er voldoende bandbreedte is gereserveerd voor heartbeats van het systeem:

- Vereist: Ja

- PFC ingeschakeld: Nee

- Aanbevolen verkeersprioriteit: Prioriteit 7

- Aanbevolen bandbreedtereservering:

- 10 GbE of minder RDMA-netwerken = 2 procent

- 25 GbE of hoger RDMA-netwerken = 1 procent

RDMA-verkeersklasse

Deze verkeersklasse zorgt ervoor dat er voldoende bandbreedte is gereserveerd voor verliesloze RDMA-communicatie met behulp van SMB Direct:

- Vereist: Ja

- PFC ingeschakeld: Ja

- Aanbevolen verkeersprioriteit: prioriteit 3 of 4

- Aanbevolen bandbreedtereservering: 50 procent

Standaard verkeersklasse

Deze verkeersklasse bevat al het andere verkeer dat niet is gedefinieerd in de systeem- of RDMA-verkeersklassen, inclusief VM-verkeer en beheerverkeer:

- Vereist: Standaard (geen configuratie vereist op de host)

- Stroombeheer (PFC) ingeschakeld: Nee

- Aanbevolen verkeersklasse: Standaard (Prioriteit 0)

- Aanbevolen bandbreedtereservering: standaard (geen hostconfiguratie vereist)

Modellen voor opslagverkeer

SMB biedt veel voordelen als het opslagprotocol voor Azure Local, inclusief SMB Multichannel. SMB Multichannel wordt niet behandeld in dit artikel, maar het is belangrijk om te begrijpen dat verkeer wordt gemultiplexeerd over elke mogelijke koppeling die SMB Multichannel kan gebruiken.

Notitie

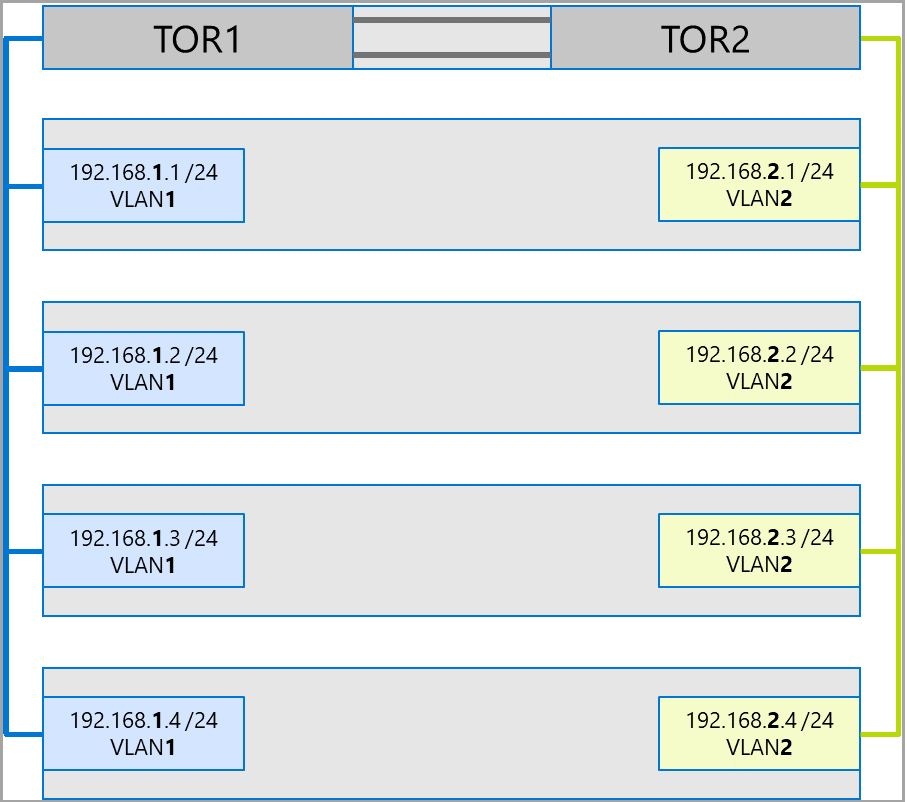

U wordt aangeraden meerdere subnetten en VLAN's te gebruiken om opslagverkeer in Azure Local te scheiden.

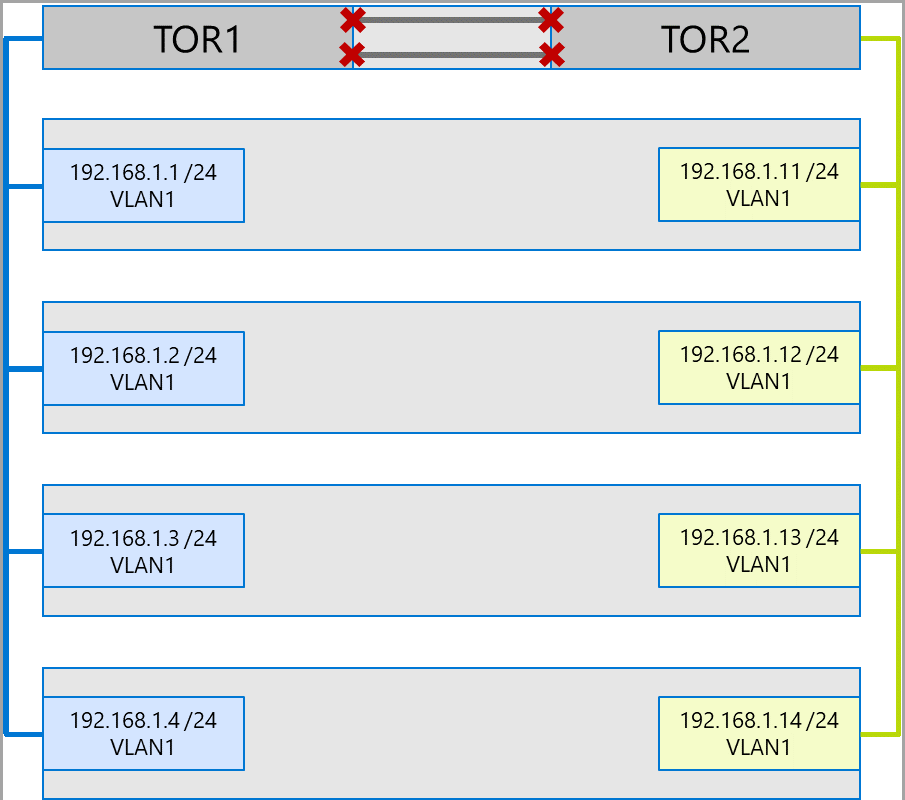

Bekijk het volgende voorbeeld van een systeem met vier knooppunten. Elke machine heeft twee opslagpoorten (links en rechts). Omdat elke adapter zich op hetzelfde subnet en VLAN bevindt, verspreidt SMB Meerdere kanalen verbindingen over alle beschikbare koppelingen. Daarom maakt de linkerpoort op de eerste computer (192.168.1.1.1) een verbinding met de linkerpoort op de tweede computer (192.168.1.2). De rechterpoort op de eerste computer (192.168.1.12) maakt verbinding met de rechterpoort op de tweede computer. Vergelijkbare verbindingen worden tot stand gebracht voor de derde en vierde machines.

Dit creëert echter onnodige verbindingen en veroorzaakt congestie bij de interlink (multi-chassis linkaggregatiegroep of MC-LAG) die de ToR-switches verbindt (gemarkeerd met Xs). Zie het volgende diagram:

De aanbevolen aanpak is het gebruik van afzonderlijke subnetten en VLAN's voor elke set adapters. In het volgende diagram gebruiken de rechterpoorten nu subnet 192.168.2.x /24 en VLAN2. Hierdoor kan het verkeer op de linkerpoorten op TOR1 blijven en het verkeer op de rechterpoorten op TOR2 blijven.

Toewijzing van verkeersbandbreedte

In de volgende tabel ziet u voorbeeld van bandbreedtetoewijzingen van verschillende verkeerstypen, met behulp van algemene adaptersnelheden, in Azure Local. Houd er rekening mee dat dit een voorbeeld is van een geconvergeerde oplossing, waarbij alle verkeerstypen (compute, opslag en beheer) worden uitgevoerd via dezelfde fysieke adapters en worden gekoppeld met SET.

Omdat deze use case de meeste beperkingen vormt, vertegenwoordigt het een goede basislijn. Gezien de permutaties voor het aantal adapters en snelheden moet dit echter worden beschouwd als een voorbeeld en niet als ondersteuningsvereiste.

In dit voorbeeld worden de volgende aannames gedaan:

Er zijn twee adapters per team.

SBL (Storage Bus Layer), CSV-verkeer (Cluster Shared Volume) en Hyper-V (livemigratie):

- Gebruik dezelfde fysieke adapters.

- Gebruik SMB.

SMB krijgt een bandbreedtetoewijzing van 50 procent met behulp van DCB.

- SBL/CSV is het hoogste prioriteitsverkeer en ontvangt 70 procent van de SMB-bandbreedtereservering.

- Livemigratie (LM) wordt beperkt door het gebruik van de

Set-SMBBandwidthLimitcmdlet en ontvangt 29 procent van de resterende bandbreedte.Als de beschikbare bandbreedte voor livemigratie = 5 Gbps is >en de netwerkadapters geschikt zijn, gebruikt u RDMA. Gebruik de volgende cmdlet om dit te doen:

Set-VMHost -VirtualMachineMigrationPerformanceOption SMBAls de beschikbare bandbreedte voor livemigratie minder dan 5 Gbps is <, gebruik dan compressie om de uitvaltijden te verminderen. Gebruik de volgende cmdlet om dit te doen:

Set-VMHost -VirtualMachineMigrationPerformanceOption Compression

Als u RDMA gebruikt voor livemigratieverkeer, moet u ervoor zorgen dat livemigratieverkeer niet de volledige bandbreedte kan verbruiken die is toegewezen aan de RDMA-verkeersklasse met behulp van een SMB-bandbreedtelimiet. Wees voorzichtig, omdat deze cmdlet invoer in bytes per seconde (bps) accepteert, terwijl netwerkadapters worden vermeld in bits per seconde (bps). Gebruik de volgende cmdlet om een bandbreedtelimiet van 6 Gbps in te stellen, bijvoorbeeld:

Set-SMBBandwidthLimit -Category LiveMigration -BytesPerSecond 750MBNotitie

In dit voorbeeld zijn 750 MBps gelijk aan 6 Gbps.

Hier volgt de voorbeeldtabel voor bandbreedtetoewijzing:

| NIC-snelheid | Gebundelde bandbreedte | SMB-bandbreedte-reservering** | SBL/CSV % | SBL/CSV-bandbreedte | Percentage livemigratie | Maximale bandbreedte voor livemigratie | Hartslag % | Hartslagbandbreedte |

|---|---|---|---|---|---|---|---|---|

| 10 Gbps | 20 Gbps | 10 Gbps | 70% | 7 Gbps | * | 200 Mbps | ||

| 25 Gbps | 50 Gbps | 25 Gbps | 70% | 17,5 Gbps | 29% | 7,25 Gbps | 1% | 250 Mbps |

| 40 Gbps | 80 Gbps | 40 Gbps | 70% | 28 Gbps | 29% | 11,6 Gbps | 1% | 400 Mbps |

| 50 Gbps | 100 Gbps | 50 Gbps | 70% | 35 Gbps | 29% | 14,5 Gbps | 1% | 500 Mbps |

| 100 Gbps | 200 Gbps | 100 Gbps | 70% | 70 Gbps | 29% | 29 Gbps | 1% | 1 Gbps |

| 200 Gbps | 400 Gbps | 200 Gbps | 70% | 140 Gbps | 29% | 58 Gbps | 1% | 2 Gbps |

* Gebruik compressie in plaats van RDMA, omdat de bandbreedte voor Live Migration-verkeer is vastgesteld op 5 Gbps<.

** 50 procent is een voorbeeld van een bandbreedtereservering.

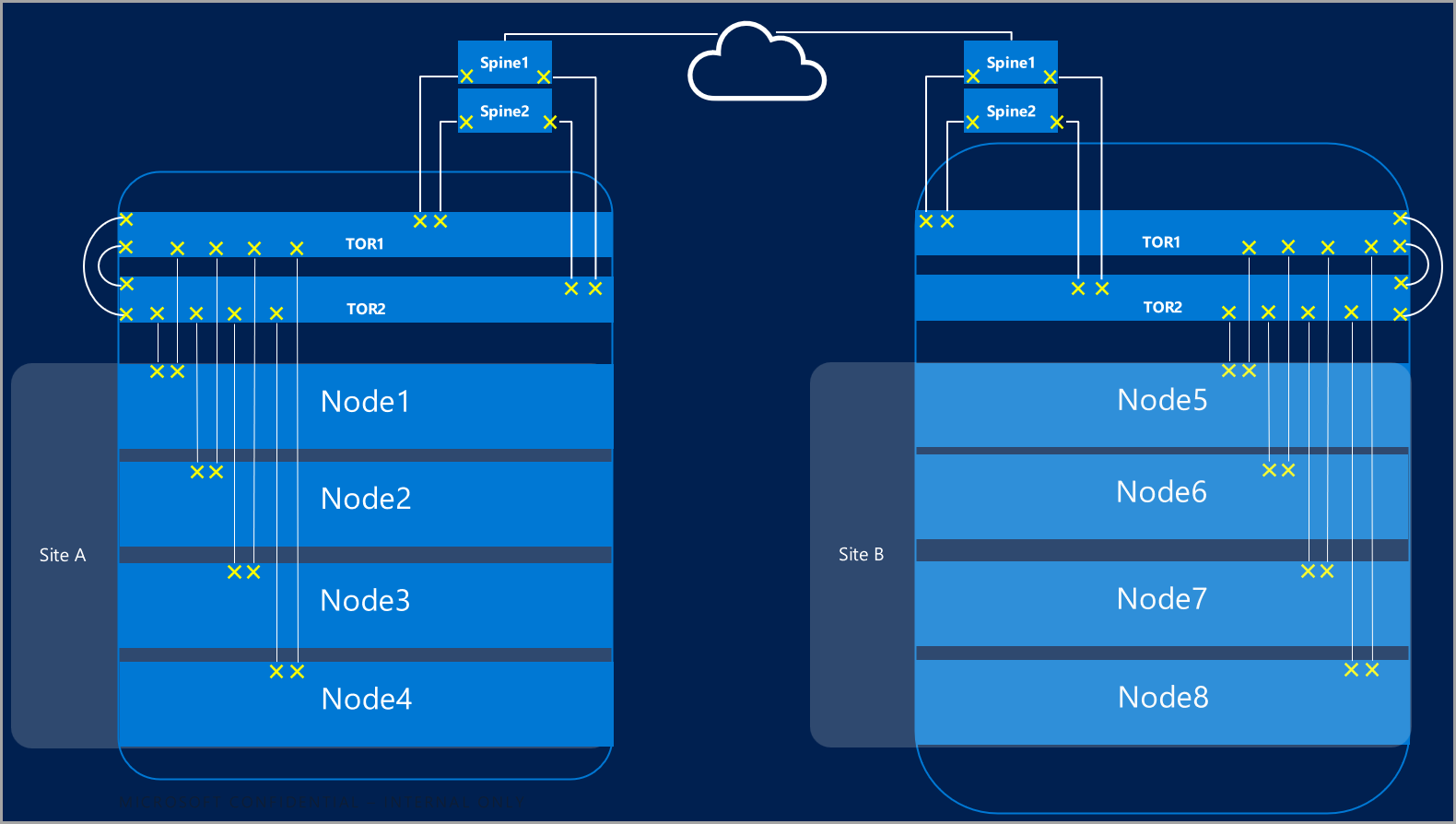

Uitgerekte clusters

Stretched clusters bieden herstel na noodgevallen die meerdere datacenters omvatten. In de eenvoudigste vorm ziet een stretched cluster van Azure Local er als volgt uit:

Vereisten voor stretched clusters

Belangrijk

Stretched-clusterfunctionaliteit is alleen beschikbaar in Azure Local, versie 22H2.

Stretched clusters hebben de volgende eisen en kenmerken:

RDMA is beperkt tot één site en wordt niet ondersteund op verschillende sites of subnetten.

Machines op dezelfde site moeten zich in hetzelfde rek en binnen dezelfde Layer-2-grens bevinden.

Hostcommunicatie tussen sites moet een grens van laag-3 overschrijden; stretched Layer-2-topologieën worden niet ondersteund.

Voldoende bandbreedte hebben om de werkbelastingen op de andere site uit te voeren. In het geval van een failover zal de alternatieve site al het verkeer afhandelen. U wordt aangeraden sites in te richten op 50 procent van de beschikbare netwerkcapaciteit. Dit is echter geen vereiste als u lagere prestaties tijdens een failover kunt tolereren.

Adapters die worden gebruikt voor communicatie tussen sites:

Kan fysiek of virtueel zijn (host-vNIC). Als adapters virtueel zijn, moet u één vNIC inrichten in een eigen subnet en VLAN per fysieke NIC.

Moet zich op hun eigen subnet en VLAN bevinden die tussen sites kunnen worden gerouteerd.

RDMA moet worden uitgeschakeld met behulp van de

Disable-NetAdapterRDMAcmdlet. U wordt aangeraden om opslagreplica expliciet te vereisen voor het gebruik van specifieke interfaces met behulp van deSet-SRNetworkConstraintcmdlet.Moet voldoen aan eventuele aanvullende vereisten voor Opslagreplica.

Volgende stappen

- Meer informatie over netwerkswitch en fysieke netwerkvereisten. Zie de vereisten voor het fysieke netwerk.

- Meer informatie over het vereenvoudigen van hostnetwerken met behulp van Network ATC. Zie Hostnetwerken vereenvoudigen met Network ATC.

- Werk u bij over de basisbeginselen van netwerken voor failoverclustering.

- Zie Implementeren met behulp van Azure Portal.

- Zie Implementeren met behulp van een Azure Resource Manager-sjabloon.