Quickstart: Azure AI Content Safety Studio

In dit artikel wordt uitgelegd hoe u aan de slag gaat met de Azure AI Content Safety-service met behulp van Content Safety Studio in uw browser.

Let op

Een deel van de voorbeeldinhoud van Content Safety Studio kan aanstootgevend zijn. Voorbeeldafbeeldingen zijn standaard wazig. Gebruikers discretie wordt geadviseerd.

Vereisten

- Een Azure-account. Als u geen account hebt, kunt u er gratis een maken.

- Een Azure-resource voor inhoudsveiligheid .

- Wijs de rol Cognitive Services-gebruiker toe aan uw account. Ga naar Azure Portal, navigeer naar uw Content Safety-resource of Azure AI Services-resource en selecteer Toegangsbeheer in de linkernavigatiebalk, selecteer + Roltoewijzing toevoegen, kies de rol Cognitive Services-gebruiker en selecteer het lid van uw account waaraan u deze rol wilt toewijzen, controleer en wijs deze vervolgens toe. Het kan enkele minuten duren voordat de opdracht van kracht wordt.

- Meld u aan bij Content Safety Studio met uw Azure-abonnement en Content Safety-resource.

Belangrijk

U moet de rol Cognitive Services-gebruiker toewijzen aan uw Azure-account om de studio-ervaring te kunnen gebruiken. Ga naar Azure Portal, navigeer naar uw Content Safety-resource of Azure AI Services-resource en selecteer Toegangsbeheer in de linkernavigatiebalk, selecteer + Roltoewijzing toevoegen, kies de rol Cognitive Services-gebruiker en selecteer het lid van uw account waaraan u deze rol wilt toewijzen, controleer en wijs deze vervolgens toe. Het kan enkele minuten duren voordat de opdracht van kracht wordt.

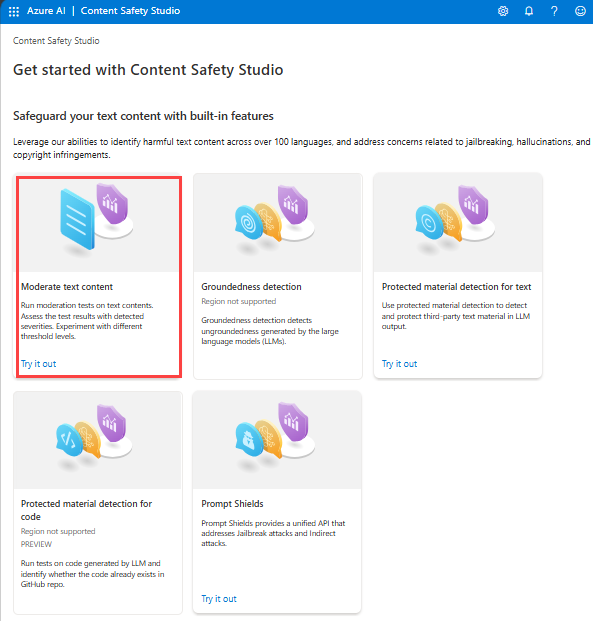

Inhoud van tekst analyseren

De inhoudspagina Gemiddelde tekst biedt u de mogelijkheid om snel tekstbeheer uit te proberen.

- Selecteer het deelvenster Tekst beheren .

- Voeg tekst toe aan het invoerveld of selecteer voorbeeldtekst in de deelvensters op de pagina.

Tip

Tekstgrootte en granulariteit: Zie invoervereisten voor maximale tekstlengtebeperkingen.

- Selecteer Test uitvoeren.

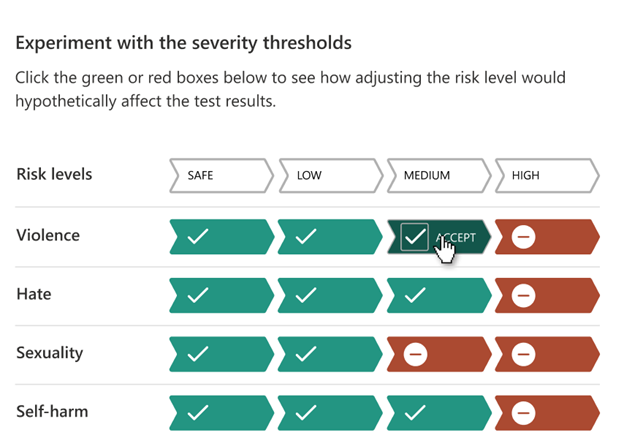

De service retourneert alle categorieën die zijn gedetecteerd, met het ernstniveau voor elk: 0-Safe, 2-Laag, 4-Gemiddeld, 6-Hoog. Het retourneert ook een binair geaccepteerd/geweigerd resultaat, op basis van de filters die u configureert. Gebruik de matrix op het tabblad Filters configureren om de toegestane/verboden ernstniveaus voor elke categorie in te stellen. Vervolgens kunt u de tekst opnieuw uitvoeren om te zien hoe het filter werkt.

Op het tabblad Bloklijst gebruiken kunt u een bloklijst maken, bewerken en toevoegen aan de beheerwerkstroom. Als u een blokkeringslijst hebt ingeschakeld wanneer u de test uitvoert, krijgt u een detectievenster voor de bloklijst onder Resultaten. Het rapporteert overeenkomsten met de blokkeringslijst.

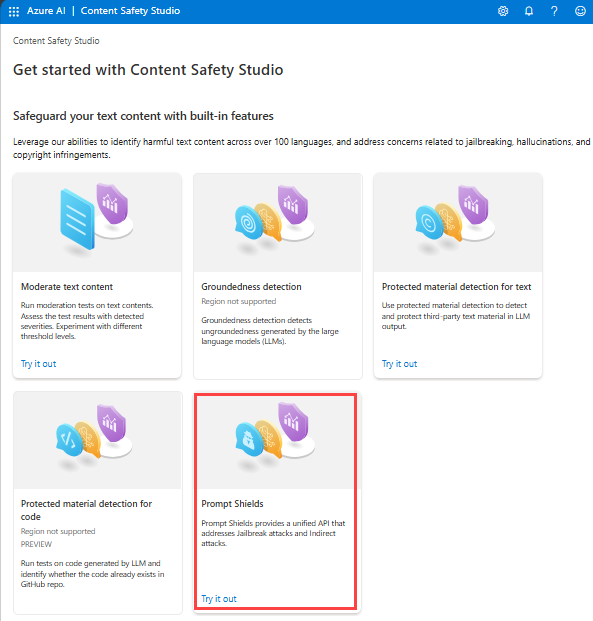

Gebruikersinvoeraanvallen detecteren

In het deelvenster Prompt Shields kunt u de detectie van gebruikersinvoerrisico's uitproberen. Detecteer gebruikersprompts die zijn ontworpen om het Generatieve AI-model uit te lokken in gedrag dat is getraind om de regels die zijn ingesteld in het systeembericht te voorkomen of te verbreken. Deze aanvallen kunnen variëren van ingewikkeld rollenspel tot subtiele subversie van de veiligheidsdoelstelling.

- Selecteer het deelvenster Prompt Shields .

- Selecteer een voorbeeldtekst op de pagina of voer uw eigen inhoud in voor het testen. U kunt ook een CSV-bestand uploaden om een batchtest uit te voeren.

- Selecteer Test uitvoeren.

De service retourneert de risicovlag en het type voor elk voorbeeld.

Zie de conceptuele handleiding Prompt Shields voor meer informatie.

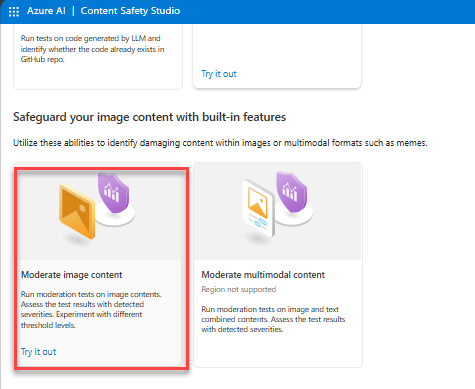

Inhoud van afbeelding analyseren

De pagina Inhoud van de moderate-afbeelding biedt u de mogelijkheid om snel afbeeldingsbeheer uit te proberen.

- Selecteer het deelvenster Afbeeldingsinhoud beheren.

- Selecteer een voorbeeldafbeelding in de panelen op de pagina of upload uw eigen afbeelding. De maximale grootte voor het indienen van afbeeldingen is 4 MB en de afmetingen van de afbeelding moeten tussen 50 x 50 pixels en 2048 x 2048 pixels zijn. Afbeeldingen kunnen een JPEG-, PNG-, GIF-, BMP-, TIFF- of WEBP-indeling hebben.

- Selecteer Test uitvoeren.

De service retourneert alle categorieën die zijn gedetecteerd, met het ernstniveau voor elk: 0-Safe, 2-Laag, 4-Gemiddeld, 6-Hoog. Het retourneert ook een binair geaccepteerd/geweigerd resultaat, op basis van de filters die u configureert. Gebruik de matrix op het tabblad Filters configureren aan de rechterkant om de toegestane/verboden ernstniveaus voor elke categorie in te stellen. Vervolgens kunt u de tekst opnieuw uitvoeren om te zien hoe het filter werkt.

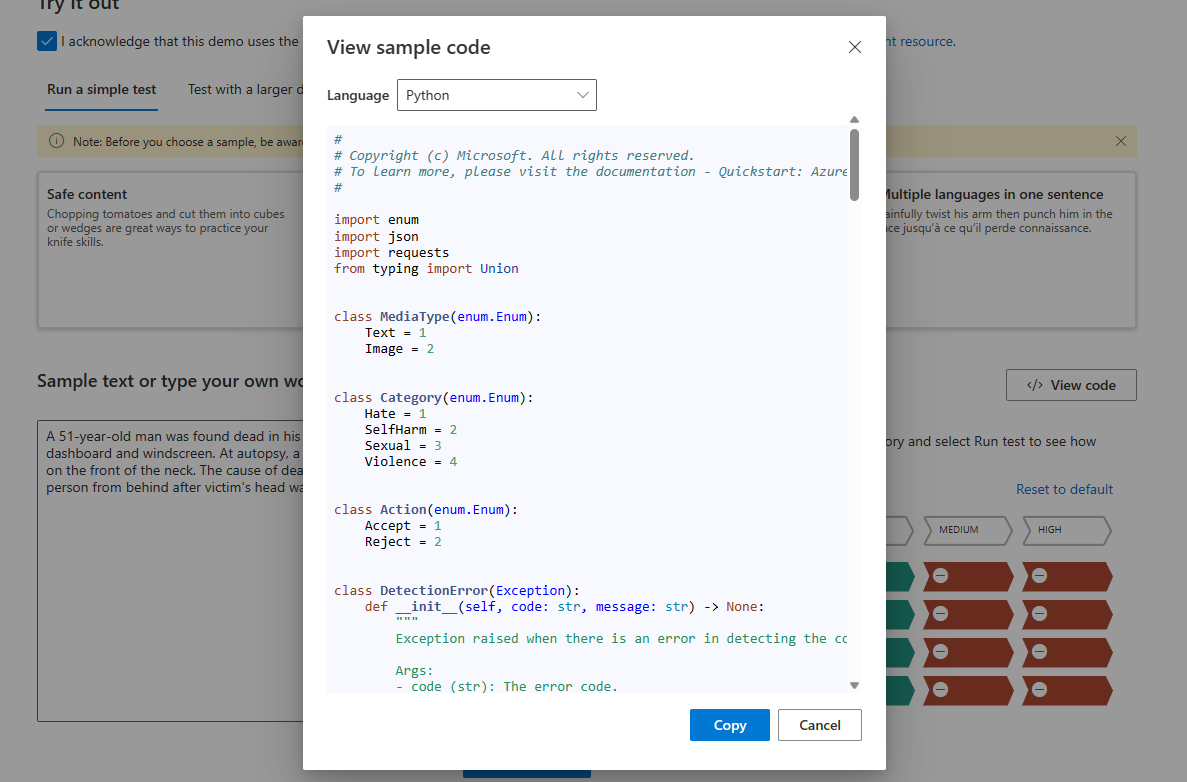

Code weergeven en exporteren

U kunt de functie Code weergeven gebruiken op de pagina's Tekst analyseren of Inhoudspagina's van afbeeldingen analyseren om de voorbeeldcode weer te geven en te kopiëren, waaronder configuratie voor ernstfilters, bloklijsten en toezichtfuncties. Vervolgens kunt u de code aan uw kant implementeren.

Onlineactiviteit bewaken

In het deelvenster Onlineactiviteiten bewaken kunt u uw API-gebruik en -trends bekijken.

U kunt kiezen welk mediatype u wilt bewaken. U kunt ook het tijdsbereik opgeven dat u wilt controleren door Gegevens weergeven te selecteren voor de laatste __.

In het diagram Percentage weigeren per categorie kunt u ook de ernstdrempels voor elke categorie aanpassen.

U kunt ook geblokkeerde lijst bewerken als u bepaalde termen wilt wijzigen, op basis van de grafiek met geblokkeerde termen in de top 10.

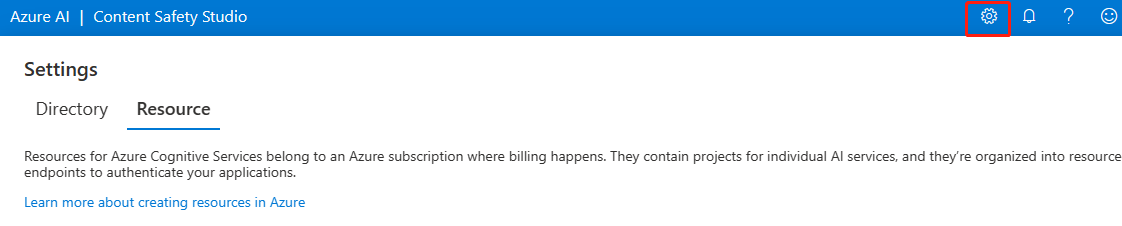

Uw resource beheren

Als u resourcedetails zoals de naam en prijscategorie wilt weergeven, selecteert u het pictogram Instellingen in de rechterbovenhoek van de startpagina van Content Safety Studio en selecteert u het tabblad Resource . Als u andere resources hebt, kunt u hier ook schakelen tussen resources.

Resources opschonen

Als u een Azure AI-servicesresource wilt opschonen en verwijderen, kunt u de resource of resourcegroep verwijderen. Als u de resourcegroep verwijdert, worden ook alle bijbehorende resources verwijderd.

Volgende stap

Ga vervolgens aan de slag met Azure AI Content Safety via de REST API's of een client-SDK, zodat u de service naadloos in uw toepassing kunt integreren.