Modellen die worden ondersteund door Azure AI Agent Service

Agents worden mogelijk gemaakt door een diverse set modellen met verschillende mogelijkheden en prijspunten. De beschikbaarheid van modellen verschilt per regio en cloud. Voor bepaalde hulpprogramma's en mogelijkheden zijn de nieuwste modellen vereist. De volgende modellen zijn beschikbaar in de beschikbare SDK's. De volgende tabel is voor betalen per gebruik. Zie de ingerichte doorvoer in de Documentatie van Azure OpenAI voor informatie over de beschikbaarheid van ingerichte doorvoereenheden (PTU). U kunt globale standaardmodellen gebruiken als ze worden ondersteund in de regio's die hier worden vermeld.

Azure OpenAI-modellen

Azure AI Agent Service ondersteunt in de volgende regio's dezelfde modellen als de API voor het voltooien van chats in Azure OpenAI.

| Regio | gpt-4o, 2024-05-13 | gpt-4o, 2024-08-06 | gpt-4o-mini, 2024-07-18 | gpt-4, 0613 | gpt-4, 1106-Preview | gpt-4, 0125-Preview | gpt-4, turbo-2024-04-09 | gpt-4-32k, 0613 | gpt-35-turbo, 0613 | gpt-35-turbo, 1106 | gpt-35-turbo, 0125 | gpt-35-turbo-16k, 0613 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| eastus | ✅ | ✅ | ✅ | - | - | ✅ | ✅ | - | ✅ | - | ✅ | ✅ |

| francecentral | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | - | ✅ |

| japaneast | - | - | - | - | - | - | - | - | ✅ | - | ✅ | ✅ |

| uksouth | - | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ |

| westus | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | ✅ | ✅ | - |

Meer modellen

De Azure AI Agent Service ondersteunt ook de volgende modellen uit de Azure AI Foundry-modelcatalogus.

- Llama 3.1-70B-instruct

- Mistral-large-2407

- Cohere-opdracht R+

Als u deze modellen wilt gebruiken, kunt u de Azure AI Foundry-portal gebruiken om een implementatie te maken en ernaar te verwijzen in uw agent.

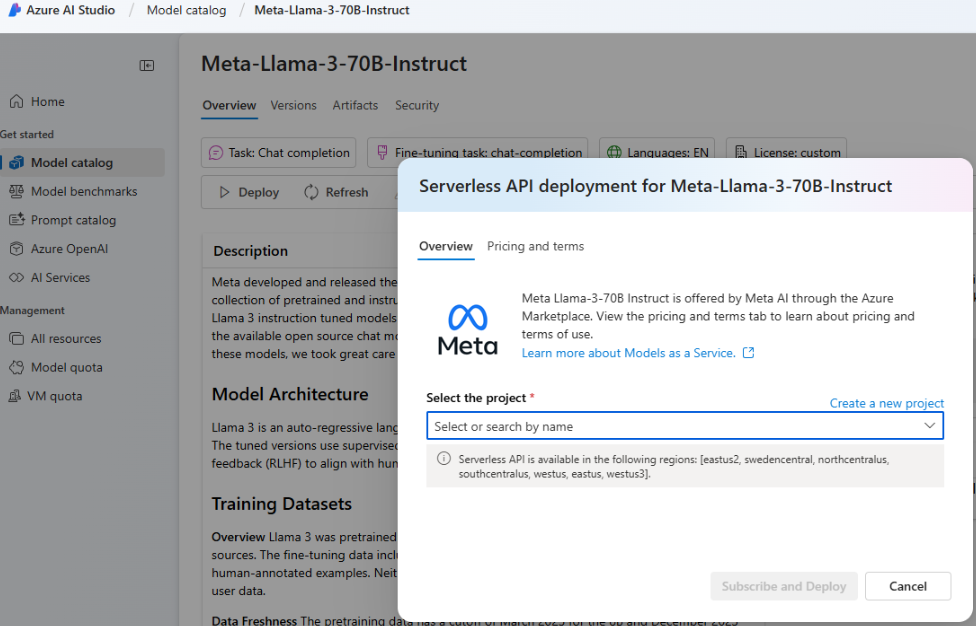

Ga naar de Azure AI Foundry-portal en selecteer Modelcatalogus in het linkernavigatiemenu en schuif omlaag naar Meta-Llama-3-70B-Instruct. U kunt ook een van de eerder vermelde modellen vinden en gebruiken.

Selecteer Implementeren.

Selecteer serverloze API met Azure AI Content Safety in het scherm Implementatieopties dat wordt weergegeven.

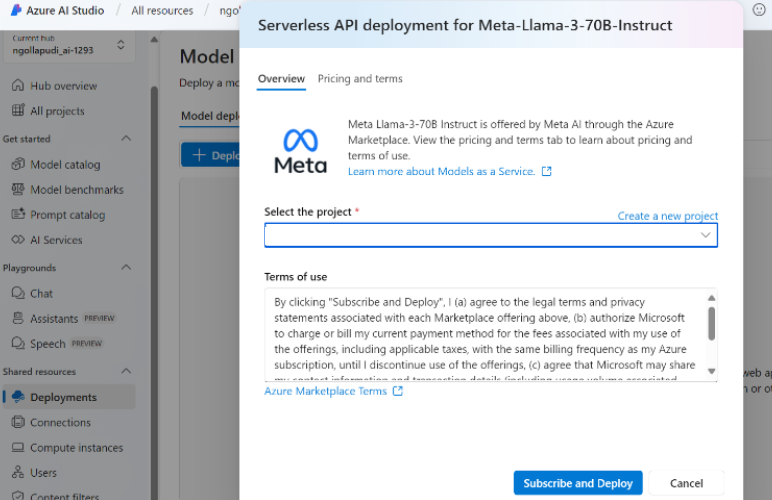

Selecteer uw project en selecteer vervolgens Abonneren en implementeren.

Voeg de serverloze verbinding toe aan uw hub/project. De implementatienaam die u kiest, is de naam waarnaar u in uw code verwijst.

Wanneer u de API voor het maken van een agent aanroept, stelt u de parameter in op uw

modelsimplementatienaam. Voorbeeld: