Prisscenario ved hjelp av et datasamlebånd for å laste inn 1 TB parquetdata til et datalager

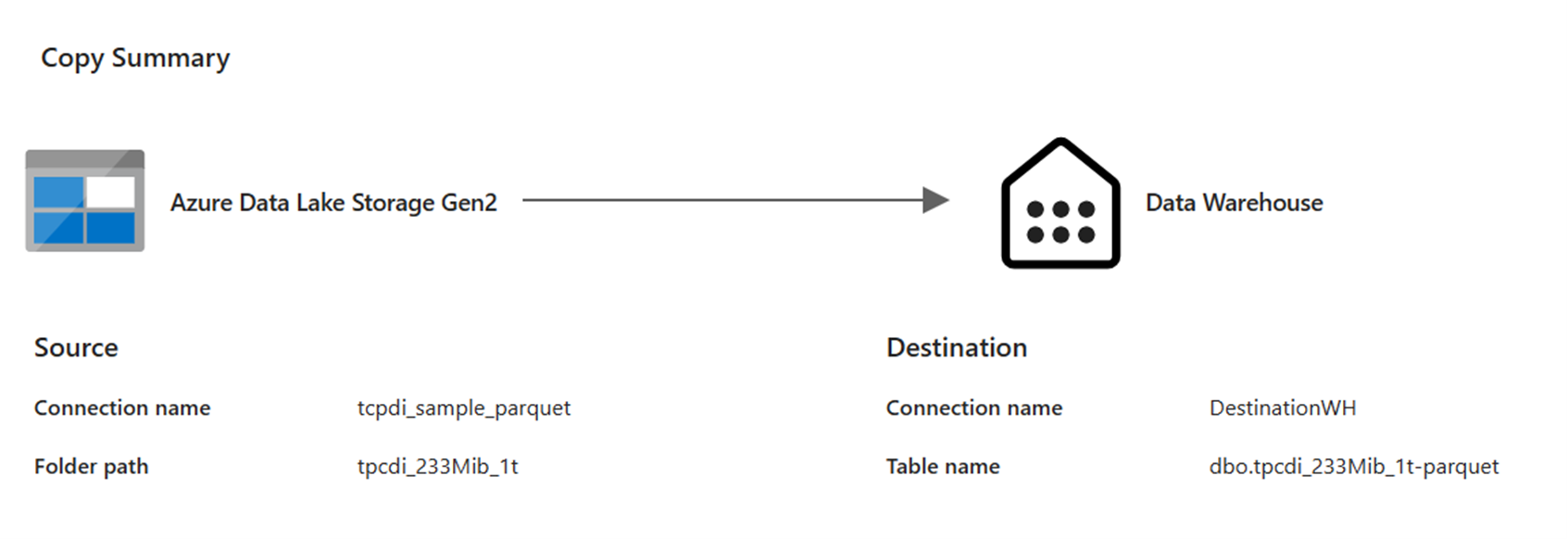

I dette scenarioet ble en Kopi-aktivitet brukt i et datasamlebånd til å laste inn 1 TB parquet-tabelldata lagret i Azure Data Lake Storage (ADLS) Gen2 til et datalager i Microsoft Fabric.

Prisene som brukes i eksemplet nedenfor, er hypotetiske og har ikke til hensikt å antyde nøyaktig faktiske priser. Dette er bare for å demonstrere hvordan du kan beregne, planlegge og administrere kostnader for Data Factory-prosjekter i Microsoft Fabric. Siden stoffkapasiteten er priset unikt på tvers av områder, bruker vi prissettingen for en Fabric-kapasitet på US West 2 (et typisk Azure-område) på USD 0,18 per CU per time. Se her til Microsoft Fabric – Priser for å utforske andre prisalternativer for fabric-kapasitet.

Konfigurasjon

Hvis du vil utføre dette scenarioet, må du opprette et datasamlebånd med følgende konfigurasjon:

Kostnadsberegning ved hjelp av Fabric Metrics App

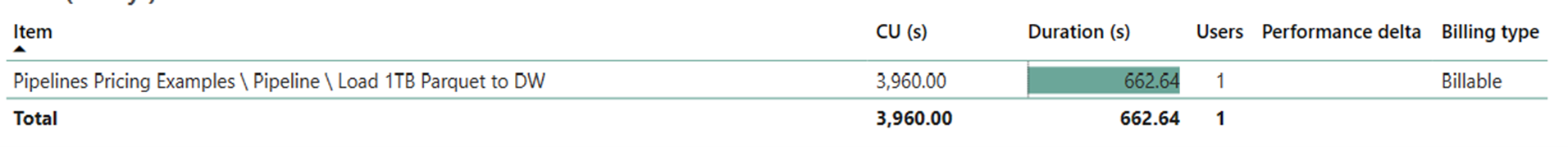

Dataflyttingsoperasjonen benyttet 3960 CU sekunder med en 662,64 sekunders varighet mens operasjonen for aktivitetskjøring var null, siden det ikke var noen ikke-kopierte aktiviteter i datasamlebåndkjøringen.

Merk

Selv om den rapporteres som en metrikkverdi, er ikke den faktiske varigheten av kjøringen relevant når du beregner de effektive CU-timene med Fabric Metrics App siden CU-sekunders måleverdien den også rapporterer allerede står for varigheten.

| Metric | Databevegelsesoperasjon |

|---|---|

| CU sekunder | 3 960 CU sekunder |

| Effektive CU-timer | (3960) / (60*60) CU-timer = 1,1 CU-timer |

Totale kjørekostnader på $0,18/CU-time = (1,1 CU-time) * ($0,18/CU-time) ~= $0,20