Overvåk kapasitetsforbruket til Apache Spark

Formålet med denne artikkelen er å gi veiledning for administratorer som ønsker å overvåke aktiviteter i kapasitetene de administrerer. Ved å bruke apache Spark-kapasitetsforbruksrapporter som er tilgjengelige i Microsoft Fabric Capacity Metrics-appen, kan administratorer få innsikt i det fakturerbare spark-kapasitetsforbruket for elementer, inkludert Lakehouse, Notebook og Apache Spark-jobbdefinisjoner. Noen spark-kapasitetsforbruksaktiviteter rapporteres ikke i appen.

Spark-kapasitetsforbruk rapportert

Følgende operasjoner fra lakehouses, notatblokker og Spark-jobbdefinisjoner behandles som fakturerbare aktiviteter.

| Operasjonsnavn | Vare | Kommentarer |

|---|---|---|

| Lakehouse operasjoner | Lakehouse | Brukere forhåndsviser tabell i Lakehouse Explorer. |

| Lakehouse bordbelastning | Lakehouse | Brukere laster inn deltatabellen i Lakehouse Explorer. |

| Notatblokkkjøring | Notatblokk | Notatblokken kjøres manuelt av brukere. |

| HC-kjøring for notatblokk | Notatblokk | Notatblokken kjører under Apache Spark-økten med høy samtidighet. |

| Planlagt kjøring av notatblokk | Notatblokk | Notatblokken kjøres utløst av planlagte hendelser i notatblokken. |

| Datasamlebånd for notatblokkkjøring | Notatblokk | Notatblokkkjøringer utløst av datasamlebånd. |

| Kjøring av NOTATBLOKK VS Code | Notatblokk | Notatblokken kjører i VS Code. |

| Spark jobbkjøring | Spark-jobbdefinisjon | Spark-satsvise jobbkjøringer startet av brukerinnsending. |

| Spark-jobb planlagt kjøring | Spark-jobbdefinisjon | Kjørselen kjører utløst av planlagte hendelser i notatblokken. |

| Spark jobbsamlebåndkjøring | Spark-jobbdefinisjon | Kjørselen kjører utløst av datasamlebånd. |

| Spark jobb VS Code kjøre | Spark-jobbdefinisjon | Spark-jobbdefinisjon sendt fra VS Code. |

Spark-kapasitetsforbruk som ikke er rapportert

Det finnes noen spark-kapasitetsforbruksaktiviteter som ikke rapporteres i måledataappen. Disse aktivitetene inkluderer system-Spark-jobber for biblioteksadministrasjon og bestemte system-Spark-jobber for Spark Live-pulje eller live-økter.

Bibliotekbehandling – Kapasitetsforbruket som er knyttet til bibliotekbehandling på arbeidsområdenivå, rapporteres ikke i måledataappen.

System Spark-jobber – Spark-kapasitetsforbruk som ikke er knyttet til en notatblokk, en Spark-jobbdefinisjon eller et lakehouse, er ikke inkludert i kapasitetsrapporteringen.

Rapporter om kapasitetsbruk

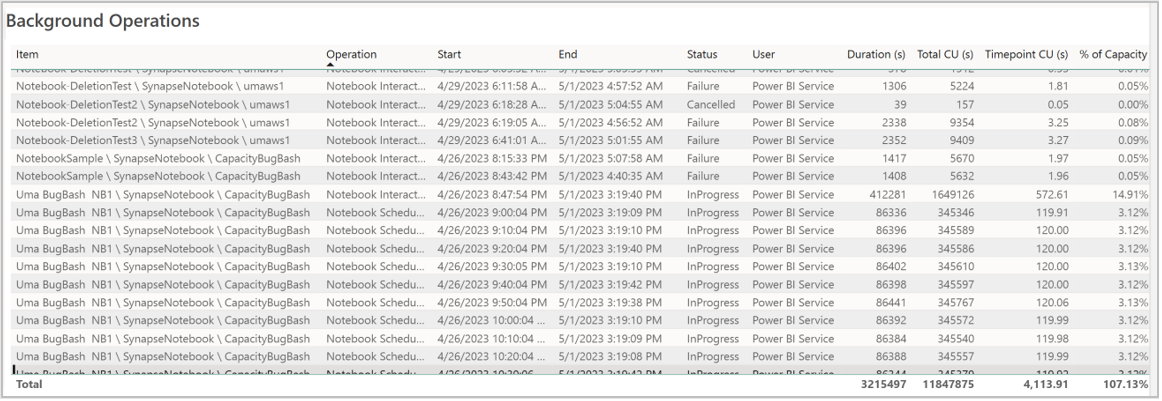

Alle Spark-relaterte operasjoner klassifiseres som bakgrunnsoperasjoner. Kapasitetsforbruk fra Spark vises under en notatblokk, en Spark-jobbdefinisjon eller et lakehouse, og aggregeres etter operasjonsnavn og element.

Rapport for bakgrunnsoperasjoner

Bakgrunnsoperasjoner vises for et bestemt tidspunkt. I rapportens tabell refererer hver rad til en brukeroperasjon. Se gjennom brukerkolonnen for å identifisere hvem som utførte en bestemt operasjon. Hvis du trenger mer informasjon om en bestemt operasjon, kan du bruke operasjons-ID-en til å slå den opp i overvåkingshuben for Microsoft Fabric.