Jobbopptak i Apache Spark for Microsoft Fabric

Gjelder for:✅ Dataingeniør ing og datavitenskap i Microsoft Fabric

Apache Spark for Fabric benytter den optimistiske jobbopptaksteknikken for å bestemme minimumskravet for Spark-jobber. Denne prosessen gjelder for interaktive eller satsvise jobber fra notatblokker, lakehouses eller Spark-jobbdefinisjoner. Det er avhengig av minimum nodeinnstillingen for det valgte Spark-utvalget i innstillingene for arbeidsområdet eller det tilknyttede miljøet. Hvis det finnes tilgjengelige kjerner i Fabric-kapasiteten som er knyttet til arbeidsområdet, godtas jobben og starter kjøringen. Jobber starter med minste nodeinnstilling og kan skaleres opp innenfor de maksimale nodegrensene i henhold til jobbfaser. Hvis de totale kjernene som brukes ved å kjøre jobber ved hjelp av Fabric-kapasiteten, er under de maksimale burst-kjernene som er tildelt, tillater jobbopptak og begrensningslag på Fabric Spark jobben å skalere opp.

Hvis du vil ha mer informasjon, kan du se Samtidighetsgrenser og kø i Microsoft Fabric Spark.

Hvordan fungerer optimistisk jobbopptak?

I Fabric leveres startbassenger med minimum én node, mens egendefinerte bassenger lar deg angi minimumsnoder basert på arbeidsbelastningsbehov. Autoskalering justerer beregningskravene for Spark-jobber under utførelsesfasene, innenfor de konfigurerte minimums- og maksimumsnodene. Optimistisk jobbopptak evaluerer jobbinnsendinger basert på tilgjengelige kjerner, og utfører dem med minimumskjerner. Jobber forsøker å vokse basert på maksimalt tildelte noder under kjøring. Oppskaleringsforespørsler godkjennes hvis totalt antall Spark-kjerner som brukes, er innenfor tildelte kapasitetsgrenser.

Merk

Hvis bruken når maksimumsgrensen og alle kjerner innenfor den totale kapasiteten for Fabric er i bruk, vil alle oppskaleringsforespørsler bli avslått. Aktive jobber må enten fullføres eller avbrytes for å frigjøre kjerner.

Hvordan påvirker dette samtidigheten av jobben?

Minimumskravet for hver jobb bestemmer om jobben kan godtas. Hvis kapasiteten er fullt ut utnyttet og ikke har noen kjerner igjen for å oppfylle en jobbs minste kjernebehov, blir jobben avvist. Interaktive notatblokkjobber eller Lakehouse-operasjoner blokkeres med en feilmelding som ikke kan sende inn denne forespørselen fordi all tilgjengelig kapasitet for øyeblikket brukes. Avbryt en jobb som kjører for øyeblikket, øk den tilgjengelige kapasiteten, eller prøv på nytt senere. Satsvise jobber kjøres i kø og utføres når kjerner blir tilgjengelige.

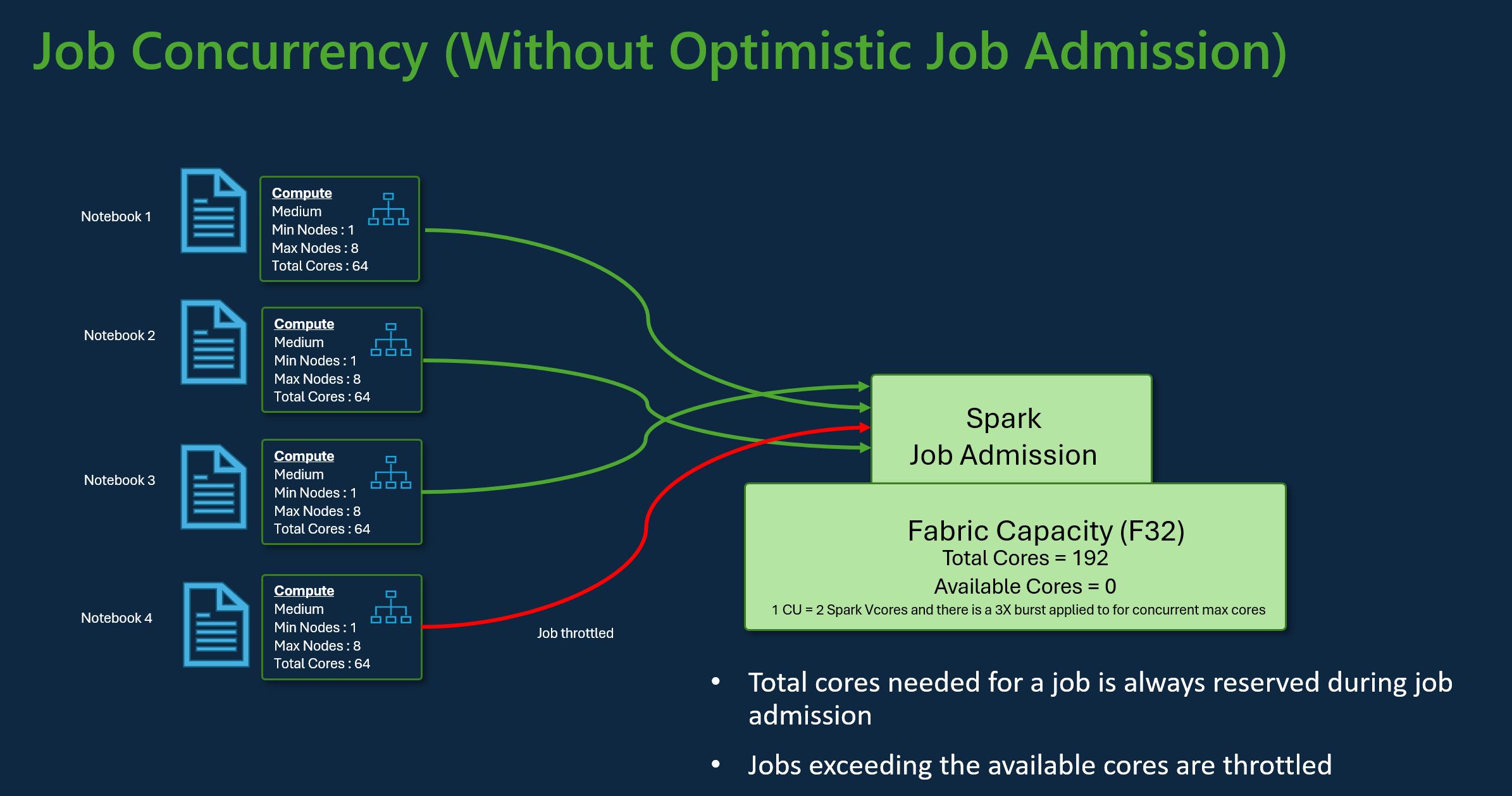

Vurder for eksempel et scenario med en bruker som bruker SKU-en for Fabric F32-kapasitet. Forutsatt at alle jobber bruker standard konfigurasjon av startutvalg uten optimistisk jobbopptak, vil kapasiteten støtte en maksimal samtidighet på tre jobber. Maksimalt antall kjerner per jobb tildeles i henhold til konfigurasjonen for maksimalt antall noder.

Med optimistisk jobbopptak med samme kapasitet som ovenfor, kan 24 jobber tas opp og utføres ved hjelp av minimum nodekonfigurasjon under maksimal samtidighetsscenario. Fordi hver jobb krever 8 Spark VCores der en minimum nodekonfigurasjon er av størrelse middels.

Skaler jobber med Autoskala for Spark

Når du aktiverer autoskala for Spark-bassenger, utføres jobber med minimum nodekonfigurasjon. Under kjøretid kan skalering forekomme. Disse forespørslene går gjennom jobbopptakskontrollen. Godkjente forespørsler skaleres opp til maksimumsgrensene basert på totalt tilgjengelige kjerner. Avviste forespørsler påvirker ikke aktive jobber. de fortsetter å kjøre med sin gjeldende konfigurasjon til kjernene blir tilgjengelige.

Merk

Hvis du vil sikre maksimal kjerneallokering for en jobb i henhold til konfigurasjonen for maksimale noder, deaktiverer du autoskala og angir maksimalt antall noder i SKU for fabric-kapasitet. I dette tilfellet, siden jobben ikke har noe minimumskjernekrav, vil den begynne å kjøre når gratis kjerner er tilgjengelige, og skalerer opp til den konfigurerte summen. Hvis kapasiteten er fullstendig brukt, kan interaktive notatblokkjobber reduseres eller legges i kø. Jobber i kø prøves automatisk etter hvert som kjerner blir tilgjengelige.

Relatert innhold

- Kom i gang med administrasjonsinnstillingene for Spark-arbeidsområdet i Microsoft Fabric.

- Lær om Spark-databehandling for stoffdatateknikk og datavitenskap.

- Mer informasjon om Samtidighet og køgrenser for Fabric Spark.