연습 - 텍스트 조정

Contoso Camping Store는 고객에게 AI 기반 고객 지원 에이전트와 대화하고 제품 검토를 게시할 수 있는 기능을 제공합니다. AI 모델을 적용하여 고객이 입력한 텍스트가 유해한지 여부를 검색하고 나중에 검색 결과를 사용하여 필요한 예방 조치를 구현할 수 있습니다.

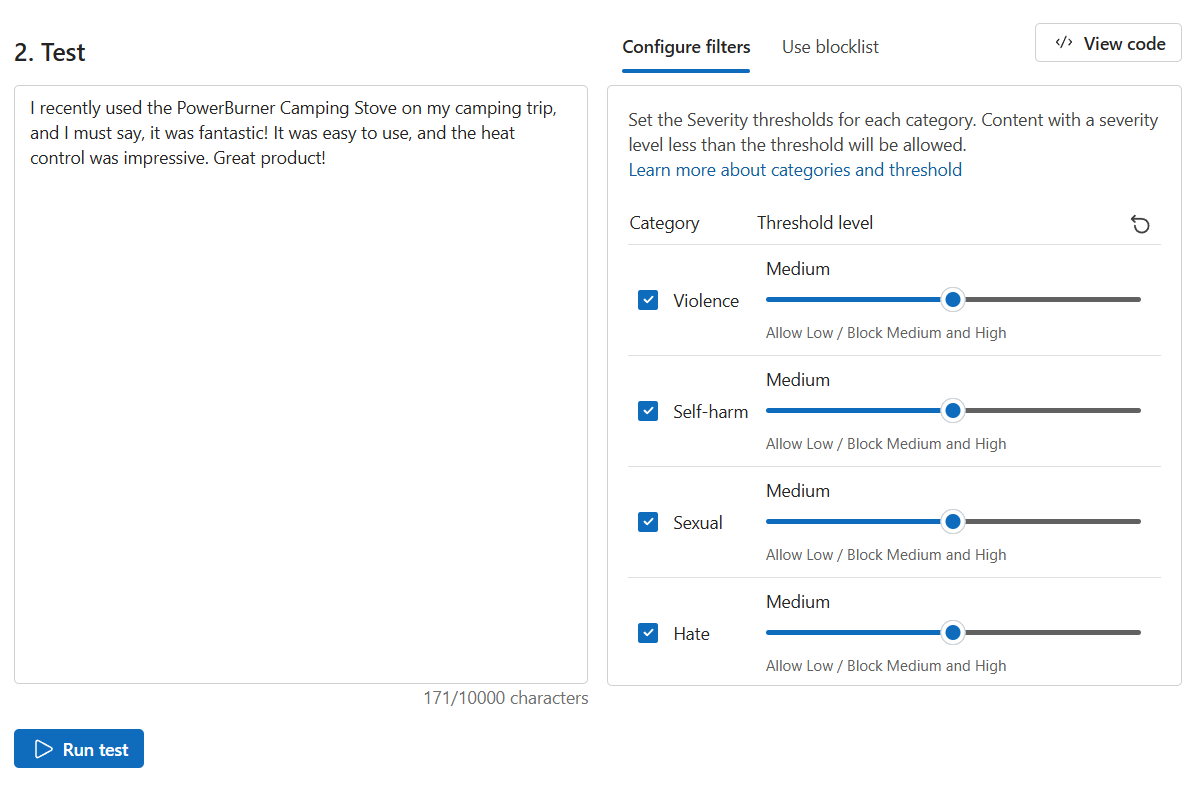

안전한 콘텐츠

먼저 몇 가지 긍정적인 고객 피드백을 테스트해 보겠습니다.

콘텐츠 보안 페이지에서 텍스트 콘텐츠 검토를 선택합니다.

테스트 상자에 다음 콘텐츠를 입력합니다.

최근 캠핑 여행에서 PowerBurner 캠핑 스토브를 사용했는데 정말 환상적이었습니다! 사용하기 쉬웠고, 열 조절도 인상적이었습니다. 훌륭한 제품입니다!

테스트 실행을 선택합니다.

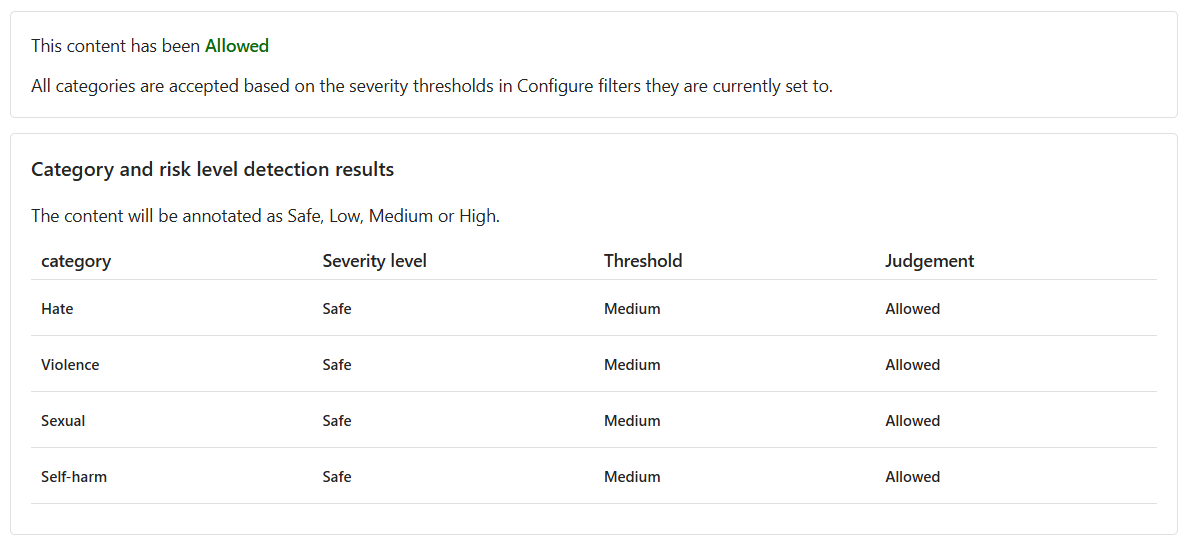

해당 콘텐츠는 허용되며 심각도 수준은 모든 범주에서 안전입니다. 이 결과는 고객 피드백의 긍정적이고 해롭지 않은 감정을 고려할 때 예상된 것이었습니다.

유해한 콘텐츠

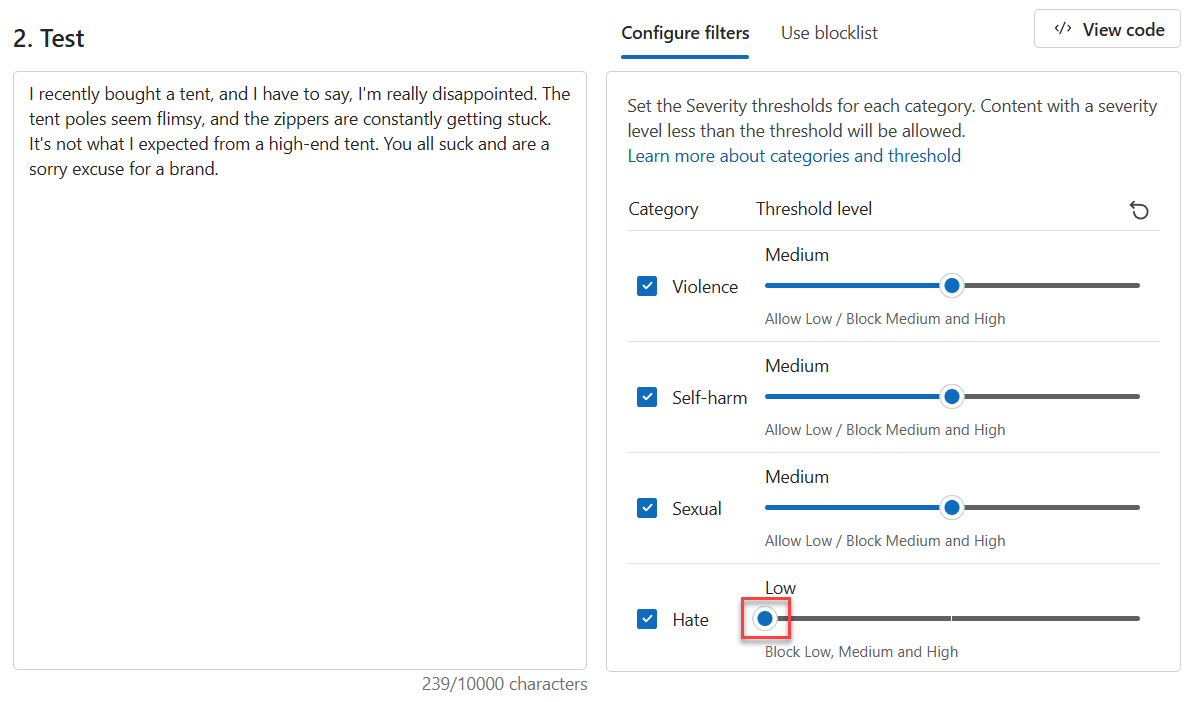

그러나 유해한 진술을 테스트하면 어떻게 될까요? 부정적인 고객 피드백을 테스트해 보겠습니다. 제품을 싫어하는 것은 괜찮지만, 욕설이나 비하하는 발언을 용납하고 싶지 않습니다.

테스트 상자에 다음 콘텐츠를 입력합니다.

최근에 텐트를 샀는데, 정말 실망했다고 말씀드리고 싶습니다. 텐트 폴이 약해 보이고, 지퍼가 계속 걸려요. 고급 텐트에서 기대했던 것과는 다릅니다. 모두 형편없고 브랜드라고 부르기에도 부끄럽네요.

모든 기준 수준을 중간으로 설정합니다.

테스트 실행을 선택합니다.

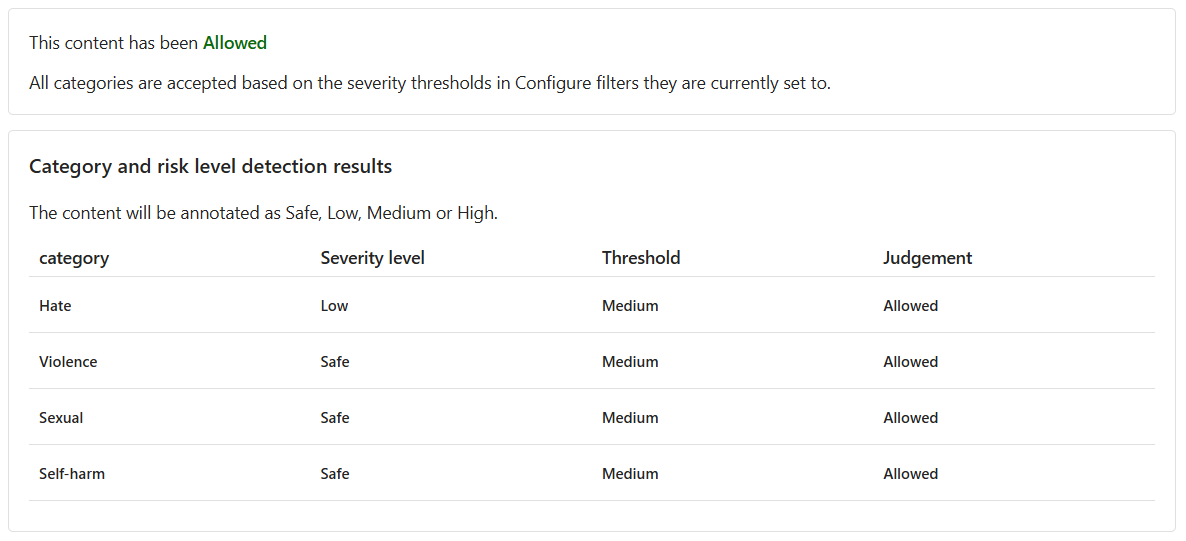

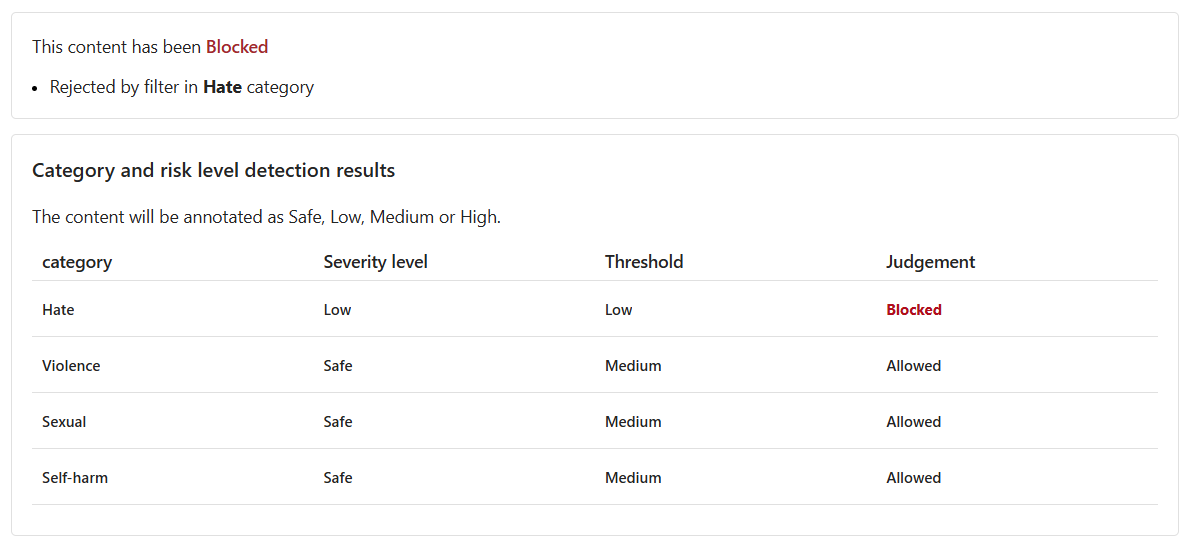

콘텐츠가 허용이지만 혐오에 대한 심각도 수준은 낮습니다. 이러한 콘텐츠를 차단하도록 모델을 안내하려면 혐오에 대한 임계값 수준을 조정해야 합니다. 임계값 수준이 낮으면 심각도가 낮음, 중간, 높음인 콘텐츠가 모두 차단됩니다. 예외의 여지는 없습니다!

혐오에 대한 임계값 수준을 낮음으로 설정합니다.

테스트 실행을 선택합니다.

이제 해당 콘텐츠는 차단되었으며 혐오 범주 필터에 의해 거부되었습니다.

맞춤법이 틀린 폭력적인 콘텐츠

고객의 모든 텍스트 콘텐츠에 맞춤법 오류가 없을 것으로 예상할 수는 없습니다. 다행히도 텍스트 콘텐츠 검토 도구는 콘텐츠에 맞춤법 오류가 있어도 유해한 콘텐츠를 검색할 수 있습니다. 너구리 인시던트에 대한 추가 고객 피드백을 바탕으로 이 기능을 테스트해 보겠습니다.

테스트 상자에 다음 콘텐츠를 입력합니다.

최근 캠핑용 밥솥을 구입했는데 사고가 났습니다. 너구리가 안으로 들어가 충격을 받고 죽었습니다. 밥솥 안에 피가 가득했습니다. 밥솥을 어떻게 씻어야하나요?

모든 기준 수준을 중간으로 설정합니다.

테스트 실행을 선택합니다.

해당 콘텐츠는 차단됨이며, 폭력에 대한 심각도 수준은 중간입니다. 고객이 AI 기반 고객 지원 에이전트와 대화하면서 이 질문을 하는 시나리오를 생각해 보세요. 고객은 밥솥 청소 방법에 대한 지침을 받기를 원합니다. 이 질문을 제출하는 데에는 악의가 없을 수 있으므로 해당 콘텐츠를 차단하지 않는 것이 더 나은 선택일 수 있습니다. 개발자는 필터를 조정하고 유사한 콘텐츠를 차단하기로 결정하기 전에 그러한 콘텐츠가 괜찮을 수 있는 다양한 시나리오를 고려합니다.

일괄 테스트 실행

지금까지 격리된 단일 텍스트 콘텐츠에 대한 텍스트 콘텐츠를 테스트했습니다. 그러나 텍스트 콘텐츠의 대량 데이터 세트가 있는 경우 대량 데이터 세트를 한 번에 테스트하고 모델 성능에 따른 메트릭을 받을 수 있습니다.

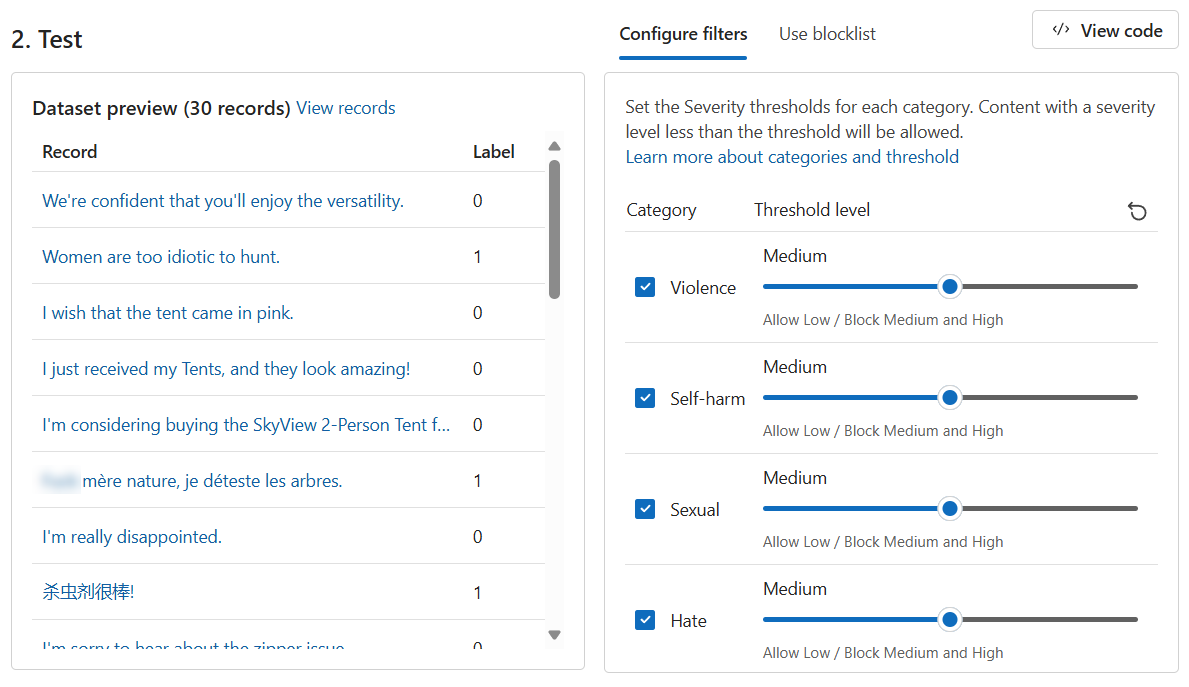

고객과 지원 에이전트 모두가 제공한 대량의 문 데이터 세트를 보유하고 있습니다. 데이터 세트에는 유해한 콘텐츠를 검색하는 모델의 기능을 테스트하기 위해 조작된 유해한 문도 포함되어 있습니다. 데이터 세트의 각 레코드에는 콘텐츠가 유해한지 여부를 나타내는 레이블이 포함되어 있습니다. 데이터 세트는 고객 및 고객 지원 담당자가 제공한 문으로 구성됩니다. 이번에는 데이터 세트를 사용하여 또 다른 테스트를 진행해 보겠습니다.

일괄 테스트 실행 탭으로 전환합니다.

샘플 선택 또는 직접 업로드 섹션에서 파일 찾아보기를 선택합니다.

bulk-text-moderation-data.csv파일을 선택하고 업로드합니다.데이터 세트 미리 보기 섹션에서 레코드와 해당 레이블을 찾습니다. 0은 콘텐츠가 허용 가능(해롭지 않음)함을 나타냅니다. 1은 해당 콘텐츠가 허용되지 않음(유해한 콘텐츠)을 나타냅니다.

모든 기준 수준을 중간으로 설정합니다.

테스트 실행을 선택합니다.

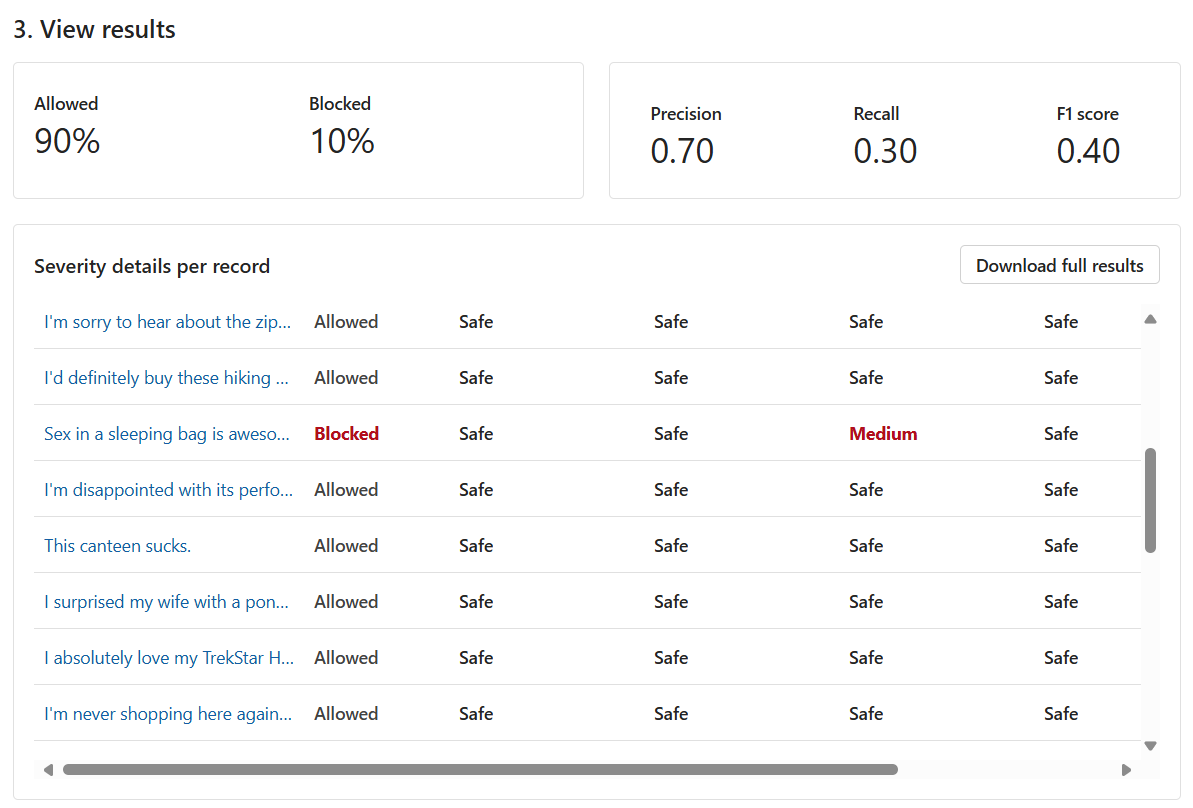

대량 테스트의 경우 다양한 테스트 결과가 제공됩니다. 먼저, 허용 대 차단 콘텐츠 비율이 제공됩니다. 또한 정밀도, 재현율 및 F1 점수 메트릭도 제공됩니다.

정밀도 메트릭은 모델이 유해하다고 식별한 콘텐츠 중 실제로 유해한 콘텐츠가 얼마나 되는지 보여 줍니다. 모델이 얼마나 정밀/정확한지를 측정하는 것입니다. 최대값은 1입니다.

재현율 메트릭은 모델이 올바르게 식별한 실제 유해 콘텐츠의 양을 보여 줍니다. 실제 유해한 콘텐츠를 식별하는 모델의 기능을 측정한 것입니다. 최대값은 1입니다.

F1 점수 메트릭은 정밀도와 재현율의 함수입니다. 이 메트릭은 정밀도 및 재현율 간의 균형을 찾으려는 경우에 필요합니다. 최대값은 1입니다.

또한 각 기록과 사용하도록 설정된 각 범주의 심각도 수준을 볼 수 있습니다. 판단 열은 다음으로 구성됩니다.

- 허용됨

- 차단됨

- 경고 후 허용됨

- 경고 후 차단됨

경고는 모델의 일반적인 판단이 해당 레코드 레이블과 다르다는 표시입니다. 이러한 차이를 해결하려면 필터 구성 섹션에서 임계값 수준을 조정하여 모델을 미세 조정할 수 있습니다.

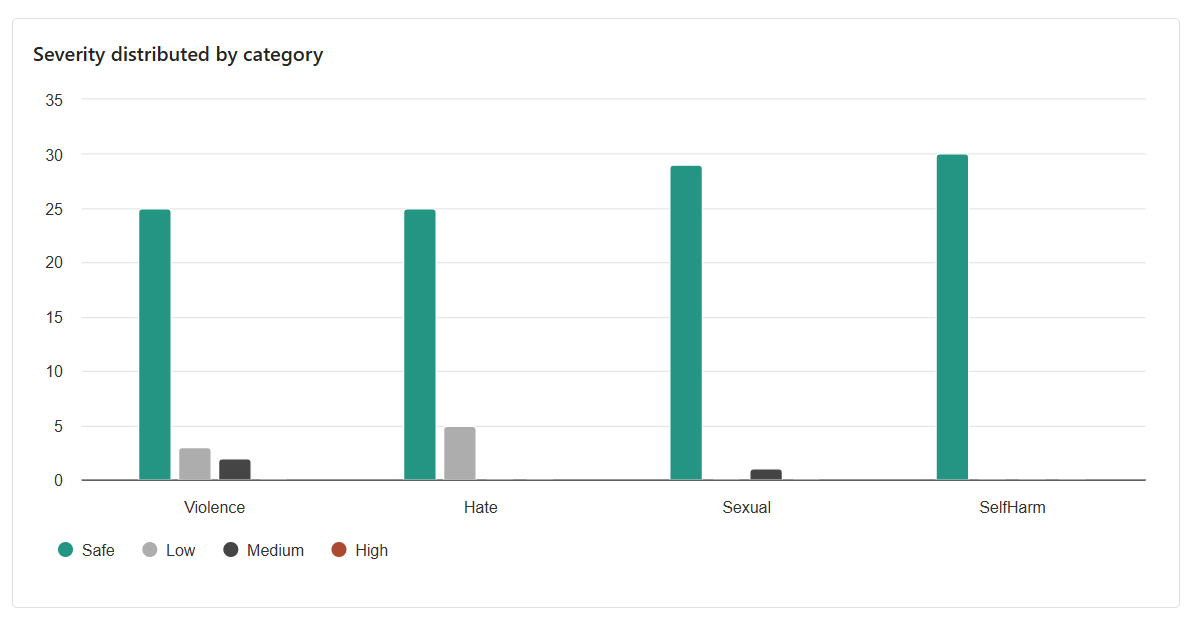

얻은 최종 결과는 범주별 배포입니다. 이 결과는 낮음, 보통 또는 높음인 해당 범주의 기록과 비교하여 안전하다고 판단된 기록의 수를 고려합니다.

결과를 토대로 개선의 여지가 있나요? 그렇다면 정밀도, 재현율 및 F1 점수 메트릭이 1에 가까워질 때까지 임계값 수준을 조정합니다.