데이터 수집 및 처리에 대한 설명

데이터 분석을 통해 데이터를 사용하고 해당 데이터에서 유의미한 정보와 추론을 찾을 수 있습니다. 이는 소매점에 적합한 제품 범위를 선택하거나 생명 공학 회사에 가장 적합한 백신 후보를 선택하는 것만큼 광범위합니다.

예를 들어 회사에서 데이터 분석은 조직에서 생성하는 데이터를 사용하여 조직이 어떻게 수행하고 있는지 그리고 비즈니스 성과를 유지하기 위해 무엇을 할 수 있는지에 대해 그림을 그리는 것일 수 있습니다. 데이터 분석을 통해 조직의 장점과 약점을 파악하고 적절한 비즈니스 결정을 내릴 수 있습니다.

회사에서 사용하는 데이터는 여러 원본에서 가져올 수 있습니다. 샅샅이 뒤져야 할 대량의 기록 데이터와 계속 도착하는 새로운 데이터가 늘 있을 수 있습니다. 이 데이터는 고객 구매, 은행 거래, 주식 가격 이동, 실시간 날씨 데이터, 모니터링 디바이스 또는 카메라에서 나온 결과일 수 있습니다. 데이터 분석 솔루션에서 이러한 데이터를 결합하여 비즈니스 운영에 대한 질문과 답변을 하는 데 사용할 수 있는 데이터 웨어하우스를 구성합니다. 데이터 웨어하우스를 빌드하려면 필요한 데이터를 캡처하여 적절한 형식으로 ‘랭글링’할 수 있어야 합니다. 그런 다음, 분석 도구 및 시각화를 사용하여 정보, ID 추세 및 해당 원인을 검토할 수 있습니다.

참고

‘랭글링’은 분석을 위해 원시 데이터를 더 유용한 형식으로 변환하고 매핑하는 프로세스입니다. 여기에는 여러 소스에서 데이터를 캡처, 필터링, 정리, 결합 및 집계하기 위한 코드를 작성하는 것이 포함될 수 있습니다.

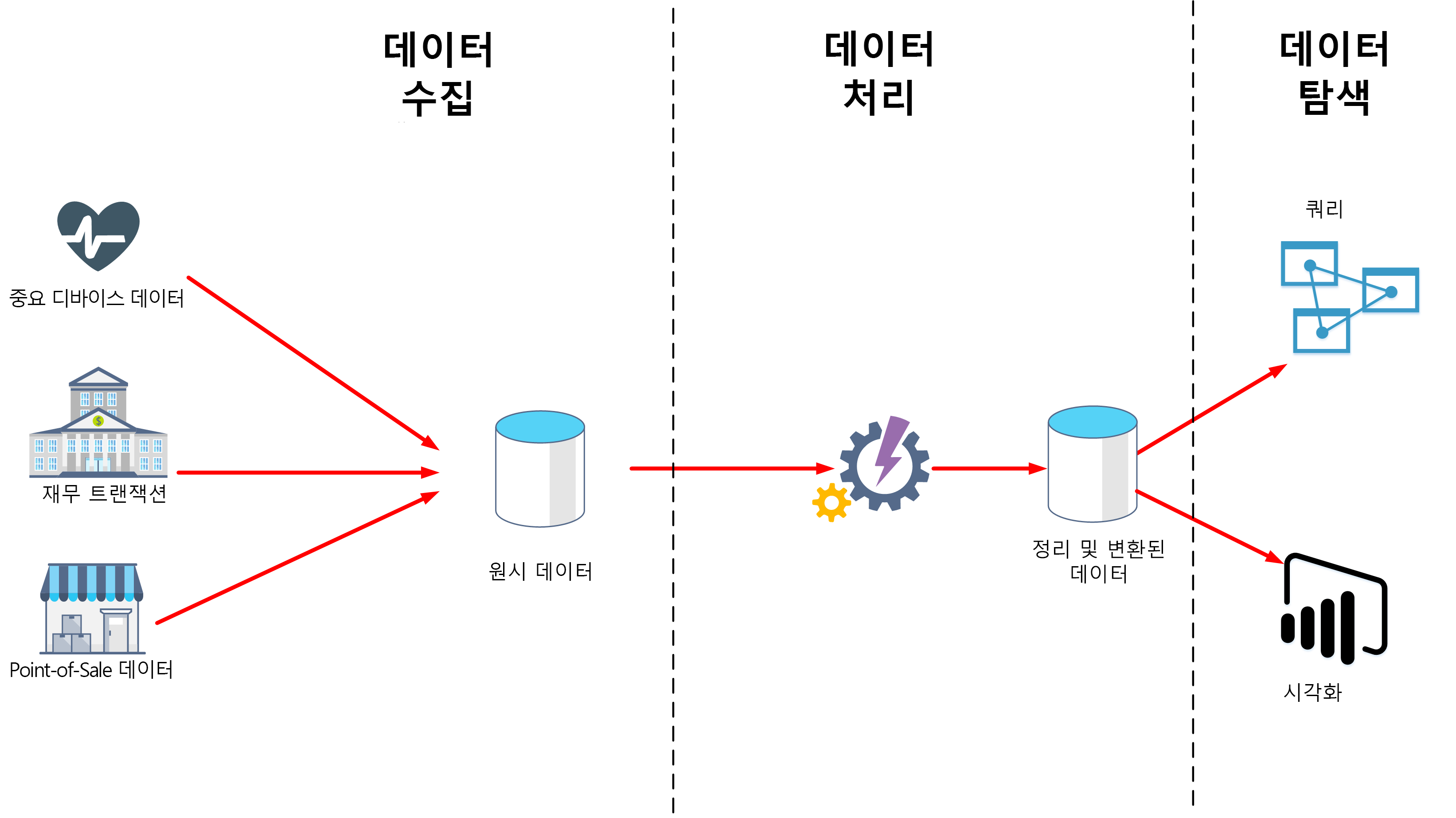

이 단원에서는 데이터 분석의 두 가지 중요한 단계인 데이터 수집 및 데이터 처리에 대해 알아봅니다. 아래 다이어그램에서는 이러한 단계가 어떻게 함께 맞춰지는지 보여 줍니다.

데이터 수집이란?

데이터 수집은 데이터베이스에서 즉시 사용하거나 저장하기 위해 데이터를 획득하고 가져오는 프로세스입니다. 데이터는 연속 스트림으로 도착할 수도 있고 원본에 따라 일괄 처리로 제공될 수도 있습니다. 수집 프로세스의 목적은 이 데이터를 캡처하고 저장하는 것입니다. 이 원시 데이터는 데이터베이스 관리 시스템, 파일 세트 또는 빠르고 쉽게 액세스할 수 있는 다른 유형의 스토리지와 같은 리포지토리에 보관될 수 있습니다.

수집 프로세스에서 필터링을 수행할 수도 있습니다. 예를 들어 수집에서 의심스러운 데이터 또는 손상된 데이터를 거부할 수 있습니다. 의심스러운 데이터는 예기치 않은 원본에서 도착한 데이터일 수 있습니다. 디바이스 오류, 전송 오류 또는 변조로 인해 데이터가 손상되거나 중복될 수 있습니다.

나중에 처리할 수 있도록 데이터를 표준 형식으로 변환하는 이 단계에서 일부 변환을 수행할 수도 있습니다. 예를 들어 동일한 날짜 및 시간 표현을 사용하도록 모든 날짜 및 시간 데이터의 서식을 다시 지정하고 모든 측정 데이터를 동일한 단위를 사용하도록 변환할 수 있습니다. 그러나 이러한 변환은 신속하게 수행해야 합니다. 이 단계에서 데이터에 대한 복잡한 계산 또는 집계를 실행하지 마세요.

데이터 처리란?

데이터 처리 단계는 데이터가 수집되고 모인 후에 발생합니다. 데이터 처리는 원시 형식으로 데이터를 가져와서 정리하고 보다 의미 있는 형식(테이블, 그래프, 문서 등)으로 변환합니다. 그 결과는 쿼리를 수행하고 시각화를 생성하는 데 사용할 수 있는 데이터의 데이터베이스가 되어 컴퓨터가 해석하고 조직의 직원이 사용하는 데 필요한 형태 및 컨텍스트를 제공합니다.

참고

데이터 정리는 변칙 제거와 수집 단계 중에 실행하려면 너무 많은 시간이 소요되는 필터 및 변환 적용 등의 다양한 작업을 포함하는 일반화된 용어입니다.

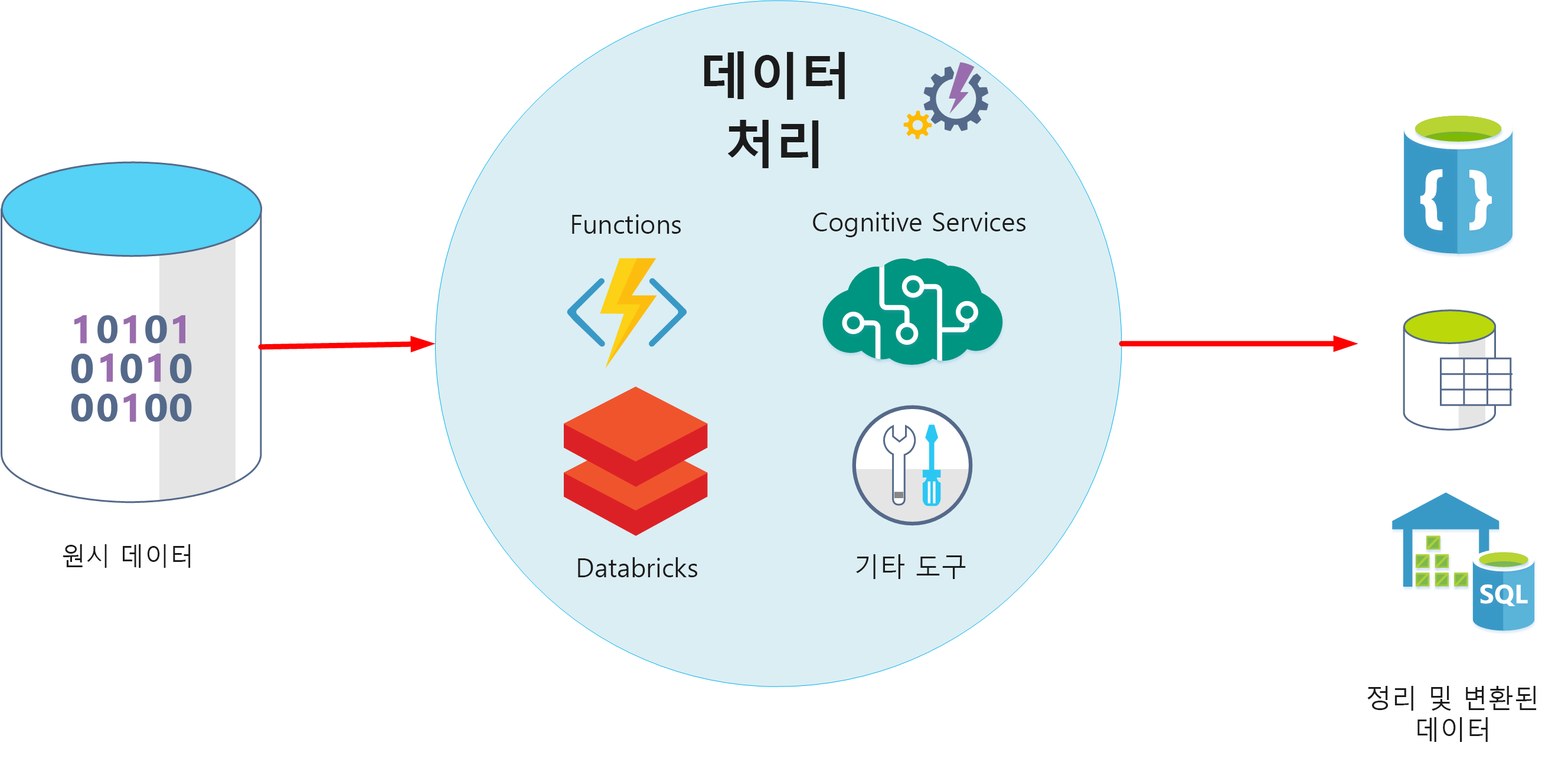

데이터 처리의 목표는 원시 데이터를 하나 이상의 비즈니스 모델로 변환하는 것입니다. 비즈니스 모델은 의미 있는 비즈니스 엔터티를 기준으로 데이터를 설명하며, 항목을 함께 집계하고 정보를 요약할 수 있습니다. 데이터 처리 단계는 데이터에서 예측 모델이나 기타 분석 모델을 생성할 수도 있습니다. 데이터 처리는 복잡할 수 있으며 자동화된 스크립트와 Azure Databricks, Azure Functions, Azure Cognitive Services 등의 도구를 사용하여 데이터를 검사하고 다시 서식을 지정하고 모델을 생성할 수 있습니다. 데이터 분석가는 기계 학습을 사용하여 이러한 모델을 기반으로 미래 추세를 파악할 수 있습니다.

ELT 및 ETL이란?

데이터 처리 메커니즘은 수집 데이터를 검색하고 처리하여 변환하고 모델을 생성한 다음 변환된 데이터와 모델을 저장하기 위해 두 가지 방법을 사용할 수 있습니다. 이러한 접근 방식을 ETL 및 ELT라고 합니다.

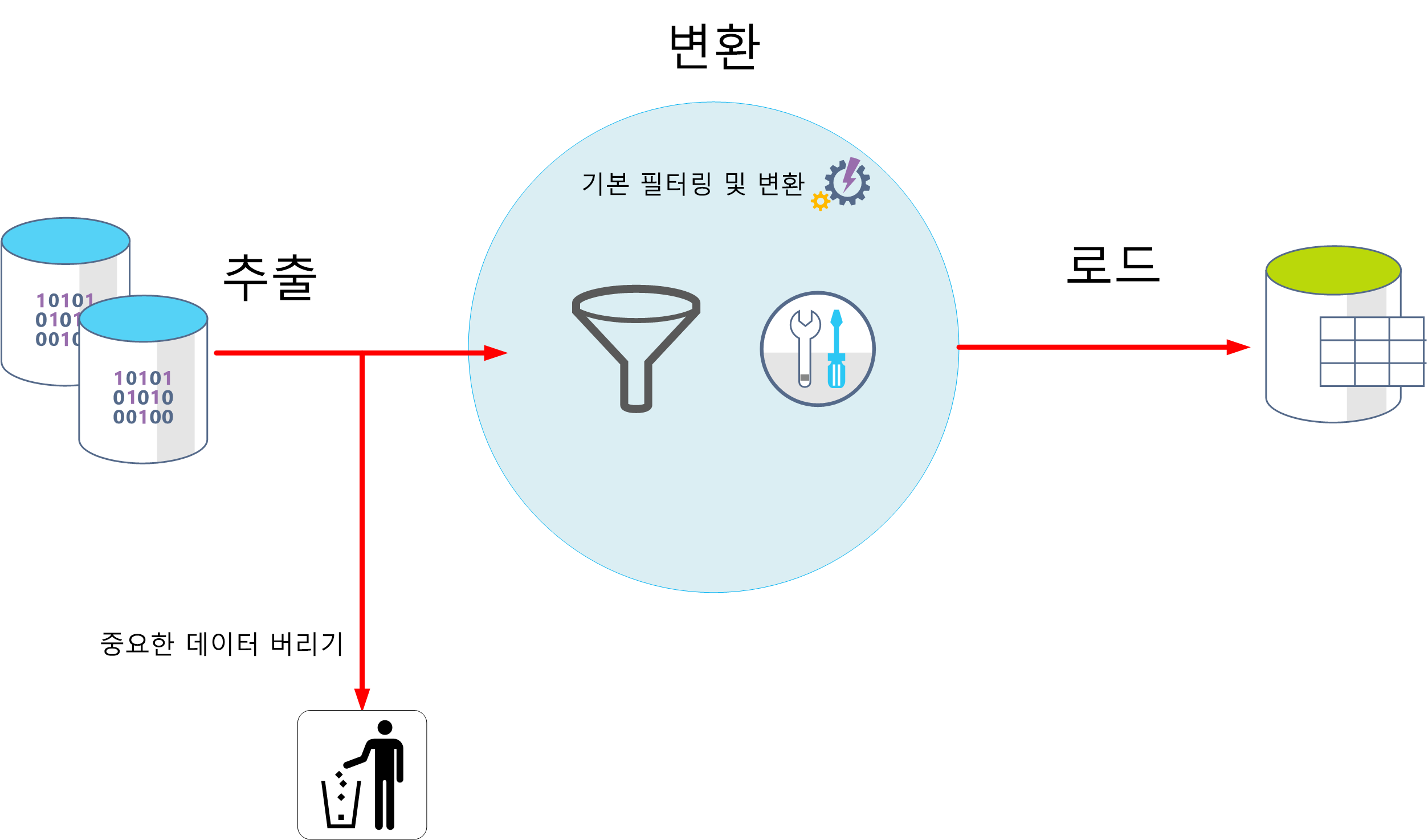

ETL은 ‘추출, 변환 및 로드’의 약자입니다. 원시 데이터는 저장되기 전에 검색 및 변환됩니다. 추출, 변환 및 로드 단계를 연속 작업 파이프라인으로 수행할 수 있습니다. 항목 간의 종속성이 거의 없는 간단한 모델만 필요한 시스템에 적합합니다. 예를 들어 이러한 유형의 프로세스는 주로 기본 데이터를 정리하고, 데이터의 중복을 제거하고, 개별 필드의 내용 서식을 다시 지정하는 데 사용됩니다.

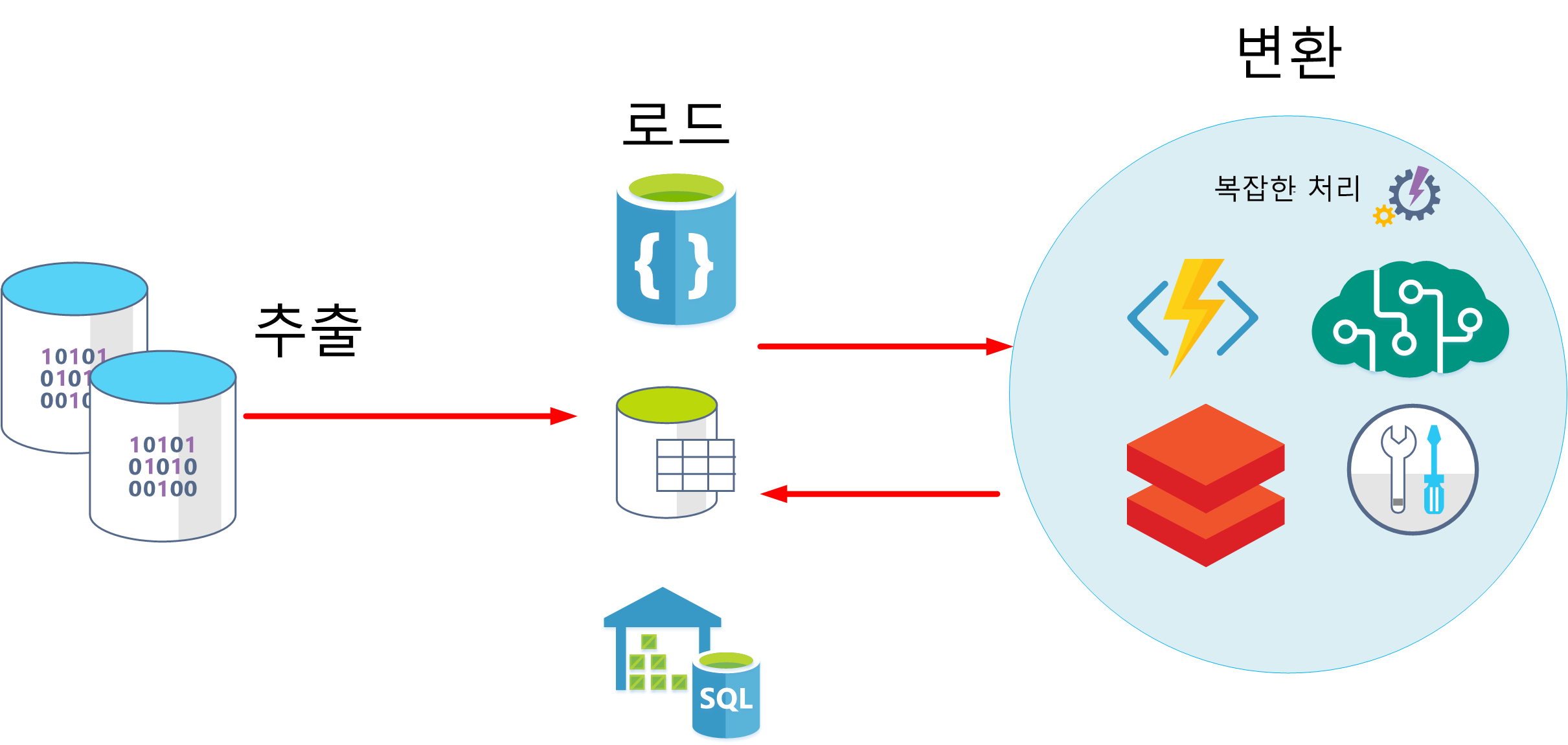

다른 방법은 ELT입니다. ELT는 추출, 로드 및 변환의 약어입니다. 프로세스는 데이터가 변환되기 전에 저장된다는 점에서 ETL과 다릅니다. 데이터 처리 엔진은 변환된 데이터와 모델을 스토리지에 다시 쓰기 전에 스토리지에서 데이터를 검색하고 처리하는 반복적인 접근 방식을 사용할 수 있습니다. ELT는 정기적으로 일괄 처리를 사용하는 데이터베이스의 여러 항목에 종속되는 복잡한 모델을 생성하는 데 더 적합합니다.

ELT는 사용 가능한 광범위한 처리 능력을 활용할 수 있으므로 클라우드에 적합한 스케일링 가능한 방법입니다. ETL의 보다 스트림 지향적인 접근 방식은 처리량에 더 중점을 둡니다. 그러나 ETL은 데이터를 저장하기 전에 필터링할 수 있습니다. 이러한 방식으로 ETL은 데이터 개인 정보 보호 및 규정 준수를 지원하여 분석 데이터 모델에 도착하기 전에 중요한 데이터를 제거할 수 있습니다.

Azure는 ELT 및 ETL 방법을 구현하는 데 사용할 수 있는 몇 가지 옵션을 제공합니다. 예를 들어 Azure SQL Database에 데이터를 저장하는 경우 SQL Server Integration Services를 사용할 수 있습니다. Integration Services는 XML 데이터 파일, 플랫 파일, 관계형 데이터 원본과 같은 다양한 원본에서 데이터를 추출 및 변환한 다음 하나 이상의 대상으로 로드할 수 있습니다.

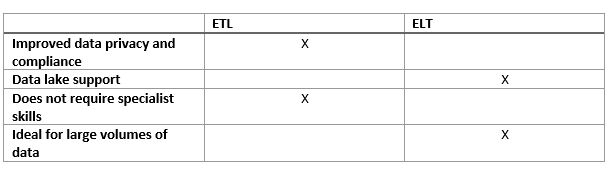

다음은 대부분의 경우 ETL 및 ELT의 장점을 보여 주는 간단한 표입니다.

또 다른 일반화된 방법은 Azure Data Factory를 사용하는 것입니다. Azure Data Factory는 데이터 이동을 오케스트레이션하고 대규모로 데이터를 변환하기 위해 데이터 기반 워크플로를 만들 수 있는 클라우드 기반 데이터 통합 서비스입니다. Azure Data Factory를 사용하여 서로 다른 데이터 저장소의 데이터를 수집할 수 있는 데이터 기반 워크플로(파이프라인이라고 함)를 만들고 예약할 수 있습니다. 데이터 흐름을 사용하여 데이터를 시각적으로 변환하는 복잡한 ETL 프로세스를 빌드하거나 Azure Databricks 및 Azure SQL Database와 같은 컴퓨팅 서비스를 사용할 수 있습니다.