데스크톱 흐름 작업 로그 구성

이 페이지에서는 페이지에서는 Power Platform 관리 센터의 환경 기능 섹션에 있는 데스크톱 흐름 로그에 대한 구성 지침을 제공합니다.

중요

- 이 기능은 클라우드 흐름에서 시작된 데스크톱 흐름에만 적용되며 Power Automate 데스크톱의 로컬 유인 실행에는 아직 사용할 수 없습니다.

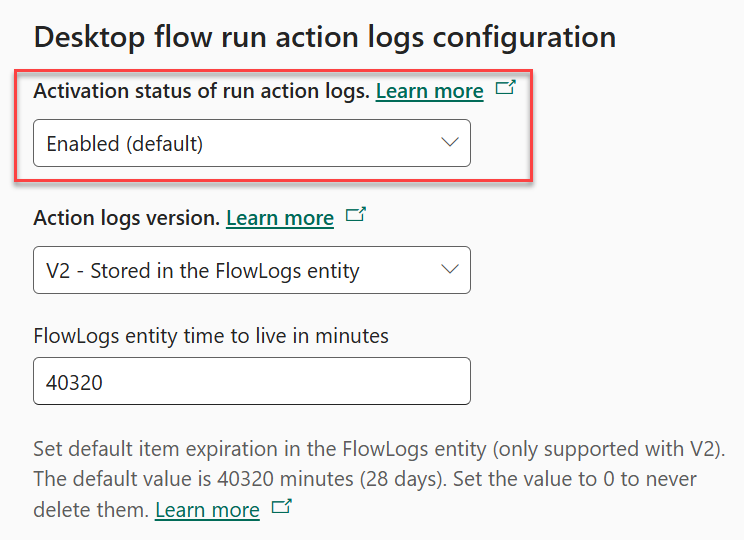

실행 작업 로그의 활성화 상태 설정은 데스크톱 흐름 실행 작업 로그를 캡처해야 하는 시기를 정의하고 이를 완전히 끌 수도 있습니다.

| 활성화 상태 | 세부 사항 |

|---|---|

| 사용(기본값) | 이 옵션은 로그가 평소대로 캡처되는 기존 환경과 새 환경 모두에 대한 기본값입니다. |

| 실행 시 실패 | 이 옵션은 런타임 오류가 있는 경우에만 데스크톱 흐름 작업 로그를 캡처합니다. 즉, 모든 단일 실행에 대해 로그를 사용할 수 없고 오류가 발생한 경우에만 로그를 사용할 수 있습니다. 그러나 오류가 발생하면 성공한 작업과 실패한 작업을 모두 포함하여 해당 특정 실행에 대한 모든 로그를 사용할 수 있습니다. |

| 사용 중지됨 | 이 옵션은 데스크톱 흐름 실행 작업 로그를 완전히 효과적으로 비활성화합니다. |

주의

이러한 설정을 변경하면 실행 실패 문제 해결 및 감사와 같은 기능에 상당한 영향을 미칠 수 있습니다. 계속하기 전에 이러한 설정 변경이 미치는 영향을 고려하십시오.

사전 요구 사항

- Premium Power Automate 라이선스 및 로그 설정을 구성할 수 있는 관리 권한

- Power Automate URL 및 IP 주소 구성

데스크톱 흐름 작업 로그 버전 구성

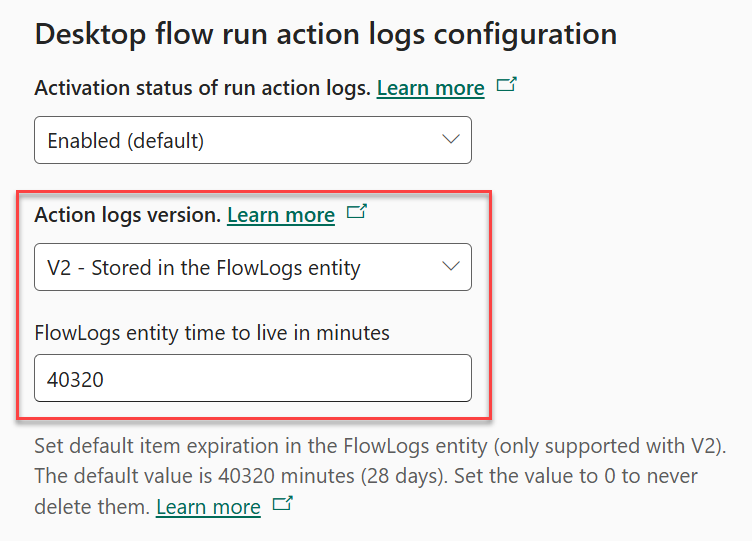

작업 로그 버전을 사용하면 V1, V2 또는 둘 다를 선택할 수 있습니다.

| 로그 버전 | 부가 설명 |

|---|---|

| V1 - FlowSession 엔터티의 AdditionalContext 필드에 저장됨 | 이 옵션이 기본값입니다. 로그는 Microsoft Dataverse에 Blob으로 저장된 파일 특성인 흐름 세션 테이블의 AdditionalContext 필드에 저장됩니다. 로그 V1은 Dataverse 파일 용량을 소비합니다. |

| V2 - FlowLogs 엔터티에 저장됨 | 이 옵션을 사용하면 탄력적 테이블에 저장되는 흐름 로그 테이블에 로그를 저장할 수 있습니다. 로그 V2는 Dataverse 데이터베이스 용량을 소비합니다. |

| 모두 | 이 설정을 사용하면 흐름 세션 테이블의 기존 추가 컨텍스트 필드와 흐름 로그 테이블 모두에 로그를 저장할 수 있습니다. 이 기능은 Dataverse 파일과 데이터베이스 용량을 모두 사용합니다. 이 설정은 Dataverse 데이터베이스와 파일 용량을 모두 소비하므로 디버깅 또는 테스트 목적으로 사용됩니다. |

FlowLogs 엔터티 time to live(분) 값은 작업 로그가 흐름 로그 탄력적 테이블에 보관되어야 하는 기간을 결정합니다. Dataverse는 지정된 기간보다 오래된 레코드를 자동으로 삭제합니다. 다음은 편의를 위한 몇 가지 예시 값입니다.

| 일 | 분 |

|---|---|

| 1일 | 1,440분 |

| 3일 | 4,320분 |

| 7일 | 10,080분 |

| 14일 | 20,160분 |

| 28일 | 40,320분 |

| 60일 | 86,400분 |

| 90일 | 129,600분 |

| 180일 | 259,200분 |

| 365일 | 525,600분 |

| 영구 | 0(영)분 |

참고

로그 V2를 활성화하기 전에 데이터 보존 설정을 지원하고 용량 계획, 권한 부여에 부합하고 필요에 따라 조정할 수 있는 충분한 Dataverse 데이터베이스 용량이 있는지 확인하세요. 일부 크기 조정 예는 다음 섹션의 로그 V2에 대한 샘플 Dataverse 용량 수요 계산을 참조하세요.

데스크톱 흐름 로그 V1과 V2의 주요 차이점

다음 표에서는 데스크톱 흐름 로그 V1과 V2의 차이점을 설명합니다.

| 기능 | 로그 V1 | 로그 V2 | 세부 사항 |

|---|---|---|---|

| 자동 데이터 보존 | 사용할 수 없음 | 대화 가능 | V2는 Azure Cosmos DB를 기반으로 하며 자동 데이터 보존을 위한 TTL(Time-to-Live) 기능이 기본 제공되는 탄력적 테이블을 사용합니다. |

| 대형 로그 크기 지원 | 대략 50,000~80,000개의 작업 로그(최대) | 최소 100K 작업, 생성된 작업 및 실행 기간에 따라 최대 10M 작업까지 갈 수 있습니다. | 이론적으로 V2는 향후 실행당 기가바이트 상당의 작업 로그까지 확장할 수 있는 반면, V1은 이 표에 지정된 볼륨으로만 확장할 수 있습니다. |

| 고급 보고 및 거버넌스 지원 | 사용할 수 없음 | 대화 가능 | V1에서 AdditionalContext 특성은 Dataverse에 Blob으로 저장된 파일 형식이므로 보고 및 거버넌스 컨트롤에 대해 구문 분석하기가 어렵습니다. V2에서는 로그에 훨씬 더 쉽게 액세스할 수 있습니다. |

| Dataverse용 Azure Synapse 링크 통합 지원 | 사용할 수 없음 | 대화 가능 | V1에서 AdditionalContext 특성은 Dataverse에 Blob으로 저장된 파일 형식으로, Azure Synapse에 대한 동기화가 지원되지 않습니다. |

| Dataverse 감사 지원 | 사용할 수 없음 | 대화 가능 | V1에서 AdditionalContext 특성은 Dataverse에 Blob으로 저장된 파일 형식으로, Dataverse 감사에서 지원되지 않습니다. |

| Dataverse 장기 보존 지원 | 사용할 수 없음 | 예정 | V1에서 AdditionalContext 특성은 Dataverse에 Blob으로 저장된 파일 형식으로, Dataverse 장기 보존에서 지원되지 않습니다. |

| Dataverse RBAC(역할 기반 액세스 제어) 기반 | 대화 가능 | 대화 가능 | 두 버전 모두 Dataverse RBAC를 사용하여 상위 흐름 세션 레코드에서 작업 로그 권한을 상속합니다. |

Logs V2는 이전 버전인 V1에 비해 크게 향상된 기능을 제공합니다. V2는 탄력적 테이블 기능을 사용합니다. 이는 작업 로그 시나리오와 같은 대용량 데이터 처리에 적합하고 데이터 보존(TTL) 기능이 내장되어 있습니다. 보고, 거버넌스 및 자동 데이터 보존 컨트롤과의 통합을 위해 상당한 양의 데이터에 액세스해야 하는 조직에 이상적입니다.

로그 V2에 대한 Dataverse 용량 수요 계산

다음 표는 로그 V2를 사용할 때 실행되는 데스크톱 흐름당 샘플 Dataverse 데이터베이스 스토리지 사용량 추정치를 보여줍니다. 이는 작업당 평균 3KB의 스토리지를 가정하여 다양한 작업 수에 대한 대략적인 스토리지 수요를 간략하게 설명합니다.

| 작업 수 | 작업당 스토리지 수요(KB) | 총 스토리지 사용량(MB) |

|---|---|---|

| 1,000 | 3 | 2.93 |

| 10,000 | 3 | 29.3 |

| 30,000 | 3 | 87.9 |

| 60,000 | 3 | 175.8 |

| 100,000 | 3 | 293 |

| 160,000 | 3 | 480 |

중요

위 표에 표시된 수치는 추정치일 뿐이며 실제 스토리지 사용량은 크게 다를 수 있습니다. 정확한 스토리지 요구량은 각 작업 로그의 특정 세부 정보 및 복잡성에 따라 달라집니다. 따라서 이러한 수치는 잠재적인 스토리지 수요를 이해하고 이에 따라 스토리지 요구 사항을 계획하기 위한 대략적인 지침으로 사용해야 합니다.

로그 V2 데이터 쿼리

기존 API 호출 구문을 사용하거나 새로운 ExecuteCosmosSqlQuery 메서드를 사용하여 Dataverse 백엔드에 대한 API 호출을 수행하면 데스크톱 흐름 작업 로그 데이터에 액세스할 수 있습니다. 이 방법을 사용하면 Dataverse에 대해 SQL 쿼리를 실행하여 데이터를 검색하고 필터링할 수 있습니다.

로그 V2의 데이터 모델은 흐름 세션과 흐름 로그 테이블 간의 상위-하위 관계를 기반으로 합니다. 모든 레코드는 상위 흐름 세션 레코드로부터 권한을 상속합니다. 특정 데스크톱 흐름 실행의 작업 로그를 쿼리하려면 다음 쿼리 구문을 사용할 수 있습니다.

기존 Dataverse API 호출 구문

다음 API 호출은 해당 ID(9d51aa1f-315e-43ab-894f-bc445dfb049b)로 특정 흐름 세션을 검색한 다음 flowsession_flowlog_parentobjectid 관계를 사용하여 연결된 작업 로그에 액세스합니다.

[Organization URI]/api/data/v9.0/flowsessions(9d51aa1f-315e-43ab-894f-bc445dfb049b)/flowsession_flowlog_parentobjectid

FlowLogs 테이블을 사용하는 새로운 ExecuteCosmosSqlQuery API 호출 구문

[Organization URI]/api/data/v9.2/ExecuteCosmosSqlQuery(

QueryText=@p1,EntityLogicalName=@p2,QueryParameters=@p3,PageSize=@p4)?

@p1: 'SELECT c.props.flowlogid as flowlogid, c.props.createdon as createdon, c.props.data as data, c.props.level as level, c.props.type as type, c.ttl as ttlinseconds, c.props.cloudflowid as cloudflowid, c.props.cloudflowrunid as cloudflowrunid, c.props.desktopflowid as desktopflowid, c.props.flowmachineid as flowmachineid, c.props.flowmachinegroupid as flowmachinegroupid, c.props.flowsessionid as flowsessionid, c.props.workqueueid as workqueueid, c.props.workqueueitemid as workqueueitemid FROM c WHERE c.props.type IN (100000001) ORDER BY c.props.data.startTime DESC'

@p2: 'flowlog'

@p3: {"Keys":["@referencingParentId","@referencingParentLogicalName"],"Values":[{"Type":"System.Guid","Value":"40590757-a9c0-4f4c-abfc-e2f389049d90"},{"Type":"System.String","Value":"flowsession"}]}

@p4: 50

탄력적 테이블에서 JSON 열 쿼리에 대해 자세히 알아보세요.

통화를 개별 조각으로 나누기

- 기본 URL(https://[my org].api.crm[my region].dynamics.com/api/data/v9.2/)은 Dataverse 웹 API의 엔드포인트입니다.

- ExecuteCosmosSqlQuery는 호출되는 메서드입니다. 이 방법을 사용하면 Dataverse에 대해 SQL 쿼리를 실행할 수 있습니다.

- ExecuteCosmosSqlQuery 메서드에 대한 매개 변수는 메서드 이름 뒤의 괄호 안에 제공됩니다.

-

QueryText=@p1: 실행할 SQL 쿼리입니다. 이 경우 쿼리는 유형이 100000001(데스크톱 흐름 작업 로그 유형)인 테이블에서 다양한 속성을 선택하고 startTime 속성을 기준으로 내림차순으로 결과를 정렬합니다. -

EntityLogicalName=@p2: 이 섹션은 작업 로그를 저장하는 테이블의 논리적 이름입니다(flowlog). -

QueryParameters=@p3: 이 섹션은 쿼리에 대한 매개 변수를 지정하는 JSON 개체입니다. 이전 예에서는 키가@referencingParentId및@referencingParentLogicalName이고 값이flowsessionid(GUID)이고 테이블 유형이flowsession인 키-값 쌍을 지정합니다. -

PageSize=p4: 이 섹션은 쿼리 페이지 크기입니다.

-

알려진 제한 사항

- 로그 V2는 데스크톱 흐름 커넥터 작업을 통해 클라우드 흐름에서 실행되는 데스크톱 흐름 실행에만 사용할 수 있습니다.

- 현재 흐름 로그 테이블에서는 대량 삭제 작업이 지원되지 않습니다.

- 흐름 로그 레코드는 Maker Portal(make.powerapps.com)의 테이블 섹션에서 아직 볼 수 없습니다.

- 작업 로그 버전을 변경해도 이전 데스크톱 흐름 작업 로그가 새 로그 스토리지 유형으로 마이그레이션되지 않습니다.