OneLake에 데이터를 수집하고 Azure Databricks를 사용하여 분석

이 가이드에서는 다음을 수행합니다.

파이프라인을 작업 영역에 만들고 데이터를 Delta 형식으로 OneLake에 수집합니다.

Azure Databricks를 사용하여 OneLake에서 Delta 테이블을 읽고 수정합니다.

필수 조건

시작하기 전에 다음이 있어야 합니다.

레이크하우스 항목이 있는 작업 영역

프리미엄 Azure Databricks 작업 영역 프리미엄 Azure Databricks 작업 영역만 Microsoft Entra 자격 증명 통과를 지원합니다. 클러스터를 만들 때 고급 옵션에서 Azure Data Lake Storage 자격 증명 통과를 사용하도록 설정합니다.

샘플 데이터 세트

데이터 수집 및 Delta 테이블 수정

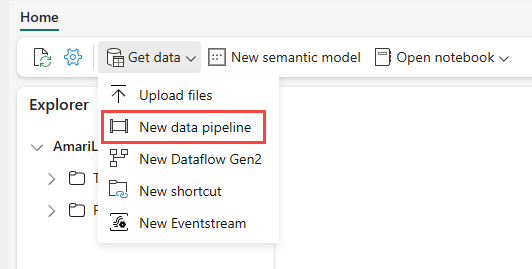

Power BI 서비스에서 레이크하우스로 이동하여 데이터 가져오기, 새 데이터 파이프라인을 차례로 선택합니다.

새 파이프라인 프롬프트에서 새 파이프라인의 이름을 입력한 다음, 만들기를 선택합니다.

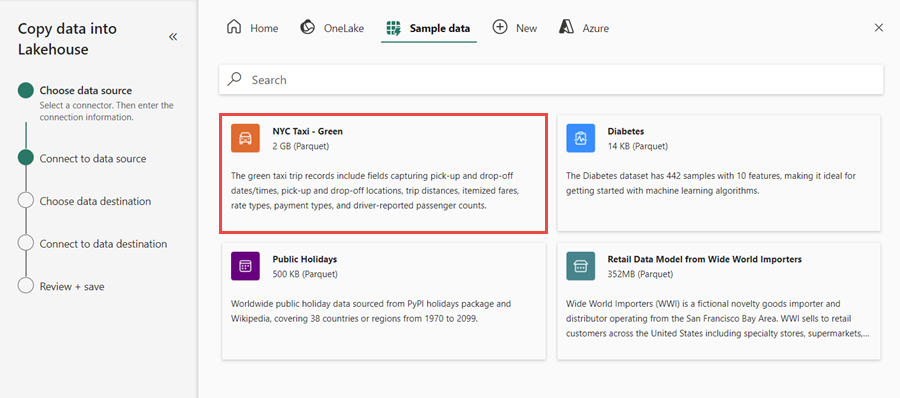

이 연습에서는 NYC Taxi - Green 샘플 데이터를 데이터 원본으로 선택하고, 다음을 선택합니다.

미리 보기 화면에서 다음을 선택합니다.

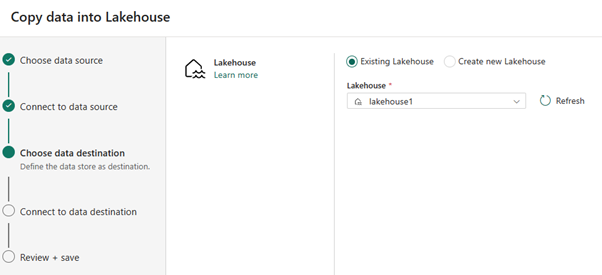

데이터 대상에 대해 OneLake Delta 테이블 데이터를 저장하는 데 사용하려는 레이크하우스의 이름을 선택합니다. 기존 레이크하우스를 선택하거나 새 레이크하우스를 만들 수 있습니다.

출력을 저장하려는 위치를 선택합니다. Tables를 루트 폴더로 선택하고, 테이블 이름으로 "nycsample"을 입력합니다.

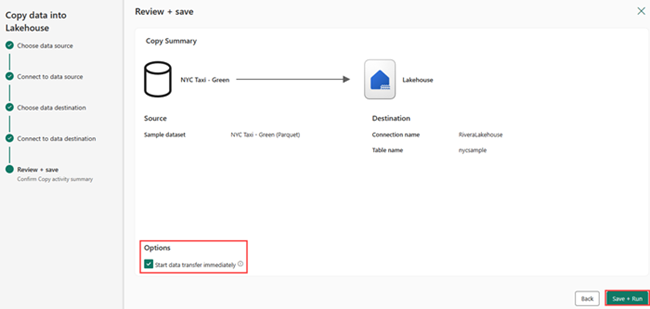

검토 + 저장 화면에서 데이터 전송 즉시 시작, 저장 + 실행을 차례로 선택합니다.

작업이 완료되면 레이크하우스로 이동하여 /Tables 폴더 아래에 나열된 Delta 테이블을 확인합니다.

마우스 오른쪽 단추로 만든 테이블 이름을 클릭하고, 속성을 선택하고, ABFS(Azure Blob 파일 시스템) 경로를 복사합니다.

Azure Databricks Notebook을 엽니다. OneLake에서 Delta 테이블을 읽습니다.

olsPath = "abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample" df=spark.read.format('delta').option("inferSchema","true").load(olsPath) df.show(5)필드 값을 변경하여 Delta 테이블 데이터를 업데이트합니다.

%sql update delta.`abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample` set vendorID = 99999 where vendorID = 1;