Dataflow Gen2를 사용하여 2GB의 Parquet 데이터를 레이크하우스 테이블에 로드하는 가격 책정 시나리오

이 시나리오에서 Dataflow Gen2를 사용하여 ADLS(Azure Data Lake Storage) Gen2에 저장된 2GB의 Parquet 데이터를 Microsoft Fabric의 레이크하우스 테이블에 로드했습니다. Parquet 데이터에 NYC Taxi-green 샘플 데이터를 사용했습니다.

다음 예제에 사용된 가격은 가상의 가격이며 정확한 실제 가격 책정을 의미하지는 않습니다. 이는 Microsoft Fabric의 Data Factory 프로젝트에 대한 비용을 예측, 계획 및 관리하는 방법을 보여줍니다. 또한 패브릭 용량은 지역마다 고유하게 가격이 책정되므로 시간당 CU별 $0.18로 미국 서부 2(일반적인 Azure 지역)의 패브릭 용량에 대해 종량제 가격을 사용합니다. 다른 패브릭 용량 가격 책정 옵션을 살펴보려면 여기에서 Microsoft Fabric - 가격 책정을 참조하세요.

구성

시나리오를 달성하려면 다음 단계를 사용하여데이터 흐름을 만들어야 합니다.

- 데이터 흐름 초기화: ADLS Gen2 스토리지 계정에서 2GB Parquet 파일 데이터를 가져옵니다.

- Power Query 구성:

- Power Query로 이동합니다.

- 쿼리를 준비하는 옵션이 사용하도록 설정되어 있는지 확인합니다.

- Parquet 파일을 결합합니다.

- 데이터 변환:

- 명확성을 위해 헤더를 승격합니다.

- 불필요한 열을 제거합니다.

- 필요에 따라 열 데이터 형식을 조정합니다.

- 출력 데이터 대상 정의:

- 레이크하우스를 데이터 출력 대상으로 구성합니다.

- 이 예제에서는 패브릭 내의 레이크하우스를 만들고 활용했습니다.

패브릭 메트릭 앱을 사용하여 비용 예측

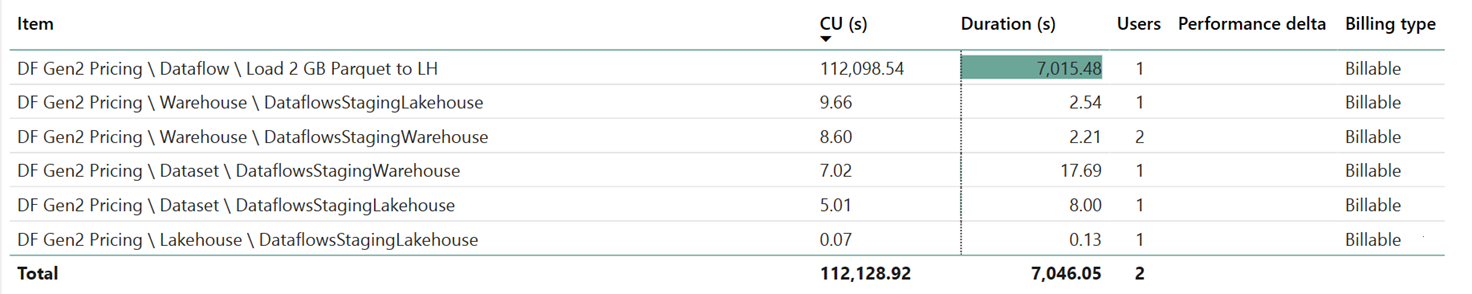

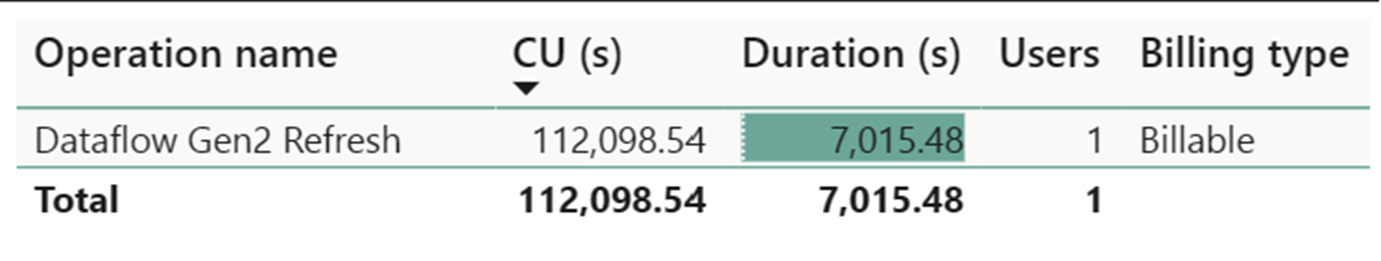

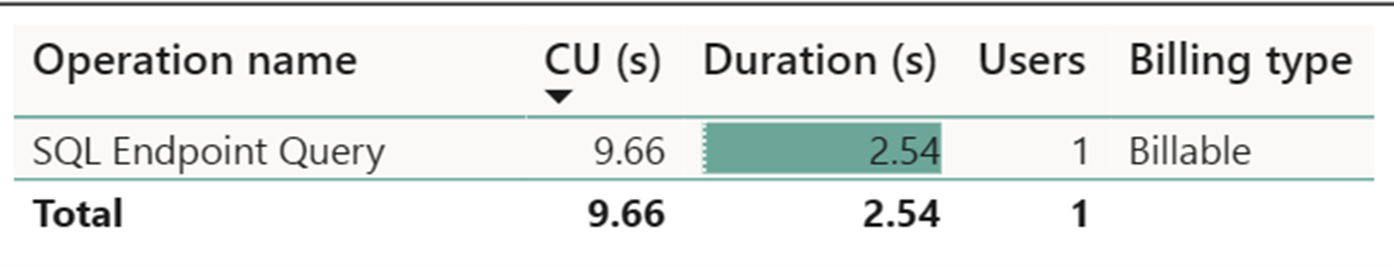

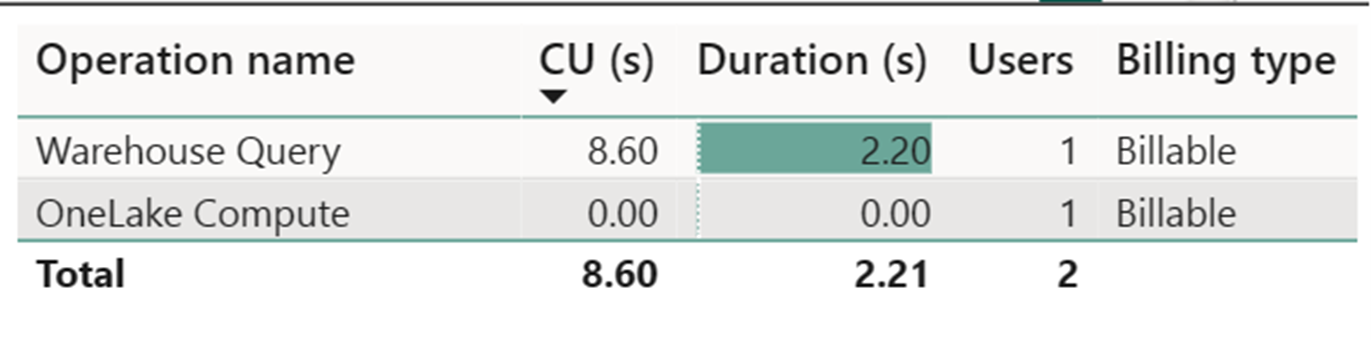

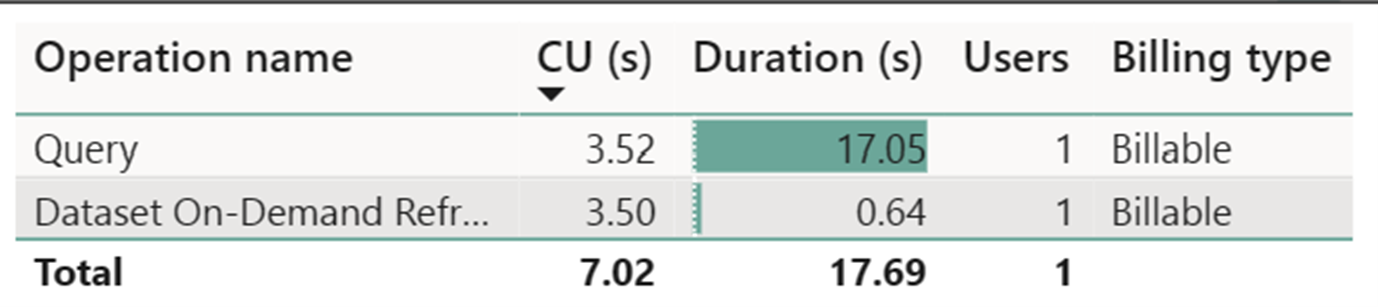

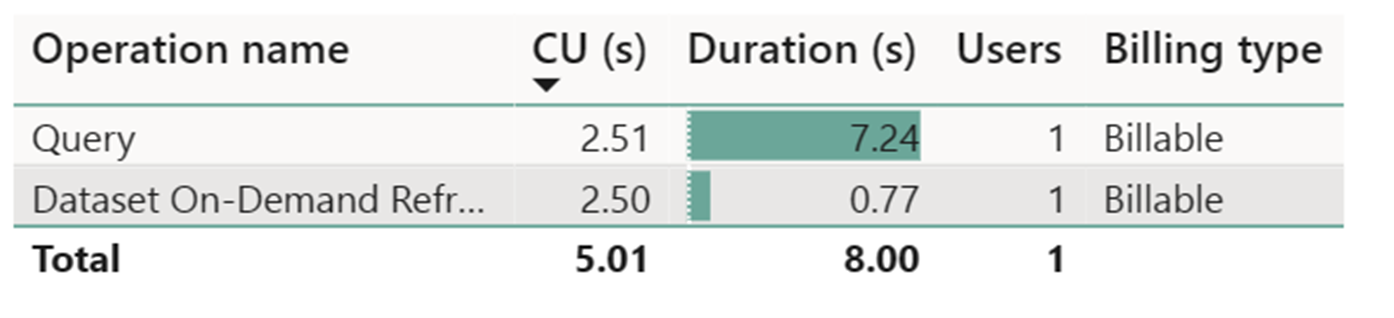

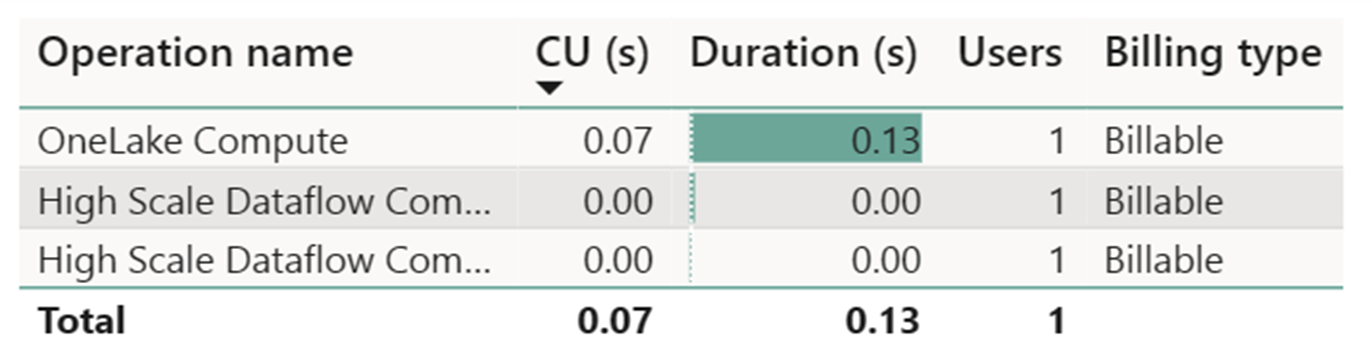

대규모 데이터 흐름 컴퓨팅 미터는 무시해도 좋은 수준의 활동을 기록했습니다. Dataflow Gen2 새로 고침 작업에 대한 표준 컴퓨팅 미터는 112,098.540 CU(컴퓨팅 단위)를 사용합니다. 웨어하우스 쿼리, SQL 엔드포인트 쿼리, 데이터 세트 주문형 새로 고침을 비롯한 다른 작업은 현재 투명하고 해당 작업에 필요한 Dataflow Gen2 구현의 자세한 측면을 구성한다는 것을 고려해야 합니다. 그러나 이러한 작업은 향후 업데이트에서 숨겨지며 Dataflow Gen2에 대한 비용을 예측할 때 무시해야 합니다.

참고 항목

메트릭으로 보고되지만 실행의 실제 기간은 패브릭 메트릭 앱을 사용하여 유효한 CU 시간을 계산할 때와 관련이 없습니다. CU 초 메트릭도 이미 해당 기간을 고려한다고 보고하기 때문입니다.

| 메트릭 | 표준 Compute | 대규모 컴퓨팅 |

|---|---|---|

| 총 CU 초 | 112,098.54 CU 초 | 0 CU 초 |

| 청구 대상 유효 CU 시간 | 112,098.54 / (60*60) = 31.14 CU 시간 | 0 / (60*60) = 0 CU 시간 |

총 실행 비용 $0.18/CU 시간 = (31.14 CU 시간) * ($0.18/CU 시간) ~= $5.60