데이터 흐름 엔드포인트 구성

Important

이 페이지에는 미리 보기 상태인 Kubernetes 배포 매니페스트를 사용하여 Azure IoT Operations 구성 요소를 관리하기 위한 지침이 포함되어 있습니다. 이 기능은 몇 가지 제한 사항을 제공하며 프로덕션 워크로드에 사용하면 안 됩니다.

베타, 미리 보기로 제공되거나 아직 일반 공급으로 릴리스되지 않은 Azure 기능에 적용되는 약관은 Microsoft Azure 미리 보기에 대한 추가 사용 약관을 참조하세요.

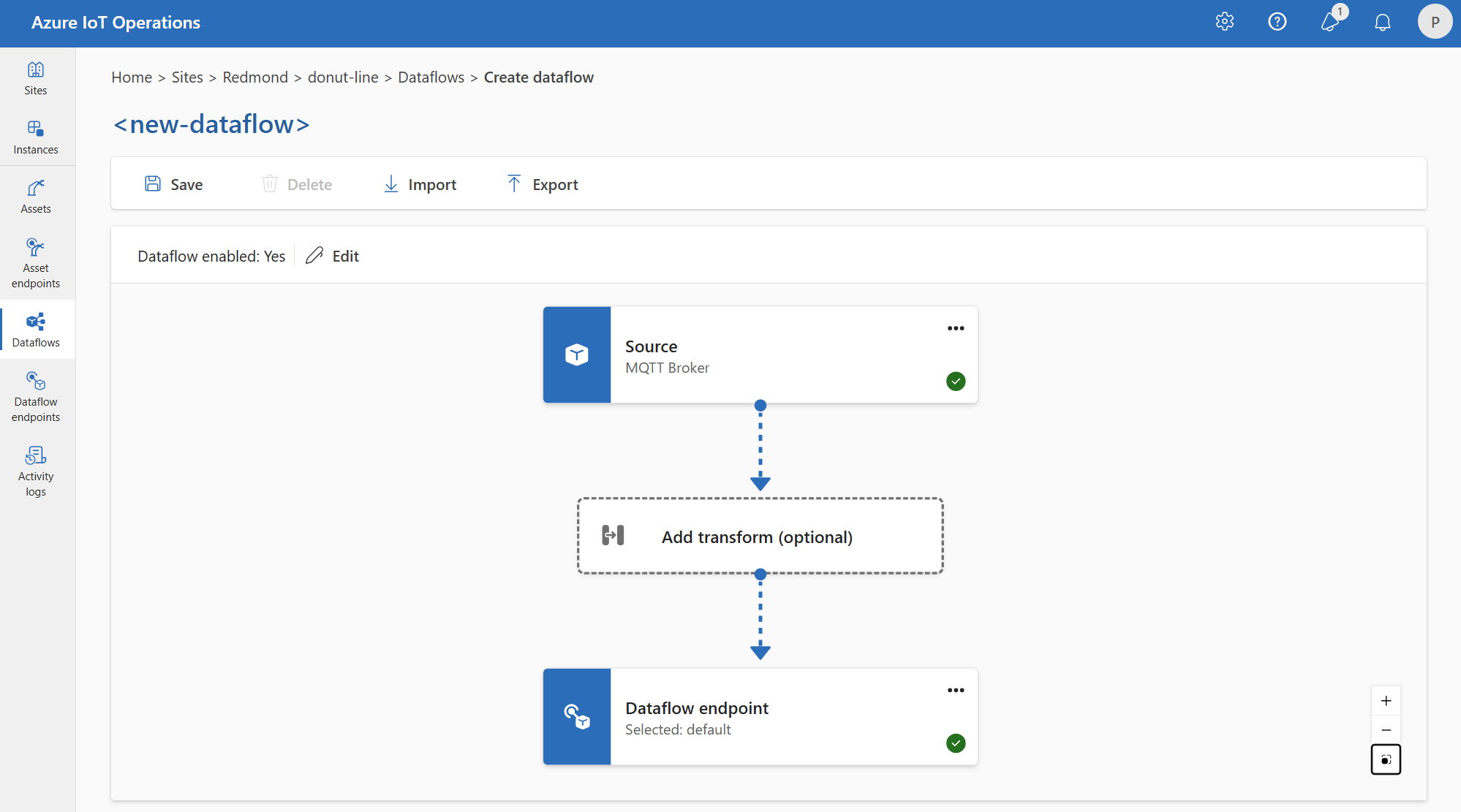

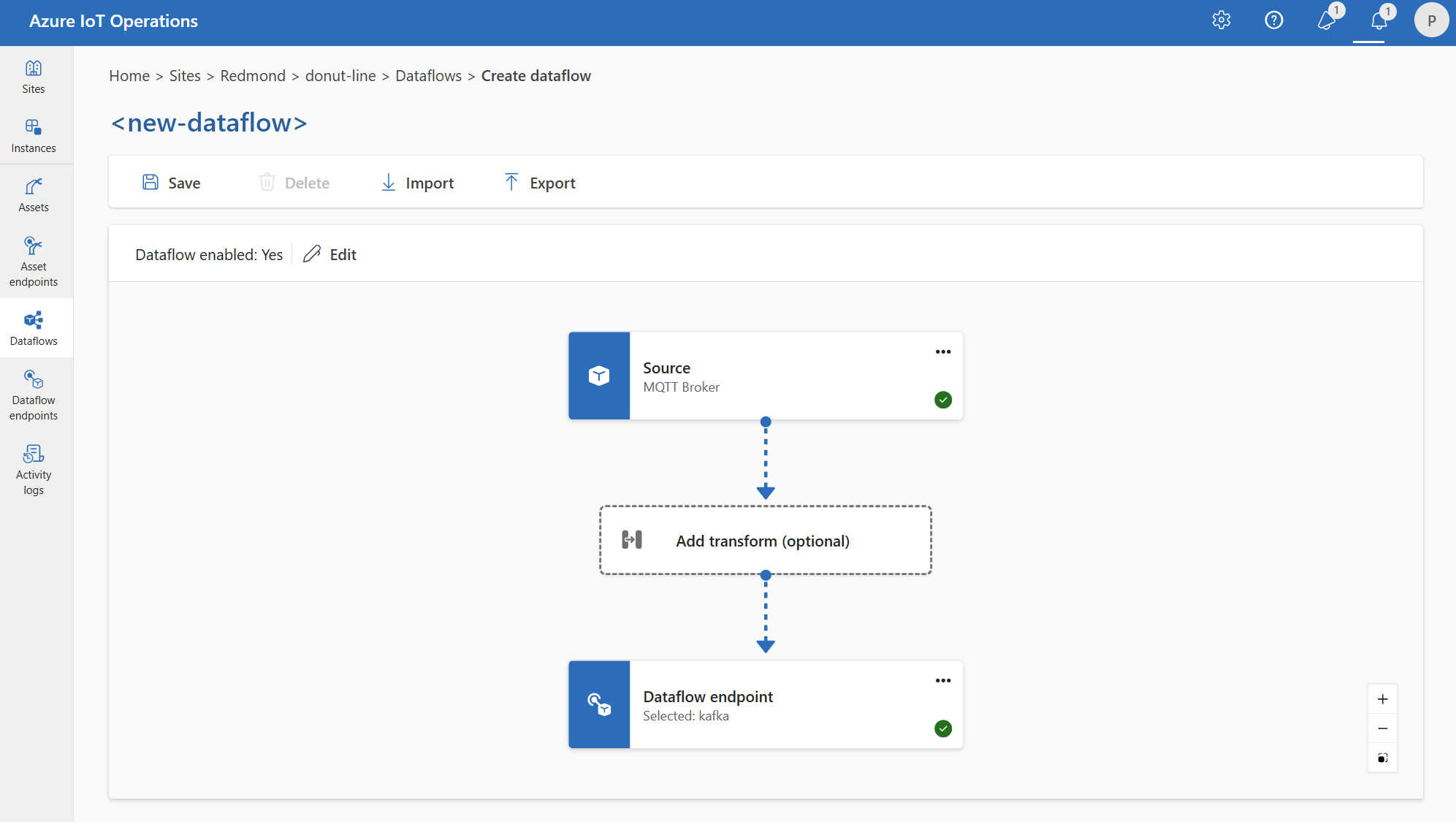

데이터 흐름을 시작하려면 먼저 데이터 흐름 엔드포인트를 만듭니다. 데이터 흐름 엔드포인트는 데이터 흐름의 연결점입니다. 엔드포인트를 데이터 흐름의 원본 또는 대상으로 사용할 수 있습니다. 일부 엔드포인트 유형은 원본과 대상 모두로 사용할 수 있으며, 대상에만 사용할 수 있는 엔드포인트 유형도 있습니다. 데이터 흐름에는 하나 이상의 원본 엔드포인트와 하나의 대상 엔드포인트가 필요합니다.

다음 표를 사용하여 구성할 엔드포인트 유형을 선택합니다.

| 엔드포인트 유형 | 설명 | 원본으로 사용할 수 있습니다. | 대상으로 사용할 수 있습니다. |

|---|---|---|---|

| MQTT | Azure IoT Operations 및 Event Grid에 기본 제공되는 메시지를 포함하여 MQTT 브로커를 사용한 양방향 메시징의 경우 | 예 | 예 |

| Kafka | Azure Event Hubs를 포함하여 Kafka broker를 사용한 양방향 메시징의 경우 | 예 | 예 |

| Data Lake | Azure Data Lake Gen2 스토리지 계정에 데이터를 업로드하는 경우 | 예 | 예 |

| Microsoft Fabric OneLake | Microsoft Fabric OneLake 레이크하우스에 데이터를 업로드하는 경우 | 예 | 예 |

| Azure Data Explorer | Azure Data Explorer 데이터베이스에 데이터를 업로드하는 경우 | 예 | 예 |

| 로컬 스토리지 | 로컬로 사용 가능한 영구 볼륨으로 데이터를 보내는 경우 Azure Arc 에지 볼륨에서 사용하도록 설정된 Azure Container Storage를 통해 데이터를 업로드할 수 있습니다. | 예 | 예 |

Important

스토리지 엔드포인트에는 serialization을 위한 스키마가 필요합니다. Microsoft Fabric OneLake, Azure Data Lake Storage, Azure Data Explorer 또는 Local Storage에서 데이터 흐름을 사용하려면 스키마 참조를 지정해야 합니다.

샘플 데이터 파일에서 스키마를 생성하려면 스키마 Gen 도우미를 사용합니다.

데이터 흐름은 로컬 MQTT broker 엔드포인트를 사용해야 합니다.

데이터 흐름을 만들 때 원본 및 대상 엔드포인트를 지정합니다. 데이터 흐름은 원본 엔드포인트에서 대상 엔드포인트로 데이터를 이동합니다. 여러 데이터 흐름에 동일한 엔드포인트를 사용할 수 있으며 데이터 흐름의 원본 및 대상과 동일한 엔드포인트를 사용할 수 있습니다.

그러나 데이터 흐름에서 원본 및 대상으로 사용자 지정 엔드포인트를 모두 사용하는 것은 지원되지 않습니다. 이 제한은 Azure IoT Operations의 기본 제공 MQTT 브로커가 하나 이상의 엔드포인트여야 하다는 것을 의미합니다. 원본, 대상 또는 둘 다일 수 있습니다. 데이터 흐름 배포 오류를 방지하려면 기본 MQTT 데이터 흐름 엔드포인트를 모든 데이터 흐름의 원본 또는 대상으로 사용합니다.

특정 요구 사항은 각 데이터 흐름에 호스트 aio-broker가 있는 MQTT 엔드포인트로 구성된 원본 또는 대상이 있어야 합니다. 따라서 기본 엔드포인트를 사용해야 하는 것은 아니며 호스트 aio-broker가 있는 한 로컬 MQTT 브로커를 가리키는 추가 데이터 흐름 엔드포인트를 만들 수 있습니다. 그러나 혼동 및 관리 효율성 문제를 방지하기 위해 기본 엔드포인트가 권장되는 방법입니다.

다음 표에서는 지원되는 시나리오를 보여 줍니다.

| 시나리오 | 지원 여부 |

|---|---|

| 원본으로 기본 엔드포인트 | 예 |

| 대상인 기본 엔드포인트 | 예 |

| 원본으로 사용자 지정 엔드포인트 | 예, 대상이 기본 엔드포인트이거나 호스트가 있는 MQTT 엔드포인트인 경우 aio-broker |

| 대상으로 사용자 지정 엔드포인트 | 예, 원본이 기본 엔드포인트이거나 호스트가 있는 MQTT 엔드포인트인 경우 aio-broker |

| 원본 및 대상으로 사용자 지정 엔드포인트 | 아니요, 호스트가 있는 MQTT 엔드포인트가 아닌 경우 aio-broker |

엔드포인트 다시 사용

각 데이터 흐름 엔드포인트는 데이터를 가져오거나 이동해야 하는 위치( host 값), 엔드포인트를 사용하여 인증하는 방법 및 TLS 구성 또는 일괄 처리 기본 설정과 같은 기타 설정을 포함하는 구성 설정의 번들로 간주합니다. 따라서 한 번만 만든 다음 이러한 설정이 동일한 여러 데이터 흐름에서 다시 사용할 수 있습니다.

엔드포인트를 더 쉽게 다시 사용할 수 있도록 MQTT 또는 Kafka 토픽 필터는 엔드포인트 구성의 일부가 아닙니다. 대신 데이터 흐름 구성에서 토픽 필터를 지정합니다. 즉, 서로 다른 토픽 필터를 사용하는 여러 데이터 흐름에 동일한 엔드포인트를 사용할 수 있습니다.

예를 들어 기본 MQTT broker 데이터 흐름 엔드포인트를 사용할 수 있습니다. 다른 토픽 필터를 사용하여 원본 및 대상 모두에 사용할 수 있습니다.

마찬가지로 다른 엔드포인트 및 토픽에 동일한 MQTT 엔드포인트를 사용하는 여러 데이터 흐름을 만들 수 있습니다. 예를 들어 Event Hubs 엔드포인트로 데이터를 보내는 데이터 흐름에 동일한 MQTT 엔드포인트를 사용할 수 있습니다.

MQTT 예제와 마찬가지로 여러 토픽에 동일한 Kafka 엔드포인트를 사용하는 여러 데이터 흐름을 만들거나 다른 테이블에 대해 동일한 Data Lake 엔드포인트를 만들 수 있습니다.

다음 단계

데이터 흐름 엔드포인트를 만듭니다.