Azure Blob Storage를 사용하여 DAG 가져오기

참고 항목

이 기능은 공개 미리 보기로 제공됩니다. 워크플로 오케스트레이션 관리자는 Apache Airflow를 통해 구동됩니다.

이 문서에서는 Azure Blob Storage를 사용하여 DAG(Directed Acyclic Graph)를 워크플로 오케스트레이션 관리자로 가져오는 방법에 대한 단계별 지침을 보여 줍니다.

필수 조건

- Azure 구독: Azure 구독이 아직 없는 경우 시작하기 전에 Azure 체험 계정을 만듭니다.

- Azure Data Factory: 워크플로 오케스트레이션 관리자 미리 보기가 지원되는 지역에서 기존 Data Factory 인스턴스를 만들거나 선택합니다.

- Azure Storage 계정: 스토리지 계정이 없는 경우 계정을 만드는 단계는 Azure Storage 계정 만들기를 참조하세요. 스토리지 계정이 선택한 네트워크에서만 액세스를 허용하는지 확인합니다.

가상 네트워크 뒤의 Blob Storage는 미리 보기 중에는 지원되지 않습니다. storageLinkedServices의 Azure Key Vault 구성은 DAG 가져오기를 지원하지 않습니다.

DAG 가져오기

설정한 Airflow 환경에 따라 샘플 Apache Airflow v2.x DAG 또는 샘플 Apache Airflow v1.10 DAG를 복사합니다. 콘텐츠를 tutorial.py라는 새 파일에 붙여넣습니다.

Blob Storage에 tutorial.py 파일을 업로드합니다. 자세한 내용은 BLOB에 파일 업로드를 참조하세요.

참고 항목

Airflow 환경으로 가져오려면 dags 및 plugins라는 폴더가 포함된 Blob Storage 계정에서 디렉터리 경로를 선택해야 합니다. 플러그 인은 필수가 아닙니다. dags라는 컨테이너가 있으면 그 안에 있는 모든 Airflow 파일을 업로드할 수도 있습니다.

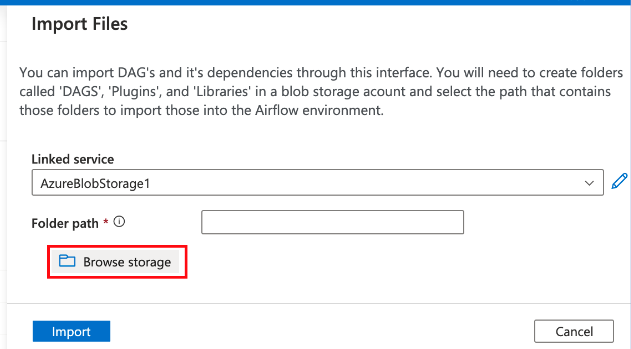

관리 허브에서 Apache Airflow를 선택합니다. 그런 다음 이전에 만들어진 Airflow 환경 위에 마우스를 놓고 파일 가져오기를 선택하여 모든 DAG 및 종속성을 Airflow 환경으로 가져옵니다.

"필수 조건" 섹션에 언급된 액세스 가능한 스토리지 계정에 연결된 새 서비스를 만듭니다. 자체 DAG가 이미 있는 경우 기존 DAG를 사용할 수도 있습니다.

DAG를 업로드한 스토리지 계정을 사용합니다. ("필수 조건" 섹션을 확인합니다.) 연결을 테스트한 다음 만들기를 선택합니다.

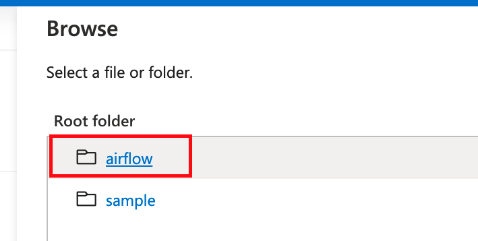

샘플 SAS URL을 사용하는 경우 airflow를 찾아 선택합니다. DAG 파일이 있는 dags 폴더가 포함된 폴더를 선택할 수도 있습니다.

참고 항목

이 인터페이스를 통해 DAG 및 해당 종속성을 가져올 수 있습니다. dags 및 plugins라는 이름의 폴더를 포함한 Blob Storage 계정에서 디렉터리 경로를 선택하여 Airflow 환경으로 가져와야 합니다. 플러그 인은 필수가 아닙니다.

파일을 가져오려면 가져오기를 선택합니다.

미리 보기 중에 DAG를 가져오는 데 몇 분 정도 걸릴 수 있습니다. 알림 센터(Data Factory UI의 종 모양 아이콘)를 사용하여 가져오기 상태 업데이트를 추적할 수 있습니다.