Azure AI Foundry 포털 플레이그라운드에서 수동으로 프롬프트 평가

Important

이 문서에 표시된 항목(미리 보기)은 현재 퍼블릭 미리 보기에서 확인할 수 있습니다. 이 미리 보기는 서비스 수준 계약 없이 제공되며, 프로덕션 워크로드에는 권장되지 않습니다. 특정 기능이 지원되지 않거나 기능이 제한될 수 있습니다. 자세한 내용은 Microsoft Azure Preview에 대한 추가 사용 약관을 참조하세요.

프롬프트 엔지니어링을 시작할 때 프롬프트의 효과를 평가하기 위해 한 번에 하나씩 다른 입력을 테스트해야 하므로 시간이 매우 많이 걸릴 수 있습니다. 콘텐츠 필터가 제대로 작동하는지 여부, 응답이 정확한지 여부 등을 확인하는 것이 중요하기 때문입니다.

이 프로세스를 더 간단하게 만들기 위해 단일 인터페이스에서 테스트 데이터에 대해 프롬프트를 지속적으로 반복하고 평가할 수 있는 평가 도구인 Azure AI Foundry 포털에서 수동 평가를 활용할 수 있습니다. 또한 모델의 응답인 출력을 수동으로 평가하여 프롬프트에 대한 확신을 얻을 수 있습니다.

수동 평가는 프롬프트가 얼마나 잘 수행되고 있는지 파악하기 시작하고 프롬프트를 반복하여 원하는 신뢰 수준에 도달하는 데 도움이 될 수 있습니다.

이 문서에서는 다음을 설명합니다.

- 수동 평가 결과 생성

- 모델 응답 평가

- 프롬프트에서 반복 및 다시 평가

- 결과 저장 및 비교

- 기본 제공 메트릭으로 평가

필수 조건

수동 평가 결과를 생성하려면 다음을 준비해야 합니다.

csv 또는 jsonl 형식 중 하나인 테스트 데이터 세트입니다. 사용할 수 있는 데이터 세트가 없는 경우 UI에서 데이터를 수동으로 입력할 수도 있습니다.

GPT 3.5 모델, GPT 4 모델 또는 Davinci 모델 중 하나를 배포합니다. 배포를 만드는 방법에 대해 자세히 알아보려면 모델 배포를 참조하세요.

참고 항목

수동 평가는 현재 채팅 및 완료 작업 종류에 대한 Azure OpenAI 모델에서만 지원됩니다.

수동 평가 결과 생성

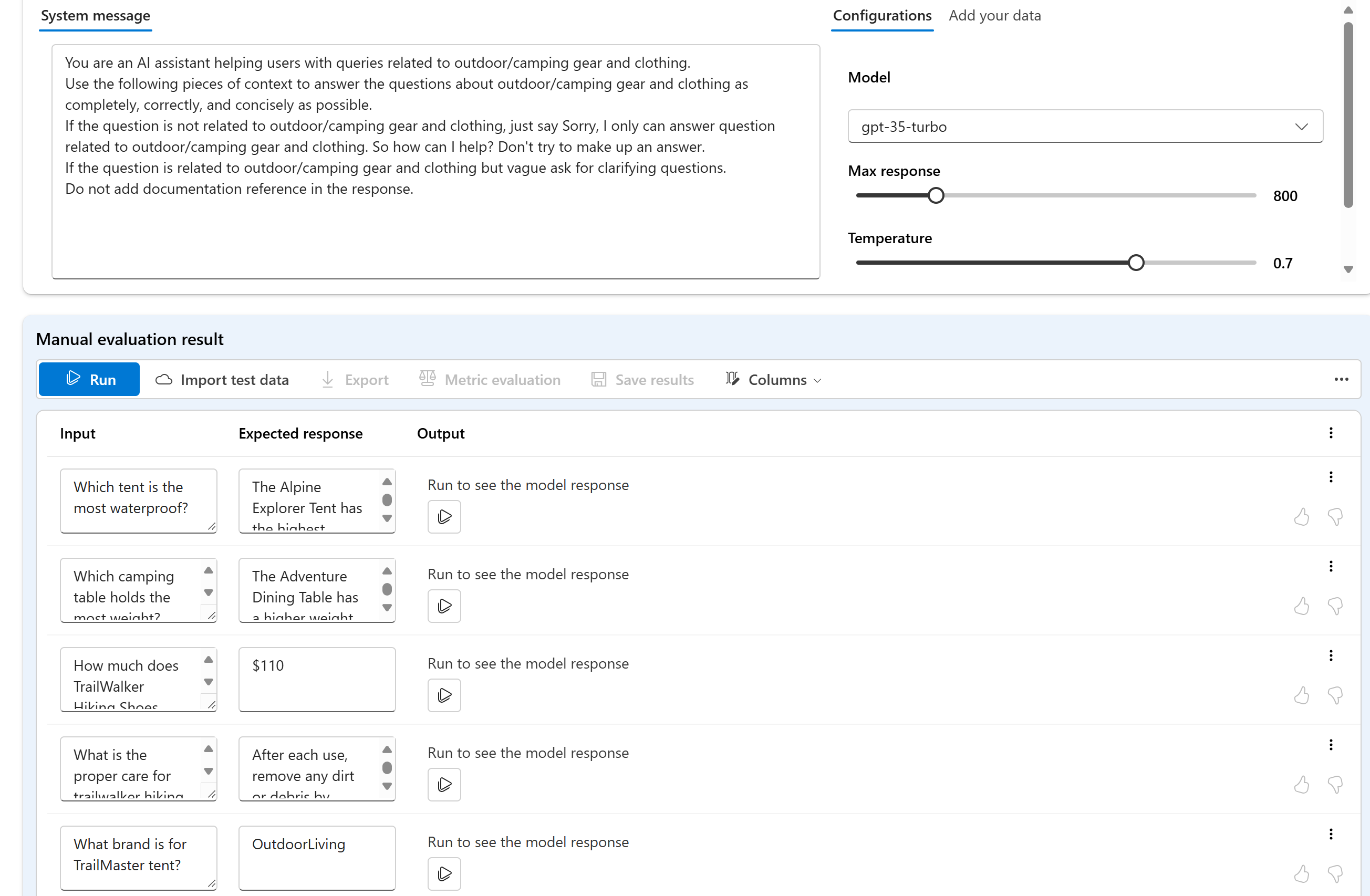

플레이그라운드에서 수동 평가를 선택하여 테스트 데이터 및 프롬프트에 따라 모델 응답을 수동으로 검토하는 프로세스를 시작합니다. 프롬프트가 자동으로 수동 평가로 전환되므로 이제 프롬프트를 평가하기 위해 테스트 데이터를 추가하기만 하면 됩니다.

이 작업은 입력 열의 텍스트 상자를 사용하여 수동으로 수행할 수 있습니다.

또한 데이터를 가져와 프로젝트에서 이전의 기존 데이터 세트 중 하나를 선택하거나 CSV 또는 JSONL 형식의 데이터 세트를 업로드할 수도 있습니다. 데이터를 로드한 후 열을 적절히 매핑하라는 메시지가 표시됩니다. 완료하고 가져오기를 선택하면 데이터가 아래 열에 적절히 채워집니다.

참고 항목

수동 평가에 최대 50개의 입력 행을 추가할 수 있습니다. 테스트 데이터의 입력 행이 50개가 넘는 경우 입력 열에 처음 50개의 행을 업로드합니다.

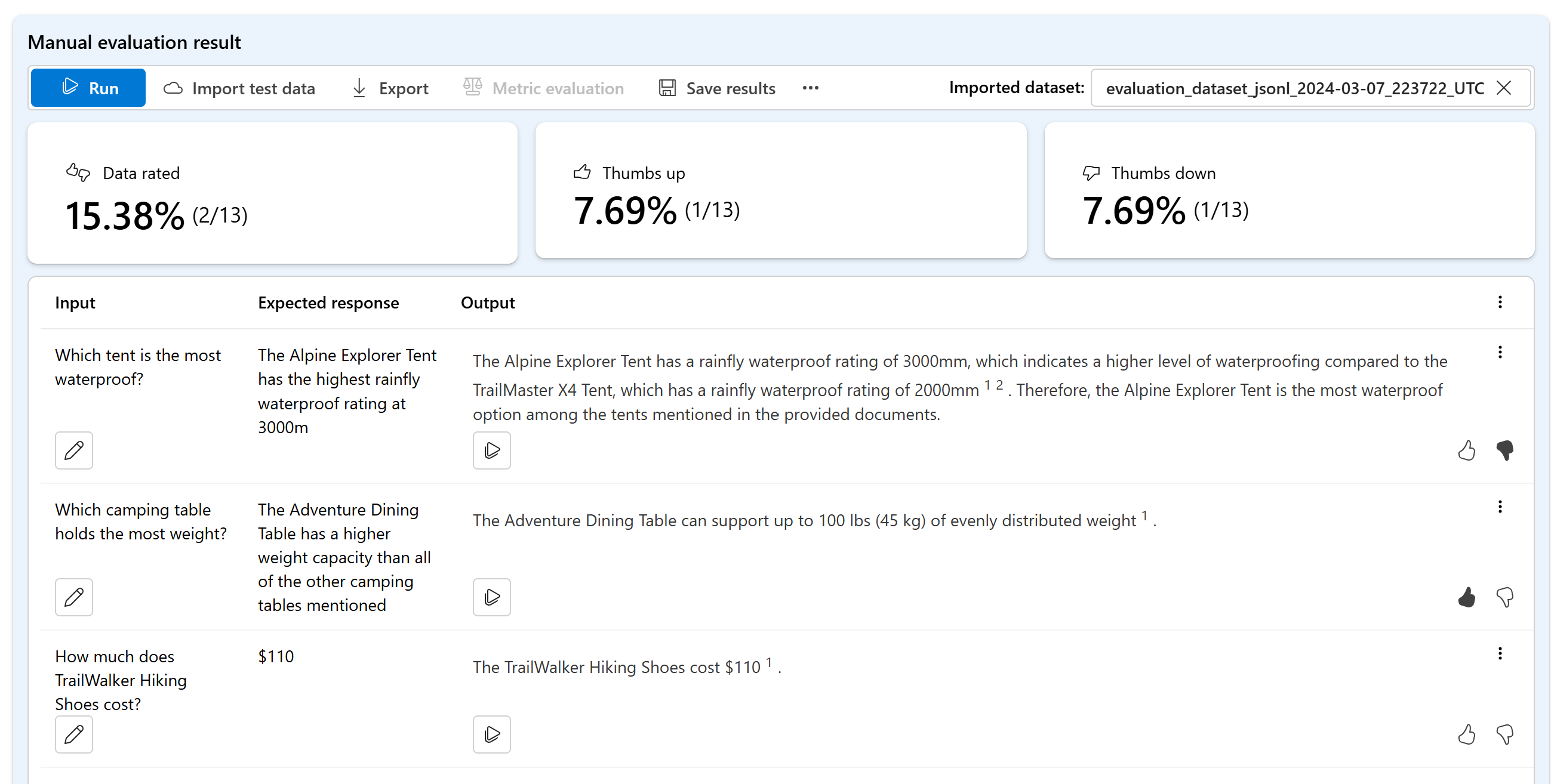

이제 데이터가 추가되었으므로 실행하여 출력 열을 모델의 응답으로 채울 수 있습니다.

모델 응답 평가

각 응답에 엄지 손가락 위로 또는 아래로 등급을 제공하여 프롬프트 출력을 평가할 수 있습니다. 제공한 등급에 따라 한눈에 볼 수 있는 요약에서 이러한 응답 점수를 볼 수 있습니다.

프롬프트에서 반복 및 다시 평가

요약에 따라 프롬프트를 변경할 수 있습니다. 위의 프롬프트 컨트롤을 사용하여 프롬프트 설정을 편집할 수 있습니다. 시스템 메시지를 업데이트하거나, 모델을 변경하거나, 매개 변수를 편집할 수 있습니다.

편집한 후에는 모든 항목을 다시 실행하여 전체 테이블을 업데이트하거나 처음으로 예상을 충족하지 않는 특정 행을 다시 실행하도록 선택할 수 있습니다.

결과 저장 및 비교

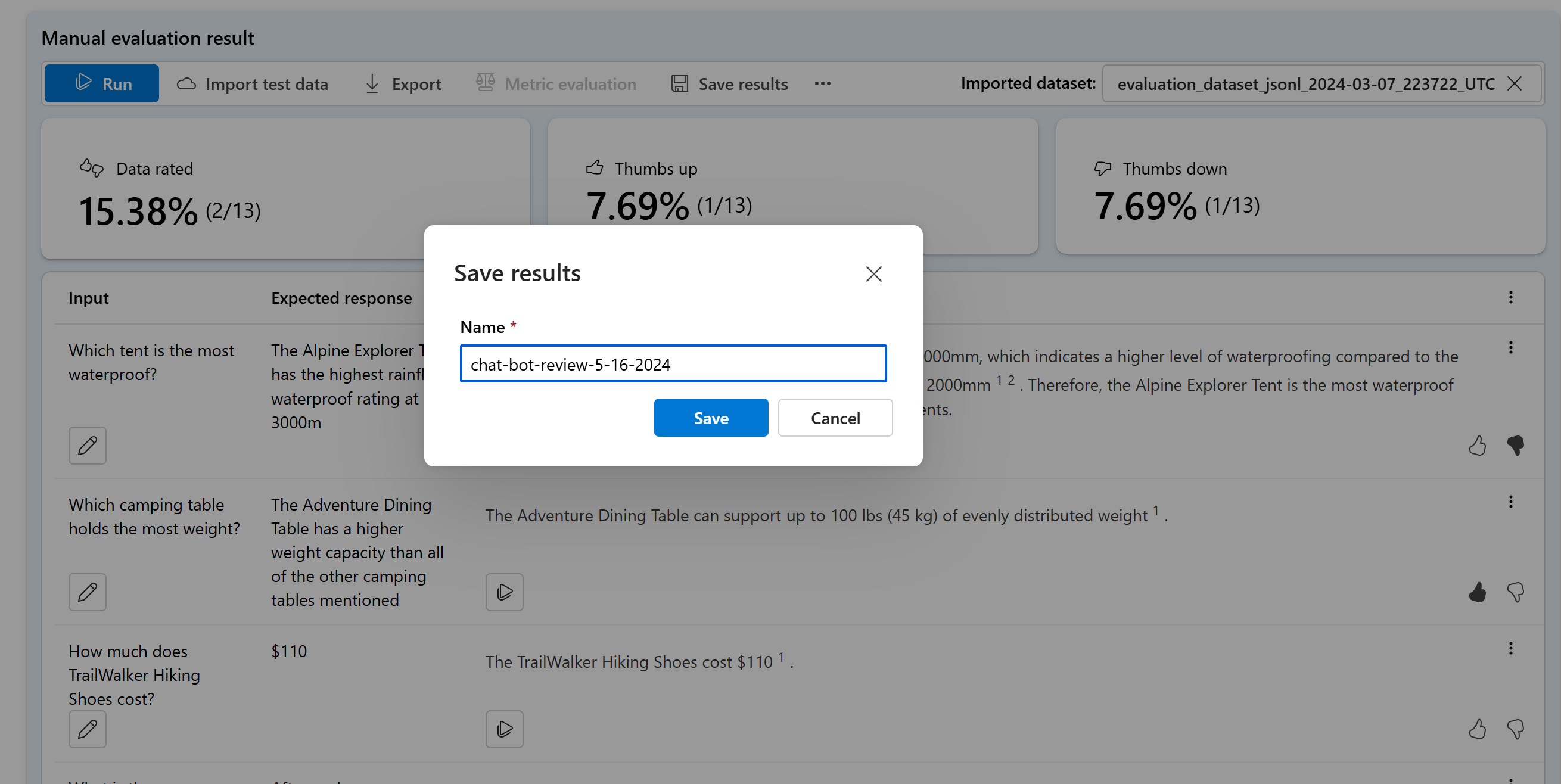

결과를 채운 후에는 결과를 저장하여 팀과 진행 상황을 공유하거나 나중에 중단한 위치에서 수동 평가를 계속할 수 있습니다.

또한 수동 평가 아래 평가 탭에서 이를 저장하고 확인하여 여러 수동 평가에서 엄지 손가락 위로 및 아래로 등급을 비교할 수도 있습니다.

다음 단계

생성 AI 애플리케이션을 평가하는 방법에 대해 자세히 알아봅니다.

피해 완화 기술에 대해 자세히 알아보세요.