LlamaIndex 및 Azure AI Foundry를 사용하여 애플리케이션 개발

이 문서에서는 Azure AI Foundry 포털의 Azure AI 모델 카탈로그에서 배포된 모델과 함께 LlamaIndex를 사용하는 방법을 알아봅니다.

Azure AI Foundry에 배포된 모델은 다음 두 가지 방법으로 LlamaIndex와 함께 사용할 수 있습니다.

Azure AI 모델 유추 API 사용: Azure AI Foundry에 배포된 모든 모델은 카탈로그의 대부분의 모델에 사용할 수 있는 일반적인 기능 집합을 제공하는 Azure AI 모델 유추 API를 지원합니다. 이 API의 이점은 모든 모델에 동일하므로 사용 중인 모델 배포를 변경하는 것만큼 간단하게 한 모델에서 다른 모델로 변경할 수 있다는 것입니다. 더 이상 코드를 변경할 필요는 없습니다. LlamaIndex를 사용할 때 확장

llama-index-llms-azure-inference와llama-index-embeddings-azure-inference를 설치합니다.모델 공급자별 API 사용: OpenAI, Cohere, Mistral 등 일부 모델은 LlamaIndex에 대한 자체 API 및 확장 집합을 제공합니다. 이러한 확장 기능에는 해당 모델이 지원하는 특정 기능이 포함될 수 있으므로 이를 활용하려는 경우 적합합니다.

llama-index를 사용할 때,llama-index-llms-openai또는llama-index-llms-cohere처럼 사용하려는 모델에 맞는 확장을 설치합니다.

이 예에서는 Azure AI 모델 유추 API를 사용합니다.

필수 조건

이 자습서를 실행하려면 다음이 필요합니다.

Azure AI Foundry 포털에서 프로젝트 만들기에 설명된 대로 Azure AI 프로젝트입니다.

Azure AI 모델 유추 API를 지원하는 모델이 배포되었습니다. 이 예에서는

Mistral-Large배포를 사용하지만 원하는 모델을 사용할 수 있습니다. LlamaIndex에서 포함 기능을 사용하려면cohere-embed-v3-multilingual과 같은 포함 모델이 필요합니다.- 모델을 서버리스 API로 배포의 지침을 따릅니다.

pip를 포함하여 Python 3.8 이상이 설치됨.

LlamaIndex가 설치되었습니다. 다음을 사용하여 수행할 수 있습니다.

pip install llama-index이 예에서는 Azure AI 모델 유추 API를 사용하기 때문에 다음 패키지를 설치합니다.

pip install -U llama-index-llms-azure-inference pip install -U llama-index-embeddings-azure-inferenceImportant

Azure AI 모델 유추 서비스를 사용하려면 버전

0.2.4llama-index-llms-azure-inference이llama-index-embeddings-azure-inference필요합니다.

환경 구성

Azure AI Foundry 포털에 배포된 LLM을 사용하려면 엔드포인트 및 자격 증명을 연결해야 합니다. 사용하려는 모델에서 필요한 정보를 가져오려면 다음 단계를 따릅니다.

Azure AI Foundry로 이동합니다.

아직 열려 있지 않은 경우 모델이 배포된 프로젝트를 엽니다.

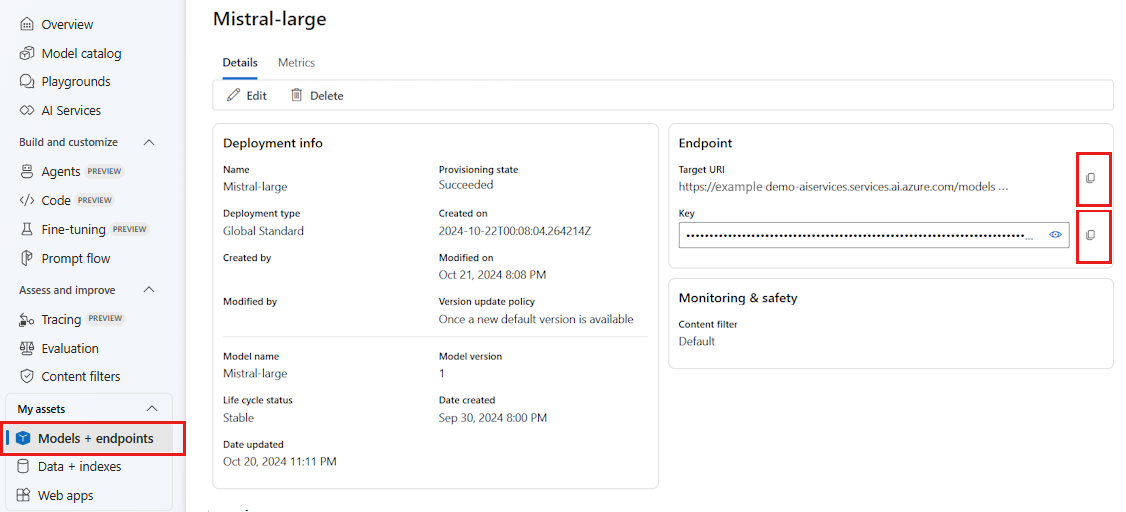

모델 + 엔드포인트로 이동하여 필수 구성 요소에 표시된 대로 배포한 모델을 선택합니다.

엔드포인트 URL과 키를 복사합니다.

팁

모델이 Microsoft Entra ID 지원과 함께 배포된 경우 키가 필요하지 않습니다.

이 시나리오에서는 엔드포인트 URL과 키를 모두 다음 환경 변수에 넣었습니다.

export AZURE_INFERENCE_ENDPOINT="<your-model-endpoint-goes-here>"

export AZURE_INFERENCE_CREDENTIAL="<your-key-goes-here>"

구성되면 엔드포인트에 연결할 클라이언트를 만듭니다.

import os

from llama_index.llms.azure_inference import AzureAICompletionsModel

llm = AzureAICompletionsModel(

endpoint=os.environ["AZURE_INFERENCE_ENDPOINT"],

credential=os.environ["AZURE_INFERENCE_CREDENTIAL"],

)

팁

모델 배포가 Azure OpenAI 서비스 또는 Azure AI Services 리소스에서 호스트되는 경우 Azure OpenAI 모델 및 Azure AI 모델 유추 서비스에 표시된 대로 클라이언트를 구성합니다.

엔드포인트가 Azure AI 모델 유추 서비스 또는 GitHub 모델과 같이 둘 이상의 모델을 제공하는 경우 매개 변수를 지정 model_name 해야 합니다.

import os

from llama_index.llms.azure_inference import AzureAICompletionsModel

llm = AzureAICompletionsModel(

endpoint=os.environ["AZURE_INFERENCE_ENDPOINT"],

credential=os.environ["AZURE_INFERENCE_CREDENTIAL"],

model_name="mistral-large-2407",

)

또는 엔드포인트가 Microsoft Entra ID를 지원하는 경우 다음 코드를 사용하여 클라이언트를 만들 수 있습니다.

import os

from azure.identity import DefaultAzureCredential

from llama_index.llms.azure_inference import AzureAICompletionsModel

llm = AzureAICompletionsModel(

endpoint=os.environ["AZURE_INFERENCE_ENDPOINT"],

credential=DefaultAzureCredential(),

)

참고 항목

Microsoft Entra ID를 사용하는 경우 엔드포인트가 해당 인증 방법을 사용하여 배포되었는지 확인하고 이를 호출하는 데 필요한 권한이 있는지 확인합니다.

비동기 호출을 사용할 계획이라면 자격 증명에 비동기 버전을 사용하는 것이 가장 좋습니다.

from azure.identity.aio import (

DefaultAzureCredential as DefaultAzureCredentialAsync,

)

from llama_index.llms.azure_inference import AzureAICompletionsModel

llm = AzureAICompletionsModel(

endpoint=os.environ["AZURE_INFERENCE_ENDPOINT"],

credential=DefaultAzureCredentialAsync(),

)

Azure OpenAI 모델 및 Azure AI 모델 유추 서비스

Azure OpenAI 서비스 또는 Azure AI 모델 유추 서비스를 사용하는 경우 적어도 0.2.4 버전의 LlamaIndex 통합이 있는지 확인합니다. 특정 api_version매개 변수를 선택해야 하는 경우 매개 변수를 사용합니다api_version.

Azure AI 모델 유추 서비스의 경우 매개 변수를 전달 model_name 해야 합니다.

from llama_index.llms.azure_inference import AzureAICompletionsModel

llm = AzureAICompletionsModel(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=os.environ["AZURE_INFERENCE_CREDENTIAL"],

model_name="mistral-large-2407",

)

Azure OpenAI 서비스의 경우:

from llama_index.llms.azure_inference import AzureAICompletionsModel

llm = AzureAICompletionsModel(

endpoint="https://<resource>.openai.azure.com/openai/deployments/<deployment-name>",

credential=os.environ["AZURE_INFERENCE_CREDENTIAL"],

api_version="2024-05-01-preview",

)

팁

배포에서 사용 중인 API 버전을 확인합니다. 잘못 api_version 되거나 모델에서 지원되지 않는 것을 사용하면 예외가 발생합니다 ResourceNotFound .

유추 매개 변수

추가 매개 변수를 설정하여 이 클라이언트를 사용하는 모든 작업에 대해 유추가 수행되는 방식을 구성할 수 있습니다. 이렇게 하면 모델에 호출할 때마다 해당 정보가 표시되는 것을 방지할 수 있습니다.

llm = AzureAICompletionsModel(

endpoint=os.environ["AZURE_INFERENCE_ENDPOINT"],

credential=os.environ["AZURE_INFERENCE_CREDENTIAL"],

temperature=0.0,

model_kwargs={"top_p": 1.0},

)

Azure AI 모델 유추 API에서 지원되지 않지만 기본 모델에서 사용할 수 있는 매개 변수(참조)가 있는 경우 model_extras 인수를 사용할 수 있습니다. 다음 예에서는 Mistral 모델에서만 사용할 수 있는 매개 변수 safe_prompt가 전달됩니다.

llm = AzureAICompletionsModel(

endpoint=os.environ["AZURE_INFERENCE_ENDPOINT"],

credential=os.environ["AZURE_INFERENCE_CREDENTIAL"],

temperature=0.0,

model_kwargs={"model_extras": {"safe_prompt": True}},

)

LLM 모델 사용

클라이언트를 직접 사용하거나 LlamaIndex에서 코드에서 사용하는 모델을 구성할 수 있습니다. 모델을 직접 사용하려면 채팅 지침 모델에 대해 chat 메서드를 사용합니다.

from llama_index.core.llms import ChatMessage

messages = [

ChatMessage(

role="system", content="You are a pirate with colorful personality."

),

ChatMessage(role="user", content="Hello"),

]

response = llm.chat(messages)

print(response)

다음과 같이 출력을 스트리밍할 수도 있습니다.

response = llm.stream_chat(messages)

for r in response:

print(r.delta, end="")

complete 메서드는 chat-completions 형식의 모델에 계속 사용할 수 있습니다. 이러한 경우, 입력한 텍스트는 role="user"가 포함된 메시지로 변환됩니다.

포함 모델 사용

LLM 클라이언트를 만드는 것과 같은 방식으로 포함 모델에 연결할 수 있습니다. 다음 예에서는 환경 변수를 설정하여 포함 모델을 가리키도록 합니다.

export AZURE_INFERENCE_ENDPOINT="<your-model-endpoint-goes-here>"

export AZURE_INFERENCE_CREDENTIAL="<your-key-goes-here>"

그런 다음 클라이언트를 만듭니다.

from llama_index.embeddings.azure_inference import AzureAIEmbeddingsModel

embed_model = AzureAIEmbeddingsModel(

endpoint=os.environ["AZURE_INFERENCE_ENDPOINT"],

credential=os.environ['AZURE_INFERENCE_CREDENTIAL'],

)

다음 예에서는 이 모델이 작동하는지 확인하기 위한 간단한 테스트를 보여 줍니다.

from llama_index.core.schema import TextNode

nodes = [

TextNode(

text="Before college the two main things I worked on, "

"outside of school, were writing and programming."

)

]

response = embed_model(nodes=nodes)

print(response[0].embedding)

코드에서 사용하는 모델 구성

LlamaIndex로 개발한 코드에서 LLM 또는 포함 모델 클라이언트를 개별적으로 사용할 수도 있고, Settings 옵션을 사용하여 전체 세션을 구성할 수도 있습니다. 세션을 구성하면 모든 작업에 대해 모든 코드가 동일한 모델을 사용할 수 있다는 이점이 있습니다.

from llama_index.core import Settings

Settings.llm = llm

Settings.embed_model = embed_model

그러나 대부분의 작업에는 일반 모델을 사용하고 특정 작업에는 특정 모델을 사용하려는 경우도 있습니다. 이런 경우에는 각 LlamaIndex 구문에 대해 사용하는 LLM 또는 포함 모델을 설정하는 것이 유용합니다. 다음 예에서는 특정 모델을 설정합니다.

from llama_index.core.evaluation import RelevancyEvaluator

relevancy_evaluator = RelevancyEvaluator(llm=llm)

일반적으로 두 가지 전략을 함께 사용합니다.