Azure AI Foundry 포털의 모델 벤치마크

Important

이 문서에 표시된 항목(미리 보기)은 현재 퍼블릭 미리 보기에서 확인할 수 있습니다. 이 미리 보기는 서비스 수준 계약 없이 제공되며, 프로덕션 워크로드에는 권장되지 않습니다. 특정 기능이 지원되지 않거나 기능이 제한될 수 있습니다. 자세한 내용은 Microsoft Azure Preview에 대한 추가 사용 약관을 참조하세요.

Azure AI Foundry 포털에서 업계에서 사용할 수 있는 모델 및 데이터 세트 간에 벤치마크를 비교하여 비즈니스 시나리오에 맞는 모델을 결정할 수 있습니다. 모델 카탈로그 내에서 자세한 벤치마킹 결과에 직접 액세스할 수 있습니다. 이미 모델을 염두에 두든 모델을 탐색하든 Azure AI의 벤치마킹 데이터를 통해 정보에 입각한 의사 결정을 빠르고 효율적으로 수행할 수 있습니다.

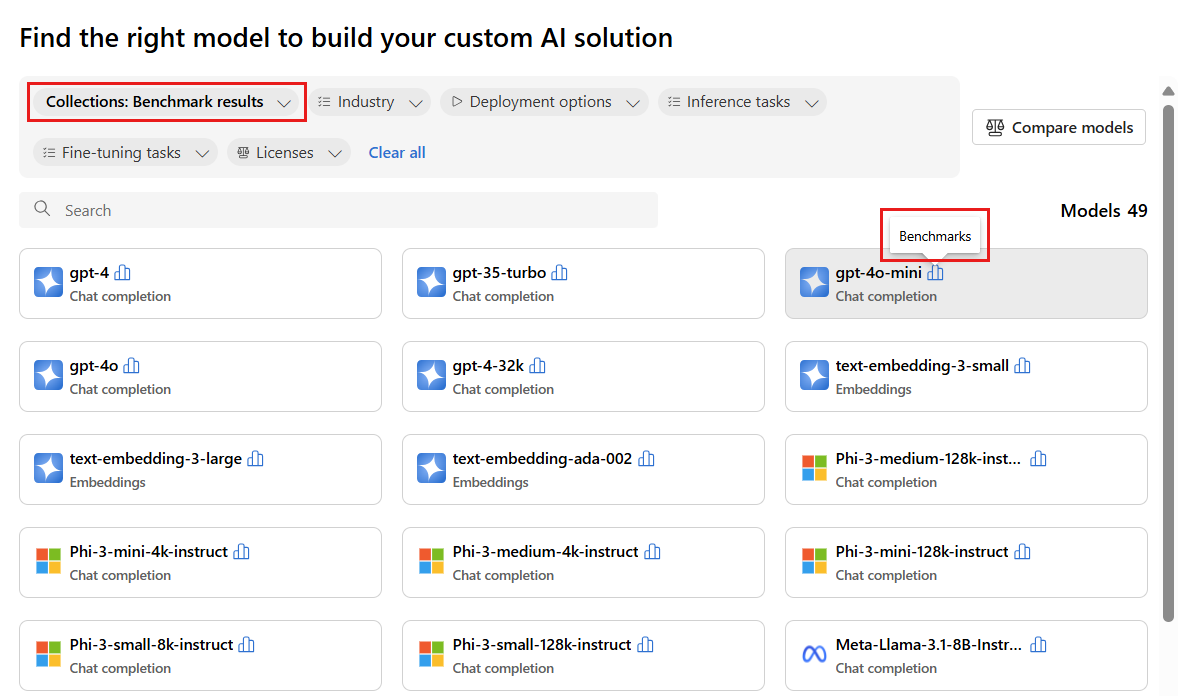

Azure AI는 인기 있고 가장 자주 사용되는 일부 모델에 대한 모델 벤치마킹을 지원합니다. 지원되는 모델에는 히스토그램처럼 보이는 벤치마크 아이콘이 있습니다. 컬렉션 필터를 사용하고 벤치마크 결과를 선택하여 모델 카탈로그에서 이러한 모델을 찾을 수 있습니다. 그런 다음 검색 기능을 사용하여 특정 모델을 찾을 수 있습니다.

모델 기준은 작업을 시작하기 전에 모델 및 데이터 세트의 지속 가능성에 대해 합리적 결정을 내리는 데 도움이 됩니다. 벤치마크는 벤치마킹 메트릭의 포괄적인 비교를 기반으로 작업에 가장 적합한 모델의 큐레이팅된 목록입니다. Azure AI Foundry는 모델 카탈로그 컬렉션에 따라 모델에 대해 다음과 같은 벤치마크를 제공합니다.

- LLM(대규모 언어 모델) 및 SLM(소규모 언어 모델)의 벤치마크

- 포함 모델의 벤치마크

LLM 및 SLLM의 벤치마킹

모델 벤치마크는 품질, 성능 및 비용 범주에서 LLM 및 SLLM을 평가합니다. 벤치마크는 새 메트릭 및 데이터 세트가 기존 모델에 추가되는 것과, 모델 카탈로그에 새 모델이 추가되는 것에 따라 정기적으로 업데이트됩니다.

품질

Azure AI는 정확도 및 프롬프트 지원 메트릭의 두 가지 주요 범주로 그룹화된 다양한 메트릭에서 LLM 및 SLLM의 품질을 평가합니다.

정확도 메트릭의 경우:

| 메트릭 | 설명 |

|---|---|

| 정확도(Accuracy) | 정확도 점수는 데이터 세트 및 모델 수준에서 사용할 수 있습니다. 데이터 세트 수준에서 점수는 데이터 세트의 모든 예제에 대해 계산된 정확도 메트릭의 평균 값입니다. 사용되는 정확도 메트릭은 exact-match 메트릭을 사용하는 HumanEval 데이터 세트를 제외한 모든 경우에 사용됩니다pass@1. 정확한 일치는 모델 생성 텍스트를 데이터 세트에 따라 정답과 비교하고, 생성된 텍스트가 대답과 정확히 일치하는 경우 1을 보고하고, 그렇지 않으면 0을 보고합니다. pass@1 메트릭은 코드 생성 작업에서 단위 테스트 집합을 통과하는 모델 솔루션의 비율을 측정합니다. 모델 수준에서 정확도 점수는 각 모델에 대한 데이터 세트 수준 정확도의 평균입니다. |

프롬프트 지원 메트릭의 경우:

| 메트릭 | 설명 |

|---|---|

| 일관성 | 일관성은 언어 모델이 출력 흐름을 얼마나 원활하게 생성하고, 자연스럽게 읽고, 인간과 유사하게 언어를 모방할 수 있는지 평가합니다. |

| 유창성 | 유창성은 생성된 AI의 예측 답변에 대한 언어 숙련도를 평가합니다. 생성된 텍스트가 문법 규칙, 구문 구조 및 어휘의 적절한 사용을 얼마나 잘 준수하는지 평가하여 언어적으로 정확하고 자연스러운 응답을 생성합니다. |

| GPT | GPTSimilarity는 참값(ground truth) 문장(또는 문서)과 AI 모델에서 생성된 예측 문장 간의 유사성에 대한 측정값입니다. 메트릭은 첫 번째 문장 수준 포함을 계산하여 계산되며, 기본 진리와 모델의 예측 모두에 embeddings API를 사용합니다. 이러한 포함은 문장의 고차원 벡터 표현을 나타내며 의미 체계적 의미와 컨텍스트를 캡처합니다. |

| 근거성 | 근거성은 언어 모델의 생성된 답변이 입력 소스의 정보와 얼마나 잘 일치하는지 측정합니다. |

| 관련성 | 관련성은 언어 모델의 생성된 응답이 관련되어 있고 지정된 질문과 직접 연결된 정도를 측정합니다. |

또한 Azure AI는 다음과 같이 품질 인덱스를 표시합니다.

| Index | 설명 |

|---|---|

| 품질 인덱스 | 품질 인덱스는 GPTSimilarity를 0에서 1 사이로 축소한 다음 정확도 메트릭을 사용하여 평균을 계산하여 계산됩니다. 품질 인덱스의 값이 높을수록 좋습니다. |

품질 인덱스는 15개의 표준 데이터 세트에 대해 적용 가능한 기본 메트릭(정확도, 다시 크기 조정된 GPTSimilarity)의 평균 점수를 나타내며 0에서 1까지의 크기로 제공됩니다.

품질 인덱스는 두 가지 범주의 메트릭을 구성합니다.

- 정확도(예: 정확한 일치 또는

pass@k). 0에서 1까지의 범위입니다. - 프롬프트 기반 메트릭(예: GPTSimilarity, 접지성, 일관성, 유창성 및 관련성). 범위는 1에서 5까지입니다.

품질 인덱스 값의 안정성은 모델의 전반적인 품질을 나타내는 지표를 제공합니다.

성능

성능 메트릭은 매 트레일 사이에 1시간 간격으로 매일 전송되는 24개의 트레일(트레일당 두 개의 요청)을 기반으로 14일 동안 집계로 계산됩니다. 모델 엔드포인트에 대한 각 요청에 다음 기본 매개 변수가 사용됩니다.

| 매개 변수 | 값 | 적용 대상 |

|---|---|---|

| 지역 | 미국 동부/미국 동부 2 | 서버리스 API 및 Azure OpenAI |

| TPM(분당 토큰) 속도 제한 | 30k(Azure OpenAI 기반 180 RPM) N/A(서버리스 API) |

Azure OpenAI 모델의 경우 배포 유형(표준, 전역, 글로벌 표준 등)에 따라 속도 제한 범위가 있는 사용자가 선택할 수 있습니다. 서버리스 API의 경우 이 설정은 추상화됩니다. |

| 요청 수 | 1시간마다 트레일에서 두 번의 요청(하루에 24개 트레일) | 서버리스 API, Azure OpenAI |

| 트레일/실행 수 | 336개의 실행에 대해 하루에 24개의 트레일이 있는 14일 | 서버리스 API, Azure OpenAI |

| 프롬프트/컨텍스트 길이 | 보통 길이 | 서버리스 API, Azure OpenAI |

| 처리된 토큰 수(보통) | 출력 토큰에 대한 입력의 경우 80:20 비율, 즉 200개의 출력 토큰에 대한 800개의 입력 토큰입니다. | 서버리스 API, Azure OpenAI |

| 동시 요청 수 | 하나(요청이 차례로 순차적으로 전송됨) | 서버리스 API, Azure OpenAI |

| 데이터 | 가상(정적 텍스트에서 준비된 입력 프롬프트) | 서버리스 API, Azure OpenAI |

| 지역 | 미국 동부/미국 동부 2 | 서버리스 API 및 Azure OpenAI |

| 배포 유형 | Standard | Azure OpenAI에만 적용 |

| Streaming | True | 서버리스 API 및 Azure OpenAI에 적용됩니다. 관리형 컴퓨팅을 통해 배포된 모델의 경우 스트리밍 시나리오를 복제하도록 max_token = 1을 설정하여 관리형 컴퓨팅에 대한 TTFT(첫 번째 토큰)의 총 시간과 같은 메트릭을 계산할 수 있습니다. |

| Tokenizer | Tiktoken 패키지(Azure OpenAI) 포옹 얼굴 모델 ID(서버리스 API) |

Face 모델 ID(Azure 서버리스 API) 포옹 |

LLM 및 SLLM의 성능은 다음 메트릭에서 평가됩니다.

| 메트릭 | 설명 |

|---|---|

| 대기 시간 평균 | 요청을 처리하는 데 걸린 평균 시간(초)으로, 여러 요청을 통해 계산됩니다. 이 메트릭을 계산하기 위해 2주 동안 매시간 엔드포인트에 요청을 보내고 평균을 계산합니다. |

| 대기 시간 P50 | 대기 시간의 50번째 백분위수 값(중앙값)(요청 간에 소요된 시간 및 성공적인 코드로 전체 응답을 수신하는 경우). 예를 들어 엔드포인트에 요청을 보내면 요청의 50%가 'x' 초 안에 완료되고 'x'는 대기 시간 측정값입니다. |

| 대기 시간 P90 | 대기 시간의 90번째 백분위수 값입니다(요청 간에 소요된 시간과 성공적인 코드로 전체 응답을 수신하는 경우). 예를 들어 엔드포인트에 요청을 보내면 요청의 90%가 'x' 초 안에 완료되고 'x'는 대기 시간 측정값입니다. |

| 대기 시간 P95 | 대기 시간의 95번째 백분위수 값입니다(요청 간에 소요된 시간 및 성공적인 코드로 전체 응답을 수신하는 경우). 예를 들어 엔드포인트에 요청을 보내면 요청의 95%가 'x' 초 안에 완료되고 'x'는 대기 시간 측정값입니다. |

| 대기 시간 P99 | 대기 시간의 99번째 백분위수 값입니다(요청 간에 소요된 시간과 성공적인 코드로 전체 응답을 수신하는 경우). 예를 들어 엔드포인트에 요청을 보내면 요청의 99%가 'x' 초 안에 완료되고 'x'는 대기 시간 측정값입니다. |

| 처리량 GTPS | GTPS(초당 생성된 토큰)는 요청이 엔드포인트로 전송되는 시점부터 초당 생성되는 출력 토큰의 수입니다. |

| 처리량 TTPS | TTPS(초당 총 토큰 수)는 입력 프롬프트와 생성된 출력 토큰을 포함하여 초당 처리되는 총 토큰 수입니다. |

| 대기 시간 TTFT | TTFT(첫 번째 토큰에 대한 총 시간)는 스트리밍을 사용할 때 엔드포인트에서 반환되는 응답의 첫 번째 토큰에 걸리는 시간입니다. |

| 토큰 간 시간 | 이 메트릭은 받은 토큰 사이의 시간입니다. |

또한 Azure AI는 다음과 같이 대기 시간 및 처리량에 대한 성능 인덱스를 표시합니다.

| Index | 설명 |

|---|---|

| 대기 시간 인덱스 | 첫 번째 토큰에 대한 평균 시간입니다. 값이 낮을수록 좋습니다. |

| 처리량 인덱스 | 초당 평균 생성된 토큰입니다. 값이 높을수록 좋습니다. |

대기 시간 또는 처리량과 같은 성능 메트릭의 경우 첫 번째 토큰에 대한 시간과 초당 생성된 토큰은 모델의 일반적인 성능 및 동작에 대한 전반적인 감각을 향상합니다. 정기적인 주기에 따라 성능 번호를 새로 고칩니다.

비용

비용 계산은 Azure AI 플랫폼에서 호스트되는 LLM 또는 SLM 모델 엔드포인트를 사용하기 위한 추정치입니다. Azure AI는 서버리스 API 및 Azure OpenAI 모델의 비용 표시를 지원합니다. 이러한 비용은 변경될 수 있으므로 정기적으로 비용 계산을 새로 고칩니다.

LLM 및 SLLM의 비용은 다음 메트릭에서 평가됩니다.

| 메트릭 | 설명 |

|---|---|

| 입력 토큰당 비용 | 1백만 개의 입력 토큰에 대한 서버리스 API 배포 비용 |

| 출력 토큰당 비용 | 1백만 개의 출력 토큰에 대한 서버리스 API 배포 비용 |

| 예상 비용 | 입력 토큰당 비용 및 출력 토큰당 비용의 합계에 대한 비용이며 비율은 3:1입니다. |

또한 Azure AI는 다음과 같이 비용 인덱스를 표시합니다.

| Index | 설명 |

|---|---|

| 비용 인덱스 | 예상 비용입니다. 값이 낮을수록 좋습니다. |

포함 모델의 벤치마킹

모델 벤치마크는 품질에 따라 포함 모델을 평가합니다.

품질

포함 모델의 품질은 다음 메트릭에서 평가됩니다.

| 메트릭 | 설명 |

|---|---|

| 정확도 | 정확도는 처리된 총예측 수 중 올바른 예측의 비율입니다. |

| F1 점수 | F1 점수는 정밀도 및 재현율의 가중 평균이며, 가장 좋은 값은 1(완벽한 정밀도 및 재현율)이며 최악의 경우는 0입니다. |

| 평균 정밀도(MAP) | MAP는 순위 및 추천 시스템의 품질을 평가합니다. 제안된 항목의 관련성과 시스템이 더 관련성이 큰 항목을 맨 위에 배치하는 데 얼마나 좋은지 모두 측정합니다. 값의 범위는 0에서 1까지이며 MAP이 높을수록 시스템에서 관련 항목을 목록에 더 높게 배치할 수 있습니다. |

| NDCG(정규화된 할인된 누적 이득) | NDCG는 관련성에 따라 항목을 정렬하는 기계 학습 알고리즘의 기능을 평가합니다. 순위를 모든 관련 항목이 목록 맨 위에 있는 이상적인 순서와 비교합니다. 여기서 k는 순위 품질을 평가하는 동안 목록 길이입니다. 벤치마크에서 k=10은 메트릭 ndcg_at_10으로 표시됩니다. 즉, 상위 10개 항목을 살펴봅니다. |

| Precision | 정밀도는 특정 클래스의 인스턴스를 올바르게 식별하는 모델의 기능을 측정합니다. 정밀도는 대상 클래스를 예측할 때 기계 학습 모델이 올바른 빈도를 보여 줍니다. |

| Spearman 상관 관계 | 코사인 유사성을 기반으로 하는 Spearman 상관 관계는 먼저 변수 간의 코사인 유사성을 계산한 다음, 이러한 점수의 순위를 지정하고 순위를 사용하여 Spearman 상관 관계를 계산하여 계산됩니다. |

| V 측정값 | V 측정값은 클러스터링의 품질을 평가하는 데 사용되는 메트릭입니다. V 측정값은 동질성과 완전성의 조화 평균으로 계산되어 의미 있는 점수를 위해 둘 사이의 균형을 보장합니다. 가능한 점수는 0에서 1 사이이며, 하나는 완벽하게 완전한 레이블 지정입니다. |

점수 계산

개별 점수

벤치마크 결과는 언어 모델 평가에 일반적으로 사용되는 공용 데이터 세트에서 비롯됩니다. 대부분의 경우 데이터는 데이터의 작성자 또는 큐레이터가 유지 관리하는 GitHub 리포지토리에서 호스팅됩니다. Azure AI 평가 파이프라인은 원래 원본에서 데이터를 다운로드하고, 각 예제 행에서 프롬프트를 추출하고, 모델 응답을 생성한 다음, 관련 정확도 메트릭을 계산합니다.

프롬프트 생성은 데이터 세트 및 업계 표준을 소개하는 문서에서 지정한 대로 각 데이터 세트에 대한 모범 사례를 따릅니다. 대부분의 경우 각 프롬프트에는 여러 샷이 포함됩니다. 즉, 작업의 모델을 소수로 만들기 위한 전체 질문과 답변의 몇 가지 예가 있습니다. 평가 파이프라인은 평가에서 제외된 데이터의 일부에서 질문과 답변을 샘플링하여 샷을 만듭니다.