오프라인 평가를 통해 학습 루프 분석

Important

2023년 9월 20일부터 새로운 Personalizer 리소스를 만들 수 없습니다. Personalizer 서비스는 2026년 10월 1일에 사용 중지됩니다.

오프라인 평가를 만들고 결과를 이해하는 방법을 알아봅니다.

오프라인 평가를 사용하면 로깅된(기록) 데이터 기간 동안 애플리케이션의 기본 동작과 비교할 때 Personalizer가 얼마나 효과적인지 측정하고, 다른 모델 구성 설정이 모델에 얼마나 좋은 성능을 가져오는지 평가할 수 있습니다.

오프라인 평가를 만들 때 최적화 검색 옵션은 다양한 학습 정책 값에 대해 오프라인 평가를 실행하여 모델의 성능을 향상시킬 수 있는 값을 찾습니다. 오프라인 평가에서 평가할 추가 정책을 제공할 수도 있습니다.

자세한 내용은 오프라인 평가를 참조하세요.

필수 조건

- 구성된 Personalizer 리소스

- Personalizer 리소스에는 전형적인 크기의 로깅된 데이터가 있어야 합니다. 의미 있는 평가 결과를 위해 로그에 최소 50,000개의 이벤트를 권장합니다. 필요에 따라 이 평가에서 테스트하고 비교하려는 학습 정책 파일을 이전에 내보냈을 수도 있습니다.

오프라인 평가 실행

Azure Portal에서 Personalizer 리소스를 찾습니다.

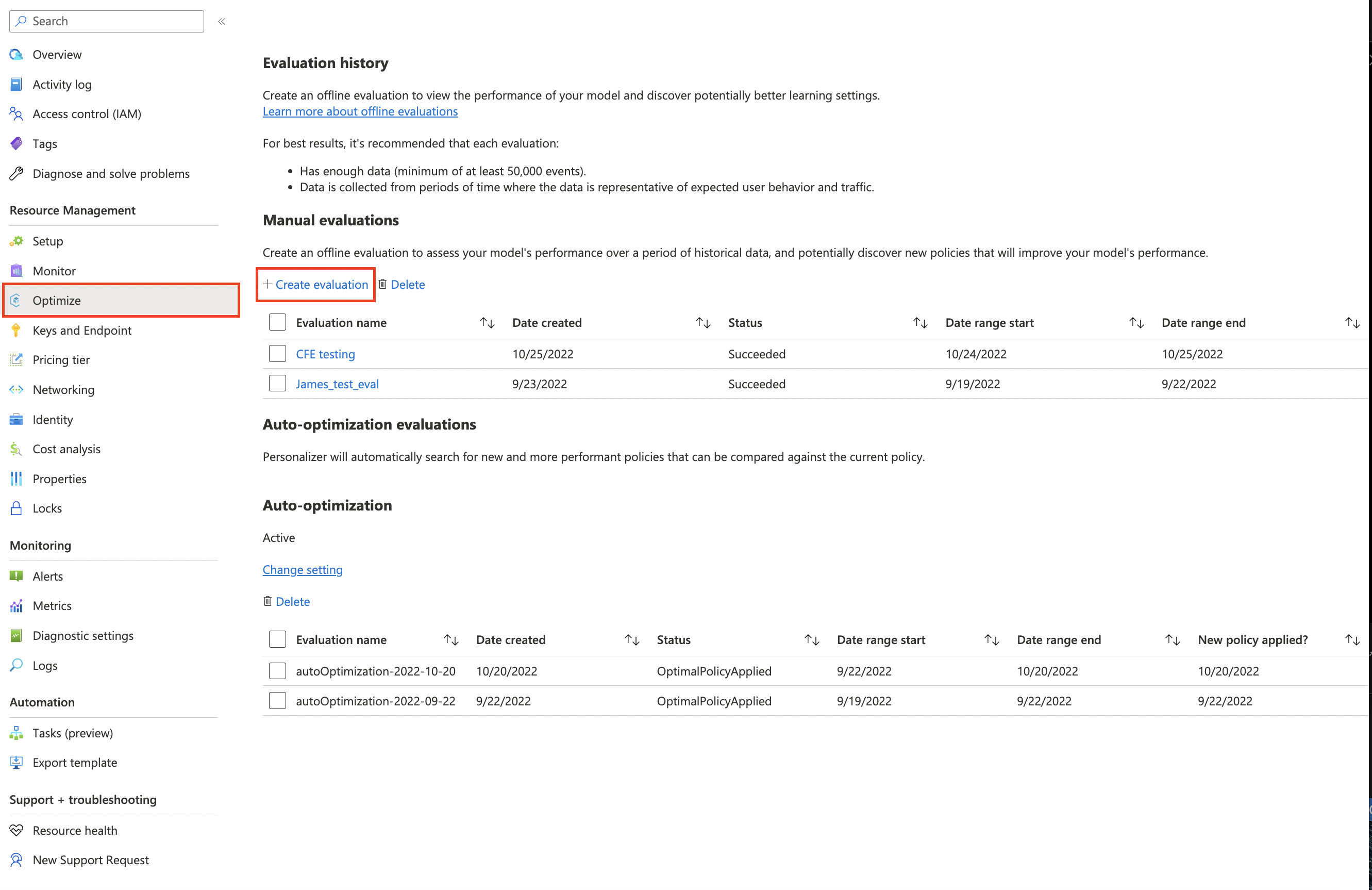

Azure Portal에서 평가 섹션으로 이동하여 평가 만들기를 선택합니다.

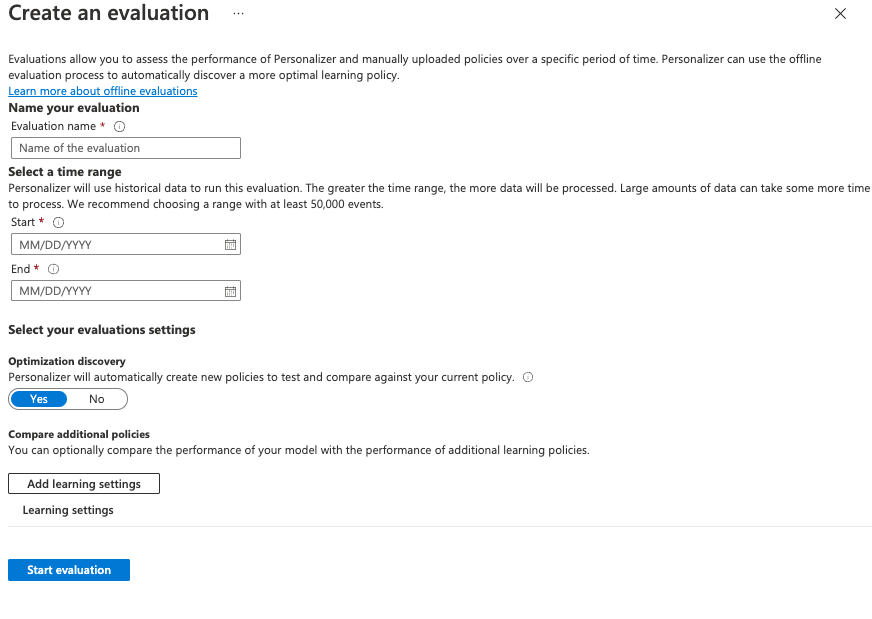

평가 만들기 창에서 옵션을 입력합니다.

- 평가 이름.

- 시작 날짜 및 종료 날짜 - 평가에 사용할 데이터 범위를 지정하는 날짜입니다. 이 데이터는 데이터 보존 값에 지정된 대로 로그에 있어야 합니다.

- Personalizer가 좀 더 최적화된 학습 정책을 찾으려는 경우 최적화 검색을 예로 설정합니다.

- 학습 설정 추가 - 사용자 지정 또는 이전에 내보낸 정책을 평가하려는 경우 학습 정책 파일을 업로드합니다.

평가 시작을 선택하여 평가를 시작합니다.

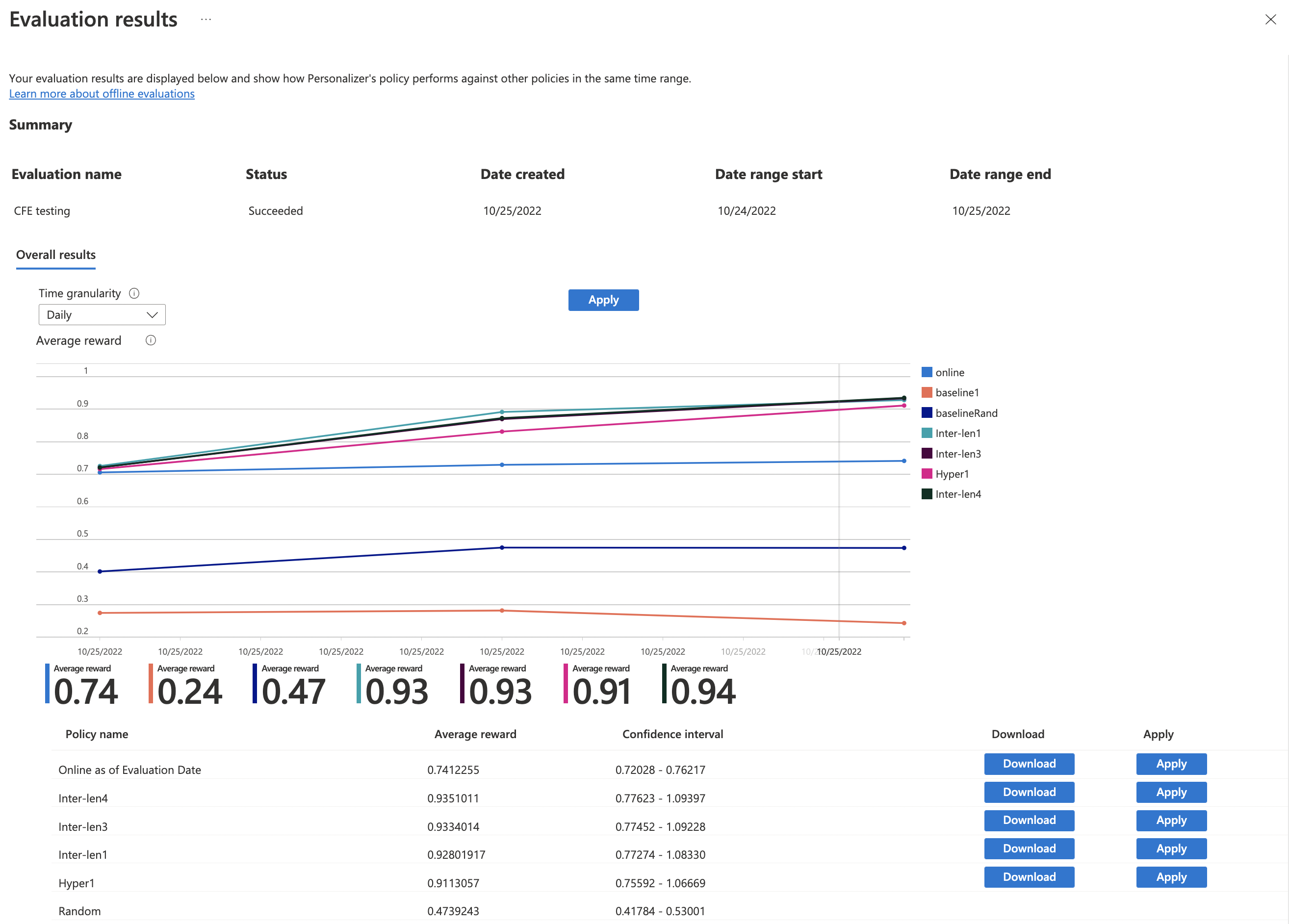

평가 결과 검토

처리할 데이터의 양, 비교할 학습 정책의 수, 최적화 요청 여부에 따라 평가가 오래 걸릴 수 있습니다.

완료되면 평가 목록에서 평가를 선택한 다음 애플리케이션의 점수와 다른 잠재적인 학습 설정 비교를 선택할 수 있습니다. 현재 학습 정책이 새 정책과 비교하여 수행되는 방식을 확인하려면 이 기능을 선택합니다.

다음으로, 학습 정책의 성능을 검토합니다.

차트에는 예상 평균 보상, 신뢰도 간격 및 특정 정책을 다운로드하거나 적용하는 옵션과 함께 다양한 학습 정책이 표시됩니다.

- "Online" - Personalizer의 현재 정책

- "Baseline1" - 애플리케이션의 기준 정책

- "BaselineRand" - 임의로 작업을 수행하는 정책

- "Inter-len#" 또는 "Hyper#" - 최적화 검색에 따라 만든 정책

적용을 선택하여 모델을 데이터에 가장 적합하도록 향상시키는 정책을 적용합니다.

다음 단계

- 오프라인 평가 수행 방법에 대해 알아봅니다.