HX 시리즈 가상 머신 개요

적용 대상: ✔️ Linux VM ✔️ Windows VM ✔️ 유연한 확장 집합 ✔️ 균일한 확장 집합

HX 시리즈 서버에는 AMD 3D-V 캐시가 포함된 총 192개의 실제 "Zen4" 코어에 대해 2 * 96 코어 EPYC 9V33X CPU가 있습니다. HX에서는 SMT(동시 멀티스레딩)을 사용하도록 설정할 수 없습니다. 이 192개의 코어는 24개의 섹션(소켓당 12개)으로 나뉘며, 각 섹션에는 96MB L3 캐시에 균일하게 액세스할 수 있는 프로세서 코어가 8개 포함됩니다. Azure HX 서버는 다음 AMD BIOS 설정도 실행합니다.

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

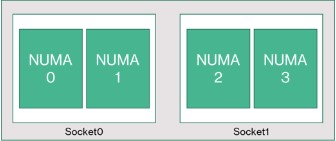

따라서 서버는 48개의 코어 크기마다 NUMA 도메인 4개(소켓당 2개)를 사용하여 부팅됩니다. 각 NUMA는 실제 DRAM의 6개 채널에 직접 액세스할 수 있습니다.

Azure 하이퍼바이저가 VM을 방해하지 않고 작동할 수 있는 공간을 제공하기 위해 서버당 16개의 물리적 코어를 예약합니다.

VM 토폴로지

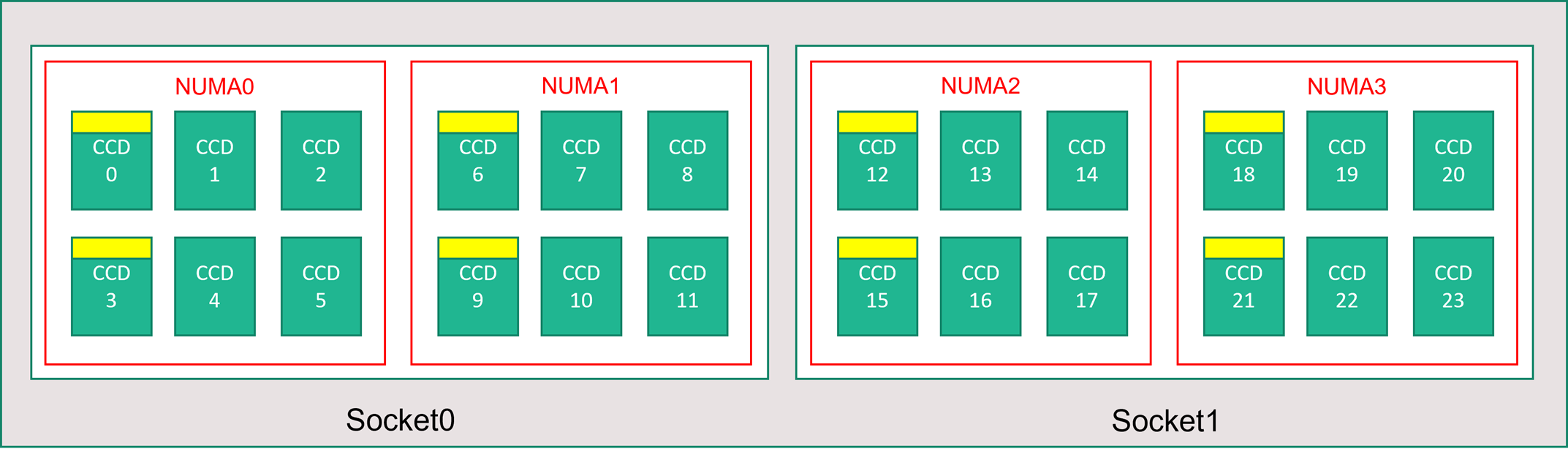

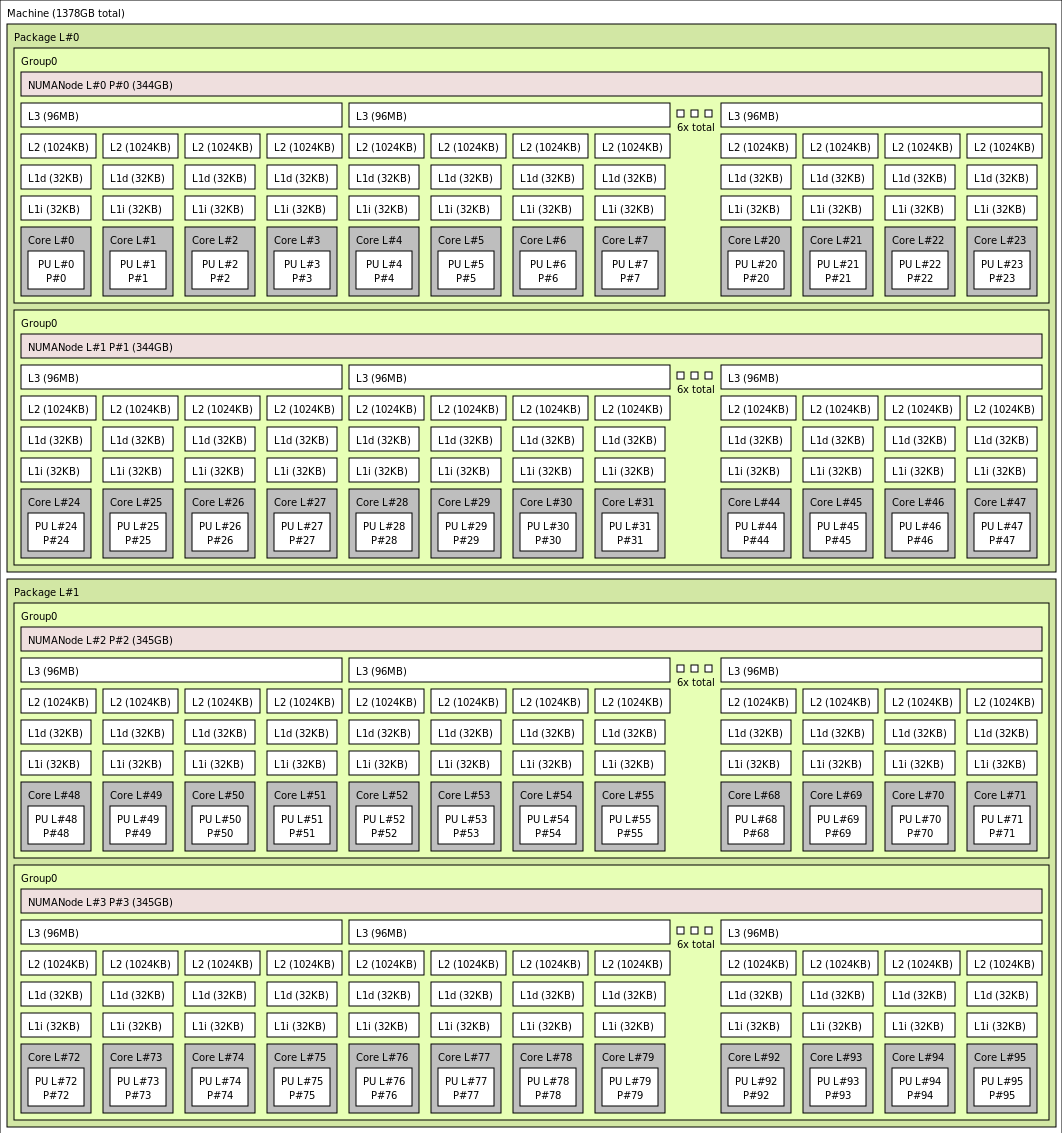

다음 다이어그램에는 서버의 토폴로지가 나와 있습니다. 이 16개의 하이퍼바이저 호스트 코어(노란색)를 두 CPU 소켓에서 대칭으로 예약하여 각 NUMA 도메인에 있는 특정 CCD(Core Complex Dies)에서 처음 코어 2개를 가져오고 나머지 코어는 HX 시리즈 VM(녹색)에 사용합니다.

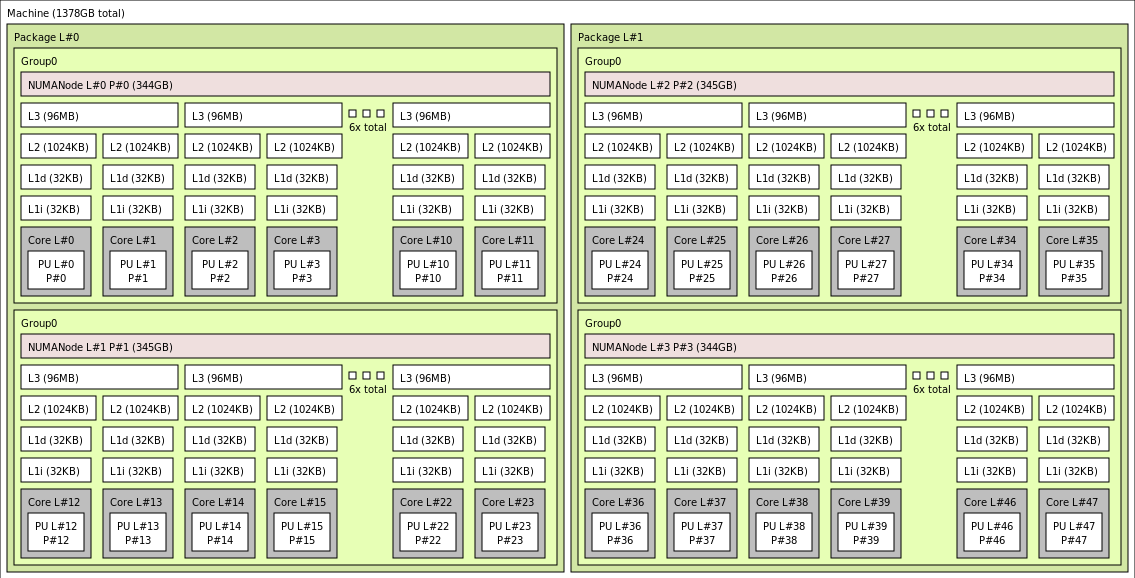

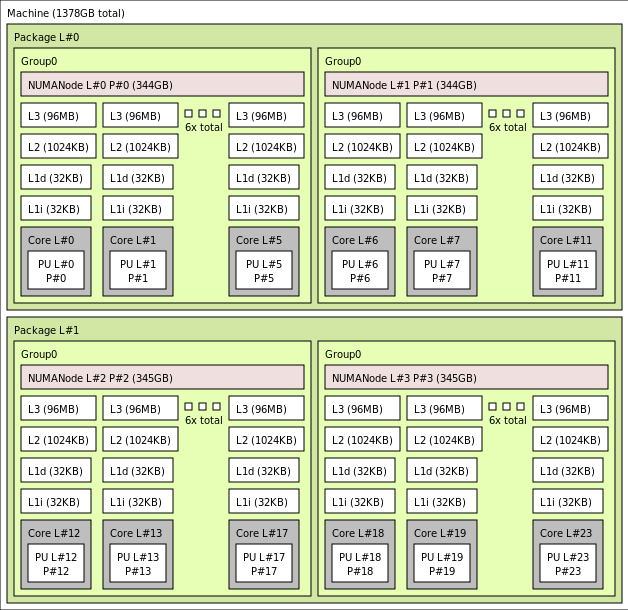

CCD 경계는 NUMA 경계와 다릅니다. HX에서는 6개의 연속 CCD 그룹이 호스트 서버 수준과 게스트 VM 내에서 모두 NUMA 도메인으로 구성됩니다. 따라서 모든 HX VM 크기는 아래와 같이 OS 및 애플리케이션에 나타나는 4개의 균일한 NUMA 도메인을 노출하며, 각 도메인에는 특정 HX VM 크기에 따라 코어 수가 다릅니다.

각 HX VM 크기는 다음과 같이 AMD EPYC 9004 시리즈와 다른 CPU의 실제 레이아웃, 기능 및 성능이 유사합니다.

| HX 시리즈 VM 크기 | NUMA 도메인 | NUMA 도메인당 코어 수 | AMD EPYC와의 유사성 |

|---|---|---|---|

| Standard_HX176rs | 4 | 44 | 이중 소켓 EPYC 9V33X |

| HX176-144rs | 4 | 36 | 이중 소켓 EPYC 9V33X |

| HX176-96rs | 4 | 24 | 이중 소켓 EPYC 9V33X |

| HX176-48rs | 4 | 12 | 이중 소켓 EPYC 9V33X |

| HX176-24rs | 4 | 6 | 이중 소켓 EPYC 9V33X |

참고 항목

제한된 코어 VM 크기는 VM에 노출되는 물리적 코어의 수만 줄입니다. 모든 전역 공유 자산(RAM, 메모리 대역폭, L3 캐시, GMI 및 xGMI 연결, InfiniBand, Azure 이더넷 네트워크, 로컬 SSD)은 일정하게 유지됩니다. 이를 통해 고객은 지정된 워크로드 또는 소프트웨어 라이선스 요구 사항 집합에 가장 적합한 VM 크기를 선택할 수 있습니다.

각 HX VM 크기의 가상 NUMA 매핑은 기본 실제 NUMA 토폴로지에 매핑됩니다. 하드웨어 토폴로지에 대한 오해의 소지가 있는 추상화 가능성은 없습니다.

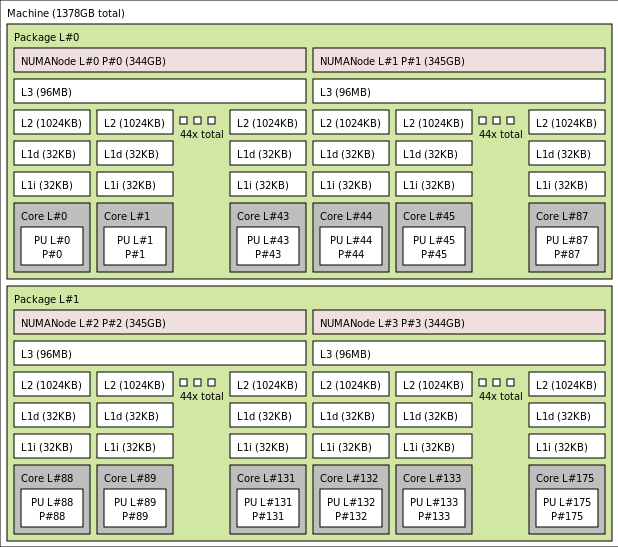

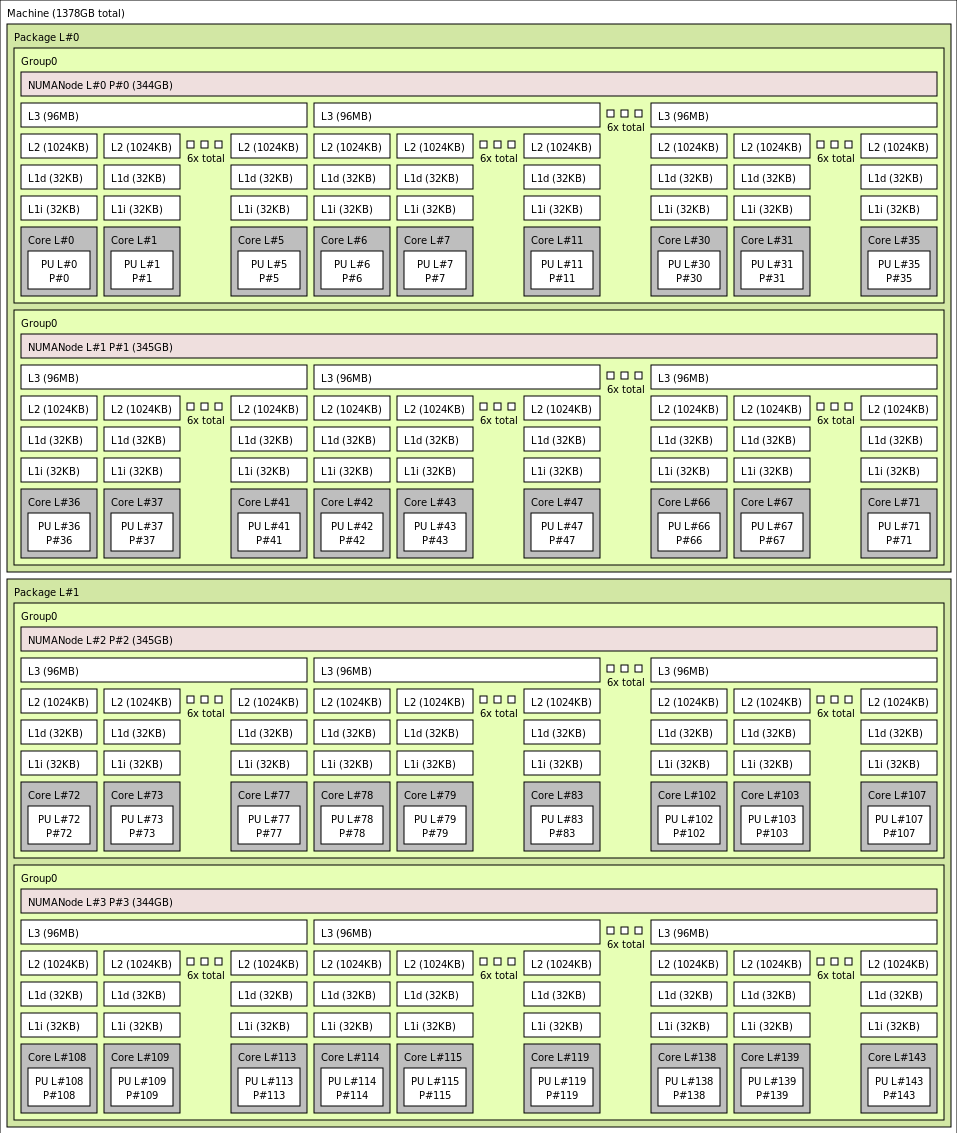

다양한 HX VM 크기의 정확한 토폴로지는 lstopo의 출력을 사용하여 다음과 같이 표시됩니다.

lstopo-no-graphics --no-io --no-legend --of txt

Standard_HX176rs에 대한 lstopo 출력을 보려면 클릭합니다

Standard_HX176-144rs에 대한 lstopo 출력을 보려면 클릭합니다

Standard_HX176-96rs에 대한 lstopo 출력을 보려면 클릭합니다

Standard_HX176-48rs에 대한 lstopo 출력을 보려면 클릭합니다

Standard_HX176-24rs에 대한 lstopo 출력을 보려면 클릭합니다

InfiniBand 네트워킹

HX VM에는 최대 400기가비트/초로 작동하는 NVIDIA Mellanox NDR InfiniBand 네트워크 어댑터(Connectx-7)도 있습니다. NIC는 SRIOV를 통해 VM으로 전달되어 네트워크 트래픽이 하이퍼바이저를 우회할 수 있습니다. 따라서 고객은 운영 체제 미설치 환경처럼 HX VM에 표준 Mellanox OFED 드라이버를 로드합니다.

HX VM은 적응형 라우팅, 동적 연결 전송(DCT, 표준 RC 및 UD 전송 외에) 및 ConnectX-7 어댑터의 온보딩 프로세서에 대한 MPI Collective의 하드웨어 기반 오프로드를 지원합니다. 이러한 기능은 애플리케이션 성능, 확장성 및 일관성을 향상하므로 사용을 권장합니다.

임시 스토리지

HX VM에는 물리적 로컬 SSD 디바이스가 3개 있습니다. 한 디바이스는 페이지 파일 역할을 하도록 미리 포맷되어 있으며 VM 내에서 일반 "SSD" 디바이스로 나타납니다.

다른 두 개의 더 큰 SSD는 NVMeDirect를 통해 형식이 지정되지 않은 블록 NVMe 디바이스로 제공됩니다. 블록 NVMe 디바이스는 하이퍼바이저를 무시하므로 더 높은 대역폭, 더 높은 IOPS 및 IOP당 대기 시간이 더 낮습니다.

스트라이프 배열에서 쌍으로 연결된 경우 NVMe SSD는 최대 12GB/s의 읽기, 7GB/s의 쓰기를 제공하고 전체 큐 깊이에 대해 최대 186,000의 IOPS(읽기) 및 201,000의 IOPS(쓰기)를 제공합니다.

하드웨어 사양

| 하드웨어 사양 | HX 시리즈 VM |

|---|---|

| 코어 | 176, 144, 96, 48, 24(SMT 사용 안 함) |

| CPU | AMD EPYC 9V33X |

| CPU 주파수(비 AVX) | 2.4GHz 기본, 3.7GHz 최대 부스트 |

| 메모리 | 1.4TB(코어당 RAM이 VM 크기에 따라 다름) |

| 로컬 디스크 | 2 * 1.8TB NVMe(블록), 480GB SSD(페이지 파일) |

| InfiniBand | 400Gb/s Mellanox ConnectX-7 NDR InfiniBand |

| 네트워크 | 80GB/s 이더넷(40GB/s 사용 가능) Azure 2세대 SmartNIC |

소프트웨어 사양

| 소프트웨어 사양 | HX 시리즈 VM |

|---|---|

| 최대 MPI 작업 크기 | 52,800개의 코어(singlePlacementGroup = true로 설정된 가상 머신 확장 집합의 300개 VM) |

| MPI 지원 | HPC-X(2.13 이상), Intel MPI(2021.7.0 이상), OpenMPI(4.1.3 이상), MVAPICH2(2.3.7 이상), MPICH(4.1 이상) |

| 추가 프레임워크 | UCX, libfabric, PGAS 또는 기타 InfiniBand 기반 런타임 |

| Azure Storage 지원 | 표준 및 프리미엄 디스크(최대 32개 디스크), Azure NetApp Files, Azure Files, Azure HPC Cache, Azure 관리 Lustre 파일 시스템 |

| 지원되고 유효성 검사된 OS | AlmaLinux 8.6, 8.7, Ubuntu 20.04+ |

| 성능에 권장되는 OS | AlmaLinux HPC 8.7, Ubuntu-HPC 20.04+ |

| Orchestrator 지원 | Azure CycleCloud, Azure Batch, AKS, 클러스터 구성 옵션 |

참고 항목

- 이러한 VM은 2세대만 지원합니다.

- AMD의 공식 커널 수준 지원은 RHEL의 파생 모델인 RHEL 8.6 및 AlmaLinux 8.6부터 시작합니다.

- Windows Server 2012 R2는 HX 및 64개 가상 또는 물리적 코어를 초과하는 기타 VM에서 지원되지 않습니다. 자세한 내용은 Windows Server에서 Hyper-V를 지원하는 Windows 게스트 운영 체제를 참조하세요. Windows Server 2022는 144 및 176 코어 크기에 필요하고 Windows Server 2016은 24, 48 및 96 코어 크기에서도 작동하며 Windows Server는 24 및 48 코어 크기에서만 작동합니다.

Important

권장 이미지 URN: almalinux:almalinux-hpc:8_7-hpc-gen2:8.7.2023060101, Azure CLI를 통해 이 이미지를 배포하려면 다음 매개 변수가 포함되어 있는지 확인합니다. --plan 8_7-hpc-gen2 --product almalinux-hpc --publisher almalinux. 크기 조정 테스트를 위해서는 새로운 HPC-X tarball과 함께 권장 URN을 사용하세요.

참고 항목

- NDR 지원은 UCX 1.13 이상에 추가되었습니다. 이전 UCX 버전에서는 위의 런타임 오류가 보고됩니다. UCX 오류: 유효하지 않은 활성 속도

[1677010492.951559] [updsb-vm-0:2754 :0] ib_iface.c:1549 UCX ERROR Invalid active_speed on mlx5_ib0:1: 128. - Ibstat의 SDR(낮은 속도 표시): 이전 Mellanox OFED(MOFED) 버전은 NDR을 지원하지 않으며 IB 속도가 더 느린 것으로 보고될 수 있습니다. Please use MOFED versions MOFED 5.6-1.0.3.3 or above.

다음 단계

- Azure Compute 기술 커뮤니티 블로그에서 최신 공지 사항, HPC 워크로드 예제 및 성능 결과에 대해 읽어보세요.

- HPC 워크로드를 실행하는 상위 수준의 아키텍처 보기는 Azure의 HPC(고성능 컴퓨팅)를 참조하세요.