Azure AI Foundry 포털의 모델 카탈로그 및 컬렉션

Important

이 문서에 표시된 항목(미리 보기)은 현재 퍼블릭 미리 보기에서 확인할 수 있습니다. 이 미리 보기는 서비스 수준 계약 없이 제공되며, 프로덕션 워크로드에는 권장되지 않습니다. 특정 기능이 지원되지 않거나 기능이 제한될 수 있습니다. 자세한 내용은 Microsoft Azure Preview에 대한 추가 사용 약관을 참조하세요.

Azure AI Foundry 포털의 모델 카탈로그는 생성 AI 애플리케이션을 빌드하기 위해 다양한 모델을 검색하고 사용하는 허브입니다. 모델 카탈로그에는 Microsoft에서 학습한 모델을 포함하여 Azure OpenAI Service, Mistral, Meta, Cohere, NVIDIA, Hugging Face와 같은 모델 공급자 전반에 걸쳐 수백 개의 모델이 포함되어 있습니다. Microsoft가 아닌 공급자의 모델은 Microsoft 제품 약관에 정의된 대로 Microsoft가 아닌 타사 제품이며 해당 모델과 함께 제공된 약관이 적용됩니다.

모델 컬렉션

모델 카탈로그는 모델을 다른 컬렉션으로 구성합니다.

Azure AI에 의해 큐레이팅됨: Azure AI 플랫폼에서 원활하게 작동하도록 패키지화되고 최적화된 가장 널리 사용되는 타사의 개방형 독자 개발 모델입니다. 이러한 모델의 사용에는 모델 공급자의 사용 조건이 적용됩니다. Azure AI Foundry 포털에서 이러한 모델을 배포하는 경우 해당 모델의 가용성은 적용 가능한 Azure SLA(서비스 수준 계약)의 적용을 받으며 Microsoft는 배포 문제에 대한 지원을 제공합니다.

Meta, NVIDIA, Mistral AI와 같은 파트너의 모델은 카탈로그의 이 컬렉션에서 사용할 수 있는 모델의 예입니다. 카탈로그의 모델 타일에서 녹색 확인 표시를 찾아 이러한 모델을 식별할 수 있습니다. 또는 Azure AI에 의해 필터링됨 컬렉션으로 필터링할 수 있습니다.

Azure에서만 사용할 수 있는 Azure OpenAI 모델: Azure OpenAI Service를 통합하여 제공되는 높은 평가를 받는 Azure OpenAI 모델입니다. Microsoft는 제품 약관 및 Azure OpenAI Service용 SLA에 따라 이러한 모델과 해당 모델의 사용을 지원합니다.

Hugging Face 허브의 공개 모델: HuggingFace 허브의 수백 가지 모델은 관리형 컴퓨팅과의 실시간 유추를 위해 사용할 수 있습니다. Hugging Face는 이 컬렉션에 나열된 모델을 만들고 유지 관리합니다. 도움을 받으려면 Hugging Face 포럼 또는 Hugging Face 지원을 사용합니다. Azure AI Foundry를 사용하여 개방형 모델 배포에 대해 자세히 알아봅니다.

이 양식을 사용하여 모델 카탈로그에 모델을 추가하라는 요청을 제출할 수 있습니다.

모델 카탈로그 기능 개요

필요에 keyword search 맞는 모델을 검색하고 검색할 수 있습니다 filters. 모델 카탈로그는 또한 선택한 모델에 대한 모델 성능 벤치마크 메트릭을 제공합니다. 모델 카드 벤치마크 탭을 클릭하거나 클릭하여 Compare Models 벤치마크에 액세스할 수 있습니다.

모델 카드에서 다음을 찾을 수 있습니다.

- 빠른 정보: 모델에 대한 주요 정보를 한눈에 볼 수 있습니다.

- 세부 정보: 이 페이지에는 설명, 버전 정보, 지원되는 데이터 형식 등을 포함하여 모델에 대한 자세한 정보가 포함되어 있습니다.

- 벤치마크: 선택한 모델에 대한 성능 벤치마크 메트릭을 찾을 수 있습니다.

- 기존 배포: 모델을 이미 배포한 경우 기존 배포 탭에서 찾을 수 있습니다.

- 코드 샘플: AI 애플리케이션 개발을 시작하기 위한 기본 코드 샘플을 찾을 수 있습니다.

- 라이선스: 모델 라이선스와 관련된 법적 정보를 찾을 수 있습니다.

- 아티팩트: 이 탭은 열린 모델에 대해서만 표시됩니다. 모델 자산을 보고 사용자 인터페이스를 통해 다운로드할 수 있습니다.

모델 배포: Azure OpenAI

Azure OpenAI 모델에 대한 자세한 내용은 Azure OpenAI Service란?을 참조하세요.

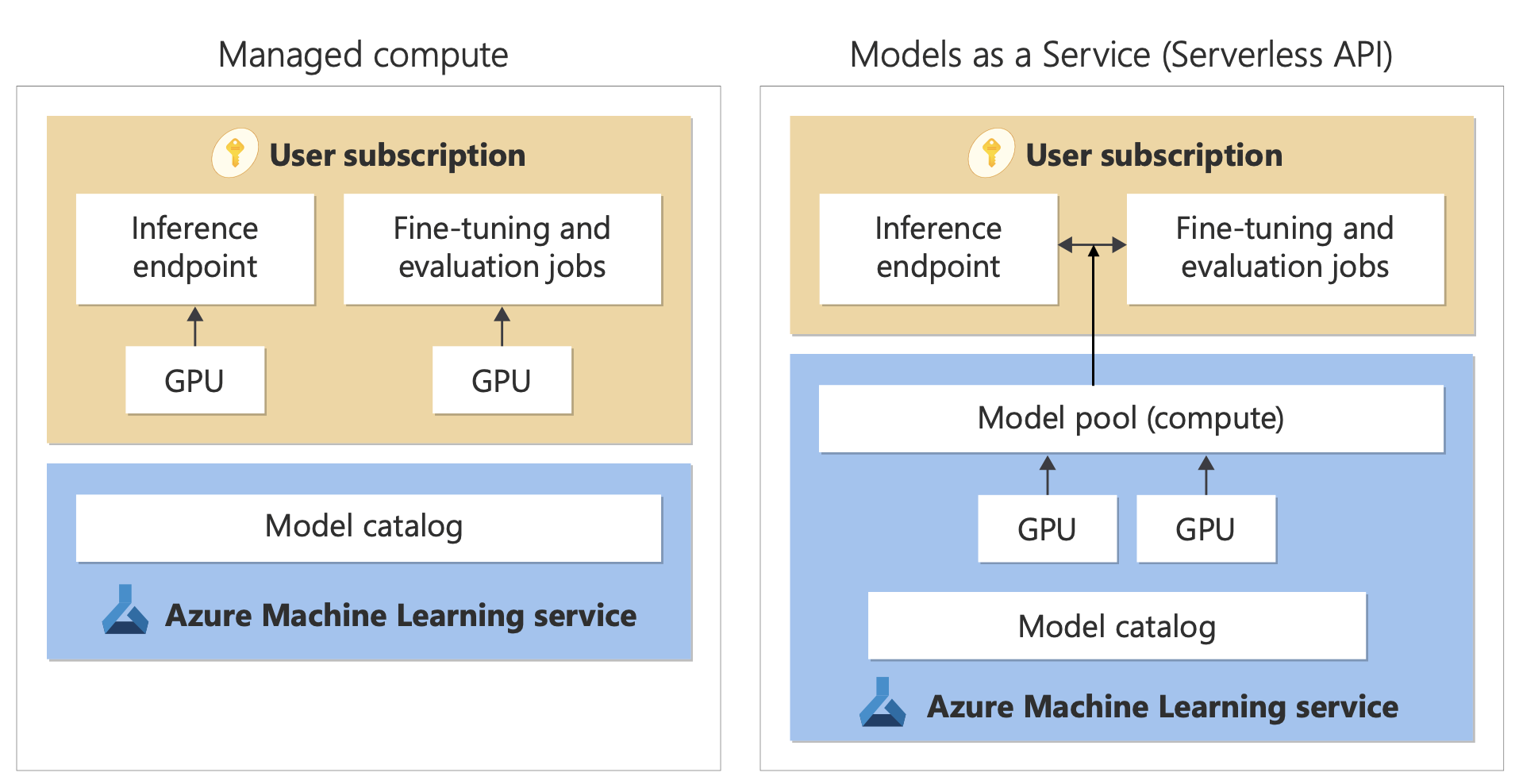

모델 배포: 관리형 컴퓨팅 및 서버리스 API

모델 카탈로그는 Azure OpenAI 서비스 모델 외에도 사용할 모델을 배포하는 두 가지 방법, 즉 관리형 컴퓨팅 및 서버리스 API를 제공합니다.

다음 표에 설명된 대로 각 모델에 사용할 수 있는 배포 옵션 및 기능은 다양합니다. 배포 옵션을 사용한 데이터 처리에 대해 자세히 알아봅니다.

모델 배포 옵션의 기능

| 기능 | 관리되는 컴퓨팅 | 서버리스 API(토큰당 지불) |

|---|---|---|

| 배포 환경 및 청구 | 모델 가중치는 관리형 컴퓨팅이 있는 전용 가상 머신에 배포됩니다. 하나 이상의 배포가 가능한 관리형 컴퓨팅은 유추를 위한 REST API를 제공합니다. 배포에 사용된 가상 머신 코어 시간에 대한 요금이 청구됩니다. | 모델에 대한 액세스는 모델에 액세스하기 위한 API를 프로비전하는 배포를 통해 이루어집니다. API는 유추를 위해 Microsoft에서 호스트하고 관리하는 모델에 액세스할 수 있도록 합니다. API에 대한 입/출력 요금은 대개 토큰으로 청구됩니다. 가격 책정 정보는 배포하기 전에 제공됩니다. |

| API 인증 | 키 및 Microsoft Entra 인증. | 키 전용. |

| 콘텐츠 안전 | Azure AI 콘텐츠 보안 서비스 API를 사용합니다. | Azure AI 콘텐츠 보안 필터는 유추 API와 통합되어 제공됩니다. Azure AI 콘텐츠 보안 필터는 별도로 청구됩니다. |

| 네트워크 격리 | Azure AI Foundry 허브에 대한 관리되는 네트워크를 구성합니다. | 관리형 컴퓨팅은 허브의 PNA(공용 네트워크 액세스) 플래그 설정을 따릅니다. 자세한 내용은 이 문서 뒷부분의 서버리스 API를 통해 배포된 모델에 대한 네트워크 격리 섹션을 참조하세요. |

지원되는 배포 옵션에 사용 가능한 모델

다음 목록에는 서버리스 API 모델이 포함되어 있습니다. Azure OpenAI 모델의 경우 Azure OpenAI 서비스 모델을 참조 하세요.

| 모델 | 관리되는 컴퓨팅 | 서버리스 API(토큰당 지불) |

|---|---|---|

| AI21 제품군 모델 | 사용할 수 없음 | 잠바-1.5-미니 Jamba-1.5-Large |

| Cohere 제품군 모델 | 사용할 수 없음 | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual Cohere-rerank-v3-english Cohere-rerank-v3-multilingual |

| 그레텔 | 사용할 수 없음 | 그레텔 네비게이터 |

| 의료 AI 제품군 모델 | MedImageParse MedImageInsight CxrReportGen Virchow Virchow2 Prism BiomedCLIP-PubMedBERT microsoft-llava-med-v1.5 m42-health-llama3-med4 biomistral-biomistral-7b microsoft-biogpt-large-pub microsoft-biomednlp-pub stanford-crfm-biomedlm medicalai-clinicalbert microsoft-biogpt microsoft-biogpt-large microsoft-biomednlp-pub |

사용 불가 |

| JAIS | 사용할 수 없음 | jais-30b-chat |

| Llama 제품군 모델 | Llama-3.3-70B-Instruct Llama-3.2-3B-Instruct Llama-3.2-1B-Instruct 라마-3.2-1B Llama-3.2-90B-Vision-Instruct Llama-3.2-11B-Vision-Instruct Llama-3.1-8B-Instruct 라마-3.1-8B Llama-3.1-70B-Instruct Llama-3.1-70B Llama-3-8B-Instruct Llama-3-70B Llama-3-8B 라마 가드-3-1B 라마 가드-3-8B 라마 가드-3-11B-비전 Llama-2-7b Llama-2-70b Llama-2-7b-chat Llama-2-13b-chat CodeLlama-7b-hf CodeLlama-7b-Instruct-hf CodeLlama-34b-hf CodeLlama-34b-Python-hf CodeLlama-34b-Instruct-hf CodeLlama-13b-Instruct-hf CodeLlama-13b-Python-hf Prompt-Guard-86M CodeLlama-70b-hf |

Llama-3.3-70B-Instruct Llama-3.2-90B-Vision-Instruct Llama-3.2-11B-Vision-Instruct Llama-3.1-8B-Instruct Llama-3.1-70B-Instruct Llama-3.1-405B-Instruct Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-70b Llama-2-70b-chat Llama-2-13b Llama-2-13b-chat |

| Microsoft Phi 제품군 모델 | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-Moe-Instruct 피-4 |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-Moe-Instruct 피-4 |

| Mistral 제품군 모델 | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large(2402) Mistral-large(2407) Mistral-small Ministral-3B Mistral-NeMo |

| Nixtla | 사용할 수 없음 | TimeGEN-1 |

모델 수명 주기: 사용 중단 및 사용 중지

AI 모델은 빠르게 발전하며, 동일한 모델 제품군에서 업데이트된 기능이 있는 새 버전 또는 새 모델을 사용할 수 있게 되면 AI Foundry 모델 카탈로그에서 이전 모델이 사용 중지될 수 있습니다. 최신 모델 버전으로 원활하게 전환할 수 있도록 일부 모델은 사용자에게 자동 업데이트를 사용하도록 설정하는 옵션을 제공합니다. 다양한 모델의 모델 수명 주기, 예정된 모델 사용 중지 날짜 및 제안된 대체 모델 및 버전에 대해 자세히 알아보려면 다음을 참조하세요.

관리되는 컴퓨팅

관리형 컴퓨팅으로 모델을 배포하는 기능은 Azure Machine Learning의 플랫폼 기능을 기반으로 빌드되어 LLM(대규모 언어 모델)의 전체 수명 주기에 걸쳐 모델 카탈로그의 광범위한 모델 컬렉션을 원활하게 통합할 수 있습니다.

관리형 컴퓨팅으로 배포할 수 있는 모델의 가용성

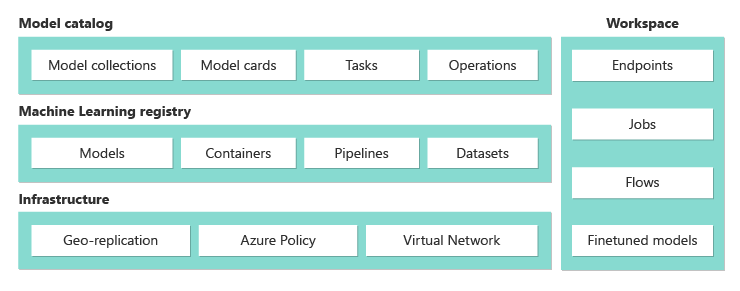

모델은 Azure Machine Learning 레지스트리를 통해 사용할 수 있습니다. 이러한 레지스트리를 사용하면 Azure Machine Learning 자산을 호스트 및 배포할 때 기계 학습 우선 방식을 적용할 수 있습니다. 이러한 자산에는 모델 가중치, 모델 실행을 위한 컨테이너 런타임, 모델 평가 및 미세 조정을 위한 파이프라인, 벤치마크 및 샘플에 대한 데이터 세트가 포함됩니다.

이 레지스트리는 다음과 같은 확장성이 뛰어난 엔터프라이즈급 인프라를 기반으로 빌드됩니다.

기본 제공 지역 복제를 통해 모든 Azure 지역에 짧은 대기 시간 액세스 모델 아티팩트를 제공합니다.

Azure Policy를 사용한 모델 액세스 제한과 관리되는 가상 네트워크를 사용한 보안 배포 같은 엔터프라이즈 보안 요구 사항을 지원합니다.

관리형 컴퓨팅을 사용하여 유추를 위한 모델 배포

관리형 컴퓨팅에 배포할 수 있는 모델은 실시간 유추를 위해 Azure Machine Learning 관리형 컴퓨팅에 배포할 수 있습니다. 관리형 컴퓨팅에 배포하려면 모델을 최적으로 실행하는 데 필요한 특정 제품에 대해 Azure 구독에 가상 머신 할당량이 있어야 합니다. 일부 모델에서는 모델 테스트를 위한 임시 공유 할당량에 배포할 수 있습니다.

모델 배포 방법에 대한 자세한 정보:

관리형 컴퓨팅을 사용하여 생성형 AI 앱 빌드

Azure Machine Learning의 프롬프트 흐름 기능은 프로토타입을 만드는 데 유용한 환경을 제공합니다. 개방형 모델 LLM 도구를 사용하면 프롬프트 흐름에서 관리형 컴퓨팅으로 배포된 모델을 사용할 수 있습니다. Azure Machine Learning 확장을 통해 LangChain과 같은 널리 사용되는 LLM 도구의 관리형 컴퓨팅에 의해 노출되는 REST API를 사용할 수도 있습니다.

관리형 컴퓨팅으로 배포된 모델의 콘텐츠 보안

Azure AI 콘텐츠 보안 서비스를 관리형 컴퓨팅과 함께 사용하여 성적 콘텐츠, 폭력, 증오, 자해 등 다양한 범주의 유해 콘텐츠를 차단할 수 있습니다. 이 서비스를 사용하여 탈옥 위험 감지 및 보호된 자료 텍스트 감지와 같은 고급 위협을 차단할 수도 있습니다.

Llama 2용 Azure AI 콘텐츠 보안과의 참조 통합에 대한 자세한 내용은 이 Notebook을 참조하면 됩니다. 또는 프롬프트 흐름에서 콘텐츠 안전(텍스트) 도구를 사용하여 모델에서 Azure AI 콘텐츠 안전으로 응답을 전달하여 차단할 수 있습니다. Azure AI 콘텐츠 보안 가격 책정에 설명된 대로 이러한 사용에 대해서는 별도로 요금이 청구됩니다.

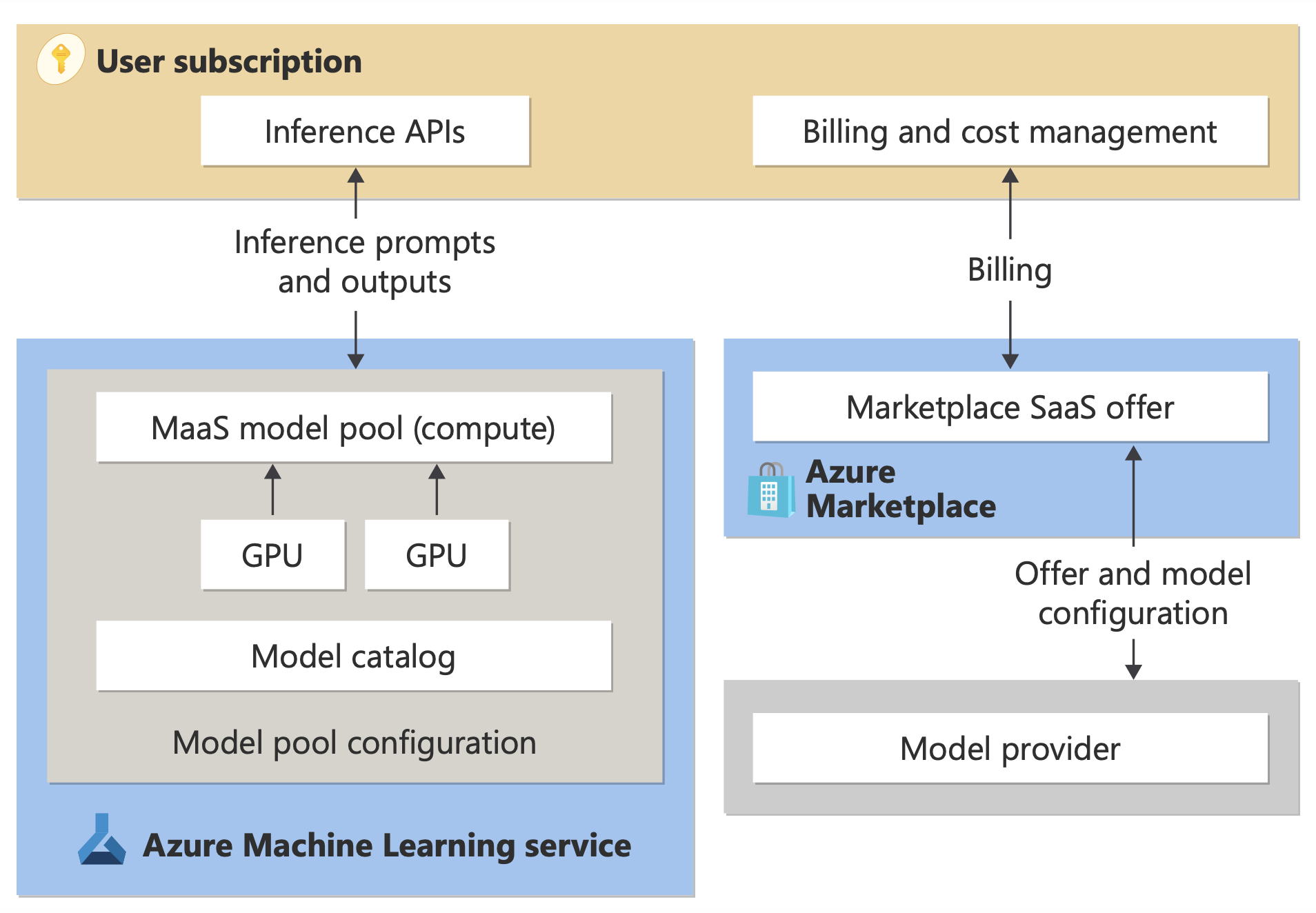

서버리스 API(토큰당 지불) 청구

토큰당 지불 청구를 사용하여 모델 카탈로그에 특정 모델을 배포할 수 있습니다. 서버리스 API라고도 하는 이 배포 방법은 구독에서 모델을 호스팅하지 않고 모델을 API로 사용하는 방법을 제공합니다. 모델은 Microsoft가 관리하는 인프라에서 호스트되므로 모델 공급자의 모델에 API를 통해 액세스할 수 있게 해 줍니다. API 기반 액세스는 모델 액세스 비용을 대폭 줄이고 프로비전 환경을 간소화할 수 있습니다.

종량제 청구를 사용하여 서버리스 API로 배포할 수 있는 모델은 모델 공급자가 제공하지만 Microsoft 관리형 Azure 인프라에서 호스트되고 API를 통해 액세스됩니다. 모델 공급자는 사용 조건을 정의하고 모델 사용에 대한 가격을 설정합니다. Azure Machine Learning Service는 다음을 수행합니다.

- 호스팅 인프라를 관리합니다.

- 유추 API를 사용할 수 있도록 합니다.

- MaaS를 통해 배포된 모델에서 제출한 프롬프트 및 콘텐츠 출력에 대한 데이터 프로세서 역할을 합니다.

데이터 개인 정보 보호 관련 문서에서 MaaS의 데이터 처리에 대해 자세히 알아보세요.

참고 항목

CSP(클라우드 솔루션 공급자) 구독에는 MaaS(서버리스 API 배포) 모델을 구매할 수 없습니다.

결제

MaaS를 통해 배포된 모델의 검색, 구독 및 사용 환경은 Azure AI Foundry 포털 및 Azure Machine Learning 스튜디오. 사용자는 모델 사용에 대한 사용 조건을 수락합니다. 사용량에 대한 가격 책정 정보는 배포 중에 제공됩니다.

Microsoft가 아닌 공급자의 모델은 Microsoft 상업용 Marketplace 사용 약관에 따라 Azure Marketplace를 통해 청구됩니다.

Microsoft의 모델은 Azure 미터를 통해 자사 사용량 서비스로 청구됩니다. 제품 약관에 설명된 대로 Azure 미터를 사용하여 자사 사용량 서비스를 구매하지만 Azure 서비스 약관이 적용되지는 않습니다. 이러한 모델의 사용에는 제공된 사용 조건이 적용됩니다.

모델 미세 조정

특정 모델은 미세 조정도 지원합니다. 이러한 모델의 경우 관리형 컴퓨팅(미리 보기) 또는 서버리스 API 미세 조정을 활용하여 제공하는 데이터를 사용하여 모델을 조정할 수 있습니다. 자세한 내용은 미세 조정 개요를 참조하세요.

서버리스 API로 배포된 모델을 사용하여 RAG

Azure AI Foundry 포털에서 벡터 인덱스 및 RAG(검색 보강 생성)를 사용할 수 있습니다. 서버리스 API를 통해 배포할 수 있는 모델을 사용하면 사용자 지정 데이터를 기반으로 포함 및 유추를 생성할 수 있습니다. 그런 다음 이러한 포함 및 유추는 사용 사례와 관련된 답변을 생성할 수 있습니다. 자세한 내용은 Azure AI Foundry 포털에서 벡터 인덱스 빌드 및 사용을 참조 하세요.

제품 및 모델의 지역적 가용성

토큰당 지불 청구는 Azure 구독이 모델 공급자가 제품을 사용할 수 있게 한 국가/지역의 청구 계정에 속한 사용자만 사용할 수 있습니다. 관련 지역에서 제품을 사용할 수 있는 경우 사용자는 해당되는 경우 배포 또는 미세 조정에 모델을 사용할 수 있는 Azure 지역에 프로젝트 리소스가 있어야 합니다. 서버리스 API 엔드포인트의 모델에 대한 지역 가용성 참조 | 자세한 내용은 Azure AI Foundry 입니다.

서버리스 API를 통해 배포된 모델의 콘텐츠 보안

서버리스 API를 통해 배포된 언어 모델의 경우 Azure AI는 증오, 자해, 성적, 폭력적인 콘텐츠와 같은 유해한 콘텐츠를 검색하는 Azure AI 콘텐츠 보안 텍스트 조정 필터의 기본 구성을 구현합니다. 콘텐츠 필터링(미리 보기)에 관해 자세히 알아보려면 Azure AI 콘텐츠 보안의 피해 범주를 참조하세요.

팁

서버리스 API를 통해 배포되는 특정 모델 유형에는 콘텐츠 필터링(미리 보기)을 사용할 수 없습니다. 이러한 모델 유형에는 포함 모델 및 시계열 모델이 포함됩니다.

콘텐츠 필터링(미리 보기)은 서비스 프로세스에서 콘텐츠를 생성하라는 메시지를 표시할 때 동시에 발생합니다. 이러한 사용에 대해서는 Azure AI 콘텐츠 보안 가격 책정에 따라 별도로 요금이 청구될 수 있습니다. 개별 서버리스 엔드포인트에 대해 콘텐츠 필터링(미리 보기)을 사용하지 않도록 설정할 수 있습니다.

- 언어 모델을 처음 배포할 때

- 나중에 배포 세부 정보 페이지에서 콘텐츠 필터링 토글을 선택하여

Azure AI 모델 유추 API 이외의 API를 사용하여 서버리스 API 를 통해 배포된 모델을 사용한다고 가정해 보겠습니다. 이러한 상황에서는 Azure AI 콘텐츠 보안을 사용하여 별도로 구현하지 않는 한 콘텐츠 필터링(미리 보기)이 활성화되지 않습니다.

Azure AI 콘텐츠 보안을 시작하려면 빠른 시작: 텍스트 콘텐츠 분석을 참조하세요. 서버리스 API를 통해 배포된 모델을 사용할 때 콘텐츠 필터링(미리 보기)을 사용하지 않으면 사용자를 유해한 콘텐츠에 노출시킬 위험이 높아집니다.

서버리스 API를 통해 배포된 모델에 대한 네트워크 격리

서버리스 API로 배포된 모델의 엔드포인트는 배포가 있는 프로젝트가 있는 Azure AI Foundry 허브의 공용 네트워크 액세스 플래그 설정을 따릅니다. 서버리스 API 엔드포인트를 보호하려면 Azure AI Foundry 허브에서 공용 네트워크 액세스 플래그를 사용하지 않도록 설정합니다. 허브에 프라이빗 엔드포인트를 사용하여 클라이언트에서 엔드포인트로의 인바운드 통신을 보호할 수 있습니다.

Azure AI Foundry 허브에 대한 공용 네트워크 액세스 플래그를 설정하려면 다음을 수행합니다.

- Azure Portal로 이동합니다.

- 허브가 속한 리소스 그룹을 검색하고 이 리소스 그룹에 대해 나열된 리소스에서 Azure AI Foundry 허브를 선택합니다.

- 허브 개요 페이지에서 왼쪽 창에서 설정>네트워킹으로 이동합니다.

- 퍼블릭 액세스 탭에서 공용 네트워크 액세스 플래그에 대한 설정을 구성할 수 있습니다.

- 변경 내용을 저장합니다. 변경 내용을 전파하는 데 최대 5분이 걸릴 수 있습니다.

제한 사항

2024년 7월 11일 이전에 만들어진 프라이빗 엔드포인트가 있는 Azure AI Foundry 허브가 있는 경우 이 허브의 프로젝트에 추가된 서버리스 API 엔드포인트는 허브의 네트워킹 구성을 따르지 않습니다. 대신 새 배포가 허브의 네트워킹 구성을 따를 수 있도록 허브에 대한 새 프라이빗 엔드포인트를 만들고 프로젝트에 서버리스 API 배포를 새로 만들어야 합니다.

2024년 7월 11일 이전에 MaaS 배포를 만든 Azure AI Foundry 허브가 있고 이 허브에서 프라이빗 엔드포인트를 사용하도록 설정한 경우 기존 서버리스 API 배포는 허브의 네트워킹 구성을 따르지 않습니다. 허브의 서버리스 API 배포가 허브의 네트워킹 구성을 따르려면 배포를 다시 만들어야 합니다.

현재 Azure OpenAI On Your Data 지원은 프라이빗 허브의 서버리스 API 배포에 사용할 수 없습니다. 프라이빗 허브에는 공용 네트워크 액세스 플래그가 비활성화되어 있기 때문입니다.

네트워크 구성 변경(예: 공용 네트워크 액세스 플래그를 사용하거나 사용하지 않도록 설정)은 전파하는 데 최대 5분이 걸릴 수 있습니다.