Azure AI 에이전트 서비스에서 지원하는 모델

에이전트는 다양한 기능과 가격 포인트를 가진 다양한 모델 집합으로 구동됩니다. 모델 가용성은 지역 및 클라우드에 따라 다릅니다. 특정 도구와 기능에는 최신 모델이 필요합니다. 다음 모델은 사용 가능한 SDK에서 사용할 수 있습니다. 다음 표는 종량제에 대한 것입니다. 프로비저닝된 PTU(처리량 단위) 가용성에 대한 자세한 내용은 Azure OpenAI 설명서의 프로비전된 처리량을 참조하세요. 여기에 나열된 지역에서 지원되는 경우 전역 표준 모델을 사용할 수 있습니다.

Azure OpenAI 모델

Azure AI 에이전트 서비스는 다음 지역의 Azure OpenAI에서 채팅 완료 API와 동일한 모델을 지원합니다.

| 지역 | gpt-4o, 2024-05-13 | gpt-4o, 2024-08-06 | gpt-4o-mini, 2024-07-18 | gpt-4, 0613 | gpt-4, 1106-미리 보기 | gpt-4, 0125-미리 보기 | gpt-4, turbo-2024-04-09 | gpt-4-32k, 0613 | gpt-35-turbo, 0613 | gpt-35-turbo, 1106 | gpt-35-turbo, 0125 | gpt-35-turbo-16k, 0613 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| australiaeast | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ | ✅ |

| eastus | ✅ | ✅ | ✅ | - | - | ✅ | ✅ | - | ✅ | - | ✅ | ✅ |

| eastus2 | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | ✅ | - | ✅ | ✅ |

| francecentral | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | - | ✅ |

| japaneast | - | - | - | - | - | - | - | - | ✅ | - | ✅ | ✅ |

| norwayeast | - | - | - | - | ✅ | - | - | - | - | - | - | - |

| southindia | - | - | - | - | ✅ | - | - | - | - | ✅ | ✅ | - |

| 스웨덴 중부 | ✅ | ✅ | ✅ | ✅ | ✅ | - | ✅ | ✅ | ✅ | ✅ | - | ✅ |

| uksouth | - | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ |

| westus | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | ✅ | ✅ | - |

| westus3 | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | - | ✅ | - |

더 많은 모델

또한 Azure AI 에이전트 서비스는 Azure AI Foundry 모델 카탈로그에서 다음 모델을 지원합니다.

- Meta-Llama-405B-Instruct

- Mistral-large-2407

- Cohere-command-r-plus

- Cohere-command-r

이러한 모델을 사용하려면 Azure AI Foundry 포털을 사용하여 배포한 다음 에이전트에서 참조할 수 있습니다.

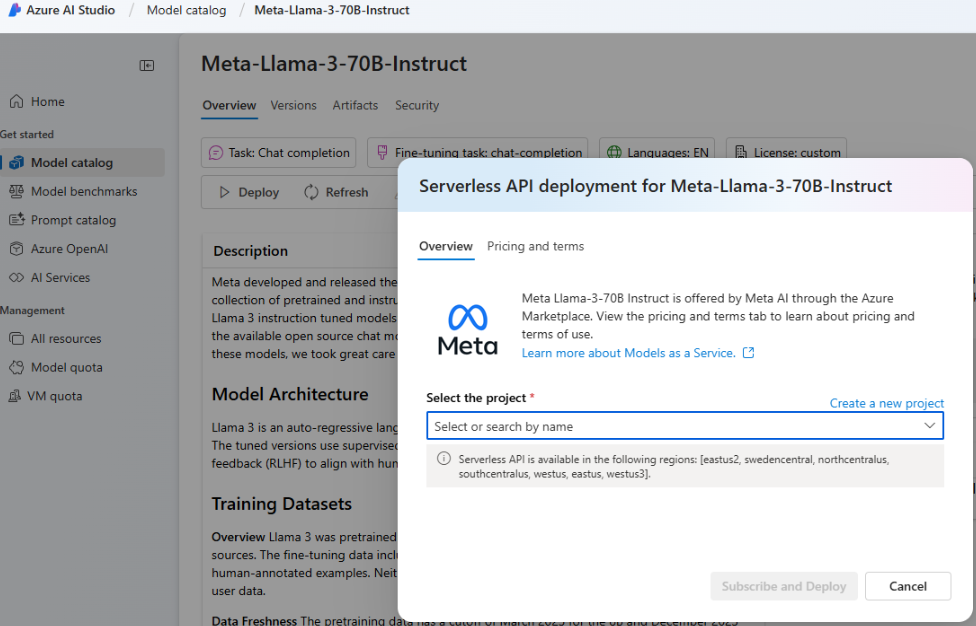

Azure AI Foundry 포털로 이동하여 왼쪽 탐색 메뉴에서 모델 카탈로그를 선택하고 아래로 스크롤하여 Meta-Llama-3-70B-Instruct로 이동합니다. 이전에 나열된 모델 중 하나를 찾아 사용할 수도 있습니다.

배포를 선택합니다.

표시되는 배포 옵션 화면에서 Azure AI Content Safety를 사용하여 서버리스 API를 선택합니다.

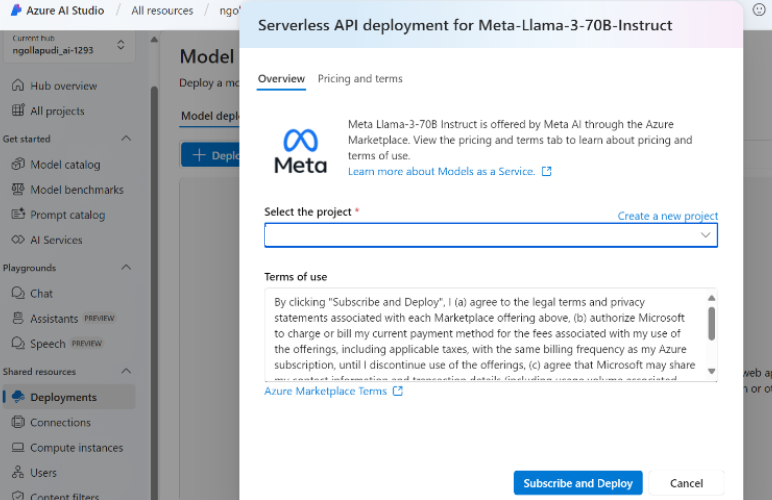

프로젝트를 선택한 다음 구독을 선택하고 배포합니다.

허브/프로젝트에 서버리스 연결을 추가합니다. 선택한 배포 이름은 코드에서 참조하는 이름입니다.

에이전트 만들기 API를 호출할 때 매개 변수를

models배포 이름으로 설정합니다. 예시: