HoloLens (第 1 世代) と Azure 301: 言語翻訳

Note

Mixed Reality Academy のチュートリアルは、HoloLens (第 1 世代) と Mixed Reality イマーシブ ヘッドセットを念頭に置いて編成されています。 そのため、それらのデバイスの開発に関するガイダンスを引き続き探している開発者のために、これらのチュートリアルをそのまま残しておくことが重要だと考えています。 これらのチュートリアルが、HoloLens 2 に使用されている最新のツールセットや操作に更新されることは "ありません"。 これらは、サポートされているデバイス上で継続して動作するように、保守されます。 今後、HoloLens 2 の開発方法を説明する新しいチュートリアルが公開される予定です。 この通知は、それらのチュートリアルが投稿されたときにリンクと共に更新されます。

このコースでは、Translator Text API と共に Azure Cognitive Services を使用して、Mixed Reality アプリケーションに翻訳機能を追加する方法について説明します。

Translator Text API は、ほぼリアルタイムで動作する翻訳サービスです。 このサービスはクラウドベースであり、REST API 呼び出しを使用することにより、アプリでニューラル機械翻訳テクノロジを利用してテキストを別の言語に変換できます。 詳細については、Azure Translator Text API に関するページを参照してください。

このコースを完了すると、次の処理を実行できる複合現実アプリケーションが完成します。

- ユーザーが、イマーシブ (VR) ヘッドセットに接続されているマイク (または HoloLens の内蔵マイク) に向かって話します。

- アプリがディクテーションをキャプチャし、Azure Translator Text API に送信します。

- 翻訳結果が Unity シーンのシンプルな UI グループに表示されます。

このコースでは、Translator サービスから結果を取得して、Unity ベースのサンプル アプリケーションに取り込む方法について説明します。 作成中のカスタム アプリケーションがある場合に、これらの概念をそのアプリケーションで採用するかどうかはご自身でご判断ください。

デバイス サポート

| コース | HoloLens | イマーシブ ヘッドセット |

|---|---|---|

| MR と Azure 301: 言語翻訳 | ✔️ | ✔️ |

Note

このコースは主に Windows Mixed Reality イマーシブ(VR)ヘッドセットに焦点を当てていますが、このコースで学んだことを Microsoft HoloLens にも応用できます。 このコースに取り組む過程で、HoloLens をサポートするために採用する必要のある変更に関するノートが表示されます。 HoloLens を使用すると、音声キャプチャ中に反響音が生じることがあります。

前提条件

Note

このチュートリアルは、Unity と C# の基本的な使用経験がある開発者を対象としています。 また、このドキュメント内の前提条件や文章による説明は、執筆時 (2018 年 5 月) にテストおよび検証された内容であることをご了承ください。 「ツールのインストール」の記事に記載されているように、最新のソフトウェアを自由に使用できます。ただし、このコースの情報は、以下に記載されているものよりも新しいソフトウェアで見つかったものと完全に一致するとは限りません。

このコースでは、次のハードウェアとソフトウェアをお勧めします。

- イマーシブ (VR) ヘッドセットの開発に必要な Windows Mixed Reality と互換性のある開発用 PC

- 開発者モードが有効になっている Windows 10 Fall Creators Update (またはそれ以降)

- 最新の Windows 10 SDK

- Unity 2017.4

- Visual Studio 2017

- 開発者モードが有効になっている Windows Mixed Reality イマーシブ (VR) ヘッドセットまたは Microsoft HoloLens

- 内蔵マイク付きヘッドホンのセット (ヘッドセットにマイクとスピーカーが組み込まれていない場合)

- Azure のセットアップと翻訳の取得のためのインターネット アクセス

開始する前に

このプロジェクトをビルドする際の問題を避けるために、このチュートリアルで紹介するプロジェクトをルートまたはルートに近いフォルダーに作成することを強くお勧めします (フォルダー パスが長いと、ビルド時に問題が発生する可能性があります)。

このチュートリアルのコードを使用すると、PC に接続されている既定のマイク デバイスから録音できます。 既定のマイク デバイスが、音声をキャプチャするために使用する予定のデバイスに設定されていることを確認します。

PC でディクテーションを有効にするには、Settings > Privacy > Speech に移動し、手描き入力と入力音声サービスを表示し、候補を入力する] ボタンを選択。

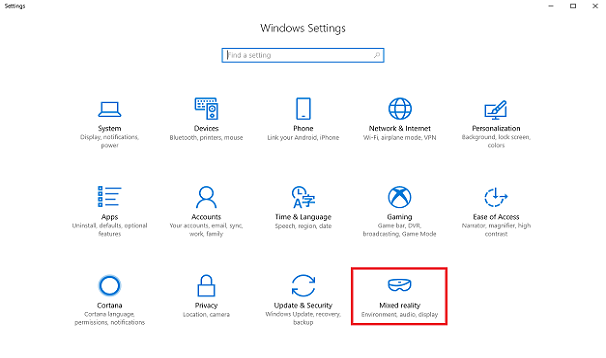

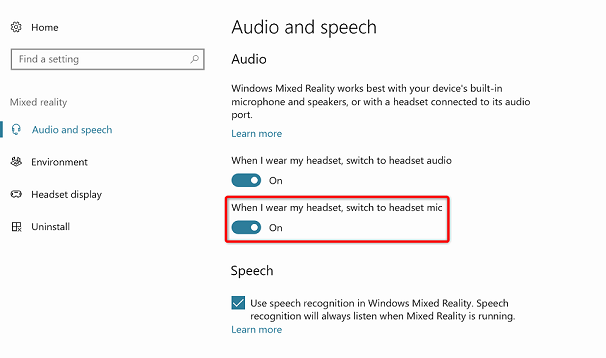

ヘッドセットに接続されている (または内蔵の) マイクとヘッドホンを使用している場合は、[設定] > [Mixed Reality] > [オーディオと音声認識] で [ヘッドセットを着用している場合はヘッドセット マイクに切り替える] オプションがオンになっていることを確認します。

警告

このラボ用にイマーシブ ヘッドセットを開発している場合は、オーディオ出力デバイスの問題が発生する可能性があることにご注意ください。 これは、Unity の新しいバージョン (Unity 2018.2) で修正された Unity の問題に起因するものです。 この問題が発生すると、Unity は実行時に既定のオーディオ出力デバイスを変更できなくなります。 問題が発生した場合は、回避策として、上記の手順が完了していることを確認し、エディターを閉じてからもう一度開いてください。

第 1 章 – Azure portal

Azure Translator API を使用するには、そのサービスのインスタンスをアプリケーションから利用できるように構成する必要があります。

Azure Portal にログインします。

Note

まだ Azure アカウントをお持ちでない方は、作成する必要があります。 このチュートリアルを教室やラボで受講している場合は、インストラクターや監督者に新しいアカウントの設定方法を質問してください。

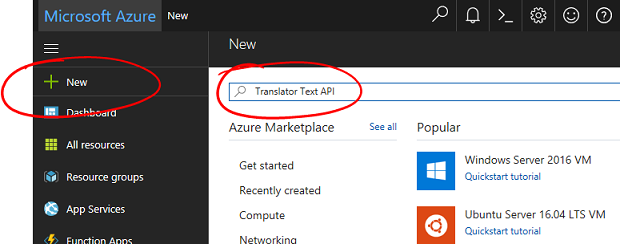

ログインしたら、左上隅の [新規作成] をクリックし、「Translator Text API」を検索します。Enter キーを選択します。

Note

新しいポータルでは、[新規作成] という文字列が [リソースの作成] に置き換えられることがあります。

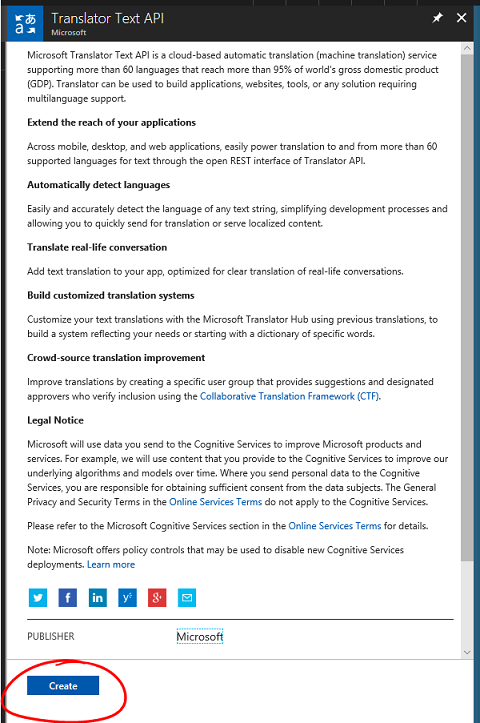

新しいページに、Translator Text API サービスの説明が表示されます。 このページの左下にある [作成] ボタンを選択すると、このサービスとの関連付けが作成されます。

[作成] をクリックしたら、次のようにします。

このサービス インスタンスに任意の名前を入力します。

適切な [サブスクリプション] を選択します。

適切な [価格レベル] を選択します。これが初めて作成する "Translator Text サービス" の場合は、Free レベル (F0 という名前) を使用できるはずです。

[リソース グループ] を選択するか、新規に作成します。 リソース グループは、Azure アセットのコレクションの監視、アクセス制御、プロビジョニング、課金管理を行う方法を提供します。 1 つのプロジェクト (例: これらのラボなど) に関連するすべての Azure サービスを共通のリソース グループの下に保持することをお勧めします。

Azure リソース グループの詳細については、リソース グループに関する記事を参照してください。

リソース グループの [場所] を決定します (新しいリソース グループを作成する場合)。 この場所は、アプリケーションが実行されるリージョン内にすることが理想的です。 一部の Azure アセットは、特定のリージョンでしか利用できません。

またお客様は、本サービスに適用されるご契約条件を理解していることを確認する必要があります。

[作成] を選択します

![[作成] ボタンを選択します。](images/azurelabs-lab1-04.png)

[作成] をクリックしたら、サービスが作成されるのを待つ必要があります。これには 1 分ほどかかります。

サービス インスタンスが作成されると、ポータルに通知が表示されます。

通知をクリックして、新しいサービス インスタンスを確認します。

![[リソースに移動] ポップアップ。](images/azurelabs-lab1-06.png)

通知の[リソースに移動]ボタンをクリックして、新しいサービスインスタンスを探します。 新しい Translator Text API サービス インスタンスが表示されます。

このチュートリアルでは、アプリケーションがサービスの呼び出しを行う必要があります。これは、サービスのサブスクリプション キーを使用して実行されます。

Translator Text サービスの [クイック スタート] ページで、最初の手順の [キーを取得する] に移動して、[キー] をクリックします (サービスのナビゲーション メニューにある鍵のアイコンで示された青いハイパーリンクの [キー] をクリックして、これを行うこともできます)。 これにより、サービスの "キー" が表示されます。

表示されているキーの 1 つをコピーします。これは、プロジェクトの後半で必要になります。

第 2 章 – Unity プロジェクトを設定する

Mixed Reality イマーシブ ヘッドセットをセットアップしてテストします。

Note

このコースでは、モーション コントローラーは必要ありません。 イマーシブ ヘッドセットのセットアップについてご不明な点がある場合は、こちらの手順を参照してください。

次に示すのは、Mixed Reality で開発するための一般的な設定であり、他のプロジェクトのテンプレートとして利用できます。

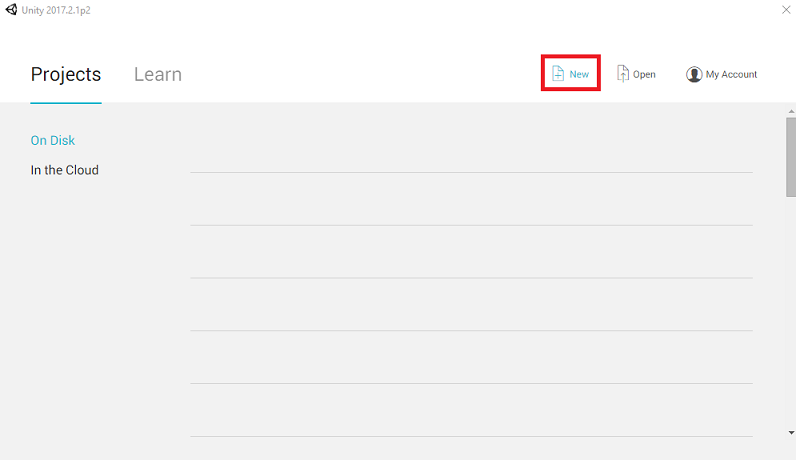

Unity を開き、[新規] をクリックします。

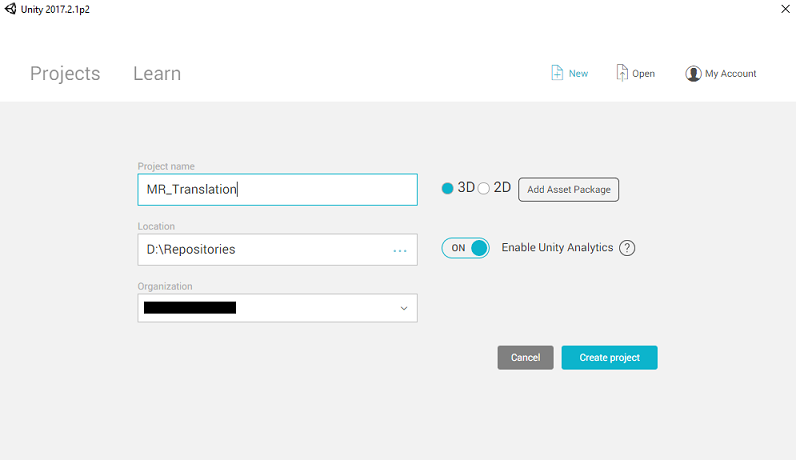

ここで、Unity プロジェクト名を指定する必要があります。 「MR_Translation」を挿入します。 プロジェクトの種類が [3D] に設定されていることを確認します。 [場所] を適切な場所に設定します (ルート ディレクトリに近い方が適しています)。 [Create project]\(プロジェクトの作成\) をクリックします。

Unity を開いた状態で、既定のスクリプト エディターが Visual Studio に設定されているかどうか確認することをお勧めします。 [編集] >[Preferences] (環境設定) に移動し、新しいウィンドウで [外部ツール] に移動します。 [外部スクリプト エディター] を [Visual Studio 2017] に変更します。 [環境設定] ウィンドウを閉じます。

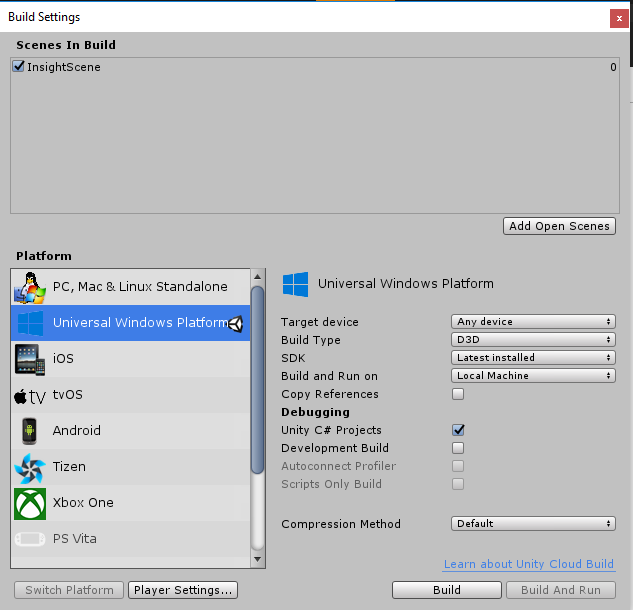

次に、[ファイル] > [ビルド設定] で、[プラットフォームの切り替え] ボタンをクリックして、プラットフォームを [ユニバーサル Windows プラットフォーム] に切り替えます。

![[Build Settings]\(ビルド設定\) ウィンドウで、プラットフォームを UWP に切り替えます。](images/azurelabs-lab1-11.png)

[ファイル] > [ビルド設定] に移動して、次を確認します。

ターゲットデバイスをいずれかのデバイスに設定します。

Microsoft HoloLens の場合は、[ターゲット デバイス] を [HoloLens] に設定します。

[Build Type] (ビルドの種類) が [D3D] に設定されている

[SDK] が [最新のインストール] に設定されている。

[Visual Studio Version] (Visual Studio のバージョン) が [Latest installed] (最新のインストール) に設定されている

[Build and Run] (ビルドと実行) が [Local Machine] (ローカル マシン) に設定されている

シーンを保存し、ビルドに追加します。

これを行うには、[Add Open Scenes] (開いているシーンを追加) を選択します。 保存ウィンドウが表示されます。

![[Add Open Scenes]\(開いているシーンを追加\) ボタンをクリックします](images/azurelabs-lab1-12.png)

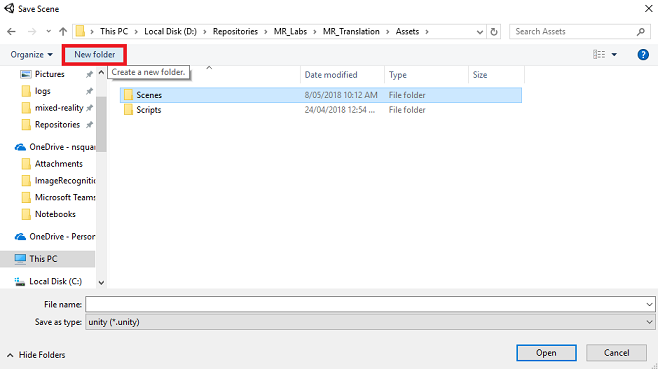

これと、今後のシーン用の新しいフォルダーを作成し、[新しいフォルダー] ボタンを選択して、新しいフォルダーを作成し、「Scenes」という名前を付けます。

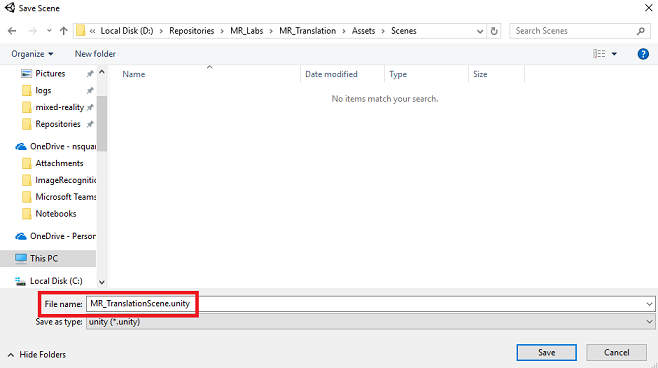

新しく作成した Scenes フォルダーを開き、[ファイル名] テキスト フィールドに「MR_TranslationScene」と入力して、[保存] をクリックします。

Unity のシーンは Assets フォルダーの中に保存する必要があることにご注意ください。シーンは Unity プロジェクトに関連付けられている必要があるためです。 Unity プロジェクトの構築では、通常、Scenes フォルダー (とその他の類似フォルダー) を作成します。

[ビルド設定] の残りの設定は、ここでは既定値のままにしておきます。

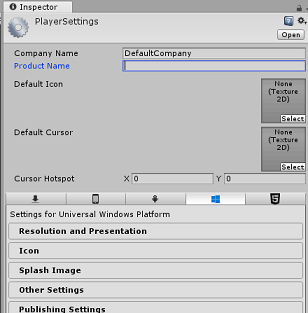

Build Settings (ビルド設定) ウィンドウで、[プレーヤー設定] ボタンをクリックすると、"インスペクター" が配置されているスペースに関連パネルが表示されます。

このパネルでは、いくつかの設定を確認する必要があります。

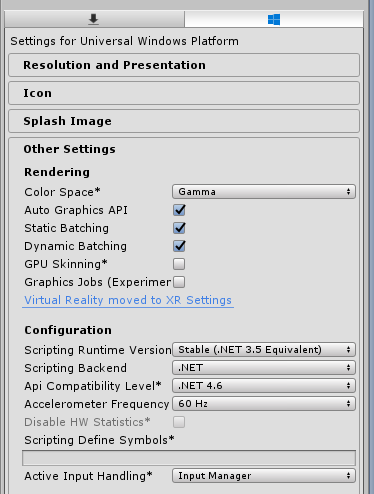

[Other Settings] (その他の設定) タブで、次の内容を確認します。

[Scripting Runtime Version] (スクリプト ランタイムのバージョン) が [Stable] (安定) (.NET 3.5 と同等) である。

[スクリプト バックエンド] が [.NET] である。

[API Compatibility Level]\(API 互換性レベル\) が [.NET 4.6] である。

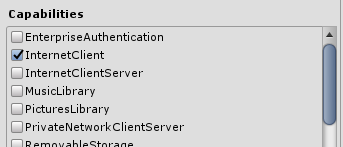

[Publishing Settings]\(公開設定\) タブ内の [Capabilities]\(機能\) で、次の内容を確認します。

InternetClient

マイク

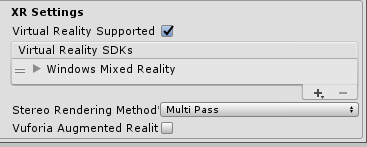

さらに、パネルの下にある [XR Settings]\(XR 設定\) ([Publish Settings]\(公開設定\) の下) で、[Virtual Reality Supported]\(Virtual Reality サポート\) をオンにし、Windows Mixed Reality SDK が追加されていることを確認します。

[ビルド設定] に戻ると、"Unity C# プロジェクト" に適用されていた灰色表示が解除されています。その横にあるチェック ボックスをオンにします。

[ビルド設定] ウィンドウを閉じます。

シーンとプロジェクトを保存します ([FILE] (ファイル) > [SAVE SCENE / FILE] (シーン/ファイルの保存) > [SAVE PROJECT] (プロジェクトの保存))。

第 3 章 – メイン カメラのセットアップ

重要

このコースの "Unity のセットアップ" コンポーネントをスキップして、そのままコードに進みたい場合は、この .unitypackage をダウンロードし、これをカスタム パッケージとしてプロジェクトにインポートした後で第 5 章から続けてください。 その場合でも、Unity プロジェクトを作成する必要があります。

[階層] パネルの中に、[メイン カメラ] という名前のオブジェクトがあります。このオブジェクトは、ユーザーがアプリケーションの "内部" にいるときの "頭" の視点を表しています。

目の前にある Unity ダッシュボードで、[メイン カメラ] GameObject を選択します。 [インスペクター] パネル (通常はダッシュボードの右側にあります) には、GameObject のさまざまなコンポーネントが表示されます。これらは、[変換]、[カメラ]、その他いくつかのコンポーネントの順に表示されています。 Main Camera の Transform (変換) をリセットして、正しい位置に配置する必要があります。

これを行うには、[カメラ] の [変換] コンポーネントの隣にある歯車アイコンを選択し、[リセット] を選択します。

![メイン カメラの [Transform]\(変換\) をリセットする。](images/azurelabs-lab1-19.png)

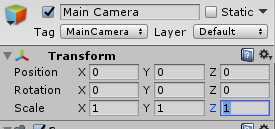

[変換] コンポーネントは次のようになります。

[位置] は 0, 0, 0 に設定されます。

[回転] は 0, 0, 0 に設定されます。

[スケール] は 1, 1, 1 に設定されます。

次に、[メイン カメラ] オブジェクトが選択された状態で、[インスペクター] パネルの一番下に [コンポーネントの追加] があるのを確認します。

そのボタンを選択し、次に示す [オーディオ ソース] という名前のコンポーネントを探して (検索フィールドに「オーディオ ソース」と入力するか、そのセクションに移動することにより)、そのコンポーネントを選択します (そのコンポーネント上で Enter キーを押しても動作します)。

次に示すように、[オーディオ ソース] コンポーネントが [メイン カメラ] に追加されます。

![[Audio Source]\(オーディオ ソース\) コンポーネントを追加する。](images/azurelabs-lab1-21.png)

Note

Microsoft HoloLens の場合、[メイン カメラ]上の [カメラ] コンポーネントの一部である以下も変更する必要があります。

- [クリア フラグ]: 単色。

- [背景] "黒、アルファ 0" – [Hex カラー]: #00000000

第 4 章 – デバッグ キャンバスを設定する

翻訳の入力と出力を表示するために、基本的な UI を作成する必要があります。 このコースでは、キャンバス UI オブジェクトと、データを表示するための複数の "テキスト" オブジェクトを作成します。

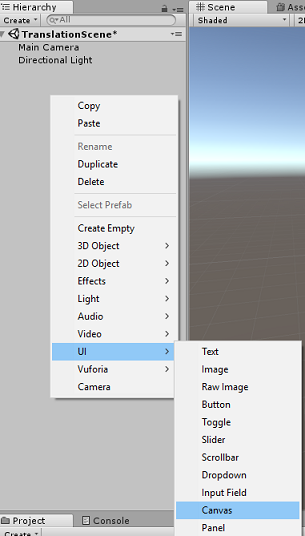

[階層] パネルの何もない領域を右クリックし、[UI]、[キャンバス] の順に選択して追加します。

[キャンバス] オブジェクトが選択されている状態で、([キャンバス] コンポーネント内の) [インスペクター] パネルにある [表示モード] を [ワールド空間] に変更します。

次に、[インスペクター] パネルの [四角形の変換] にある以下のパラメーターを変更します。

[位置] - X 0 Y 0 Z 40

[幅] - 500

[高さ] - 300

[スケール] - X 0.13 Y 0.13 Z 0.13

![キャンバスの [Rect Transform]\(四角形の変換\) を更新する。](images/azurelabs-lab1-23.png)

[階層] パネルの [キャンバス] 上で右クリックし、[UI]、[パネル] の順に選択して追加します。 この [パネル] で、シーンに表示されるテキストの背景が指定されます。

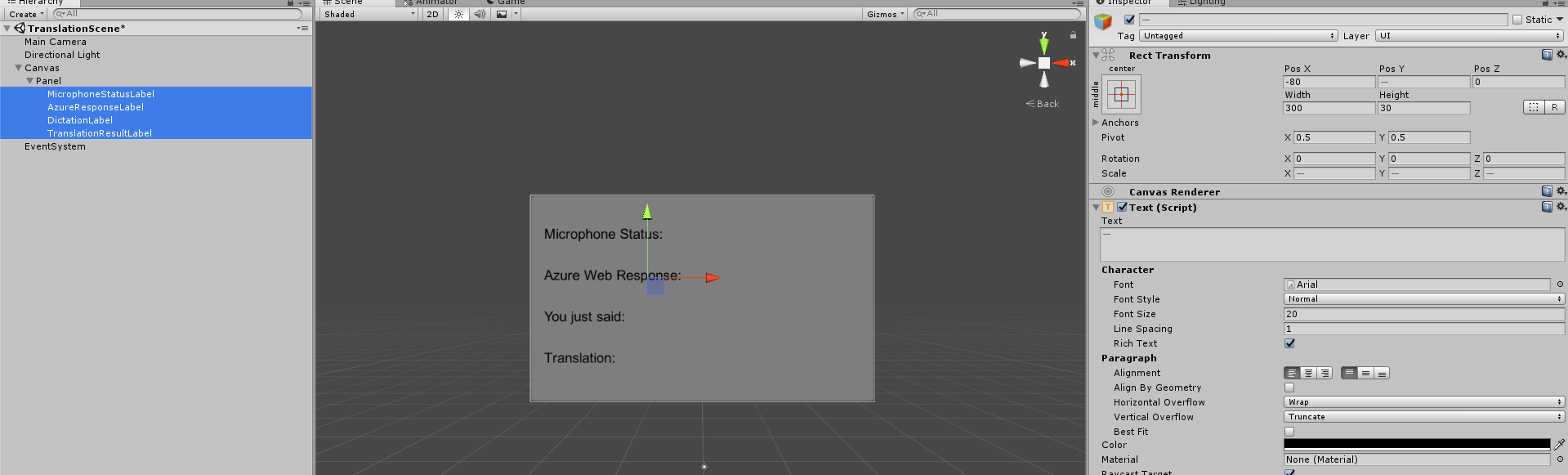

[階層] パネルの [パネル] 上で右クリックし、[UI]、[テキスト] の順に選択してオブジェクトを追加します。 合計で 4 つのテキスト オブジェクトを作成するまで同じプロセスを繰り返します (ヒント: 最初のテキスト オブジェクトを選択して Ctrl キーと D キーを同時に押すだけで、オブジェクトを複製できます。合計 4 つ作成できるまでこの操作を繰り返します)。

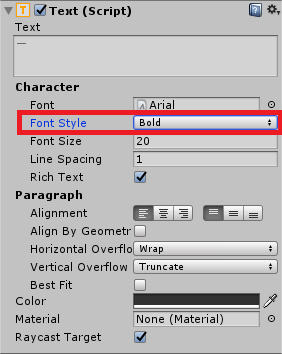

[インスペクター] パネルでそれぞれのテキスト オブジェクトを選択し、以下の表を使用してパラメーターを設定します。

[四角形の変換] コンポーネント:

Name 変換 - 位置 幅 高さ MicrophoneStatusLabel X -80 Y 90 Z 0 300 30 AzureResponseLabel X -80 Y 30 Z 0 300 30 DictationLabel X -80 Y -30 Z 0 300 30 TranslationResultLabel X -80 Y -90 Z 0 300 30 [テキスト (スクリプト)] コンポーネント:

Name テキスト フォント サイズ MicrophoneStatusLabel マイクの状態: 20 AzureResponseLabel Azure Web の応答 20 DictationLabel ユーザーの発話内容: 20 TranslationResultLabel 変換: 20

また、フォント スタイルを [ボールド] に指定します。 これにより、テキストが読みやすくなります。

Chapter 5 で作成UI Text オブジェクトごとに、新しい child UI Text オブジェクトを作成。 これらの子は、アプリケーションの出力を表示します。 対象となる親 (MicrophoneStatusLabel など) を右クリックして "子" オブジェクトを作成し、[UI]、[テキスト] の順に選択します。

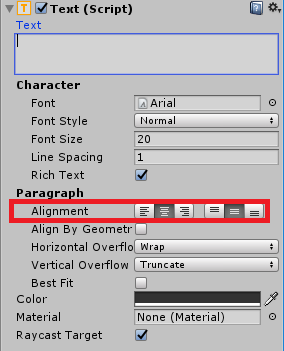

[インスペクター] パネルでそれぞれの子を選択し、以下の表を使用してパラメーターを設定します。

[四角形の変換] コンポーネント:

Name 変換 - 位置 幅 高さ MicrophoneStatusText X 0 Y -30 Z 0 300 30 AzureResponseText X 0 Y -30 Z 0 300 30 DictationText X 0 Y -30 Z 0 300 30 TranslationResultText X 0 Y -30 Z 0 300 30 [テキスト (スクリプト)] コンポーネント:

Name テキスト フォント サイズ MicrophoneStatusText ?? 20 AzureResponseText ?? 20 DictationText ?? 20 TranslationResultText ?? 20

次に、各テキスト コンポーネントに対して [中央揃え] オプションを選択します。

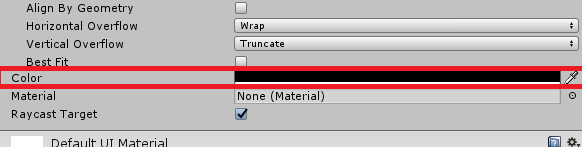

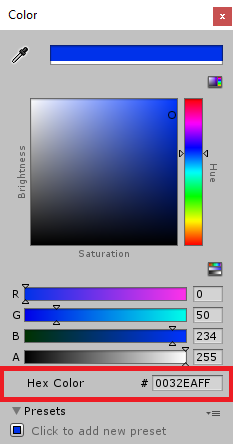

子 UI テキスト オブジェクトが読みやすくなるように、[色] を変更します。 これを行うには、[色] の横にあるバー (現在は "黒") の上でクリックします。

次に、新しく開いた小さな [色] ウィンドウで、[Hex カラー] を 0032EAFF に変更します。

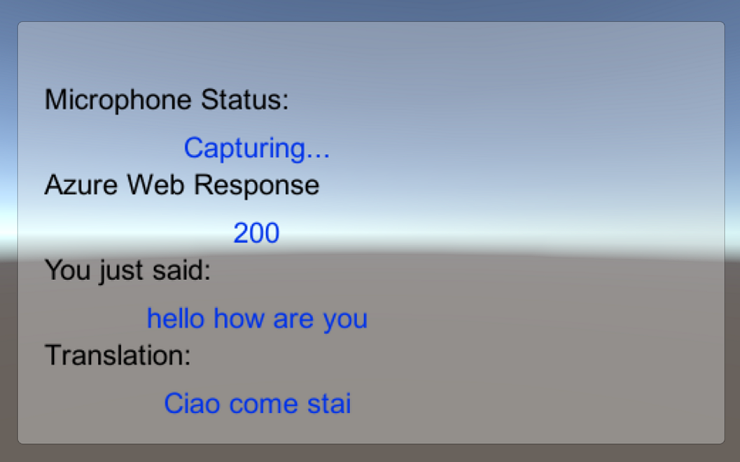

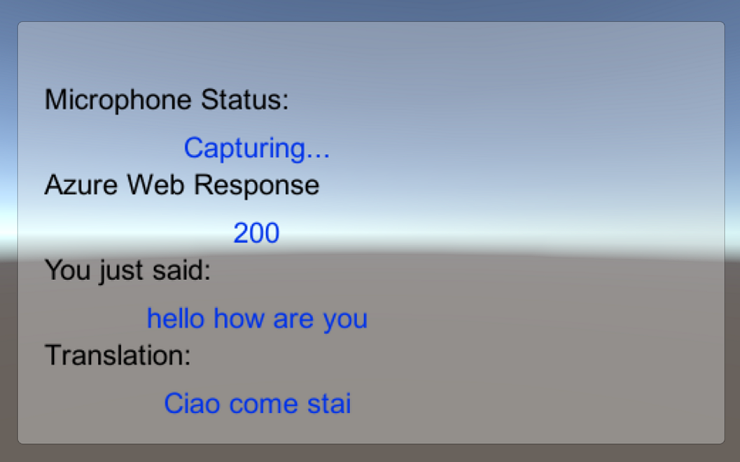

UI は次のように表示されます。

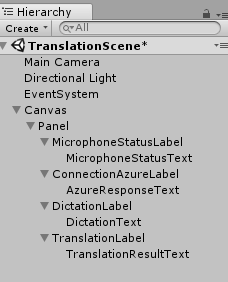

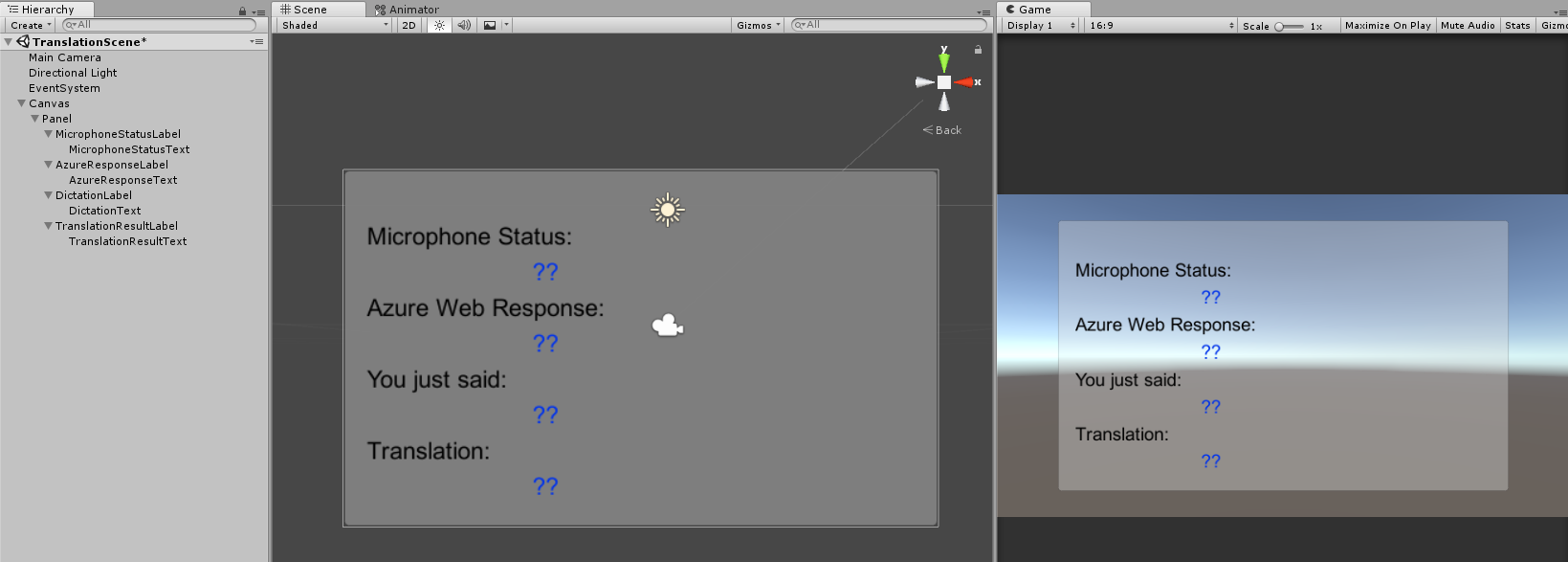

階層パネル:

[シーン] および [ゲーム] ビュー:

第 5 章 – Results クラスを作成する

作成する必要のある最初のスクリプトは、Results クラスです。このクラスは、翻訳の結果を確認する手段を提供します。 このクラスは、次のものを格納して表示します。

- Azure からの応答結果。

- マイクの状態。

- ディクテーションの結果 (音声からテキストへ)。

- 変換の結果。

このクラスを作成するには、次の手順を実行します。

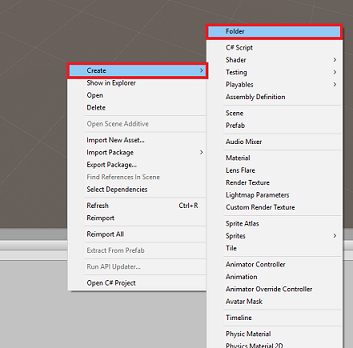

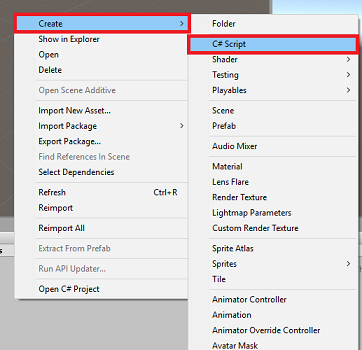

[Project] (プロジェクト) パネル内で右クリックし、[Create] (作成) > [Folder] (フォルダー) を選択します。 フォルダーに「Scripts」という名前を付けます。

作成した Scripts フォルダーをダブルクリックして開きます。 次に、そのフォルダー内で右クリックして [Create] (作成) > [C# Script] (C# スクリプト) を選択します。 スクリプトに Results という名前を指定します。

新しい Results スクリプトをダブルクリックして、Visual Studio で開きます。

次の名前空間を挿入します。

using UnityEngine; using UnityEngine.UI;このクラス内に次の変数を挿入します。

public static Results instance; [HideInInspector] public string azureResponseCode; [HideInInspector] public string translationResult; [HideInInspector] public string dictationResult; [HideInInspector] public string micStatus; public Text microphoneStatusText; public Text azureResponseText; public Text dictationText; public Text translationResultText;次に、Awake() メソッドを追加します。これは、このクラスが初期化されたときに呼び出されます。

private void Awake() { // Set this class to behave similar to singleton instance = this; }最後に、さまざまな結果情報を UI に出力するメソッドを追加します。

/// <summary> /// Stores the Azure response value in the static instance of Result class. /// </summary> public void SetAzureResponse(string result) { azureResponseCode = result; azureResponseText.text = azureResponseCode; } /// <summary> /// Stores the translated result from dictation in the static instance of Result class. /// </summary> public void SetDictationResult(string result) { dictationResult = result; dictationText.text = dictationResult; } /// <summary> /// Stores the translated result from Azure Service in the static instance of Result class. /// </summary> public void SetTranslatedResult(string result) { translationResult = result; translationResultText.text = translationResult; } /// <summary> /// Stores the status of the Microphone in the static instance of Result class. /// </summary> public void SetMicrophoneStatus(string result) { micStatus = result; microphoneStatusText.text = micStatus; }Unity に戻る前に、必ず Visual Studio で変更を保存してください。

第 6 章 – MicrophoneManager クラスを作成する

2 番目に作成するクラスは、MicrophoneManager です。

このクラスでは次のことを行います。

- ヘッドセットまたはコンピューターに接続されている録音デバイス (既定である方) を検出する。

- オーディオ (音声) をキャプチャし、ディクテーションを使用して文字列として保存する。

- 音声が一時停止したら、ディクテーションを Translator クラスに送信する。

- 必要に応じて、音声キャプチャを停止できるメソッドをホストする。

このクラスを作成するには、次の手順を実行します。

Scripts フォルダーをダブルクリックして開きます。

[Scripts] フォルダー内で右クリックし、[Create] (作成) > [C# Script] (C# スクリプト) をクリックします。 スクリプトに「MicrophoneManager」という名前を付けます。

この新しいスクリプトをダブルクリックして Visual Studio で開きます。

MicrophoneManager クラスの先頭で、名前空間を次のように更新します。

using UnityEngine; using UnityEngine.Windows.Speech;次に、MicrophoneManager クラス内に以下の変数を追加します。

// Help to access instance of this object public static MicrophoneManager instance; // AudioSource component, provides access to mic private AudioSource audioSource; // Flag indicating mic detection private bool microphoneDetected; // Component converting speech to text private DictationRecognizer dictationRecognizer;Awake() メソッドと Start() メソッドのコードを追加する必要があります。 これらは、クラスの初期化時に呼び出されます。

private void Awake() { // Set this class to behave similar to singleton instance = this; } void Start() { //Use Unity Microphone class to detect devices and setup AudioSource if(Microphone.devices.Length > 0) { Results.instance.SetMicrophoneStatus("Initialising..."); audioSource = GetComponent<AudioSource>(); microphoneDetected = true; } else { Results.instance.SetMicrophoneStatus("No Microphone detected"); } }Update() メソッドは、このクラスでは使用しないので "削除" してもかまいません。

ここで、音声キャプチャを開始および停止し、その音声キャプチャをこの後の手順で作成する Translator クラスに渡すのにアプリが使用するメソッドが必要になります。 次のコードをコピーして、Start() メソッドの下に貼り付けます。

/// <summary> /// Start microphone capture. Debugging message is delivered to the Results class. /// </summary> public void StartCapturingAudio() { if(microphoneDetected) { // Start dictation dictationRecognizer = new DictationRecognizer(); dictationRecognizer.DictationResult += DictationRecognizer_DictationResult; dictationRecognizer.Start(); // Update UI with mic status Results.instance.SetMicrophoneStatus("Capturing..."); } } /// <summary> /// Stop microphone capture. Debugging message is delivered to the Results class. /// </summary> public void StopCapturingAudio() { Results.instance.SetMicrophoneStatus("Mic sleeping"); Microphone.End(null); dictationRecognizer.DictationResult -= DictationRecognizer_DictationResult; dictationRecognizer.Dispose(); }ヒント

このアプリケーションでは使用しませんが、アプリケーションにオーディオのキャプチャを停止する機能を実装する必要がある場合のために、この例では StopCapturingAudio() メソッドも指定されています。

次に、音声が停止したときに呼び出されるディクテーション ハンドラーを追加する必要があります。 このメソッドは、ディクテーションされたテキストを Translator クラスに渡します。

/// <summary> /// This handler is called every time the Dictation detects a pause in the speech. /// Debugging message is delivered to the Results class. /// </summary> private void DictationRecognizer_DictationResult(string text, ConfidenceLevel confidence) { // Update UI with dictation captured Results.instance.SetDictationResult(text); // Start the coroutine that process the dictation through Azure StartCoroutine(Translator.instance.TranslateWithUnityNetworking(text)); }Unity に戻る前に、必ず Visual Studio で変更を保存してください。

警告

このとき、Unity エディターの [コンソール] パネルに、"名前 'Translator' は存在しません..." というエラーが表示されます。 これは、次の章で作成する Translator クラスがコードで参照されているためです。

第 7 章 – Azure と翻訳サービスを呼び出す

作成する必要がある最後のスクリプトは Translator クラスです。

このクラスでは次のことを行います。

- 認証トークンと引き換えに、Azure でアプリを認証する。

- 認証トークンを使用して、翻訳すべきテキスト (MicrophoneManager クラスから受信したもの) を送信する。

- 翻訳された結果を受け取り、UI で視覚化されるように Results クラスにそれを渡す。

このクラスを作成するには、次の手順を実行します。

先ほど作成した Scripts フォルダーに移動します。

[プロジェクト] パネルで右クリックし、[作成] > [C# スクリプト] の順に選択します。 このスクリプトに「Translator」という名前を付けます。

新しい Translator スクリプトをダブルクリックして、Visual Studio で開きます。

次の名前空間を ファイルの先頭に追加します。

using System; using System.Collections; using System.Xml.Linq; using UnityEngine; using UnityEngine.Networking;次に、Translator クラス内に以下の変数を追加します。

public static Translator instance; private string translationTokenEndpoint = "https://api.cognitive.microsoft.com/sts/v1.0/issueToken"; private string translationTextEndpoint = "https://api.microsofttranslator.com/v2/http.svc/Translate?"; private const string ocpApimSubscriptionKeyHeader = "Ocp-Apim-Subscription-Key"; //Substitute the value of authorizationKey with your own Key private const string authorizationKey = "-InsertYourAuthKeyHere-"; private string authorizationToken; // languages set below are: // English // French // Italian // Japanese // Korean public enum Languages { en, fr, it, ja, ko }; public Languages from = Languages.en; public Languages to = Languages.it;Note

- 言語の enum に挿入されている言語は例に過ぎません。 必要に応じてさらに追加できます。この API は 60 を超える言語をサポートしています (クリンゴン語も含まれます)。

- 使用可能な言語を説明したよりインタラクティブなページも用意されています。ただし、このページはサイトの言語が '' に設定されている場合にのみ動作することに注意してください (Microsoft サイトは通常、ユーザーの母国語にリダイレクトされます)。 サイトの言語は、ページの下部か URL を変更することによって変更できます。

- 上のコード スニペットの authorizationKey 値は、Azure Translator Text API をサブスクライブしたときに受け取ったキーである必要があります。 これについては、第 1 章で説明されています。

Awake() メソッドと Start() メソッドのコードを追加する必要があります。

この例では、このコードは認可キーを使用して Azure を呼び出し、"トークン" を取得します。

private void Awake() { // Set this class to behave similar to singleton instance = this; } // Use this for initialization void Start() { // When the application starts, request an auth token StartCoroutine("GetTokenCoroutine", authorizationKey); }Note

トークンは 10 分後に期限切れになります。 アプリのシナリオによっては、同じコルーチン呼び出しを複数回実行することが必要になる場合があります。

トークンを取得するコルーチンは次のとおりです。

/// <summary> /// Request a Token from Azure Translation Service by providing the access key. /// Debugging result is delivered to the Results class. /// </summary> private IEnumerator GetTokenCoroutine(string key) { if (string.IsNullOrEmpty(key)) { throw new InvalidOperationException("Authorization key not set."); } using (UnityWebRequest unityWebRequest = UnityWebRequest.Post(translationTokenEndpoint, string.Empty)) { unityWebRequest.SetRequestHeader("Ocp-Apim-Subscription-Key", key); yield return unityWebRequest.SendWebRequest(); long responseCode = unityWebRequest.responseCode; // Update the UI with the response code Results.instance.SetAzureResponse(responseCode.ToString()); if (unityWebRequest.isNetworkError || unityWebRequest.isHttpError) { Results.instance.azureResponseText.text = unityWebRequest.error; yield return null; } else { authorizationToken = unityWebRequest.downloadHandler.text; } } // After receiving the token, begin capturing Audio with the MicrophoneManager Class MicrophoneManager.instance.StartCapturingAudio(); }警告

IEnumerator メソッドの GetTokenCoroutine() の名前を編集する場合は、上のコードの StartCoroutine および StopCoroutine の呼び出し文字列値を更新する必要があります。 Unity のドキュメントにあるように、特定の "コルーチン" を停止するには、文字列値メソッドを使用する必要があります。

次に、MicrophoneManager クラスで受信したテキストの翻訳を取得するために、コルーチンを追加します (その直下に "サポート" ストリーム メソッドを指定します)。 このコードは、Azure Translator Text API に送信するクエリ文字列を作成します。次に、内部の Unity UnityWebRequest クラスを使用し、作成したクエリ文字列を使用して、エンドポイントへの Get 呼び出しを実行します。 その後、この結果を使用して、Results オブジェクトに翻訳を設定します。 次のコードにその実装を示します。

/// <summary> /// Request a translation from Azure Translation Service by providing a string. /// Debugging result is delivered to the Results class. /// </summary> public IEnumerator TranslateWithUnityNetworking(string text) { // This query string will contain the parameters for the translation string queryString = string.Concat("text=", Uri.EscapeDataString(text), "&from=", from, "&to=", to); using (UnityWebRequest unityWebRequest = UnityWebRequest.Get(translationTextEndpoint + queryString)) { unityWebRequest.SetRequestHeader("Authorization", "Bearer " + authorizationToken); unityWebRequest.SetRequestHeader("Accept", "application/xml"); yield return unityWebRequest.SendWebRequest(); if (unityWebRequest.isNetworkError || unityWebRequest.isHttpError) { Debug.Log(unityWebRequest.error); yield return null; } // Parse out the response text from the returned Xml string result = XElement.Parse(unityWebRequest.downloadHandler.text).Value; Results.instance.SetTranslatedResult(result); } }Unity に戻る前に、必ず Visual Studio で変更を保存してください。

第 8 章 – Unity シーンを構成する

Unity エディターに戻り、Scripts フォルダーの Results クラスをクリックして、[階層] パネルの [メイン カメラ] オブジェクトにドラッグします。

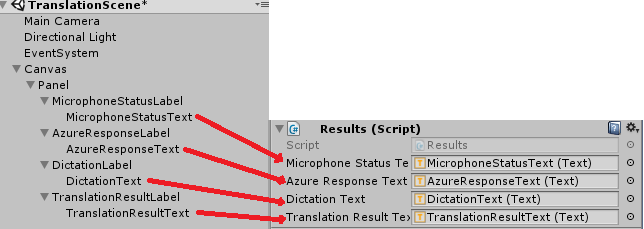

[メイン カメラ] をクリックして、[インスペクター] パネルを見てみます。 新しく追加された Script コンポーネント内に、値が空のフィールドが 4 つ表示されます。 これらは、コード内のプロパティへの出力参照です。

これらの 4 つのスロットに、下の図に示すように、"階層パネル" から適切なテキスト オブジェクトをドラッグします。

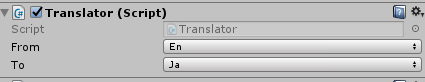

次に、Scripts フォルダーの Translator クラスをクリックして、"階層パネル" の Main Camera オブジェクトにドラッグします。

次に、Scripts フォルダーの MicrophoneManager クラスをクリックして、[階層] パネルの [メイン カメラ] オブジェクトにドラッグします。

最後に、[メイン カメラ] をクリックして、[インスペクター] パネルを確認します。 ドラッグしたスクリプトに 2 つのドロップダウン ボックスがあり、それらを使用して言語を設定できることを確認できます。

第 9 章 – Mixed Reality でテストする

ここで、シーンが正しく実装されていることをテストする必要があります。

次のことを確認してください。

- 第 1 章で説明した設定がすべて正しく設定されている。

- Results、Translator、MicrophoneManager の各スクリプトが [メイン カメラ] オブジェクトに関連付けられている。

- Azure Translator Text API サービス キーが、Translator スクリプト内の authorizationKey 変数内に配置されている。

- Main Camera の [Inspector] (インスペクター) パネルのすべてのフィールドに適切な値が割り当てられています。

- シーンを実行するとマイクが動作する (動作しない場合は、接続されているマイクが "既定" のデバイスであり、Windows 内で正しく設定されていることを確認します)。

"Unity エディター" の [再生] ボタンを押すことで、イマーシブ ヘッドセットをテストできます。 アプリは、接続されているイマーシブ ヘッドセットを介して機能している必要があります。

警告

既定のオーディオ デバイスの変更について Unity コンソールにエラーが表示される場合は、シーンが想定どおりに機能しない可能性があります。 これは、ヘッドセットにマイクが内蔵されている場合の、Mixed Reality ポータルにおける内蔵マイクの取り扱いが原因です。 このエラーが表示された場合は、シーンを停止してからもう一度開始するだけで、期待どおりに動作するはずです。

第 10 章 – UWP ソリューションをビルドし、ローカル コンピューターにサイドロードする

このプロジェクトの Unity セクションに必要なすべての手順が完了したため、ここでは Unity からビルドを行います。

[ビルド設定] に移動します ([ファイル] > [ビルド設定...])。

[ビルド設定] ウィンドウで、[ビルド] をクリックします。

[Unity C# プロジェクト] をオンにします (まだオンにしていない場合)。

[ビルド] をクリックします。 Unity によって [エクスプローラー] ウィンドウが起動されます。そこで、アプリのビルド先のフォルダーを作成して選択する必要があります。 そのフォルダーを作成して、「App」という名前を付けます。 次に、App フォルダーを選択した状態で、[フォルダーの選択] を押します。

Unity で、App フォルダーに対してプロジェクトのビルドが開始されます。

Unity によるビルドが完了すると (多少時間がかかる場合があります)、[エクスプローラー] ウィンドウが開いて、ビルドの場所が表示されます (必ずしも最前面に表示されるとは限らないため、タスク バーを確認してください。新しいウィンドウが追加されたことがわかります)。

第 11 章 – アプリケーションをデプロイする

アプリケーションをデプロイするには、以下の手順を実行します。

新しいユニティビルド(アプリフォルダー)にナビゲートし、Visual Studioでソリューションファイルを開きます。

[ソリューション構成] で、[デバッグ] を選択します。

ソリューションプラットフォームで、x86、ローカルマシンを選択します。

Microsoft HoloLens の場合は、これを [リモート コンピューター] に設定した方が便利かもしれません。そうすると、お使いのコンピューターに縛られずに済みます。 ただし、次のことも行う必要があります。

- HoloLens の IP アドレス を把握します。これは、 Settings > ネットワークとインターネット > Wi-Fi > 詳細オプション内にあります。IPv4 は使用する必要があるアドレスです。

- Developer Mode が On; であることを確認します。これは、開発者向け Settings > Update および Security > にあります。

[ビルド] メニューに移動して、[ソリューションの配置] をクリックし、お使いの PC にアプリケーションをサイドロードします。

ここで、インストールされたアプリのリストにアプリが現れ、起動できる状態になります。

起動すると、"マイク" へのアクセスを認可するように求めるメッセージがアプリに表示されます。 [はい] ボタンをクリックします。

これで翻訳を開始する準備ができました。

完成した Translation Text API アプリケーション

おめでとうございます。これで、Azure Translation Text API を利用して音声を翻訳されたテキストに変換する Mixed Reality アプリを構築できました。

ボーナス演習

演習 1

アプリにテキスト読み上げ機能を追加して、返されたテキストが読み上げられるようにできますか?

演習 2

ユーザーがアプリ自体の内部でソース言語と出力言語 ('from' と 'to') を変更でき、言語を変更するたびにアプリを再構築しなくても済むようにします。